Aktuelle Events

Gut beraten als Berater?

Trendreport: Gründen als Berater

Autor: Heike HuchtBeraten, trainieren, coachen: Consulting hat viele Facetten. Wir zeigen auf, wie es Ihnen gelingen kann, auf dem hart umkämpften Terrain als Gründer erfolgreich durchzustarten.

Die gute Nachricht vorweg: Auch in Zeiten deutlicher Wettbewerbsverdichtung und zunehmender Internationalisierung, massiv gestiegenem Kosten- und Zeitdruck gibt es noch Chancen für Gründer in der Beratungsbranche, sind sich die Experten einig. Man müsse sie sich nur härter erarbeiten – gründlicher recherchieren, gewissenhafter ausloten, abwägen und zuschneiden. „Die großen Boomjahre der Beratungsbranche, die Goldgräberstimmung von 1990 bis 2001, sind definitiv vorbei“, sagt Klaus Reiners, Sprecher des Bundesverbands Deutscher Unternehmensberater (BDU). Die Wirtschafts- und Finanzkrisen haben deutliche Spuren hinterlassen. Zweistellige Zuwachsraten gehören der Vergangenheit an. Nach einem Minus im Jahr 2009 ist der Markt in den vergangenen Jahren zwischen sechs und acht Prozent gewachsen.

Eine kurze Bestandsaufnahme

Laut BDU waren 2012 in Deutschland rund 95.000 Unternehmensberater in knapp 15.000 Beratungsfirmen beschäftigt. Mehr als die Hälfte ist meist als Einzelkämpfer unterwegs und erzielt einen Jahresumsatz, der unter 250.000 Euro liegt. Der Gesamtumsatz der Branche stieg 2012 auf 22,3 Milliarden Euro – ein Plus von acht Prozent beziehungsweise 1,7 Milliarden Euro. Für 2013 wird ein Wachstum von sieben Prozent erwartet.

Auch in Zukunft werde es noch Wachstumswellen geben, ist sich Reiners sicher: „Allerdings in einem sehr viel schwierigeren, weil volatilen Markt.“ Eva Manger-Wiemann vom Schweizer Meta-Consultingunternehmen Cardea, das sich auf die Vermittlung von Beratern spezialisiert hat, spricht sogar von Sättigung im deutschsprachigen Raum. „Wir stecken mitten in einem tiefgreifenden Konsolidierungsprozess, der einerseits immer größere Fullservice-Beratungen mit tausenden Mitarbeitern hervorbringt: global aufgestellte Riesen, die neuerdings auch um den Mittelstand buhlen. Andererseits gewinnen Spezialisten mit fundierter Branchenkompetenz und hochgradig fachlicher Expertise, sogenannte Boutique-Anbieter, an Relevanz“, sagt die Expertin.

Beratungsfelder verschmelzen

Eine Entwicklung, die den Marktzugang spürbar erschwere beziehungsweise es neuen Teilnehmern alles andere als leicht mache sich zu positionieren, betont Reiners. Dazu kommt, dass sich der Beratungsanspruch vieler Kunden in den vergangenen Jahren nachhaltig verändert hat. Denn mit der Erfahrung wächst der Anspruch. Gefragt sind schon lange nicht mehr allein Strategie und Konzeption, sondern auch deren Umsetzung – bei inzwischen mehr als 95 Prozent der Projekte, schätzt der BDU-Mann: „Berater müssen beim Kunden mit anpacken können und wollen. Und das setzt eben auch ein tiefes Verständnis der Unternehmenskultur voraus.“

Überhaupt ließen sich heutzutage die vier klassischen Beratungsfelder – Organisation und Prozesse, IT, Human Ressource (HR) und Strategie – kaum noch voneinander trennen, „die Grenzen verschwimmen zunehmend.“ Mehr denn je sind integrative Ansätze gefordert. Deshalb werde es zunehmend wichtiger zu destillieren und zu definieren, welche Rollen man als Berater anbieten kann und möchte, so Manger-Wiemann.

Das Spektrum reicht vom kreativen Vordenker über den rhetorisch versierten Moderator und Trainer bis zum umsetzungsstarken Lenker und Manager. „Klingt banal, ist es aber nicht“, meint die Expertin. „Sich dieses Repertoire bewusst zu machen und herauszustellen, kann ein effektives Differenzierungsmoment sein – und ein Aha-Effekt für so manchen Kunden. Viele Unternehmen wissen nämlich gar nicht, welche Rollen nötig sind, um sie bei ihrer Problemlösung bestmöglich zu unterstützen.“ Ein Plädoyer für „je mehr, umso besser“? „Keineswegs“, sagt Manger-Wiemann. Der Schlüssel zum Erfolg liegt für sie eindeutig im Dreiklang aus Differenzieren, Spezialisieren und Fokussieren, „und zwar glaubwürdig und ehrlich. Darauf legen vor allem beratungserfahrene Kunden großen Wert“.

Dies ist ein Auszug aus einem aktuellen Artikel unseres Print-Objekts StartingUp:

Den vollständigen Artikel lesen Sie in der aktuellen StartingUp - Heft 01/14 - ab dem 20. Februar 2014 im Handel oder jederzeit online bestellbar in unserem Bestellservice-Bereich

Diese Artikel könnten Sie auch interessieren:

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

StartingUp-DeepTech-Watchlist 2026

Von „German Engineering“ zu „German DeepTech“: Diese jungen Start-ups und Scale-ups zünden 2026 die nächste Stufe – und sollten zwingend auf dem Radar von Investor*innen und Entscheider*innen stehen.

„Prognosen sind schwierig, vor allem, wenn sie die Zukunft betreffen.“ Dieser Ausspruch unterstreicht die Herausforderung, die Dynamik unseres Start-up-Ökosystems vorherzusagen. Doch wer 2025 aufmerksam verfolgt hat, der spürt: Es hat sich etwas gedreht. Der Investor*innenfokus hat sich verschoben – weg von reinen E-Commerce-Modellen, hin zu substanzieller Technologie, die echte physikalische Probleme löst.

Die folgende Auswahl an Start-ups und Scale-ups, mit denen 2026 gerechnet werden sollte, ist mehr als eine Watchlist. Sie basiert auf einer Analyse der signifikanten Finanzierungsrunden 2025, der technologischen Reife und der Resonanz bei bedeutenden Preisen. Diese Unternehmen stehen beispielhaft für eine Gründer*innengeneration, die Wissenschaft und Skalierung vereint. Natürlich bleibt ein Restrisiko. Unwägbarkeiten – von geopolitischen Instabilitäten über regulatorische Verschärfungen wie dem EU AI Act bis hin zu volatilen Zinsmärkten – können die nahe Zukunft beeinflussen. Doch die Resilienz dieser Unternehmen stimmt optimistisch.

DefenseTech: Die neue Realität der Sicherheit

Lange war Verteidigungstechnologie in Deutschland ein Tabuthema für Risikokapitalgeber. Das hat sich grundlegend geändert. Ganz oben auf der Watchlist steht neben dem Münchner Start-up Helsing nun das 2024 gegründete Black Forest Labs. Das Geschäftsmodell ist faszinierend, weil es die Grenzen zwischen kreativer Zerstörung und Sicherheitstechnologie verwischt. Es basiert auf der Entwicklung proprietärer State-of-the-Art-Modelle für generative Videoerzeugung. Nach einer spektakulären 300-Mio.-USD-Runde im Dezember 2025 katapultierte sich die Bewertung auf satte 3,25 Milliarden USD. Das Start-up ist damit Deutschlands wertvollste KI-Firma und beweist, dass Europa bei Generative AI den Anschluss nicht verloren hat. Der globale Siegeszug deutet sich 2026 unter anderem in einem mehrjährigen Vertrag mit Meta sowie in Kooperationen mit US-Plattformen wie X und Hollywood-Studios an, die Produktionskosten senken wollen. Mitgründer Robin Rombach prognostizierte im Sifted-Podcast: „2026 wird generative Video-KI zum industriellen Standard in der Medienproduktion.“ Doch auch bei der Simulation für Sicherheitsszenarien spielt die Technologie eine wachsende Rolle.

Ein weiterer Schlüsselakteur ist Stark Defence. Das 2024 gegründete Münchner Start-up adressiert eine Lücke der modernen Kriegsführung: asymmetrische Bedrohungen. Stark Defence fokussiert sich auf softwaredefinierte, autonome Drohnensysteme, die „on the edge“ entscheiden und nicht auf ständige Funkverbindung angewiesen sind. Dass das Start-up durch seine KI-Schwarmtechnologie massiv an Bedeutung gewinnen wird, hat sich Ende Februar 2026 eindrucksvoll bestätigt: Der Haushaltsausschuss des Bundestages gab einen Auftrag über 540 Millionen Euro für Kampfdrohnen frei, den sich Stark Defence (Modell „Virtus“) und das nach einer Mega-Runde im Sommer 2025 mittlerweile mit 12 Milliarden Euro bewertete Münchner Unicorn Helsing (Modell „HX-2“) teilen. Um diese rasante Skalierung zu stemmen, hat Stark Defence kürzlich das Berliner Software-Start-up Pleno übernommen und eine neue Serienfertigung im britischen Swindon eröffnet. Mitgründer Florian Seibel dazu: „Unser Ziel für 2026 ist die erste vollautonome Verteidigungslinie für Europa.“

MedTech-Start-up RAYDIAX holt 7,5 Mio. Euro für neuartiges CT-System

RAYDIAX sichert sich 7,5 Mio. Euro, um mit einem speziell für minimal-invasive Eingriffe entwickelten Computertomographen die Krebsbehandlung zu verbessern. Doch der Weg vom universitären Forschungslabor in die globalen Operationssäle ist im hochregulierten Gesundheitsmarkt lang. Ein Blick auf ein DeepTech-Geschäftsmodell, das sich nun in der klinischen Praxis beweisen muss.

Die erfolgreiche Series-A1-Finanzierungsrunde über 7,5 Millionen Euro für RAYDIAX markiert einen wichtigen Meilenstein von der universitären Forschung in den Gesundheitsmarkt. Das 2022 gegründete Unternehmen mit Hauptsitz im Magdeburger Wissenschaftshafen ist eine Ausgründung des Forschungscampus STIMULATE und der Otto-von-Guericke-Universität Magdeburg. Unter der Führung eines fünfköpfigen Gründerteams – bestehend aus CEO Dr. Thomas Hoffmann, Dr. Tim Pfeiffer, Dr. André Mewes, Benjamin Fritsch und Robert Frysch – konnte das Start-up nach einer erfolgreichen Seed-Phase nun erhebliche Mittel für den Eintritt in die klinische Phase sichern.

Das frische Kapital setzt sich aus 5 Millionen Euro Venture Capital von bestehenden Business Angels, dem Bestandsinvestor bmp Ventures mit den IBG Fonds sowie dem neu eingestiegenen GETEC Family Office um Dr. Karl Gerhold zusammen. Ergänzt wird diese Summe durch 2,5 Millionen Euro Fördermittel aus dem hochkompetitiven EIC Accelerator-Programm der Europäischen Kommission, das gezielt disruptive Deep-Tech-Innovationen mit hohem Skalierungspotenzial unterstützt.

TACT: Computertomographie für den OP neu gedacht

Im Zentrum dieser ambitionierten Wachstumspläne steht der Therapieassistenz-Computertomograph „TACT“, den RAYDIAX dediziert für minimal-invasive Krebstherapien entwickelt. Anders als herkömmliche CTs optimiert das Unternehmen sein System sowohl im Hardware- als auch im Softwarebereich speziell für den interventionellen Einsatz bei der Therapieplanung, -durchführung und -kontrolle. Wie Steffen Schmidt, CFO der GETEC-Gruppe, hervorhebt, ermöglicht die innovative Technologie eine fokussierte Live-Bildgebung, welche die Strahlenbelastung für Patient*innen und Operateur*innen senkt und die Operationszeit verringert.

Zudem bietet das System durch eine größere Geräteöffnung völlig neue Operationsmethoden im CT, wie beispielsweise den Einsatz von Robotik. Der Markt für solche Lösungen wächst, da minimal-invasive Eingriffe angesichts einer alternden Bevölkerung und steigender Krebsinzidenzen massiv an Bedeutung gewinnen. Sie ermöglichen in vielen Fällen eine schonendere Behandlung im Vergleich zu offenen chirurgischen Eingriffen, verkürzen potenziell Operations- sowie Liegezeiten, verringern Komplikationen und können so zusätzliche Behandlungskapazitäten schaffen, um die Krankenhausstrukturen zu entlasten.

Harter Wettbewerb und regulatorische Hürden

Trotz der vielversprechenden Technologie steht das Geschäftsmodell in der Praxis vor erheblichen Herausforderungen. Der globale Markt für medizinische Bildgebung ist hart umkämpft, und der Vertrieb an Kliniken ist durch extrem lange, hochkomplexe B2B-Entscheidungszyklen geprägt. RAYDIAX tritt diesem Wettbewerb entgegen, indem es anstrebt, eine funktional dringend benötigte, neue Gerätekategorie in der interventionellen Onkologie zu etablieren, um so eine Lücke im OP-Betrieb zu füllen.

Der Beweisdruck auf dem jungen Unternehmen ist dennoch enorm: Das neu eingeworbene Kapital wird nun für First-in-Human-Studien eingesetzt, um die frühe klinische Evidenz am Patienten zu generieren. Diese Phase legt die Grundlage für die regulatorische Zulassung und kommerzielle Skalierung. Parallel dazu erfordert die Weiterentwicklung zur Serienreife einen konsequenten Ausbau in den Bereichen Vertrieb, Produktion und Qualitätsmanagement, um die ersten kommerziellen Installationen systematisch vorzubereiten.

Lehrstück für europäisches DeepTech

Dieser Fall zeigt eindrucksvoll die Realität und die hohen Anforderungen europäischen DeepTech-Unternehmertums. Der Abschluss dieser Finanzierungsrunde belegt deutlich, wie essenziell die intelligente Kombination aus wissenschaftlicher Grundlagenforschung, klassischem Risikokapital und strategischen europäischen Fördergeldern ist. Nur so lässt sich die extrem kapitalintensive Entwicklungsphase von Hardware in der Medizintechnik erfolgreich überstehen. Wenn es dem Gründerteam nun gelingt, die klinische Wirksamkeit in der Praxis zu belegen und die regulatorischen Hürden zu meistern, hat dieses Spin-off das Potenzial, die Anwendung minimal-invasiver Krebstherapien erheblich auszuweiten.

eeden: Die Alchemie der Altkleider

Das Münsteraner Unternehmen eeden verwandelt Textilmüll in hochwertige Rohstoffe. Mit Millioneninvestments baut das Team um Steffen Gerlach und Tobias Börnhorst nun die erste Demonstrationsanlage auf.

Steffen Gerlach saß entspannt mit seinem Schulfreund Reiner Mantsch auf einer Couch in einer Kölner Wohngemeinschaft. Mantsch hatte zuvor an der Universität in Mönchengladbach Textiltechnik studiert. Er berichtete leidenschaftlich von seinen naturwissenschaftlichen Forschungen zur Kreislaufwirtschaft. Dieses Gespräch veränderte Gerlachs gesamte berufliche Planung radikal. Mantsch suchte jemanden für die Marktseite seiner technischen Vision. Gerlach war sofort fasziniert von dem ökonomischen Potenzial. Er wollte wissen, ob man daraus ein echtes Unternehmen formen kann. „Das war der eigentliche Startpunkt für eeden. Wir entschieden uns für einen vollen Fokus auf das Projekt. Und wir wollten das Recyclingproblem der Branche grundlegend lösen“, erinnert sich Gerlach.

Der langsame Weg zum technologischen Durchbruch

Es gab keinen plötzlichen Heureka-Moment in einem winzigen und improvisierten Labor. Die Entwicklung war eher eine gezielte Suche nach einer Problemlösung. Mantsch war früher Leistungssportler und brachte den nötigen Fokus mit. Er sah den Frust seiner Kommilitonen nach Praktika in der Industrie. Die Branche wirkte starr und wenig dynamisch für junge Talente. Das Duo suchte stattdessen nach den Megatrends der Zukunft. „Die Kreislaufwirtschaft kristallisierte sich schnell als das zentrale Thema heraus. Ich habe die Marktseite intensiv analysiert und viele Gespräche geführt“, so Gerlach. Er erkannte die Verknüpfungen zwischen technischer Machbarkeit und ökonomischen Anforderungen. Die Suche nach dem technologischen Sweetspot dauerte Monate. Am Anfang stand lediglich die reine Faszination für das Recycling. Es war ein schleichender Prozess mit vielen Etappenentscheidungen.

Die wachsende Last der globalen Fast Fashion

Das Umweltproblem der globalen Textilindustrie ist mittlerweile gewaltig. Die Branche verdoppelt ihren Durchsatz alle 20 bis 30 Jahre. Jährlich werden mittlerweile mehr als 120 Mio. Tonnen Textilien produziert. Nach Angaben der Ellen MacArthur Foundation werden weltweit ungefähr zwei Drittel dieser Mengen praktisch direkt nach der Nutzung entsorgt; sie landen auf riesigen Deponien oder werden ungenutzt verbrannt. In Deutschland steht das klassische Rücknahmesystem laut Experten vor dem Kollaps. Es gibt nach seiner Aussage derzeit eine gestiegene Anzahl an Insolvenzen bei Sammel- und Sortierbetrieben. Die Qualität der Kleidung sinkt durch den Trend zur Fast Fashion massiv. Der Wiederverkauf der gebrauchten Ware lohnt sich oft nicht mehr. Neuware aus Asien ist meistens günstiger als Second Hand-Stücke aus Europa. In Deutschland verursacht die Entsorgung einer Tonne Altkleider zudem Kosten – das Material wird somit zur finanziellen Belastung für die Sammel- und Sortierbetriebe.

Chemische Trennung als industrieller Schlüssel

Das Unternehmen aus Münster setzt genau an diesem Punkt an. Die Technologie ermöglicht die Trennung von Baumwolle und Polyester und macht beide Materialien wieder nutzbar. Das ist entscheidend für den Erfolg der Kreislaufwirtschaft. Die meisten Textilien bestehen heute aus komplexen Mischgeweben. Gerlach erklärt, dass das Unternehmen aus dem Abfall eine hochwertige Cellulose und chemische Bausteine für neues Polyester gewinnt. Die Cellulose dient als sauberes Vorprodukt für die neue Faserherstellung. Das Polyester wird in seine Grundbausteine zerlegt, die für die Herstellung von neuem Polyester verwendet werden können. „Wir stellen aus Baumwolle eine hochwertige Cellulose her und gewinnen aus dem Polyester die chemischen Bausteine zurück“, sagt Gerlach. Beide Materialströme können direkt wieder in der Textilproduktion eingesetzt werden. Damit wird der Kreislauf zwischen Abfall und Kleidung geschlossen. Seit Anfang 2025 hilft zudem eine neue gesetzliche Regelung. Die EU-weite Getrenntsammlungspflicht für Textilabfälle ist in Kraft getreten: Unternehmen dürfen Textilien nun nicht mehr über den Restmüll entsorgen. Das sichert den Zugang zu großen Mengen an Rohstoffen.

Harte Verhandlungen in der Welt des Wagniskapitals

Der Weg von der ersten Idee zur fertig gebauten Industrieanlage ist lang. Deeptech-Unternehmen brauchen oft viel Geduld und Zeit für die Entwicklung. Das erfordert Investoren mit einem sehr langen Atem. In einer frühen Phase kam der High-Tech Gründerfonds an Bord. Auch die NRW.Bank und der TechVision Fonds unterstützen das Vorhaben. Später stiegen Forbion und der Chemiekonzern Henkel als Investor ein. Gerlach erinnert sich im Gespräch an einen intensiven Lernprozess bei den ersten Finanzierungsrunden. Man müsse technische Begeisterung mit harten Umsatzprognosen anreichern. Auch D11Z.Ventures, das Family Office von Dieter Schwarz (Lidl/Kaufland), investierte in das Unternehmen. Die Investoren verstehen laut Gerlach die Entwicklungszyklen und Skalierung von Deeptech-Unternehmen. Mittlerweile flossen über 20 Mio. EUR an Kapital in die Firma. Dieses Geld ermöglicht nun den nächsten großen Schritt.

Ein neues Team für die industrielle Skalierung

Das Start-up ist mittlerweile den Kinderschuhen entwachsen. In Münster entsteht derzeit eine industrielle Demonstrationsanlage. Gerlach erinnert sich an den Moment der Schlüsselübergabe: Zuerst wirkte die leere Halle riesig auf das Team. Inzwischen planen die Ingenieure bereits jeden Zentimeter der Fläche. Das Team ist auf über 25 Köpfe gewachsen. Es ist eine Mischung aus jungen Talenten und erfahrenen Kräften. Viele Mitarbeitende wechselten von großen Konzernen wie BASF nach Münster. Gerlach beobachtet eine große Lust auf die Arbeit an innovativen Prozessen. Die flachen Hierarchien im Unternehmen ziehen Experten an. Er schätzt das Know-how dieser Fachkräfte für den Anlagenbau. Erfahrene Chemiker bringen eine neue Qualität in die Prozesse. Die Zusammenarbeit zwischen Alt und Jung funktioniert hervorragend.

Führung zwischen Agilität und unternehmerischer Verantwortung

Die Unternehmenskultur hat sich mit der Größe weiterentwickelt. Gerlach betont, dass viele Impulse direkt aus der Belegschaft kommen. So wurde die Regelung für die Präsenz im Büro gemeinsam erarbeitet. Die Mitarbeitenden wünschten sich feste Tage für den Austausch. „Die schönsten Tage sind jene mit viel Begegnung“, berichtet Gerlach. Die bürokratischen Pflichten eines Geschäftsführers gehören einfach dazu. Trotzdem bleibt die Mission der Firma der wichtigste Treiber. Die Motivation im gesamten Team sei extrem hoch. Jeder packt an und treibt das Unternehmen voran. Der Spagat zwischen Entwicklung und Business ist fordernd. Gerlach jedoch genießt diese tägliche Herausforderung sehr.

Der Standort Deutschland als Zentrum für Innovation

Viele Fachleute kritisieren die Bedingungen für die Chemieindustrie. Hohe Energiekosten belasten die traditionsreichen Unternehmen stark. Gerlach sieht das differenzierter aus der Perspektive von innovativen Start-ups: „Für die Entwicklung neuer Technologien ist der Standort Deutschland weiter exzellent. Und die Qualifikation der Technologen ist hervorragend. Die aktuelle Krise führt bei uns auch zu Bewerbungen von erfahrenen Talenten aus der chemischen Industrie – die hätte es vor einigen Jahren in der Menge nicht gegeben.“ Die vorhandene Infrastruktur sei ein klarer Vorteil. Auch Konzerne beobachten solche Innovationen genau. Die Nähe zum Mittelstand fördert zudem die Skalierung. Für die beiden Gründer ist die aktuelle Produktionsanlage nur ein Anfang. Langfristig soll die Technologie weltweit lizenziert werden; überall auf der Welt fällt schließlich Textilmüll an. Die Kombination aus Ingenieurskunst und Skalierung ist das Ziel. Auch die aktuellen Investoren von eeden sehen dieses globale Potenzial. Das Unternehmen will beweisen, dass sich Kreislaufwirtschaft lohnt. Deutschland bleibt dafür ein wichtiger Ankerpunkt.

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

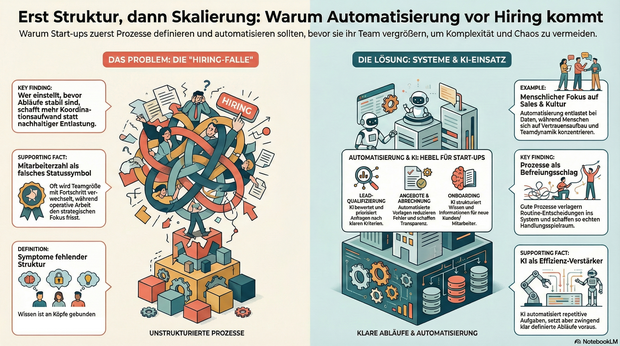

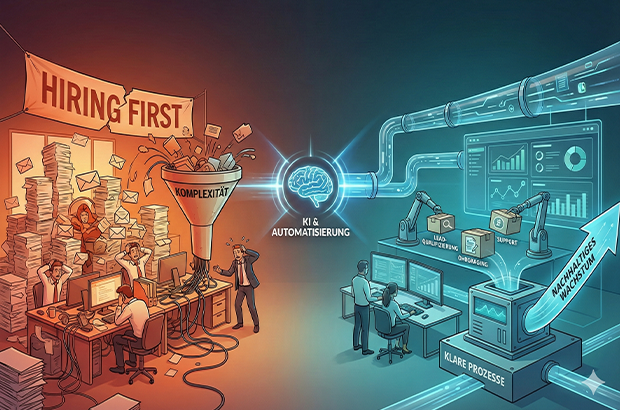

Automatisierung vor Hiring, sonst wird Komplexität skaliert

Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung. Tipps und To-Dos.

Wachstum wird in Start-ups oft sehr eindimensional gedacht: mehr Nachfrage gleich mehr Menschen. Sobald Anfragen steigen, Deals reinkommen oder neue Märkte locken, folgt fast automatisch der nächste Hiring-Plan. Dabei wird häufig die Ursache mit Wirkung verwechselt. Nicht fehlende Kapazität bremst junge Unternehmen, sondern fehlende Struktur. Prozesse entstehen improvisiert, Verantwortung wird situativ verteilt, operative Arbeit frisst Fokus. Und irgendwann fühlt sich Wachstum nicht mehr nach Fortschritt, sondern nach Dauerstress an.

Gerade in der Start-up-Branche wird Wachstum zudem stark über sichtbare Kennzahlen bewertet. In Gesprächen mit Investor*innen lautet eine der ersten Fragen häufig nicht Gewinn oder EBITA, sondern: Wie viele Mitarbeitende seid ihr und wie viel Umsatz macht ihr? Die Anzahl der Mitarbeitenden wird damit fast zu einem Statussymbol. Hiring wird nicht nur zur operativen, sondern auch zur psychologischen Größe und ein Zeichen von Fortschritt. Diese Logik verstärkt den Reflex, früh zu skalieren, auch wenn die strukturellen Voraussetzungen dafür noch fehlen. Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung.

Warum Hiring allein selten skaliert

Mehr Menschen im Team wirken wie eine schnelle Lösung. In der Praxis zeigt sich jedoch häufig ein ähnliches Muster: Neue Kolleg*innen übernehmen Aufgaben, die eigentlich nur deshalb existieren, weil Abläufe unklar oder manuell gewachsen sind. Statt nachhaltiger Entlastung entsteht zusätzliche Koordination.

Typische Symptome sind:

- operative Aufgaben blockieren strategische Arbeit,

- Wissen verteilt sich auf einzelne Köpfe,

- Entscheidungen hängen an Personen statt an klaren Abläufen,

- Abstimmungen nehmen zu, ohne dass die Wertschöpfung im gleichen Maß wächst.

Das Problem ist nicht Hiring an sich, sondern die Reihenfolge. In vielen Fällen wird Hiring eingesetzt, um kurzfristig Druck rauszunehmen, obwohl das eigentliche Nadelöhr fehlende Klarheit ist. Wer einstellt, bevor Abläufe stabil sind, schafft zwar mehr Kapazität, skaliert aber auch Komplexität.

Prozesse als Voraussetzung für wirksames Wachstum

Prozesse werden in Start-ups häufig mit Bürokratie verwechselt. Tatsächlich sind sie das Gegenteil: Sie reduzieren Reibung. Gute Prozesse verlagern Entscheidungen vom Einzelfall ins System. Sie beantworten zwei zentrale Fragen zuverlässig: Was passiert als Nächstes – und wer ist verantwortlich?

Gerade kleine Teams profitieren davon besonders. Prozesse schaffen keine Starrheit, sondern Handlungsspielraum. Sie machen Arbeit vorhersehbar, Übergaben sauber und Entscheidungen reproduzierbar. Erst auf dieser Grundlage kann ein wachsendes Team seine Stärke wirklich entfalten.

Automatisierung im KI-Zeitalter: neue Möglichkeiten, neue Verantwortung

Mit KI hat sich die Eintrittshürde für Automatisierung massiv gesenkt. Viele Aufgaben, die früher manuell oder individuell erledigt wurden, lassen sich heute zuverlässig unterstützen oder teilweise abnehmen, vorausgesetzt, der zugrunde liegende Ablauf ist klar definiert. Entscheidend ist dabei nicht die Tool-Auswahl, sondern die Frage, was automatisiert wird. Automatisierung verstärkt bestehende Strukturen, gute wie schlechte. Wer unklare Abläufe automatisiert, skaliert keine Effizienz, sondern Chaos. Gleichzeitig gibt es zentrale Bereiche, die sich bewusst nicht oder nur sehr begrenzt automatisieren lassen und auch nicht sollten. Recruiting ist einer davon. Der Aufbau eines funktionierenden Teams lebt von persönlicher Einschätzung, Teamdynamik und kulturellem Fit. Ähnliches gilt für Sales: Vertrauensaufbau, Verhandlung und das persönliche Gespräch bleiben essenziell. Automatisierung ist hier unterstützend, aber kein Ersatz. Besonders geeignet sind Tätigkeiten, die häufig auftreten, wenig kreativen Spielraum haben und auf wiederkehrenden Informationen basieren.

Bereiche, die sich heute besonders gut automatisieren lassen

Lead- und Anfragequalifizierung

Unstrukturierte Anfragen lassen sich mithilfe von KI zusammenfassen, bewerten und priorisieren. Statt jede Anfrage manuell zu prüfen, entstehen klare Kriterien, die relevante von irrelevanten Leads trennen und Follow-ups vorbereiten.

Angebots- und Abrechnungsprozesse

Angebote, Verträge und Rechnungen folgen in vielen Startups ähnlichen Mustern. Automatisierte Vorlagen, angebundene Datenquellen und definierte Freigaben sparen Zeit, reduzieren Fehler und schaffen Transparenz.

Onboarding von Kund:innen und Mitarbeitenden

Onboarding ist kein Einzelfall, sondern ein wiederkehrender Prozess. Checklisten, automatische Aufgaben und zentrale Informationspunkte sorgen für Verlässlichkeit. KI kann helfen, Informationen zu strukturieren und kontextbezogen bereitzustellen.

Support und interne Anfragen

Ein Großteil von Fragen wiederholt sich. Wissensbasen in Kombination mit KI-gestützter Suche und Antwortvorschlägen entlasten Teams und machen sichtbar, wo Standards fehlen.

Projektmanagement und Übergaben

Klare Projekt-Templates, automatisierte Status-Updates und definierte Trigger reduzieren Abstimmungsaufwand. KI kann dabei unterstützen, Risiken früh zu erkennen oder nächste Schritte vorzuschlagen.

Was Start-ups daraus lernen können

Automatisierung ersetzt keine Entscheidungen, sie macht sie skalierbar. Voraussetzung dafür ist Klarheit über Abläufe, Verantwortlichkeiten und Prioritäten. Wer versucht, Chaos zu automatisieren, verstärkt es lediglich.

Hilfreiche Leitfragen sind:

- Welche Aufgaben wiederholen sich regelmäßig?

- Wo entstehen manuelle Engpässe?

- Welche Tätigkeiten binden qualifizierte Menschen ohne echten Mehrwert?

Die Antworten darauf liefern meist schnell die größten Hebel.

Der KI-Wendepunkt: Systeme und Personal

Nachhaltiges Wachstum entsteht dort, wo Start-ups Systeme aufbauen und diese bewusst mit ihrem Team verzahnen. Nicht, weil Systeme Menschen ersetzen, sondern weil sie Menschen von struktureller Überforderung entlasten. Automatisierung schafft dabei nicht nur Effizienz, sondern Entscheidungsqualität: Wenn Daten sauber fließen, Übergaben klar sind und Standards greifen, werden Prioritäten weniger Bauchgefühl und stärker reproduzierbar.

Der gezielte Einsatz von KI-Tools verschiebt diesen Wendepunkt zusätzlich. Sie können Routinearbeiten abfangen, Informationen aus unstrukturierten Inputs verdichten und Entscheidungen vorbereiten – etwa durch Lead-Vorqualifizierung, Support-Clustering oder zusammengefasste Status-Updates. KI wirkt dabei nicht als Ersatz für Klarheit, sondern als Verstärker funktionierender Prozesse.

Hiring bleibt auch weiterhin essentiell. Seine Wirkung entfaltet es jedoch erst dann vollständig, wenn Prozesse klar sind und Automatisierung sowie KI gezielt unterstützen. So entsteht Wachstum, das nicht nur schneller, sondern auch gesünder ist.

Der Autor Markus Hetzenegger ist Gründer & CEO von NYBA Media. 2018 gegründet, zählt NYBA heute zu den führenden Marketing-Unternehmen im Live-Entertainment.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

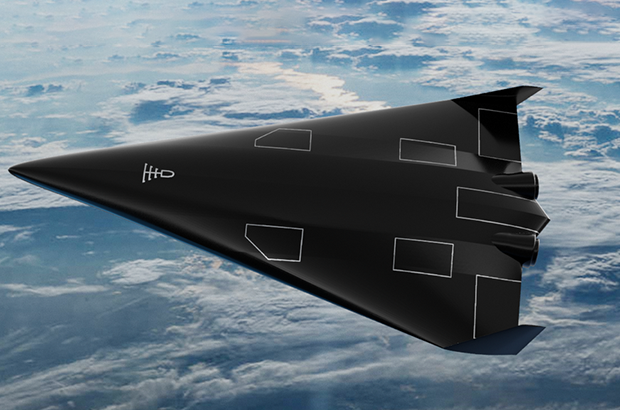

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

Diese 10 Start-ups bauen an der Zukunft der AgriFood-Branche

Die deutsche Start-up-Landschaft verzeichnete 2025 ein Rekordhoch bei Neugründungen. Doch gerade im AgriFood-Sektor ist der Weg vom Prototyp zum Marktführer steinig. Kapitalintensive Hardware und strenge Regulatorik bremsen viele aus. Der Growth Alliance Accelerator zeigt, wie Gründer*innen diese Hürden überspringen – und präsentiert zehn Akteure, die auf der Erfolgsspur sind.

Es ist ein Paradoxon: Die Nachfrage nach nachhaltigen Lebensmitteln und effizienter Landwirtschaft ist so hoch wie nie, doch für Gründer*innen und junge Unternehmen in der AgriFood-Branche bleibt der Markteintritt ein Hürdenlauf. Während Software-Start-ups oft mit geringem Kapital skalieren, kämpfen Food- und AgTech-Pioniere mit der „Hardware-Falle“. Sie benötigen teure Produktionsanlagen, Labore und müssen langwierige Zulassungsverfahren (z.B. Novel-Food-Verordnung) durchlaufen.

Dennoch ist die Branche im Aufwind: Laut dem Deutschen Startup Monitor und aktuellen Zahlen des Startup-Verbands stiegen die Gründungszahlen 2025 um beachtliche 29 Prozent. Das Kapital ist da, doch es fließt selektiv. Investor*innen suchen heute keine reinen Ideen mehr, sondern validierte Geschäftsmodelle mit technologischem Tiefgang (DeepTech). Genau hier setzte das Finale des Growth Alliance Accelerator 2025 am 28. Januar 2026 in Frankfurt/Main an.

Brückenschlag zwischen Acker und Finanzwelt

Initiiert vom TechQuartier und der Landwirtschaftlichen Rentenbank, hat sich der Accelerator als Schmiede für die „Scale-up“-Phase etabliert. Vier Monate lang wurden zehn Start-ups, die bereits eine Nutzer*innenbasis vorweisen konnten, fit für die nächste Finanzierungsrunde gemacht.

Das Programm adressierte genau die Pain Points der Branche: Verhandlungstaktik, Rechtsfragen und vor allem den Zugang zu Kapital. Ein Highlight war das Investor Dinner im November 2025, bei dem die Gründer*innen direkten Zugang zu Risikokapitalgeber*innen erhielten – in der aktuellen Marktphase ein entscheidender Wettbewerbsvorteil.

Die „Class of 2025“: Wer die Transformation treibt

Die zehn Absolvent*innen decken die gesamte Wertschöpfungskette ab – vom Boden über das Labor bis zum Supermarktregal. Hier ein Blick auf die Köpfe hinter den Innovationen:

1. High-Tech auf dem Acker: Robotik und Daten

Die Digitalisierung der Landwirtschaft (Smart Farming) ist der stärkste Hebel für mehr Effizienz.

Paltech GmbH

Die Brüder Felix und Florian Schiegg gründeten 2022 Paltech zusammen mit Jorge Decombe im Allgäu. Ihr autonomer Roboter für chemiefreie Unkrautbekämpfung im Grünland ist eine Antwort auf strengere Pestizid-Gesetze und Personalmangel.

Bacchus Software GmbH

Das 2023 gegründete Start-up bacchus Weinbau-Software um das Trio Maximilian Dick, Julian Herrlich und Philipp Bletzer digitalisiert den Weinbau. Ihre Software ersetzt das händische Fahrtenbuch und koordiniert die komplette Weinbergsarbeit.

Agrario Energy

Die Energiewende macht Landwirt*innen zu Energiewirt*innen. Seit 2023 bieten die Gründer Alexander von Breitenbach und Chris Weber mit Agrario Energy eine unabhängige Vergleichsplattform, die Flächeneigentümer mit Betreiber*innen von Erneuerbare-Energien-Anlagen zusammenbringt.

2. Deep Tech & Sicherheit: Das Labor als Wächter

Lebensmittelsicherheit wird durch globale Lieferketten immer komplexer. Hier setzen wissenschaftsbasierte Ausgründungen an.

NanoStruct GmbH

NanoStruct wurde 2021 als Spin-off der Universität Würzburg gegründet. Das Team nutzt Nanotechnologie, um gefährliche Bakterien in Lebensmitteln in Minuten statt Tagen aufzuspüren.

SAFIA Technologies

Gegründet 2020 von Timm Schwaar (aus der Bundesanstalt für Materialforschung), entwickelt das Berliner Start-up SAFIA Technologies Schnelltests für Mykotoxine (Schimmelpilzgifte). Ihre Technologie ermöglicht Laborqualität im Schnelltest-Format.

Landman.Bio

Das noch junge Unternehmen (Gründung 2023) Landman.Bio nutzt Bakteriophagen (Viren, die Bakterien fressen) als natürliche Waffe gegen Pflanzenkrankheiten – eine dringend benötigte Alternative zu Antibiotika und klassischen Pestiziden in der Nutzpflanzenzucht.

3. Sustainability & Climate: Kohlenstoff als Währung

CO2-Tracking ist kein Marketing-Gimmick mehr, sondern ökonomische Notwendigkeit.

CinSOIL

Das 2024 in Berlin gegründete CinSOIL-Team um Dr. Giorgi Shuradze, Dr. Antonella Succurro und Dr. Tavseef Shah kommt aus der Wissenschaft. Ihr KI-Tool nutzt Satellitendaten, um Bodenkohlenstoff zu erfassen. Das ermöglicht Agrarunternehmen, Dekarbonisierung nicht nur zu behaupten, sondern zu beweisen.

Niatsu

Gegründet 2023 von Marius Semm und Jakob Tresch in Zürich, adressiert Niatsu die Lebensmittelindustrie. Ihre Software berechnet den Product Carbon Footprint (PCF) automatisiert und kostengünstig, was gerade für den Mittelstand entscheidend ist.

4. Future Food

Was wir morgen essen (und trinken).

VANOZZA

Eines der etabliertesten Start-ups der Runde. Gegründet 2019 von Nico Hansen in Hamburg, hat sich Vanozza mit fermentierten Käsealternativen auf Cashew-Basis einen Namen gemacht und arbeitet nun an der „zweiten Generation“ ihrer Produkte.

food42morrow/JUMA

Die Frankfurter Gründer Raoul und Max Kammann sowie Carlos Lopez Granado gründeten die GmbH bereits 2020 und brachten 2022 ihre Marke JUMA (Tee-Eistees auf Guayusa-Basis) auf den Markt. Sie bedienen den Trend zu „Functional Food“.

Fazit

Die AgriFood-Start-ups des Abschlussjahrgangs des Growth Alliance Accelerators 2025 haben die Phase der reinen Ideen-Findung bereits eindrucksvoll gemeistert. Jetzt geht es um Skalierung, industrielle Anwendung und messbaren Impact. Programme wie die Growth Alliance sind dabei der Katalysator, der wissenschaftliche Exzellenz mit dem nötigen Geschäftssinn verbindet.

Social Engineering auf dem Vormarsch

Wie Deepfakes die Sicherheit von Führungskräften stärker in den Fokus rücken.

Fotorealistische KI liefert innerhalb von kürzester Zeit realistische Visuals. Was in vielerlei Hinsicht den Arbeitsalltag erleichtert, bedeutet für Social Engineering jedoch eine neue Eskalationsstufe, wie nicht zuletzt die hitzige Debatte um massenhaft sexualisierte Deepfakes von realen Personen durch Grok eindrücklich vor Augen führte.

Auch Personen in leitenden Funktionen in Unternehmen sind vor solchen Manipulationen nicht gefeit. Zunehmend zielen Angriffe auf Menschen mit Zugriffsrechten und Entscheidungsbefugnissen, deren Freigaben unmittelbare Wirkung auf die Sicherheit einer ganzen Organisation haben. „Fotorealistische KI und hybride Social-Engineering-Kampagnen erhöhen den Druck auf Schlüsselpersonen. Daher brauchen Unternehmen belastbare Verifikationsprozesse, Krisenroutinen und integrierte Schutzkonzepte“, erklärt Markus Weidenauer, geschäftsführender Gesellschafter der SecCon Group GmbH.

Deepfakes zielen auf privates Umfeld

Nach Angaben des Bundesamts für Sicherheit in der Informationstechnik (BSI) lassen sich Deepfakes als Verfahren beschreiben, die gezielt Spear-Phishing und andere Social-Engineering-Angriffe nutzen, um Vertrauen aufzubauen und Autorität zu simulieren. Generative KI fungiert dabei als zentraler technischer Enabler, da sie die realistische Erzeugung manipulativer Audio-, Video- und Textinhalte erstmals in industriellem Maßstab ermöglicht. „Die eigentliche Bedrohung ergibt sich dabei nicht aus einzelnen KI-generierten Inhalten, sondern aus deren koordinierter Nutzung“, weiß der Sicherheitsexperte.

Infolge der steigenden Qualität und der zunehmenden Verfügbarkeit generativer KI wird es darüber hinaus zunehmend schwieriger, Fakt von Fiktion zu unterscheiden „Zwar können isolierte Inhalte für sich betrachtet zweifelhaft sein, doch das konsistente Zusammenspiel mehrerer manipulierter Medieninhalte erhöht die wahrgenommene Glaubwürdigkeit erheblich“, ergänzt der Profi und weist darauf hin, dass sich diese Entwicklung in der Praxis zuspitzt. „Social Engineering, Deepfakes und digitale Erpressung werden immer häufiger mit Observationen des privaten Umfelds sowie Angriffen auf die Heim-IT kombiniert. Durch diese Eskalation der Angriffsmittel bauen Täter gezielt psychologischen Druck auf, der die Widerstandsfähigkeit der Betroffenen weiter reduziert.“

Risiken kennen, Wege einüben

Kompromittierte Schlüsselpersonen mit Steuerungs- und Entscheidungsfähigkeiten bergen hohes Schadenspotenzial für Betriebe. Das reicht von unmittelbaren finanziellen Verlusten bis zu dauerhaften Reputationsschäden. Dieses Risiko wird insbesondere dort verstärkt, wo organisatorische und prozessuale Absicherungen fehlen. „Resilienz bedeutet aber, auch in potenziellen Krisensituationen sichere Entscheidungen treffen zu können“, betont Markus Weidenauer. Trotzdem mangelt es vielen Unternehmen sowohl an speziellen Trainings zum Thema Social Engineering als auch an Meldewegen, klaren Freigabeprozessen, die auch unter Druck funktionieren, sowie alternativen Kommunikationskanälen. „Nur wenn Mitarbeiter diese Strukturen kennen und regelmäßig einüben, entsteht eine Kultur, in der eine frühzeitige Eskalation in der Meldekette als notwendiger Beitrag zur Sicherheit des gesamten Betriebs wahrgenommen wird“, fügt Markus Weidenauer hinzu.

Dringender Handlungsbedarf in Unternehmen

Um hier Abhilfe zu schaffen, verabschiedete im September 2025 das Bundeskabinett das sogenannte KRITIS-Dachgesetz zur Stärkung der Resilienz kritischer Einrichtungen. Es verpflichtet die Unternehmensleitung, Schutz- und Präventionsmaßnahmen umzusetzen, deren Wirksamkeit nachzuweisen ist. Der dem Regelwerk zugrunde liegende All-Gefahren-Ansatz fordert, dabei physische, digitale und organisatorische Dimensionen gemeinsam zu betrachten. „Auch wenn Führungskräftesicherheit hier kein eigener Rechtsbegriff ist, sollte sie Teil der Anforderungen an ein modernes Sicherheitsmanagement sein“, so der Geschäftsführer der SecCon Group.

Das bedeutet: Führungskräfte etwa vor Erpressungsversuchen durch Social Engineering zu schützen, ist weder persönlicher Luxus noch Symbolpolitik, sondern ein Element der nachweisbaren Unternehmensresilienz. Schließlich ist die Sicherung von Steuerungs- und Entscheidungsfähigkeit ein Governance-Baustein. Nicht die Person steht im Mittelpunkt, sondern die Handlungsfähigkeit des Instituts.