Aktuelle Events

Antivirusprogramm für Kreditkarten

Nachdem Yaron Samid vor einiger Zeit vor einer Firma gewarnt worden war, die monatlich Geld per Kreditkarte in Rechnung stellen würde, ohne eine Gegenleistung dafür zu erbringen, stellte er fest, dass diese Firma für sechs Monate jeweils 12 US-Dollar pro Monat von seiner Kreditkarte abgebucht hatte, ohne dass er den Betrug bemerkt hatte.

Laut Samid passiert sowas neun von zehn Kreditkartenbesitzern. Aber auch seriöse Firmen buchen häufig unrechtmäßige Gebühren ab. So entsteht in den USA nach Recherchen von Samid jährlich ein Schaden von über 7 Mrd. Dollar.

Das müsste aber nicht sein. Denn täglich berichten Zehntausende in Foren über unrechtmäßigen Kreditkartenabbuchungen. Man muss nur darauf aufmerksam werden. Dafür sorgt jetzt das Start-up Billquard, das Samid mit Partnern gegründet hat. Man kann kostenfrei ein Konto bei Billquard anmelden, nachdem man seine Kreditkartennummern hinterlassen hat. Billguard überprüft täglich die Abbuchungen von der Karte und informiert bei Unregelmäßigkeiten, die durch mehr als 100 Tests bzw. durch Meldungen im Internet oder von anderen Billguard-Nutzern erkannt werden.

Diese Artikel könnten Sie auch interessieren:

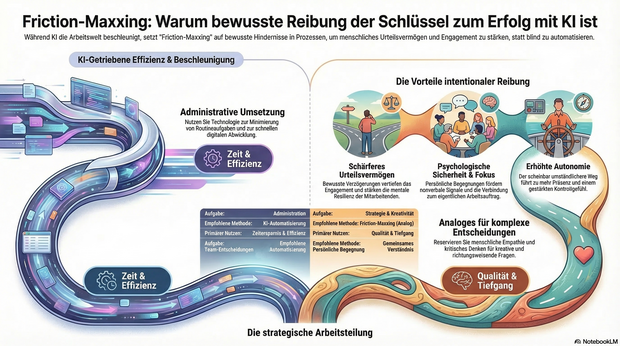

KI-Müdigkeit im Team? Warum Friction-Maxxing jetzt die Antwort ist

Nach all der Euphorie über KI-Tools macht sich bei immer mehr Menschen eine gewisse KI-Müdigkeit breit. Die Technologie hat die Arbeitswelt im Sturm erobert – doch in Unternehmen wachsen die Zweifel: Macht KI wirklich alles einfacher oder trägt sie sogar zu sinkendem Engagement bei? Dr. Arne Sjöström von Culture Amp erklärt, warum Unternehmen jetzt auf Friction-Maxxing setzen sollten.

Friction-Maxxing ist ein Trend aus dem Lifestyle-Bereich, der jedoch auch großes Potenzial für die Arbeitswelt und den strategischen Einsatz von KI in Unternehmen hat. Gemeint ist damit ein Verhalten, bei dem man bewusst mehr kleine Hindernisse und Hürden in Arbeitsprozessen akzeptiert.

Der große Vorteil: Durch eine bewusste Verzögerung wird das Urteilsvermögen geschärft, das Engagement vertieft und die mentale Resilienz der Mitarbeitenden gestärkt.

Friction-Maxxing als Gegengewicht zur KI-Dominanz

Insbesondere für Führungskräfte und das mittlere Management bietet Friction-Maxxing die Möglichkeit, produktive Reibung in Entscheidungsprozesse zurückzubringen. Durch die Rückkehr zu mehr persönlichen Begegnungen und analogen Arbeitsabläufen entstehen Dinge, die in digitalen Formaten schlicht verloren gehen:

- Konzentrierte Aufmerksamkeit.

- Psychologische Sicherheit.

- Wichtige nonverbale Signale.

Persönliche Begegnungen ermöglichen einen konstruktiven Austausch und helfen Teams dabei, ein gemeinsames Verständnis von Qualität zu entwickeln. Am Ende geht es nicht darum, unnötige Hürden aufzubauen, sondern das richtige Maß an „Reibung“ zu gestalten: Analoges für einen besseren Umgang mit Ambiguität, Kreativität und richtungsweisenden Entscheidungen – Digitales für die Umsetzung.

Fokus und Sinnhaftigkeit zurückerobern

Positive Reibung kann als dringend benötigtes Gegengewicht zur KI-getriebenen Beschleunigung in der Arbeitswelt fungieren und den Fokus wiederherstellen. Sei es durch das gründliche, manuelle Überdenken eines Briefings oder den bewussten Wunsch nach persönlichem Austausch anstelle eines asynchronen Chats. Wer sich Zeit zum Denken, Begegnen und Gestalten zurückerobert, ermöglicht es Teams, sich wieder mit ihrem eigentlichen Auftrag und ihren Ansprüchen zu verbinden – Qualitäten, die KI-Automatisierung allein niemals erreichen kann.

Dieses geänderte Verhalten führt zu mehr Präsenz, weniger Angst und einem gestärkten Gefühl der Kontrolle. Der bewusst gewählte, nur scheinbar umständlichere Weg kann somit zu mehr Autonomie und tieferer Zufriedenheit am Arbeitsplatz beitragen.

Ein Plädoyer für intentionale Reibung

Die Aufgabe moderner Führungskräfte ist es daher, bei menschenzentrierten Tätigkeiten ganz bewusst sogenannte intentionale Reibung herbeizuführen und KI parallel dazu zu nutzen, den täglichen administrativen Arbeitsaufwand zu minimieren.

Unternehmen müssen klar benennen, wo KI ihre Stärken hat und eingesetzt werden soll – und wo menschliche Fähigkeiten wie Empathie, Urteilsvermögen und kritisches Denken absolut unersetzlich sind. So gibt man Mitarbeitenden die Möglichkeit, sich auf die Arbeit zu konzentrieren, die wirklich zählt und echten Mehrwert schafft.

Friction-Maxxing ist somit weniger ein Plädoyer gegen die Technologie, sondern vielmehr ein Aufruf zur Intentionalität: Dem bewussten Abwägen darüber, wann Prozesse automatisiert werden sollten und wann gerade der Widerstand den entscheidenden Unterschied machen kann.

Der Autor Dr. Arne Sjöström ist Regional Director, People Science EMEA bei Culture Amp. Sein Schwerpunkt liegt in der Organisationspsychologie und der angewandten Forschung.

StartingUp-DeepTech-Watchlist 2026

Von „German Engineering“ zu „German DeepTech“: Diese jungen Start-ups und Scale-ups zünden 2026 die nächste Stufe – und sollten zwingend auf dem Radar von Investor*innen und Entscheider*innen stehen.

„Prognosen sind schwierig, vor allem, wenn sie die Zukunft betreffen.“ Dieser Ausspruch unterstreicht die Herausforderung, die Dynamik unseres Start-up-Ökosystems vorherzusagen. Doch wer 2025 aufmerksam verfolgt hat, der spürt: Es hat sich etwas gedreht. Der Investor*innenfokus hat sich verschoben – weg von reinen E-Commerce-Modellen, hin zu substanzieller Technologie, die echte physikalische Probleme löst.

Die folgende Auswahl an Start-ups und Scale-ups, mit denen 2026 gerechnet werden sollte, ist mehr als eine Watchlist. Sie basiert auf einer Analyse der signifikanten Finanzierungsrunden 2025, der technologischen Reife und der Resonanz bei bedeutenden Preisen. Diese Unternehmen stehen beispielhaft für eine Gründer*innengeneration, die Wissenschaft und Skalierung vereint. Natürlich bleibt ein Restrisiko. Unwägbarkeiten – von geopolitischen Instabilitäten über regulatorische Verschärfungen wie dem EU AI Act bis hin zu volatilen Zinsmärkten – können die nahe Zukunft beeinflussen. Doch die Resilienz dieser Unternehmen stimmt optimistisch.

DefenseTech: Die neue Realität der Sicherheit

Lange war Verteidigungstechnologie in Deutschland ein Tabuthema für Risikokapitalgeber. Das hat sich grundlegend geändert. Ganz oben auf der Watchlist steht neben dem Münchner Start-up Helsing nun das 2024 gegründete Black Forest Labs. Das Geschäftsmodell ist faszinierend, weil es die Grenzen zwischen kreativer Zerstörung und Sicherheitstechnologie verwischt. Es basiert auf der Entwicklung proprietärer State-of-the-Art-Modelle für generative Videoerzeugung. Nach einer spektakulären 300-Mio.-USD-Runde im Dezember 2025 katapultierte sich die Bewertung auf satte 3,25 Milliarden USD. Das Start-up ist damit Deutschlands wertvollste KI-Firma und beweist, dass Europa bei Generative AI den Anschluss nicht verloren hat. Der globale Siegeszug deutet sich 2026 unter anderem in einem mehrjährigen Vertrag mit Meta sowie in Kooperationen mit US-Plattformen wie X und Hollywood-Studios an, die Produktionskosten senken wollen. Mitgründer Robin Rombach prognostizierte im Sifted-Podcast: „2026 wird generative Video-KI zum industriellen Standard in der Medienproduktion.“ Doch auch bei der Simulation für Sicherheitsszenarien spielt die Technologie eine wachsende Rolle.

Ein weiterer Schlüsselakteur ist Stark Defence. Das 2024 gegründete Münchner Start-up adressiert eine Lücke der modernen Kriegsführung: asymmetrische Bedrohungen. Stark Defence fokussiert sich auf softwaredefinierte, autonome Drohnensysteme, die „on the edge“ entscheiden und nicht auf ständige Funkverbindung angewiesen sind. Dass das Start-up durch seine KI-Schwarmtechnologie massiv an Bedeutung gewinnen wird, hat sich Ende Februar 2026 eindrucksvoll bestätigt: Der Haushaltsausschuss des Bundestages gab einen Auftrag über 540 Millionen Euro für Kampfdrohnen frei, den sich Stark Defence (Modell „Virtus“) und das nach einer Mega-Runde im Sommer 2025 mittlerweile mit 12 Milliarden Euro bewertete Münchner Unicorn Helsing (Modell „HX-2“) teilen. Um diese rasante Skalierung zu stemmen, hat Stark Defence kürzlich das Berliner Software-Start-up Pleno übernommen und eine neue Serienfertigung im britischen Swindon eröffnet. Mitgründer Florian Seibel dazu: „Unser Ziel für 2026 ist die erste vollautonome Verteidigungslinie für Europa.“

Better Sol: Zweites Leben für die Solarwende

Wie das 2023 von Mirko Laube und Luisa Schulze gegründete Start-up Better Sol den PV-Gebrauchtmarkt aufmischen will.

Das Braunschweiger Start-up Better Sol erhält rund 125.000 Euro Förderung aus dem „Green Startup“-Programm der Deutschen Bundesstiftung Umwelt (DBU), um gebrauchte Solarpaneele in großem Stil zurück in den Markt zu bringen.

Hinter dem Start-up stehen Luisa Schulze und Mirko Laube. Better Sol entstand ursprünglich im Sommer 2022 als Ausgründung des Magdeburger Recycling-Unternehmens Solar Materials und agiert seit 2023 als eigenständige GmbH am Standort Braunschweig. Während sich die ehemalige Muttergesellschaft auf das komplexe werkstoffliche Recycling von Modulen konzentriert, widmet sich Better Sol voll und ganz dem „Second Life“ – also der direkten Wiederverwendung der noch intakten Platten.

KI-gestützte Prüfung statt Schredder

Die Beschaffungsseite von Better Sol zielt primär auf große Solarparks ab. Die Betreiber tauschen dort häufig größere Mengen an Solarmodulen recht früh in ihrem Lebenszyklus durch neuere, leistungsstärkere Modelle aus. Um diese Module vor dem Müll zu bewahren, hat das Better-Sol-Team mittels DBU-Förderung ein in Teilen automatisiertes Testsystem mit eigener Software auf Basis künstlicher Intelligenz (KI) entwickelt.

Der Prüfprozess beginnt mit einer mehrstufigen optischen Untersuchung, bei der sowohl grobe Beschädigungen als auch jede Solarzelle einzeln begutachtet werden. Im Anschluss folgen eine eingehende Prüfung der elektrischen Sicherheit sowie eine Leistungsüberprüfung, die misst, wie viel Watt das Produkt im Vergleich zur ursprünglichen Leistung noch liefert. Die Software führt all diese Daten automatisiert zu einer detaillierten Leistungsprognose zusammen. Jedes funktionstüchtige Modul erhält ein Label mit den Testdaten, einer zugewiesenen Leistungsklasse und einem umfangreichen Prüfprotokoll. Nur der endgültige Rest wird zum Recycling aussortiert. Der Vertrieb erfolgt direkt über die Internetseite von Better Sol. Zielgruppe sind oft Privathaushalte oder die Dächer größerer Fabrikhallen.

Der Markt und die Technologie im Wettbewerbsvergleich

Nach Angaben des Statistischen Bundesamtes verbucht die Photovoltaik mittlerweile einen Anteil von etwa 24 Prozent und ist damit der zweitwichtigste Energieträger der inländischen Stromerzeugung. Das Reservoir an ausgemusterten, aber noch funktionierenden Modulen wächst rasant. Laut Schulze ist im Schnitt jedes zweite gebrauchte Solarmodul noch für eine erneute Nutzung geeignet. Doch der Gebrauchtmarkt professionalisiert sich zusehends.

Better Sol setzt aktuell auf eine pragmatische, KI-gestützte Teilautomatisierung und plant als nächsten logischen Entwicklungsschritt eine mobile Testanlage, um die Solarmodule direkt dort zu testen, wo sie ausgemustert werden. Genau in diesem logistisch entscheidenden Bereich der Vor-Ort-Prüfung operiert bereits der etablierte Wettbewerber 2ndlifesolar, eine Marke der großen Buhck Gruppe. 2ndlifesolar greift auf ein deutschlandweites Logistiknetzwerk zurück und kombiniert stationäre Erstbehandlungsanlagen mit mobilen Prüflaboren. Technologisch geht das Unternehmen tief in die industrielle Qualitätssicherung und führt standardmäßig Elektrolumineszenz-Prüfungen durch, um unsichtbare Mikrorisse im Vorfeld zu detektieren.

Einen völlig anderen, stark hochskalierten Weg bestreitet das österreichische CleanTech-Start-up 2nd Cycle. Das Unternehmen betreibt eine vollautomatische Inspektions- und Upcycling-Anlage im industriellen Hochdurchsatz und nutzt neben klassischer Robotik auch patentierte hyperspektrale Analysen aus der Raumfahrt, um Zellalterungen frühzeitig zu erkennen.

Der Schlüssel zum wirtschaftlichen Erfolg

Das Vorhaben von Better Sol leistet einen fundamentalen Beitrag, um noch leistungsfähige Materialien durch geschickte Kreislaufwirtschaft für eine Weiternutzung zu erhalten, damit die Bemühungen für mehr erneuerbare Energien nicht ins Stocken geraten. Dennoch muss sich das Geschäftsmodell in einem harten Wettbewerb beweisen.

Die Handwerkerkosten für den Aufbau einer PV-Anlage auf einem Eigenheim sind hoch und fallen völlig unabhängig davon an, ob man neue oder gebrauchte Paneele installiert. Gleichzeitig steht der Markt unter enormem Preisdruck durch historisch günstige asiatische Neuware. Wenn fabrikneue Module extrem billiger werden, schwindet das Argument der finanziellen Ersparnis bei Gebrauchtmodulen mit kürzerer Restlebensdauer. Der Schlüssel zum wirtschaftlichen Erfolg von Better Sol liegt daher in der rigorosen Minimierung der eigenen Logistik- und Prozesskosten. Die geplante mobile Testanlage und die zusätzliche Automatisierung des Testsystems sind für das Start-up essenziell, um künftig auch größere Ausmusterungen von Solarparks wirtschaftlich bewältigen zu können.

Die Müsli-Macher und die Kälte: Das neue Millionen-Projekt von Kraiss & Mahler

Dass sie Märkte revolutionieren können, haben die Freda-Gründer bereits bewiesen – nun steht die Tiefkühlkette auf dem Prüfstand. Mit einem mutigen Modul-Konzept fordern Philipp Kraiss und Christian Mahler die Industrie-Riesen im Supermarktregal heraus.

In der Start-up-Welt ist der Begriff Seriengründer*in oft ein zweischneidiges Schwert: Das Vertrauen der Investor*innen ist hoch, doch die Fallhöhe nach einem Erfolg wie mymuesli ebenso. Philipp Kraiss und Christian Mahler haben sich mit ihrem 2023 gegründeten Food-Start-up Freda bewusst gegen ein „Me-too-Produkt“ und für eine operative Wette auf die Zukunft der Tiefkühlkette entschieden. Mit einem mutigen Modul-Konzept fordern sie die etablierten Industrie-Riesen im Supermarktregal heraus. Die Prämisse: Der Markt für Tiefkühlkost (TK) wächst – auf über 22,6 Milliarden Euro im Jahr 2024 –, ist aber durch extremen Preisdruck und eine veraltete Produktlogik geprägt. Wir haben uns das Geschäftsmodell näher angesehen und die Gründer dazu befragt.

Pizza, Pasta, Gelato … und jetzt Blocks?

Die Pizza „Salami Sensation“ war für Freda der Türöffner. Mit dem Sieg bei Stiftung Warentest (2024) bewies das Team, dass es Qualität „kann“ und schuf einen starken USP. Strategisch ist Pizza jedoch kein leichtes Feld: Der Wettbewerb ist anspruchsvoll, die Regalplätze im Einzelhandel sind besetzt und die Differenzierung erfolgt meist über den Preis. Mit einer Innovation wie „Frozen Blocks“ erweitert Freda nun das Spielfeld und eröffnet eine neue Kategorie von Tiefkühlkost.

Es handelt sich dabei nicht mehr um ein fertiges Gericht, sondern um eine Systemkomponente. Das Konzept orientiert sich am gastronomischen „Mise en Place“: Vorbereitete, schockgefrostete Komponenten wie Beef Ragù oder Chili sin Carne fungieren als Basismodule für die heimische Küche. Strategisch gesehen erhöht dies die Wertdichte pro Kubikzentimeter im TK-Fach und verringert die Komplexität in der eigenen Produktion im Vergleich zu mehrkomponentigen Fertigmenüs.

Auf die Frage, ob der strategische Wechsel von der Pizza zu den „Frozen Blocks“ eine Flucht aus dem Commodity-Preiskampf der Pizza-Truhe hin zu einer proprietären Nische sei, widerspricht Philipp Kraiss. Vielmehr handele es sich um einen konsequenten Ausbau des Sortiments, denn Freda solle künftig den gesamten Alltag der Kund*innen abbilden – vom Frühstück bis zum Abendbrot. Das sei eben mehr als nur Pizza. „Unser Anspruch ist aber nicht nur Bekanntes besser zu machen – wie bei unserer Pizza, sondern auch neue Wege zu gehen“, stellt der Gründer klar. Die flexiblen Module seien auf diesem Weg der nächste logische Schritt. Er verspricht dabei maximale Vielfalt aus dem Gefrierfach, „denn jeder Block lässt sich vielfältig kombinieren.“

Die Retail-Herausforderung: Kaufland als Stresstest

Mit einer Basis von über 30.000 D2C-Kund*innen hat das Unternehmen bereits bewiesen, dass die Nachfrage nach seinen Produkten besteht. Um dieses Potenzial voll auszuschöpfen und die Margen zu stärken, wurde im August 2025 der Launch in 780 Kaufland-Märkten umgesetzt – ein strategischer Meilenstein, der die Reichweite massiv erhöht und über das Volumen des stationären Einzelhandels den Weg zu nachhaltigem, profitablem Wachstum ebnet – ohne aufwendigen Versand mit Isolierung und Trockeneis.

Hier zählt nun die Shelf Velocity (Abverkaufsgeschwindigkeit). Ein modulares System erfordert von der Kundschaft jedoch ein Umdenken: Man kauft kein fertiges Abendessen, sondern eine Zutat. Freda muss hier beweisen, dass der Mehrwert der Zeitersparnis am Point of Sale verstanden wird, bevor die harten Auslistungsmechanismen des Handels greifen.

Doch wie überzeugt man eine*n Einkäufer*in davon, dass ein modulares System mehr Flächenproduktivität bringt als die zehnte Sorte Standard-Lasagne? Christian Mahler kontert auf diese Retail-Frage mit einem anschaulichen Branchen-Vergleich: „Wir sind eben nicht die zehnte Lasagne. Eine klassische TK-Lasagne belegt viel Regalfläche, bedient genau einen Anlass und konkurriert mit neun anderen Lasagnen um denselben Kunden.“ Durch das kompakte Format und eine maximale SKU-Dichte der Blocks könne der Händler auf derselben Regalfläche mehrere Sorten listen und spreche damit dutzende Zubereitungsarten von der Bowl bis zum Curry an. Mahler zeigt sich selbstbewusst: „Wir eröffnen eine neue Kategorie statt in einer bestehenden zu kämpfen.“

Operative Exzellenz vs. bayerisches Handwerk

Ein weiterer Spagat wartet in der Produktion: Freda wirbt offensiv mit „Made in Bavaria“ und handwerklicher Herstellung. In der Start-up-Praxis beißt sich Handwerk jedoch oft mit Skalierung. Wer bundesweit fast 900 Supermärkte bedient, muss industrielle Prozesse beherrschen. Die Gefahr dabei ist offensichtlich: Wenn die Qualität durch die Masse sinkt, verliert Freda seinen wichtigsten USP. Gleichzeitig bleibt bei der exklusiven Zielgruppe, die bereit ist, für TK-Komponenten Premium-Preise zu zahlen, in Zeiten der Inflation die Frage der Preissensibilität bestehen.

Auf drohende Kapazitätsgrenzen angesprochen, räumt Philipp Kraiss ein, dass die Passauer Manufaktur zwar das Herzstück bleibe. „Aber wir waren von Anfang an ehrlich zu uns selbst: Eine Manufaktur skaliert nicht linear“, gibt der Seriengründer zu bedenken. Mit wachsendem Geschäft müsse man die Produktion auf breitere Schultern stellen und mit Partnern zusammenarbeiten. Sein Kernversprechen an die Kund*innen lautet dabei jedoch: „Wir lagern nicht die Rezeptur aus, sondern die Kapazität.“

Marktpsychologie: Convenience ohne Reue

Psychologisch besetzt Freda damit eine überaus geschickte Lücke. Die „Frozen Blocks“ nehmen der Käuferschaft zwar die Entscheidung für die aufwendige Kernkomponente ab, lassen das Gefühl des Selbstkochens durch das frische Ergänzen von Beilagen jedoch vollkommen intakt. Dies eliminiert die oft vorhandene „Convenience-Scham“ gesundheitsbewusster Zielgruppen und könnte die Lösung für die stagnierenden Marktanteile klassischer Fertiggerichte bei jüngeren Konsument*innen sein.

Fazit für die Start-up-Praxis

Freda ist ein Lehrstück für den Übergang von einer digitalen D2C-Brand zum Player im Massenmarkt. Die Gründer nutzen ihre Erfahrung, um eine etablierte Kategorie neu zu denken. Ob die Rechnung aufgeht, wird sich an der Regal-Rotation zeigen. Wenn die Kund*innen den Aufpreis für die „bayerische Handarbeit“ und das modulare System dauerhaft akzeptieren, könnte Freda die Blaupause für die nächste Generation von Food-Marken liefern.

Distart: Vom Agentur-Frust zum EdTech-Champion

Wie das 2021 von Thomy Roecklin gegründete und seit 2025 zusammen mit Lucia-Miriam Selbert geführte Leipziger EdTech Distart das Bildungssystem „gegen den Strich bürstet“.

Wer in Deutschland über Start-up-Hubs spricht, landet meist schnell in Berlin oder München. Doch in der sächsischen Metropole Leipzig wächst seit einigen Jahren ein Player heran, der beweist, dass Innovation auch abseits der üblichen Verdächtigen gedeiht: Die Distart Education GmbH. Ihr Treibstoff ist der eklatante Mangel an digitaler Kompetenz in der deutschen Wirtschaft – und der Mut, das „System Bildung“ gegen den Strich zu bürsten.

Wenn „Done for You“ nicht mehr reicht

Die Wurzeln des Unternehmens reichen weiter zurück als das offizielle Gründungsjahr 2021. Gründer Thomy Roecklin setzte jahrelang mit seinen Agenturen MNKY lab und TRDIGITAL digitale Kampagnen für Kund*innen um. Doch im Tagesgeschäft bremste das fehlende Digitalverständnis auf Kundenseite die Projekte immer wieder aus. Die Erkenntnis, dass Deutschland weniger neue Agenturen, sondern mehr digitale Mündigkeit braucht, führte schließlich zum Pivot.

Interessanterweise war der Auslöser für diesen Kurswechsel kein konkretes Kundenprojekt. Auf die Frage nach dem „Aha-Moment“ erklärt Roecklin, dass er lediglich versuchte, Lucia-Miriam Selbert einzuarbeiten, und dabei schockiert feststellte, wie wenig praxisnahe digitale Weiterbildungen existierten. Er baute kurzerhand selbst ein Lernprogramm – ohne zu ahnen, dass daraus einmal Distart entstehen würde. Im Januar 2021 fiel der Startschuss für Distart learn. Mitten in der Pandemie setzte Roecklin auf ein Modell, das sich radikal von klassischen Bildungsträgern unterschied: 100 Prozent remote, aber mit enger persönlicher Betreuung und einem klaren Fokus auf die Praxis.

Das Schnellboot zwischen den Tankern

Distart operiert im sogenannten AZAV-Markt (Akkreditierungs- und Zulassungsverordnung Arbeitsförderung). Während etablierte Bildungsriesen oft mit der Trägheit ihrer Größe kämpfen und bis zu 24 Monate für Lehrplananpassungen benötigen, hat sich Distart als agiler „Qualitäts-Vorreiter“ positioniert.

Für Roecklin ist diese Agilität eine Frage des Überlebens, da sich Jobs und Skills heute schneller verändern als jede klassische Bildungslogik. Er betont, dass man ohne permanente Weiterentwicklung der Inhalte zwangsläufig am Markt vorbei ausbilden würde. Diese Flexibilität ist zudem essenziell für die Zielgruppe: Viele Teilnehmende bilden sich neben ihrem 9-to-5-Job weiter, betreuen Kinder oder pflegen Angehörige und benötigen daher flexible statt starrer Strukturen.

Agency-DNA statt Schulbank-Feeling

Der entscheidende Wettbewerbsvorteil liegt in der Herkunft: Distart ist keine klassische Schule, sondern wurde von Marketern für Marketer gebaut. Diese „Agency-DNA“ durchzieht das gesamte Geschäftsmodell. Mit einer modernen Lernumgebung aus Live-Sessions und asynchronen Deep-Dives spricht das Unternehmen alle Altersgruppen gleichermaßen an.

Auch technologisch ist man der Konkurrenz oft einen Schritt voraus: Als ChatGPT Ende 2022 die Arbeitswelt veränderte, reagierte Distart fast in Echtzeit. Auf die kritische Frage, ob KI das vermittelte Wissen nicht bald obsolet mache, findet Roecklin eine klare Antwort: KI ersetzt keine Menschen, sie ersetzt lediglich Mittelmaß. Während KI das Netz mit generischen Inhalten flutet, steige paradoxerweise der Hunger nach echten Stimmen, Ideen und Perspektiven – Marketing werde also menschlicher.

Bootstrapping und gesundes Wachstum

Der Erfolg gibt dem Konzept recht. Im September 2024 erfolgte die Umfirmierung zur Distart Education GmbH, was den Übergang vom Start-up zum etablierten Bildungsinstitut markierte. Während andere Tech-Unternehmen Personal abbauen mussten, verdoppelte Distart seine Belegschaft beinahe auf über 100 Köpfe und bezog im Oktober 2025 neue Räumlichkeiten im NEO Leipzig.

Besonders bemerkenswert: Das Wachstum ist organisch und gebootstrapped – finanziert aus dem eigenen Cashflow ohne externe Risikokapitalgeber. Das macht Distart unabhängig von Exit-Druck. Seit Februar 2025 verstärkt Lucia-Miriam Selbert als Geschäftsführerin die strategische Ausrichtung.

Dennoch birgt die Skalierung Risiken, da das Geschäftsmodell stark von staatlichen Bildungsgutscheinen abhängt. Auf einen möglichen „Plan B“ angesprochen, erklärt das Unternehmen, dass Förderungen zwar beim Beschleunigen helfen, man Distart aber bewusst so aufbaue, dass langfristig strukturelle Unabhängigkeit erreicht wird. Auch die Qualitätssicherung bei über 100 Mitarbeitenden ist eine Herausforderung. Thomy Roecklin gibt offen zu, dass Wachstum kein Wellnessprogramm ist und es im Getriebe zwangsläufig knirscht. Sein Schlüssel: Qualität darf nicht an Einzelpersonen hängen, sondern muss im gesamten System verankert sein, kombiniert mit echtem Vertrauen in das Team statt Kontrolle.

Der Standort als Statement und Vision

Dass Distart in Leipzig verwurzelt bleibt, ist Teil der Identität. Roecklin sieht im Osten Deutschlands ein enormes, oft unterschätztes Potenzial und erlebt dort viel Talent, Pragmatismus und Lernhunger. Distart versteht sich hier auch als Regionalentwickler.

Die Vision der Gründer geht jedoch über reine Kurse hinaus. Unterstrichen durch Auszeichnungen wie „Top Fernschule 2025“ und „2026“, arbeitet das Team nun an der Gründung der Distart University of Applied Sciences. Das Ziel bis 2030 ist ambitioniert: Ein Alumni-Netzwerk von 25.000 Absolvent*innen. Sollte der komplexe Weg zur staatlichen Anerkennung gelingen, wird Distart endgültig zum gewichtigen Faktor für die digitale Wettbewerbsfähigkeit der Bundesrepublik.

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

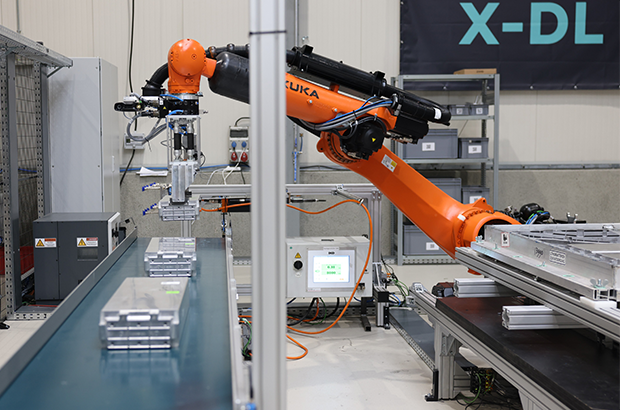

ChatGPT schreibt Texte. R3 Robotics zerlegt Batterien

Es gibt Probleme, die man mit Software lösen kann, und es gibt Probleme, für die man sich die Hände schmutzig machen muss – oder besser: Roboterhände nutzt. Antoine Welter und Dr. Xavier Kohll haben mit Circu Li-ion begonnen, um Batterien zu retten. Jetzt, unter dem neuen Namen R3 Robotics und mit 20 Millionen Euro frischem Kapital im Rücken, treten sie an, um den wohl größten Flaschenhals der kommenden Mobilitätswende zu beseitigen. Ihr Ansatz: Keine teuren Spezialmaschinen, sondern intelligente Standard-Roboter, die sehen, verstehen und sicher zupacken.

Wenn in den Vorstandsetagen der Automobilhersteller über die Zukunft gesprochen wird, geht es meist um Reichweiten und Software-Defined Vehicles. Doch am anderen Ende der Wertschöpfungskette braut sich ein Sturm zusammen. Millionen von Elektrofahrzeugen werden in den kommenden Jahren ihr Lebensende erreichen. Die derzeitige Realität in vielen Recyclinghöfen wirkt dagegen fast archaisch: Menschen, die mit Handwerkzeugen komplexe Systeme auseinanderschrauben. Das ist nicht nur teuer und schwer skalierbar, sondern bei Hochvolt-Systemen auch lebensgefährlich.

Genau hier setzen Antoine Welter und Xavier Kohll an. Die Nachricht, die das deutsch-luxemburgische Unternehmen Anfang Februar 2026 verkündete, ist mehr als nur eine Finanzierungsrunde. Die 20 Millionen Euro – aufgeteilt in 14 Millionen Euro Series-A-Kapital und 6 Millionen Euro öffentliche Fördergelder – heben die Gesamtfinanzierung des Unternehmens auf ein neues Level. Angeführt wird die Runde von HG Ventures und Suma Capital, unterstützt von Co-Investoren wie der Oetker Collection und dem EIC Fund.

Doch das Geld ist nur der Treibstoff für eine strategische Evolution. Aus Circu Li-ion wird R3 Robotics. Der neue Name ist Programm: Repair, Reuse, Recycle. Antoine Welter erklärt die Motivation hinter der Umbenennung pragmatisch: „Circu Li-ion hat beschrieben, wo wir angefangen haben. R3 Robotics beschreibt, was wir aufbauen: industrielle Robotik, die Demontage skalierbar, sicher und kosteneffizient macht.“

Wenn der Roboter Augen bekommt

Die größte Hürde im Recycling ist nicht die Chemie, sondern die Variabilität. Kein Batteriepack gleicht dem anderen, E-Motoren sind unterschiedlich verbaut, Schrauben sind korrodiert. Starre Fertigungsstraßen scheitern hier. R3 Robotics löst dies mit einer Plattform, die Computer Vision, künstliche Intelligenz und Robotik verschmilzt.

Das System fungiert dabei fast wie ein „ChatGPT für die physische Welt“: Anstatt Text zu generieren, plant die KI physische Handlungen. Sensoren scannen das Bauteil, die KI erkennt den Zustand und promptet den Roboterarm dynamisch durch den Demontageprozess. Der entscheidende Vorteil: Der Mensch wird aus der Gefahrenzone der Hochspannung genommen, während der Roboter Aufgaben erledigt, die für klassische Automatisierung zu komplex wären.

Angesprochen auf den Vergleich mit Generative AI und die Frage, wie die Roboter tatsächlich „sehen“ und „entscheiden“, bestätigt Welter die Parallele: „Der Vergleich mit Generative AI passt gut: Das Modell bekommt einen Input – keinen Text, sondern einen Scan des Bauteils – und generiert daraus eine Handlungssequenz.“ Es gehe darum zu erkennen, um welches Modell es sich handelt, wie der Zustand ist und wo die Verbindungspunkte liegen. „Das klingt simpel, ist es aber nicht – kein Pack ist identisch“, so Welter. Die eigentliche Herausforderung liege jedoch in der Entscheidung davor: „Welche Reihenfolge ist sicher? Ein falscher Griff an ein Hochvoltsystem kann tödlich sein. Unser System sieht, bewertet und entscheidet.“

Smart Hardware: Warum das Rad neu erfinden?

Ein Detail, das Investor*innen besonders aufhorchen lässt, ist die Kapitaleffizienz der Gründer. Wer an Industrie-Robotik denkt, denkt an teure Hardware-Entwicklung. R3 Robotics geht einen pragmatischen Weg: Ein Großteil der verwendeten Hardware wird „von der Stange“ gekauft.

Die Roboterarme sind Standardprodukte. Die Innovation – und damit das geistige Eigentum – steckt in den spezialisierten „End-Effektoren“ (den Roboterhänden), den Sensorsystemen und vor allem dem Software-Stack, der alles steuert. Das erlaubt eine Skalierung, die mit proprietärer Hardware kaum möglich wäre. Mitgründer Dr. Xavier Kohll betont, dass dies eine bewusste Entscheidung gegen „Over-Engineering“ war: „Der Roboterarm ist Standard und die Intelligenz sitzt in den Endeffektoren, der Sensorik und dem Software-Stack, der alles zusammenbringt. Das ist unser geistiges Eigentum, und genau das lässt sich skalieren.“

David gegen Goliath – oder Partner?

Während große Recycling-Konzerne oft noch auf den Schredder setzen und die manuelle Demontage an ihre Grenzen stößt, positioniert sich R3 Robotics in einer neuen Nische. Es geht nicht darum, die Chemie-Giganten zu ersetzen, sondern ihnen den Rohstoff so rein wie möglich zu liefern – als strategische Quelle für kritische Materialien. Doch der Markt schläft nicht: Weltweit entstehen Initiativen zur Automatisierung.

Trotz des aktuellen „Gegners“ – dem Menschen mit dem Schraubenzieher – und potenzieller Konkurrenz durch Tech-Start-ups oder Autohersteller, bleibt Welter gelassen. „Wir konkurrieren nicht mit den Chemie-Giganten, wir liefern ihnen den reinsten möglichen Stoffstrom“, stellt er klar. Gegenüber potenziellen Nachahmern sieht er einen entscheidenden Vorteil, den „Unfair Advantage“: die Kombination aus Flexibilität und industrieller Automatisierungstiefe. „Wir sind aktuell die einzige Plattform, die sowohl Variabilität managt als auch für kontinuierlichen Industriebetrieb ausgelegt ist.“

Deutschland als Labor, USA als Skalierungsmarkt

Die Wachstumsstrategie von R3 Robotics ruht auf zwei massiven Säulen: technologischer Tiefe in Europa und kommerzieller Breite in den USA.

Deutschland fungiert dabei als das technologische Rückgrat. Mit der Erweiterung der Anlage in Karlsruhe zur Lighthouse Facility demonstriert das Unternehmen industrielle Leistungsfähigkeit direkt vor der Haustür der großen Autobauer. Hier wird die Technologie gehärtet. Das zeigt sich auch im Leuchtturmprojekt ReDriveS, wo R3 Robotics Seite an Seite mit Giganten wie Schaeffler und VW an der Demontage von E-Achsen arbeitet.

Doch für das massive Volumen blickt das Team über den Atlantik. Der für 2026 geplante Markteintritt in den USA ist Kern der neuen Strategie. Die frischen 20 Millionen Euro sollen gezielt in den Aufbau strategischer Partnerschaften vor Ort fließen, um die Technologie dort auszurollen, wo Pragmatismus auf riesige „End-of-Life“-Volumina trifft. Für Welter ist dieser Doppelschlag essenziell: „Deutschland ist unser Beweisstand. Hier zeigen wir Schaeffler, VW und Co., dass unsere Technologie industriellen Maßstäben in Deutschland standhält.“ Die USA seien hingegen der wichtige Skalierungsmarkt, wo pragmatische Entscheider auf gigantische Volumina treffen. „Beides brauchen wir: die Glaubwürdigkeit aus Europa und das Volumen aus Amerika.“

Industrialisierung statt Romantik

Mit Peter Mohnen, dem ehemaligen CEO des Roboter-Riesen KUKA, holte sich das Start-up zudem einen Beirat, der wie kaum ein anderer weiß, was Industriestandard bedeutet. Er beschreibt den Ansatz von R3 als Beweis für die nötige Automatisierungsexpertise, um Variabilität und Sicherheit gleichzeitig zu managen.

Um diese Expertise weiter auszubauen, wächst das Team rasant. Die Belegschaft soll mit der neuen Finanzierung massiv aufgestockt werden, vor allem im Bereich Engineering und KI. R3 Robotics hat den Beweis erbracht, dass Kreislaufwirtschaft kein ökologisches Nischenprojekt sein muss, sondern ein harter industrieller Prozess ist, der sich rechnet.

Denn letztlich, so das Fazit von Antoine Welter, sei Automatisierung der einzige Weg, das Problem wirklich zu lösen – nicht allein aus ökologischen Gründen, sondern weil es wirtschaftlich Sinn ergibt. „Was wir aufbauen, ist am Ende ein harter industrieller Prozess: Er muss zuverlässig funktionieren und sich rechnen.“ Es gehe aber um mehr als ein Geschäftsmodell: „Europa braucht eine Antwort auf die Frage, woher seine kritischen Materialien in Zukunft kommen“, mahnt Welter abschließend. „Wenn Europa diesen Zugang sichern will, braucht es Unternehmen, die genau das industriell umsetzen können. Dafür bauen wir diese Infrastruktur, und mit dem neuen Kapital und Team haben wir jetzt die Mittel dazu.“

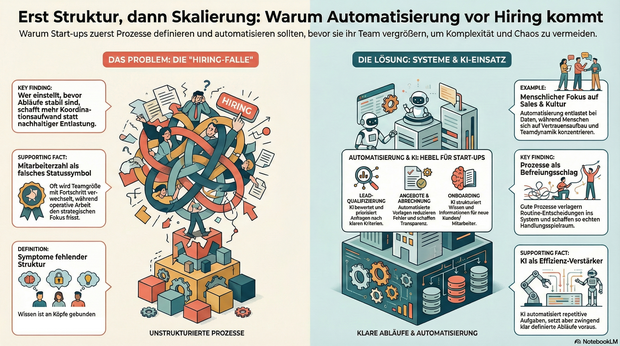

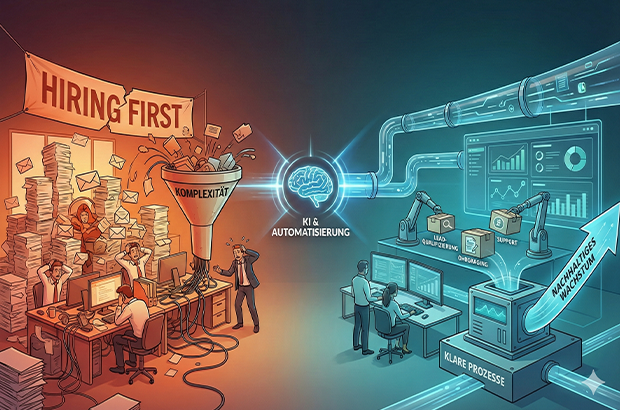

Automatisierung vor Hiring, sonst wird Komplexität skaliert

Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung. Tipps und To-Dos.

Wachstum wird in Start-ups oft sehr eindimensional gedacht: mehr Nachfrage gleich mehr Menschen. Sobald Anfragen steigen, Deals reinkommen oder neue Märkte locken, folgt fast automatisch der nächste Hiring-Plan. Dabei wird häufig die Ursache mit Wirkung verwechselt. Nicht fehlende Kapazität bremst junge Unternehmen, sondern fehlende Struktur. Prozesse entstehen improvisiert, Verantwortung wird situativ verteilt, operative Arbeit frisst Fokus. Und irgendwann fühlt sich Wachstum nicht mehr nach Fortschritt, sondern nach Dauerstress an.

Gerade in der Start-up-Branche wird Wachstum zudem stark über sichtbare Kennzahlen bewertet. In Gesprächen mit Investor*innen lautet eine der ersten Fragen häufig nicht Gewinn oder EBITA, sondern: Wie viele Mitarbeitende seid ihr und wie viel Umsatz macht ihr? Die Anzahl der Mitarbeitenden wird damit fast zu einem Statussymbol. Hiring wird nicht nur zur operativen, sondern auch zur psychologischen Größe und ein Zeichen von Fortschritt. Diese Logik verstärkt den Reflex, früh zu skalieren, auch wenn die strukturellen Voraussetzungen dafür noch fehlen. Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung.

Warum Hiring allein selten skaliert

Mehr Menschen im Team wirken wie eine schnelle Lösung. In der Praxis zeigt sich jedoch häufig ein ähnliches Muster: Neue Kolleg*innen übernehmen Aufgaben, die eigentlich nur deshalb existieren, weil Abläufe unklar oder manuell gewachsen sind. Statt nachhaltiger Entlastung entsteht zusätzliche Koordination.

Typische Symptome sind:

- operative Aufgaben blockieren strategische Arbeit,

- Wissen verteilt sich auf einzelne Köpfe,

- Entscheidungen hängen an Personen statt an klaren Abläufen,

- Abstimmungen nehmen zu, ohne dass die Wertschöpfung im gleichen Maß wächst.

Das Problem ist nicht Hiring an sich, sondern die Reihenfolge. In vielen Fällen wird Hiring eingesetzt, um kurzfristig Druck rauszunehmen, obwohl das eigentliche Nadelöhr fehlende Klarheit ist. Wer einstellt, bevor Abläufe stabil sind, schafft zwar mehr Kapazität, skaliert aber auch Komplexität.

Prozesse als Voraussetzung für wirksames Wachstum

Prozesse werden in Start-ups häufig mit Bürokratie verwechselt. Tatsächlich sind sie das Gegenteil: Sie reduzieren Reibung. Gute Prozesse verlagern Entscheidungen vom Einzelfall ins System. Sie beantworten zwei zentrale Fragen zuverlässig: Was passiert als Nächstes – und wer ist verantwortlich?

Gerade kleine Teams profitieren davon besonders. Prozesse schaffen keine Starrheit, sondern Handlungsspielraum. Sie machen Arbeit vorhersehbar, Übergaben sauber und Entscheidungen reproduzierbar. Erst auf dieser Grundlage kann ein wachsendes Team seine Stärke wirklich entfalten.

Automatisierung im KI-Zeitalter: neue Möglichkeiten, neue Verantwortung

Mit KI hat sich die Eintrittshürde für Automatisierung massiv gesenkt. Viele Aufgaben, die früher manuell oder individuell erledigt wurden, lassen sich heute zuverlässig unterstützen oder teilweise abnehmen, vorausgesetzt, der zugrunde liegende Ablauf ist klar definiert. Entscheidend ist dabei nicht die Tool-Auswahl, sondern die Frage, was automatisiert wird. Automatisierung verstärkt bestehende Strukturen, gute wie schlechte. Wer unklare Abläufe automatisiert, skaliert keine Effizienz, sondern Chaos. Gleichzeitig gibt es zentrale Bereiche, die sich bewusst nicht oder nur sehr begrenzt automatisieren lassen und auch nicht sollten. Recruiting ist einer davon. Der Aufbau eines funktionierenden Teams lebt von persönlicher Einschätzung, Teamdynamik und kulturellem Fit. Ähnliches gilt für Sales: Vertrauensaufbau, Verhandlung und das persönliche Gespräch bleiben essenziell. Automatisierung ist hier unterstützend, aber kein Ersatz. Besonders geeignet sind Tätigkeiten, die häufig auftreten, wenig kreativen Spielraum haben und auf wiederkehrenden Informationen basieren.

Bereiche, die sich heute besonders gut automatisieren lassen

Lead- und Anfragequalifizierung

Unstrukturierte Anfragen lassen sich mithilfe von KI zusammenfassen, bewerten und priorisieren. Statt jede Anfrage manuell zu prüfen, entstehen klare Kriterien, die relevante von irrelevanten Leads trennen und Follow-ups vorbereiten.

Angebots- und Abrechnungsprozesse

Angebote, Verträge und Rechnungen folgen in vielen Startups ähnlichen Mustern. Automatisierte Vorlagen, angebundene Datenquellen und definierte Freigaben sparen Zeit, reduzieren Fehler und schaffen Transparenz.

Onboarding von Kund:innen und Mitarbeitenden

Onboarding ist kein Einzelfall, sondern ein wiederkehrender Prozess. Checklisten, automatische Aufgaben und zentrale Informationspunkte sorgen für Verlässlichkeit. KI kann helfen, Informationen zu strukturieren und kontextbezogen bereitzustellen.

Support und interne Anfragen

Ein Großteil von Fragen wiederholt sich. Wissensbasen in Kombination mit KI-gestützter Suche und Antwortvorschlägen entlasten Teams und machen sichtbar, wo Standards fehlen.

Projektmanagement und Übergaben

Klare Projekt-Templates, automatisierte Status-Updates und definierte Trigger reduzieren Abstimmungsaufwand. KI kann dabei unterstützen, Risiken früh zu erkennen oder nächste Schritte vorzuschlagen.

Was Start-ups daraus lernen können

Automatisierung ersetzt keine Entscheidungen, sie macht sie skalierbar. Voraussetzung dafür ist Klarheit über Abläufe, Verantwortlichkeiten und Prioritäten. Wer versucht, Chaos zu automatisieren, verstärkt es lediglich.

Hilfreiche Leitfragen sind:

- Welche Aufgaben wiederholen sich regelmäßig?

- Wo entstehen manuelle Engpässe?

- Welche Tätigkeiten binden qualifizierte Menschen ohne echten Mehrwert?

Die Antworten darauf liefern meist schnell die größten Hebel.

Der KI-Wendepunkt: Systeme und Personal

Nachhaltiges Wachstum entsteht dort, wo Start-ups Systeme aufbauen und diese bewusst mit ihrem Team verzahnen. Nicht, weil Systeme Menschen ersetzen, sondern weil sie Menschen von struktureller Überforderung entlasten. Automatisierung schafft dabei nicht nur Effizienz, sondern Entscheidungsqualität: Wenn Daten sauber fließen, Übergaben klar sind und Standards greifen, werden Prioritäten weniger Bauchgefühl und stärker reproduzierbar.

Der gezielte Einsatz von KI-Tools verschiebt diesen Wendepunkt zusätzlich. Sie können Routinearbeiten abfangen, Informationen aus unstrukturierten Inputs verdichten und Entscheidungen vorbereiten – etwa durch Lead-Vorqualifizierung, Support-Clustering oder zusammengefasste Status-Updates. KI wirkt dabei nicht als Ersatz für Klarheit, sondern als Verstärker funktionierender Prozesse.

Hiring bleibt auch weiterhin essentiell. Seine Wirkung entfaltet es jedoch erst dann vollständig, wenn Prozesse klar sind und Automatisierung sowie KI gezielt unterstützen. So entsteht Wachstum, das nicht nur schneller, sondern auch gesünder ist.

Der Autor Markus Hetzenegger ist Gründer & CEO von NYBA Media. 2018 gegründet, zählt NYBA heute zu den führenden Marketing-Unternehmen im Live-Entertainment.

Von der Kochbox zum Hundenapf: Ex-HelloFresh-Duo startet Tasty Petfood

Wie Lisa Vannini und Nadja Chylla mit ihrem Start-up Tasty Petfood die etablierten Premium-Tierfuttermarken herausfordern.

Das Berliner Start-up Tasty Petfood ist offiziell in den Markt eingetreten. Das Unternehmen, gegründet von den ehemaligen HelloFresh-Kolleginnen Lisa Vannini und Nadja Chylla, positioniert sich im Premium-Segment für Hundefutter und setzt dabei auf ein digitales Vertriebsmodell. Der offizielle Marktstart in Deutschland und der Schweiz erfolgte am 6. Februar 2026.

Transfer von Food-Logistik auf den Heimtiermarkt

Die Gründerinnen arbeiteten zuvor über fünf Jahre gemeinsam beim Kochboxen-Versender HelloFresh. Das dort in den Bereichen Skalierung und Operations gewonnene Know-how wollen Lisa und Nadja nun auf den Heimtiermarkt übertragen.

„Wir haben gemerkt, dass viele Hundehalter entweder bei klassischem Trockenfutter bleiben oder sehr viel Zeit in aufwendige BARF-Konzepte investieren müssen. Genau diese Lücke zwischen Bequemlichkeit und echter Qualität wollten wir schließen“, berichtet Lisa.

Das Kernprodukt von Tasty Petfood unterscheidet sich logistisch von herkömmlichem Nassfutter oder Barf-Angeboten: Das Unternehmen vertreibt dampfgegartes Frischfutter im Glas. Ein wesentlicher Unterschied zu vielen Wettbewerbern im Frische-Segment ist die Haltbarmachung: Die Produkte benötigen keine geschlossene Kühlkette und können ungekühlt gelagert werden. Dies reduziert die Komplexität in der Lagerhaltung und im Versand erheblich – ein Faktor, der im D2C-Bereich direkten Einfluss auf die Unit Economics hat. „Unser Anspruch war Qualität wie selbstgekocht – aber ohne Kühlschrank und ohne komplizierte Logistik. Dass wir Frische, Haltbarkeit und Alltagstauglichkeit verbinden können, ist für viele Kundinnen und Kunden ein echter Gamechanger“, sagt Nadja.

Wachstumskurs in einem Milliardenmarkt

Mit ihrem Geschäftsmodell stoßen die Gründerinnen in ein wirtschaftlich hochattraktives Umfeld vor. Nach aktuellen Daten des Industrieverbands Heimtierbedarf (IVH) und des Zentralverbands Zoologischer Fachbetriebe (ZZF) liegt der Gesamtumsatz der Branche bei rund sieben Milliarden Euro, wobei allein das Segment für Fertignahrung gut 4,4 Milliarden Euro ausmacht. Trotz allgemeiner wirtschaftlicher Herausforderungen bleibt die Zahlungsbereitschaft der Halter hoch.

Während der Absatz im Standard-Segment teils stagniert, wächst der Bereich für Premium-Nahrung kontinuierlich. Tasty Petfood ordnet sich im oberen Preissegment ein und zielt auf eine kaufkräftige Zielgruppe, die den Trend zur „Humanisierung“ des Haustiers vorantreibt.

„Hunde werden heute immer stärker als Familienmitglieder gesehen. Entsprechend steigen die Ansprüche an Transparenz, Zutatenqualität und Nährstoffversorgung – ähnlich wie beim eigenen Essen“, so Lisa.

Die Nische zwischen Konzern und Tiefkühltruhe

In diesem dynamischen Umfeld muss sich Tasty Petfood gegen zwei Lager behaupten. Zum einen konkurriert das Start-up mit etablierten Premium-Marken im stationären Handel wie Terra Canis, das als Pionier für „Human Grade“-Nahrung gilt und seit 2017 mehrheitlich zum Nestlé-Konzern gehört. Zum anderen wächst der Druck durch rein digitale Player wie Butternut Box oder HelloBello, die ebenfalls auf personalisiertes Frischfutter setzen, dieses jedoch tiefgekühlt versenden.

Genau hier besetzt Tasty Petfood eine strategische Lücke: Start-ups fungieren in diesem Sektor aktuell als wesentliche Innovationstreiber, und die Berliner Gründerinnen nutzen dies für eine „Ambient Fresh“-Strategie. Mit ungekühlt haltbarem Frischfutter verbindet das Unternehmen den steigenden Wunsch nach Convenience mit der Qualität von Frische-Menüs – ein entscheidender Logistik-Vorteil gegenüber der aufwendigen Tiefkühl-Konkurrenz. „Wir sitzen genau zwischen Tiefkühltruhe und Trockenfutter. Unser Futter ist reisefähig, blockiert keinen Gefrierschrank und passt damit perfekt in den Alltag moderner Hundehalter“, sagt Nadja.

Datengetriebenes Abo-Modell

Der Bestellvorgang für den/die Endkund*in ist vollständig datengestützt aufgebaut. Zu Beginn erfassen Interessent*innen über ein Online-Quiz relevante Parameter wie Rasse, Alter und Gewicht des Tieres. Auf Grundlage dieser Daten berechnet das Unternehmen einen individuellen Futterplan, der exakt auf den Hund zugeschnitten ist. Um die Akzeptanz zu testen, erhalten Neukund*innen zunächst eine Probebox mit verschiedenen Sorten. Bei erfolgreicher Annahme geht das Modell automatisch in ein flexibles Abonnement über, bei dem sowohl die Rationsgröße als auch der Lieferrhythmus dynamisch an den tatsächlichen Bedarf des Hundes angepasst werden. „Viele Halter sind unsicher, ob sie ihren Hund wirklich bedarfsgerecht füttern. Unser Algorithmus nimmt ihnen diese Entscheidung ab und sorgt dafür, dass Menge und Nährstoffe langfristig passen“, so Lisa.

Positionierung im Premium-Segment

Das Produktportfolio umfasst zum Start sechs Sorten auf Monoprotein-Basis. Durch den hohen Fleischanteil und den Verzicht auf Füllstoffe oder Konservierungsmittel zielt das Start-up auf die „Human Grade“-Nische ab. Das Produkt ist dabei so designt, dass es optisch und qualitativ an selbstgekochtes Futter erinnert, um die Hürde für qualitätsbewusste Käufer*innen zu senken. Das Kalkül: Die Zielgruppe sucht die Qualität einer BARF-Ernährung, benötigt aber die Convenience eines Fertigprodukts. „Unser Ziel ist es, Pet Nutrition durch sichtbare Qualität und Transparenz neu zu definieren“, so Nadja über den Anspruch, moderne Halterbedürfnisse mit dem Produkt-Design zu adressieren.

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

Die Wächter des Firmengedächtnisses

Wie das 2025 von Christian Kirsch und Stefan Kirsch gegründete Start-up amaiko den Strukturwandel im Mittelstand adressiert.

Der demografische Wandel und eine erhöhte Personalfluktuation stellen mittelständische Unternehmen zunehmend vor die Herausforderung, internes Know-how zu bewahren. Viele Unternehmen stehen vor der Schwierigkeit, dass Firmenwissen fragmentiert vorliegt. Informationen sind häufig in unterschiedlichen Systemen oder ausschließlich in den Köpfen der Mitarbeitenden gespeichert. Verlassen langjährige Fachkräfte den Betrieb in den Ruhestand oder wechseln jüngere Arbeitnehmerinnen und Arbeitnehmer kurzfristig die Stelle, gehen diese Informationen oft verloren. Zudem bindet die Suche nach relevanten Dokumenten in verwaisten Ordnerstrukturen Arbeitszeit, die in operativen Prozessen fehlt.

Das 2025 gegründete Start-up amaiko aus Niederbayern setzt hierbei auf einen technischen Ansatz, der auf die Einführung neuer Plattformen verzichtet und stattdessen eine KI-Lösung direkt in die bestehende Infrastruktur von Microsoft Teams integriert. Vor diesem Hintergrund entwickelten die Brüder Christian und Stefan Kirsch mit amaiko eine Softwarelösung, die spezifisch auf die Ressourcenstruktur mittelständischer Betriebe ausgelegt ist.

Integration statt neuer Insellösungen – und die Abgrenzung zu Copilot

Ein wesentliches Merkmal des Ansatzes ist die Entscheidung gegen eine separate Software-Plattform. Christian Kirsch, Geschäftsführer von PASSION4IT und amaiko, positioniert die Lösung als „Teams-native“. Das bedeutet, dass der KI-Assistent technisch in Microsoft Teams eingebettet wird – jene Umgebung, die in vielen Büros bereits als primäres Kommunikationswerkzeug dient. Ziel ist es, die Hürden bei der Implementierung zu senken, da Nutzer ihre gewohnte Arbeitsumgebung nicht verlassen müssen.

Angesichts der Tatsache, dass Microsoft mit dem „Microsoft 365 Copilot“ derzeit eine eigene, tief integrierte KI-Lösung ausrollt, stellt sich die Frage nach der Positionierung. Christian Kirsch sieht hier jedoch keine direkte Konkurrenzsituation, sondern eine klare Differenzierung: Copilot sei eine sehr breite, Microsoft-zentrische KI-Funktion. Amaiko hingegen verstehe sich als spezialisierter, mittelstandsorientierter Wissensassistent, der Beziehungen, Rollen, Prozesse und Unternehmenslogik tiefgreifend abbildet.

Ein entscheidender Vorteil liegt laut Kirsch zudem in der Offenheit des Systems: „Während Copilot naturgemäß an Microsoft‑Systeme gebunden ist, lässt sich amaiko herstellerunabhängig in eine viel breitere Softwarelandschaft integrieren – vom ERP über CRM bis zu Branchenlösungen. Unser Ziel ist nicht, Copilot zu kopieren, sondern reale Mittelstandsprozesse nutzbar zu machen“, so der Co-Founder.

Funktionsweise, Sicherheit und Haftung

Funktional unterscheidet sich das System von herkömmlichen Suchmasken durch eine agentenähnliche Logik. Die Software bündelt Wissen aus internen Quellen wie Richtlinien oder Projektdokumentationen und stellt diese kontextbezogen zur Verfügung. Ein Fokus liegt dabei auf der Datensouveränität. Hierbei betont Christian Kirsch, dass Kundendaten nicht in öffentlichen Modellen verarbeitet werden: „Die Modelle laufen in der europäischen Azure AI Foundry, unsere eigenen Dienste auf deutschen Servern. Die Daten des Kunden bleiben on rest vollständig im jeweiligen Microsoft‑365‑Tenant. Es findet kein Training der Foundation Models mit Kundendaten statt – weder bei Microsoft noch bei uns. Grundlage dafür sind die Azure OpenAI Non‑Training Guarantees, die Microsoft in den Product Terms sowie in SOC‑2/SOC‑3‑ und ISO‑27001‑Reports dokumentiert.“

Auch rechtlich zieht das Start-up eine klare Grenze, sollte die KI einmal fehlerhafte Informationen, sogenannte Halluzinationen, liefern. „Amaiko generiert Vorschläge, keine rechts‑ oder sicherheitsverbindlichen Anweisungen. Das stellen wir in unseren AGB klar: Die Entscheidungshoheit bleibt beim Unternehmen. Wir haften für den sicheren Betrieb der Plattform, nicht für kundenseitig freigegebene Inhalte oder daraus abgeleitete Maßnahmen. Es geht um eine saubere Abgrenzung – technische Verantwortung bei uns, inhaltliche Verantwortung beim Unternehmen“, so Christian Kirsch.

Geschäftsmodell und Markteintritt

Seit der Vorstellung der Version amaiko.ai im Juli 2025 wird das System nach Angaben des Unternehmens mittlerweile von über 200 Anwendern genutzt. Durch die Integration in die bestehende Microsoft-365-Landschaft entfällt für mittelständische Kunden eine aufwendige Systemmigration, was die technische Eintrittsbarriere gering hält.

Passend zu diesem Ansatz ist amaiko als reines SaaS-Produkt konzipiert, das Unternehmen ohne Einstiegshürde direkt online buchen können. Laut Kirsch sind keine Vorprojekte, individuellen Integrationspfade oder teuren Beratungspflichten notwendig: „Die Nutzung ist selbsterklärend und leichtgewichtig. Wer zusätzlich Unterstützung möchte – etwa zur Wissensstrukturierung oder Governance – kann sie bekommen. Aber die technische Einführung selbst ist bewusst so gestaltet, dass Mittelständler ohne Implementierungsaufwand starten können.“

Unterm Strich liefert amaiko damit eine pragmatische Antwort auf den drohenden Wissensverlust durch den demografischen Wandel: Statt auf komplexe IT-Großprojekte zu setzen, holt das bayerische Start-up die Mitarbeitenden dort ab, wo sie ohnehin kommunizieren. Ob sich die „Teams-native“-Strategie langfristig gegen die Feature-Macht von Microsoft behauptet, bleibt abzuwarten – doch mit dem Fokus auf Datensouveränität und mittelständische Prozesslogik hat amaiko gewichtige Argumente auf seiner Seite, um sich als spezialisierter Wächter des Firmengedächtnisses zu etablieren.

to teach: Vom KI-Hype zur Schulinfrastruktur

Wie das 2022 gegründete EdTech to teach die Lücke zwischen Chatbot und Klassenzimmer schließt.

Vor drei Jahren begann mit dem öffentlichen Zugang zu generativer künstlicher Intelligenz ein weltweiter Hype, der auch vor den Schultoren nicht haltmachte. Doch im Bildungsmarkt entscheidet sich derzeit, ob die Technologie tatsächlich Produktivität schafft oder in einer digitalen Sackgasse endet. Das Hamburger EdTech to teach liefert hierzu eine Blaupause: Was 2022 als Experiment begann, hat sich innerhalb von drei Jahren zu einer Arbeitsplattform für hunderttausende Lehrkräfte entwickelt.

Das Problem: US-Tools verstehen deutsche Schulen nicht

Als generative KI erstmals verfügbar wurde, wirkte ihr Einsatz im Bildungsbereich naheliegend. Doch der Blick auf die internationale Konkurrenz zeigt das Dilemma: Während US-Platzhirsche wie MagicSchool AI oder Diffit den Markt mit hunderten Mikro-Tools fluten und technisch beeindrucken, fehlt ihnen der kulturelle Fit. „Einfach nur Texte aus ChatGPT zu kopieren, löst kein einziges Problem von Lehrkräften“, erklärt Felix Weiß, Co-Founder und CEO von to teach.

Die Diskrepanz zwischen dem Versprechen der KI und dem tatsächlichen Schulalltag war groß. US-Lösungen scheitern oft an spezifischen deutschen Lehrplänen oder liefern reine Multiple-Choice-Formate, die hierzulande kaum Anwendung finden. Lehrkräfte benötigten keine unstrukturierten Textwüsten, sondern didaktisch saubere, lehrplankonforme und sofort einsetzbare Materialien. Genau hier setzte das 2022 von Felix Weiß und Marius Lindenmeier gegründete Unternehmen an.

Der Pivot: Datenschutz als Burggraben

Der entscheidende Wendepunkt kam 2023. Das Start-up vollzog einen Strategiewechsel (Pivot) weg von einer SaaS-Lösung für Verlage hin zu einer direkten Plattform für Lehrkräfte. Anstatt Nutzer*innen mit freien Eingabefeldern (Prompts) allein zu lassen, entwickelte das Team feste Arbeitsblattvorlagen. Dies wurde zum entscheidenden Wettbewerbsvorteil gegenüber internationalen Anbietern: Während diese oft an der strikten DSGVO scheitern, bietet to teach durch Serverstandorte in der EU und Rechtssicherheit eine Lösung, die Schulträger akzeptieren.

Dabei mussten technische Kinderkrankheiten überwunden werden: Frühe KI-Modelle „halluzinierten“ Fakten. To teach reagierte mit der systematischen Integration von Quellen und profitierte zugleich von der rasanten Evolution der Sprachmodelle.

Skalierung im Ökosystem gegen nationale Konkurrenz

Der Markt nahm die Lösung schnell an: Im Januar 2023 meldete sich der erste Nutzer an, bis Ende des Jahres waren es laut Unternehmen bereits knapp 16.000 Lehrkräfte. Das Jahr 2024 markierte dann den Übergang vom Start-up zur Plattform: Durch die Übernahme von fobizz (101skills GmbH) wurde to teach Teil eines größeren Bildungsökosystems. Die Gründer blieben als Geschäftsführer an Bord.

Dieser Schritt war strategisch überlebenswichtig in einem sich konsolidierenden Markt. Einerseits gegenüber agilen Herausforderern, da Konkurrenten wie schulKI, Teachino, KIULY oder Kuraplan zum Teil aggressiv um Landeslizenzen kämpfen bzw. auf dem Markt für KI-gestützte Unterrichtsplanung und Materialerstellung durchgestartet sind.

Andererseits war der Schritte in Hinblick auf etablierte Verlage notwendig. Denn Häuser wie Cornelsen ziehen inzwischen mit eigenen KI-Assistenten nach, sperren ihre Inhalte jedoch oft in geschlossene Systeme, d.h. binden sie oft an die eigenen Verlagswerke.

Durch die erfolgreiche Integration in fobizz ist to teach kein isoliertes Insel-Tool mehr, sondern profitiert von bestehenden Landesrahmenverträgen und einem riesigen Vertriebsnetz. Die Nutzer*innenzahlen explodierten förmlich auf über 140.000 Lehrkräfte bis Ende 2024, so die Angaben von to teach.

Status Quo 2025: KI als neue Infrastruktur

Heute, im dritten Jahr nach der Gründung, hat sich der Fokus erneut verschoben. To teach versteht sich inzwischen als Arbeitsinfrastruktur. Die Zahlen unterstreichen diesen Anspruch: Nach Angaben von to teach nutzen über 300.000 Lehrkräfte die Plattform, und mehr als 4.000 Schulen sind angebunden. Das bedeutet: Millionen von Inhalten wurden so bereits KI-gestützt vorbereitet.

Das Unternehmen treibt nun den systematischen Schulvertrieb voran. Damit beweisen EdTechs wie to teach, dass sich Qualität und Personalisierung im sonst oft als innovationsresistent geltenden Bildungsmarkt skalieren lassen.

Für CEO Felix Weiß ist die Diskussion über das „Ob“ längst beendet: „Die Frage ist nicht mehr, ob KI im Klassenzimmer ankommt, sondern, wie und auf welche Weise sie dort wirklich hilft.“

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.

Wenn Dr. Martin Baumgärtl erklären will, wie er die chemische Industrie revolutionieren möchte, wählt er ein Bild, das jeder versteht: „Im Grunde ist es wie ein Wasserkocher in der heimischen Küche – nur im industriellen Maßstab.“ Baumgärtl ist CTO von SYPOX, und was er beschreibt, könnte einer der wichtigsten Hebel für die Dekarbonisierung einer der schmutzigsten Branchen der Welt sein.

Die chemische Industrie ist süchtig nach Energie. Um Basischemikalien wie Methanol oder Ammoniak herzustellen, wird sogenanntes Synthesegas benötigt – eine Mischung aus Wasserstoff und Kohlenmonoxid. Die Herstellung geschieht in gewaltigen Hochtemperaturprozessen. Bisher wird die dafür nötige Hitze fast ausschließlich durch das Verbrennen von Erdgas oder Öl erzeugt. Die Folge: Gigantische CO₂-Emissionen.

Strom statt Flamme

Genau hier setzt SYPOX an. Das 2021 in Freising gegründete Unternehmen ersetzt die offenen Gasflammen durch elektrischen Strom. In ihren Reaktoren, die von außen wie gewöhnliche Druckbehälter aussehen, stecken hochkomplexe elektrische Heizelemente, die direkt hinter den Katalysatoren platziert sind.

Der Effekt ist enorm: „In konventionellen Verfahren entfallen rund 40 Prozent der Emissionen allein auf die Wärmeerzeugung aus fossilen Energieträgern“, rechnet Baumgärtl vor. Durch die Elektrifizierung des Reaktors fallen diese Emissionen weg – vorausgesetzt, der Strom kommt aus erneuerbaren Quellen. Zudem lässt sich der Prozess laut den Gründern präziser und sicherer steuern.

Der Anti-Trend im Silicon Valley

Doch nicht nur technologisch, auch ökonomisch schwimmt SYPOX gegen den Strom. In der Tech-Szene ist es üblich, dass Start-ups jahrelang Verluste schreiben und sich von einer Venture-Capital-Runde zur nächsten hangeln, getrieben von Investoren, die schnelles Wachstum fordern.

Die bayerischen Gründer wählten einen konservativeren, fast schon mittelständischen Ansatz. „Es entsprach nicht unserem Stil, Geld einzuwerben – wir haben vielmehr von Anfang an versucht, auf Basis unserer Technologie ein tragfähiges Geschäft aufzubauen“, erklärt CEO Dr. Gianluca Pauletto. Man wolle bodenständig bleiben und sich aus Umsätzen finanzieren, statt sich in Abhängigkeiten zu begeben.

Vom Container im Altmühltal zum Großkunden

Die Wurzeln des Unternehmens liegen an der Technischen Universität München (TUM). Die Idee brachte Pauletto aus seiner Zeit in Montréal mit, an der TUM fand er in Prof. Johannes Lercher und dem damaligen Doktoranden Martin Baumgärtl die wissenschaftlichen Mitstreiter.

Der Weg zum marktreifen Produkt war – typisch für „Deep Tech“ – langwierig. „Vier Jahre Forschung und zahlreiche Versuchsreihen waren notwendig“, erinnert sich Lercher. Während andere Software im Co-Working-Space programmierten, baute das SYPOX-Team eine Pilotanlage in einem einfachen Stahlcontainer auf dem Gelände einer Biogasanlage im ländlichen Dollnstein (Altmühltal).

Diese Beharrlichkeit zahlt sich nun aus. Das Start-up hat, unterstützt durch den Spezialchemie-Konzern Clariant, seinen ersten Großkunden an Land gezogen. Ab 2026 soll eine erste industrielle Anlage in Betrieb gehen, die täglich 150 Tonnen Synthesegas produziert. „Das ist nicht nur ein Meilenstein für uns, sondern auch ein starkes Signal an die gesamte chemische Industrie“, so Baumgärtl.

Für das Team, das inzwischen in Langenbach bei Freising sitzt und weiterhin Labore auf dem Forschungscampus Garching betreibt, ist das der Beweis: Die Elektrifizierung der Chemie ist keine Zukunftsmusik mehr, sie beginnt jetzt.