Aktuelle Events

Geschäftsideen Verpackung: Personalisierung senkt Retourenquote

Verpackung reduziert Retouren

Auch heute verschicken die meisten Onlineshops ihre Produkte in schmucklosen braunen Pappkartons. Das geht auch anders, dank einer personalisierten Verpackung. Eine pfiffige Geschäftsidee!

Denn eine hochwertige, personalisierte Verpackung erfreut den Kunden nicht nur und macht den Moment des Auspackens besonders – sie bindet den Empfänger auch psychologisch an das Paket. Und das führt zu deutlich sinkenden Retourenquoten.

Davon will die Printmate GmbH profitieren, die 2015 von Julian Jost in Berlin gegründet wurden. Das Start-up hat sich mit seiner Geschäftsidee auf den Onlinedruck von Versandverpackungen im kundenindividuellen Design spezialisiert. Hauptzielgruppe ist der Onlinehandel, den Printmate in Auflagen ab 100 Exemplaren beliefert.

Diese Artikel könnten Sie auch interessieren:

„Keine Shortcuts bei der Entwicklung des Produkts nehmen“

Im Interview: Alberto Zamora, Mitgründer von osapiens. Seine Tipps und Erfahrungen für Gründer*innen. Das 2018 gegründete Mannheinmer Tech-Unternehmen hat zum Jahresbeginn Unicorn-Status erreicht.

Sie haben kürzlich im Rahmen einer Series C-Finanzierung 100 Mio. USD eingesammelt und damit Unicorn-Status erlangt. Welche Pläne und Ziele haben Sie sich mit dem frischen Kapital gesetzt?

Zamora: In erster Linie war unser Ziel, den neuen Investor Decarbonization Partners, das Joint Venture zwischen BlackRock und Temasek, als strategischen Partner zu gewinnen. Zusammen verfügen die beiden Investmentgesellschaften über ein riesiges Netzwerk, von dem wir in der nächsten Stufe unseres Wachstums stark profitieren können. Der Einstieg von Decarbonization Partners ergänzt die bestehenden Investoren Goldman Sachs Alternatives und Armira Growth hervorragend und ist nicht nur eine Anerkennung unserer bisherigen Erfolge, sondern vor allem ein Vertrauensbeweis in unseren Weg, Nachhaltigkeit und Effizienz zusammen zu denken. Das Investment selbst dient uns als Kapitalrücklage und hilft uns, die bestehende Wachstumsstrategie zu stärken. Unser Ziel ist es, weiter international zu expandieren, insbesondere in den nordischen Ländern und in den USA, und unsere Cloudplattform osapiens Hub als weltweit führende Lösung für nachhaltiges Wachstum zu etablieren. Die neu geschlossene Partnerschaft stärkt langfristig diese Strategie und hilft uns, noch flexibler zu agieren.

Als Sustainability-Software-Start-up bündelt osapiens mehr als 25 Tools und erreicht damit über 2.500 Kunden. Mit welchem Alleinstellungsmerkmal können Sie die Kunden am meisten überzeugen?

Zamora: Unser USP im Vergleich zur Konkurrenz ist unser ganzheitlicher Plattformansatz. Statt Einzellösungen anzubieten, etwa für bestimmte Regulierungen, integriert unser osapiens Hub Lösungen für zahlreiche Anforderungen: Wir vereinen Transparenz-, Compliance- und Effizienzlösungen in einem System, das unseren Kunden klare operative Mehrwerte bietet. Der osapiens Hub funktioniert automatisiert, KI-gestützt und datenbasiert. Dabei bietet er Echtzeitanalysen, strategische Steuerung und Prozessoptimierung. Zudem garantieren unsere Softwarelösungen Rechtssicherheit und können nahtlos in bestehende Systemlandschaften integriert werden. Der große Vorteil unserer Plattform ist also, dass sie regulatorische Anforderungen und operative Prozesse ganzheitlich auf einer zentralen Datenbasis adressiert.

Sie beschäftigen mehr als 550 Mitarbeitende. Welche Herausforderungen kamen auf, als das Team immer größer wurde, und wie haben Sie diese gemeistert?

Zamora: Tatsächlich ist unser Team in den letzten Jahren sehr stark gewachsen. Mittlerweile beschäftigen wir an neun Standorten in Europa und den USA Mitarbeitende mit über 40 Nationalitäten. Die größte Herausforderung war bisher, unserer hohen Wachstumsgeschwindigkeit entsprechend die richtigen Mitarbeitenden zu finden. Gemeistert haben wir das, indem wir von Anfang an klare Werte etabliert haben, die unser tägliches Arbeiten prägen: Speed, Commitment und Team. Das bedeutet im Kern: schnelle Entscheidungen und Umsetzung, hohe Eigenverantwortung und eine enge, standortübergreifende Zusammenarbeit. Diese Werte geben Orientierung und helfen uns, auch bei zunehmender Größe effizient und fokussiert zu bleiben. Unsere Entwicklerteams sind in Mannheim und Madrid konzentriert, was eine enge Zusammenarbeit und Schnelligkeit stark begünstigt.

Welche Rolle spielte künstliche Intelligenz bei der aktuellen Finanzierungsrunde, wie wichtig war Ihren Investoren dieses Thema?

Zamora: Als bedeutendste Zukunftstechnologie war Künstliche Intelligenz sowohl unserem neuen Investor Decarbonization Partners als auch unseren bisherigen Investoren sehr wichtig. Bei uns ist KI wesentlicher Bestandteil unseres Kernprodukts. Selbstlernende Systeme sind eine zentrale Komponente unserer Plattform. Im osapiens Hub bildet KI-gestützte Automatisierung die Grundlage für die Datenverarbeitung, weshalb alle unsere Softwarelösungen auf KI-gesteuerten Prozessen basieren. KI ist also eine Grundvoraussetzung für den erfolgreichen Einsatz unserer Lösungen und garantiert effizientes Operieren.

Was ist Ihnen bei der Auswahl Ihrer Finanzierungspartner besonders wichtig?

Zamora: Wir achten vor allem darauf, dass unsere Investoren über ein großes Netzwerk verfügen, das uns bei unserem internationalen Wachstum unterstützt. Mit Decarbonization Partners sowie Goldman Sachs und Armira Growth als Investoren sind wir dafür optimal aufgestellt. Alle unsere Investoren sind dafür bekannt, mit schnell wachsenden jungen Unternehmen zusammenzuarbeiten und diese auf ihrem Weg an die Spitze zu unterstützen.

Sie sind mehr als sieben Jahre am Markt. Was war in der Gründungszeit Ihre größte Lesson Learned?

Zamora: Aus vorherigen Gründungen haben wir vor allem eines mitgenommen: keine Shortcuts bei der Entwicklung des Produkts nehmen. Natürlich spart man zu Beginn Geld und Ressourcen, wenn man seine Software auf externen Hyperscalern aufbaut. Langfristig begibt man sich aber nicht nur in eine gewisse Abhängigkeit, sondern wird aufgrund des eingeschlagenen Entwicklungspfads auch unflexibel. Diese Beschränkung wollten wir bei osapiens unbedingt vermeiden. Deshalb haben wir drei Jahre in den konsequenten Aufbau einer eigenen Plattform gesteckt. Das hat zunächst viele Ressourcen gebunden, gibt uns jetzt aber die Möglichkeit, maximal flexibel auf Veränderungen zu reagieren, und sichert langfristig unsere Unabhängigkeit.

Welchen Rat geben Sie Gründern und Grtünderinnen, die ein B2B-Produkt auf den Markt bringen wollen?

Zamora: Nehmt euch die Zeit, die ihr braucht, um euer Produkt vollständig zu entwickeln. Im Nachhinein fragt keiner mehr danach, ob ihr nach einem oder nach vier Jahren an den Markt gegangen seid. Euer Produkt sollte stets an erster Stelle stehen, und nur dessen Qualität sichert euch langfristigen Erfolg. Vergesst dabei aber nicht, vertrauensvolle Partner zu gewinnen und schon früh den Rat erfahrener Verbündeter einzuholen. Diese strategischen Partnerschaften sichern euch gerade im späteren Stadium die Möglichkeit, erfolgreich zu expandieren. Früh geschlossene Kontakte zahlen sich später aus. Und ganz wichtig: Bleibt optimistisch! Die Rahmenbedingungen können sich in kürzester Zeit ändern, aber wenn ihr an euer Produkt glaubt und flexibel agiert, wird es immer Wege geben, euer Produkt erfolgreich zu vermarkten und dadurch mit eurem Unternehmen zu wachsen.

Alberto Zamora, vielen Dank für das Gespräch

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen!

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Better Sol: Zweites Leben für die Solarwende

Wie das 2023 von Mirko Laube und Luisa Schulze gegründete Start-up Better Sol den PV-Gebrauchtmarkt aufmischen will.

Das Braunschweiger Start-up Better Sol erhält rund 125.000 Euro Förderung aus dem „Green Startup“-Programm der Deutschen Bundesstiftung Umwelt (DBU), um gebrauchte Solarpaneele in großem Stil zurück in den Markt zu bringen.

Hinter dem Start-up stehen Luisa Schulze und Mirko Laube. Better Sol entstand ursprünglich im Sommer 2022 als Ausgründung des Magdeburger Recycling-Unternehmens Solar Materials und agiert seit 2023 als eigenständige GmbH am Standort Braunschweig. Während sich die ehemalige Muttergesellschaft auf das komplexe werkstoffliche Recycling von Modulen konzentriert, widmet sich Better Sol voll und ganz dem „Second Life“ – also der direkten Wiederverwendung der noch intakten Platten.

KI-gestützte Prüfung statt Schredder

Die Beschaffungsseite von Better Sol zielt primär auf große Solarparks ab. Die Betreiber tauschen dort häufig größere Mengen an Solarmodulen recht früh in ihrem Lebenszyklus durch neuere, leistungsstärkere Modelle aus. Um diese Module vor dem Müll zu bewahren, hat das Better-Sol-Team mittels DBU-Förderung ein in Teilen automatisiertes Testsystem mit eigener Software auf Basis künstlicher Intelligenz (KI) entwickelt.

Der Prüfprozess beginnt mit einer mehrstufigen optischen Untersuchung, bei der sowohl grobe Beschädigungen als auch jede Solarzelle einzeln begutachtet werden. Im Anschluss folgen eine eingehende Prüfung der elektrischen Sicherheit sowie eine Leistungsüberprüfung, die misst, wie viel Watt das Produkt im Vergleich zur ursprünglichen Leistung noch liefert. Die Software führt all diese Daten automatisiert zu einer detaillierten Leistungsprognose zusammen. Jedes funktionstüchtige Modul erhält ein Label mit den Testdaten, einer zugewiesenen Leistungsklasse und einem umfangreichen Prüfprotokoll. Nur der endgültige Rest wird zum Recycling aussortiert. Der Vertrieb erfolgt direkt über die Internetseite von Better Sol. Zielgruppe sind oft Privathaushalte oder die Dächer größerer Fabrikhallen.

Der Markt und die Technologie im Wettbewerbsvergleich

Nach Angaben des Statistischen Bundesamtes verbucht die Photovoltaik mittlerweile einen Anteil von etwa 24 Prozent und ist damit der zweitwichtigste Energieträger der inländischen Stromerzeugung. Das Reservoir an ausgemusterten, aber noch funktionierenden Modulen wächst rasant. Laut Schulze ist im Schnitt jedes zweite gebrauchte Solarmodul noch für eine erneute Nutzung geeignet. Doch der Gebrauchtmarkt professionalisiert sich zusehends.

Better Sol setzt aktuell auf eine pragmatische, KI-gestützte Teilautomatisierung und plant als nächsten logischen Entwicklungsschritt eine mobile Testanlage, um die Solarmodule direkt dort zu testen, wo sie ausgemustert werden. Genau in diesem logistisch entscheidenden Bereich der Vor-Ort-Prüfung operiert bereits der etablierte Wettbewerber 2ndlifesolar, eine Marke der großen Buhck Gruppe. 2ndlifesolar greift auf ein deutschlandweites Logistiknetzwerk zurück und kombiniert stationäre Erstbehandlungsanlagen mit mobilen Prüflaboren. Technologisch geht das Unternehmen tief in die industrielle Qualitätssicherung und führt standardmäßig Elektrolumineszenz-Prüfungen durch, um unsichtbare Mikrorisse im Vorfeld zu detektieren.

Einen völlig anderen, stark hochskalierten Weg bestreitet das österreichische CleanTech-Start-up 2nd Cycle. Das Unternehmen betreibt eine vollautomatische Inspektions- und Upcycling-Anlage im industriellen Hochdurchsatz und nutzt neben klassischer Robotik auch patentierte hyperspektrale Analysen aus der Raumfahrt, um Zellalterungen frühzeitig zu erkennen.

Der Schlüssel zum wirtschaftlichen Erfolg

Das Vorhaben von Better Sol leistet einen fundamentalen Beitrag, um noch leistungsfähige Materialien durch geschickte Kreislaufwirtschaft für eine Weiternutzung zu erhalten, damit die Bemühungen für mehr erneuerbare Energien nicht ins Stocken geraten. Dennoch muss sich das Geschäftsmodell in einem harten Wettbewerb beweisen.

Die Handwerkerkosten für den Aufbau einer PV-Anlage auf einem Eigenheim sind hoch und fallen völlig unabhängig davon an, ob man neue oder gebrauchte Paneele installiert. Gleichzeitig steht der Markt unter enormem Preisdruck durch historisch günstige asiatische Neuware. Wenn fabrikneue Module extrem billiger werden, schwindet das Argument der finanziellen Ersparnis bei Gebrauchtmodulen mit kürzerer Restlebensdauer. Der Schlüssel zum wirtschaftlichen Erfolg von Better Sol liegt daher in der rigorosen Minimierung der eigenen Logistik- und Prozesskosten. Die geplante mobile Testanlage und die zusätzliche Automatisierung des Testsystems sind für das Start-up essenziell, um künftig auch größere Ausmusterungen von Solarparks wirtschaftlich bewältigen zu können.

eeden: Die Alchemie der Altkleider

Das Münsteraner Unternehmen eeden verwandelt Textilmüll in hochwertige Rohstoffe. Mit Millioneninvestments baut das Team um Steffen Gerlach und Tobias Börnhorst nun die erste Demonstrationsanlage auf.

Steffen Gerlach saß entspannt mit seinem Schulfreund Reiner Mantsch auf einer Couch in einer Kölner Wohngemeinschaft. Mantsch hatte zuvor an der Universität in Mönchengladbach Textiltechnik studiert. Er berichtete leidenschaftlich von seinen naturwissenschaftlichen Forschungen zur Kreislaufwirtschaft. Dieses Gespräch veränderte Gerlachs gesamte berufliche Planung radikal. Mantsch suchte jemanden für die Marktseite seiner technischen Vision. Gerlach war sofort fasziniert von dem ökonomischen Potenzial. Er wollte wissen, ob man daraus ein echtes Unternehmen formen kann. „Das war der eigentliche Startpunkt für eeden. Wir entschieden uns für einen vollen Fokus auf das Projekt. Und wir wollten das Recyclingproblem der Branche grundlegend lösen“, erinnert sich Gerlach.

Der langsame Weg zum technologischen Durchbruch

Es gab keinen plötzlichen Heureka-Moment in einem winzigen und improvisierten Labor. Die Entwicklung war eher eine gezielte Suche nach einer Problemlösung. Mantsch war früher Leistungssportler und brachte den nötigen Fokus mit. Er sah den Frust seiner Kommilitonen nach Praktika in der Industrie. Die Branche wirkte starr und wenig dynamisch für junge Talente. Das Duo suchte stattdessen nach den Megatrends der Zukunft. „Die Kreislaufwirtschaft kristallisierte sich schnell als das zentrale Thema heraus. Ich habe die Marktseite intensiv analysiert und viele Gespräche geführt“, so Gerlach. Er erkannte die Verknüpfungen zwischen technischer Machbarkeit und ökonomischen Anforderungen. Die Suche nach dem technologischen Sweetspot dauerte Monate. Am Anfang stand lediglich die reine Faszination für das Recycling. Es war ein schleichender Prozess mit vielen Etappenentscheidungen.

Die wachsende Last der globalen Fast Fashion

Das Umweltproblem der globalen Textilindustrie ist mittlerweile gewaltig. Die Branche verdoppelt ihren Durchsatz alle 20 bis 30 Jahre. Jährlich werden mittlerweile mehr als 120 Mio. Tonnen Textilien produziert. Nach Angaben der Ellen MacArthur Foundation werden weltweit ungefähr zwei Drittel dieser Mengen praktisch direkt nach der Nutzung entsorgt; sie landen auf riesigen Deponien oder werden ungenutzt verbrannt. In Deutschland steht das klassische Rücknahmesystem laut Experten vor dem Kollaps. Es gibt nach seiner Aussage derzeit eine gestiegene Anzahl an Insolvenzen bei Sammel- und Sortierbetrieben. Die Qualität der Kleidung sinkt durch den Trend zur Fast Fashion massiv. Der Wiederverkauf der gebrauchten Ware lohnt sich oft nicht mehr. Neuware aus Asien ist meistens günstiger als Second Hand-Stücke aus Europa. In Deutschland verursacht die Entsorgung einer Tonne Altkleider zudem Kosten – das Material wird somit zur finanziellen Belastung für die Sammel- und Sortierbetriebe.

Chemische Trennung als industrieller Schlüssel

Das Unternehmen aus Münster setzt genau an diesem Punkt an. Die Technologie ermöglicht die Trennung von Baumwolle und Polyester und macht beide Materialien wieder nutzbar. Das ist entscheidend für den Erfolg der Kreislaufwirtschaft. Die meisten Textilien bestehen heute aus komplexen Mischgeweben. Gerlach erklärt, dass das Unternehmen aus dem Abfall eine hochwertige Cellulose und chemische Bausteine für neues Polyester gewinnt. Die Cellulose dient als sauberes Vorprodukt für die neue Faserherstellung. Das Polyester wird in seine Grundbausteine zerlegt, die für die Herstellung von neuem Polyester verwendet werden können. „Wir stellen aus Baumwolle eine hochwertige Cellulose her und gewinnen aus dem Polyester die chemischen Bausteine zurück“, sagt Gerlach. Beide Materialströme können direkt wieder in der Textilproduktion eingesetzt werden. Damit wird der Kreislauf zwischen Abfall und Kleidung geschlossen. Seit Anfang 2025 hilft zudem eine neue gesetzliche Regelung. Die EU-weite Getrenntsammlungspflicht für Textilabfälle ist in Kraft getreten: Unternehmen dürfen Textilien nun nicht mehr über den Restmüll entsorgen. Das sichert den Zugang zu großen Mengen an Rohstoffen.

Harte Verhandlungen in der Welt des Wagniskapitals

Der Weg von der ersten Idee zur fertig gebauten Industrieanlage ist lang. Deeptech-Unternehmen brauchen oft viel Geduld und Zeit für die Entwicklung. Das erfordert Investoren mit einem sehr langen Atem. In einer frühen Phase kam der High-Tech Gründerfonds an Bord. Auch die NRW.Bank und der TechVision Fonds unterstützen das Vorhaben. Später stiegen Forbion und der Chemiekonzern Henkel als Investor ein. Gerlach erinnert sich im Gespräch an einen intensiven Lernprozess bei den ersten Finanzierungsrunden. Man müsse technische Begeisterung mit harten Umsatzprognosen anreichern. Auch D11Z.Ventures, das Family Office von Dieter Schwarz (Lidl/Kaufland), investierte in das Unternehmen. Die Investoren verstehen laut Gerlach die Entwicklungszyklen und Skalierung von Deeptech-Unternehmen. Mittlerweile flossen über 20 Mio. EUR an Kapital in die Firma. Dieses Geld ermöglicht nun den nächsten großen Schritt.

Ein neues Team für die industrielle Skalierung

Das Start-up ist mittlerweile den Kinderschuhen entwachsen. In Münster entsteht derzeit eine industrielle Demonstrationsanlage. Gerlach erinnert sich an den Moment der Schlüsselübergabe: Zuerst wirkte die leere Halle riesig auf das Team. Inzwischen planen die Ingenieure bereits jeden Zentimeter der Fläche. Das Team ist auf über 25 Köpfe gewachsen. Es ist eine Mischung aus jungen Talenten und erfahrenen Kräften. Viele Mitarbeitende wechselten von großen Konzernen wie BASF nach Münster. Gerlach beobachtet eine große Lust auf die Arbeit an innovativen Prozessen. Die flachen Hierarchien im Unternehmen ziehen Experten an. Er schätzt das Know-how dieser Fachkräfte für den Anlagenbau. Erfahrene Chemiker bringen eine neue Qualität in die Prozesse. Die Zusammenarbeit zwischen Alt und Jung funktioniert hervorragend.

Führung zwischen Agilität und unternehmerischer Verantwortung

Die Unternehmenskultur hat sich mit der Größe weiterentwickelt. Gerlach betont, dass viele Impulse direkt aus der Belegschaft kommen. So wurde die Regelung für die Präsenz im Büro gemeinsam erarbeitet. Die Mitarbeitenden wünschten sich feste Tage für den Austausch. „Die schönsten Tage sind jene mit viel Begegnung“, berichtet Gerlach. Die bürokratischen Pflichten eines Geschäftsführers gehören einfach dazu. Trotzdem bleibt die Mission der Firma der wichtigste Treiber. Die Motivation im gesamten Team sei extrem hoch. Jeder packt an und treibt das Unternehmen voran. Der Spagat zwischen Entwicklung und Business ist fordernd. Gerlach jedoch genießt diese tägliche Herausforderung sehr.

Der Standort Deutschland als Zentrum für Innovation

Viele Fachleute kritisieren die Bedingungen für die Chemieindustrie. Hohe Energiekosten belasten die traditionsreichen Unternehmen stark. Gerlach sieht das differenzierter aus der Perspektive von innovativen Start-ups: „Für die Entwicklung neuer Technologien ist der Standort Deutschland weiter exzellent. Und die Qualifikation der Technologen ist hervorragend. Die aktuelle Krise führt bei uns auch zu Bewerbungen von erfahrenen Talenten aus der chemischen Industrie – die hätte es vor einigen Jahren in der Menge nicht gegeben.“ Die vorhandene Infrastruktur sei ein klarer Vorteil. Auch Konzerne beobachten solche Innovationen genau. Die Nähe zum Mittelstand fördert zudem die Skalierung. Für die beiden Gründer ist die aktuelle Produktionsanlage nur ein Anfang. Langfristig soll die Technologie weltweit lizenziert werden; überall auf der Welt fällt schließlich Textilmüll an. Die Kombination aus Ingenieurskunst und Skalierung ist das Ziel. Auch die aktuellen Investoren von eeden sehen dieses globale Potenzial. Das Unternehmen will beweisen, dass sich Kreislaufwirtschaft lohnt. Deutschland bleibt dafür ein wichtiger Ankerpunkt.

Distart: Vom Agentur-Frust zum EdTech-Champion

Wie das 2021 von Thomy Roecklin gegründete und seit 2025 zusammen mit Lucia-Miriam Selbert geführte Leipziger EdTech Distart das Bildungssystem „gegen den Strich bürstet“.

Wer in Deutschland über Start-up-Hubs spricht, landet meist schnell in Berlin oder München. Doch in der sächsischen Metropole Leipzig wächst seit einigen Jahren ein Player heran, der beweist, dass Innovation auch abseits der üblichen Verdächtigen gedeiht: Die Distart Education GmbH. Ihr Treibstoff ist der eklatante Mangel an digitaler Kompetenz in der deutschen Wirtschaft – und der Mut, das „System Bildung“ gegen den Strich zu bürsten.

Wenn „Done for You“ nicht mehr reicht

Die Wurzeln des Unternehmens reichen weiter zurück als das offizielle Gründungsjahr 2021. Gründer Thomy Roecklin setzte jahrelang mit seinen Agenturen MNKY lab und TRDIGITAL digitale Kampagnen für Kund*innen um. Doch im Tagesgeschäft bremste das fehlende Digitalverständnis auf Kundenseite die Projekte immer wieder aus. Die Erkenntnis, dass Deutschland weniger neue Agenturen, sondern mehr digitale Mündigkeit braucht, führte schließlich zum Pivot.

Interessanterweise war der Auslöser für diesen Kurswechsel kein konkretes Kundenprojekt. Auf die Frage nach dem „Aha-Moment“ erklärt Roecklin, dass er lediglich versuchte, Lucia-Miriam Selbert einzuarbeiten, und dabei schockiert feststellte, wie wenig praxisnahe digitale Weiterbildungen existierten. Er baute kurzerhand selbst ein Lernprogramm – ohne zu ahnen, dass daraus einmal Distart entstehen würde. Im Januar 2021 fiel der Startschuss für Distart learn. Mitten in der Pandemie setzte Roecklin auf ein Modell, das sich radikal von klassischen Bildungsträgern unterschied: 100 Prozent remote, aber mit enger persönlicher Betreuung und einem klaren Fokus auf die Praxis.

Das Schnellboot zwischen den Tankern

Distart operiert im sogenannten AZAV-Markt (Akkreditierungs- und Zulassungsverordnung Arbeitsförderung). Während etablierte Bildungsriesen oft mit der Trägheit ihrer Größe kämpfen und bis zu 24 Monate für Lehrplananpassungen benötigen, hat sich Distart als agiler „Qualitäts-Vorreiter“ positioniert.

Für Roecklin ist diese Agilität eine Frage des Überlebens, da sich Jobs und Skills heute schneller verändern als jede klassische Bildungslogik. Er betont, dass man ohne permanente Weiterentwicklung der Inhalte zwangsläufig am Markt vorbei ausbilden würde. Diese Flexibilität ist zudem essenziell für die Zielgruppe: Viele Teilnehmende bilden sich neben ihrem 9-to-5-Job weiter, betreuen Kinder oder pflegen Angehörige und benötigen daher flexible statt starrer Strukturen.

Agency-DNA statt Schulbank-Feeling

Der entscheidende Wettbewerbsvorteil liegt in der Herkunft: Distart ist keine klassische Schule, sondern wurde von Marketern für Marketer gebaut. Diese „Agency-DNA“ durchzieht das gesamte Geschäftsmodell. Mit einer modernen Lernumgebung aus Live-Sessions und asynchronen Deep-Dives spricht das Unternehmen alle Altersgruppen gleichermaßen an.

Auch technologisch ist man der Konkurrenz oft einen Schritt voraus: Als ChatGPT Ende 2022 die Arbeitswelt veränderte, reagierte Distart fast in Echtzeit. Auf die kritische Frage, ob KI das vermittelte Wissen nicht bald obsolet mache, findet Roecklin eine klare Antwort: KI ersetzt keine Menschen, sie ersetzt lediglich Mittelmaß. Während KI das Netz mit generischen Inhalten flutet, steige paradoxerweise der Hunger nach echten Stimmen, Ideen und Perspektiven – Marketing werde also menschlicher.

Bootstrapping und gesundes Wachstum

Der Erfolg gibt dem Konzept recht. Im September 2024 erfolgte die Umfirmierung zur Distart Education GmbH, was den Übergang vom Start-up zum etablierten Bildungsinstitut markierte. Während andere Tech-Unternehmen Personal abbauen mussten, verdoppelte Distart seine Belegschaft beinahe auf über 100 Köpfe und bezog im Oktober 2025 neue Räumlichkeiten im NEO Leipzig.

Besonders bemerkenswert: Das Wachstum ist organisch und gebootstrapped – finanziert aus dem eigenen Cashflow ohne externe Risikokapitalgeber. Das macht Distart unabhängig von Exit-Druck. Seit Februar 2025 verstärkt Lucia-Miriam Selbert als Geschäftsführerin die strategische Ausrichtung.

Dennoch birgt die Skalierung Risiken, da das Geschäftsmodell stark von staatlichen Bildungsgutscheinen abhängt. Auf einen möglichen „Plan B“ angesprochen, erklärt das Unternehmen, dass Förderungen zwar beim Beschleunigen helfen, man Distart aber bewusst so aufbaue, dass langfristig strukturelle Unabhängigkeit erreicht wird. Auch die Qualitätssicherung bei über 100 Mitarbeitenden ist eine Herausforderung. Thomy Roecklin gibt offen zu, dass Wachstum kein Wellnessprogramm ist und es im Getriebe zwangsläufig knirscht. Sein Schlüssel: Qualität darf nicht an Einzelpersonen hängen, sondern muss im gesamten System verankert sein, kombiniert mit echtem Vertrauen in das Team statt Kontrolle.

Der Standort als Statement und Vision

Dass Distart in Leipzig verwurzelt bleibt, ist Teil der Identität. Roecklin sieht im Osten Deutschlands ein enormes, oft unterschätztes Potenzial und erlebt dort viel Talent, Pragmatismus und Lernhunger. Distart versteht sich hier auch als Regionalentwickler.

Die Vision der Gründer geht jedoch über reine Kurse hinaus. Unterstrichen durch Auszeichnungen wie „Top Fernschule 2025“ und „2026“, arbeitet das Team nun an der Gründung der Distart University of Applied Sciences. Das Ziel bis 2030 ist ambitioniert: Ein Alumni-Netzwerk von 25.000 Absolvent*innen. Sollte der komplexe Weg zur staatlichen Anerkennung gelingen, wird Distart endgültig zum gewichtigen Faktor für die digitale Wettbewerbsfähigkeit der Bundesrepublik.

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

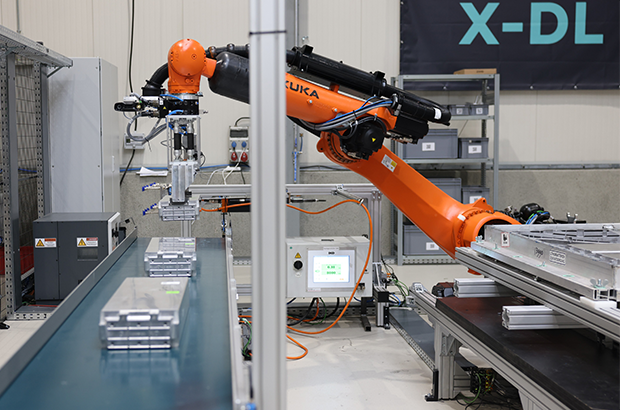

ChatGPT schreibt Texte. R3 Robotics zerlegt Batterien

Es gibt Probleme, die man mit Software lösen kann, und es gibt Probleme, für die man sich die Hände schmutzig machen muss – oder besser: Roboterhände nutzt. Antoine Welter und Dr. Xavier Kohll haben mit Circu Li-ion begonnen, um Batterien zu retten. Jetzt, unter dem neuen Namen R3 Robotics und mit 20 Millionen Euro frischem Kapital im Rücken, treten sie an, um den wohl größten Flaschenhals der kommenden Mobilitätswende zu beseitigen. Ihr Ansatz: Keine teuren Spezialmaschinen, sondern intelligente Standard-Roboter, die sehen, verstehen und sicher zupacken.

Wenn in den Vorstandsetagen der Automobilhersteller über die Zukunft gesprochen wird, geht es meist um Reichweiten und Software-Defined Vehicles. Doch am anderen Ende der Wertschöpfungskette braut sich ein Sturm zusammen. Millionen von Elektrofahrzeugen werden in den kommenden Jahren ihr Lebensende erreichen. Die derzeitige Realität in vielen Recyclinghöfen wirkt dagegen fast archaisch: Menschen, die mit Handwerkzeugen komplexe Systeme auseinanderschrauben. Das ist nicht nur teuer und schwer skalierbar, sondern bei Hochvolt-Systemen auch lebensgefährlich.

Genau hier setzen Antoine Welter und Xavier Kohll an. Die Nachricht, die das deutsch-luxemburgische Unternehmen Anfang Februar 2026 verkündete, ist mehr als nur eine Finanzierungsrunde. Die 20 Millionen Euro – aufgeteilt in 14 Millionen Euro Series-A-Kapital und 6 Millionen Euro öffentliche Fördergelder – heben die Gesamtfinanzierung des Unternehmens auf ein neues Level. Angeführt wird die Runde von HG Ventures und Suma Capital, unterstützt von Co-Investoren wie der Oetker Collection und dem EIC Fund.

Doch das Geld ist nur der Treibstoff für eine strategische Evolution. Aus Circu Li-ion wird R3 Robotics. Der neue Name ist Programm: Repair, Reuse, Recycle. Antoine Welter erklärt die Motivation hinter der Umbenennung pragmatisch: „Circu Li-ion hat beschrieben, wo wir angefangen haben. R3 Robotics beschreibt, was wir aufbauen: industrielle Robotik, die Demontage skalierbar, sicher und kosteneffizient macht.“

Wenn der Roboter Augen bekommt

Die größte Hürde im Recycling ist nicht die Chemie, sondern die Variabilität. Kein Batteriepack gleicht dem anderen, E-Motoren sind unterschiedlich verbaut, Schrauben sind korrodiert. Starre Fertigungsstraßen scheitern hier. R3 Robotics löst dies mit einer Plattform, die Computer Vision, künstliche Intelligenz und Robotik verschmilzt.

Das System fungiert dabei fast wie ein „ChatGPT für die physische Welt“: Anstatt Text zu generieren, plant die KI physische Handlungen. Sensoren scannen das Bauteil, die KI erkennt den Zustand und promptet den Roboterarm dynamisch durch den Demontageprozess. Der entscheidende Vorteil: Der Mensch wird aus der Gefahrenzone der Hochspannung genommen, während der Roboter Aufgaben erledigt, die für klassische Automatisierung zu komplex wären.

Angesprochen auf den Vergleich mit Generative AI und die Frage, wie die Roboter tatsächlich „sehen“ und „entscheiden“, bestätigt Welter die Parallele: „Der Vergleich mit Generative AI passt gut: Das Modell bekommt einen Input – keinen Text, sondern einen Scan des Bauteils – und generiert daraus eine Handlungssequenz.“ Es gehe darum zu erkennen, um welches Modell es sich handelt, wie der Zustand ist und wo die Verbindungspunkte liegen. „Das klingt simpel, ist es aber nicht – kein Pack ist identisch“, so Welter. Die eigentliche Herausforderung liege jedoch in der Entscheidung davor: „Welche Reihenfolge ist sicher? Ein falscher Griff an ein Hochvoltsystem kann tödlich sein. Unser System sieht, bewertet und entscheidet.“

Smart Hardware: Warum das Rad neu erfinden?

Ein Detail, das Investor*innen besonders aufhorchen lässt, ist die Kapitaleffizienz der Gründer. Wer an Industrie-Robotik denkt, denkt an teure Hardware-Entwicklung. R3 Robotics geht einen pragmatischen Weg: Ein Großteil der verwendeten Hardware wird „von der Stange“ gekauft.

Die Roboterarme sind Standardprodukte. Die Innovation – und damit das geistige Eigentum – steckt in den spezialisierten „End-Effektoren“ (den Roboterhänden), den Sensorsystemen und vor allem dem Software-Stack, der alles steuert. Das erlaubt eine Skalierung, die mit proprietärer Hardware kaum möglich wäre. Mitgründer Dr. Xavier Kohll betont, dass dies eine bewusste Entscheidung gegen „Over-Engineering“ war: „Der Roboterarm ist Standard und die Intelligenz sitzt in den Endeffektoren, der Sensorik und dem Software-Stack, der alles zusammenbringt. Das ist unser geistiges Eigentum, und genau das lässt sich skalieren.“

David gegen Goliath – oder Partner?

Während große Recycling-Konzerne oft noch auf den Schredder setzen und die manuelle Demontage an ihre Grenzen stößt, positioniert sich R3 Robotics in einer neuen Nische. Es geht nicht darum, die Chemie-Giganten zu ersetzen, sondern ihnen den Rohstoff so rein wie möglich zu liefern – als strategische Quelle für kritische Materialien. Doch der Markt schläft nicht: Weltweit entstehen Initiativen zur Automatisierung.

Trotz des aktuellen „Gegners“ – dem Menschen mit dem Schraubenzieher – und potenzieller Konkurrenz durch Tech-Start-ups oder Autohersteller, bleibt Welter gelassen. „Wir konkurrieren nicht mit den Chemie-Giganten, wir liefern ihnen den reinsten möglichen Stoffstrom“, stellt er klar. Gegenüber potenziellen Nachahmern sieht er einen entscheidenden Vorteil, den „Unfair Advantage“: die Kombination aus Flexibilität und industrieller Automatisierungstiefe. „Wir sind aktuell die einzige Plattform, die sowohl Variabilität managt als auch für kontinuierlichen Industriebetrieb ausgelegt ist.“

Deutschland als Labor, USA als Skalierungsmarkt

Die Wachstumsstrategie von R3 Robotics ruht auf zwei massiven Säulen: technologischer Tiefe in Europa und kommerzieller Breite in den USA.

Deutschland fungiert dabei als das technologische Rückgrat. Mit der Erweiterung der Anlage in Karlsruhe zur Lighthouse Facility demonstriert das Unternehmen industrielle Leistungsfähigkeit direkt vor der Haustür der großen Autobauer. Hier wird die Technologie gehärtet. Das zeigt sich auch im Leuchtturmprojekt ReDriveS, wo R3 Robotics Seite an Seite mit Giganten wie Schaeffler und VW an der Demontage von E-Achsen arbeitet.

Doch für das massive Volumen blickt das Team über den Atlantik. Der für 2026 geplante Markteintritt in den USA ist Kern der neuen Strategie. Die frischen 20 Millionen Euro sollen gezielt in den Aufbau strategischer Partnerschaften vor Ort fließen, um die Technologie dort auszurollen, wo Pragmatismus auf riesige „End-of-Life“-Volumina trifft. Für Welter ist dieser Doppelschlag essenziell: „Deutschland ist unser Beweisstand. Hier zeigen wir Schaeffler, VW und Co., dass unsere Technologie industriellen Maßstäben in Deutschland standhält.“ Die USA seien hingegen der wichtige Skalierungsmarkt, wo pragmatische Entscheider auf gigantische Volumina treffen. „Beides brauchen wir: die Glaubwürdigkeit aus Europa und das Volumen aus Amerika.“

Industrialisierung statt Romantik

Mit Peter Mohnen, dem ehemaligen CEO des Roboter-Riesen KUKA, holte sich das Start-up zudem einen Beirat, der wie kaum ein anderer weiß, was Industriestandard bedeutet. Er beschreibt den Ansatz von R3 als Beweis für die nötige Automatisierungsexpertise, um Variabilität und Sicherheit gleichzeitig zu managen.

Um diese Expertise weiter auszubauen, wächst das Team rasant. Die Belegschaft soll mit der neuen Finanzierung massiv aufgestockt werden, vor allem im Bereich Engineering und KI. R3 Robotics hat den Beweis erbracht, dass Kreislaufwirtschaft kein ökologisches Nischenprojekt sein muss, sondern ein harter industrieller Prozess ist, der sich rechnet.

Denn letztlich, so das Fazit von Antoine Welter, sei Automatisierung der einzige Weg, das Problem wirklich zu lösen – nicht allein aus ökologischen Gründen, sondern weil es wirtschaftlich Sinn ergibt. „Was wir aufbauen, ist am Ende ein harter industrieller Prozess: Er muss zuverlässig funktionieren und sich rechnen.“ Es gehe aber um mehr als ein Geschäftsmodell: „Europa braucht eine Antwort auf die Frage, woher seine kritischen Materialien in Zukunft kommen“, mahnt Welter abschließend. „Wenn Europa diesen Zugang sichern will, braucht es Unternehmen, die genau das industriell umsetzen können. Dafür bauen wir diese Infrastruktur, und mit dem neuen Kapital und Team haben wir jetzt die Mittel dazu.“

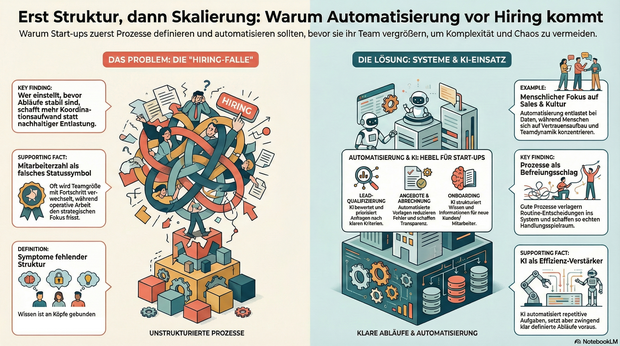

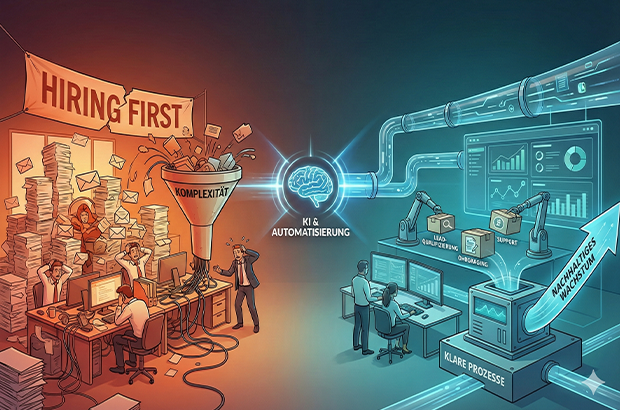

Automatisierung vor Hiring, sonst wird Komplexität skaliert

Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung. Tipps und To-Dos.

Wachstum wird in Start-ups oft sehr eindimensional gedacht: mehr Nachfrage gleich mehr Menschen. Sobald Anfragen steigen, Deals reinkommen oder neue Märkte locken, folgt fast automatisch der nächste Hiring-Plan. Dabei wird häufig die Ursache mit Wirkung verwechselt. Nicht fehlende Kapazität bremst junge Unternehmen, sondern fehlende Struktur. Prozesse entstehen improvisiert, Verantwortung wird situativ verteilt, operative Arbeit frisst Fokus. Und irgendwann fühlt sich Wachstum nicht mehr nach Fortschritt, sondern nach Dauerstress an.

Gerade in der Start-up-Branche wird Wachstum zudem stark über sichtbare Kennzahlen bewertet. In Gesprächen mit Investor*innen lautet eine der ersten Fragen häufig nicht Gewinn oder EBITA, sondern: Wie viele Mitarbeitende seid ihr und wie viel Umsatz macht ihr? Die Anzahl der Mitarbeitenden wird damit fast zu einem Statussymbol. Hiring wird nicht nur zur operativen, sondern auch zur psychologischen Größe und ein Zeichen von Fortschritt. Diese Logik verstärkt den Reflex, früh zu skalieren, auch wenn die strukturellen Voraussetzungen dafür noch fehlen. Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung.

Warum Hiring allein selten skaliert

Mehr Menschen im Team wirken wie eine schnelle Lösung. In der Praxis zeigt sich jedoch häufig ein ähnliches Muster: Neue Kolleg*innen übernehmen Aufgaben, die eigentlich nur deshalb existieren, weil Abläufe unklar oder manuell gewachsen sind. Statt nachhaltiger Entlastung entsteht zusätzliche Koordination.

Typische Symptome sind:

- operative Aufgaben blockieren strategische Arbeit,

- Wissen verteilt sich auf einzelne Köpfe,

- Entscheidungen hängen an Personen statt an klaren Abläufen,

- Abstimmungen nehmen zu, ohne dass die Wertschöpfung im gleichen Maß wächst.

Das Problem ist nicht Hiring an sich, sondern die Reihenfolge. In vielen Fällen wird Hiring eingesetzt, um kurzfristig Druck rauszunehmen, obwohl das eigentliche Nadelöhr fehlende Klarheit ist. Wer einstellt, bevor Abläufe stabil sind, schafft zwar mehr Kapazität, skaliert aber auch Komplexität.

Prozesse als Voraussetzung für wirksames Wachstum

Prozesse werden in Start-ups häufig mit Bürokratie verwechselt. Tatsächlich sind sie das Gegenteil: Sie reduzieren Reibung. Gute Prozesse verlagern Entscheidungen vom Einzelfall ins System. Sie beantworten zwei zentrale Fragen zuverlässig: Was passiert als Nächstes – und wer ist verantwortlich?

Gerade kleine Teams profitieren davon besonders. Prozesse schaffen keine Starrheit, sondern Handlungsspielraum. Sie machen Arbeit vorhersehbar, Übergaben sauber und Entscheidungen reproduzierbar. Erst auf dieser Grundlage kann ein wachsendes Team seine Stärke wirklich entfalten.

Automatisierung im KI-Zeitalter: neue Möglichkeiten, neue Verantwortung

Mit KI hat sich die Eintrittshürde für Automatisierung massiv gesenkt. Viele Aufgaben, die früher manuell oder individuell erledigt wurden, lassen sich heute zuverlässig unterstützen oder teilweise abnehmen, vorausgesetzt, der zugrunde liegende Ablauf ist klar definiert. Entscheidend ist dabei nicht die Tool-Auswahl, sondern die Frage, was automatisiert wird. Automatisierung verstärkt bestehende Strukturen, gute wie schlechte. Wer unklare Abläufe automatisiert, skaliert keine Effizienz, sondern Chaos. Gleichzeitig gibt es zentrale Bereiche, die sich bewusst nicht oder nur sehr begrenzt automatisieren lassen und auch nicht sollten. Recruiting ist einer davon. Der Aufbau eines funktionierenden Teams lebt von persönlicher Einschätzung, Teamdynamik und kulturellem Fit. Ähnliches gilt für Sales: Vertrauensaufbau, Verhandlung und das persönliche Gespräch bleiben essenziell. Automatisierung ist hier unterstützend, aber kein Ersatz. Besonders geeignet sind Tätigkeiten, die häufig auftreten, wenig kreativen Spielraum haben und auf wiederkehrenden Informationen basieren.

Bereiche, die sich heute besonders gut automatisieren lassen

Lead- und Anfragequalifizierung

Unstrukturierte Anfragen lassen sich mithilfe von KI zusammenfassen, bewerten und priorisieren. Statt jede Anfrage manuell zu prüfen, entstehen klare Kriterien, die relevante von irrelevanten Leads trennen und Follow-ups vorbereiten.

Angebots- und Abrechnungsprozesse

Angebote, Verträge und Rechnungen folgen in vielen Startups ähnlichen Mustern. Automatisierte Vorlagen, angebundene Datenquellen und definierte Freigaben sparen Zeit, reduzieren Fehler und schaffen Transparenz.

Onboarding von Kund:innen und Mitarbeitenden

Onboarding ist kein Einzelfall, sondern ein wiederkehrender Prozess. Checklisten, automatische Aufgaben und zentrale Informationspunkte sorgen für Verlässlichkeit. KI kann helfen, Informationen zu strukturieren und kontextbezogen bereitzustellen.

Support und interne Anfragen

Ein Großteil von Fragen wiederholt sich. Wissensbasen in Kombination mit KI-gestützter Suche und Antwortvorschlägen entlasten Teams und machen sichtbar, wo Standards fehlen.

Projektmanagement und Übergaben

Klare Projekt-Templates, automatisierte Status-Updates und definierte Trigger reduzieren Abstimmungsaufwand. KI kann dabei unterstützen, Risiken früh zu erkennen oder nächste Schritte vorzuschlagen.

Was Start-ups daraus lernen können

Automatisierung ersetzt keine Entscheidungen, sie macht sie skalierbar. Voraussetzung dafür ist Klarheit über Abläufe, Verantwortlichkeiten und Prioritäten. Wer versucht, Chaos zu automatisieren, verstärkt es lediglich.

Hilfreiche Leitfragen sind:

- Welche Aufgaben wiederholen sich regelmäßig?

- Wo entstehen manuelle Engpässe?

- Welche Tätigkeiten binden qualifizierte Menschen ohne echten Mehrwert?

Die Antworten darauf liefern meist schnell die größten Hebel.

Der KI-Wendepunkt: Systeme und Personal

Nachhaltiges Wachstum entsteht dort, wo Start-ups Systeme aufbauen und diese bewusst mit ihrem Team verzahnen. Nicht, weil Systeme Menschen ersetzen, sondern weil sie Menschen von struktureller Überforderung entlasten. Automatisierung schafft dabei nicht nur Effizienz, sondern Entscheidungsqualität: Wenn Daten sauber fließen, Übergaben klar sind und Standards greifen, werden Prioritäten weniger Bauchgefühl und stärker reproduzierbar.

Der gezielte Einsatz von KI-Tools verschiebt diesen Wendepunkt zusätzlich. Sie können Routinearbeiten abfangen, Informationen aus unstrukturierten Inputs verdichten und Entscheidungen vorbereiten – etwa durch Lead-Vorqualifizierung, Support-Clustering oder zusammengefasste Status-Updates. KI wirkt dabei nicht als Ersatz für Klarheit, sondern als Verstärker funktionierender Prozesse.

Hiring bleibt auch weiterhin essentiell. Seine Wirkung entfaltet es jedoch erst dann vollständig, wenn Prozesse klar sind und Automatisierung sowie KI gezielt unterstützen. So entsteht Wachstum, das nicht nur schneller, sondern auch gesünder ist.

Der Autor Markus Hetzenegger ist Gründer & CEO von NYBA Media. 2018 gegründet, zählt NYBA heute zu den führenden Marketing-Unternehmen im Live-Entertainment.

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

Europa kann KI!

Was wir von den besten EU-AI-Companies lernen können, erläutert KI-Experte Fabian Westerheide.

Europa muss sich bei KI nicht kleinreden. Wir sehen gerade sehr deutlich: Aus Europa heraus entstehen Unternehmen, die Kategorien besetzen – und dann auch das große Kapital anziehen. Beispiele gibt es genug: Mistral AI, DeepL, Black Forest Labs, Parloa, Helsing, Lovable oder n8n.

Ich schreibe das aus drei Blickwinkeln: als Investor (AI.FUND), als Konferenz-Initiator (Rise of AI Conference) und als Autor von „Die KI-Nation“. Was du hier bekommst, ist kein „Europa-hat-ein-Problem“-Essay – sondern eine Analyse plus ein Execution-Set an Empfehlungen, das du direkt auf dein Start-up übertragen kannst.

Die Realität: Seed geht oft – Scale ist das Spiel

Am Anfang brauchst du selten „zu viel“ Geld. MVP, erste Kunden, Iteration: Das klappt in Deutschland in vielen Fällen mit Seed. Die echte Trennlinie kommt später – wenn du aus einem starken Start-up einen Kategorie-Gewinner bauen willst.

Denn KI ist zunehmend Winner-takes-most. Und das gilt auch fürs Kapital: In vielen Fällen ist die Growth-Finanzierung in den USA grob 25-mal größer – bei den aktuellen Front-Runnern (Modelle, Infrastruktur, Distribution) wirkt es teilweise wie 100-mal, weil Kapital sich auf die vermuteten Sieger stapelt. (Nicht „fair“, aber Marktmechanik.)

Die gute Nachricht: Genau die EU-Vorbilder oben zeigen, dass du das nicht wegdiskutieren musst – du musst es exekutieren.

Was die EU-Winner gemeinsam haben: 6 Execution-Prinzipien

1. Starkes Gründerteam – aber vor allem: vollständig

Alle genannten Vorbilder hatten (oder bauten sehr schnell) ein Team, das drei Dinge gleichzeitig kann:

- Tech & Produkt (nicht nur „Model-IQ“, sondern Produktgeschmack)

- Go-to-Market (Vertrieb, Buyer-Verständnis, Pricing)

- Tempo (entscheiden, shippen, lernen)

Wenn eine Säule fehlt, zahlst du später mit Zeit. Und Zeit ist in KI eine Währung, die dir niemand schenkt.

Founder-Move: Benenne eine Person, die Umsatz genauso hart verantwortet wie Modellqualität. Wenn das „später“ ist, ist das sehr wahrscheinlich dein Bottleneck.

2. Global denken – aber spitz: KI-Nische statt Bauchladen

Die EU-Winner sind nicht „KI für alles“. Sie besetzen klare Nischen:

Language-AI (DeepL), Customer-Experience-Agents (Parloa), GenAI-Modelle (Black Forest Labs), Defence-Tech (Helsing), Builder/Vibe-Coding (Lovable), Orchestration & Automation (n8n), Foundation-Model-Ambition (Mistral).

Founder-Move: Formuliere deinen Claim so, dass er in einem Satz sagt, welche Kategorie du dominierst. Wenn du drei Absätze brauchst, bist du noch zu breit.

3. Umsatz ist keine Nebenwirkung – Umsatz ist Souveränität

Der schnellste Weg zu Growth-Capital ist nicht „noch ein Pilot“, sondern Revenue, der deine Kategorie glaubwürdig macht.

Parloa kommuniziert z.B. ARR > 50 Mio. USD und wächst international – genau die Art Signal, die große Runden freischaltet.

Founder-Move (gegen Pilotitis): Kein PoC ohne schriftlichen Pfad in einen Vertrag (Budget, KPI, Entscheidungstermin). Sonst finanzierst du mit deiner Runway den Lernprozess des Kunden.

4. Internationales Kapital früh anbahnen – bevor du es brauchst

Das Muster ist klar: Erst Kategorie-Story + Traktion, dann große Checks.

Mistral (Series C 1,7 Mrd. €) oder Lovable (330 Mio. USD bei 6,6 Mrd. Bewertung) sind kein „Glück“ – das ist Momentum + Positionierung + Timing.

Founder-Move (90-Tage-Plan):

- Baue eine Capital Map deiner Nische (wer zahlt Growth-Checks?)

- Definiere die drei Metriken, die diese Investor:innen sehen wollen

- Organisiere zehn Intros jetzt, nicht erst bei sechs Monaten Runway

5. Compute ist keine IT-Zeile – es ist ein Wachstumshebel

In KI ist Compute Teil deiner Wettbewerbsfähigkeit. Geschwindigkeit beim Trainieren, Testen und Deployen entscheidet, wie schnell du am Markt lernst.

Founder-Move: Plane Compute-Runway wie Cash-Runway. Verhandle früh Kontingente, bevor dein Verbrauch explodiert – sonst wird Wachstum plötzlich zur Margen-Frage.

6. Trust & Compliance als Verkaufsargument – nicht als Ausrede

Gerade in DACH gilt: Wer secure, audit-fähig, enterprise-ready wirklich liefern kann, gewinnt Deals.

DeepL betont genau diesen Business-Wert: verlässliche, sichere Lösungen statt Hype.

Founder-Move: Baue Trust-Artefakte früh – Dokumentation, Governance, Datenflüsse, Rollen, Audit-Spuren. Das beschleunigt Enterprise-Vertrieb, statt ihn zu bremsen.

Kurz-Checkliste: Wenn du in Europa KI gewinnen willst

- Kategorie in einem Satz (spitze Nische, globaler Anspruch)

- Klarer Revenue-Pfad (weniger Piloten, mehr Verträge)

- Capital Map (international früh andocken)

- Compute-Runway (wie Cash planen)

- Trust by Design (verkaufsfähig machen)

- Tempo als Kultur (shippen, messen, nachschärfen)

Europa kann KI. Die Frage ist nicht, ob hier Talent existiert – das ist bewiesen.

Die Frage ist, ob du Execution so aufsetzt, dass aus Talent Marktführerschaft wird.

Der Autor Fabian Westerheide gestaltet als KI-Vordenker, Investor, Ökosystem-Pionier und Keynote Speaker seit über einem Jahrzehnt die Debatte um KI, Macht und digitale Zukunft mit.

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

to teach: Vom KI-Hype zur Schulinfrastruktur

Wie das 2022 gegründete EdTech to teach die Lücke zwischen Chatbot und Klassenzimmer schließt.

Vor drei Jahren begann mit dem öffentlichen Zugang zu generativer künstlicher Intelligenz ein weltweiter Hype, der auch vor den Schultoren nicht haltmachte. Doch im Bildungsmarkt entscheidet sich derzeit, ob die Technologie tatsächlich Produktivität schafft oder in einer digitalen Sackgasse endet. Das Hamburger EdTech to teach liefert hierzu eine Blaupause: Was 2022 als Experiment begann, hat sich innerhalb von drei Jahren zu einer Arbeitsplattform für hunderttausende Lehrkräfte entwickelt.

Das Problem: US-Tools verstehen deutsche Schulen nicht

Als generative KI erstmals verfügbar wurde, wirkte ihr Einsatz im Bildungsbereich naheliegend. Doch der Blick auf die internationale Konkurrenz zeigt das Dilemma: Während US-Platzhirsche wie MagicSchool AI oder Diffit den Markt mit hunderten Mikro-Tools fluten und technisch beeindrucken, fehlt ihnen der kulturelle Fit. „Einfach nur Texte aus ChatGPT zu kopieren, löst kein einziges Problem von Lehrkräften“, erklärt Felix Weiß, Co-Founder und CEO von to teach.

Die Diskrepanz zwischen dem Versprechen der KI und dem tatsächlichen Schulalltag war groß. US-Lösungen scheitern oft an spezifischen deutschen Lehrplänen oder liefern reine Multiple-Choice-Formate, die hierzulande kaum Anwendung finden. Lehrkräfte benötigten keine unstrukturierten Textwüsten, sondern didaktisch saubere, lehrplankonforme und sofort einsetzbare Materialien. Genau hier setzte das 2022 von Felix Weiß und Marius Lindenmeier gegründete Unternehmen an.

Der Pivot: Datenschutz als Burggraben

Der entscheidende Wendepunkt kam 2023. Das Start-up vollzog einen Strategiewechsel (Pivot) weg von einer SaaS-Lösung für Verlage hin zu einer direkten Plattform für Lehrkräfte. Anstatt Nutzer*innen mit freien Eingabefeldern (Prompts) allein zu lassen, entwickelte das Team feste Arbeitsblattvorlagen. Dies wurde zum entscheidenden Wettbewerbsvorteil gegenüber internationalen Anbietern: Während diese oft an der strikten DSGVO scheitern, bietet to teach durch Serverstandorte in der EU und Rechtssicherheit eine Lösung, die Schulträger akzeptieren.

Dabei mussten technische Kinderkrankheiten überwunden werden: Frühe KI-Modelle „halluzinierten“ Fakten. To teach reagierte mit der systematischen Integration von Quellen und profitierte zugleich von der rasanten Evolution der Sprachmodelle.

Skalierung im Ökosystem gegen nationale Konkurrenz

Der Markt nahm die Lösung schnell an: Im Januar 2023 meldete sich der erste Nutzer an, bis Ende des Jahres waren es laut Unternehmen bereits knapp 16.000 Lehrkräfte. Das Jahr 2024 markierte dann den Übergang vom Start-up zur Plattform: Durch die Übernahme von fobizz (101skills GmbH) wurde to teach Teil eines größeren Bildungsökosystems. Die Gründer blieben als Geschäftsführer an Bord.

Dieser Schritt war strategisch überlebenswichtig in einem sich konsolidierenden Markt. Einerseits gegenüber agilen Herausforderern, da Konkurrenten wie schulKI, Teachino, KIULY oder Kuraplan zum Teil aggressiv um Landeslizenzen kämpfen bzw. auf dem Markt für KI-gestützte Unterrichtsplanung und Materialerstellung durchgestartet sind.

Andererseits war der Schritte in Hinblick auf etablierte Verlage notwendig. Denn Häuser wie Cornelsen ziehen inzwischen mit eigenen KI-Assistenten nach, sperren ihre Inhalte jedoch oft in geschlossene Systeme, d.h. binden sie oft an die eigenen Verlagswerke.

Durch die erfolgreiche Integration in fobizz ist to teach kein isoliertes Insel-Tool mehr, sondern profitiert von bestehenden Landesrahmenverträgen und einem riesigen Vertriebsnetz. Die Nutzer*innenzahlen explodierten förmlich auf über 140.000 Lehrkräfte bis Ende 2024, so die Angaben von to teach.

Status Quo 2025: KI als neue Infrastruktur

Heute, im dritten Jahr nach der Gründung, hat sich der Fokus erneut verschoben. To teach versteht sich inzwischen als Arbeitsinfrastruktur. Die Zahlen unterstreichen diesen Anspruch: Nach Angaben von to teach nutzen über 300.000 Lehrkräfte die Plattform, und mehr als 4.000 Schulen sind angebunden. Das bedeutet: Millionen von Inhalten wurden so bereits KI-gestützt vorbereitet.

Das Unternehmen treibt nun den systematischen Schulvertrieb voran. Damit beweisen EdTechs wie to teach, dass sich Qualität und Personalisierung im sonst oft als innovationsresistent geltenden Bildungsmarkt skalieren lassen.

Für CEO Felix Weiß ist die Diskussion über das „Ob“ längst beendet: „Die Frage ist nicht mehr, ob KI im Klassenzimmer ankommt, sondern, wie und auf welche Weise sie dort wirklich hilft.“

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.

Wenn Dr. Martin Baumgärtl erklären will, wie er die chemische Industrie revolutionieren möchte, wählt er ein Bild, das jeder versteht: „Im Grunde ist es wie ein Wasserkocher in der heimischen Küche – nur im industriellen Maßstab.“ Baumgärtl ist CTO von SYPOX, und was er beschreibt, könnte einer der wichtigsten Hebel für die Dekarbonisierung einer der schmutzigsten Branchen der Welt sein.

Die chemische Industrie ist süchtig nach Energie. Um Basischemikalien wie Methanol oder Ammoniak herzustellen, wird sogenanntes Synthesegas benötigt – eine Mischung aus Wasserstoff und Kohlenmonoxid. Die Herstellung geschieht in gewaltigen Hochtemperaturprozessen. Bisher wird die dafür nötige Hitze fast ausschließlich durch das Verbrennen von Erdgas oder Öl erzeugt. Die Folge: Gigantische CO₂-Emissionen.

Strom statt Flamme

Genau hier setzt SYPOX an. Das 2021 in Freising gegründete Unternehmen ersetzt die offenen Gasflammen durch elektrischen Strom. In ihren Reaktoren, die von außen wie gewöhnliche Druckbehälter aussehen, stecken hochkomplexe elektrische Heizelemente, die direkt hinter den Katalysatoren platziert sind.

Der Effekt ist enorm: „In konventionellen Verfahren entfallen rund 40 Prozent der Emissionen allein auf die Wärmeerzeugung aus fossilen Energieträgern“, rechnet Baumgärtl vor. Durch die Elektrifizierung des Reaktors fallen diese Emissionen weg – vorausgesetzt, der Strom kommt aus erneuerbaren Quellen. Zudem lässt sich der Prozess laut den Gründern präziser und sicherer steuern.

Der Anti-Trend im Silicon Valley

Doch nicht nur technologisch, auch ökonomisch schwimmt SYPOX gegen den Strom. In der Tech-Szene ist es üblich, dass Start-ups jahrelang Verluste schreiben und sich von einer Venture-Capital-Runde zur nächsten hangeln, getrieben von Investoren, die schnelles Wachstum fordern.

Die bayerischen Gründer wählten einen konservativeren, fast schon mittelständischen Ansatz. „Es entsprach nicht unserem Stil, Geld einzuwerben – wir haben vielmehr von Anfang an versucht, auf Basis unserer Technologie ein tragfähiges Geschäft aufzubauen“, erklärt CEO Dr. Gianluca Pauletto. Man wolle bodenständig bleiben und sich aus Umsätzen finanzieren, statt sich in Abhängigkeiten zu begeben.

Vom Container im Altmühltal zum Großkunden

Die Wurzeln des Unternehmens liegen an der Technischen Universität München (TUM). Die Idee brachte Pauletto aus seiner Zeit in Montréal mit, an der TUM fand er in Prof. Johannes Lercher und dem damaligen Doktoranden Martin Baumgärtl die wissenschaftlichen Mitstreiter.

Der Weg zum marktreifen Produkt war – typisch für „Deep Tech“ – langwierig. „Vier Jahre Forschung und zahlreiche Versuchsreihen waren notwendig“, erinnert sich Lercher. Während andere Software im Co-Working-Space programmierten, baute das SYPOX-Team eine Pilotanlage in einem einfachen Stahlcontainer auf dem Gelände einer Biogasanlage im ländlichen Dollnstein (Altmühltal).

Diese Beharrlichkeit zahlt sich nun aus. Das Start-up hat, unterstützt durch den Spezialchemie-Konzern Clariant, seinen ersten Großkunden an Land gezogen. Ab 2026 soll eine erste industrielle Anlage in Betrieb gehen, die täglich 150 Tonnen Synthesegas produziert. „Das ist nicht nur ein Meilenstein für uns, sondern auch ein starkes Signal an die gesamte chemische Industrie“, so Baumgärtl.

Für das Team, das inzwischen in Langenbach bei Freising sitzt und weiterhin Labore auf dem Forschungscampus Garching betreibt, ist das der Beweis: Die Elektrifizierung der Chemie ist keine Zukunftsmusik mehr, sie beginnt jetzt.