Aktuelle Events

Sein Markenzeichen: Sport

Die Erfolgsstory von Unternehmer Willy Bogner

Autor: Sabine HölperWilly Bogner ist Spitzensportler, Filmregisseur und Inhaber des gleichnamigen Sportmode-Labels. Im Jahr 1932 gründete sein Vater das Unternehmen. Heute ist Bogner weltweit Marktführer in hochwertiger Skimode, setzt mehr als 200 Mio. Euro im Jahr um und beschäftigt rund 770 Mitarbeiter.

München ist eine perfekte Basis für Ausflüge in die Alpen. Nur ein paar Kilometer – und man steht „droben“ auf dem Berg, wo die Sonne jetzt im Winter vom Schnee reflektiert wird. Da kommt die Bräune ganz von alleine. Meist braungebrannt ist auch der gebürtige Münchner Willy Bogner. Häufig ist er im Gebirge, schnallt sich ein Paar Ski unter die Füße – und ab geht die Post. Selbst als recht guter Skifahrer kommt man ihm dann nicht hinterher.

Bogner, heute 71, hat noch immer den Mumm des Spitzensportlers in sich, der er schon in seiner Jugend war. Bereits im Alter von 16 Jahren war Bogner mehrfacher deutscher Jugendmeister. Zweimal, 1960 in Squaw Valley und 1964 in Innsbruck, startete Bogner für die deutsche Olympiamannschaft.

86-prozentige Markenbekanntheit

Wer heute 30, 40, 50 Jahre alt ist, ist zu jung, um sich an Willy Bogner als erfolgreichen Abfahrtsläufer zu erinnern. Der Name Bogner ist den meisten dennoch ein Begriff. 86 Prozent der Deutschen kennen die Skimode-Marke, in den USA gehört sie sogar zum offiziellen Sprachgebrauch. Im Wörterbuch werden „Bogners“ als Synonym für Keilhosen geführt. Nun sind auch Keilhosen nicht mehr jedem bekannt.

Dabei legten sie den Grundstein für den internationalen Erfolg des Unternehmens. 1948 präsentierte Bogner die Hosen aus Stretchmaterial erstmals auf einer Modenschau. Seither trug, wer etwas auf sich hielt, die Keilhosen aus München, darunter Stars wie Marilyn Monroe, Jane Mansfield oder Ingrid Bergman. Im vergangenen Jahr, dem Jubiläumsjahr des Unternehmens, tauchten die Keilhosen im Übrigen wieder auf – im Rahmen der Bogner „Heritage Collection“.

Mit Ski und Strickwaren aus Norwegen fing es an

Im Hause Bogner pflegt man die Tradition. 81 Jahre währt sie bereits. 1932 gründete Bogners Vater, ebenfalls Willy mit Vornamen, gemeinsam mit einem Freund ein Importgeschäft für Ski, Zubehör und Strickwaren aus Norwegen.

Seine Motivation war die Leidenschaft für den Skisport. Im Langlauf und Springen gehörte Bogner senior zu den Besten in Europa. Elfmal wurde er Deutscher Meister in der Nordischen Kombination, fünfmal Bayerischer Meister. 1935 belegte er bei den Ski-Weltmeisterschaften in der Tschechoslowakei den dritten Platz. Zu Bogners Glaubwürdigkeit als Leistungssportler gesellte sich „der Geschmack der Mutter“ Maria, die Bogner 1937 heiratete. „Sie fand die Anzüge der Skifahrer scheußlich“, sagt Bogner junior.

„In den Klamotten kannst Du alleine fahren“, habe sie zu ihrem Mann gesagt. Der fuhr dann lieber nicht alleine, sondern gab den Startschuss für die erste eigene Kollektion. Bereits 1936 trug die deutsche Olympia-Mannschaft erstmals Bogner. Seither blieb es bei der Arbeitsteilung: Maria Bogner war für die Entwürfe zuständig, ihr Mann für das Kaufmännische und fürs Marketing.

Das „baumelnde B“

Der größte Marketing-Coup allerdings gelang seiner Frau. 1955 führte sie ein Logo ein, das „baumelnde B“ an den Reißverschlüssen. „Bogner hat als eines der ersten Unternehmen ein Branding geschaffen“, sagt der Firmenchef. „Das war eine geniale Idee.“ Das B sei heute so wichtig wie damals.

Dies ist ein Auszug aus einem aktuellen Artikel unseres Print-Objekts StartingUp:

Den vollständigen Artikel lesen Sie in der aktuellen StartingUp - Heft 01/13 - ab dem 21. Februar 2013 im Handel oder jederzeit online bestellbar in unserem Bestellservice-Bereich

Den vollständigen Artikel lesen Sie in der Ausgabe 01/2013

Diese Artikel könnten Sie auch interessieren:

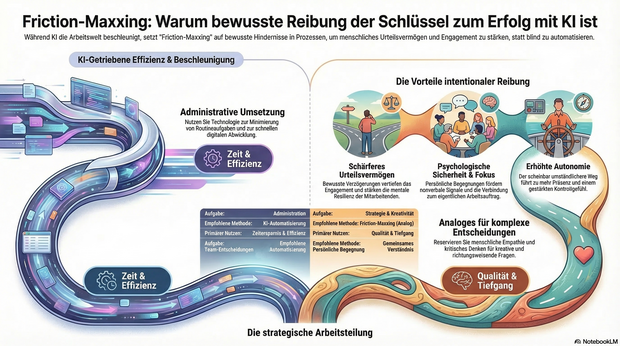

KI-Müdigkeit im Team? Warum Friction-Maxxing jetzt die Antwort ist

Nach all der Euphorie über KI-Tools macht sich bei immer mehr Menschen eine gewisse KI-Müdigkeit breit. Die Technologie hat die Arbeitswelt im Sturm erobert – doch in Unternehmen wachsen die Zweifel: Macht KI wirklich alles einfacher oder trägt sie sogar zu sinkendem Engagement bei? Dr. Arne Sjöström von Culture Amp erklärt, warum Unternehmen jetzt auf Friction-Maxxing setzen sollten.

Friction-Maxxing ist ein Trend aus dem Lifestyle-Bereich, der jedoch auch großes Potenzial für die Arbeitswelt und den strategischen Einsatz von KI in Unternehmen hat. Gemeint ist damit ein Verhalten, bei dem man bewusst mehr kleine Hindernisse und Hürden in Arbeitsprozessen akzeptiert.

Der große Vorteil: Durch eine bewusste Verzögerung wird das Urteilsvermögen geschärft, das Engagement vertieft und die mentale Resilienz der Mitarbeitenden gestärkt.

Friction-Maxxing als Gegengewicht zur KI-Dominanz

Insbesondere für Führungskräfte und das mittlere Management bietet Friction-Maxxing die Möglichkeit, produktive Reibung in Entscheidungsprozesse zurückzubringen. Durch die Rückkehr zu mehr persönlichen Begegnungen und analogen Arbeitsabläufen entstehen Dinge, die in digitalen Formaten schlicht verloren gehen:

- Konzentrierte Aufmerksamkeit.

- Psychologische Sicherheit.

- Wichtige nonverbale Signale.

Persönliche Begegnungen ermöglichen einen konstruktiven Austausch und helfen Teams dabei, ein gemeinsames Verständnis von Qualität zu entwickeln. Am Ende geht es nicht darum, unnötige Hürden aufzubauen, sondern das richtige Maß an „Reibung“ zu gestalten: Analoges für einen besseren Umgang mit Ambiguität, Kreativität und richtungsweisenden Entscheidungen – Digitales für die Umsetzung.

Fokus und Sinnhaftigkeit zurückerobern

Positive Reibung kann als dringend benötigtes Gegengewicht zur KI-getriebenen Beschleunigung in der Arbeitswelt fungieren und den Fokus wiederherstellen. Sei es durch das gründliche, manuelle Überdenken eines Briefings oder den bewussten Wunsch nach persönlichem Austausch anstelle eines asynchronen Chats. Wer sich Zeit zum Denken, Begegnen und Gestalten zurückerobert, ermöglicht es Teams, sich wieder mit ihrem eigentlichen Auftrag und ihren Ansprüchen zu verbinden – Qualitäten, die KI-Automatisierung allein niemals erreichen kann.

Dieses geänderte Verhalten führt zu mehr Präsenz, weniger Angst und einem gestärkten Gefühl der Kontrolle. Der bewusst gewählte, nur scheinbar umständlichere Weg kann somit zu mehr Autonomie und tieferer Zufriedenheit am Arbeitsplatz beitragen.

Ein Plädoyer für intentionale Reibung

Die Aufgabe moderner Führungskräfte ist es daher, bei menschenzentrierten Tätigkeiten ganz bewusst sogenannte intentionale Reibung herbeizuführen und KI parallel dazu zu nutzen, den täglichen administrativen Arbeitsaufwand zu minimieren.

Unternehmen müssen klar benennen, wo KI ihre Stärken hat und eingesetzt werden soll – und wo menschliche Fähigkeiten wie Empathie, Urteilsvermögen und kritisches Denken absolut unersetzlich sind. So gibt man Mitarbeitenden die Möglichkeit, sich auf die Arbeit zu konzentrieren, die wirklich zählt und echten Mehrwert schafft.

Friction-Maxxing ist somit weniger ein Plädoyer gegen die Technologie, sondern vielmehr ein Aufruf zur Intentionalität: Dem bewussten Abwägen darüber, wann Prozesse automatisiert werden sollten und wann gerade der Widerstand den entscheidenden Unterschied machen kann.

Der Autor Dr. Arne Sjöström ist Regional Director, People Science EMEA bei Culture Amp. Sein Schwerpunkt liegt in der Organisationspsychologie und der angewandten Forschung.

StartingUp-DeepTech-Watchlist 2026

Von „German Engineering“ zu „German DeepTech“: Diese jungen Start-ups und Scale-ups zünden 2026 die nächste Stufe – und sollten zwingend auf dem Radar von Investor*innen und Entscheider*innen stehen.

„Prognosen sind schwierig, vor allem, wenn sie die Zukunft betreffen.“ Dieser Ausspruch unterstreicht die Herausforderung, die Dynamik unseres Start-up-Ökosystems vorherzusagen. Doch wer 2025 aufmerksam verfolgt hat, der spürt: Es hat sich etwas gedreht. Der Investor*innenfokus hat sich verschoben – weg von reinen E-Commerce-Modellen, hin zu substanzieller Technologie, die echte physikalische Probleme löst.

Die folgende Auswahl an Start-ups und Scale-ups, mit denen 2026 gerechnet werden sollte, ist mehr als eine Watchlist. Sie basiert auf einer Analyse der signifikanten Finanzierungsrunden 2025, der technologischen Reife und der Resonanz bei bedeutenden Preisen. Diese Unternehmen stehen beispielhaft für eine Gründer*innengeneration, die Wissenschaft und Skalierung vereint. Natürlich bleibt ein Restrisiko. Unwägbarkeiten – von geopolitischen Instabilitäten über regulatorische Verschärfungen wie dem EU AI Act bis hin zu volatilen Zinsmärkten – können die nahe Zukunft beeinflussen. Doch die Resilienz dieser Unternehmen stimmt optimistisch.

DefenseTech: Die neue Realität der Sicherheit

Lange war Verteidigungstechnologie in Deutschland ein Tabuthema für Risikokapitalgeber. Das hat sich grundlegend geändert. Ganz oben auf der Watchlist steht neben dem Münchner Start-up Helsing nun das 2024 gegründete Black Forest Labs. Das Geschäftsmodell ist faszinierend, weil es die Grenzen zwischen kreativer Zerstörung und Sicherheitstechnologie verwischt. Es basiert auf der Entwicklung proprietärer State-of-the-Art-Modelle für generative Videoerzeugung. Nach einer spektakulären 300-Mio.-USD-Runde im Dezember 2025 katapultierte sich die Bewertung auf satte 3,25 Milliarden USD. Das Start-up ist damit Deutschlands wertvollste KI-Firma und beweist, dass Europa bei Generative AI den Anschluss nicht verloren hat. Der globale Siegeszug deutet sich 2026 unter anderem in einem mehrjährigen Vertrag mit Meta sowie in Kooperationen mit US-Plattformen wie X und Hollywood-Studios an, die Produktionskosten senken wollen. Mitgründer Robin Rombach prognostizierte im Sifted-Podcast: „2026 wird generative Video-KI zum industriellen Standard in der Medienproduktion.“ Doch auch bei der Simulation für Sicherheitsszenarien spielt die Technologie eine wachsende Rolle.

Ein weiterer Schlüsselakteur ist Stark Defence. Das 2024 gegründete Münchner Start-up adressiert eine Lücke der modernen Kriegsführung: asymmetrische Bedrohungen. Stark Defence fokussiert sich auf softwaredefinierte, autonome Drohnensysteme, die „on the edge“ entscheiden und nicht auf ständige Funkverbindung angewiesen sind. Dass das Start-up durch seine KI-Schwarmtechnologie massiv an Bedeutung gewinnen wird, hat sich Ende Februar 2026 eindrucksvoll bestätigt: Der Haushaltsausschuss des Bundestages gab einen Auftrag über 540 Millionen Euro für Kampfdrohnen frei, den sich Stark Defence (Modell „Virtus“) und das nach einer Mega-Runde im Sommer 2025 mittlerweile mit 12 Milliarden Euro bewertete Münchner Unicorn Helsing (Modell „HX-2“) teilen. Um diese rasante Skalierung zu stemmen, hat Stark Defence kürzlich das Berliner Software-Start-up Pleno übernommen und eine neue Serienfertigung im britischen Swindon eröffnet. Mitgründer Florian Seibel dazu: „Unser Ziel für 2026 ist die erste vollautonome Verteidigungslinie für Europa.“

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

eeden: Die Alchemie der Altkleider

Das Münsteraner Unternehmen eeden verwandelt Textilmüll in hochwertige Rohstoffe. Mit Millioneninvestments baut das Team um Steffen Gerlach und Tobias Börnhorst nun die erste Demonstrationsanlage auf.

Steffen Gerlach saß entspannt mit seinem Schulfreund Reiner Mantsch auf einer Couch in einer Kölner Wohngemeinschaft. Mantsch hatte zuvor an der Universität in Mönchengladbach Textiltechnik studiert. Er berichtete leidenschaftlich von seinen naturwissenschaftlichen Forschungen zur Kreislaufwirtschaft. Dieses Gespräch veränderte Gerlachs gesamte berufliche Planung radikal. Mantsch suchte jemanden für die Marktseite seiner technischen Vision. Gerlach war sofort fasziniert von dem ökonomischen Potenzial. Er wollte wissen, ob man daraus ein echtes Unternehmen formen kann. „Das war der eigentliche Startpunkt für eeden. Wir entschieden uns für einen vollen Fokus auf das Projekt. Und wir wollten das Recyclingproblem der Branche grundlegend lösen“, erinnert sich Gerlach.

Der langsame Weg zum technologischen Durchbruch

Es gab keinen plötzlichen Heureka-Moment in einem winzigen und improvisierten Labor. Die Entwicklung war eher eine gezielte Suche nach einer Problemlösung. Mantsch war früher Leistungssportler und brachte den nötigen Fokus mit. Er sah den Frust seiner Kommilitonen nach Praktika in der Industrie. Die Branche wirkte starr und wenig dynamisch für junge Talente. Das Duo suchte stattdessen nach den Megatrends der Zukunft. „Die Kreislaufwirtschaft kristallisierte sich schnell als das zentrale Thema heraus. Ich habe die Marktseite intensiv analysiert und viele Gespräche geführt“, so Gerlach. Er erkannte die Verknüpfungen zwischen technischer Machbarkeit und ökonomischen Anforderungen. Die Suche nach dem technologischen Sweetspot dauerte Monate. Am Anfang stand lediglich die reine Faszination für das Recycling. Es war ein schleichender Prozess mit vielen Etappenentscheidungen.

Die wachsende Last der globalen Fast Fashion

Das Umweltproblem der globalen Textilindustrie ist mittlerweile gewaltig. Die Branche verdoppelt ihren Durchsatz alle 20 bis 30 Jahre. Jährlich werden mittlerweile mehr als 120 Mio. Tonnen Textilien produziert. Nach Angaben der Ellen MacArthur Foundation werden weltweit ungefähr zwei Drittel dieser Mengen praktisch direkt nach der Nutzung entsorgt; sie landen auf riesigen Deponien oder werden ungenutzt verbrannt. In Deutschland steht das klassische Rücknahmesystem laut Experten vor dem Kollaps. Es gibt nach seiner Aussage derzeit eine gestiegene Anzahl an Insolvenzen bei Sammel- und Sortierbetrieben. Die Qualität der Kleidung sinkt durch den Trend zur Fast Fashion massiv. Der Wiederverkauf der gebrauchten Ware lohnt sich oft nicht mehr. Neuware aus Asien ist meistens günstiger als Second Hand-Stücke aus Europa. In Deutschland verursacht die Entsorgung einer Tonne Altkleider zudem Kosten – das Material wird somit zur finanziellen Belastung für die Sammel- und Sortierbetriebe.

Chemische Trennung als industrieller Schlüssel

Das Unternehmen aus Münster setzt genau an diesem Punkt an. Die Technologie ermöglicht die Trennung von Baumwolle und Polyester und macht beide Materialien wieder nutzbar. Das ist entscheidend für den Erfolg der Kreislaufwirtschaft. Die meisten Textilien bestehen heute aus komplexen Mischgeweben. Gerlach erklärt, dass das Unternehmen aus dem Abfall eine hochwertige Cellulose und chemische Bausteine für neues Polyester gewinnt. Die Cellulose dient als sauberes Vorprodukt für die neue Faserherstellung. Das Polyester wird in seine Grundbausteine zerlegt, die für die Herstellung von neuem Polyester verwendet werden können. „Wir stellen aus Baumwolle eine hochwertige Cellulose her und gewinnen aus dem Polyester die chemischen Bausteine zurück“, sagt Gerlach. Beide Materialströme können direkt wieder in der Textilproduktion eingesetzt werden. Damit wird der Kreislauf zwischen Abfall und Kleidung geschlossen. Seit Anfang 2025 hilft zudem eine neue gesetzliche Regelung. Die EU-weite Getrenntsammlungspflicht für Textilabfälle ist in Kraft getreten: Unternehmen dürfen Textilien nun nicht mehr über den Restmüll entsorgen. Das sichert den Zugang zu großen Mengen an Rohstoffen.

Harte Verhandlungen in der Welt des Wagniskapitals

Der Weg von der ersten Idee zur fertig gebauten Industrieanlage ist lang. Deeptech-Unternehmen brauchen oft viel Geduld und Zeit für die Entwicklung. Das erfordert Investoren mit einem sehr langen Atem. In einer frühen Phase kam der High-Tech Gründerfonds an Bord. Auch die NRW.Bank und der TechVision Fonds unterstützen das Vorhaben. Später stiegen Forbion und der Chemiekonzern Henkel als Investor ein. Gerlach erinnert sich im Gespräch an einen intensiven Lernprozess bei den ersten Finanzierungsrunden. Man müsse technische Begeisterung mit harten Umsatzprognosen anreichern. Auch D11Z.Ventures, das Family Office von Dieter Schwarz (Lidl/Kaufland), investierte in das Unternehmen. Die Investoren verstehen laut Gerlach die Entwicklungszyklen und Skalierung von Deeptech-Unternehmen. Mittlerweile flossen über 20 Mio. EUR an Kapital in die Firma. Dieses Geld ermöglicht nun den nächsten großen Schritt.

Ein neues Team für die industrielle Skalierung

Das Start-up ist mittlerweile den Kinderschuhen entwachsen. In Münster entsteht derzeit eine industrielle Demonstrationsanlage. Gerlach erinnert sich an den Moment der Schlüsselübergabe: Zuerst wirkte die leere Halle riesig auf das Team. Inzwischen planen die Ingenieure bereits jeden Zentimeter der Fläche. Das Team ist auf über 25 Köpfe gewachsen. Es ist eine Mischung aus jungen Talenten und erfahrenen Kräften. Viele Mitarbeitende wechselten von großen Konzernen wie BASF nach Münster. Gerlach beobachtet eine große Lust auf die Arbeit an innovativen Prozessen. Die flachen Hierarchien im Unternehmen ziehen Experten an. Er schätzt das Know-how dieser Fachkräfte für den Anlagenbau. Erfahrene Chemiker bringen eine neue Qualität in die Prozesse. Die Zusammenarbeit zwischen Alt und Jung funktioniert hervorragend.

Führung zwischen Agilität und unternehmerischer Verantwortung

Die Unternehmenskultur hat sich mit der Größe weiterentwickelt. Gerlach betont, dass viele Impulse direkt aus der Belegschaft kommen. So wurde die Regelung für die Präsenz im Büro gemeinsam erarbeitet. Die Mitarbeitenden wünschten sich feste Tage für den Austausch. „Die schönsten Tage sind jene mit viel Begegnung“, berichtet Gerlach. Die bürokratischen Pflichten eines Geschäftsführers gehören einfach dazu. Trotzdem bleibt die Mission der Firma der wichtigste Treiber. Die Motivation im gesamten Team sei extrem hoch. Jeder packt an und treibt das Unternehmen voran. Der Spagat zwischen Entwicklung und Business ist fordernd. Gerlach jedoch genießt diese tägliche Herausforderung sehr.

Der Standort Deutschland als Zentrum für Innovation

Viele Fachleute kritisieren die Bedingungen für die Chemieindustrie. Hohe Energiekosten belasten die traditionsreichen Unternehmen stark. Gerlach sieht das differenzierter aus der Perspektive von innovativen Start-ups: „Für die Entwicklung neuer Technologien ist der Standort Deutschland weiter exzellent. Und die Qualifikation der Technologen ist hervorragend. Die aktuelle Krise führt bei uns auch zu Bewerbungen von erfahrenen Talenten aus der chemischen Industrie – die hätte es vor einigen Jahren in der Menge nicht gegeben.“ Die vorhandene Infrastruktur sei ein klarer Vorteil. Auch Konzerne beobachten solche Innovationen genau. Die Nähe zum Mittelstand fördert zudem die Skalierung. Für die beiden Gründer ist die aktuelle Produktionsanlage nur ein Anfang. Langfristig soll die Technologie weltweit lizenziert werden; überall auf der Welt fällt schließlich Textilmüll an. Die Kombination aus Ingenieurskunst und Skalierung ist das Ziel. Auch die aktuellen Investoren von eeden sehen dieses globale Potenzial. Das Unternehmen will beweisen, dass sich Kreislaufwirtschaft lohnt. Deutschland bleibt dafür ein wichtiger Ankerpunkt.

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

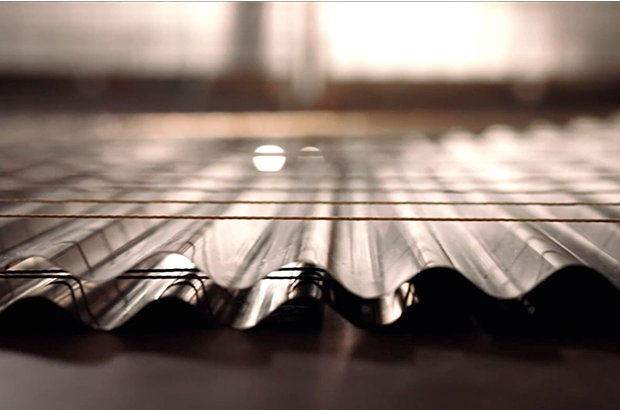

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

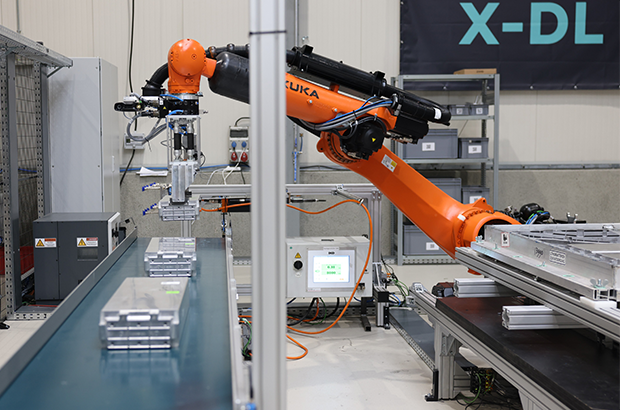

ChatGPT schreibt Texte. R3 Robotics zerlegt Batterien

Es gibt Probleme, die man mit Software lösen kann, und es gibt Probleme, für die man sich die Hände schmutzig machen muss – oder besser: Roboterhände nutzt. Antoine Welter und Dr. Xavier Kohll haben mit Circu Li-ion begonnen, um Batterien zu retten. Jetzt, unter dem neuen Namen R3 Robotics und mit 20 Millionen Euro frischem Kapital im Rücken, treten sie an, um den wohl größten Flaschenhals der kommenden Mobilitätswende zu beseitigen. Ihr Ansatz: Keine teuren Spezialmaschinen, sondern intelligente Standard-Roboter, die sehen, verstehen und sicher zupacken.

Wenn in den Vorstandsetagen der Automobilhersteller über die Zukunft gesprochen wird, geht es meist um Reichweiten und Software-Defined Vehicles. Doch am anderen Ende der Wertschöpfungskette braut sich ein Sturm zusammen. Millionen von Elektrofahrzeugen werden in den kommenden Jahren ihr Lebensende erreichen. Die derzeitige Realität in vielen Recyclinghöfen wirkt dagegen fast archaisch: Menschen, die mit Handwerkzeugen komplexe Systeme auseinanderschrauben. Das ist nicht nur teuer und schwer skalierbar, sondern bei Hochvolt-Systemen auch lebensgefährlich.

Genau hier setzen Antoine Welter und Xavier Kohll an. Die Nachricht, die das deutsch-luxemburgische Unternehmen Anfang Februar 2026 verkündete, ist mehr als nur eine Finanzierungsrunde. Die 20 Millionen Euro – aufgeteilt in 14 Millionen Euro Series-A-Kapital und 6 Millionen Euro öffentliche Fördergelder – heben die Gesamtfinanzierung des Unternehmens auf ein neues Level. Angeführt wird die Runde von HG Ventures und Suma Capital, unterstützt von Co-Investoren wie der Oetker Collection und dem EIC Fund.

Doch das Geld ist nur der Treibstoff für eine strategische Evolution. Aus Circu Li-ion wird R3 Robotics. Der neue Name ist Programm: Repair, Reuse, Recycle. Antoine Welter erklärt die Motivation hinter der Umbenennung pragmatisch: „Circu Li-ion hat beschrieben, wo wir angefangen haben. R3 Robotics beschreibt, was wir aufbauen: industrielle Robotik, die Demontage skalierbar, sicher und kosteneffizient macht.“

Wenn der Roboter Augen bekommt

Die größte Hürde im Recycling ist nicht die Chemie, sondern die Variabilität. Kein Batteriepack gleicht dem anderen, E-Motoren sind unterschiedlich verbaut, Schrauben sind korrodiert. Starre Fertigungsstraßen scheitern hier. R3 Robotics löst dies mit einer Plattform, die Computer Vision, künstliche Intelligenz und Robotik verschmilzt.

Das System fungiert dabei fast wie ein „ChatGPT für die physische Welt“: Anstatt Text zu generieren, plant die KI physische Handlungen. Sensoren scannen das Bauteil, die KI erkennt den Zustand und promptet den Roboterarm dynamisch durch den Demontageprozess. Der entscheidende Vorteil: Der Mensch wird aus der Gefahrenzone der Hochspannung genommen, während der Roboter Aufgaben erledigt, die für klassische Automatisierung zu komplex wären.

Angesprochen auf den Vergleich mit Generative AI und die Frage, wie die Roboter tatsächlich „sehen“ und „entscheiden“, bestätigt Welter die Parallele: „Der Vergleich mit Generative AI passt gut: Das Modell bekommt einen Input – keinen Text, sondern einen Scan des Bauteils – und generiert daraus eine Handlungssequenz.“ Es gehe darum zu erkennen, um welches Modell es sich handelt, wie der Zustand ist und wo die Verbindungspunkte liegen. „Das klingt simpel, ist es aber nicht – kein Pack ist identisch“, so Welter. Die eigentliche Herausforderung liege jedoch in der Entscheidung davor: „Welche Reihenfolge ist sicher? Ein falscher Griff an ein Hochvoltsystem kann tödlich sein. Unser System sieht, bewertet und entscheidet.“

Smart Hardware: Warum das Rad neu erfinden?

Ein Detail, das Investor*innen besonders aufhorchen lässt, ist die Kapitaleffizienz der Gründer. Wer an Industrie-Robotik denkt, denkt an teure Hardware-Entwicklung. R3 Robotics geht einen pragmatischen Weg: Ein Großteil der verwendeten Hardware wird „von der Stange“ gekauft.

Die Roboterarme sind Standardprodukte. Die Innovation – und damit das geistige Eigentum – steckt in den spezialisierten „End-Effektoren“ (den Roboterhänden), den Sensorsystemen und vor allem dem Software-Stack, der alles steuert. Das erlaubt eine Skalierung, die mit proprietärer Hardware kaum möglich wäre. Mitgründer Dr. Xavier Kohll betont, dass dies eine bewusste Entscheidung gegen „Over-Engineering“ war: „Der Roboterarm ist Standard und die Intelligenz sitzt in den Endeffektoren, der Sensorik und dem Software-Stack, der alles zusammenbringt. Das ist unser geistiges Eigentum, und genau das lässt sich skalieren.“

David gegen Goliath – oder Partner?

Während große Recycling-Konzerne oft noch auf den Schredder setzen und die manuelle Demontage an ihre Grenzen stößt, positioniert sich R3 Robotics in einer neuen Nische. Es geht nicht darum, die Chemie-Giganten zu ersetzen, sondern ihnen den Rohstoff so rein wie möglich zu liefern – als strategische Quelle für kritische Materialien. Doch der Markt schläft nicht: Weltweit entstehen Initiativen zur Automatisierung.

Trotz des aktuellen „Gegners“ – dem Menschen mit dem Schraubenzieher – und potenzieller Konkurrenz durch Tech-Start-ups oder Autohersteller, bleibt Welter gelassen. „Wir konkurrieren nicht mit den Chemie-Giganten, wir liefern ihnen den reinsten möglichen Stoffstrom“, stellt er klar. Gegenüber potenziellen Nachahmern sieht er einen entscheidenden Vorteil, den „Unfair Advantage“: die Kombination aus Flexibilität und industrieller Automatisierungstiefe. „Wir sind aktuell die einzige Plattform, die sowohl Variabilität managt als auch für kontinuierlichen Industriebetrieb ausgelegt ist.“

Deutschland als Labor, USA als Skalierungsmarkt

Die Wachstumsstrategie von R3 Robotics ruht auf zwei massiven Säulen: technologischer Tiefe in Europa und kommerzieller Breite in den USA.

Deutschland fungiert dabei als das technologische Rückgrat. Mit der Erweiterung der Anlage in Karlsruhe zur Lighthouse Facility demonstriert das Unternehmen industrielle Leistungsfähigkeit direkt vor der Haustür der großen Autobauer. Hier wird die Technologie gehärtet. Das zeigt sich auch im Leuchtturmprojekt ReDriveS, wo R3 Robotics Seite an Seite mit Giganten wie Schaeffler und VW an der Demontage von E-Achsen arbeitet.

Doch für das massive Volumen blickt das Team über den Atlantik. Der für 2026 geplante Markteintritt in den USA ist Kern der neuen Strategie. Die frischen 20 Millionen Euro sollen gezielt in den Aufbau strategischer Partnerschaften vor Ort fließen, um die Technologie dort auszurollen, wo Pragmatismus auf riesige „End-of-Life“-Volumina trifft. Für Welter ist dieser Doppelschlag essenziell: „Deutschland ist unser Beweisstand. Hier zeigen wir Schaeffler, VW und Co., dass unsere Technologie industriellen Maßstäben in Deutschland standhält.“ Die USA seien hingegen der wichtige Skalierungsmarkt, wo pragmatische Entscheider auf gigantische Volumina treffen. „Beides brauchen wir: die Glaubwürdigkeit aus Europa und das Volumen aus Amerika.“

Industrialisierung statt Romantik

Mit Peter Mohnen, dem ehemaligen CEO des Roboter-Riesen KUKA, holte sich das Start-up zudem einen Beirat, der wie kaum ein anderer weiß, was Industriestandard bedeutet. Er beschreibt den Ansatz von R3 als Beweis für die nötige Automatisierungsexpertise, um Variabilität und Sicherheit gleichzeitig zu managen.

Um diese Expertise weiter auszubauen, wächst das Team rasant. Die Belegschaft soll mit der neuen Finanzierung massiv aufgestockt werden, vor allem im Bereich Engineering und KI. R3 Robotics hat den Beweis erbracht, dass Kreislaufwirtschaft kein ökologisches Nischenprojekt sein muss, sondern ein harter industrieller Prozess ist, der sich rechnet.

Denn letztlich, so das Fazit von Antoine Welter, sei Automatisierung der einzige Weg, das Problem wirklich zu lösen – nicht allein aus ökologischen Gründen, sondern weil es wirtschaftlich Sinn ergibt. „Was wir aufbauen, ist am Ende ein harter industrieller Prozess: Er muss zuverlässig funktionieren und sich rechnen.“ Es gehe aber um mehr als ein Geschäftsmodell: „Europa braucht eine Antwort auf die Frage, woher seine kritischen Materialien in Zukunft kommen“, mahnt Welter abschließend. „Wenn Europa diesen Zugang sichern will, braucht es Unternehmen, die genau das industriell umsetzen können. Dafür bauen wir diese Infrastruktur, und mit dem neuen Kapital und Team haben wir jetzt die Mittel dazu.“

Rouge: Vom Tabu zum Geschäftsmodell

Die Menstruation ist ein Milliardenmarkt – und dennoch oft unsichtbar. Das von Tina Frey und Patrick Gsell gegründete Start-up Rouge bricht mit diesem Muster. Was Ende 2022 als Vision in der Schweiz begann, hat sich durch geschickte Positionierung und Expansion nach Deutschland zu einem ernstzunehmenden Player im FemTech-Bereich entwickelt.

Die Grundidee von Rouge ist so simpel wie strategisch klug: Statt die Menstruation zu verstecken, wird sie zum sichtbaren Lifestyle-Element. „Mich hat fasziniert, wie sehr die Menstruation unseren Alltag beeinflusst und wie konsequent wir trotzdem darüber schweigen“, erklärt Mitgründerin Tina Frey. „Bald wurde mir klar: Das ist ein gesellschaftliches Problem.“ Dass dieser Ansatz einen Nerv trifft, zeigt der rasche Aufstieg des Unternehmens. Durch gezielte Medienarbeit gelang es dem Team, das Thema aus der Nische in den Mainstream zu heben – Tina Frey positioniert sich dabei konsequent nicht nur als Unternehmerin, sondern als Expertin für Frauengesundheit.

Differenzierung im "Red Ocean"

Im Zentrum der Marke steht der Rouge-Drink, ein Pulver-Supplement mit Eisen, Vitamin B12 und Granatapfel. Doch der eigentliche USP liegt nicht in den Inhaltsstoffen, sondern in der Inszenierung. Die transparente Flasche mit der roten Flüssigkeit fungiert als bewusstes „Statement-Piece“.

Hier gelingt dem Start-up ein entscheidender Schachzug im wachsenden Markt für Zyklusgesundheit: Während Wettbewerber wie FEMNA oder MYLILY auf funktionale Nahrungsergänzung in diskreter Kapselform setzen, inszeniert Rouge die Einnahme als genussvollen Wellness-Moment. Gleichzeitig emanzipiert sich das Duo von den „lauten“ Tabubrechern der Branche wie The Female Company: Rouge setzt weniger auf Provokation durch Hygieneartikel, sondern transformiert die Linderung von Regelbeschwerden von einer medizinischen Notwendigkeit in eine „ästhetische Selbstverständlichkeit“.

„Sichtbarkeit verändert Verhalten“, so Tina Frey. „Die Flasche macht den Zyklus im Alltag sichtbar und löst Gespräche aus. Noch wichtiger: Viele Frauen erleben dadurch eine neue Selbstverständlichkeit und mehr Selbstbewusstsein.“ Dieser Social-Impact-Gedanke ist fest im Geschäftsmodell verankert: Ein Teil der Erlöse fließt in Aufklärungsprojekte. „Sozialer Impact ist kein Marketing-Trick, sondern eine Notwendigkeit“, ergänzt Co-Founder Patrick Gsell. „Gleichzeitig braucht es wirtschaftliche Stabilität, um langfristig bestehen zu können.“

Diverse Kompetenzen als Wachstumstreiber

Hinter der Marke steht ein komplementäres Gründungs-Duo. Tina Frey bringt als Marketing-Expertin das kommunikative Rüstzeug mit, während Patrick Gsell – seit über 20 Jahren Geschäftsführer eines Softwareunternehmens – die strategische Struktur und Skalierungserfahrung liefert. Patrick Gsell, der 2022 den Bund-Essay-Preis gewann, liefert zudem den intellektuellen Unterbau. „Die Hälfte der Menschheit erlebt die Menstruation. Trotzdem betrifft sie die ganze Gesellschaft und nicht zuletzt das Verständnis zwischen Mann und Frau. Genau deshalb finde ich es so spannend, mit Rouge am Anfang eines gesellschaftlichen Wandels zu stehen“, so Patrick Gsell.

Expansion mit lokaler Strategie

Nach der Etablierung auf dem Schweizer Heimatmarkt erreichte Rouge im Herbst 2025 den nächsten Meilenstein: den Markteintritt in Deutschland. Anders als bei reinen Export-Modellen setzt das Start-up hierbei auf lokale Strukturen und Partner vor Ort. „Der deutsche Markt bietet großes Potenzial, aber jede Gesellschaft tickt anders“, begründet Tina Frey den Schritt. Das Ziel bleibt grenzüberschreitend gleich: Die Menstruation soll kein Nischenthema bleiben, sondern als normaler Teil der weiblichen Gesundheit akzeptiert werden – sichtbar gemacht durch eine rote Flasche, die den Dialog eröffnet.

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

Europa kann KI!

Was wir von den besten EU-AI-Companies lernen können, erläutert KI-Experte Fabian Westerheide.

Europa muss sich bei KI nicht kleinreden. Wir sehen gerade sehr deutlich: Aus Europa heraus entstehen Unternehmen, die Kategorien besetzen – und dann auch das große Kapital anziehen. Beispiele gibt es genug: Mistral AI, DeepL, Black Forest Labs, Parloa, Helsing, Lovable oder n8n.

Ich schreibe das aus drei Blickwinkeln: als Investor (AI.FUND), als Konferenz-Initiator (Rise of AI Conference) und als Autor von „Die KI-Nation“. Was du hier bekommst, ist kein „Europa-hat-ein-Problem“-Essay – sondern eine Analyse plus ein Execution-Set an Empfehlungen, das du direkt auf dein Start-up übertragen kannst.

Die Realität: Seed geht oft – Scale ist das Spiel

Am Anfang brauchst du selten „zu viel“ Geld. MVP, erste Kunden, Iteration: Das klappt in Deutschland in vielen Fällen mit Seed. Die echte Trennlinie kommt später – wenn du aus einem starken Start-up einen Kategorie-Gewinner bauen willst.

Denn KI ist zunehmend Winner-takes-most. Und das gilt auch fürs Kapital: In vielen Fällen ist die Growth-Finanzierung in den USA grob 25-mal größer – bei den aktuellen Front-Runnern (Modelle, Infrastruktur, Distribution) wirkt es teilweise wie 100-mal, weil Kapital sich auf die vermuteten Sieger stapelt. (Nicht „fair“, aber Marktmechanik.)

Die gute Nachricht: Genau die EU-Vorbilder oben zeigen, dass du das nicht wegdiskutieren musst – du musst es exekutieren.

Was die EU-Winner gemeinsam haben: 6 Execution-Prinzipien

1. Starkes Gründerteam – aber vor allem: vollständig

Alle genannten Vorbilder hatten (oder bauten sehr schnell) ein Team, das drei Dinge gleichzeitig kann:

- Tech & Produkt (nicht nur „Model-IQ“, sondern Produktgeschmack)

- Go-to-Market (Vertrieb, Buyer-Verständnis, Pricing)

- Tempo (entscheiden, shippen, lernen)

Wenn eine Säule fehlt, zahlst du später mit Zeit. Und Zeit ist in KI eine Währung, die dir niemand schenkt.

Founder-Move: Benenne eine Person, die Umsatz genauso hart verantwortet wie Modellqualität. Wenn das „später“ ist, ist das sehr wahrscheinlich dein Bottleneck.

2. Global denken – aber spitz: KI-Nische statt Bauchladen

Die EU-Winner sind nicht „KI für alles“. Sie besetzen klare Nischen:

Language-AI (DeepL), Customer-Experience-Agents (Parloa), GenAI-Modelle (Black Forest Labs), Defence-Tech (Helsing), Builder/Vibe-Coding (Lovable), Orchestration & Automation (n8n), Foundation-Model-Ambition (Mistral).

Founder-Move: Formuliere deinen Claim so, dass er in einem Satz sagt, welche Kategorie du dominierst. Wenn du drei Absätze brauchst, bist du noch zu breit.

3. Umsatz ist keine Nebenwirkung – Umsatz ist Souveränität

Der schnellste Weg zu Growth-Capital ist nicht „noch ein Pilot“, sondern Revenue, der deine Kategorie glaubwürdig macht.

Parloa kommuniziert z.B. ARR > 50 Mio. USD und wächst international – genau die Art Signal, die große Runden freischaltet.

Founder-Move (gegen Pilotitis): Kein PoC ohne schriftlichen Pfad in einen Vertrag (Budget, KPI, Entscheidungstermin). Sonst finanzierst du mit deiner Runway den Lernprozess des Kunden.

4. Internationales Kapital früh anbahnen – bevor du es brauchst

Das Muster ist klar: Erst Kategorie-Story + Traktion, dann große Checks.

Mistral (Series C 1,7 Mrd. €) oder Lovable (330 Mio. USD bei 6,6 Mrd. Bewertung) sind kein „Glück“ – das ist Momentum + Positionierung + Timing.

Founder-Move (90-Tage-Plan):

- Baue eine Capital Map deiner Nische (wer zahlt Growth-Checks?)

- Definiere die drei Metriken, die diese Investor:innen sehen wollen

- Organisiere zehn Intros jetzt, nicht erst bei sechs Monaten Runway

5. Compute ist keine IT-Zeile – es ist ein Wachstumshebel

In KI ist Compute Teil deiner Wettbewerbsfähigkeit. Geschwindigkeit beim Trainieren, Testen und Deployen entscheidet, wie schnell du am Markt lernst.

Founder-Move: Plane Compute-Runway wie Cash-Runway. Verhandle früh Kontingente, bevor dein Verbrauch explodiert – sonst wird Wachstum plötzlich zur Margen-Frage.

6. Trust & Compliance als Verkaufsargument – nicht als Ausrede

Gerade in DACH gilt: Wer secure, audit-fähig, enterprise-ready wirklich liefern kann, gewinnt Deals.

DeepL betont genau diesen Business-Wert: verlässliche, sichere Lösungen statt Hype.

Founder-Move: Baue Trust-Artefakte früh – Dokumentation, Governance, Datenflüsse, Rollen, Audit-Spuren. Das beschleunigt Enterprise-Vertrieb, statt ihn zu bremsen.

Kurz-Checkliste: Wenn du in Europa KI gewinnen willst

- Kategorie in einem Satz (spitze Nische, globaler Anspruch)

- Klarer Revenue-Pfad (weniger Piloten, mehr Verträge)

- Capital Map (international früh andocken)

- Compute-Runway (wie Cash planen)

- Trust by Design (verkaufsfähig machen)

- Tempo als Kultur (shippen, messen, nachschärfen)

Europa kann KI. Die Frage ist nicht, ob hier Talent existiert – das ist bewiesen.

Die Frage ist, ob du Execution so aufsetzt, dass aus Talent Marktführerschaft wird.

Der Autor Fabian Westerheide gestaltet als KI-Vordenker, Investor, Ökosystem-Pionier und Keynote Speaker seit über einem Jahrzehnt die Debatte um KI, Macht und digitale Zukunft mit.

Wie viel verdienen Twitch Streamer wirklich? Zahlen und Verdienstmöglichkeiten im Blick

Wer als passionierter Spieler noch nicht an eine Gaming Karriere gedacht hat, sollte dies jetzt nachholen: Schließlich ergeben sich aus dieser von Esport-Turnieren bis hin zum Streaming einige Verdienstmöglichkeiten. Creatoren verdienen mit der Echtzeit-Übertragung ihres Spielerlebnisses Geld. Was sich einfach anhört, kann für so manchen Spieler auch zum komplexen Unterfangen werden. Wie hoch der Streamer Verdienst in diesen Fällen ausfällt und welche Einnahmemöglichkeiten es für Twitch Streamer noch gibt, erfahren Sie hier.

Die Top 10 Twitch Streamer im Jahr 2025

„Es gewinnt nicht der beste Spieler, sondern der beste Entertainer.“ |

Auf Plattformen wie Twitch gilt: Die Community beeinflusst stark, wie viel Geld Streamer verdienen können. Wer eine starke Zuschauergemeinde aufbauen kann, freut sich in der Regel über ein höheres Einkommen – dabei spielt vor allem die Interaktion der Viewer eine zentrale Rolle.

Aktuell weisen diese top 10 Twitch Channels die höchsten Zuschauerzahlen vor:

Streamer | Durchschnittliche Zuschauerzahl | Follower |

126.449 | 19,8 Millionen | |

52.024 | 7,9 Millionen | |

46.844 | 3,3 Millionen | |

36.903 | 2,2 Millionen | |

29.320 | 2,2 Millionen | |

71.045 | 1,5 Millionen | |

31.839 | 1,5 Millionen | |

42.837 | 1,4 Millionen | |

34.996 | 1,1 Millionen | |

30.438 | 993.817 |

Geld verdienen mit Streaming: Diese Faktoren wirken sich auf Twitch Einnahmen aus

Die Twitch-Einnahmen der verschiedenen Streamer setzen sich aus unterschiedlichen Verdienstquellen zusammen. So können die Kontoinhaber Werbung in ihren Live-Übertragungen schalten, die ihnen je nach Zuschauerzahl und Länge der Werbepause einen kleinen bis mittleren Betrag einbringen. Hierbei handelt es sich jedoch um ein eher statisches Nebeneinkommen, das die meisten Streamer auch als nebensächlich empfinden. Den größeren Teil des Twitch Einkommens machen Abonnements und Spenden der Zuschauer aus, aber auch Sponsoring und Markenpartnerschaften.

Übrigens: Twitch Auszahlungen erfolgen automatisch via PayPal oder Banküberweisung, sofern ein gewisser Mindestbetrag erreicht wurde. In diesem Zusammenhang bieten mobile casinos, ähnlich wie Streaming-Plattformen, eine bequeme Möglichkeit für Spieler, jederzeit und überall zu spielen, ohne auf traditionelle Zahlungsmethoden angewiesen zu sein. Diese Art von Plattformen hat sich zu einer beliebten Option entwickelt, da sie den Nutzern schnelle Auszahlungen und einfache Handhabung bieten.

Twitch Daten Leak 2021: Das verdienen Top-Streamer

Ende 2021 wurde die bekannte Plattform Twitch gehackt. Bei einem Datenleck kam heraus, dass die 2014 von Amazon gekaufte Plattform kaum Sicherheitsvorkehrungen geschaffen hatte – weshalb große Teile des Programmiercodes sowie Login-Daten und Zahlen zum Streamer Verdienst veröffentlicht werden konnten. Zu sehen waren vor allem die Gesamteinnahmen der Top Spieler aus den Twitch Statistiken des Zeitraumes August 2018 bis Oktober 2021 in US-Dollar:

- CriticalRole: 9,6 Millionen

- xQc: 8,5 Millionen

- summit1g: 5,8 Millionen

- Tfue: 5,3 Millionen

- Nickmercs: 5,1 Millionen

Zum Vergleich: Der deutsche Twitch Streamer Marcel Eris (alias MontanaBlack88) hat über Twitch 2,4 Millionen US-Dollar eingenommen. Der Streamer MontanaBlack88 gehört zu den bestbezahlten deutschen Spielern auf Twitch.

Damit werden die großen Unterschiede zwischen den Verdiensten der Streamer aus Deutschland und den USA deutlich. Rund vier Millionen Deutsche verfolgen Twitch-Übertragungen – und das sogar täglich. In den USA liegt die tägliche Zuschauerzahl bei stolzen 35 Millionen Nutzern, sodass amerikanische Streamer auch einen deutlich größeren Markt bedienen und die Einkommensunterschiede nicht verwunderlich sind. MontanaBlack88 ist allerdings auch auf anderen Plattformen wie YouTube zu finden, sodass sein Gesamtverdienst womöglich deutlich höher liegt.

Gut zu wissen: Twitch Partner (von Twitch ausgewählte Streamer mit qualitativem Content) können sich über höhere Einnahmen freuen – etwa einen höheren Anteil aus dem Abonnenten-Verdienst.

Im Detail: So setzt sich der Verdienst zusammen

Wie eingangs erwähnt, verdienen Twitch Streamer vor allem durch Abonnenten einen großen Teil ihres Einkommens. Das Abonnement kostet Subscribern in der ersten Stufe 4,99 Euro – wovon Streamer in der Regel 50% (2,50 Euro) behalten dürfen. Dafür erhalten Abonnenten bestimmte Vorteile wie etwa die Möglichkeit, per Chat mit dem Streamer interagieren zu können. Wer also 1.000 Abonnenten hat, kann deshalb schon mit Einnahmen von 2.500 Euro monatlich rechnen.

Einen Großteil ihrer Einnahmen generieren Gaming-Streamer aber auch mit Hilfe von Subscriber-Spenden. Diese werden in Twitch Bits genannt und von der Plattform ausgezahlt. Die Spenden rufen bei einigen Streamern emotionale Reaktionen hervor, was wiederum mehr Menschen zum Spenden anregt.

Eine weitere Möglichkeit stellt Affiliate-Marketing dar: Streamer bewerben in dem Fall für ihre Zuschauer interessante Produkte in ihren Videos. Kaufen Zuschauer die Produkte, profitieren Streamer von einer Provision – die nicht selten 30% des Kaufbetrages ausmacht.

Sponsoren und Markendeals als größte Einnahmequelle für Streamer

An Streamer mit besonders hohen Zuschauer- und Followerzahlen treten oft auch bekannte Marken heran. Sie bezahlen die Gamer dafür, ihre Produkte im Live-Stream anzupreisen – beispielsweise Gaming-Peripherie oder Energy-Drinks. Soll dies über einen längeren Zeitraum geschehen, werden solche Marken oft auch zum Sponsor des Spielers, um ihre eigene Reichweite zu erhöhen.

Kosten und Abzüge: Dem steht der Streamer Gehalt in Deutschland gegenüber

Die genannten Streamer Gehälter stellen Brutto-Summen dar – also den Verdienst vor Abzug der deutschen Einkommens-, Umsatz- und Gewerbesteuer, sowie Sozialversicherungen. Wer all diese Beträge zusammenzählt, muss oft bis zu 45% seines Brutto-Einkommens an den Fiskus abführen. Doch damit nicht genug: Die meisten Twitch-Streamer müssen auch Chat-Moderatoren bezahlen, die für eine angenehme Atmosphäre unter den Kommentierenden sorgen und Community-Richtlinien durchsetzen.

Darüber hinaus wollen sich Zuschauer nur Streams ansehen, die eine hohe Qualität aufweisen. Um leistungsstark spielen und den Verlauf optimal übertragen zu können, brauchen Streamer bestimmtes Gaming-Equipment, das selbst zwischen 2.000 und 10.000 Euro kosten kann. Auch eine stabile Internetverbindung und die damit verbundenen Kosten sind zu bedenken.

Alternative Plattformen zur Diversifizierung

Um noch mehr Einkommen zu generieren, können passionierte Spieler ihre Streams allerdings zusätzlich auf anderen Plattformen veröffentlichen und monetarisieren – beispielsweise durch Werbung und Affiliate-Marketing. Zur Diversifizierung kommen Plattformen wie YouTube und Kick in Frage, die teilweise sogar bessere Konditionen bieten. Denn: Bei Kick werden Streamer zu 95% an den Einnahmen durch Abonnements beteiligt, was im Gegensatz zu Twitch deutlich attraktiver erscheint.

to teach: Vom KI-Hype zur Schulinfrastruktur

Wie das 2022 gegründete EdTech to teach die Lücke zwischen Chatbot und Klassenzimmer schließt.

Vor drei Jahren begann mit dem öffentlichen Zugang zu generativer künstlicher Intelligenz ein weltweiter Hype, der auch vor den Schultoren nicht haltmachte. Doch im Bildungsmarkt entscheidet sich derzeit, ob die Technologie tatsächlich Produktivität schafft oder in einer digitalen Sackgasse endet. Das Hamburger EdTech to teach liefert hierzu eine Blaupause: Was 2022 als Experiment begann, hat sich innerhalb von drei Jahren zu einer Arbeitsplattform für hunderttausende Lehrkräfte entwickelt.

Das Problem: US-Tools verstehen deutsche Schulen nicht

Als generative KI erstmals verfügbar wurde, wirkte ihr Einsatz im Bildungsbereich naheliegend. Doch der Blick auf die internationale Konkurrenz zeigt das Dilemma: Während US-Platzhirsche wie MagicSchool AI oder Diffit den Markt mit hunderten Mikro-Tools fluten und technisch beeindrucken, fehlt ihnen der kulturelle Fit. „Einfach nur Texte aus ChatGPT zu kopieren, löst kein einziges Problem von Lehrkräften“, erklärt Felix Weiß, Co-Founder und CEO von to teach.

Die Diskrepanz zwischen dem Versprechen der KI und dem tatsächlichen Schulalltag war groß. US-Lösungen scheitern oft an spezifischen deutschen Lehrplänen oder liefern reine Multiple-Choice-Formate, die hierzulande kaum Anwendung finden. Lehrkräfte benötigten keine unstrukturierten Textwüsten, sondern didaktisch saubere, lehrplankonforme und sofort einsetzbare Materialien. Genau hier setzte das 2022 von Felix Weiß und Marius Lindenmeier gegründete Unternehmen an.

Der Pivot: Datenschutz als Burggraben

Der entscheidende Wendepunkt kam 2023. Das Start-up vollzog einen Strategiewechsel (Pivot) weg von einer SaaS-Lösung für Verlage hin zu einer direkten Plattform für Lehrkräfte. Anstatt Nutzer*innen mit freien Eingabefeldern (Prompts) allein zu lassen, entwickelte das Team feste Arbeitsblattvorlagen. Dies wurde zum entscheidenden Wettbewerbsvorteil gegenüber internationalen Anbietern: Während diese oft an der strikten DSGVO scheitern, bietet to teach durch Serverstandorte in der EU und Rechtssicherheit eine Lösung, die Schulträger akzeptieren.

Dabei mussten technische Kinderkrankheiten überwunden werden: Frühe KI-Modelle „halluzinierten“ Fakten. To teach reagierte mit der systematischen Integration von Quellen und profitierte zugleich von der rasanten Evolution der Sprachmodelle.

Skalierung im Ökosystem gegen nationale Konkurrenz

Der Markt nahm die Lösung schnell an: Im Januar 2023 meldete sich der erste Nutzer an, bis Ende des Jahres waren es laut Unternehmen bereits knapp 16.000 Lehrkräfte. Das Jahr 2024 markierte dann den Übergang vom Start-up zur Plattform: Durch die Übernahme von fobizz (101skills GmbH) wurde to teach Teil eines größeren Bildungsökosystems. Die Gründer blieben als Geschäftsführer an Bord.

Dieser Schritt war strategisch überlebenswichtig in einem sich konsolidierenden Markt. Einerseits gegenüber agilen Herausforderern, da Konkurrenten wie schulKI, Teachino, KIULY oder Kuraplan zum Teil aggressiv um Landeslizenzen kämpfen bzw. auf dem Markt für KI-gestützte Unterrichtsplanung und Materialerstellung durchgestartet sind.

Andererseits war der Schritte in Hinblick auf etablierte Verlage notwendig. Denn Häuser wie Cornelsen ziehen inzwischen mit eigenen KI-Assistenten nach, sperren ihre Inhalte jedoch oft in geschlossene Systeme, d.h. binden sie oft an die eigenen Verlagswerke.

Durch die erfolgreiche Integration in fobizz ist to teach kein isoliertes Insel-Tool mehr, sondern profitiert von bestehenden Landesrahmenverträgen und einem riesigen Vertriebsnetz. Die Nutzer*innenzahlen explodierten förmlich auf über 140.000 Lehrkräfte bis Ende 2024, so die Angaben von to teach.

Status Quo 2025: KI als neue Infrastruktur

Heute, im dritten Jahr nach der Gründung, hat sich der Fokus erneut verschoben. To teach versteht sich inzwischen als Arbeitsinfrastruktur. Die Zahlen unterstreichen diesen Anspruch: Nach Angaben von to teach nutzen über 300.000 Lehrkräfte die Plattform, und mehr als 4.000 Schulen sind angebunden. Das bedeutet: Millionen von Inhalten wurden so bereits KI-gestützt vorbereitet.

Das Unternehmen treibt nun den systematischen Schulvertrieb voran. Damit beweisen EdTechs wie to teach, dass sich Qualität und Personalisierung im sonst oft als innovationsresistent geltenden Bildungsmarkt skalieren lassen.

Für CEO Felix Weiß ist die Diskussion über das „Ob“ längst beendet: „Die Frage ist nicht mehr, ob KI im Klassenzimmer ankommt, sondern, wie und auf welche Weise sie dort wirklich hilft.“

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.

Wenn Dr. Martin Baumgärtl erklären will, wie er die chemische Industrie revolutionieren möchte, wählt er ein Bild, das jeder versteht: „Im Grunde ist es wie ein Wasserkocher in der heimischen Küche – nur im industriellen Maßstab.“ Baumgärtl ist CTO von SYPOX, und was er beschreibt, könnte einer der wichtigsten Hebel für die Dekarbonisierung einer der schmutzigsten Branchen der Welt sein.

Die chemische Industrie ist süchtig nach Energie. Um Basischemikalien wie Methanol oder Ammoniak herzustellen, wird sogenanntes Synthesegas benötigt – eine Mischung aus Wasserstoff und Kohlenmonoxid. Die Herstellung geschieht in gewaltigen Hochtemperaturprozessen. Bisher wird die dafür nötige Hitze fast ausschließlich durch das Verbrennen von Erdgas oder Öl erzeugt. Die Folge: Gigantische CO₂-Emissionen.

Strom statt Flamme

Genau hier setzt SYPOX an. Das 2021 in Freising gegründete Unternehmen ersetzt die offenen Gasflammen durch elektrischen Strom. In ihren Reaktoren, die von außen wie gewöhnliche Druckbehälter aussehen, stecken hochkomplexe elektrische Heizelemente, die direkt hinter den Katalysatoren platziert sind.

Der Effekt ist enorm: „In konventionellen Verfahren entfallen rund 40 Prozent der Emissionen allein auf die Wärmeerzeugung aus fossilen Energieträgern“, rechnet Baumgärtl vor. Durch die Elektrifizierung des Reaktors fallen diese Emissionen weg – vorausgesetzt, der Strom kommt aus erneuerbaren Quellen. Zudem lässt sich der Prozess laut den Gründern präziser und sicherer steuern.

Der Anti-Trend im Silicon Valley

Doch nicht nur technologisch, auch ökonomisch schwimmt SYPOX gegen den Strom. In der Tech-Szene ist es üblich, dass Start-ups jahrelang Verluste schreiben und sich von einer Venture-Capital-Runde zur nächsten hangeln, getrieben von Investoren, die schnelles Wachstum fordern.

Die bayerischen Gründer wählten einen konservativeren, fast schon mittelständischen Ansatz. „Es entsprach nicht unserem Stil, Geld einzuwerben – wir haben vielmehr von Anfang an versucht, auf Basis unserer Technologie ein tragfähiges Geschäft aufzubauen“, erklärt CEO Dr. Gianluca Pauletto. Man wolle bodenständig bleiben und sich aus Umsätzen finanzieren, statt sich in Abhängigkeiten zu begeben.

Vom Container im Altmühltal zum Großkunden

Die Wurzeln des Unternehmens liegen an der Technischen Universität München (TUM). Die Idee brachte Pauletto aus seiner Zeit in Montréal mit, an der TUM fand er in Prof. Johannes Lercher und dem damaligen Doktoranden Martin Baumgärtl die wissenschaftlichen Mitstreiter.

Der Weg zum marktreifen Produkt war – typisch für „Deep Tech“ – langwierig. „Vier Jahre Forschung und zahlreiche Versuchsreihen waren notwendig“, erinnert sich Lercher. Während andere Software im Co-Working-Space programmierten, baute das SYPOX-Team eine Pilotanlage in einem einfachen Stahlcontainer auf dem Gelände einer Biogasanlage im ländlichen Dollnstein (Altmühltal).

Diese Beharrlichkeit zahlt sich nun aus. Das Start-up hat, unterstützt durch den Spezialchemie-Konzern Clariant, seinen ersten Großkunden an Land gezogen. Ab 2026 soll eine erste industrielle Anlage in Betrieb gehen, die täglich 150 Tonnen Synthesegas produziert. „Das ist nicht nur ein Meilenstein für uns, sondern auch ein starkes Signal an die gesamte chemische Industrie“, so Baumgärtl.

Für das Team, das inzwischen in Langenbach bei Freising sitzt und weiterhin Labore auf dem Forschungscampus Garching betreibt, ist das der Beweis: Die Elektrifizierung der Chemie ist keine Zukunftsmusik mehr, sie beginnt jetzt.