Aktuelle Events

Wie KI-Technologie den modernen Arbeitsalltag revolutioniert

Die dritte Phase der Digitalisierung hat begonnen. Wir zeigen Anwendungsgebiete und Potenziale moderner KI-Technologien im Überblick.

Der moderne Büroalltag, aber auch die Unternehmensführung, die Logistik, Marketing- und Planungsprozesse aller Art sind in den vergangenen Jahrzehnten immer digitaler und rationaler geworden. Derzeit befinden wir uns mitten in einem weiteren Umbruchsprozess, der in seiner Wirkung nur mit der Einführung des PCs und der umfassenden Vernetzung durch Internet und Unternehmensnetzwerke vergleichbar sein dürfte.

Wie in Transformationsphasen üblich bringen diese entscheidende Risiken und Potenziale für etablierte Größen wie auch für Start-ups mit sich. Wer jetzt zurückbleibt, verschafft der Konkurrenz unter Umständen einen Vorsprung, der nur schwer einholbar sein kann. Umgekehrt bieten sich für frühe Anwender zahlreiche Chancen, die eigenen Prozesse zu rationalisieren, neue Dienstleistungen auf den Markt zu bringen und sich auf absehbare Zeit eine stabile Marktposition zu erobern.

Um das volle Potenzial der digitalen Revolution und insbesondere der sich rasant entwickelnden KI-Technologie ausloten zu können, sollte man sich zunächst bewusst machen, welche Bedeutung technische Revolutionen auf den Arbeits- und Unternehmensalltag haben, sich einen möglichst breiten Überblick über die verschiedenen Anwendungsmöglichkeiten der neuen Technologie verschaffen und sich abschließend fragen, wie das eigene Unternehmen oder ein vielversprechendes Businessmodell davon profitieren könnten.

Die drei Phasen der digitalen Revolution

Einfach nur von der digitalen Revolution zu sprechen, wird dem Phänomen längst nicht mehr gerecht. Eine Einteilung in drei historische Phasen zeigt einerseits, wie lange wir bereits von der computergetriebenen Entwicklung beeinflusst werden und andererseits, wie sich die Digitalisierung zunehmend in alle ökonomischen und sozialen Bereiche ausdehnt.

1. Die Ära des Personal Computers: Die Anfänge der digitalen Revolution

Die erste Phase der digitalen Revolution begann mit der Einführung des Personal Computers in den Büroalltag. Dieser technologische Durchbruch in den 1970er und 80er Jahren markierte einen Paradigmenwechsel in der Arbeitswelt. PCs ermöglichten eine effizientere Datenverarbeitung, Textverarbeitung und Tabellenkalkulation, wodurch zeitaufwendige manuelle Prozesse ersetzt wurden. Diese Entwicklung ebnete den Weg für eine produktivere und zugänglichere Arbeitsumgebung, in der Aufgaben schneller und präziser ausgeführt werden konnten.

2. Das Internetzeitalter: Vernetzung und globale Expansion

Die zweite Phase, ausgelöst durch die weite Verbreitung des Internets in den 1990er Jahren, revolutionierte die Kommunikation und Zusammenarbeit im Büro. Die Möglichkeit, in Echtzeit Informationen auszutauschen und auf eine Fülle von Online-Ressourcen zuzugreifen, eröffnete Unternehmen neue Dimensionen der globalen Vernetzung. E-Mail wurde zum Standardkommunikationsmittel, während das World Wide Web eine Plattform für unendliche Informations- und Geschäftsmöglichkeiten wurde. Diese Ära definierte die Art und Weise, wie Unternehmen operieren und interagieren, vollständig neu und leitete das Zeitalter der digitalen Wirtschaft ein.

3. KI-Technologie: Ein neues Kapitel in Produktion, Unternehmensführung, Vermarktung und Verwaltung

In der dritten und aktuellen Phase der digitalen Revolution tritt KI in den Vordergrund, indem sie die Grenzen praktisch aller unternehmerischen Prozesse und den Büroalltag von Millionen Menschen neu definiert. KI-gesteuerte Anwendungen, von automatisierten Kundendienstlösungen bis hin zu fortschrittlicher Datenanalytik, transformieren die Arbeitsweise in Unternehmen grundlegend. Sie ermöglichen nicht nur eine bisher unerreichte Automatisierung und Effizienzsteigerung, sondern auch eine personalisierte und vorausschauende Geschäftsstrategie in allen Bereichen von der Vermarktung bis zu den Lieferketten. Die Integration von KI in den modernen Unternehmensalltag stellt somit nicht nur eine Fortsetzung der Digitalisierung dar, sondern eröffnet neue Wege in Richtung intelligenter, datengesteuerter Arbeitsumgebungen in allen Unternehmensbereichen.

Potenziale und Anwendungsgebiete moderne KI-Techniken

Während die automatisierte Datenanalyse riesiger Datenmengen (Big Data) praktisch alle datengetriebenen Prozesse der Unternehmensführung, -organisation und Verwaltung betrifft, beginnt die jüngste Entwicklung sprachbegabter KI-Technologien gerade erst ihr Potenzial und ihre verschiedenen Anwendungsmöglichkeiten zu zeigen.

Verarbeitung natürlicher Sprache (NLP): KI, die uns versteht

Die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) ist ein beeindruckender technischer Durchbruch sowie ein faszinierendes und schnell wachsendes Feld der Künstlichen Intelligenz. Erstmals wird die Interaktion zwischen Computern und Menschen in natürlicher Sprache ermöglicht. Dies verschafft einer breiten Zahl von Nutzern Zugang zu Instrumenten, die zuvor nur Programmierern oder anderen Experten zur Verfügung standen. In Verbindung mit weiteren Fähigkeiten der KI lässt sich derzeit kaum eine Grenze für das Transformationspotenzial dieser Technologien erahnen. Im Kontext des modernen Büroalltags machen NLP-Anwendung beinahe täglich bedeutende Fortschritte und bieten immer vielfältigere Anwendungsmöglichkeiten, die die Arbeitsweise grundlegend verändern:

- Spracherkennung und -verarbeitung: NLP ermöglicht es Computern, gesprochene Sprache zu verstehen und zu verarbeiten. Dies erweitert die Interaktionsmöglichkeiten zwischen normalen Nutzern und KI-Anwendungen grundlegend. Eine der aktuellsten Innovationen auf diesem Gebiet ist beispielsweise Blizo, eine Software zur Transkription und übersichtlichen Zusammenfassung von Meetings. Anwendungen wie diese erlauben Mitarbeitern zudem Berichte durch Sprechen, anstatt durch Tippen zu erstellen, was Zeit spart und die Zugänglichkeit erhöht. NLP revolutioniert allgemein und umfassend die Sprachsteuerung von Geräten und Software, wobei die Entwicklung hier noch ganz am Anfang ist und die Möglichkeiten weiterer Anwendungen gerade erst am Horizont erscheinen.

- Chatbots und Virtuelle Assistenten: Im Kundenservice werden bereits seit längerer Zeit NLP-basierte Chatbots eingesetzt, um Kundenanfragen effizient zu beantworten oder vorzusortieren. Diese Systeme können natürliche Konversationen simulieren und so die Kundeninteraktion verbessern. Ebenso unterstützen virtuelle Assistenten Mitarbeiter, indem sie einfache Aufgaben wie die Terminplanung oder Informationsabfragen übernehmen. Alexa, Siri und Co. werden in Kürze wie fossile Urgesteine neben der neuesten Generation sprechender Bots aussehen und vermutlich bald selbst ein umfassendes Update bekommen.

- Sentimentanalyse: NLP-Tools können Stimmungen und Meinungen in Texten erkennen und analysieren. Dies ist besonders nützlich für Marketing- und Kundendienstabteilungen, um Kundenfeedback und Markttrends zu verstehen und darauf zu reagieren, kann beispielsweise aber auch in der Wissenschaft Anwendung finden.

- Automatische Zusammenfassungen und Berichterstattung: NLP kann genutzt werden, um lange Dokumente oder Datenmengen automatisch zu analysieren und zusammenzufassen. Dies spart Zeit bei der Informationsbeschaffung und ermöglicht es, schneller fundierte Entscheidungen zu treffen. NLP ermöglicht es Computern erstmals, menschliche Sprache in für sie prozessierbare Daten zu verwandeln.

- Sprachübersetzung: Fortgeschrittene NLP-Systeme bieten nahezu Echtzeit-Übersetzung von und in verschiedene Sprachen, was die globale Kommunikation und Zusammenarbeit erleichtert. ChatGPT etwa brachte sich selbst auf der Basis seiner Algorithmen und der englischen Sprache zahlreiche weitere Sprachen bei und kann mittlerweile für viele Sprachen auch als relativ zuverlässiges Übersetzungstool genutzt werden.

- Verbesserte Suchfunktionen: NLP verbessert Suchalgorithmen, sodass Nutzer natürliche Sprache verwenden können, um komplexe und kontextbezogene Informationen in Datenbanken oder im Internet zu finden. Dies wird die Forschung und Bildung in den nächsten Jahren transformieren und Big Data noch größer machen.

Alles kann berechnet werden: Big Data

Neben den Fortschritten bei der Sprachfähigkeit beeindrucken KI-Anwendungen vor allem durch ihre unglaublichen Analysefähigkeiten, mit denen sie in der Lage sind, verschiedenste Muster auf der Grundlage riesiger Datenmengen zu erstellen und sogar Vorhersagen über zukünftige Entwicklungen zu erstellen. Dabei speist sich die Datengrundlage, Big Data, aus unterschiedlichen Quellen von Social Media Postings bis hin zu medizinischen Statistiken und Ähnlichem.

Intelligente Algorithmen beziehungsweise Methoden des maschinellen Lernens ermöglichen eine automatisierte Analyse dieser Daten zu unterschiedlichen Zwecken. Aufgrund ihrer enormen Rechenleistung und der Fortschrittlichkeit der statistischen Analysemethoden entdecken KI-Anwendungen mittlerweile viele Muster zuverlässiger und schneller als menschliche Forscher oder Analysten. Über kurz oder lang wird ein Großteil unseres statistischen Wissens auf der automatisierten Analyse von Big Data beruhen. Zu den Hauptanwendungsgebieten dieser mächtigen Algorithmen gehören derzeit folgende Bereiche:

- Unternehmensorganisation und Entscheidungsfindung: Unternehmen nutzen Big Data, um Markttrends zu analysieren, Kundenverhalten zu verstehen und fundierte Entscheidungen bei Geschäftsstrategien, in der Produktentwicklung und bezüglich ihrer Marketingkampagnen zu treffen. Diese Analysen ermöglichen es Unternehmen, auf sich ändernde Marktdynamiken schnell zu reagieren und ihre Angebote besser auf die Kundenbedürfnisse abzustimmen.

- Personalisierte Kundenerfahrungen: Im Einzelhandel und in der Dienstleistungsbranche wird Big Data verwendet, um personalisierte Einkaufserlebnisse zu schaffen. Durch Analyse des Kaufverhaltens, Online-Interaktionen und Kundenpräferenzen können Unternehmen individuell zugeschnittene Empfehlungen und Angebote erstellen.

- Gesundheitswesen: Im Gesundheitssektor ermöglichen Big Data Analysen eine bessere Patientenversorgung durch die Analyse von Patientendaten, klinischen Studien und Forschungsergebnissen. Sie tragen zur Entwicklung personalisierter Medizin bei und helfen bei der Vorhersage von Krankheitsmustern und Epidemien.

- Finanzdienstleistungen: In der Finanzbranche wird Big Data unter anderem genutzt, um Risiken zu bewerten, Betrug zu erkennen und Investitionsentscheidungen zu optimieren. Banken und Versicherungen analysieren große Mengen an Transaktionsdaten, um ungewöhnliche Muster zu identifizieren und ihr Risikomanagement zu verbessern.

- Supply Chain Management: Big Data hilft Unternehmen, ihre Lieferketten effizienter zu gestalten. Durch die Analyse von Daten aus verschiedenen Quellen können Unternehmen Lagerbestände optimieren, Lieferzeiten verkürzen und die Reaktionsfähigkeit auf Marktveränderungen verbessern.

- Städtische Planung und Verkehr: Im öffentlichen Sektor werden Big Data Anwendungen zur Verbesserung der städtischen Infrastruktur und zur Optimierung des Verkehrsflusses eingesetzt. Städte nutzen Verkehrs- und Mobilitätsdaten, um Staus zu reduzieren und öffentliche Dienstleistungen zu verbessern.

- Energie und Umwelt: Im Energiebereich ermöglichen Big Data Analysen eine effizientere Nutzung von Ressourcen und tragen zur Entwicklung nachhaltiger Energielösungen bei. Sie werden auch zur Überwachung und zum Schutz der Umwelt eingesetzt, indem beispielsweise Emissionsdaten analysiert werden.

Fazit: Unendliche Möglichkeiten

Wie in der Übersicht deutlich geworden sein dürfte, sind die Möglichkeiten und Grenzen moderner KI-Technologien derzeit kaum absehbar. Nahezu jede Branche sowie Unternehmen aller Größen werden in den nächsten Jahren in der ein oder anderen Form durch diese neueste Phase der digitalen Revolution beeinflusst werden. Derzeit stecken viele Anwendungen zwar noch in den Kinderschuhen, aber ihr Transformations- und Rationalisierungspotenzial lässt sich bereits erahnen – und vor allem schon heute nutzen.

Jeder Jungunternehmer, Start-up-Gründer, aber auch etablierte Firmen und Manager sollten diese frühe Phase nutzen, um sich einen Vorsprung zu verschaffen, Erfahrungen zu sammeln und ihr gesamtes Geschäftsmodell daraufhin zu befragen, wo ihnen KI in Zukunft behilflich sein kann.

Diese Artikel könnten Sie auch interessieren:

Amba: Der Schlüssel zum Digital Detox

Drei Stunden und 19 Minuten – so lange hängen junge Erwachsene täglich auf Social Media, oft völlig unbewusst. Das Kölner Start-up Amba will diesen Scroll-Automatismus nun mit einem simplen haptischen Trick durchbrechen: Ein NFC-Schlüsselanhänger erzwingt eine physische Hürde. Doch kann das Konzept im Alltag wirklich bestehen?

Das 2025 von Yves Maurice Clever und Bastian Fischer gegründete Kölner Start-up Amba positioniert sich mutig im umkämpften Digital-Wellbeing-Markt. Statt auf strenge App-Verbote zu setzen, wollen die beiden 27-Jährigen das unbewusste Dauer-Scrollen auf Social Media mit einem physischen Schlüsselanhänger stoppen. Angesichts einer durchschnittlichen Social-Media-Nutzungsdauer von drei Stunden und 19 Minuten bei jungen Erwachsenen – wovon viel Zeit für rein gewohnheitsmäßiges Scrollen draufgeht – zielt Amba darauf ab, dieses Muster durch eine haptische Hürde zu durchbrechen.

Yves, der in Neuss Marketing studierte, beschäftigt sich schon lange mit digitaler Achtsamkeit, während Bastian als Informatiker das technische Know-how aus der Softwareentwicklung mitbringt. Angetrieben aus dem eigenen Frust über gängige Software-Lösungen, die sich mit wenigen Klicks umgehen ließen, begannen sie im Sommer vergangenen Jahres mit der Produktentwicklung, bevor im Oktober 2025 die offizielle Gründung in Köln folgte.

Haptik schlägt Habit

Doch wie verhindert man, dass der Griff zum NFC-Chip nicht bald zur nächsten unbewussten Gewohnheit wird? „Unbewusstes Scrollen funktioniert so gut, weil alles in derselben Bewegung passiert: Man nimmt das Handy in die Hand und ist sofort in der App“, analysiert Mitgründer Bastian. Ein physisches Element unterbreche genau diesen Automatismus.

Der entscheidende Vorteil gegenüber klassischer Software liege im Timing, so Bastian weiter: „Bildschirmzeit-Limits erscheinen meist erst im Scroll-Moment, wenn viele schon im Autopilot sind und sie reflexartig wegklicken. Bei Amba fällt die Entscheidung vorher.“ Nach dem haptischen Entsperren legen die Nutzer*innen fest, wie viel Zeit sie in der App verbringen möchten. Bastian betont: „Dieser kleine mentale Rahmen macht Social Media wieder zu einer bewussten Entscheidung statt zu einer Gewohnheit.“ Erste Tests scheinen den Gründern recht zu geben: Eigenen Angaben zufolge sei die Social-Media-Nutzung der Tester auf durchschnittlich 49 Minuten pro Tag gesunken.

Das Hardware-Paradoxon und die Konkurrenz

Der Ansatz der „Intentional Friction“ ist clever, doch der Markt verzeiht keine Fehler. Mit dem niederländischen Start-up Unpluq existiert bereits ein etablierter Konkurrent mit einem fast identischen NFC-Konzept. Yves sieht den Unterschied seines Produkts vor allem in der Systematik. „Viele bestehende Lösungen [...] funktionieren nach dem Prinzip: Man hält den Tag ans Smartphone, um Apps zu sperren, und deaktiviert die Sperre später wieder. Wir haben die Logik umgedreht“, kontert Yves. Bei Amba seien die Apps standardmäßig gesperrt und würden erst durch den Schlüssel freigeschaltet.

Zudem wolle man sich über eine extrem niedrige Einstiegshürde abheben: „Deshalb kostet der physische Tag bei uns nur einen symbolischen Euro und Nutzer können Amba zwei Wochen lang testen“, erklärt Yves den aggressiven Markteinstieg.

Der Kampf gegen die Abo-Müdigkeit

Dennoch muss sich Amba langfristig beweisen, insbesondere da laut einer ExpressVPN-Umfrage 38 Prozent der Konsument*innen explizit unter „Abo-Müdigkeit“ leiden. Ob die Nutzerschaft dauerhaft bereit ist, knapp 20 Euro im Jahr für einen softwarebasierten Verzicht zu zahlen, bleibt abzuwarten.

Bastian räumt offen ein: „Mit den physischen Tags verdienen wir tatsächlich kein Geld, sie decken lediglich die Produktionskosten.“ Er ist jedoch überzeugt, dass die Abo-Investition für die Nutzer*innen unverzichtbar bleibt, da das Suchtpotenzial der Apps nicht verschwinde. „Social-Media-Plattformen sind bewusst so gestaltet, dass sie möglichst lange Aufmerksamkeit binden. Viele Nutzer berichten uns, dass sie nach kurzer Zeit wieder in alte Muster zurückfallen, sobald sie die Unterstützung entfernen“, warnt Bastian. Das Ziel sei daher keine einmalige „Detox“-Kur, sondern ein Rahmen, um die Nutzung „langfristig kontrollierter zu gestalten“.

Technischer Flaschenhals zum Start

Erschwerend kommt aktuell ein stark restriktives System hinzu: Durch die Begrenzung auf das Betriebssystem iOS 18 bleiben der gesamte Android-Markt sowie Besitzer*innen älterer Apple-Geräte vorerst kategorisch ausgeschlossen. „Die aktuelle Einschränkung auf neuere iOS-Versionen hat vor allem technische Gründe“, verteidigt Yves diesen harten Schnitt. Einige NFC-Funktionen liefen auf älteren Systemen schlichtweg noch nicht stabil genug. Eine Android-Version sei geplant, befinde sich aber noch nicht in der Entwicklung.

Und was passiert, wenn man den rettenden Chip zu Hause vergisst und komplett blockiert ist? Yves beschwichtigt: Für solche Fälle gebe es eine Notfallfunktion in der App, die eine temporäre Entsperrung erlaube. Er verspricht: „Amba soll eine bewusste Hürde schaffen, aber keine Situation, in der Nutzer komplett von ihrem Smartphone abgeschnitten sind.“

Letztlich wandert das Kölner Start-up auf dem schmalen Grat zwischen Achtsamkeit und Deinstallation. Der Erfolg steht und fällt mit dem Hardware-Paradoxon: Nur wenn die Community den Schlüsselanhänger langfristig als befreiendes Werkzeug und nicht als frustrierende Barriere wahrnimmt, wird sich das subventionierte Abo-Modell gegen die Platzhirsche rentieren.

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

KI gegen Buchhaltungsriesen: Wie Bonster den Spesen-Markt aufmischen will

Pay-per-Use statt Abo-Falle: Das Oldenburger Start-up fast2work attackiert mit seiner App bonster komplexe Software-Giganten. Doch reicht das Versprechen maximaler Einfachheit im Haifischbecken der FinTechs? Wir haben nachgehakt.

Es ist eines der letzten großen Ärgernisse im Arbeitsalltag von Freelancer*innen und kleinen Agenturen: Der Freitagabend, der für das Sortieren verknitterter Tankbelege und das Abtippen von Bewirtungsbelegen in Excel-Listen draufgeht. Genau hier setzt die Oldenburger fast2work GmbH mit ihrer am 17. Februar 2026 gelaunchten App bonster an, um den Papierkram bei der Reisekostenabrechnung zu beenden. Das Versprechen von Gründer und CEO Ronald Bankowsky: Drei Minuten Aufwand, KI-Automatisierung und keine Einstiegshürden.

Das Versprechen: Simpel statt Systemintegration

Die Funktionsweise der App ist bewusst minimalistisch gehalten: Beleg fotografieren, woraufhin die KI relevante Werte wie Datum, Betrag und Mehrwertsteuer ausliest, auf Duplikate prüft und eine fertige Abrechnung erstellt. „Kein Onboarding-Projekt, kein Vertriebsgespräch, kein IT-Setup“, fasst Bankowsky den Ansatz der Standalone-Lösung zusammen.

Die Zielgruppe ist klar definiert: Selbständige, Freelancer*innen und Mini-Teams, denen Enterprise-Lösungen wie SAP Concur zu mächtig und Start-ups wie Circula oder Pleo oft noch zu prozesslastig sind. Mit einem Preismodell von 1,99 Euro für Einzelabrechnungen und 6,99 Euro (Stand Ende Febr. 2026) für eine Flatrate positioniert sich das Unternehmen im unteren Preissegment.

Im Haifischbecken der Neobanken und Buchhaltungsriesen

Laut fast2work gab es bislang „kaum eine Alternative zwischen Excel und Enterprise-Software“. Diese Aussage hält einem Realitätscheck im Jahr 2026 allerdings nur bedingt stand. Bonster betritt ein Haifischbecken, denn die vermeintliche Lücke wird längst geschlossen.

Zum einen integrieren Buchhaltungsriesen wie Lexoffice oder sevDesk Reisekosten-Features immer tiefer in ihre Standardpakete. Zum anderen wildern Neobanken wie Qonto, Finom oder Kontist im selben Revier: Wer dort ein Geschäftskonto hat, bekommt die Belegzuordnung oft als „Commodity“ gratis dazu. Mit knapp 7 Euro im Monat bewegt sich bonster in einer Preisregion, in der man fast schon eine komplette einfache Buchhaltungssoftware bekommt. Die App muss also einen enormen Mehrwert bieten, um gegen die „Eh-da-Lösungen“ (Software, die Kund*innen ohnehin bezahlen) zu bestehen.

Auf die Frage, warum Freelancer*innen für eine Insellösung extra zahlen sollten, entgegnet der Gründer, dass bonster bewusst früher ansetze als klassische Tools. Das Hauptproblem sei nicht die Buchhaltung, sondern das Erfassen von Belegen unterwegs. „Genau dort scheitert es oft, weil Mitarbeitende keine komplexen Systeme nutzen wollen oder gar keine Zugänge haben“, argumentiert Bankowsky. Der Mehrwert liege nicht in einer weiteren Buchhaltungssoftware, sondern darin, dass durch die Reduzierung auf ein Foto „überhaupt verwertbare Abrechnungsdaten/Belege entstehen“.

Kritische Faktoren: GoBD und Datensicherheit

Neben der Marktpositionierung ist die Rechtssicherheit ein kritischer Faktor. „Fertige Abrechnung für die Buchhaltung“ ist ein mutiges Versprechen, da in Deutschland ein Foto allein oft nicht ausreicht; es muss GoBD-konform und revisionssicher archiviert werden. Zudem ist die KI-Nutzung datenschutzrechtlich sensibel. Wenn Bewirtungsbelege, die offenbaren, mit wem man gegessen hat, über US-Schnittstellen (z.B. OpenAI) fließen, ist das für deutsche Geschäftskund*innen und Steuerberater oft ein K.O.-Kriterium.

Auf die sensiblen Vorgaben der Finanzämter und den Serverstandort angesprochen, betont Bankowsky, dass die Verarbeitung „ausschließlich auf europäischen Servern“ erfolge. Zwar nutze man OpenAI-basierte Modelle, diese liefen jedoch über Azure-Rechenzentren im europäischen Raum. Datenschutz und regulatorische Anforderungen seien Grundvoraussetzung. Auch beim Export zum Steuerberater zeigt sich der Gründer zuversichtlich: Buchhaltungssysteme könnten die Daten direkt und „ohne manuelle Nacharbeit“ weiterverarbeiten.

Beta-Test als Exklusiv-Club

Zum Start setzt das Unternehmen auf eine Gamification des Rollouts. Die ersten 500 Nutzer*innen erhalten im „Club 500“ einen lebenslangen Rabatt von 50 Prozent. Was als Belohnung für Early Adopters verkauft wird, ist strategisch notwendig: Die KI muss lernen. Der Algorithmus braucht dringend „Real World Data“ – echte, verknitterte, schlecht beleuchtete Belege. Das bedeutet auch: Die ersten User*innen sind Teil des Entwicklungsprozesses.

Dass die App im Alltag noch dazulernen muss, räumt Bankowsky ein. Bei der reinen Datenerkennung sei man technisch auf dem aktuellen Stand. „Entscheidend ist jedoch die Qualität realer Belege im Alltag – etwa schlecht fotografierte oder handschriftliche Quittungen“, erklärt er den Bedarf an Praxis-Feedback. Durch schnelle Updates solle die Genauigkeit für alle Nutzer*innen laufend steigen.

Gegenmodell zur Ökosystem-Abhängigkeit

Wer ein Feature-Feuerwerk suche, werde bei bonster enttäuscht sein – was laut Unternehmen aus Überzeugung geschehe. Anbieter wie Rydoo verfolgten eine Strategie der maximalen Integration und langfristiger Verträge, was eine Abhängigkeit erzeuge, die ihr eigentliches Geschäftsmodell sei, so der Gründer. Wer einmal im Ökosystem stecke, wechsle nicht mehr, weil der Ausstieg zu teuer geworden sei.

Bonster positioniert sich als Gegenmodell für Unternehmen, die nicht für ungewollte Komplexität zahlen möchten: Kein Vertrag, keine Mindestnutzerzahl, Setup in unter fünf Minuten und ein Pay-per-Use-Modell. „Wer aufhören will, hört auf, ohne Konsequenzen“, beschreibt das Start-up den Ansatz der bewussten Entscheidung, Kund*innen freizulassen. Wer bleibe, tue dies, weil es funktioniere, was laut Bankowsky „die interessantere Innovation“ sei.

Fazit

Bonster ist ein innovativer Angriff auf die Zettelwirtschaft und wirkt durch den Verzicht auf starre Abo-Modelle bei der Einzelabrechnung fair. Doch die App steht und fällt mit der Schnittstellenkompetenz. Wenn der Export zu DATEV & Co. hakt, wird aus der Zeitersparnis schnell Mehrarbeit. Bonster muss beweisen, dass es die Brücke zwischen dem schnellen Foto und der strengen deutschen Buchhaltung schlagen kann – und zwar besser als die Banken, die das Feature bereits kostenlos anbieten.

Distart: Vom Agentur-Frust zum EdTech-Champion

Wie das 2021 von Thomy Roecklin gegründete und seit 2025 zusammen mit Lucia-Miriam Selbert geführte Leipziger EdTech Distart das Bildungssystem „gegen den Strich bürstet“.

Wer in Deutschland über Start-up-Hubs spricht, landet meist schnell in Berlin oder München. Doch in der sächsischen Metropole Leipzig wächst seit einigen Jahren ein Player heran, der beweist, dass Innovation auch abseits der üblichen Verdächtigen gedeiht: Die Distart Education GmbH. Ihr Treibstoff ist der eklatante Mangel an digitaler Kompetenz in der deutschen Wirtschaft – und der Mut, das „System Bildung“ gegen den Strich zu bürsten.

Wenn „Done for You“ nicht mehr reicht

Die Wurzeln des Unternehmens reichen weiter zurück als das offizielle Gründungsjahr 2021. Gründer Thomy Roecklin setzte jahrelang mit seinen Agenturen MNKY lab und TRDIGITAL digitale Kampagnen für Kund*innen um. Doch im Tagesgeschäft bremste das fehlende Digitalverständnis auf Kundenseite die Projekte immer wieder aus. Die Erkenntnis, dass Deutschland weniger neue Agenturen, sondern mehr digitale Mündigkeit braucht, führte schließlich zum Pivot.

Interessanterweise war der Auslöser für diesen Kurswechsel kein konkretes Kundenprojekt. Auf die Frage nach dem „Aha-Moment“ erklärt Roecklin, dass er lediglich versuchte, Lucia-Miriam Selbert einzuarbeiten, und dabei schockiert feststellte, wie wenig praxisnahe digitale Weiterbildungen existierten. Er baute kurzerhand selbst ein Lernprogramm – ohne zu ahnen, dass daraus einmal Distart entstehen würde. Im Januar 2021 fiel der Startschuss für Distart learn. Mitten in der Pandemie setzte Roecklin auf ein Modell, das sich radikal von klassischen Bildungsträgern unterschied: 100 Prozent remote, aber mit enger persönlicher Betreuung und einem klaren Fokus auf die Praxis.

Das Schnellboot zwischen den Tankern

Distart operiert im sogenannten AZAV-Markt (Akkreditierungs- und Zulassungsverordnung Arbeitsförderung). Während etablierte Bildungsriesen oft mit der Trägheit ihrer Größe kämpfen und bis zu 24 Monate für Lehrplananpassungen benötigen, hat sich Distart als agiler „Qualitäts-Vorreiter“ positioniert.

Für Roecklin ist diese Agilität eine Frage des Überlebens, da sich Jobs und Skills heute schneller verändern als jede klassische Bildungslogik. Er betont, dass man ohne permanente Weiterentwicklung der Inhalte zwangsläufig am Markt vorbei ausbilden würde. Diese Flexibilität ist zudem essenziell für die Zielgruppe: Viele Teilnehmende bilden sich neben ihrem 9-to-5-Job weiter, betreuen Kinder oder pflegen Angehörige und benötigen daher flexible statt starrer Strukturen.

Agency-DNA statt Schulbank-Feeling

Der entscheidende Wettbewerbsvorteil liegt in der Herkunft: Distart ist keine klassische Schule, sondern wurde von Marketern für Marketer gebaut. Diese „Agency-DNA“ durchzieht das gesamte Geschäftsmodell. Mit einer modernen Lernumgebung aus Live-Sessions und asynchronen Deep-Dives spricht das Unternehmen alle Altersgruppen gleichermaßen an.

Auch technologisch ist man der Konkurrenz oft einen Schritt voraus: Als ChatGPT Ende 2022 die Arbeitswelt veränderte, reagierte Distart fast in Echtzeit. Auf die kritische Frage, ob KI das vermittelte Wissen nicht bald obsolet mache, findet Roecklin eine klare Antwort: KI ersetzt keine Menschen, sie ersetzt lediglich Mittelmaß. Während KI das Netz mit generischen Inhalten flutet, steige paradoxerweise der Hunger nach echten Stimmen, Ideen und Perspektiven – Marketing werde also menschlicher.

Bootstrapping und gesundes Wachstum

Der Erfolg gibt dem Konzept recht. Im September 2024 erfolgte die Umfirmierung zur Distart Education GmbH, was den Übergang vom Start-up zum etablierten Bildungsinstitut markierte. Während andere Tech-Unternehmen Personal abbauen mussten, verdoppelte Distart seine Belegschaft beinahe auf über 100 Köpfe und bezog im Oktober 2025 neue Räumlichkeiten im NEO Leipzig.

Besonders bemerkenswert: Das Wachstum ist organisch und gebootstrapped – finanziert aus dem eigenen Cashflow ohne externe Risikokapitalgeber. Das macht Distart unabhängig von Exit-Druck. Seit Februar 2025 verstärkt Lucia-Miriam Selbert als Geschäftsführerin die strategische Ausrichtung.

Dennoch birgt die Skalierung Risiken, da das Geschäftsmodell stark von staatlichen Bildungsgutscheinen abhängt. Auf einen möglichen „Plan B“ angesprochen, erklärt das Unternehmen, dass Förderungen zwar beim Beschleunigen helfen, man Distart aber bewusst so aufbaue, dass langfristig strukturelle Unabhängigkeit erreicht wird. Auch die Qualitätssicherung bei über 100 Mitarbeitenden ist eine Herausforderung. Thomy Roecklin gibt offen zu, dass Wachstum kein Wellnessprogramm ist und es im Getriebe zwangsläufig knirscht. Sein Schlüssel: Qualität darf nicht an Einzelpersonen hängen, sondern muss im gesamten System verankert sein, kombiniert mit echtem Vertrauen in das Team statt Kontrolle.

Der Standort als Statement und Vision

Dass Distart in Leipzig verwurzelt bleibt, ist Teil der Identität. Roecklin sieht im Osten Deutschlands ein enormes, oft unterschätztes Potenzial und erlebt dort viel Talent, Pragmatismus und Lernhunger. Distart versteht sich hier auch als Regionalentwickler.

Die Vision der Gründer geht jedoch über reine Kurse hinaus. Unterstrichen durch Auszeichnungen wie „Top Fernschule 2025“ und „2026“, arbeitet das Team nun an der Gründung der Distart University of Applied Sciences. Das Ziel bis 2030 ist ambitioniert: Ein Alumni-Netzwerk von 25.000 Absolvent*innen. Sollte der komplexe Weg zur staatlichen Anerkennung gelingen, wird Distart endgültig zum gewichtigen Faktor für die digitale Wettbewerbsfähigkeit der Bundesrepublik.

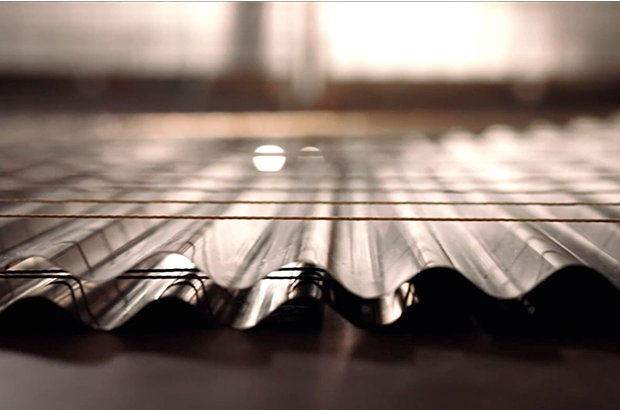

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Vom Check-in zur Patient*innenakte: Wie Travel-Pionier Salim Sahi mit HoloLogix.AI die Health-IT aufmischt

Vom Reisebuchungssystem zur Sicherheits-Uhr für Senior*innen: Serial Entrepreneur Salim Sahi greift mit HoloLogix.AI greift gleich zwei Milliardenmärkte an: Gesundheitswesen und Hotellerie. Doch wie viel Substanz steckt hinter der Vision?

Gründungslegenden klingen oft zu glatt für die Realität – wie Sahis Skateboard-Unfall, der in einer Notaufnahme zur Idee für sein neuestes Venture führte. Wer den Mann kennt, der in den 90ern mit „Traffics“ die Reisebranche digitalisierte, weiß jedoch: Er macht keine halben Sachen. Jetzt, im Februar 2026, steht er mit einer europäischen Aktiengesellschaft (SE) und einem enorm breiten Versprechen wieder auf dem Platz.

Wie Touristik-Know-how in die Klinik kommt

Der Sprung von der Touristik zur Service-Automatisierung im Gesundheitswesen wirkt wie ein harter Bruch. Doch unter der Haube geht es in beiden Welten um hochvolumige Transaktionen, Termin-Slots und Datenabgleich in Echtzeit. Wer Millionen Pauschalreisen fehlerfrei abwickelt, so die Wette von HoloLogix.AI, beherrscht auch das Termin-Management von Kliniken, Hotels und Restaurants.

Für CEO und Gründer Salim Sahi ist das Projekt dennoch ein „kompletter unternehmerischer Neuanfang“. Gegenüber StartingUp räumt er ein, von 25 Jahren Travel-Tech-Erfahrung zu profitieren, doch seine wahre Passion gelte der künstlichen Intelligenz. Das Herzstück bilde dabei die MIA Service KI: „Wir haben eine holistische KI-Plattform geschaffen, also ein Tool, das ganzheitlich agiert und eingesetzt werden kann.“ MIA verstehe Gespräche, erledige parallel Aufgaben und verbinde Systeme – „rund um die Uhr und branchenübergreifend“. Auch wenn der Fokus aktuell auf Gesundheitswesen und Hospitality liege, sei das System laut Sahi letztlich „nahezu überall einsetzbar, wo Kunden- oder Patientenkontakt herrscht.“

Der Angriff auf die Platzhirsche

Der Markt für Conversational AI ist 2026 kein blauer Ozean mehr. Etablierte Player wie Aaron.ai haben sich tief in die Health-Landschaft eingegraben, flankiert von Plattform-Giganten wie Doctolib. HoloLogix.AI reagiert mit aggressiven Preisen ab 99 Euro im Monat und einer massiven technologischen Breite.

Aber warum sollten Klinikverantwortliche das Risiko eines Wechsels eingehen? Salim Sahi sieht den „Killer-USP“ in der Architektur der Interaktion: „Unser Ansatz ist ein anderer: Statt starrer Skripte bieten wir echte Gesprächsintelligenz durch Conversational AI an.“ Das System sei eine KI, die im laufenden Gespräch aktiv Aufgaben erledige, was eine beispiellose Integrationstiefe erfordere. „Hier gehen wir ganz tief rein und verarbeiten Daten in Echtzeit“, so der CEO. Da Aufgaben direkt ausgeführt werden, optimiere sich das Zeitmanagement drastisch – konzipiert als Omnichannel-Ansatz über Telefon, Website, E-Mail, Wearables oder bald sogar über Robotik.

Die schmale Gratwanderung am Handgelenk

HoloLogix.AI belässt es nicht bei Software, sondern bringt mit der MIA Watch eigene Hardware ins Spiel. Die Smartwatch für Senior*innen soll Stürze erkennen und sofort einen aktiven Sprachdialog führen. Eine Gratwanderung: Reines Assistenz-System oder medizinisches Gerät mit komplexer Zertifizierungspflicht (MDR)?

Prof. Dr. Thomas Fuchs, Co-Founder und Aufsichtsrat für den Bereich Health Care, ordnet das rechtlich eindeutig ein: „MIA Protect ist ein Teil der holistischen KI-Plattform, die mit verschiedenen Health Watches wie z.B. auch der Apple Watch kompatibel ist. Sie ist ein Assistenz- und Companion-System.“ Die Hardware erkenne Stürze, ersetze aber „keine ärztliche Untersuchung oder medizinische Entscheidung“. Um Geschwindigkeit und Nutzer*innenfreundlichkeit zu wahren, bewege man sich „bewusst außerhalb der Medizinprodukt-Zertifizierung (MDR), ohne den Sicherheitsrahmen zu verlassen“.

Ein mehrstufiges Sicherheitsnetz aus Sensorik, KI-Algorithmen und menschlichem Service-Team federt Fehlinterpretationen ab. Haftungsfragen sind laut Fuchs über klare Nutzungsbedingungen geregelt. Für den Mediziner steht ohnehin der „Companion Aspekt“ im Vordergrund: Nach einem Sturz, wenn Patient*innen hilflos am Boden liegen, alarmiere MIA in einer Kaskade Notfallkontakte und beruhige das Unfallopfer, bis Hilfe eintrifft. „MIA Protect soll an diesem Punkt Sicherheit und damit Lebensqualität geben, vielleicht sogar die Möglichkeit schaffen für Senioren, länger selbstbestimmt in ihrem Zuhause zu leben“, resümiert Fuchs.

Pflegeheim und Luxushotel: (K)ein operativer Widerspruch?

Das vielleicht Spannendste an HoloLogix.AI ist das Personal: Salim Sahi hat sich politische und ethische Schwergewichte in den Aufsichtsrat geholt. Darunter Dr. Marcel Klinge, ehemaliger FDP-Bundestagsabgeordneter und Tourismus-Experte. Er muss Investor*innen den Spagat erklären, warum ein Start-up gleichzeitig Pflegeheime und Luxushotels digitalisieren will – was oft als Warnsignal für operative Verzettelung gilt.

Dr. Marcel Klinge sieht darin jedoch keinen Widerspruch, sondern die Stärke der technischen Basis: „Der gemeinsame Nenner liegt im Kern: Unsere holistische KI-Infrastruktur kann über das Telefon Gespräche führen, kann aber auch über die Website, Health Watches und Devices und direkt im Gespräch Aufgaben ausführen.“ Das Backend orchestriere lediglich Termin-Slots, Daten und Anfragen in Hochgeschwindigkeit. Dabei spiele es schlichtweg keine Rolle, „ob der Kunde Patient in einem Pflegeheim oder Gast in einem Luxushotel ist.“

Wenn die KI-Vision auf den deutschen Fax-Alltag trifft

Ein Blick auf die Website verrät große Visionen, doch diese müssen sich im harten Alltag deutscher IT-Infrastrukturen und oft veralteter Praxis-Server beweisen. Zudem ist die Frage des Datenschutzes elementar: Nutzt das Unternehmen US-amerikanische Sprachmodelle via API, oder hostet man eigene „Sovereign AI“ in Europa?

Für Prof. Dr. Thomas Fuchs sind Datenschutz und Systemintegration absolute Kernpunkte. Um digitale Souveränität zu wahren, setzt das Unternehmen auf einen hybriden Weg: „Wir orchestrieren auf die gängigen sowie auf eigene Modelle auf deutschen Servern, die in Europa bereits genutzt werden.“ Laut Fuchs verlässt man sich dabei nicht nur auf das Versprechen von Sicherheit, sondern arbeitet seit der ersten Stunde eng mit dem renommierten Fraunhofer-Institut zusammen und lässt die eigene Infrastruktur „regelmäßig durch deren Experten prüfen“. Das bloße Versprechen von Sicherheit reicht HoloLogix.AI dabei nicht.

Mehr als nur ein GPT-Wrapper?

HoloLogix.AI ist eine der vielleicht ambitioniertesten Gründungen des Jahres. Technologisch muss es beweisen, dass es mehr ist als ein „GPT-Wrapper“ mit Smartwatch. Aber die Kombination aus Sahis Exekutiv-Erfahrung, Klinges Netzwerk und Fuchs‘ ethischem Korrektiv macht es zu einem spannenden Herausforderer. Wenn die Uhr im Alltag für Sicherheit sorgt – und die KI den deutschen Datenschutz überlebt – könnte aus Berlin der nächste europäische Champion kommen.

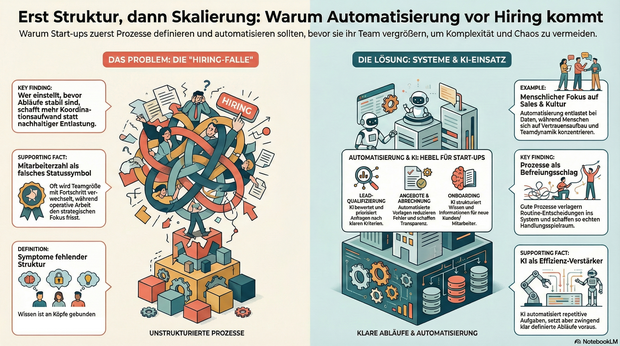

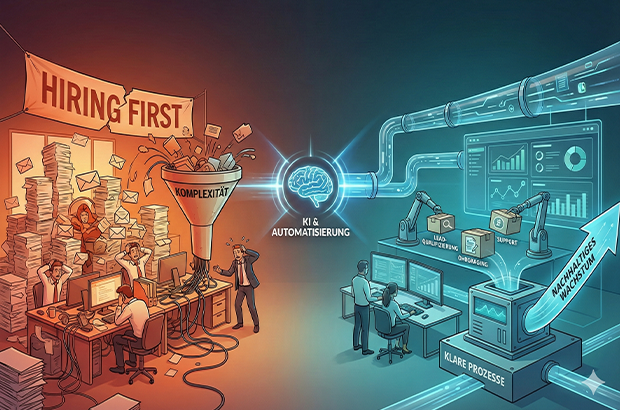

Automatisierung vor Hiring, sonst wird Komplexität skaliert

Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung. Tipps und To-Dos.

Wachstum wird in Start-ups oft sehr eindimensional gedacht: mehr Nachfrage gleich mehr Menschen. Sobald Anfragen steigen, Deals reinkommen oder neue Märkte locken, folgt fast automatisch der nächste Hiring-Plan. Dabei wird häufig die Ursache mit Wirkung verwechselt. Nicht fehlende Kapazität bremst junge Unternehmen, sondern fehlende Struktur. Prozesse entstehen improvisiert, Verantwortung wird situativ verteilt, operative Arbeit frisst Fokus. Und irgendwann fühlt sich Wachstum nicht mehr nach Fortschritt, sondern nach Dauerstress an.

Gerade in der Start-up-Branche wird Wachstum zudem stark über sichtbare Kennzahlen bewertet. In Gesprächen mit Investor*innen lautet eine der ersten Fragen häufig nicht Gewinn oder EBITA, sondern: Wie viele Mitarbeitende seid ihr und wie viel Umsatz macht ihr? Die Anzahl der Mitarbeitenden wird damit fast zu einem Statussymbol. Hiring wird nicht nur zur operativen, sondern auch zur psychologischen Größe und ein Zeichen von Fortschritt. Diese Logik verstärkt den Reflex, früh zu skalieren, auch wenn die strukturellen Voraussetzungen dafür noch fehlen. Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung.

Warum Hiring allein selten skaliert

Mehr Menschen im Team wirken wie eine schnelle Lösung. In der Praxis zeigt sich jedoch häufig ein ähnliches Muster: Neue Kolleg*innen übernehmen Aufgaben, die eigentlich nur deshalb existieren, weil Abläufe unklar oder manuell gewachsen sind. Statt nachhaltiger Entlastung entsteht zusätzliche Koordination.

Typische Symptome sind:

- operative Aufgaben blockieren strategische Arbeit,

- Wissen verteilt sich auf einzelne Köpfe,

- Entscheidungen hängen an Personen statt an klaren Abläufen,

- Abstimmungen nehmen zu, ohne dass die Wertschöpfung im gleichen Maß wächst.

Das Problem ist nicht Hiring an sich, sondern die Reihenfolge. In vielen Fällen wird Hiring eingesetzt, um kurzfristig Druck rauszunehmen, obwohl das eigentliche Nadelöhr fehlende Klarheit ist. Wer einstellt, bevor Abläufe stabil sind, schafft zwar mehr Kapazität, skaliert aber auch Komplexität.

Prozesse als Voraussetzung für wirksames Wachstum

Prozesse werden in Start-ups häufig mit Bürokratie verwechselt. Tatsächlich sind sie das Gegenteil: Sie reduzieren Reibung. Gute Prozesse verlagern Entscheidungen vom Einzelfall ins System. Sie beantworten zwei zentrale Fragen zuverlässig: Was passiert als Nächstes – und wer ist verantwortlich?

Gerade kleine Teams profitieren davon besonders. Prozesse schaffen keine Starrheit, sondern Handlungsspielraum. Sie machen Arbeit vorhersehbar, Übergaben sauber und Entscheidungen reproduzierbar. Erst auf dieser Grundlage kann ein wachsendes Team seine Stärke wirklich entfalten.

Automatisierung im KI-Zeitalter: neue Möglichkeiten, neue Verantwortung

Mit KI hat sich die Eintrittshürde für Automatisierung massiv gesenkt. Viele Aufgaben, die früher manuell oder individuell erledigt wurden, lassen sich heute zuverlässig unterstützen oder teilweise abnehmen, vorausgesetzt, der zugrunde liegende Ablauf ist klar definiert. Entscheidend ist dabei nicht die Tool-Auswahl, sondern die Frage, was automatisiert wird. Automatisierung verstärkt bestehende Strukturen, gute wie schlechte. Wer unklare Abläufe automatisiert, skaliert keine Effizienz, sondern Chaos. Gleichzeitig gibt es zentrale Bereiche, die sich bewusst nicht oder nur sehr begrenzt automatisieren lassen und auch nicht sollten. Recruiting ist einer davon. Der Aufbau eines funktionierenden Teams lebt von persönlicher Einschätzung, Teamdynamik und kulturellem Fit. Ähnliches gilt für Sales: Vertrauensaufbau, Verhandlung und das persönliche Gespräch bleiben essenziell. Automatisierung ist hier unterstützend, aber kein Ersatz. Besonders geeignet sind Tätigkeiten, die häufig auftreten, wenig kreativen Spielraum haben und auf wiederkehrenden Informationen basieren.

Bereiche, die sich heute besonders gut automatisieren lassen

Lead- und Anfragequalifizierung

Unstrukturierte Anfragen lassen sich mithilfe von KI zusammenfassen, bewerten und priorisieren. Statt jede Anfrage manuell zu prüfen, entstehen klare Kriterien, die relevante von irrelevanten Leads trennen und Follow-ups vorbereiten.

Angebots- und Abrechnungsprozesse

Angebote, Verträge und Rechnungen folgen in vielen Startups ähnlichen Mustern. Automatisierte Vorlagen, angebundene Datenquellen und definierte Freigaben sparen Zeit, reduzieren Fehler und schaffen Transparenz.

Onboarding von Kund:innen und Mitarbeitenden

Onboarding ist kein Einzelfall, sondern ein wiederkehrender Prozess. Checklisten, automatische Aufgaben und zentrale Informationspunkte sorgen für Verlässlichkeit. KI kann helfen, Informationen zu strukturieren und kontextbezogen bereitzustellen.

Support und interne Anfragen

Ein Großteil von Fragen wiederholt sich. Wissensbasen in Kombination mit KI-gestützter Suche und Antwortvorschlägen entlasten Teams und machen sichtbar, wo Standards fehlen.

Projektmanagement und Übergaben

Klare Projekt-Templates, automatisierte Status-Updates und definierte Trigger reduzieren Abstimmungsaufwand. KI kann dabei unterstützen, Risiken früh zu erkennen oder nächste Schritte vorzuschlagen.

Was Start-ups daraus lernen können

Automatisierung ersetzt keine Entscheidungen, sie macht sie skalierbar. Voraussetzung dafür ist Klarheit über Abläufe, Verantwortlichkeiten und Prioritäten. Wer versucht, Chaos zu automatisieren, verstärkt es lediglich.

Hilfreiche Leitfragen sind:

- Welche Aufgaben wiederholen sich regelmäßig?

- Wo entstehen manuelle Engpässe?

- Welche Tätigkeiten binden qualifizierte Menschen ohne echten Mehrwert?

Die Antworten darauf liefern meist schnell die größten Hebel.

Der KI-Wendepunkt: Systeme und Personal

Nachhaltiges Wachstum entsteht dort, wo Start-ups Systeme aufbauen und diese bewusst mit ihrem Team verzahnen. Nicht, weil Systeme Menschen ersetzen, sondern weil sie Menschen von struktureller Überforderung entlasten. Automatisierung schafft dabei nicht nur Effizienz, sondern Entscheidungsqualität: Wenn Daten sauber fließen, Übergaben klar sind und Standards greifen, werden Prioritäten weniger Bauchgefühl und stärker reproduzierbar.

Der gezielte Einsatz von KI-Tools verschiebt diesen Wendepunkt zusätzlich. Sie können Routinearbeiten abfangen, Informationen aus unstrukturierten Inputs verdichten und Entscheidungen vorbereiten – etwa durch Lead-Vorqualifizierung, Support-Clustering oder zusammengefasste Status-Updates. KI wirkt dabei nicht als Ersatz für Klarheit, sondern als Verstärker funktionierender Prozesse.

Hiring bleibt auch weiterhin essentiell. Seine Wirkung entfaltet es jedoch erst dann vollständig, wenn Prozesse klar sind und Automatisierung sowie KI gezielt unterstützen. So entsteht Wachstum, das nicht nur schneller, sondern auch gesünder ist.

Der Autor Markus Hetzenegger ist Gründer & CEO von NYBA Media. 2018 gegründet, zählt NYBA heute zu den führenden Marketing-Unternehmen im Live-Entertainment.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

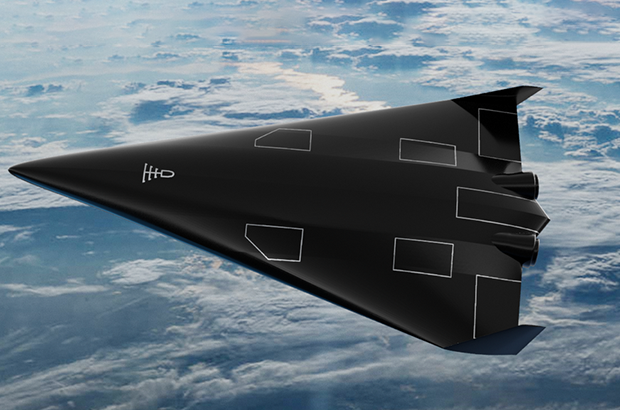

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

KI als neuer Ort für Kaufentscheidungen

Das Start-up publuence.ai zeigt am Beispiel der Automobilbranche, wie Marken in generativen KI-Antworten sichtbar werden und warum das zum neuen Erfolgsfaktor wird.

2025 haben wir euch das Start-up publuence.ai von Cevahir Ejder als "Gründer*in der Woche" präsentiert. Publuence.ai ist eine SaaS-Lösung für AI Search Analytics für Marken, die täglich analysiert, wie sichtbar Marken in generativen KI-Antworten sind: bei welchen Fragen erscheinen sie, wie werden sie erwähnt und welche Inhalte sowie Quellen beeinflussen die Antworten. Da die KI-Sichtbarkeit zunehmend darüber entscheidet, ob eine Marke in der engeren Auswahl der Konsumenten stattfindet, sind die Ergebnisse für Unternehmen strategisch sehr relevant.

Beispiel Automobilbrache: KI wird zum Verkaufsberater, Chatfenster zum Showroom

Während Marketing- und Kommunikationsbudgets weiterhin nach klassischen Logiken verteilt werden, fällt ein entscheidender Teil der Markenbildung inzwischen außerhalb des Mediaplans: KI-Systeme beantworten Kauf- und Vergleichsfragen oft lange bevor Kampagnen greifen. Anhand der Automobilbranche etwa, in der Marken wie Volkswagen für eine ganze Industrie stehen, zeigt sich, dass sich Sichtbarkeit im KI-Dialog zum neuen Machtfaktor entwickelt. Sie entscheidet zunehmend darüber, welche Hersteller überhaupt in die engere Auswahl kommen.

Was früher im Autohaus oder auf Herstellerwebsites stattfand, spielt sich heute in KI-gestützten Beratungsgesprächen ab. Nutzer*innen stellen dort Fragen wie: „Welche E-Autos sind familienfreundlich?“ „Wie gut ist die Reichweite im Winter?“ „Welche Modelle laden am schnellsten?“

In der Initialanalyse erzielt beispielsweise VW im Themenbereich E-Autos – je nach Fragestellung bzw. Prompt – Sichtbarkeitswerte zwischen 20 und 88 Prozent. Damit prägen die Antworten frühzeitig das Bild, das Konsument*innen von der Marke haben. Wer dort nicht vorkommt beziehungsweise seine Mehrwerte nicht sichtbar macht, wird in der Entscheidungsfindung schlicht nicht berücksichtigt.

Tesla und Hyundai vorn, VW im Mittelfeld

Das aktuelle Wettbewerbsranking der führenden Automobilhersteller – basierend auf 30 relevanten KI-Prompts rund um das Thema Elektromobilität – zeigt, wie präsent die einzelnen Marken im neuen digitalen Beratungsraum sind. Mit knapp 64 Prozent Sichtbarkeit führt Tesla klar und profitiert von seiner technologischen Positionierung sowie einer starken Medienpräsenz. Überraschend landet Hyundai insbesondere im E-Auto-Segment mit mehr als 58 Prozent dahinter. Volkswagen erreicht solide, aber deutlich ausbaufähige 51 Prozent.

Doch es geht nicht nur um Quantität, die Analyse zeigt auch, wo das Bild der Marken ins Wanken gerät. Im Fall von VW sind es vor allem Themen wie Winterreichweite, Ladeinfrastruktur und Schnellladekosten, die negative Ausschläge erzeugen. Diese kritischen Inhalte sind es allerdings, die die Markenwahrnehmung und dementsprechend auch die konkreten Kaufentscheidungen beeinflussen.

Die stille Macht der Quellen: Medien, die prägen

Eine zentrale Erkenntnis der Analyse von publuence.ai ist, dass KI-Systeme nicht auf Basis eines objektiven Querschnitts des Internets antworten. Vielmehr orientieren sie sich an bestimmten Medienquellen, deren Inhalte überproportional stark einfließen und so die Darstellung von Marken maßgeblich mitformen. Umso wichtiger ist es für Marken zu verstehen, auf welche Fragen sie reagieren müssen – und über welche vertrauenswürdigen Medien sie in den Wissensraum der KI gelangen.

Dabei zeigen sich je nach Medium erhebliche Unterschiede in der Tonalität. Während focus.de sowie adac.de E-Mobilität eher wohlwollend behandelt, sind andere Portale kritischer. Für Unternehmen bedeutet das: Wer verstehen will, wie KI über die eigene Marke spricht, muss wissen, welche Inhalte sie beeinflussen.

Warum Marken nicht an KI-Monitoring vorbeikommen

Publuence.ai bietet Unternehmen ein strukturiertes, datenbasiertes Werkzeug, um ihre Sichtbarkeit in KI-Systemen wie ChatGPT, Google oder Perplexity zu analysieren und darauf aufbauend gezielt zu steuern. Die Plattform zeigt, welche Fragen zur Marke führen, wie die Antworten ausfallen, welche Medien zugrunde liegen und wo Wettbewerber besser abschneiden.

Besonders wichtig ist die Identifikation von Content- und Sentiment-Gaps. Sie erkennt Themenfelder, in denen eine Marke kaum oder gar nicht auftaucht, obwohl sie dort relevant sein sollte. Gleichzeitig analysiert sie, ob etwas positiv, negativ oder neutral erwähnt wird. Dies macht publuence.ai für Kommunikations-, Marketing- und Markenverantwortliche zum zentralen Steuerungsinstrument. Nur wer versteht, wie KI antwortet, kann Inhalte gezielt darauf anpassen, Medienarbeit datenbasiert ausrichten und so die eigene Markenpräsenz dort stärken, wo die Entscheidungen heute vorbereitet werden.

KI-Sichtbarkeit wird zur Basis für Markterfolg

Cevahir Ejder, Gründer und GF der publuence GmbH, fasst zusammen: „Kaufentscheidungen beginnen heute und auch in Zukunft im Dialog mit KI-Systemen. Marken, die dort nicht auftauchen, sind raus.“ Volkswagen steht dabei stellvertretend für viele Unternehmen, die ihren Fokus noch auf klassische Marketingkanäle legen und den digitalen Showroom der KI bislang kaum berücksichtigen. Ejder warnt: „Wer jetzt nicht handelt, riskiert, neben Reichweitenverlusten, einen tiefgreifenden Bedeutungsverlust im Moment der Entscheidung.“

Optocycle: Bauschutt-Recycling auf KI-Basis

Die Optocycle-Gründer Max-Frederick Gerken und Lars Wolff Optocycle zeigen, wie aus Bauschutt neuer Rohstoff wird und erhalten dafür eine Förderung der Deutschen Bundesstiftung Umwelt (DBU).

Jährlich fallen in Deutschland laut Umweltbundesamt rund 86 Mio. Tonnen Schutt und Abfälle auf Baustellen an. Häufig landen diese Materialien auf Deponien. So gehen allerdings wertvolle Ressourcen verloren. Der Ausweg: Ein hochqualitatives Recycling des Schutts vermeidet klimaschädliche Emissionen und hält wertvolle Materialien im Wertstoffkreislauf – und das bei zertifiziert gleichwertiger Qualität.

Um das Recycling von Material im Bausektor zu automatisieren, entwickelt das 2022 von Max-Frederick Gerken und Lars Wolff gegründete Start-up Optocycle aus Tübingen ein System auf Grundlage künstlicher Intelligenz (KI) zum Echtzeit-Monitoring.

Echtzeit-Monitoring im Recycling-Prozess