Aktuelle Events

Initiative "KI für Deutschland" startet Aktionsplan

Die Initiative "KI für Deutschland" wurde Ende 2024 von privaten Akteur*innen aus dem KI-Ökosystem ins Leben gerufen, um hierzulande eine zukunftsorientierte Strategie für die KI-Nutzung als Schlüsseltechnologie des 21. Jhs. zu etablieren.

Die Initiative "KI für Deutschland" wurde Ende 2024 von privaten Akteur*innen aus dem KI-Ökosystem ins Leben gerufen. Ziel ist es, einen praxisnahen und unternehmerisch getriebenen Impuls zu setzen, um in dieser Phase der politischen und gesellschaftlichen Neuorientierung Eckpfeiler zu definieren, wie KI zum Wohle und unter Beteiligung aller in Deutschland, effektiv genutzt werden kann.

Zu den Initiator*innen von "KI für Deutschland" gehören maßgeblich die AI.GROUP, der AI.FUND, sowie die Rise of AI Conference - insbesondere die Unternehmer*innen und KI-Expert*innen Dr. Hauke Hansen, Fabian Westerheide, Ragnar Kruse, Petra Vorsteher, Dr. John Lange und Ingo Hoffmann. Unterstützt wird die Initiative von namhaften Institutionen wie dem KI-Bundesverband.

Die Initiative ist deutschlandweit, interdisziplinär und holistisch ausgerichtet. Sie ist offen für den Input und die Unterstützung aller relevanten gesellschaftlichen Gruppen und Persönlichkeiten.

Aufbruchssignal in Zeiten des Umbruchs

Mitinitiator Dr. Hauke Hansen: “Die Initiative KI für Deutschland ist ein Aufbruchssignal in Zeiten des Umbruchs. Mit unseren 11 Impulsen machen wir greifbare und umsetzbare Vorschläge, wie Deutschland die KI nutzen kann, um den gesellschaftlichen Stillstand zu durchbrechen und Wege aus der wirtschaftlichen Rezession zu finden. Wir richten uns damit an alle gesellschaftlichen Akteure, die Wirtschaft ebenso wie die Politik. Wir brauchen eine zukunftsweisende und konsequente Industriepolitik und unternehmerisches Handeln, um die KI am Standort Deutschland zur Chefsache zu machen und damit das Bruttosozialprodukt nachhaltig zu steigern. Stellen wir gemeinsam die Weichen für innovatives und wirtschaftlich erfolgreiches Deutschland von morgen.”

Diese elf Impulse will die Initiative "KI für Deutschland" zur Nutzung künstlicher Intelligenz in Deutschland in Form eines KI-Aktionsplans setzen:

Impuls 1: Einrichtung eines Digitalministeriums auf Bundesebene

Die Digitalisierung in Deutschland hat wirtschaftliche und politische Priorität. Um eine konsequente Digitalisierung der Gesellschaft, Wirtschaft und Verwaltung zu erreichen, ist ein dediziertes Bundesministerium für Digitales mit dem Schwerpunkt KI notwendig.

Impuls 2: Förderung von KI-Forschung und -Innovationen

Deutschland muss die jährlichen Investitionen in KI-Forschung und -Entwicklung bis 2030 auf mindestens 5,0 Mrd. € pro Jahr aufstocken, um international wettbewerbsfähig zu bleiben.

Impuls 3: Bereitstellung von KI-Wagniskapital für KI-Start-ups und -Innovationen

Deutschland benötigt ein KI-Wagniskapitalprogramm ausgestattet mit 10 Mrd. € über 5 Jahre, um KI-Startups zu fördern. Staatliche Fund-of-Funds sollten dazu genutzt werden, Mittel zielgenau und effektiv zu platzieren.

Impuls 4: Aufbau von KI-Clustern zur Förderung von Innovationen und Exzellenz in regionalen Ökosystemen

Deutschland sollte regionale KI-Cluster fördern, die räumliche Nähe mit technischer und wirtschaftlicher Exzellenz verbinden, um Innovationskraft zu maximieren und international Talente anzuziehen.

Impuls 5: Aufbau einer leistungsfähigen und souveränen digitalen Infrastruktur zur Stärkung der KI

Eine flächendeckende digitale Infrastruktur ist essenziell, um KI für Bürger und Unternehmen in der Breite nutzbar zu machen. Wir setzen uns dafür ein, GPU-Megacluster für Forschung und Industrie in Deutschland zu etablieren.

Impuls 6: Förderung der Anwendung von KI in Unternehmen

Bis 2030 sollten mindestens 80% aller deutschen Unternehmen KI-Anwendungen aktiv nutzen, um ihre Geschäfte zu optimieren und auszubauen.

Impuls 7: KI für den öffentlichen Sektor – Effizienzsteigerung und weniger Bürokratie

Bis 2029 sollte der Einsatz von KI in allen wesentlichen Behörden auf Bundes-, Landes- und Regionalebene etabliert werden, um Prozesse zu optimieren, Bürokratie abzubauen und Bürgerdienste zu verbessern.

Impuls 8: KI und Nachhaltigkeit – erschwingliche und saubere Energie für Deutschland

Deutschland sollte KI gezielt einsetzen, um die Energiewende zu unterstützen und die CO2-Emissionen im Energiesektor bis 2035 um mehr als 15% zu senken. Unser Land braucht eine sichere und bezahlbare Energieversorgung als Grundlage für technologiebasiertes Wachstum.

Impuls 9: Eine KI-Bildungsinitiative als Grundlage einer zukunftsfähigen Gesellschaft

Bis 2030 sollten mehr als 80% der Arbeitskräfte in Deutschland grundlegende KI-Kompetenzen besitzen, um den digitalen Wandel aktiv mitzugestalten.

Impuls 10: Ein klarer und sicherer rechtlicher Rahmen für KI und ein KI-Gütesiegel

Deutschland sollte bis 2026 einen flexiblen Rechtsrahmen für KI schaffen, der Innovation fördert, aber Missbrauch verhindert, und ein KI-Gütesiegel zur Förderung ethischer und transparenter KI einführen.

Impuls 11: Schaffung eines europaweiten KI-Ökosystems mit Deutschland als Schrittmacher

Deutschland sollte eine gestaltende Rolle beim Aufbau eines europäischen KI-Ökosystems übernehmen, um eine wettbewerbsfähige Alternative zu den USA und China zu etablieren.

Hier gibt’s mehr Infos zur Initiative "KI für Deutschland"

Diese Artikel könnten Sie auch interessieren:

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

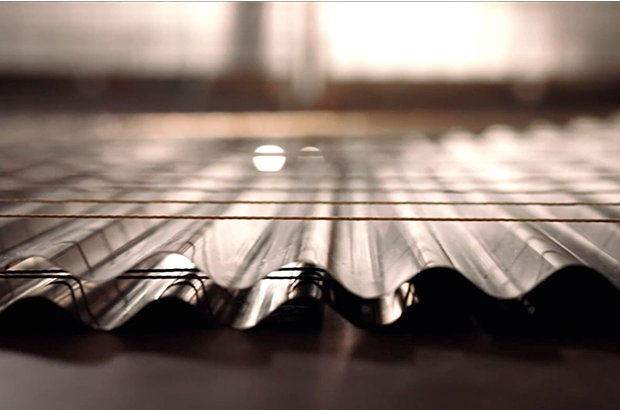

Better Sol: Zweites Leben für die Solarwende

Wie das 2023 von Mirko Laube und Luisa Schulze gegründete Start-up Better Sol den PV-Gebrauchtmarkt aufmischen will.

Das Braunschweiger Start-up Better Sol erhält rund 125.000 Euro Förderung aus dem „Green Startup“-Programm der Deutschen Bundesstiftung Umwelt (DBU), um gebrauchte Solarpaneele in großem Stil zurück in den Markt zu bringen.

Hinter dem Start-up stehen Luisa Schulze und Mirko Laube. Better Sol entstand ursprünglich im Sommer 2022 als Ausgründung des Magdeburger Recycling-Unternehmens Solar Materials und agiert seit 2023 als eigenständige GmbH am Standort Braunschweig. Während sich die ehemalige Muttergesellschaft auf das komplexe werkstoffliche Recycling von Modulen konzentriert, widmet sich Better Sol voll und ganz dem „Second Life“ – also der direkten Wiederverwendung der noch intakten Platten.

KI-gestützte Prüfung statt Schredder

Die Beschaffungsseite von Better Sol zielt primär auf große Solarparks ab. Die Betreiber tauschen dort häufig größere Mengen an Solarmodulen recht früh in ihrem Lebenszyklus durch neuere, leistungsstärkere Modelle aus. Um diese Module vor dem Müll zu bewahren, hat das Better-Sol-Team mittels DBU-Förderung ein in Teilen automatisiertes Testsystem mit eigener Software auf Basis künstlicher Intelligenz (KI) entwickelt.

Der Prüfprozess beginnt mit einer mehrstufigen optischen Untersuchung, bei der sowohl grobe Beschädigungen als auch jede Solarzelle einzeln begutachtet werden. Im Anschluss folgen eine eingehende Prüfung der elektrischen Sicherheit sowie eine Leistungsüberprüfung, die misst, wie viel Watt das Produkt im Vergleich zur ursprünglichen Leistung noch liefert. Die Software führt all diese Daten automatisiert zu einer detaillierten Leistungsprognose zusammen. Jedes funktionstüchtige Modul erhält ein Label mit den Testdaten, einer zugewiesenen Leistungsklasse und einem umfangreichen Prüfprotokoll. Nur der endgültige Rest wird zum Recycling aussortiert. Der Vertrieb erfolgt direkt über die Internetseite von Better Sol. Zielgruppe sind oft Privathaushalte oder die Dächer größerer Fabrikhallen.

Der Markt und die Technologie im Wettbewerbsvergleich

Nach Angaben des Statistischen Bundesamtes verbucht die Photovoltaik mittlerweile einen Anteil von etwa 24 Prozent und ist damit der zweitwichtigste Energieträger der inländischen Stromerzeugung. Das Reservoir an ausgemusterten, aber noch funktionierenden Modulen wächst rasant. Laut Schulze ist im Schnitt jedes zweite gebrauchte Solarmodul noch für eine erneute Nutzung geeignet. Doch der Gebrauchtmarkt professionalisiert sich zusehends.

Better Sol setzt aktuell auf eine pragmatische, KI-gestützte Teilautomatisierung und plant als nächsten logischen Entwicklungsschritt eine mobile Testanlage, um die Solarmodule direkt dort zu testen, wo sie ausgemustert werden. Genau in diesem logistisch entscheidenden Bereich der Vor-Ort-Prüfung operiert bereits der etablierte Wettbewerber 2ndlifesolar, eine Marke der großen Buhck Gruppe. 2ndlifesolar greift auf ein deutschlandweites Logistiknetzwerk zurück und kombiniert stationäre Erstbehandlungsanlagen mit mobilen Prüflaboren. Technologisch geht das Unternehmen tief in die industrielle Qualitätssicherung und führt standardmäßig Elektrolumineszenz-Prüfungen durch, um unsichtbare Mikrorisse im Vorfeld zu detektieren.

Einen völlig anderen, stark hochskalierten Weg bestreitet das österreichische CleanTech-Start-up 2nd Cycle. Das Unternehmen betreibt eine vollautomatische Inspektions- und Upcycling-Anlage im industriellen Hochdurchsatz und nutzt neben klassischer Robotik auch patentierte hyperspektrale Analysen aus der Raumfahrt, um Zellalterungen frühzeitig zu erkennen.

Der Schlüssel zum wirtschaftlichen Erfolg

Das Vorhaben von Better Sol leistet einen fundamentalen Beitrag, um noch leistungsfähige Materialien durch geschickte Kreislaufwirtschaft für eine Weiternutzung zu erhalten, damit die Bemühungen für mehr erneuerbare Energien nicht ins Stocken geraten. Dennoch muss sich das Geschäftsmodell in einem harten Wettbewerb beweisen.

Die Handwerkerkosten für den Aufbau einer PV-Anlage auf einem Eigenheim sind hoch und fallen völlig unabhängig davon an, ob man neue oder gebrauchte Paneele installiert. Gleichzeitig steht der Markt unter enormem Preisdruck durch historisch günstige asiatische Neuware. Wenn fabrikneue Module extrem billiger werden, schwindet das Argument der finanziellen Ersparnis bei Gebrauchtmodulen mit kürzerer Restlebensdauer. Der Schlüssel zum wirtschaftlichen Erfolg von Better Sol liegt daher in der rigorosen Minimierung der eigenen Logistik- und Prozesskosten. Die geplante mobile Testanlage und die zusätzliche Automatisierung des Testsystems sind für das Start-up essenziell, um künftig auch größere Ausmusterungen von Solarparks wirtschaftlich bewältigen zu können.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

eeden: Die Alchemie der Altkleider

Das Münsteraner Unternehmen eeden verwandelt Textilmüll in hochwertige Rohstoffe. Mit Millioneninvestments baut das Team um Steffen Gerlach und Tobias Börnhorst nun die erste Demonstrationsanlage auf.

Steffen Gerlach saß entspannt mit seinem Schulfreund Reiner Mantsch auf einer Couch in einer Kölner Wohngemeinschaft. Mantsch hatte zuvor an der Universität in Mönchengladbach Textiltechnik studiert. Er berichtete leidenschaftlich von seinen naturwissenschaftlichen Forschungen zur Kreislaufwirtschaft. Dieses Gespräch veränderte Gerlachs gesamte berufliche Planung radikal. Mantsch suchte jemanden für die Marktseite seiner technischen Vision. Gerlach war sofort fasziniert von dem ökonomischen Potenzial. Er wollte wissen, ob man daraus ein echtes Unternehmen formen kann. „Das war der eigentliche Startpunkt für eeden. Wir entschieden uns für einen vollen Fokus auf das Projekt. Und wir wollten das Recyclingproblem der Branche grundlegend lösen“, erinnert sich Gerlach.

Der langsame Weg zum technologischen Durchbruch

Es gab keinen plötzlichen Heureka-Moment in einem winzigen und improvisierten Labor. Die Entwicklung war eher eine gezielte Suche nach einer Problemlösung. Mantsch war früher Leistungssportler und brachte den nötigen Fokus mit. Er sah den Frust seiner Kommilitonen nach Praktika in der Industrie. Die Branche wirkte starr und wenig dynamisch für junge Talente. Das Duo suchte stattdessen nach den Megatrends der Zukunft. „Die Kreislaufwirtschaft kristallisierte sich schnell als das zentrale Thema heraus. Ich habe die Marktseite intensiv analysiert und viele Gespräche geführt“, so Gerlach. Er erkannte die Verknüpfungen zwischen technischer Machbarkeit und ökonomischen Anforderungen. Die Suche nach dem technologischen Sweetspot dauerte Monate. Am Anfang stand lediglich die reine Faszination für das Recycling. Es war ein schleichender Prozess mit vielen Etappenentscheidungen.

Die wachsende Last der globalen Fast Fashion

Das Umweltproblem der globalen Textilindustrie ist mittlerweile gewaltig. Die Branche verdoppelt ihren Durchsatz alle 20 bis 30 Jahre. Jährlich werden mittlerweile mehr als 120 Mio. Tonnen Textilien produziert. Nach Angaben der Ellen MacArthur Foundation werden weltweit ungefähr zwei Drittel dieser Mengen praktisch direkt nach der Nutzung entsorgt; sie landen auf riesigen Deponien oder werden ungenutzt verbrannt. In Deutschland steht das klassische Rücknahmesystem laut Experten vor dem Kollaps. Es gibt nach seiner Aussage derzeit eine gestiegene Anzahl an Insolvenzen bei Sammel- und Sortierbetrieben. Die Qualität der Kleidung sinkt durch den Trend zur Fast Fashion massiv. Der Wiederverkauf der gebrauchten Ware lohnt sich oft nicht mehr. Neuware aus Asien ist meistens günstiger als Second Hand-Stücke aus Europa. In Deutschland verursacht die Entsorgung einer Tonne Altkleider zudem Kosten – das Material wird somit zur finanziellen Belastung für die Sammel- und Sortierbetriebe.

Chemische Trennung als industrieller Schlüssel

Das Unternehmen aus Münster setzt genau an diesem Punkt an. Die Technologie ermöglicht die Trennung von Baumwolle und Polyester und macht beide Materialien wieder nutzbar. Das ist entscheidend für den Erfolg der Kreislaufwirtschaft. Die meisten Textilien bestehen heute aus komplexen Mischgeweben. Gerlach erklärt, dass das Unternehmen aus dem Abfall eine hochwertige Cellulose und chemische Bausteine für neues Polyester gewinnt. Die Cellulose dient als sauberes Vorprodukt für die neue Faserherstellung. Das Polyester wird in seine Grundbausteine zerlegt, die für die Herstellung von neuem Polyester verwendet werden können. „Wir stellen aus Baumwolle eine hochwertige Cellulose her und gewinnen aus dem Polyester die chemischen Bausteine zurück“, sagt Gerlach. Beide Materialströme können direkt wieder in der Textilproduktion eingesetzt werden. Damit wird der Kreislauf zwischen Abfall und Kleidung geschlossen. Seit Anfang 2025 hilft zudem eine neue gesetzliche Regelung. Die EU-weite Getrenntsammlungspflicht für Textilabfälle ist in Kraft getreten: Unternehmen dürfen Textilien nun nicht mehr über den Restmüll entsorgen. Das sichert den Zugang zu großen Mengen an Rohstoffen.

Harte Verhandlungen in der Welt des Wagniskapitals

Der Weg von der ersten Idee zur fertig gebauten Industrieanlage ist lang. Deeptech-Unternehmen brauchen oft viel Geduld und Zeit für die Entwicklung. Das erfordert Investoren mit einem sehr langen Atem. In einer frühen Phase kam der High-Tech Gründerfonds an Bord. Auch die NRW.Bank und der TechVision Fonds unterstützen das Vorhaben. Später stiegen Forbion und der Chemiekonzern Henkel als Investor ein. Gerlach erinnert sich im Gespräch an einen intensiven Lernprozess bei den ersten Finanzierungsrunden. Man müsse technische Begeisterung mit harten Umsatzprognosen anreichern. Auch D11Z.Ventures, das Family Office von Dieter Schwarz (Lidl/Kaufland), investierte in das Unternehmen. Die Investoren verstehen laut Gerlach die Entwicklungszyklen und Skalierung von Deeptech-Unternehmen. Mittlerweile flossen über 20 Mio. EUR an Kapital in die Firma. Dieses Geld ermöglicht nun den nächsten großen Schritt.

Ein neues Team für die industrielle Skalierung

Das Start-up ist mittlerweile den Kinderschuhen entwachsen. In Münster entsteht derzeit eine industrielle Demonstrationsanlage. Gerlach erinnert sich an den Moment der Schlüsselübergabe: Zuerst wirkte die leere Halle riesig auf das Team. Inzwischen planen die Ingenieure bereits jeden Zentimeter der Fläche. Das Team ist auf über 25 Köpfe gewachsen. Es ist eine Mischung aus jungen Talenten und erfahrenen Kräften. Viele Mitarbeitende wechselten von großen Konzernen wie BASF nach Münster. Gerlach beobachtet eine große Lust auf die Arbeit an innovativen Prozessen. Die flachen Hierarchien im Unternehmen ziehen Experten an. Er schätzt das Know-how dieser Fachkräfte für den Anlagenbau. Erfahrene Chemiker bringen eine neue Qualität in die Prozesse. Die Zusammenarbeit zwischen Alt und Jung funktioniert hervorragend.

Führung zwischen Agilität und unternehmerischer Verantwortung

Die Unternehmenskultur hat sich mit der Größe weiterentwickelt. Gerlach betont, dass viele Impulse direkt aus der Belegschaft kommen. So wurde die Regelung für die Präsenz im Büro gemeinsam erarbeitet. Die Mitarbeitenden wünschten sich feste Tage für den Austausch. „Die schönsten Tage sind jene mit viel Begegnung“, berichtet Gerlach. Die bürokratischen Pflichten eines Geschäftsführers gehören einfach dazu. Trotzdem bleibt die Mission der Firma der wichtigste Treiber. Die Motivation im gesamten Team sei extrem hoch. Jeder packt an und treibt das Unternehmen voran. Der Spagat zwischen Entwicklung und Business ist fordernd. Gerlach jedoch genießt diese tägliche Herausforderung sehr.

Der Standort Deutschland als Zentrum für Innovation

Viele Fachleute kritisieren die Bedingungen für die Chemieindustrie. Hohe Energiekosten belasten die traditionsreichen Unternehmen stark. Gerlach sieht das differenzierter aus der Perspektive von innovativen Start-ups: „Für die Entwicklung neuer Technologien ist der Standort Deutschland weiter exzellent. Und die Qualifikation der Technologen ist hervorragend. Die aktuelle Krise führt bei uns auch zu Bewerbungen von erfahrenen Talenten aus der chemischen Industrie – die hätte es vor einigen Jahren in der Menge nicht gegeben.“ Die vorhandene Infrastruktur sei ein klarer Vorteil. Auch Konzerne beobachten solche Innovationen genau. Die Nähe zum Mittelstand fördert zudem die Skalierung. Für die beiden Gründer ist die aktuelle Produktionsanlage nur ein Anfang. Langfristig soll die Technologie weltweit lizenziert werden; überall auf der Welt fällt schließlich Textilmüll an. Die Kombination aus Ingenieurskunst und Skalierung ist das Ziel. Auch die aktuellen Investoren von eeden sehen dieses globale Potenzial. Das Unternehmen will beweisen, dass sich Kreislaufwirtschaft lohnt. Deutschland bleibt dafür ein wichtiger Ankerpunkt.

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Agentic AI als Erfolgsgrundlage für Start-ups

KI befeuert den aktuellen Gründungsboom, doch für eine erfolgreiche Skalierung braucht es mehr. Warum Agentic AI auf Basis einer soliden Datenarchitektur zum entscheidenden Erfolgsfaktor für Start-ups wird.

Das Jahr startete für Start-ups mit einer Rekordmeldung: In Deutschland wurden im vergangenen Jahr fast ein Drittel mehr Gründungen verzeichnet. In absoluten Zahlen wurden 2025 insgesamt 3.568 neue Firmen geschaffen – ein neuer Höchststand, wie der Start-up-Verband im Januar verkündete. Dies ist auch der künstlichen Intelligenz (KI) zu verdanken, wie sich beim genauen Hinschauen herausstellt. 853 dieser neuen Unternehmen kommen aus dem Bereich Software. Doch nicht nur sie verwenden KI; bei einer Umfrage gab ein Drittel aller Gründer und Gründerinnen an, dass sie mit KI arbeiten. Dementsprechend sehen die Sprecher des Verbands in der Technologie auch die treibende Kraft hinter dem Start-up-Rekord.

Wirft man einen Blick über den Tellerrand hinaus, so lässt sich feststellen, dass die Start-up-Szene in Europa insgesamt floriert. Der „State of European Tech 2025“-Report im Auftrag von Atomico und anderen schätzt, dass im letzten Jahr Investitionen in Höhe von 44 Milliarden US-Dollar (umgerechnet ca. 38 Mrd. EUR) in diesen Sektor geflossen sind. Geldgeber erwarten inzwischen, dass Start-ups mit KI und Deep Tech arbeiten, so der Report. Demnach flossen auch 36 Prozent der europäischen Start-up-Investitionen in genau diese beiden Felder.

Das Gründungsumfeld könnte also kaum besser sein. Doch ein Rekord an Start-ups und steigende Investitionssummen bedeuten nicht zwangsläufig auch eine einfache Skalierung der Geschäftsmodelle. Viele – zu viele – Start-ups scheitern nach erfolgreichen ersten Jahren an der Weiterentwicklung ihres Geschäfts. Neben einer Reihe üblicher Herausforderungen stehen vor allem Bürokratie, Fragen zur Datenhoheit und ein Betrieb über Landesgrenzen und Wirtschaftszonen hinweg im Vordergrund. Start-ups müssen nachweisen, dass ihre Nutzung von KI auf soliden, regulierten Datenfundamenten basiert und den Compliance-Vorgaben entspricht.

Hier kommt Agentic AI ins Spiel. Die Einbettung von KI-Agenten in den Kern der Betriebsabläufe ist die Antwort auf viele dieser Herausforderungen und wird für das Wachstum im Jahr 2026 von entscheidender Bedeutung sein.

Solide Datenbasis vor KI-Einsatz

Start-ups, die dies erreichen wollen, sollten sich darauf konzentrieren, ihre KI-Nutzung auf einer soliden Datenbasis aufzubauen, deren Fundament eine einheitliche Datenarchitektur ist. Sie tun sich deutlich leichter damit, die dafür nötigen Architekturentscheidungen zu treffen, als etablierte Unternehmen mit entsprechender Legacy-IT. Gründer und Gründerinnen sollten daher von Beginn an darüber nachdenken, wie sie eine starke Datenarchitektur aufsetzen, Silos abbauen und KI als Herzstück ihrer Prozesse einbetten.

Diese Grundlage hilft bei der Einführung von KI-Agenten, damit deren Output auch die Erwartungen erfüllt: Geschäftsprozesse effizienter zu strukturieren und zu optimieren sowie die Entscheidungsfindung zu beschleunigen. Start-ups, die dies umsetzen, werden sich gegen ihre Konkurrenten durchsetzen und letztlich erfolgreich sein.

KI-Agenten als Innovationsbeschleuniger

Indem Start-ups KI-Agenten von Beginn an in den Kern ihrer Geschäftsabläufe integrieren, skalieren sie schneller als mit dem Einsatz von nur einem reinen Large Language Model (LLM). Der Grund dafür liegt in der Standardisierung der Daten, die für KI-Agenten notwendig ist. Auf dieser Grundlage können die Agenten ihre einzigartigen, autonomen Fähigkeiten ausspielen, da sie mit unternehmenseigenen Daten trainiert werden. Vor allem bei Start-ups können Potenziale schnell gehoben werden: Wenn Agenten für bestimmte Aufgaben entwickelt werden, können sie diese auch lösen – egal wie komplex und fachspezifisch sie sein mögen. Stimmt die Datenbasis, lassen sich auch mehrere Agenten miteinander verknüpfen, um sogar noch komplexere Herausforderungen zu bewältigen.

Ein Beispiel dafür ist die mögliche Kooperation zwischen einem Kundensupport-Agenten und einem Prognose-Agenten. Wenn ein Kunde einen Support-Fall auslöst, kann der andere Agent sogleich die Kosten berechnen, was die Kundenzufriedenheit durch eine schnellere Reaktion steigern kann. Für die Skalierung von Start-ups ist ein enges Zusammenspiel der Abteilungen wichtig, um die Geschäftsbeziehungen zu zufriedenen Kunden weiter ausbauen zu können. Der Einsatz von KI-Agenten kann, gepaart mit dem menschlichen Element, begrenzte personelle Ressourcen ausgleichen und eine bessere Serviceleistung ermöglichen, was für ein schnelles Wachstum unabdingbar ist.

Doch nicht nur der Kundenkontakt lässt sich automatisieren, sondern auch eine ganze Reihe von Routinevorgängen in der internen Verwaltung der Firmen selbst. Dies ermöglicht nicht nur dem Management, sondern auch den Investoren, schnell einen fundierten Überblick über Liquidität, Umsatz, Einnahmen und Gewinn zu erhalten. Die Erkenntnisse in Echtzeit führen zu schnellen und datenbasierten Entscheidungen, was für junge Unternehmen Gold wert ist und es ihnen ermöglicht, flexibel zu bleiben.

Die Datenbasis muss stimmen

Für Start-ups sind Probleme beim Datenzugriff ein kritisches Risiko für den Geschäftserfolg. Eine einheitliche, moderne Datenarchitektur ermöglicht die Demokratisierung des Datenzugriffs und löst Datensilos auf. Der Vorteil liegt auf der Hand: Schneller Datenzugriff schafft Transparenz gegenüber Kunden und Aufsichtsbehörden. Darüber hinaus erhöht dies auch das Vertrauen der Mitarbeitenden und schafft ein Gefühl des Zusammenhalts.

Governance ist auch bei der Verwendung von KI-Agenten von entscheidender Bedeutung. Der Druck zur Einhaltung von Vorschriften sollte daher als Vorteil betrachtet werden.

Der Dreiklang aus Datenherkunft, Versionierung und automatisierter Auswertung der Ergebnisse hilft jungen Unternehmen dabei, Governance auf einem soliden Fundament aufzubauen. Die Teams erhalten direkte Transparenz darüber, wie sich die KI-Agenten verhalten, auf welchen Daten sie basieren und wie sie ihre Ergebnisse im Laufe der Zeit verändern. Laufende Bewertungen tragen dazu bei, dass KI-Agenten präziser werden, um genau jene hochwertigen Ergebnisse zu liefern, die Start-ups für die Skalierung ihrer Geschäftsmodelle benötigen. Dies ist besonders wichtig, wenn proprietäre KI-Modelle entwickelt und von der Testphase in die Produktion überführt werden, wobei gesetzliche Vorschriften wie die DSGVO oder der EU AI Act zwingend einzuhalten sind.

Parloa, ein deutsches Start-up-Unternehmen mit einer Bewertung von drei Milliarden US-Dollar, ist ein hervorragendes Beispiel dafür, wie dieser Ansatz in der Praxis aussehen kann: Das Unternehmen hat KI-Agenten zum Kern seines Kundenservice gemacht und gleichzeitig eine einheitliche, kontrollierte Datenbasis aufgebaut, die vollständig mit der DSGVO und dem EU AI Act konform ist. Seine Plattform folgt den Prinzipien des „Privacy by Design“, sodass sensible Kundendaten ohne Kontrollverlust verwendet werden können. Durch die Verwaltung des gesamten Lebenszyklus von KI-Agenten macht Parloa Governance zu etwas Greifbarem und gibt den Teams Klarheit darüber, welche Daten verwendet wurden, wie sich die Agenten verhalten haben und wie sich die Ergebnisse im Laufe der Zeit entwickelt haben. Diese Kombination aus moderner Architektur und starker Governance ermöglicht es den Kunden von Parloa, Zugang zu hochwertigen Daten zu erhalten und die Transparenz für Regulierungsbehörden sowie Endnutzer zu erhöhen – und dennoch KI-gesteuerte Kundeninteraktionen in Umgebungen zu skalieren, in denen Fehler oder Missbrauch inakzeptabel sind.

Fazit

KI-Agenten bieten europäischen Start-ups eine einmalige Gelegenheit, schnell zu wachsen und gleichzeitig Investoren anzuziehen, die bekanntermaßen ihr Geld bevorzugt in Unternehmen investieren, die Wert auf Datenverwaltung, Genauigkeit, Qualität und die Schaffung von echtem Mehrwert durch Technologie legen. Es ist jedoch ein Fehler, sich ohne sorgfältige Überlegungen auf die Einführung von Agenten zu stürzen. Start-ups, die KI-Agenten einsetzen, ohne zuvor eine einheitliche Datenbasis aufzubauen und eine solide Verwaltung sowie Bewertung sicherzustellen, riskieren, mehr Komplexität als Mehrwert zu schaffen. Letztlich werden jene Gründer und Gründerinnen erfolgreich sein, die ihre Geschäftsmodelle branchen- und länderübergreifend skalieren können – hierbei spielt der Einsatz von KI-Agenten bereits jetzt eine entscheidende Rolle.

Der Autor Nico Gaviola ist VP Digital Natives & Emerging Enterprise bei Databricks EMEA.

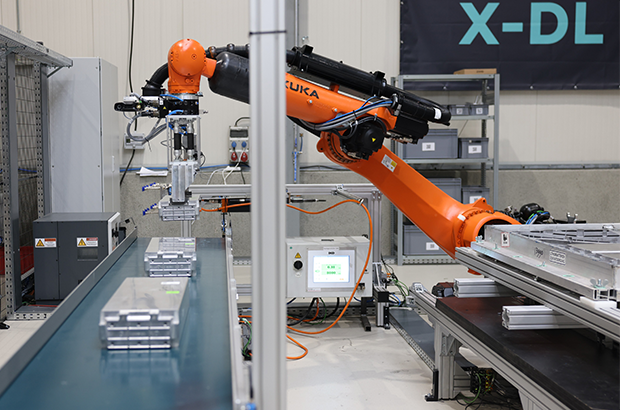

ChatGPT schreibt Texte. R3 Robotics zerlegt Batterien

Es gibt Probleme, die man mit Software lösen kann, und es gibt Probleme, für die man sich die Hände schmutzig machen muss – oder besser: Roboterhände nutzt. Antoine Welter und Dr. Xavier Kohll haben mit Circu Li-ion begonnen, um Batterien zu retten. Jetzt, unter dem neuen Namen R3 Robotics und mit 20 Millionen Euro frischem Kapital im Rücken, treten sie an, um den wohl größten Flaschenhals der kommenden Mobilitätswende zu beseitigen. Ihr Ansatz: Keine teuren Spezialmaschinen, sondern intelligente Standard-Roboter, die sehen, verstehen und sicher zupacken.

Wenn in den Vorstandsetagen der Automobilhersteller über die Zukunft gesprochen wird, geht es meist um Reichweiten und Software-Defined Vehicles. Doch am anderen Ende der Wertschöpfungskette braut sich ein Sturm zusammen. Millionen von Elektrofahrzeugen werden in den kommenden Jahren ihr Lebensende erreichen. Die derzeitige Realität in vielen Recyclinghöfen wirkt dagegen fast archaisch: Menschen, die mit Handwerkzeugen komplexe Systeme auseinanderschrauben. Das ist nicht nur teuer und schwer skalierbar, sondern bei Hochvolt-Systemen auch lebensgefährlich.

Genau hier setzen Antoine Welter und Xavier Kohll an. Die Nachricht, die das deutsch-luxemburgische Unternehmen Anfang Februar 2026 verkündete, ist mehr als nur eine Finanzierungsrunde. Die 20 Millionen Euro – aufgeteilt in 14 Millionen Euro Series-A-Kapital und 6 Millionen Euro öffentliche Fördergelder – heben die Gesamtfinanzierung des Unternehmens auf ein neues Level. Angeführt wird die Runde von HG Ventures und Suma Capital, unterstützt von Co-Investoren wie der Oetker Collection und dem EIC Fund.

Doch das Geld ist nur der Treibstoff für eine strategische Evolution. Aus Circu Li-ion wird R3 Robotics. Der neue Name ist Programm: Repair, Reuse, Recycle. Antoine Welter erklärt die Motivation hinter der Umbenennung pragmatisch: „Circu Li-ion hat beschrieben, wo wir angefangen haben. R3 Robotics beschreibt, was wir aufbauen: industrielle Robotik, die Demontage skalierbar, sicher und kosteneffizient macht.“

Wenn der Roboter Augen bekommt

Die größte Hürde im Recycling ist nicht die Chemie, sondern die Variabilität. Kein Batteriepack gleicht dem anderen, E-Motoren sind unterschiedlich verbaut, Schrauben sind korrodiert. Starre Fertigungsstraßen scheitern hier. R3 Robotics löst dies mit einer Plattform, die Computer Vision, künstliche Intelligenz und Robotik verschmilzt.

Das System fungiert dabei fast wie ein „ChatGPT für die physische Welt“: Anstatt Text zu generieren, plant die KI physische Handlungen. Sensoren scannen das Bauteil, die KI erkennt den Zustand und promptet den Roboterarm dynamisch durch den Demontageprozess. Der entscheidende Vorteil: Der Mensch wird aus der Gefahrenzone der Hochspannung genommen, während der Roboter Aufgaben erledigt, die für klassische Automatisierung zu komplex wären.

Angesprochen auf den Vergleich mit Generative AI und die Frage, wie die Roboter tatsächlich „sehen“ und „entscheiden“, bestätigt Welter die Parallele: „Der Vergleich mit Generative AI passt gut: Das Modell bekommt einen Input – keinen Text, sondern einen Scan des Bauteils – und generiert daraus eine Handlungssequenz.“ Es gehe darum zu erkennen, um welches Modell es sich handelt, wie der Zustand ist und wo die Verbindungspunkte liegen. „Das klingt simpel, ist es aber nicht – kein Pack ist identisch“, so Welter. Die eigentliche Herausforderung liege jedoch in der Entscheidung davor: „Welche Reihenfolge ist sicher? Ein falscher Griff an ein Hochvoltsystem kann tödlich sein. Unser System sieht, bewertet und entscheidet.“

Smart Hardware: Warum das Rad neu erfinden?

Ein Detail, das Investor*innen besonders aufhorchen lässt, ist die Kapitaleffizienz der Gründer. Wer an Industrie-Robotik denkt, denkt an teure Hardware-Entwicklung. R3 Robotics geht einen pragmatischen Weg: Ein Großteil der verwendeten Hardware wird „von der Stange“ gekauft.

Die Roboterarme sind Standardprodukte. Die Innovation – und damit das geistige Eigentum – steckt in den spezialisierten „End-Effektoren“ (den Roboterhänden), den Sensorsystemen und vor allem dem Software-Stack, der alles steuert. Das erlaubt eine Skalierung, die mit proprietärer Hardware kaum möglich wäre. Mitgründer Dr. Xavier Kohll betont, dass dies eine bewusste Entscheidung gegen „Over-Engineering“ war: „Der Roboterarm ist Standard und die Intelligenz sitzt in den Endeffektoren, der Sensorik und dem Software-Stack, der alles zusammenbringt. Das ist unser geistiges Eigentum, und genau das lässt sich skalieren.“

David gegen Goliath – oder Partner?

Während große Recycling-Konzerne oft noch auf den Schredder setzen und die manuelle Demontage an ihre Grenzen stößt, positioniert sich R3 Robotics in einer neuen Nische. Es geht nicht darum, die Chemie-Giganten zu ersetzen, sondern ihnen den Rohstoff so rein wie möglich zu liefern – als strategische Quelle für kritische Materialien. Doch der Markt schläft nicht: Weltweit entstehen Initiativen zur Automatisierung.

Trotz des aktuellen „Gegners“ – dem Menschen mit dem Schraubenzieher – und potenzieller Konkurrenz durch Tech-Start-ups oder Autohersteller, bleibt Welter gelassen. „Wir konkurrieren nicht mit den Chemie-Giganten, wir liefern ihnen den reinsten möglichen Stoffstrom“, stellt er klar. Gegenüber potenziellen Nachahmern sieht er einen entscheidenden Vorteil, den „Unfair Advantage“: die Kombination aus Flexibilität und industrieller Automatisierungstiefe. „Wir sind aktuell die einzige Plattform, die sowohl Variabilität managt als auch für kontinuierlichen Industriebetrieb ausgelegt ist.“

Deutschland als Labor, USA als Skalierungsmarkt

Die Wachstumsstrategie von R3 Robotics ruht auf zwei massiven Säulen: technologischer Tiefe in Europa und kommerzieller Breite in den USA.

Deutschland fungiert dabei als das technologische Rückgrat. Mit der Erweiterung der Anlage in Karlsruhe zur Lighthouse Facility demonstriert das Unternehmen industrielle Leistungsfähigkeit direkt vor der Haustür der großen Autobauer. Hier wird die Technologie gehärtet. Das zeigt sich auch im Leuchtturmprojekt ReDriveS, wo R3 Robotics Seite an Seite mit Giganten wie Schaeffler und VW an der Demontage von E-Achsen arbeitet.

Doch für das massive Volumen blickt das Team über den Atlantik. Der für 2026 geplante Markteintritt in den USA ist Kern der neuen Strategie. Die frischen 20 Millionen Euro sollen gezielt in den Aufbau strategischer Partnerschaften vor Ort fließen, um die Technologie dort auszurollen, wo Pragmatismus auf riesige „End-of-Life“-Volumina trifft. Für Welter ist dieser Doppelschlag essenziell: „Deutschland ist unser Beweisstand. Hier zeigen wir Schaeffler, VW und Co., dass unsere Technologie industriellen Maßstäben in Deutschland standhält.“ Die USA seien hingegen der wichtige Skalierungsmarkt, wo pragmatische Entscheider auf gigantische Volumina treffen. „Beides brauchen wir: die Glaubwürdigkeit aus Europa und das Volumen aus Amerika.“

Industrialisierung statt Romantik

Mit Peter Mohnen, dem ehemaligen CEO des Roboter-Riesen KUKA, holte sich das Start-up zudem einen Beirat, der wie kaum ein anderer weiß, was Industriestandard bedeutet. Er beschreibt den Ansatz von R3 als Beweis für die nötige Automatisierungsexpertise, um Variabilität und Sicherheit gleichzeitig zu managen.

Um diese Expertise weiter auszubauen, wächst das Team rasant. Die Belegschaft soll mit der neuen Finanzierung massiv aufgestockt werden, vor allem im Bereich Engineering und KI. R3 Robotics hat den Beweis erbracht, dass Kreislaufwirtschaft kein ökologisches Nischenprojekt sein muss, sondern ein harter industrieller Prozess ist, der sich rechnet.

Denn letztlich, so das Fazit von Antoine Welter, sei Automatisierung der einzige Weg, das Problem wirklich zu lösen – nicht allein aus ökologischen Gründen, sondern weil es wirtschaftlich Sinn ergibt. „Was wir aufbauen, ist am Ende ein harter industrieller Prozess: Er muss zuverlässig funktionieren und sich rechnen.“ Es gehe aber um mehr als ein Geschäftsmodell: „Europa braucht eine Antwort auf die Frage, woher seine kritischen Materialien in Zukunft kommen“, mahnt Welter abschließend. „Wenn Europa diesen Zugang sichern will, braucht es Unternehmen, die genau das industriell umsetzen können. Dafür bauen wir diese Infrastruktur, und mit dem neuen Kapital und Team haben wir jetzt die Mittel dazu.“

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

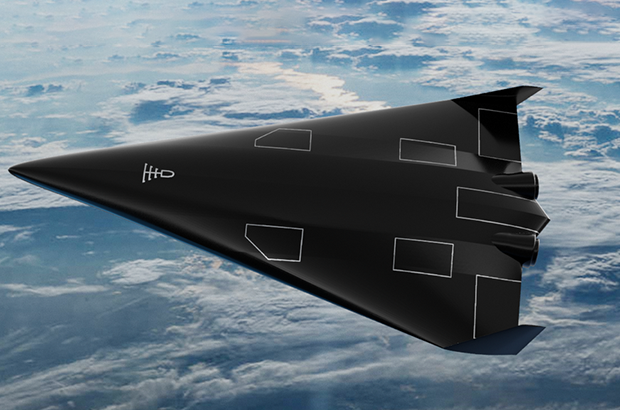

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

Die Wächter des Firmengedächtnisses

Wie das 2025 von Christian Kirsch und Stefan Kirsch gegründete Start-up amaiko den Strukturwandel im Mittelstand adressiert.

Der demografische Wandel und eine erhöhte Personalfluktuation stellen mittelständische Unternehmen zunehmend vor die Herausforderung, internes Know-how zu bewahren. Viele Unternehmen stehen vor der Schwierigkeit, dass Firmenwissen fragmentiert vorliegt. Informationen sind häufig in unterschiedlichen Systemen oder ausschließlich in den Köpfen der Mitarbeitenden gespeichert. Verlassen langjährige Fachkräfte den Betrieb in den Ruhestand oder wechseln jüngere Arbeitnehmerinnen und Arbeitnehmer kurzfristig die Stelle, gehen diese Informationen oft verloren. Zudem bindet die Suche nach relevanten Dokumenten in verwaisten Ordnerstrukturen Arbeitszeit, die in operativen Prozessen fehlt.

Das 2025 gegründete Start-up amaiko aus Niederbayern setzt hierbei auf einen technischen Ansatz, der auf die Einführung neuer Plattformen verzichtet und stattdessen eine KI-Lösung direkt in die bestehende Infrastruktur von Microsoft Teams integriert. Vor diesem Hintergrund entwickelten die Brüder Christian und Stefan Kirsch mit amaiko eine Softwarelösung, die spezifisch auf die Ressourcenstruktur mittelständischer Betriebe ausgelegt ist.

Integration statt neuer Insellösungen – und die Abgrenzung zu Copilot

Ein wesentliches Merkmal des Ansatzes ist die Entscheidung gegen eine separate Software-Plattform. Christian Kirsch, Geschäftsführer von PASSION4IT und amaiko, positioniert die Lösung als „Teams-native“. Das bedeutet, dass der KI-Assistent technisch in Microsoft Teams eingebettet wird – jene Umgebung, die in vielen Büros bereits als primäres Kommunikationswerkzeug dient. Ziel ist es, die Hürden bei der Implementierung zu senken, da Nutzer ihre gewohnte Arbeitsumgebung nicht verlassen müssen.

Angesichts der Tatsache, dass Microsoft mit dem „Microsoft 365 Copilot“ derzeit eine eigene, tief integrierte KI-Lösung ausrollt, stellt sich die Frage nach der Positionierung. Christian Kirsch sieht hier jedoch keine direkte Konkurrenzsituation, sondern eine klare Differenzierung: Copilot sei eine sehr breite, Microsoft-zentrische KI-Funktion. Amaiko hingegen verstehe sich als spezialisierter, mittelstandsorientierter Wissensassistent, der Beziehungen, Rollen, Prozesse und Unternehmenslogik tiefgreifend abbildet.

Ein entscheidender Vorteil liegt laut Kirsch zudem in der Offenheit des Systems: „Während Copilot naturgemäß an Microsoft‑Systeme gebunden ist, lässt sich amaiko herstellerunabhängig in eine viel breitere Softwarelandschaft integrieren – vom ERP über CRM bis zu Branchenlösungen. Unser Ziel ist nicht, Copilot zu kopieren, sondern reale Mittelstandsprozesse nutzbar zu machen“, so der Co-Founder.

Funktionsweise, Sicherheit und Haftung

Funktional unterscheidet sich das System von herkömmlichen Suchmasken durch eine agentenähnliche Logik. Die Software bündelt Wissen aus internen Quellen wie Richtlinien oder Projektdokumentationen und stellt diese kontextbezogen zur Verfügung. Ein Fokus liegt dabei auf der Datensouveränität. Hierbei betont Christian Kirsch, dass Kundendaten nicht in öffentlichen Modellen verarbeitet werden: „Die Modelle laufen in der europäischen Azure AI Foundry, unsere eigenen Dienste auf deutschen Servern. Die Daten des Kunden bleiben on rest vollständig im jeweiligen Microsoft‑365‑Tenant. Es findet kein Training der Foundation Models mit Kundendaten statt – weder bei Microsoft noch bei uns. Grundlage dafür sind die Azure OpenAI Non‑Training Guarantees, die Microsoft in den Product Terms sowie in SOC‑2/SOC‑3‑ und ISO‑27001‑Reports dokumentiert.“

Auch rechtlich zieht das Start-up eine klare Grenze, sollte die KI einmal fehlerhafte Informationen, sogenannte Halluzinationen, liefern. „Amaiko generiert Vorschläge, keine rechts‑ oder sicherheitsverbindlichen Anweisungen. Das stellen wir in unseren AGB klar: Die Entscheidungshoheit bleibt beim Unternehmen. Wir haften für den sicheren Betrieb der Plattform, nicht für kundenseitig freigegebene Inhalte oder daraus abgeleitete Maßnahmen. Es geht um eine saubere Abgrenzung – technische Verantwortung bei uns, inhaltliche Verantwortung beim Unternehmen“, so Christian Kirsch.

Geschäftsmodell und Markteintritt

Seit der Vorstellung der Version amaiko.ai im Juli 2025 wird das System nach Angaben des Unternehmens mittlerweile von über 200 Anwendern genutzt. Durch die Integration in die bestehende Microsoft-365-Landschaft entfällt für mittelständische Kunden eine aufwendige Systemmigration, was die technische Eintrittsbarriere gering hält.

Passend zu diesem Ansatz ist amaiko als reines SaaS-Produkt konzipiert, das Unternehmen ohne Einstiegshürde direkt online buchen können. Laut Kirsch sind keine Vorprojekte, individuellen Integrationspfade oder teuren Beratungspflichten notwendig: „Die Nutzung ist selbsterklärend und leichtgewichtig. Wer zusätzlich Unterstützung möchte – etwa zur Wissensstrukturierung oder Governance – kann sie bekommen. Aber die technische Einführung selbst ist bewusst so gestaltet, dass Mittelständler ohne Implementierungsaufwand starten können.“

Unterm Strich liefert amaiko damit eine pragmatische Antwort auf den drohenden Wissensverlust durch den demografischen Wandel: Statt auf komplexe IT-Großprojekte zu setzen, holt das bayerische Start-up die Mitarbeitenden dort ab, wo sie ohnehin kommunizieren. Ob sich die „Teams-native“-Strategie langfristig gegen die Feature-Macht von Microsoft behauptet, bleibt abzuwarten – doch mit dem Fokus auf Datensouveränität und mittelständische Prozesslogik hat amaiko gewichtige Argumente auf seiner Seite, um sich als spezialisierter Wächter des Firmengedächtnisses zu etablieren.

to teach: Vom KI-Hype zur Schulinfrastruktur

Wie das 2022 gegründete EdTech to teach die Lücke zwischen Chatbot und Klassenzimmer schließt.

Vor drei Jahren begann mit dem öffentlichen Zugang zu generativer künstlicher Intelligenz ein weltweiter Hype, der auch vor den Schultoren nicht haltmachte. Doch im Bildungsmarkt entscheidet sich derzeit, ob die Technologie tatsächlich Produktivität schafft oder in einer digitalen Sackgasse endet. Das Hamburger EdTech to teach liefert hierzu eine Blaupause: Was 2022 als Experiment begann, hat sich innerhalb von drei Jahren zu einer Arbeitsplattform für hunderttausende Lehrkräfte entwickelt.

Das Problem: US-Tools verstehen deutsche Schulen nicht

Als generative KI erstmals verfügbar wurde, wirkte ihr Einsatz im Bildungsbereich naheliegend. Doch der Blick auf die internationale Konkurrenz zeigt das Dilemma: Während US-Platzhirsche wie MagicSchool AI oder Diffit den Markt mit hunderten Mikro-Tools fluten und technisch beeindrucken, fehlt ihnen der kulturelle Fit. „Einfach nur Texte aus ChatGPT zu kopieren, löst kein einziges Problem von Lehrkräften“, erklärt Felix Weiß, Co-Founder und CEO von to teach.

Die Diskrepanz zwischen dem Versprechen der KI und dem tatsächlichen Schulalltag war groß. US-Lösungen scheitern oft an spezifischen deutschen Lehrplänen oder liefern reine Multiple-Choice-Formate, die hierzulande kaum Anwendung finden. Lehrkräfte benötigten keine unstrukturierten Textwüsten, sondern didaktisch saubere, lehrplankonforme und sofort einsetzbare Materialien. Genau hier setzte das 2022 von Felix Weiß und Marius Lindenmeier gegründete Unternehmen an.

Der Pivot: Datenschutz als Burggraben

Der entscheidende Wendepunkt kam 2023. Das Start-up vollzog einen Strategiewechsel (Pivot) weg von einer SaaS-Lösung für Verlage hin zu einer direkten Plattform für Lehrkräfte. Anstatt Nutzer*innen mit freien Eingabefeldern (Prompts) allein zu lassen, entwickelte das Team feste Arbeitsblattvorlagen. Dies wurde zum entscheidenden Wettbewerbsvorteil gegenüber internationalen Anbietern: Während diese oft an der strikten DSGVO scheitern, bietet to teach durch Serverstandorte in der EU und Rechtssicherheit eine Lösung, die Schulträger akzeptieren.

Dabei mussten technische Kinderkrankheiten überwunden werden: Frühe KI-Modelle „halluzinierten“ Fakten. To teach reagierte mit der systematischen Integration von Quellen und profitierte zugleich von der rasanten Evolution der Sprachmodelle.

Skalierung im Ökosystem gegen nationale Konkurrenz

Der Markt nahm die Lösung schnell an: Im Januar 2023 meldete sich der erste Nutzer an, bis Ende des Jahres waren es laut Unternehmen bereits knapp 16.000 Lehrkräfte. Das Jahr 2024 markierte dann den Übergang vom Start-up zur Plattform: Durch die Übernahme von fobizz (101skills GmbH) wurde to teach Teil eines größeren Bildungsökosystems. Die Gründer blieben als Geschäftsführer an Bord.

Dieser Schritt war strategisch überlebenswichtig in einem sich konsolidierenden Markt. Einerseits gegenüber agilen Herausforderern, da Konkurrenten wie schulKI, Teachino, KIULY oder Kuraplan zum Teil aggressiv um Landeslizenzen kämpfen bzw. auf dem Markt für KI-gestützte Unterrichtsplanung und Materialerstellung durchgestartet sind.

Andererseits war der Schritte in Hinblick auf etablierte Verlage notwendig. Denn Häuser wie Cornelsen ziehen inzwischen mit eigenen KI-Assistenten nach, sperren ihre Inhalte jedoch oft in geschlossene Systeme, d.h. binden sie oft an die eigenen Verlagswerke.

Durch die erfolgreiche Integration in fobizz ist to teach kein isoliertes Insel-Tool mehr, sondern profitiert von bestehenden Landesrahmenverträgen und einem riesigen Vertriebsnetz. Die Nutzer*innenzahlen explodierten förmlich auf über 140.000 Lehrkräfte bis Ende 2024, so die Angaben von to teach.

Status Quo 2025: KI als neue Infrastruktur

Heute, im dritten Jahr nach der Gründung, hat sich der Fokus erneut verschoben. To teach versteht sich inzwischen als Arbeitsinfrastruktur. Die Zahlen unterstreichen diesen Anspruch: Nach Angaben von to teach nutzen über 300.000 Lehrkräfte die Plattform, und mehr als 4.000 Schulen sind angebunden. Das bedeutet: Millionen von Inhalten wurden so bereits KI-gestützt vorbereitet.

Das Unternehmen treibt nun den systematischen Schulvertrieb voran. Damit beweisen EdTechs wie to teach, dass sich Qualität und Personalisierung im sonst oft als innovationsresistent geltenden Bildungsmarkt skalieren lassen.

Für CEO Felix Weiß ist die Diskussion über das „Ob“ längst beendet: „Die Frage ist nicht mehr, ob KI im Klassenzimmer ankommt, sondern, wie und auf welche Weise sie dort wirklich hilft.“

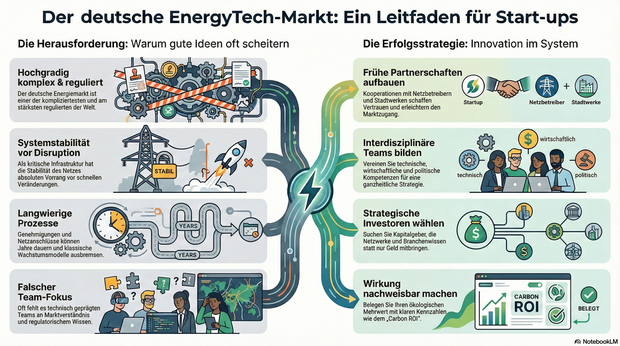

Report: Inside Germany’s EnergyTech Market

Aktuelle Ein- und Ausblicke für Gründer*innen und Start-ups im EnergyTech-Markt.

EnergyTech gehört in Deutschland zu den spannendsten, aber auch herausforderndsten Märkten für Gründer*innen. Die Kombination aus technologischer Innovation, wirtschaftlichem Potenzial und der Dringlichkeit, das Energiesystem klimaneutral zu gestalten, schafft enorme Chancen. Gleichzeitig ist die Eintrittsbarriere hoch, denn der deutsche Energiemarkt ist einer der komplexesten und am stärksten regulierten weltweit.

Laut der Internationalen Energieagentur werden im Jahr 2025 weltweit rund 2,1 Billionen Euro in saubere Energien investiert. Damit übertreffen die Investitionen in erneuerbare Energien erstmals die in fossile Brennstoffe deutlich. Deutschland spielt dabei eine zentrale Rolle, denn kein anderes Land in Europa verfügt über eine vergleichbare Durchdringung mit erneuerbaren Energien. Diese Vorreiterrolle macht den Markt attraktiv, aber auch kompliziert.

Gründer*innen, die in diesem Umfeld aktiv werden, müssen verstehen, dass Erfolg hier weniger von reiner Technologie abhängt, sondern von der Fähigkeit, sich in einem vielschichtigen System aus Regularien, Netzstrukturen und politischen Rahmenbedingungen zu bewegen. Es reicht nicht, eine gute Idee zu haben. Entscheidend ist, wie diese Idee in ein System passt, das auf Stabilität, Versorgungssicherheit und langfristige Planung ausgelegt ist.

Deutschlands Energiemarkt zwischen Stabilität und Veränderung

Der deutsche Energiemarkt gilt als hoch reguliert, gleichzeitig aber auch als offen für neue Akteur*innen. Wer hier tätig werden will, findet klar definierte Wege, um als Energieversorger*in zugelassen zu werden. Doch der Weg dorthin ist gesäumt von Genehmigungen, Netzanschlussverfahren und Förderbedingungen.

Die Stabilität des Systems steht über allem. Jede Veränderung im Netz kann weitreichende Folgen haben, weshalb die Regulierung streng überwacht wird. Netzbetreiber*innen müssen ständig das Gleichgewicht zwischen Erzeugung und Verbrauch sichern, um Versorgungsstörungen zu vermeiden. Das führt dazu, dass Innovationen nur schrittweise eingeführt werden können.

Hinzu kommt die dezentrale Struktur des Energiesystems. Deutschland hat den Umbau seiner Energieversorgung regional organisiert, was zu einer Vielzahl von kleinen Akteur*innen führt. Ob Solaranlagen auf Privathäusern, Windparks in ländlichen Regionen oder Batteriespeicher in Städten, alle müssen an das öffentliche Netz angeschlossen werden. Dieses Netz ist die Lebensader des Systems, aber gleichzeitig ein Flaschenhals. Jede neue Installation benötigt einen Netzanschluss, und die Wartezeit kann sich über mehrere Jahre erstrecken.