Aktuelle Events

Geschäftsideen Werbung: Reise als Inspirationsquelle

Die Welt als Impulsgeber

Der Kunde erwartet von seiner Werbeagentur neue, unverbrauchte Ideen. So kamen sechs Studenten der schwedischen Hyper-Island Hochschule auf die Geschäftsidee, für drei Monate durch die Welt zu reisen, um an jedem Wochenende in einer anderen Stadt und einem anderen Land Werbekonzepte zu entwickeln.

Da die Studenten in der Woche studieren mussten, blieben nur die Wochenenden für ihre "Welttournee" und die Umsetzung der Geschäftsidee übrig.

Die Jung-Werber versprachen, innerhalb von 48 Stunden ein komplettes Werbekonzept für ihre Kunden zu erstellen. Mehr Zeit blieb auch gar nicht. Das Studententeam verlangte für seine Arbeit keine klassische Entlohnung, sondern die Bezahlung der Flugkosten und die Unterbringung vor Ort. Das Konzept stieß bereits auf sehr große Nachfrage. Häufig haben auch große, etablierte Werbeagenturen das Studententeam namens The Pop Up Agency gebucht, um neue Impulse zu bekommen.

Diese Artikel könnten Sie auch interessieren:

Amba: Der Schlüssel zum Digital Detox

Drei Stunden und 19 Minuten – so lange hängen junge Erwachsene täglich auf Social Media, oft völlig unbewusst. Das Kölner Start-up Amba will diesen Scroll-Automatismus nun mit einem simplen haptischen Trick durchbrechen: Ein NFC-Schlüsselanhänger erzwingt eine physische Hürde. Doch kann das Konzept im Alltag wirklich bestehen?

Das 2025 von Yves Maurice Clever und Bastian Fischer gegründete Kölner Start-up Amba positioniert sich mutig im umkämpften Digital-Wellbeing-Markt. Statt auf strenge App-Verbote zu setzen, wollen die beiden 27-Jährigen das unbewusste Dauer-Scrollen auf Social Media mit einem physischen Schlüsselanhänger stoppen. Angesichts einer durchschnittlichen Social-Media-Nutzungsdauer von drei Stunden und 19 Minuten bei jungen Erwachsenen – wovon viel Zeit für rein gewohnheitsmäßiges Scrollen draufgeht – zielt Amba darauf ab, dieses Muster durch eine haptische Hürde zu durchbrechen.

Yves, der in Neuss Marketing studierte, beschäftigt sich schon lange mit digitaler Achtsamkeit, während Bastian als Informatiker das technische Know-how aus der Softwareentwicklung mitbringt. Angetrieben aus dem eigenen Frust über gängige Software-Lösungen, die sich mit wenigen Klicks umgehen ließen, begannen sie im Sommer vergangenen Jahres mit der Produktentwicklung, bevor im Oktober 2025 die offizielle Gründung in Köln folgte.

Haptik schlägt Habit

Doch wie verhindert man, dass der Griff zum NFC-Chip nicht bald zur nächsten unbewussten Gewohnheit wird? „Unbewusstes Scrollen funktioniert so gut, weil alles in derselben Bewegung passiert: Man nimmt das Handy in die Hand und ist sofort in der App“, analysiert Mitgründer Bastian. Ein physisches Element unterbreche genau diesen Automatismus.

Der entscheidende Vorteil gegenüber klassischer Software liege im Timing, so Bastian weiter: „Bildschirmzeit-Limits erscheinen meist erst im Scroll-Moment, wenn viele schon im Autopilot sind und sie reflexartig wegklicken. Bei Amba fällt die Entscheidung vorher.“ Nach dem haptischen Entsperren legen die Nutzer*innen fest, wie viel Zeit sie in der App verbringen möchten. Bastian betont: „Dieser kleine mentale Rahmen macht Social Media wieder zu einer bewussten Entscheidung statt zu einer Gewohnheit.“ Erste Tests scheinen den Gründern recht zu geben: Eigenen Angaben zufolge sei die Social-Media-Nutzung der Tester auf durchschnittlich 49 Minuten pro Tag gesunken.

Das Hardware-Paradoxon und die Konkurrenz

Der Ansatz der „Intentional Friction“ ist clever, doch der Markt verzeiht keine Fehler. Mit dem niederländischen Start-up Unpluq existiert bereits ein etablierter Konkurrent mit einem fast identischen NFC-Konzept. Yves sieht den Unterschied seines Produkts vor allem in der Systematik. „Viele bestehende Lösungen [...] funktionieren nach dem Prinzip: Man hält den Tag ans Smartphone, um Apps zu sperren, und deaktiviert die Sperre später wieder. Wir haben die Logik umgedreht“, kontert Yves. Bei Amba seien die Apps standardmäßig gesperrt und würden erst durch den Schlüssel freigeschaltet.

Zudem wolle man sich über eine extrem niedrige Einstiegshürde abheben: „Deshalb kostet der physische Tag bei uns nur einen symbolischen Euro und Nutzer können Amba zwei Wochen lang testen“, erklärt Yves den aggressiven Markteinstieg.

Der Kampf gegen die Abo-Müdigkeit

Dennoch muss sich Amba langfristig beweisen, insbesondere da laut einer ExpressVPN-Umfrage 38 Prozent der Konsument*innen explizit unter „Abo-Müdigkeit“ leiden. Ob die Nutzerschaft dauerhaft bereit ist, knapp 20 Euro im Jahr für einen softwarebasierten Verzicht zu zahlen, bleibt abzuwarten.

Bastian räumt offen ein: „Mit den physischen Tags verdienen wir tatsächlich kein Geld, sie decken lediglich die Produktionskosten.“ Er ist jedoch überzeugt, dass die Abo-Investition für die Nutzer*innen unverzichtbar bleibt, da das Suchtpotenzial der Apps nicht verschwinde. „Social-Media-Plattformen sind bewusst so gestaltet, dass sie möglichst lange Aufmerksamkeit binden. Viele Nutzer berichten uns, dass sie nach kurzer Zeit wieder in alte Muster zurückfallen, sobald sie die Unterstützung entfernen“, warnt Bastian. Das Ziel sei daher keine einmalige „Detox“-Kur, sondern ein Rahmen, um die Nutzung „langfristig kontrollierter zu gestalten“.

Technischer Flaschenhals zum Start

Erschwerend kommt aktuell ein stark restriktives System hinzu: Durch die Begrenzung auf das Betriebssystem iOS 18 bleiben der gesamte Android-Markt sowie Besitzer*innen älterer Apple-Geräte vorerst kategorisch ausgeschlossen. „Die aktuelle Einschränkung auf neuere iOS-Versionen hat vor allem technische Gründe“, verteidigt Yves diesen harten Schnitt. Einige NFC-Funktionen liefen auf älteren Systemen schlichtweg noch nicht stabil genug. Eine Android-Version sei geplant, befinde sich aber noch nicht in der Entwicklung.

Und was passiert, wenn man den rettenden Chip zu Hause vergisst und komplett blockiert ist? Yves beschwichtigt: Für solche Fälle gebe es eine Notfallfunktion in der App, die eine temporäre Entsperrung erlaube. Er verspricht: „Amba soll eine bewusste Hürde schaffen, aber keine Situation, in der Nutzer komplett von ihrem Smartphone abgeschnitten sind.“

Letztlich wandert das Kölner Start-up auf dem schmalen Grat zwischen Achtsamkeit und Deinstallation. Der Erfolg steht und fällt mit dem Hardware-Paradoxon: Nur wenn die Community den Schlüsselanhänger langfristig als befreiendes Werkzeug und nicht als frustrierende Barriere wahrnimmt, wird sich das subventionierte Abo-Modell gegen die Platzhirsche rentieren.

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

Die Müsli-Macher und die Kälte: Das neue Millionen-Projekt von Kraiss & Mahler

Dass sie Märkte revolutionieren können, haben die Freda-Gründer bereits bewiesen – nun steht die Tiefkühlkette auf dem Prüfstand. Mit einem mutigen Modul-Konzept fordern Philipp Kraiss und Christian Mahler die Industrie-Riesen im Supermarktregal heraus.

In der Start-up-Welt ist der Begriff Seriengründer*in oft ein zweischneidiges Schwert: Das Vertrauen der Investor*innen ist hoch, doch die Fallhöhe nach einem Erfolg wie mymuesli ebenso. Philipp Kraiss und Christian Mahler haben sich mit ihrem 2023 gegründeten Food-Start-up Freda bewusst gegen ein „Me-too-Produkt“ und für eine operative Wette auf die Zukunft der Tiefkühlkette entschieden. Mit einem mutigen Modul-Konzept fordern sie die etablierten Industrie-Riesen im Supermarktregal heraus. Die Prämisse: Der Markt für Tiefkühlkost (TK) wächst – auf über 22,6 Milliarden Euro im Jahr 2024 –, ist aber durch extremen Preisdruck und eine veraltete Produktlogik geprägt. Wir haben uns das Geschäftsmodell näher angesehen und die Gründer dazu befragt.

Pizza, Pasta, Gelato … und jetzt Blocks?

Die Pizza „Salami Sensation“ war für Freda der Türöffner. Mit dem Sieg bei Stiftung Warentest (2024) bewies das Team, dass es Qualität „kann“ und schuf einen starken USP. Strategisch ist Pizza jedoch kein leichtes Feld: Der Wettbewerb ist anspruchsvoll, die Regalplätze im Einzelhandel sind besetzt und die Differenzierung erfolgt meist über den Preis. Mit einer Innovation wie „Frozen Blocks“ erweitert Freda nun das Spielfeld und eröffnet eine neue Kategorie von Tiefkühlkost.

Es handelt sich dabei nicht mehr um ein fertiges Gericht, sondern um eine Systemkomponente. Das Konzept orientiert sich am gastronomischen „Mise en Place“: Vorbereitete, schockgefrostete Komponenten wie Beef Ragù oder Chili sin Carne fungieren als Basismodule für die heimische Küche. Strategisch gesehen erhöht dies die Wertdichte pro Kubikzentimeter im TK-Fach und verringert die Komplexität in der eigenen Produktion im Vergleich zu mehrkomponentigen Fertigmenüs.

Auf die Frage, ob der strategische Wechsel von der Pizza zu den „Frozen Blocks“ eine Flucht aus dem Commodity-Preiskampf der Pizza-Truhe hin zu einer proprietären Nische sei, widerspricht Philipp Kraiss. Vielmehr handele es sich um einen konsequenten Ausbau des Sortiments, denn Freda solle künftig den gesamten Alltag der Kund*innen abbilden – vom Frühstück bis zum Abendbrot. Das sei eben mehr als nur Pizza. „Unser Anspruch ist aber nicht nur Bekanntes besser zu machen – wie bei unserer Pizza, sondern auch neue Wege zu gehen“, stellt der Gründer klar. Die flexiblen Module seien auf diesem Weg der nächste logische Schritt. Er verspricht dabei maximale Vielfalt aus dem Gefrierfach, „denn jeder Block lässt sich vielfältig kombinieren.“

Die Retail-Herausforderung: Kaufland als Stresstest

Mit einer Basis von über 30.000 D2C-Kund*innen hat das Unternehmen bereits bewiesen, dass die Nachfrage nach seinen Produkten besteht. Um dieses Potenzial voll auszuschöpfen und die Margen zu stärken, wurde im August 2025 der Launch in 780 Kaufland-Märkten umgesetzt – ein strategischer Meilenstein, der die Reichweite massiv erhöht und über das Volumen des stationären Einzelhandels den Weg zu nachhaltigem, profitablem Wachstum ebnet – ohne aufwendigen Versand mit Isolierung und Trockeneis.

Hier zählt nun die Shelf Velocity (Abverkaufsgeschwindigkeit). Ein modulares System erfordert von der Kundschaft jedoch ein Umdenken: Man kauft kein fertiges Abendessen, sondern eine Zutat. Freda muss hier beweisen, dass der Mehrwert der Zeitersparnis am Point of Sale verstanden wird, bevor die harten Auslistungsmechanismen des Handels greifen.

Doch wie überzeugt man eine*n Einkäufer*in davon, dass ein modulares System mehr Flächenproduktivität bringt als die zehnte Sorte Standard-Lasagne? Christian Mahler kontert auf diese Retail-Frage mit einem anschaulichen Branchen-Vergleich: „Wir sind eben nicht die zehnte Lasagne. Eine klassische TK-Lasagne belegt viel Regalfläche, bedient genau einen Anlass und konkurriert mit neun anderen Lasagnen um denselben Kunden.“ Durch das kompakte Format und eine maximale SKU-Dichte der Blocks könne der Händler auf derselben Regalfläche mehrere Sorten listen und spreche damit dutzende Zubereitungsarten von der Bowl bis zum Curry an. Mahler zeigt sich selbstbewusst: „Wir eröffnen eine neue Kategorie statt in einer bestehenden zu kämpfen.“

Operative Exzellenz vs. bayerisches Handwerk

Ein weiterer Spagat wartet in der Produktion: Freda wirbt offensiv mit „Made in Bavaria“ und handwerklicher Herstellung. In der Start-up-Praxis beißt sich Handwerk jedoch oft mit Skalierung. Wer bundesweit fast 900 Supermärkte bedient, muss industrielle Prozesse beherrschen. Die Gefahr dabei ist offensichtlich: Wenn die Qualität durch die Masse sinkt, verliert Freda seinen wichtigsten USP. Gleichzeitig bleibt bei der exklusiven Zielgruppe, die bereit ist, für TK-Komponenten Premium-Preise zu zahlen, in Zeiten der Inflation die Frage der Preissensibilität bestehen.

Auf drohende Kapazitätsgrenzen angesprochen, räumt Philipp Kraiss ein, dass die Passauer Manufaktur zwar das Herzstück bleibe. „Aber wir waren von Anfang an ehrlich zu uns selbst: Eine Manufaktur skaliert nicht linear“, gibt der Seriengründer zu bedenken. Mit wachsendem Geschäft müsse man die Produktion auf breitere Schultern stellen und mit Partnern zusammenarbeiten. Sein Kernversprechen an die Kund*innen lautet dabei jedoch: „Wir lagern nicht die Rezeptur aus, sondern die Kapazität.“

Marktpsychologie: Convenience ohne Reue

Psychologisch besetzt Freda damit eine überaus geschickte Lücke. Die „Frozen Blocks“ nehmen der Käuferschaft zwar die Entscheidung für die aufwendige Kernkomponente ab, lassen das Gefühl des Selbstkochens durch das frische Ergänzen von Beilagen jedoch vollkommen intakt. Dies eliminiert die oft vorhandene „Convenience-Scham“ gesundheitsbewusster Zielgruppen und könnte die Lösung für die stagnierenden Marktanteile klassischer Fertiggerichte bei jüngeren Konsument*innen sein.

Fazit für die Start-up-Praxis

Freda ist ein Lehrstück für den Übergang von einer digitalen D2C-Brand zum Player im Massenmarkt. Die Gründer nutzen ihre Erfahrung, um eine etablierte Kategorie neu zu denken. Ob die Rechnung aufgeht, wird sich an der Regal-Rotation zeigen. Wenn die Kund*innen den Aufpreis für die „bayerische Handarbeit“ und das modulare System dauerhaft akzeptieren, könnte Freda die Blaupause für die nächste Generation von Food-Marken liefern.

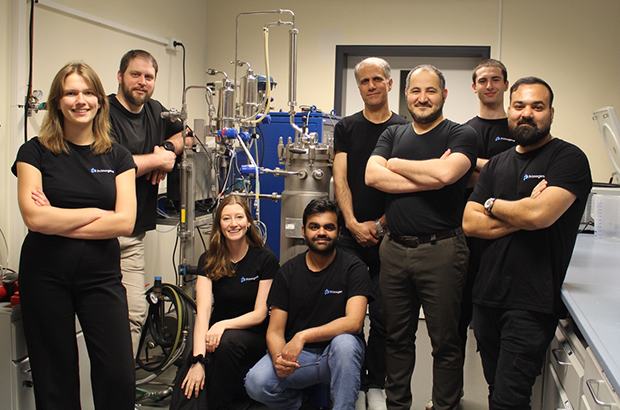

Primogene: Muttermilch als Vorbild

Primogene ist ein 2023 gegründetes BioTech-Start-up mit Sitz in Leipzig, das sich auf die Entwicklung biotechnologischer Herstellungsverfahren für bioidentische Inhaltsstoffe spezialisiert hat. Ein Schwerpunkt liegt auf Verbindungen, die der Muttermilch nachempfunden sind und die Gesundheit in allen Lebensphasen fördern können.

Auch wenn das Produkt als weißes Pulver eher unscheinbar aussieht, markiert seine Existenz einen wissenschaftlichen Meilenstein. „Wir haben eine spezielle Technologie entwickelt, dank der wir komplexe bioidentische humane Milchzucker skalierbar herstellen können“, erzählt Linda Karger, einst Managementstudentin an der Technischen Universität in München, heute COO der 2023 in Leipzig gegründeten Primogene GmbH. Die chemischen Verbindungen entsprechen also den im menschlichen Körper vorkommenden Molekülen bis ins kleinste biochemische Detail. Und sie übernehmen – obwohl industriell hergestellt – die gleichen Funktionen, die bisher nur Muttermilch garantierte.

Zum Verständnis: Die komplexen Zuckerstrukturen sind nach Fett und Laktose der drittgrößte feste Bestandteil menschlicher Milch. Sie bieten einzigartige gesundheitliche Vorteile, unterstützen beispielsweise das Immunsystem sowie die kognitive Entwicklung wie kein anderer Stoff. „Nach zahllosen Gesprächen mit Ärzten und Kliniken begann unsere Geschichte mit der Idee, nährstoffreiche Inhaltsstoffe als Zusatz für die Ernährung von Frühgeborenen herzustellen. Weitergedacht können bioaktive Bestandteile der Muttermilch ebenso zur Krankheitsprävention bei Erwachsenen sinnvoll eingesetzt werden“, erklärt Karger. „Um das Wirkungspotenzial unserer Human Milk Oligosaccharides (HMO) weiter zu erforschen, testen wir diese aktuell in enger Zusammenarbeit mit dem Leipziger Fraunhofer-Institut für Zelltherapie und Immunologie.“

Produktsortiment in der Breite offen

Gleichzeitig wird die von Dr.-Ing. Reza Mahour (CEO, Experte für Bioverfahrenstechnologie) und Valerian Grote (CTO, Molekularbiologe/Experte für Analytische Biochemie) entwickelte enzymatische Technologie genutzt, um bioidentische Moleküle für andere Märkte zu erzeugen, beispielsweise Inhaltsstoffe für Produkte der Körperpflege oder Rohmaterialien für die Pharmaindustrie. „Wir produzieren selbst. Dabei lässt sich jedes unserer Produkte auf die spezielle Technologie zurückführen. Unseren Kunden bieten wir Komplettlösungen – das reicht von der Suche nach der richtigen Produktionsplattform bis hin zu Entwicklung und Produktion“, bestätigt Karger. Erste Umsätze wurden nach ihren Angaben bereits früh erzielt. Inhaltsstoffe für den Kosmetikbereich sollen noch in diesem Jahr mithilfe bestehender Partnerschaften am Markt eingeführt werden. Im Pharmabereich wird ebenfalls mit ersten Kunden zusammengearbeitet.

Karger ergänzt: „Wir haben früh auf Partnerschaften und Vorbestellungen gesetzt, um den Markt besser zu verstehen.“ Um die bereits verabredeten hochwertigen Roh- und Inhaltsstoffe bald in größeren Mengen liefern zu können, ist das aktuell elfköpfige Team von Primogene gerade innerhalb Leipzigs umgezogen. Für die anstehende Skalierung war der Wechsel auf eine Betriebsstätte mit mehr Laborfläche und größerem Produktionsbereich wichtig. Große Mitspieler auf dem Feld der HMOs wie die niederländische DSM-Firmenich oder der dänische Konzern Chr. Hansen schrecken Karger nicht: „Bekannt sind mehr als 200 verschiedene HMOs, davon sind bisher sieben strukturell einfacher industriell herstellbar und auf dem Markt. Sie werden mit einer Fermentationstechnologie produziert. Unser enzymatisches Verfahren kann deutlich mehr und komplexere Zuckerstrukturen hervorbringen. Außerdem reicht unsere Produktpalette weit über HMOs hinaus.“

Sichtbarkeit durch Innovationsplattform futureSax erleichtert Investorensuche

Das bisher benötigte Kapital stammt unter anderem von Business Angels aus dem Bereich der Biotechnologie, darunter auch Climate Founders, bei deren Accelerator-Programm Mahour Grote und Karger einst zusammenfanden. Für Primogene als forschungs- und deshalb kapitalintensives Biotech-Unternehmen sind daneben die Mittel aus Förderprogrammen des Landes Sachsen und der Stadt Leipzig von wesentlicher Bedeutung. Darüber hinaus profitiert das Start-up noch heute von der Sichtbarkeit, die es durch den Gewinn des dritten Platzes beim Sächsischen Gründerpreis 2024 erhielt. Zunächst sorgten der professionelle Nominiertenfilm und die begleitende Öffentlichkeitsarbeit von futureSax für Aufmerksamkeit sowohl in den Medien als auch innerhalb des Netzwerks.

Dann bot die Preisübergabe auf der Sächsischen Innovationskonferenz vor über 1.000 Gästen Primogene eine wichtige Gelegenheit zur Präsentation. „Sachsen ist ein Innovationsstandort mit besonderer Dichte: Exzellente Forschung, starke Industrie- und Mittelstandsstrukturen und eine wachsende Start-up-Szene greifen ineinander. Hier entstehen Lösungen, die international wettbewerbsfähig sind. Entscheidend ist der Schulterschluss im Ökosystem – von Hochschulen über Unternehmen bis zu Kapitalgebern. futureSax schafft dafür die Bühne und die Verbindungen, damit aus Ideen schneller Produkte, Partnerschaften und Gründungen werden“, erklärt Susanne Stump, Geschäftsführerin der Innovationsplattform des Freistaats Sachsen. Das Interesse großer Investoren bestätigt, dass Primogene auf dem richtigen Weg ist. Im Jahr 2025 schloss das innovative Start-up eine Seed-Finanzierungsrunde mit namhaften Investoren wie HTGF, TGFS, der Sächsischen Beteiligungsgesellschaft und better ventures ab. Das geplante Personalwachstum sowie die Produktionsaktivitäten der nächsten zwei Jahre sind damit gesichert.

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen: https://t1p.de/p8gop

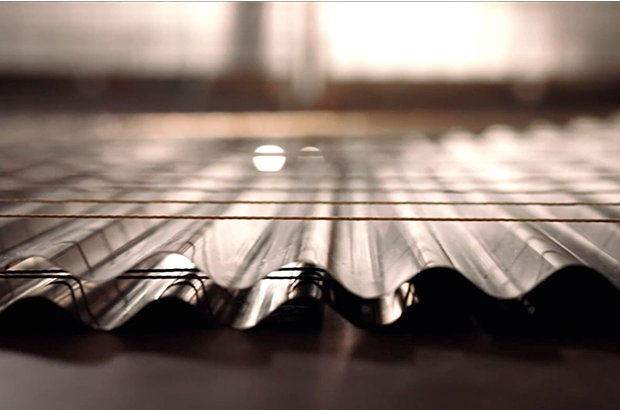

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Vom Check-in zur Patient*innenakte: Wie Travel-Pionier Salim Sahi mit HoloLogix.AI die Health-IT aufmischt

Vom Reisebuchungssystem zur Sicherheits-Uhr für Senior*innen: Serial Entrepreneur Salim Sahi greift mit HoloLogix.AI greift gleich zwei Milliardenmärkte an: Gesundheitswesen und Hotellerie. Doch wie viel Substanz steckt hinter der Vision?

Gründungslegenden klingen oft zu glatt für die Realität – wie Sahis Skateboard-Unfall, der in einer Notaufnahme zur Idee für sein neuestes Venture führte. Wer den Mann kennt, der in den 90ern mit „Traffics“ die Reisebranche digitalisierte, weiß jedoch: Er macht keine halben Sachen. Jetzt, im Februar 2026, steht er mit einer europäischen Aktiengesellschaft (SE) und einem enorm breiten Versprechen wieder auf dem Platz.

Wie Touristik-Know-how in die Klinik kommt

Der Sprung von der Touristik zur Service-Automatisierung im Gesundheitswesen wirkt wie ein harter Bruch. Doch unter der Haube geht es in beiden Welten um hochvolumige Transaktionen, Termin-Slots und Datenabgleich in Echtzeit. Wer Millionen Pauschalreisen fehlerfrei abwickelt, so die Wette von HoloLogix.AI, beherrscht auch das Termin-Management von Kliniken, Hotels und Restaurants.

Für CEO und Gründer Salim Sahi ist das Projekt dennoch ein „kompletter unternehmerischer Neuanfang“. Gegenüber StartingUp räumt er ein, von 25 Jahren Travel-Tech-Erfahrung zu profitieren, doch seine wahre Passion gelte der künstlichen Intelligenz. Das Herzstück bilde dabei die MIA Service KI: „Wir haben eine holistische KI-Plattform geschaffen, also ein Tool, das ganzheitlich agiert und eingesetzt werden kann.“ MIA verstehe Gespräche, erledige parallel Aufgaben und verbinde Systeme – „rund um die Uhr und branchenübergreifend“. Auch wenn der Fokus aktuell auf Gesundheitswesen und Hospitality liege, sei das System laut Sahi letztlich „nahezu überall einsetzbar, wo Kunden- oder Patientenkontakt herrscht.“

Der Angriff auf die Platzhirsche

Der Markt für Conversational AI ist 2026 kein blauer Ozean mehr. Etablierte Player wie Aaron.ai haben sich tief in die Health-Landschaft eingegraben, flankiert von Plattform-Giganten wie Doctolib. HoloLogix.AI reagiert mit aggressiven Preisen ab 99 Euro im Monat und einer massiven technologischen Breite.

Aber warum sollten Klinikverantwortliche das Risiko eines Wechsels eingehen? Salim Sahi sieht den „Killer-USP“ in der Architektur der Interaktion: „Unser Ansatz ist ein anderer: Statt starrer Skripte bieten wir echte Gesprächsintelligenz durch Conversational AI an.“ Das System sei eine KI, die im laufenden Gespräch aktiv Aufgaben erledige, was eine beispiellose Integrationstiefe erfordere. „Hier gehen wir ganz tief rein und verarbeiten Daten in Echtzeit“, so der CEO. Da Aufgaben direkt ausgeführt werden, optimiere sich das Zeitmanagement drastisch – konzipiert als Omnichannel-Ansatz über Telefon, Website, E-Mail, Wearables oder bald sogar über Robotik.

Die schmale Gratwanderung am Handgelenk

HoloLogix.AI belässt es nicht bei Software, sondern bringt mit der MIA Watch eigene Hardware ins Spiel. Die Smartwatch für Senior*innen soll Stürze erkennen und sofort einen aktiven Sprachdialog führen. Eine Gratwanderung: Reines Assistenz-System oder medizinisches Gerät mit komplexer Zertifizierungspflicht (MDR)?

Prof. Dr. Thomas Fuchs, Co-Founder und Aufsichtsrat für den Bereich Health Care, ordnet das rechtlich eindeutig ein: „MIA Protect ist ein Teil der holistischen KI-Plattform, die mit verschiedenen Health Watches wie z.B. auch der Apple Watch kompatibel ist. Sie ist ein Assistenz- und Companion-System.“ Die Hardware erkenne Stürze, ersetze aber „keine ärztliche Untersuchung oder medizinische Entscheidung“. Um Geschwindigkeit und Nutzer*innenfreundlichkeit zu wahren, bewege man sich „bewusst außerhalb der Medizinprodukt-Zertifizierung (MDR), ohne den Sicherheitsrahmen zu verlassen“.

Ein mehrstufiges Sicherheitsnetz aus Sensorik, KI-Algorithmen und menschlichem Service-Team federt Fehlinterpretationen ab. Haftungsfragen sind laut Fuchs über klare Nutzungsbedingungen geregelt. Für den Mediziner steht ohnehin der „Companion Aspekt“ im Vordergrund: Nach einem Sturz, wenn Patient*innen hilflos am Boden liegen, alarmiere MIA in einer Kaskade Notfallkontakte und beruhige das Unfallopfer, bis Hilfe eintrifft. „MIA Protect soll an diesem Punkt Sicherheit und damit Lebensqualität geben, vielleicht sogar die Möglichkeit schaffen für Senioren, länger selbstbestimmt in ihrem Zuhause zu leben“, resümiert Fuchs.

Pflegeheim und Luxushotel: (K)ein operativer Widerspruch?

Das vielleicht Spannendste an HoloLogix.AI ist das Personal: Salim Sahi hat sich politische und ethische Schwergewichte in den Aufsichtsrat geholt. Darunter Dr. Marcel Klinge, ehemaliger FDP-Bundestagsabgeordneter und Tourismus-Experte. Er muss Investor*innen den Spagat erklären, warum ein Start-up gleichzeitig Pflegeheime und Luxushotels digitalisieren will – was oft als Warnsignal für operative Verzettelung gilt.

Dr. Marcel Klinge sieht darin jedoch keinen Widerspruch, sondern die Stärke der technischen Basis: „Der gemeinsame Nenner liegt im Kern: Unsere holistische KI-Infrastruktur kann über das Telefon Gespräche führen, kann aber auch über die Website, Health Watches und Devices und direkt im Gespräch Aufgaben ausführen.“ Das Backend orchestriere lediglich Termin-Slots, Daten und Anfragen in Hochgeschwindigkeit. Dabei spiele es schlichtweg keine Rolle, „ob der Kunde Patient in einem Pflegeheim oder Gast in einem Luxushotel ist.“

Wenn die KI-Vision auf den deutschen Fax-Alltag trifft

Ein Blick auf die Website verrät große Visionen, doch diese müssen sich im harten Alltag deutscher IT-Infrastrukturen und oft veralteter Praxis-Server beweisen. Zudem ist die Frage des Datenschutzes elementar: Nutzt das Unternehmen US-amerikanische Sprachmodelle via API, oder hostet man eigene „Sovereign AI“ in Europa?

Für Prof. Dr. Thomas Fuchs sind Datenschutz und Systemintegration absolute Kernpunkte. Um digitale Souveränität zu wahren, setzt das Unternehmen auf einen hybriden Weg: „Wir orchestrieren auf die gängigen sowie auf eigene Modelle auf deutschen Servern, die in Europa bereits genutzt werden.“ Laut Fuchs verlässt man sich dabei nicht nur auf das Versprechen von Sicherheit, sondern arbeitet seit der ersten Stunde eng mit dem renommierten Fraunhofer-Institut zusammen und lässt die eigene Infrastruktur „regelmäßig durch deren Experten prüfen“. Das bloße Versprechen von Sicherheit reicht HoloLogix.AI dabei nicht.

Mehr als nur ein GPT-Wrapper?

HoloLogix.AI ist eine der vielleicht ambitioniertesten Gründungen des Jahres. Technologisch muss es beweisen, dass es mehr ist als ein „GPT-Wrapper“ mit Smartwatch. Aber die Kombination aus Sahis Exekutiv-Erfahrung, Klinges Netzwerk und Fuchs‘ ethischem Korrektiv macht es zu einem spannenden Herausforderer. Wenn die Uhr im Alltag für Sicherheit sorgt – und die KI den deutschen Datenschutz überlebt – könnte aus Berlin der nächste europäische Champion kommen.

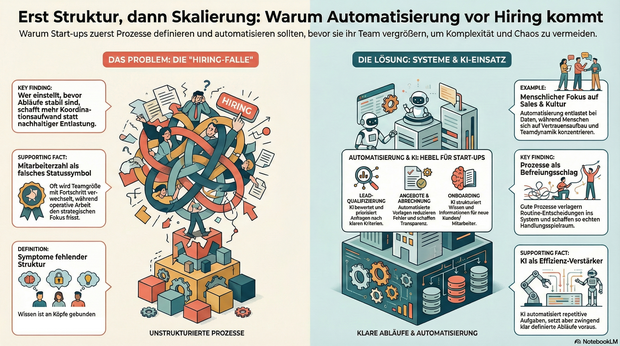

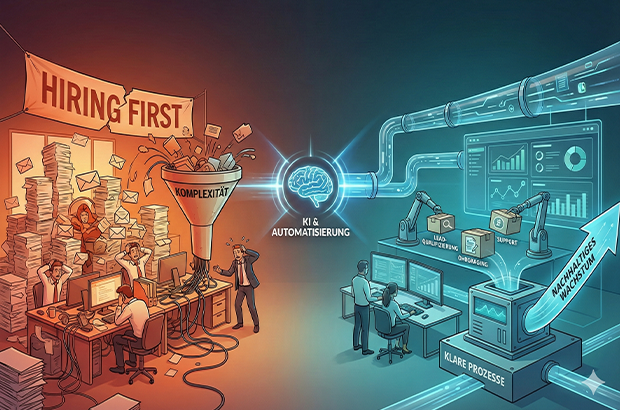

Automatisierung vor Hiring, sonst wird Komplexität skaliert

Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung. Tipps und To-Dos.

Wachstum wird in Start-ups oft sehr eindimensional gedacht: mehr Nachfrage gleich mehr Menschen. Sobald Anfragen steigen, Deals reinkommen oder neue Märkte locken, folgt fast automatisch der nächste Hiring-Plan. Dabei wird häufig die Ursache mit Wirkung verwechselt. Nicht fehlende Kapazität bremst junge Unternehmen, sondern fehlende Struktur. Prozesse entstehen improvisiert, Verantwortung wird situativ verteilt, operative Arbeit frisst Fokus. Und irgendwann fühlt sich Wachstum nicht mehr nach Fortschritt, sondern nach Dauerstress an.

Gerade in der Start-up-Branche wird Wachstum zudem stark über sichtbare Kennzahlen bewertet. In Gesprächen mit Investor*innen lautet eine der ersten Fragen häufig nicht Gewinn oder EBITA, sondern: Wie viele Mitarbeitende seid ihr und wie viel Umsatz macht ihr? Die Anzahl der Mitarbeitenden wird damit fast zu einem Statussymbol. Hiring wird nicht nur zur operativen, sondern auch zur psychologischen Größe und ein Zeichen von Fortschritt. Diese Logik verstärkt den Reflex, früh zu skalieren, auch wenn die strukturellen Voraussetzungen dafür noch fehlen. Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung.

Warum Hiring allein selten skaliert

Mehr Menschen im Team wirken wie eine schnelle Lösung. In der Praxis zeigt sich jedoch häufig ein ähnliches Muster: Neue Kolleg*innen übernehmen Aufgaben, die eigentlich nur deshalb existieren, weil Abläufe unklar oder manuell gewachsen sind. Statt nachhaltiger Entlastung entsteht zusätzliche Koordination.

Typische Symptome sind:

- operative Aufgaben blockieren strategische Arbeit,

- Wissen verteilt sich auf einzelne Köpfe,

- Entscheidungen hängen an Personen statt an klaren Abläufen,

- Abstimmungen nehmen zu, ohne dass die Wertschöpfung im gleichen Maß wächst.

Das Problem ist nicht Hiring an sich, sondern die Reihenfolge. In vielen Fällen wird Hiring eingesetzt, um kurzfristig Druck rauszunehmen, obwohl das eigentliche Nadelöhr fehlende Klarheit ist. Wer einstellt, bevor Abläufe stabil sind, schafft zwar mehr Kapazität, skaliert aber auch Komplexität.

Prozesse als Voraussetzung für wirksames Wachstum

Prozesse werden in Start-ups häufig mit Bürokratie verwechselt. Tatsächlich sind sie das Gegenteil: Sie reduzieren Reibung. Gute Prozesse verlagern Entscheidungen vom Einzelfall ins System. Sie beantworten zwei zentrale Fragen zuverlässig: Was passiert als Nächstes – und wer ist verantwortlich?

Gerade kleine Teams profitieren davon besonders. Prozesse schaffen keine Starrheit, sondern Handlungsspielraum. Sie machen Arbeit vorhersehbar, Übergaben sauber und Entscheidungen reproduzierbar. Erst auf dieser Grundlage kann ein wachsendes Team seine Stärke wirklich entfalten.

Automatisierung im KI-Zeitalter: neue Möglichkeiten, neue Verantwortung

Mit KI hat sich die Eintrittshürde für Automatisierung massiv gesenkt. Viele Aufgaben, die früher manuell oder individuell erledigt wurden, lassen sich heute zuverlässig unterstützen oder teilweise abnehmen, vorausgesetzt, der zugrunde liegende Ablauf ist klar definiert. Entscheidend ist dabei nicht die Tool-Auswahl, sondern die Frage, was automatisiert wird. Automatisierung verstärkt bestehende Strukturen, gute wie schlechte. Wer unklare Abläufe automatisiert, skaliert keine Effizienz, sondern Chaos. Gleichzeitig gibt es zentrale Bereiche, die sich bewusst nicht oder nur sehr begrenzt automatisieren lassen und auch nicht sollten. Recruiting ist einer davon. Der Aufbau eines funktionierenden Teams lebt von persönlicher Einschätzung, Teamdynamik und kulturellem Fit. Ähnliches gilt für Sales: Vertrauensaufbau, Verhandlung und das persönliche Gespräch bleiben essenziell. Automatisierung ist hier unterstützend, aber kein Ersatz. Besonders geeignet sind Tätigkeiten, die häufig auftreten, wenig kreativen Spielraum haben und auf wiederkehrenden Informationen basieren.

Bereiche, die sich heute besonders gut automatisieren lassen

Lead- und Anfragequalifizierung

Unstrukturierte Anfragen lassen sich mithilfe von KI zusammenfassen, bewerten und priorisieren. Statt jede Anfrage manuell zu prüfen, entstehen klare Kriterien, die relevante von irrelevanten Leads trennen und Follow-ups vorbereiten.

Angebots- und Abrechnungsprozesse

Angebote, Verträge und Rechnungen folgen in vielen Startups ähnlichen Mustern. Automatisierte Vorlagen, angebundene Datenquellen und definierte Freigaben sparen Zeit, reduzieren Fehler und schaffen Transparenz.

Onboarding von Kund:innen und Mitarbeitenden

Onboarding ist kein Einzelfall, sondern ein wiederkehrender Prozess. Checklisten, automatische Aufgaben und zentrale Informationspunkte sorgen für Verlässlichkeit. KI kann helfen, Informationen zu strukturieren und kontextbezogen bereitzustellen.

Support und interne Anfragen

Ein Großteil von Fragen wiederholt sich. Wissensbasen in Kombination mit KI-gestützter Suche und Antwortvorschlägen entlasten Teams und machen sichtbar, wo Standards fehlen.

Projektmanagement und Übergaben

Klare Projekt-Templates, automatisierte Status-Updates und definierte Trigger reduzieren Abstimmungsaufwand. KI kann dabei unterstützen, Risiken früh zu erkennen oder nächste Schritte vorzuschlagen.

Was Start-ups daraus lernen können

Automatisierung ersetzt keine Entscheidungen, sie macht sie skalierbar. Voraussetzung dafür ist Klarheit über Abläufe, Verantwortlichkeiten und Prioritäten. Wer versucht, Chaos zu automatisieren, verstärkt es lediglich.

Hilfreiche Leitfragen sind:

- Welche Aufgaben wiederholen sich regelmäßig?

- Wo entstehen manuelle Engpässe?

- Welche Tätigkeiten binden qualifizierte Menschen ohne echten Mehrwert?

Die Antworten darauf liefern meist schnell die größten Hebel.

Der KI-Wendepunkt: Systeme und Personal

Nachhaltiges Wachstum entsteht dort, wo Start-ups Systeme aufbauen und diese bewusst mit ihrem Team verzahnen. Nicht, weil Systeme Menschen ersetzen, sondern weil sie Menschen von struktureller Überforderung entlasten. Automatisierung schafft dabei nicht nur Effizienz, sondern Entscheidungsqualität: Wenn Daten sauber fließen, Übergaben klar sind und Standards greifen, werden Prioritäten weniger Bauchgefühl und stärker reproduzierbar.

Der gezielte Einsatz von KI-Tools verschiebt diesen Wendepunkt zusätzlich. Sie können Routinearbeiten abfangen, Informationen aus unstrukturierten Inputs verdichten und Entscheidungen vorbereiten – etwa durch Lead-Vorqualifizierung, Support-Clustering oder zusammengefasste Status-Updates. KI wirkt dabei nicht als Ersatz für Klarheit, sondern als Verstärker funktionierender Prozesse.

Hiring bleibt auch weiterhin essentiell. Seine Wirkung entfaltet es jedoch erst dann vollständig, wenn Prozesse klar sind und Automatisierung sowie KI gezielt unterstützen. So entsteht Wachstum, das nicht nur schneller, sondern auch gesünder ist.

Der Autor Markus Hetzenegger ist Gründer & CEO von NYBA Media. 2018 gegründet, zählt NYBA heute zu den führenden Marketing-Unternehmen im Live-Entertainment.

Von der Kochbox zum Hundenapf: Ex-HelloFresh-Duo startet Tasty Petfood

Wie Lisa Vannini und Nadja Chylla mit ihrem Start-up Tasty Petfood die etablierten Premium-Tierfuttermarken herausfordern.

Das Berliner Start-up Tasty Petfood ist offiziell in den Markt eingetreten. Das Unternehmen, gegründet von den ehemaligen HelloFresh-Kolleginnen Lisa Vannini und Nadja Chylla, positioniert sich im Premium-Segment für Hundefutter und setzt dabei auf ein digitales Vertriebsmodell. Der offizielle Marktstart in Deutschland und der Schweiz erfolgte am 6. Februar 2026.

Transfer von Food-Logistik auf den Heimtiermarkt

Die Gründerinnen arbeiteten zuvor über fünf Jahre gemeinsam beim Kochboxen-Versender HelloFresh. Das dort in den Bereichen Skalierung und Operations gewonnene Know-how wollen Lisa und Nadja nun auf den Heimtiermarkt übertragen.

„Wir haben gemerkt, dass viele Hundehalter entweder bei klassischem Trockenfutter bleiben oder sehr viel Zeit in aufwendige BARF-Konzepte investieren müssen. Genau diese Lücke zwischen Bequemlichkeit und echter Qualität wollten wir schließen“, berichtet Lisa.

Das Kernprodukt von Tasty Petfood unterscheidet sich logistisch von herkömmlichem Nassfutter oder Barf-Angeboten: Das Unternehmen vertreibt dampfgegartes Frischfutter im Glas. Ein wesentlicher Unterschied zu vielen Wettbewerbern im Frische-Segment ist die Haltbarmachung: Die Produkte benötigen keine geschlossene Kühlkette und können ungekühlt gelagert werden. Dies reduziert die Komplexität in der Lagerhaltung und im Versand erheblich – ein Faktor, der im D2C-Bereich direkten Einfluss auf die Unit Economics hat. „Unser Anspruch war Qualität wie selbstgekocht – aber ohne Kühlschrank und ohne komplizierte Logistik. Dass wir Frische, Haltbarkeit und Alltagstauglichkeit verbinden können, ist für viele Kundinnen und Kunden ein echter Gamechanger“, sagt Nadja.

Wachstumskurs in einem Milliardenmarkt

Mit ihrem Geschäftsmodell stoßen die Gründerinnen in ein wirtschaftlich hochattraktives Umfeld vor. Nach aktuellen Daten des Industrieverbands Heimtierbedarf (IVH) und des Zentralverbands Zoologischer Fachbetriebe (ZZF) liegt der Gesamtumsatz der Branche bei rund sieben Milliarden Euro, wobei allein das Segment für Fertignahrung gut 4,4 Milliarden Euro ausmacht. Trotz allgemeiner wirtschaftlicher Herausforderungen bleibt die Zahlungsbereitschaft der Halter hoch.

Während der Absatz im Standard-Segment teils stagniert, wächst der Bereich für Premium-Nahrung kontinuierlich. Tasty Petfood ordnet sich im oberen Preissegment ein und zielt auf eine kaufkräftige Zielgruppe, die den Trend zur „Humanisierung“ des Haustiers vorantreibt.

„Hunde werden heute immer stärker als Familienmitglieder gesehen. Entsprechend steigen die Ansprüche an Transparenz, Zutatenqualität und Nährstoffversorgung – ähnlich wie beim eigenen Essen“, so Lisa.

Die Nische zwischen Konzern und Tiefkühltruhe

In diesem dynamischen Umfeld muss sich Tasty Petfood gegen zwei Lager behaupten. Zum einen konkurriert das Start-up mit etablierten Premium-Marken im stationären Handel wie Terra Canis, das als Pionier für „Human Grade“-Nahrung gilt und seit 2017 mehrheitlich zum Nestlé-Konzern gehört. Zum anderen wächst der Druck durch rein digitale Player wie Butternut Box oder HelloBello, die ebenfalls auf personalisiertes Frischfutter setzen, dieses jedoch tiefgekühlt versenden.

Genau hier besetzt Tasty Petfood eine strategische Lücke: Start-ups fungieren in diesem Sektor aktuell als wesentliche Innovationstreiber, und die Berliner Gründerinnen nutzen dies für eine „Ambient Fresh“-Strategie. Mit ungekühlt haltbarem Frischfutter verbindet das Unternehmen den steigenden Wunsch nach Convenience mit der Qualität von Frische-Menüs – ein entscheidender Logistik-Vorteil gegenüber der aufwendigen Tiefkühl-Konkurrenz. „Wir sitzen genau zwischen Tiefkühltruhe und Trockenfutter. Unser Futter ist reisefähig, blockiert keinen Gefrierschrank und passt damit perfekt in den Alltag moderner Hundehalter“, sagt Nadja.

Datengetriebenes Abo-Modell

Der Bestellvorgang für den/die Endkund*in ist vollständig datengestützt aufgebaut. Zu Beginn erfassen Interessent*innen über ein Online-Quiz relevante Parameter wie Rasse, Alter und Gewicht des Tieres. Auf Grundlage dieser Daten berechnet das Unternehmen einen individuellen Futterplan, der exakt auf den Hund zugeschnitten ist. Um die Akzeptanz zu testen, erhalten Neukund*innen zunächst eine Probebox mit verschiedenen Sorten. Bei erfolgreicher Annahme geht das Modell automatisch in ein flexibles Abonnement über, bei dem sowohl die Rationsgröße als auch der Lieferrhythmus dynamisch an den tatsächlichen Bedarf des Hundes angepasst werden. „Viele Halter sind unsicher, ob sie ihren Hund wirklich bedarfsgerecht füttern. Unser Algorithmus nimmt ihnen diese Entscheidung ab und sorgt dafür, dass Menge und Nährstoffe langfristig passen“, so Lisa.

Positionierung im Premium-Segment

Das Produktportfolio umfasst zum Start sechs Sorten auf Monoprotein-Basis. Durch den hohen Fleischanteil und den Verzicht auf Füllstoffe oder Konservierungsmittel zielt das Start-up auf die „Human Grade“-Nische ab. Das Produkt ist dabei so designt, dass es optisch und qualitativ an selbstgekochtes Futter erinnert, um die Hürde für qualitätsbewusste Käufer*innen zu senken. Das Kalkül: Die Zielgruppe sucht die Qualität einer BARF-Ernährung, benötigt aber die Convenience eines Fertigprodukts. „Unser Ziel ist es, Pet Nutrition durch sichtbare Qualität und Transparenz neu zu definieren“, so Nadja über den Anspruch, moderne Halterbedürfnisse mit dem Produkt-Design zu adressieren.

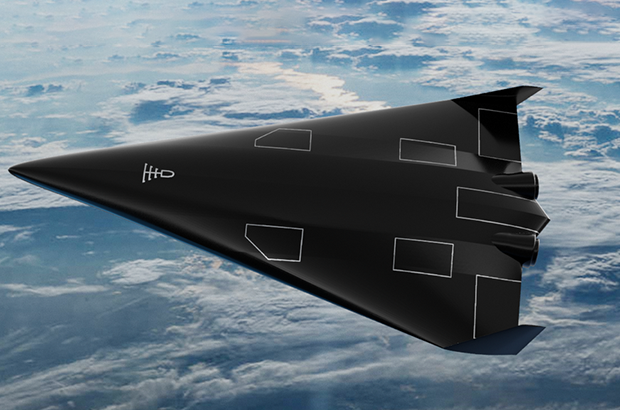

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

Die Wächter des Firmengedächtnisses

Wie das 2025 von Christian Kirsch und Stefan Kirsch gegründete Start-up amaiko den Strukturwandel im Mittelstand adressiert.

Der demografische Wandel und eine erhöhte Personalfluktuation stellen mittelständische Unternehmen zunehmend vor die Herausforderung, internes Know-how zu bewahren. Viele Unternehmen stehen vor der Schwierigkeit, dass Firmenwissen fragmentiert vorliegt. Informationen sind häufig in unterschiedlichen Systemen oder ausschließlich in den Köpfen der Mitarbeitenden gespeichert. Verlassen langjährige Fachkräfte den Betrieb in den Ruhestand oder wechseln jüngere Arbeitnehmerinnen und Arbeitnehmer kurzfristig die Stelle, gehen diese Informationen oft verloren. Zudem bindet die Suche nach relevanten Dokumenten in verwaisten Ordnerstrukturen Arbeitszeit, die in operativen Prozessen fehlt.

Das 2025 gegründete Start-up amaiko aus Niederbayern setzt hierbei auf einen technischen Ansatz, der auf die Einführung neuer Plattformen verzichtet und stattdessen eine KI-Lösung direkt in die bestehende Infrastruktur von Microsoft Teams integriert. Vor diesem Hintergrund entwickelten die Brüder Christian und Stefan Kirsch mit amaiko eine Softwarelösung, die spezifisch auf die Ressourcenstruktur mittelständischer Betriebe ausgelegt ist.

Integration statt neuer Insellösungen – und die Abgrenzung zu Copilot

Ein wesentliches Merkmal des Ansatzes ist die Entscheidung gegen eine separate Software-Plattform. Christian Kirsch, Geschäftsführer von PASSION4IT und amaiko, positioniert die Lösung als „Teams-native“. Das bedeutet, dass der KI-Assistent technisch in Microsoft Teams eingebettet wird – jene Umgebung, die in vielen Büros bereits als primäres Kommunikationswerkzeug dient. Ziel ist es, die Hürden bei der Implementierung zu senken, da Nutzer ihre gewohnte Arbeitsumgebung nicht verlassen müssen.

Angesichts der Tatsache, dass Microsoft mit dem „Microsoft 365 Copilot“ derzeit eine eigene, tief integrierte KI-Lösung ausrollt, stellt sich die Frage nach der Positionierung. Christian Kirsch sieht hier jedoch keine direkte Konkurrenzsituation, sondern eine klare Differenzierung: Copilot sei eine sehr breite, Microsoft-zentrische KI-Funktion. Amaiko hingegen verstehe sich als spezialisierter, mittelstandsorientierter Wissensassistent, der Beziehungen, Rollen, Prozesse und Unternehmenslogik tiefgreifend abbildet.

Ein entscheidender Vorteil liegt laut Kirsch zudem in der Offenheit des Systems: „Während Copilot naturgemäß an Microsoft‑Systeme gebunden ist, lässt sich amaiko herstellerunabhängig in eine viel breitere Softwarelandschaft integrieren – vom ERP über CRM bis zu Branchenlösungen. Unser Ziel ist nicht, Copilot zu kopieren, sondern reale Mittelstandsprozesse nutzbar zu machen“, so der Co-Founder.

Funktionsweise, Sicherheit und Haftung

Funktional unterscheidet sich das System von herkömmlichen Suchmasken durch eine agentenähnliche Logik. Die Software bündelt Wissen aus internen Quellen wie Richtlinien oder Projektdokumentationen und stellt diese kontextbezogen zur Verfügung. Ein Fokus liegt dabei auf der Datensouveränität. Hierbei betont Christian Kirsch, dass Kundendaten nicht in öffentlichen Modellen verarbeitet werden: „Die Modelle laufen in der europäischen Azure AI Foundry, unsere eigenen Dienste auf deutschen Servern. Die Daten des Kunden bleiben on rest vollständig im jeweiligen Microsoft‑365‑Tenant. Es findet kein Training der Foundation Models mit Kundendaten statt – weder bei Microsoft noch bei uns. Grundlage dafür sind die Azure OpenAI Non‑Training Guarantees, die Microsoft in den Product Terms sowie in SOC‑2/SOC‑3‑ und ISO‑27001‑Reports dokumentiert.“

Auch rechtlich zieht das Start-up eine klare Grenze, sollte die KI einmal fehlerhafte Informationen, sogenannte Halluzinationen, liefern. „Amaiko generiert Vorschläge, keine rechts‑ oder sicherheitsverbindlichen Anweisungen. Das stellen wir in unseren AGB klar: Die Entscheidungshoheit bleibt beim Unternehmen. Wir haften für den sicheren Betrieb der Plattform, nicht für kundenseitig freigegebene Inhalte oder daraus abgeleitete Maßnahmen. Es geht um eine saubere Abgrenzung – technische Verantwortung bei uns, inhaltliche Verantwortung beim Unternehmen“, so Christian Kirsch.

Geschäftsmodell und Markteintritt

Seit der Vorstellung der Version amaiko.ai im Juli 2025 wird das System nach Angaben des Unternehmens mittlerweile von über 200 Anwendern genutzt. Durch die Integration in die bestehende Microsoft-365-Landschaft entfällt für mittelständische Kunden eine aufwendige Systemmigration, was die technische Eintrittsbarriere gering hält.

Passend zu diesem Ansatz ist amaiko als reines SaaS-Produkt konzipiert, das Unternehmen ohne Einstiegshürde direkt online buchen können. Laut Kirsch sind keine Vorprojekte, individuellen Integrationspfade oder teuren Beratungspflichten notwendig: „Die Nutzung ist selbsterklärend und leichtgewichtig. Wer zusätzlich Unterstützung möchte – etwa zur Wissensstrukturierung oder Governance – kann sie bekommen. Aber die technische Einführung selbst ist bewusst so gestaltet, dass Mittelständler ohne Implementierungsaufwand starten können.“

Unterm Strich liefert amaiko damit eine pragmatische Antwort auf den drohenden Wissensverlust durch den demografischen Wandel: Statt auf komplexe IT-Großprojekte zu setzen, holt das bayerische Start-up die Mitarbeitenden dort ab, wo sie ohnehin kommunizieren. Ob sich die „Teams-native“-Strategie langfristig gegen die Feature-Macht von Microsoft behauptet, bleibt abzuwarten – doch mit dem Fokus auf Datensouveränität und mittelständische Prozesslogik hat amaiko gewichtige Argumente auf seiner Seite, um sich als spezialisierter Wächter des Firmengedächtnisses zu etablieren.

KI als neuer Ort für Kaufentscheidungen

Das Start-up publuence.ai zeigt am Beispiel der Automobilbranche, wie Marken in generativen KI-Antworten sichtbar werden und warum das zum neuen Erfolgsfaktor wird.

2025 haben wir euch das Start-up publuence.ai von Cevahir Ejder als "Gründer*in der Woche" präsentiert. Publuence.ai ist eine SaaS-Lösung für AI Search Analytics für Marken, die täglich analysiert, wie sichtbar Marken in generativen KI-Antworten sind: bei welchen Fragen erscheinen sie, wie werden sie erwähnt und welche Inhalte sowie Quellen beeinflussen die Antworten. Da die KI-Sichtbarkeit zunehmend darüber entscheidet, ob eine Marke in der engeren Auswahl der Konsumenten stattfindet, sind die Ergebnisse für Unternehmen strategisch sehr relevant.

Beispiel Automobilbrache: KI wird zum Verkaufsberater, Chatfenster zum Showroom

Während Marketing- und Kommunikationsbudgets weiterhin nach klassischen Logiken verteilt werden, fällt ein entscheidender Teil der Markenbildung inzwischen außerhalb des Mediaplans: KI-Systeme beantworten Kauf- und Vergleichsfragen oft lange bevor Kampagnen greifen. Anhand der Automobilbranche etwa, in der Marken wie Volkswagen für eine ganze Industrie stehen, zeigt sich, dass sich Sichtbarkeit im KI-Dialog zum neuen Machtfaktor entwickelt. Sie entscheidet zunehmend darüber, welche Hersteller überhaupt in die engere Auswahl kommen.

Was früher im Autohaus oder auf Herstellerwebsites stattfand, spielt sich heute in KI-gestützten Beratungsgesprächen ab. Nutzer*innen stellen dort Fragen wie: „Welche E-Autos sind familienfreundlich?“ „Wie gut ist die Reichweite im Winter?“ „Welche Modelle laden am schnellsten?“

In der Initialanalyse erzielt beispielsweise VW im Themenbereich E-Autos – je nach Fragestellung bzw. Prompt – Sichtbarkeitswerte zwischen 20 und 88 Prozent. Damit prägen die Antworten frühzeitig das Bild, das Konsument*innen von der Marke haben. Wer dort nicht vorkommt beziehungsweise seine Mehrwerte nicht sichtbar macht, wird in der Entscheidungsfindung schlicht nicht berücksichtigt.

Tesla und Hyundai vorn, VW im Mittelfeld

Das aktuelle Wettbewerbsranking der führenden Automobilhersteller – basierend auf 30 relevanten KI-Prompts rund um das Thema Elektromobilität – zeigt, wie präsent die einzelnen Marken im neuen digitalen Beratungsraum sind. Mit knapp 64 Prozent Sichtbarkeit führt Tesla klar und profitiert von seiner technologischen Positionierung sowie einer starken Medienpräsenz. Überraschend landet Hyundai insbesondere im E-Auto-Segment mit mehr als 58 Prozent dahinter. Volkswagen erreicht solide, aber deutlich ausbaufähige 51 Prozent.

Doch es geht nicht nur um Quantität, die Analyse zeigt auch, wo das Bild der Marken ins Wanken gerät. Im Fall von VW sind es vor allem Themen wie Winterreichweite, Ladeinfrastruktur und Schnellladekosten, die negative Ausschläge erzeugen. Diese kritischen Inhalte sind es allerdings, die die Markenwahrnehmung und dementsprechend auch die konkreten Kaufentscheidungen beeinflussen.

Die stille Macht der Quellen: Medien, die prägen

Eine zentrale Erkenntnis der Analyse von publuence.ai ist, dass KI-Systeme nicht auf Basis eines objektiven Querschnitts des Internets antworten. Vielmehr orientieren sie sich an bestimmten Medienquellen, deren Inhalte überproportional stark einfließen und so die Darstellung von Marken maßgeblich mitformen. Umso wichtiger ist es für Marken zu verstehen, auf welche Fragen sie reagieren müssen – und über welche vertrauenswürdigen Medien sie in den Wissensraum der KI gelangen.

Dabei zeigen sich je nach Medium erhebliche Unterschiede in der Tonalität. Während focus.de sowie adac.de E-Mobilität eher wohlwollend behandelt, sind andere Portale kritischer. Für Unternehmen bedeutet das: Wer verstehen will, wie KI über die eigene Marke spricht, muss wissen, welche Inhalte sie beeinflussen.

Warum Marken nicht an KI-Monitoring vorbeikommen

Publuence.ai bietet Unternehmen ein strukturiertes, datenbasiertes Werkzeug, um ihre Sichtbarkeit in KI-Systemen wie ChatGPT, Google oder Perplexity zu analysieren und darauf aufbauend gezielt zu steuern. Die Plattform zeigt, welche Fragen zur Marke führen, wie die Antworten ausfallen, welche Medien zugrunde liegen und wo Wettbewerber besser abschneiden.

Besonders wichtig ist die Identifikation von Content- und Sentiment-Gaps. Sie erkennt Themenfelder, in denen eine Marke kaum oder gar nicht auftaucht, obwohl sie dort relevant sein sollte. Gleichzeitig analysiert sie, ob etwas positiv, negativ oder neutral erwähnt wird. Dies macht publuence.ai für Kommunikations-, Marketing- und Markenverantwortliche zum zentralen Steuerungsinstrument. Nur wer versteht, wie KI antwortet, kann Inhalte gezielt darauf anpassen, Medienarbeit datenbasiert ausrichten und so die eigene Markenpräsenz dort stärken, wo die Entscheidungen heute vorbereitet werden.

KI-Sichtbarkeit wird zur Basis für Markterfolg

Cevahir Ejder, Gründer und GF der publuence GmbH, fasst zusammen: „Kaufentscheidungen beginnen heute und auch in Zukunft im Dialog mit KI-Systemen. Marken, die dort nicht auftauchen, sind raus.“ Volkswagen steht dabei stellvertretend für viele Unternehmen, die ihren Fokus noch auf klassische Marketingkanäle legen und den digitalen Showroom der KI bislang kaum berücksichtigen. Ejder warnt: „Wer jetzt nicht handelt, riskiert, neben Reichweitenverlusten, einen tiefgreifenden Bedeutungsverlust im Moment der Entscheidung.“

Optocycle: Bauschutt-Recycling auf KI-Basis

Die Optocycle-Gründer Max-Frederick Gerken und Lars Wolff Optocycle zeigen, wie aus Bauschutt neuer Rohstoff wird und erhalten dafür eine Förderung der Deutschen Bundesstiftung Umwelt (DBU).

Jährlich fallen in Deutschland laut Umweltbundesamt rund 86 Mio. Tonnen Schutt und Abfälle auf Baustellen an. Häufig landen diese Materialien auf Deponien. So gehen allerdings wertvolle Ressourcen verloren. Der Ausweg: Ein hochqualitatives Recycling des Schutts vermeidet klimaschädliche Emissionen und hält wertvolle Materialien im Wertstoffkreislauf – und das bei zertifiziert gleichwertiger Qualität.

Um das Recycling von Material im Bausektor zu automatisieren, entwickelt das 2022 von Max-Frederick Gerken und Lars Wolff gegründete Start-up Optocycle aus Tübingen ein System auf Grundlage künstlicher Intelligenz (KI) zum Echtzeit-Monitoring.

Echtzeit-Monitoring im Recycling-Prozess

Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit rund 170.000 Euro. Im Rahmen der DBU-Green Startup-Förderung haben die Gründer ein KI-basiertes System zur automatischen, reproduzierbaren Klassifizierung von Bauabfällen entwickelt. Darauf aufbauend soll nun ein Prototyp das Echtzeit-Monitoring von RC-Körnungen – also recycelten Gesteinskörnungen aus Bauschutt – ermöglichen.

„Aktuell basiert in der Branche der Aufbereitungsprozess von Bauschutt meist auf subjektiven Schätzungen“, so Max-Frederick Gerken. Auch das Endprodukt werde nur stichprobenartig im Labor überprüft. Mit dem System sei „Echtzeitmonitoring von Recycling-Gesteinskörnungen möglich. Somit können die Qualität der Körnung verbessert und mehr Material in die Beton-Produktion überführt werden“, so Gerken.

Die Qualität von Sekundärrohstoffen verbessern

Das System kombiniert laut Gerken moderne, optische Sensorik mit KI – und löse so ein altbekanntes Problem in der Baubranche. „Zurzeit schwankt oft die Beschaffenheit der recycelten Rohstoffe. Das bedeutet einerseits ein wirtschaftliches Risiko für Unternehmen und führt andererseits zum Verlust von wertvollen Materialien“, so Gerken. Optocycle erwartet mithilfe seiner Entwicklung eine 20 Prozent höhere Menge an recycelten, hochqualitativen Gesteinskörnungen sowie 15 Prozent geringere Abfallreste, die sonst auf Deponien landen würden. Dazu werden nach Gerkens Angaben sowohl der eingehende Schutt „optimal klassifiziert“ als auch das Ergebnis transparent überprüft. Kooperationspartner ist hierbei die Heinrich Feeß GmbH, die laut Gerken bereits seit vielen Jahren mit Optocycle zusammenarbeitet. Der Mitgründer weiter: „Die Technologie leistet einen Beitrag für Kreislaufwirtschaft im Bauwesen. Wir helfen dabei, die Qualität von Sekundärrohstoffen zu verbessern, die aus dem Bauschutt gewonnen werden. Diese Lösung lässt sich zudem perspektivisch auf alle Abfallströme übertragen."

Das System von Optocycle kann Gerken zufolge direkt in bereits bestehende Anlagen zur Verarbeitung von Bauabfällen installiert werden – „direkt über dem Fließband.“ Diese einfache Nachrüstung spare Kosten und ermögliche die schnelle Umsetzung eines innovativen Bauschutt-Recyclings. „Denn nur wenn das Recycling finanziell machbar ist, kann die Kreislaufwirtschaft in der Baubranche Erfolg haben“, so Gerken.

Kreislaufwirtschaft in der Baubranche ist aktiver Klimaschutz

Kreislaufwirtschaft in der Baubranche hat nach den Worten des zuständigen DBU-Referenten Dr. Volker Berding wichtige Effekte für den Klimaschutz: „Die Produktion von immer neuem Beton sorgt für hohen Ausstoß von klimaschädlichen Treibhausgasen.“ Einer WWF-Studie zufolge entstehen bei der Herstellung von Zement – dem wichtigsten Bestandteil von Beton – acht Prozent der gesamten globalen Treibhausgasemissionen. Berding: „Alles, was zur einer Emissionsreduzierung beiträgt, hat also bereits einen großen Effekt für den Klimaschutz.“ Eine Kreislaufwirtschaft funktioniere jedoch nur, „wenn die Sekundärrohstoffe sich qualitativ nicht von einer Neuproduktion unterscheiden. Genau diesen Schritt kann Optocycle mit einem skalierbaren, optimierten Prototypen gehen.“

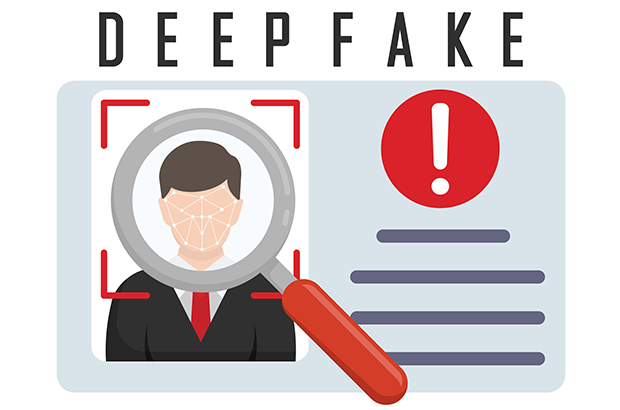

Social Engineering auf dem Vormarsch

Wie Deepfakes die Sicherheit von Führungskräften stärker in den Fokus rücken.

Fotorealistische KI liefert innerhalb von kürzester Zeit realistische Visuals. Was in vielerlei Hinsicht den Arbeitsalltag erleichtert, bedeutet für Social Engineering jedoch eine neue Eskalationsstufe, wie nicht zuletzt die hitzige Debatte um massenhaft sexualisierte Deepfakes von realen Personen durch Grok eindrücklich vor Augen führte.