Aktuelle Events

Digitale Zettelwirtschaft: Gefahren durch Tool-Hoarding

Warum Unternehmen die Gefahren des sog. Tool-Hoardings nicht unterschätzen sollten und wie sie dem Problem effizient und effektiv vorbeugen können.

In einer zunehmend digitalisierten Geschäftswelt ist der Einsatz spezialisierter Software zu einer Selbstverständlichkeit geworden. Für nahezu jede betriebliche Aufgabe gibt es mittlerweile ein passendes Tool, das verspricht, die Effizienz und Produktivität zu steigern. Dabei kann jedoch die Ansammlung von zu vielen verschiedenen Anwendungen, das sogenannte Tool-Hoarding, Risiken mit sich bringen, die häufig übersehen werden. Diese digitale Zettelwirtschaft führt nicht nur zu Ineffizienz und höheren Kosten, sondern kann auch die Datenqualität und -sicherheit gefährden. Ein bewusster Umgang mit Tools und eine kluge Integration sind daher notwendig, um die eigentlichen Ziele der Digitalisierung – nämlich Prozessoptimierung und Effizienzsteigerung – zu erreichen. Doch was ist zu tun, um die Gefahren des Tool-Hoardings nicht zu unterschätzen bzw. dem Phänomen vorzubeugen?

Das Phänomen des Tool-Hoardings

Unter Tool-Hoarding versteht man die unkontrollierte Ansammlung verschiedener spezialisierter Softwarelösungen, die oft ohne eine ganzheitliche Strategie implementiert werden. In vielen Fällen beginnt das Phänomen dabei unauffällig und schleichend: Ein Unternehmen führt ein Tool für die Buchhaltung ein, ein weiteres für die Projektverwaltung, dann ein separates System für das Kundenmanagement und schließlich eine Lösung für die interne Kommunikation. Jedes dieser Tools ist für sich genommen sinnvoll, erfüllt eine spezifische Aufgabe und soll Arbeitsprozesse vereinfachen. Doch wenn immer mehr spezialisierte Anwendungen hinzugefügt werden, ohne dass sie effizient miteinander integriert sind, entstehen unerwartete Herausforderungen.

Die Gründe für das Entstehen von Tool-Hoarding sind dabei vielschichtig. Allem voran steht häufig jedoch der Wunsch, für jede Herausforderung das „beste“ oder „modernste“ Tool zu verwenden. Unternehmen möchten ihre Mitarbeitenden mit den neuesten technischen Lösungen unterstützen, in der Hoffnung, dass diese den Arbeitsalltag vereinfachen und die Produktivität erhöhen. Doch oft wird dabei übersehen, dass zu viele separate Systeme am Ende eher das Gegenteil bewirken können oder es fehlt generell an der kompletten Übersicht. Die Verwaltung einer Vielzahl von Tools kann dann sogar zur Belastung werden, insbesondere wenn die Systeme nicht miteinander kommunizieren oder Daten manuell übertragen werden müssen. Ein weiteres Problem ist die fragmentierte Datenhaltung, die zu Fehlern und Inkonsistenzen führt. Im schlimmsten Fall hat dann die zuerst gut gemeinte Anschaffung sogar einen gegenteiligen Effekt: Denn je mehr Tools ein Unternehmen im Einsatz hat, desto geringer ist die Wahrscheinlichkeit, dass sie tatsächlich genutzt werden.

Die versteckten Kosten des Tool-Hoardings

Neben der offensichtlichen organisatorischen Komplexität birgt Tool-Hoarding auch finanzielle Risiken, die oft nicht sofort ersichtlich sind. Denn jede Softwarelösung bringt nicht nur Lizenzkosten mit sich, sondern erfordert auch regelmäßige Wartung, Updates und Schulungen für die Mitarbeitenden. Diese Kosten summieren sich schnell, insbesondere in Unternehmen, die für unterschiedliche Aufgaben verschiedene Tools einsetzen.

Darüber hinaus können versteckte Kosten entstehen, die auf den ersten Blick nicht offensichtlich sind. Beispielsweise wird der Zeitaufwand für die Pflege mehrerer Systeme oft unterschätzt. Mitarbeitende müssen sich in jedes Tool einarbeiten, Daten zwischen verschiedenen Anwendungen synchronisieren und bei Problemen den IT-Support kontaktieren. Dies führt zu einem erheblichen administrativen Aufwand und Unkosten, die den eigentlichen Nutzen der Tools schnell übersteigen kann.

Sicherheits- und Datenschutzrisiken

Neben den organisatorischen und finanziellen Aspekten bringt Tool-Hoarding auch Sicherheitsrisiken mit sich. Je mehr Tools ein Unternehmen verwendet, desto größer ist die Angriffsfläche für Cyberkriminelle. Insbesondere in Branchen, in denen mit sensiblen Daten gearbeitet wird, wie im Personalwesen oder im Finanzsektor, stellt dies ein erhebliches Risiko dar. Jedes zusätzliche Tool bedeutet ein weiteres Einfallstor für potenzielle Angriffe. Unzureichende Passwortsicherheit, veraltete Softwareversionen oder mangelhafte Zugangskontrollen können dann dazu führen, dass sensible Daten ungeschützt bleiben.

Ein weiteres Sicherheitsproblem entsteht wiederum durch die Fragmentierung der Daten. Wenn verschiedene Tools nicht optimal integriert sind, besteht die Gefahr, dass wichtige Informationen in unterschiedlichen Systemen gespeichert werden, ohne dass diese ausreichend gesichert oder synchronisiert sind. Dies kann nicht nur zu Datenverlusten führen, sondern auch die Einhaltung von Datenschutzbestimmungen erschweren. Insbesondere in Zeiten strengerer Datenschutzgesetze, wie der DSGVO, ist es für Unternehmen von entscheidender Bedeutung, den Überblick über ihre Daten zu behalten und sicherzustellen, dass diese jederzeit geschützt sind.

HR-Software als Beispiel für die Auswirkungen von Tool-Hoarding: Fluch oder Segen?

Ein besonders anschauliches Beispiel für das Problem bietet aktuell in vielen Firmen der HR-Bereich. Viele Unternehmen setzen insbesondere hier noch auf verschiedene Einzellösungen für Recruiting, Personalverwaltung, Schichtplanung, Zeiterfassung und Lohnabrechnung. Während jedes dieser Tools für sich genommen seine Funktion erfüllt, führt die parallele Nutzung oft zu den bereits genannten Herausforderungen. Beispielsweise müssen Personalabteilungen Daten manuell in verschiedene Systeme eingeben, da diese nicht ausreichend miteinander vernetzt sind. Das Ergebnis: Zeitverschwendung, höhere Fehleranfälligkeit und Frustration bei den Mitarbeitenden. HR-Verantwortliche tun also gut daran, sich vor der schlussendlichen Auswahl eines Tools einige Fragen zu stellen und vorhandene System zu hinterfragen: Werden die Daten der Zeiterfassung nahtlos in die Lohnabrechnungssoftware übertragen? Werden Urlaubs- und Krankheitsanfragen in der Schichtplanung berücksichtigt?

Gerade für Unternehmen, deren Mitarbeitende nicht klassisch am Schreibtisch zu finden sind, stellt zudem die Mobilfähigkeit der genutzten Software ein absolutes Muss dar. Denn oftmals haben Mitarbeitende in diesen Branchen nur über mobile Endgeräte wie Smartphones Zugang zu den Tools, sodass nicht mobil-optimierte Anwendungen schlichtweg nicht genutzt werden. Die Folge: Die erhoffte Effizienzsteigerung durch die Einführung der digitalen Lösungen bleibt ganz einfach aus.

Der Weg aus der Tool-Harding-Falle: Integration und Automatisierung

Unternehmen sollten demnach ihre Softwarelandschaft regelmäßig überprüfen und rationalisieren, um den negativen Auswirkungen des Tool-Hoardings zu entgehen. Anstatt für jede Aufgabe ein separates Tool zu verwenden, ist es oft sinnvoller, eine integrierte Lösung zu wählen, die mehrere Funktionen abdeckt. Dies reduziert nicht nur die Anzahl der verwendeten Tools, sondern erleichtert auch die Datenverwaltung und sorgt für eine einheitliche Benutzererfahrung.

Sind wiederum schon Tools vorhanden, auf die es aufzubauen gilt, ist dann wiederum ein zentraler Punkt die Integration neuer Lösungen in die vorhandenen Systeme. Eine nahtlose Datenübertragung zwischen den Tools und eine zentrale Verwaltung der Informationen sind entscheidend, um den administrativen Aufwand zu minimieren und gleichzeitig die Datensicherheit zu erhöhen. Unternehmen, die auf integrierte Plattformen setzen, profitieren von einem besseren Überblick über ihre Prozesse und können schneller auf Veränderungen reagieren. Generell gilt jedoch: Wenn zwei Tools durch eines ersetzt werden könnten, lohnt es sich oft, diese Möglichkeit zu prüfen.

Schlussendlich spielt dann auch die Automatisierung von Prozessen eine immer größere Rolle bei der Reduzierung des Tool-Hoardings. Mithilfe von künstlicher Intelligenz (KI) können Routineaufgaben wie die Dateneingabe oder die Verwaltung von Benutzerzugängen automatisiert werden, sodass weniger manuelle Eingriffe erforderlich sind. Dies entlastet nicht nur die Mitarbeitenden, sondern verringert auch die Notwendigkeit zusätzlicher Tools.

Fazit: Klasse statt Masse

Tool-Hoarding ist eine der unterschätzten Herausforderungen der digitalen Transformation. Unternehmen, die eine Vielzahl spezialisierter Softwarelösungen anhäufen, riskieren, dass die vermeintliche Effizienzsteigerung durch diese Tools in einem unübersichtlichen, ineffizienten Softwaredschungel verpufft. Um diesem Problem entgegenzuwirken, ist es wichtig, die eingesetzten Tools regelmäßig zu evaluieren und sicherzustellen, dass diese optimal integriert sind. Weniger ist hier oft mehr: Eine konsolidierte Softwarelandschaft, die alle wichtigen Funktionen abdeckt, sorgt dann nicht nur für eine bessere Übersicht, sondern senkt auch die Kosten und erhöht die Sicherheit. Unternehmen, die also frühzeitig auf integrierte, benutzerfreundliche Plattformen setzen, können die Effizienz ihrer Prozesse nachhaltig steigern und die Gefahren des Tool-Hoardings vermeiden. Denn letztendlich geht es bei der Digitalisierung nicht darum, möglichst viele Tools zu verwenden, sondern eben die richtigen.

Der Autor David Padilla ist Gründer und CEO von Kenjo, Anbieter einer HR-Software für Arbeitskräfte bzw. Mitarbeitende in Unternehmen, die nicht an einen Schreibtisch gebunden sind und New Work effizient praktizieren wollen.

MAxL: Der Vorgründungs-Turbo für die Biotech-Branche

Keine Gründung ohne präzise Vorbereitung: Mit dem Inkubator MAxL bringt BioM Biotech-Projekte aus dem akademischen Umfeld direkt auf den Radar von Venture-Capital und Pharma-Riesen. Christina Enke-Stolle und Dr. Petra Burgstaller – sie haben die Leitung des Gründungsbereichs bei der Biotech Cluster Management Organisation BioM inne – sprechen über die größten Hürden vor der Gründung, selektive Investoren und erste Millionen-Erfolgsstorys aus dem Inkubator.

Wie unterscheidet sich MAxL von anderen Inkubatoren, was zeichnet Ihren Inkubator besonders aus?

Enke-Stolle: Mit MAxL wollen wir für die vielversprechendsten Start-ups im Bereich der Biomedizin und Biotechnologie die besten Rahmenbedingungen schaffen, einerseits in Form von State-of-the-Art-Infrastruktur und andererseits mit einem umfassenden Unterstützungsprogramm. Das Besondere an MAxL ist die Fokussierung auf die Vorgründungsphase, also Projekte und Gründungsteams, die noch ein bis zwei Jahre vor der Ausgründung stehen. Wir haben uns mit MAxL zum Ziel gesetzt, die Teams in dieser entscheidenden Phase der Translation bestmöglich dabei zu unterstützen, die richtigen Entscheidungen zu treffen und ihre Projekte bereits frühzeitig auf die Anforderungen von Investoren und auch späteren Industriepartnern wie Pharmaunternehmen auszurichten. Im Rahmen der Inkubation durch MAxL sollen für Investoren attraktive Geschäftsmodelle entstehen und überzeugende, professionelle Datenpakete generiert werden. MAxL-Teams profitieren auch entscheidend vom umfassenden Netzwerk von BioM, sei es zu potenziellen Kunden, Industriepartnern als auch Investoren.

Worauf sollten angehende Gründer*innen beim Tech-Transfer von Biotech-Themen besonders achten, mit welchen Hürden müssen sie rechnen?

Burgstaller: Ganz entscheidend zu Beginn ist oft eine durchdachte IP-Strategie. Gerade in der Biotechnologie, wo die Entwicklung meist kapitalintensiv ist, sind belastbare Schutzrechte in der Regel ein zentraler Werttreiber. Hierzu bieten wir Teams Erstberatungen durch unsere ehrenamtlichen Patentmentoren an.

Enke-Stolle: Wichtig ist auch, ausreichend Zeit für die Gewinnung von Investoren einzuplanen und die Investoren zielgerichtet anzusprechen. Wir unterstützen unsere Teams bei der Erstellung von überzeugenden Pitch Decks und vermitteln persönliche Kontakte zu Investoren. Außerdem bieten wir ihnen über unsere Veranstaltungen die Möglichkeit, sich wirkungsvoll zu präsentieren. Im Rahmen unserer Eventserie „MAxL Meets the Money“ stellen Investoren sich und ihre Investmentstrategie außerdem in einem informellen Setting vor, sodass unsere Gründer auch den Blickwinkel und das Konzept von Venture Capital verstehen und den jeweiligen Fokus der wichtigsten Player kennen.

Burgstaller: Im Hinblick auf experimentelle Daten, die noch im akademischen Umfeld erhoben werden, und Entwicklungspläne ist es wie bereits erwähnt wichtig, die eigenen Projekte frühzeitig so auszurichten, dass sie Anforderungen aus der Industrie gerecht werden. Produkte wie neuartige Therapeutika sollten hier schon zu Beginn „vom Ende gedacht“ werden: Es geht nicht nur um die Frage „Können wir etwas wissenschaftlich Spannendes entwickeln?“, sondern um Fragen wie „Würde es jemand zulassen, bezahlen, einsetzen – und kaufen?“. Dabei setzen wir bei MAxL neben einer intensiven Begleitung durch unsere MAxL-Mentoren auch auf eine enge Zusammenarbeit mit Pharma. 2025 etwa haben wir eine Kooperation mit dem japanischen Pharmaunternehmen Daiichi Sankyo geschlossen. Daiichi unterstützt ein ausgewähltes Start-up im MAxL, indem es für zwölf Monate die Kosten für den Inkubator übernimmt und mit seinen Experten in der Wirkstoffentwicklung für Fragen des Start-ups zur Verfügung steht. Weitere solche „Golden Ticket-Kooperationen“ sind in der Anbahnung.

Nach welchen Kriterien wählt MAxL Start-ups für das Programm aus?

Burgstaller: Die beiden wichtigsten Kriterien sind ein innovatives Produkt- und Geschäftskonzept und ein talentiertes Gründerteam, dem wir zutrauen, das Konzept auch erfolgreich umzusetzen. Im Bereich der Therapeutikaentwicklung gibt es im Team idealerweise bereits Hands-on Erfahrung im Bereich Drug Development. Wenn das noch nicht der Fall ist, ist es entscheidend, dass das Team offen dafür ist, sich erfahrene Leute ins Team zu holen und/oder von erfahrenen Personen zu lernen.

Enke-Stolle: Bei Projekten, die ins MAxL ziehen möchten, muss schon ein erster Proof of Principle erbracht sein. Lediglich eine Idee zu haben, wäre zu früh für unseren Inkubator. Für das innovative Produkt sollte es einen hohen medizinischen Bedarf und klare Alleinstellungsmerkmale geben, und es sollte möglich sein, eine tragfähige Schutzrechtstrategie zu entwickeln. Die meisten der aktuellen MAxL-Projekte sind durch ein akademisches Pre-Seed- oder Validierungsförderprogramm finanziert. Wir unterstützen aber auch Spin-outs aus bestehenden Unternehmen, wenn Mittel vorhanden sind, um das Projekt in ein bis zwei Jahren experimentell und kommerziell so weiterzuentwickeln, dass ein entscheidender Meilenstein erreicht werden kann.

Burgstaller: Zudem haben Teams einen zusätzlichen Pluspunkt, wenn ihre Expertise und ihr Ansatz auch einen Mehrwert für aktuelle MAxL-Teams bieten und sich daraus spannende Synergien ergeben. Eines unserer Ziele im MAxL ist die Förderung von interdisziplinärer Zusammenarbeit, zum Beispiel zwischen Teams, die Wirkstoffe entwickeln, und solchen, die Algorithmen im Bereich der Wirkstoffentwicklung entwickeln.

Wie viele Start-ups hat MAxL bislang begleitet, welche Erfolgsstory erzählen Sie besonders gern?

Burgstaller: MAxL wurde im Juni 2024 eröffnet und hat seitdem nach und nach neue Teams aufgenommen. Inzwischen sind zehn Teams im MAxL; weitere Aufnahmen bereiten wir derzeit vor. Einen wichtigen ersten Meilenstein konnte nun Twogee Biotech erreichen. Das 2025 gegründete Start-up um Frank Wallrapp und Helge Jochens ist seit Herbst 2024 im MAxL und entwickelt maßgeschneiderte Enzymlösungen zur industriellen Verwertung von Biomasse zu nachhaltigen Rohstoffen. Vor Kurzem konnte Twogee erfolgreich eine Seed-Finanzierungsrunde über 2,16 Mio. EUR abschließen. Zu den Investoren zählen der High-Tech Gründerfonds (HTGF) und Bayern Kapital sowie strategische Partner. Das Team konnte auch bereits eine Reihe von Pilotkunden für seinen Ansatz gewinnen. Eine Erfolgsgeschichte des BioM-Angebots für Start-ups ist natürlich auch Tubulis: Das Unternehmen nahm 2015 am BioM BioEntrepreneur Bootcamp teil, erhielt 2017 den m4 Award und eine Förderung durch exist, wurde 2019 gegründet und konnte seitdem mit seinen innovativen Antibody-Drug-Conjugates für die Krebstherapie über 540 Mio. EUR einwerben.

Wie bewerten Sie das aktuelle Finanzierungsumfeld für frühphasige Biotech-Start-ups?

Enke-Stolle: Für sehr frühphasige Biotech-Start-ups ist das Finanzierungsumfeld aktuell weiterhin schwieriger als noch vor ein paar Jahren. Wie wir an Twogee sehen, ist es zwar nach wie vor möglich, erfolgreiche Seed-Finanzierungen einzuwerben, aber die Investoren sind momentan deutlich selektiver und risikoaverser. Für umso wichtiger halten wir es aktuell, die Teams mit Instrumenten wie MAxL möglichst früh professionell zu unterstützen, damit sie mit überzeugenden Datenpaketen und durchdachten Entwicklungsplänen im internationalen Wettbewerb gut aufgestellt sind.

Frau Burgstaller und Frau Enke-Stolle – vielen Dank für das Gespräch

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen: https://t1p.de/p8gop

Dezentrales Edge-Computing: Peeriot sichert sich Mio.-finanzierung für neuen IoT-Standard

Das Leipziger DeepTech-Start-up Peeriot sichert sich einen siebenstelligen Betrag, um den Marktstart seiner Open-Source-Lösung „Myrmic“ zu finanzieren. Doch die Etablierung eines neuen Infrastruktur-Standards ist ein ambitioniertes und riskantes Unterfangen.

Angeführt wird die Late-Seed-Finanzierungsrunde von den Altinvestor*innen Technologiegründerfonds Sachsen (TGFS) und der beteiligungsmanagement thüringen gmbh (bm|t), die Peeriot bereits 2024 mit 1,5 Millionen Euro unterstützt hatten. Neu eingestiegen ist das Business-Angel-Netzwerk Companisto. Das Kapital soll direkt in die Go-to-Market-Strategie für 2026 fließen: Im Fokus steht der Launch der Community-Version „Myrmic“. Die Monetarisierung soll im Anschluss über die kommerzielle Enterprise-Variante „EdgeVance“ erfolgen.

Das Team: Konzern-Know-how trifft Deep-Tech

Das 2022 gegründete Unternehmen wird von einem dreiköpfigen Gründerteam geführt, das fundierte Branchenerfahrung bündelt. CEO Ralf Hüskes verfügt über TelCo-Start-up-Erfahrung, während CFO Roy Kaiser Operations-Expertise aus einem Deep-Tech-Start-up sowie Konzern-Know-how einbringt. Komplettiert wird das Trio durch Mitgründer und Senior Developer Erik Junghanns, der die technische Umsetzung der komplexen Software-Architektur verantwortet. Diese Kombination verhalf dem Team bereits zu frühen Erfolgen bei regionalen Innovationspreisen und Pitch-Wettbewerben.

Das Problem: Fragmentierung als Kostentreiber

Der Markt für Industrial IoT und Edge-Computing wächst rasant, krankt aber an seiner extremen Fragmentierung. Die Vernetzung unterschiedlichster Hardware – vom simplen, ressourcenarmen Mikrocontroller (MCU) in einem Sensor bis zum leistungsstarken Edge-Server – erfordert derzeit massiven manuellen Integrationsaufwand. Die Resultate sind oft unflexible Systeme (Hardware-Lock-ins), die bei Skalierungen, Netzwerkausfällen oder Konnektivitätsänderungen versagen. Verschärft wird die Lage durch den EU Cyber Resilience Act, der künftig Update-Fähigkeit und höhere Sicherheit für Geräteflotten vorschreibt.

Der USP: Schwarmintelligenz statt zentralem Broker

Genau hier positioniert Peeriot sein Alleinstellungsmerkmal: Die Middleware abstrahiert die Hardware vollständig und ermöglicht eine echte, dezentrale Peer-to-Peer-Kommunikation.

- Ohne zentralen Server: Im Gegensatz zu klassischen Client-Server-Modellen oder zentralen Brokern organisieren sich die Geräte bei Peeriot selbständig zu widerstandsfähigen Netzwerken (Mesh) – ähnlich einem Insektenschwarm. Fällt ein Knotenpunkt aus, leitet das Netzwerk die Datenströme autark um (Self-Healing).

- Speichersicherheit durch Rust: Die gesamte Laufzeitumgebung ist in der Programmiersprache Rust geschrieben. Das garantiert eine extrem hohe Speicher- und Threadsicherheit und schützt vor klassischen Cyberangriffen, die auf Speicherlecks abzielen.

- Skalierbarkeit: Die Software läuft hardwareunabhängig auf kleinsten Mikrocontrollern ebenso wie auf großen Serverarchitekturen.

Die Herausforderung: Die Open-Source-Falle im B2B

Das Geschäftsmodell von Peeriot folgt der klassischen Open-Source-Strategie: Die Kerntechnologie (Myrmic) wird kostenlos an Entwickler abgegeben, um eine schnelle Marktdurchdringung zu erzielen. Umsätze sollen später über ein B2B-Subskriptionsmodell generiert werden, bei dem Enterprise-Kunden für die Version EdgeVance pro eingesetztem Gerät zahlen.

Der kritische Punkt dieses Modells ist die Conversion-Rate. Entwickler*innen nutzen Open-Source-Tools gern, doch der Schritt zum zahlenden Unternehmen erfordert lange Vertriebszyklen. Zudem birgt das „Pay-per-Device“-Modell bei industriellen IoT-Schwärmen mit zehntausenden Sensoren die Gefahr exponentiell steigender Kosten für den Endkund*innen. Peeriot muss beweisen, dass die Einsparungen bei der Wartung die laufenden Lizenzkosten übersteigen.

Der Wettbewerb

Peeriot agiert in einem hochkompetitiven Umfeld. Die größten Hürden sind die Bequemlichkeit der Industrie und die Dominanz der Tech-Giganten.

- Die Cloud-Konzerne: AWS (mit IoT Greengrass) und Microsoft (mit Azure IoT Edge) binden Kunden mit eigenen Edge-Lösungen tief in ihre Cloud-Ökosysteme ein.

- Direkte Middleware-Konkurrenz: Peeriot konkurriert mit etablierten IoT-Plattformen und Middleware-Anbietern wie dem deutschen Unternehmen HiveMQ (fokussiert auf MQTT-Broker), Real-Time Innovations (RTI) aus den USA oder europäischen Playern wie Cybus und Zerynth.

- Open-Source-Protokolle: Auch dezentrale Open-Source-Protokolle wie Eclipse Zenoh adressieren ähnliche Probleme im Edge-Routing.

Peeriots stärkstes Argument gegen diese Übermacht ist die radikale Cloud-Unabhängigkeit (Data Sovereignty) gepaart mit dem dezentralen Peer-to-Peer-Ansatz, der ohne fehleranfällige zentrale Broker auskommt.

Fazit: Infrastruktur statt App-Spielerei

Peeriot ist ein prägnantes Beispiel für europäisches DeepTech-Unternehmertum. Das Team wagt sich an ein fundamentales Infrastrukturproblem der Industrie 4.0. Die aktuelle Finanzierung verschafft den notwendigen Runway für den Produkt-Launch 2026. Gelingt der Aufbau der Entwickler-Community, könnte das Start-up eine neue Kategorie der Edge-Software etablieren. Findet die Open-Source-Lösung jedoch keine breite Akzeptanz, droht die technologisch anspruchsvolle Plattform in der Nische zu bleiben.

Smart Scaling: 3 konkrete Learnings für B2B- und Tech-Gründer*innen

Aus dem strategischen Ansatz von Peeriot lassen sich drei handfeste Manöver ableiten, die Start-ups bei der Skalierung im B2B-Umfeld helfen können:

1. Open-Source als trojanisches Pferd

Ein Kernprodukt an Entwickler*innen zu verschenken, ist ein bewährter Growth-Hack für maximale Marktdurchdringung. Aber eine aktive Community ersetzt keinen B2B-Vertriebsprozess. Peeriot muss beweisen, dass der Schritt von der kostenlosen Variante zum Enterprise-Modell funktioniert.

Learning: Definiert von Tag eins an glasklar, welchen monetären oder operativen Schmerz eure Enterprise-Version löst. In der Industrie zahlen Kunden selten für die reine Technologie, sondern für Service Level Agreements (SLAs) und einfache Wartung.

2. Die blinden Flecken der Tech-Giganten besetzen

Wer als Start-up versucht, gegen Tech-Giganten wie AWS oder Microsoft mit einem breiteren Funktionsumfang anzutreten, verliert. Peeriot wählt einen anderen Weg und fokussiert sich auf radikale Cloud-Unabhängigkeit und europäische Datensouveränität.

Learning: Findet den Schmerzpunkt eurer Zielgruppe, den die großen „Goliaths“ aufgrund ihres eigenen Geschäftsmodells (z.B. der Bindung an die eigene Cloud) strategisch nicht lösen können oder wollen.

3. Regulatorik als Vertriebsturbo nutzen

Lange B2B-Sales-Zyklen sind der Tod vieler Start-ups. Wer sein Produkt jedoch geschickt an neue gesetzliche Vorgaben (wie bei Peeriot den EU Cyber Resilience Act) ankoppelt, schafft sofortige Dringlichkeit bei der Kundschaft.

Learning: Verknüpft eure Lösung nach Möglichkeit direkt mit aktueller Regulatorik. Hilft euer Produkt dem/der Kund*in, gesetzliche Strafen zu vermeiden oder Compliance-Kosten zu senken, wandert es auf der Prioritätenliste des Einkaufs automatisch ganz nach oben.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

Cyber Security Report 2026

Ein aktueller Report zur Cybersicherheit in Deutschland zeigt, dass viele Unternehmen ihre Vorbereitung auf Cyber-Risiken überschätzen. Für Start-ups und Scale-ups ergeben sich daraus wichtige strategische Aufgaben. Neben der neuen NIS-2-Regulierung, die auch schnellwachsende Unternehmen treffen kann, rückt die IT-Sicherheit zunehmend in den Fokus von B2B-Kund*innen und Investor*innen.

Der auf der Cyber Security Conference 2026 in Heilbronn vorgestellte Cyber Security Report 2026 von Schwarz Digits liefert aufschlussreiche Daten zur Sicherheitslage der deutschen Wirtschaft. Obwohl die branchenübergreifenden IT-Sicherheitsbudgets auf mittlerweile 17 Prozent der IT-Gesamtausgaben steigen, offenbart die repräsentative Erhebung unter rund 1.000 deutschen Firmen, dass Maßnahmen oft eher reaktiv erfolgen.

Für die Start-up-Szene zeigen sich dabei spezifische Handlungsfelder, die im Wachstumsalltag schnell untergehen.

Wachstum und Regulierung: Die Anforderungen von NIS-2 im Blick behalten

Die EU-Richtlinie zur Netz- und Informationssicherheit (NIS-2) wird oft als reines Thema für Großkonzerne und kritische Infrastrukturen wahrgenommen. Der Report zeigt jedoch, dass branchenübergreifend 48 Prozent der befragten Unternehmen ihre regulatorische Betroffenheit voraussichtlich falsch einschätzen.

Dies betrifft zunehmend auch Scale-ups: Erreicht ein Unternehmen mit 10 bis 49 Mitarbeitern einen Jahresumsatz von über 10 Millionen Euro, fällt es – je nach Sektor – in den Anwendungsbereich der strengen Richtlinie. In diesem Größensegment gehen laut Report aktuell 92 Prozent der Firmen fälschlicherweise davon aus, nicht betroffen zu sein. Wer als Scale-up unter das in Deutschland greifende Umsetzungsgesetz fällt, muss strenge Meldepflichten und Risikomanagement-Maßnahmen etablieren. Da die Geschäftsführung bei Versäumnissen künftig verstärkt in die persönliche Haftung genommen werden kann, ist eine frühzeitige rechtliche Prüfung des eigenen Status dringend ratsam.

Die Lieferkette im Fokus: Cyber-Resilienz als B2B-Wettbewerbsvorteil

Auch Start-ups, die nicht direkt unter NIS-2 fallen, spüren die Auswirkungen häufig indirekt. Laut Erhebung hat bereits jedes zweite Unternehmen Angriffe auf seine Zulieferer registriert. Bisher überprüfen allerdings 75 Prozent der Firmen ihre Partner*innen nicht regelmäßig auf IT-Sicherheit.

Das dürfte sich durch den aktuellen regulatorischen Druck bald ändern. Konzerne und regulierte Unternehmen müssen ihre Lieferketten stärker absichern und fordern zunehmend vertragliche IT-Sicherheitsnachweise von ihren Start-up-Dienstleistern und SaaS-Anbietern ein. Gründer*innen, die hier proaktiv eine saubere Cyber-Resilienz und idealerweise den Einsatz digital-souveräner, europäischer Lösungen nachweisen können, haben in Enterprise-Pitches und bei Beschaffungsprozessen klare Vorteile.

Künstliche Intelligenz: Chancen nutzen, Sicherheitsaspekte mitdenken

Künstliche Intelligenz ist ein zentraler Treiber vieler moderner Start-up-Geschäftsmodelle. Den Sicherheitsaspekt beim KI-Einsatz schätzen viele kleine und mittlere Unternehmen (KMU) jedoch noch zu gelassen ein: 54 Prozent der Befragten gehen davon aus, dass KI-Anwendungen die eigene Cyber-Bedrohungslage nicht wesentlich verändern.

IT-Sicherheitsexperten warnen im Report jedoch vor neuen Angriffsvektoren wie autonomen KI-Angriffen oder der gezielten Manipulation von KI-Modellen (sogenannte Prompt-Hacks). Während 73 Prozent der Großunternehmen bereits klare Regeln für den KI-Einsatz definiert haben, fehlt es bei knapp einem Viertel der kleineren Unternehmen noch an internen Richtlinien. Für Start-ups empfiehlt es sich daher, das Prinzip „Security-by-Design“ von Beginn an in die eigene KI-Entwicklung und die interne Nutzung von KI-Tools zu integrieren.

Fazit

Cybersicherheit ist mehr als nur ein technisches Thema für die IT-Abteilung – sie ist ein geschäftskritischer strategischer Baustein. Start-ups, die Security- und Compliance-Anforderungen frühzeitig und professionell in ihr Wachstum integrieren, beugen nicht nur Risiken vor, sondern schaffen eine verlässliche Basis für das Vertrauen von B2B-Kund*innen, Partner*innen und Investor*innen.

Praxis-Check: Fällt mein Start-up unter die NIS-2-Richtlinie?

Ob ein Unternehmen die strengen Vorgaben der NIS-2-Richtlinie (bzw. des deutschen Umsetzungsgesetzes NIS2UmsuCG) direkt erfüllen muss, lässt sich grob in vier Schritten prüfen:

- Die Branchen-Frage: Ist das Start-up in einem der 18 kritischen Sektoren aktiv? Für Tech-Start-ups besonders relevant: Dazu zählen nicht nur klassische Felder wie Energie oder Gesundheit, sondern auch Digitale Infrastruktur (Cloud-Computing-Dienste, Rechenzentren), Managed IT-Services (MSP/MSSP) und Digitale Anbieter (Online-Marktplätze, Suchmaschinen).

- Die Größen-Frage: Beschäftigt das Unternehmen mindestens 50 Mitarbeitende oder erzielt es einen Jahresumsatz bzw. eine Jahresbilanzsumme von mehr als 10 Millionen Euro? (Achtung: Hier greift oft die erwähnte Falle für schnell wachsende Scale-ups mit wenigen Mitarbeitenden, aber hohem Umsatz).

- Die Ausnahmen (unabhängig von der Größe): Bietet das Start-up spezielle Dienste an (z. B. qualifizierte Vertrauensdienste, öffentliche Telekommunikationsnetze oder ist es der einzige Anbieter eines essenziellen Dienstes)? In diesen Sonderfällen greift NIS-2 ab dem ersten Mitarbeitenden.

- Die indirekte Betroffenheit: Selbst wenn Punkt 1 bis 3 nicht zutreffen – beliefert das Start-up große B2B-Kund*innen, die unter NIS-2 fallen? Wenn ja, werden die Sicherheitsanforderungen zunehmend über Verträge und Audits an das Start-up „durchgereicht“.

Tipp: Das Bundesamt für Sicherheit in der Informationstechnik (BSI) bietet online interaktive Formulare zur genauen Betroffenheitsprüfung an. Bei Unklarheiten lohnt sich der frühzeitige Rat eines/einer IT-Rechtsexpert*in.

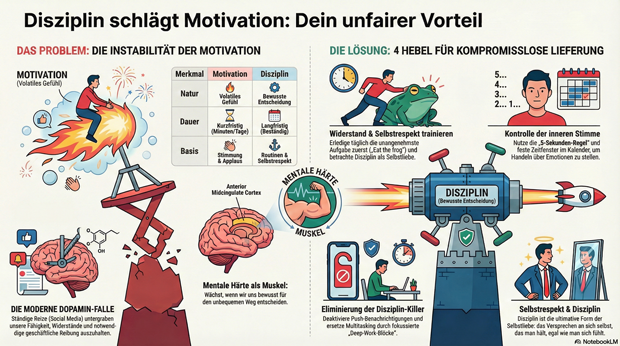

Gründen heißt liefern: Warum Disziplin wichtiger ist als jeder Motivationsschub

Motivation bringt dich an den Start, aber Disziplin hält dich im Rennen. Wenn die erste Euphorie verfliegt und der harte Business-Alltag mit Rückschlägen und Akquise-Druck zuschlägt, trennt sich bei Gründer*innen schnell die Spreu vom Weizen. Gastautor Timo Sven Bauer zeigt, warum eiserne Routinen wichtiger sind als jeder flüchtige Motivationsschub und mit welchen vier Hebeln du die mentale Härte aufbaust, um auch dann kompromisslos zu liefern, wenn der Applaus ausbleibt.

Jede(r) Gründer*in startet sein/ihr Vorhaben zunächst mit einer klaren Vision. Man ist voller Energie und spürbarer Begeisterung. Doch auf diese erste Euphorie folgt unweigerlich der harte Business-Alltag. Plötzlich stehen Produktentwicklung, scheinbar endlose Problemketten, mühsame Akquise, schmerzhafte Ablehnung, wachsender Cashflow-Druck und nervenaufreibende Investoren-Pitches auf der Tagesordnung. Spätestens in dieser Phase zeigt sich, wer tatsächlich bereit ist, den hohen Preis des Erfolgs zu bezahlen. Als Gründer*in muss man genau dort weitermachen, wo selbst sehr ambitionierte Angestellte längst aufhören Es gilt: Wer gründet, muss die notwendigen Dinge erledigen – und zwar völlig losgelöst davon, wie er oder sie sich in diesem Moment fühlt.

Motivation vs. Disziplin

Genau hier liegt das fundamentale Problem der Motivation. Motivation ist lediglich ein Gefühl, das starken Schwankungen unterliegt. Manchmal hält sie eine ganze Woche an, manchmal verfliegt sie nach nur fünf Minuten, und an manchen Tagen taucht sie überhaupt nicht erst auf. Da Gefühle extrem volatil sind, ist es nur eine Frage der Zeit, bis man das Handtuch wirft, wenn man das eigene Business von der aktuellen Gemütslage abhängig macht. Motivation mag ein hilfreicher Antrieb für den Start sein, doch es ist die Disziplin, die dafür sorgt, dass man auch langfristig am Ball bleibt.

Denn im Gegensatz zum wankelmütigen Gefühl der Motivation ist Disziplin eine bewusste Entscheidung. In der Praxis bedeutet das beispielsweise, das Minimum Viable Product (MVP) komplett neu aufzusetzen, nachdem die Zielgruppe die ursprüngliche Idee nicht verstanden hat. Es bedeutet, Akquise-Anrufe zu tätigen, obwohl man absolut keine Lust darauf hat, und kontinuierlich Content zu produzieren, selbst wenn der Applaus des Publikums ausbleibt. Ebenso erfordert es eiserne Disziplin, bei Investor*innen nachzufassen, obwohl man bereits 87 Absagen kassiert hat. Wahrer Erfolg entsteht eben nicht aus einer guten Stimmung heraus, sondern durch unermüdliche Wiederholung.

Gefangen in der Dopamin-Falle

Dass uns Disziplin heute oft schwerer fällt als je zuvor, liegt an unserer modernen Welt der sofortigen Belohnungen. Ein kurzes Scrollen, ein schneller Like, eine eingehende Nachricht oder die nächste Episode der Lieblingsserie liefern uns verlässliche Dopamin-Kicks. Das fatale Problem dabei ist, dass sich unser Gehirn an diese ständige Reizüberflutung gewöhnt. Verhaltenspsychologen warnen in diesem Zusammenhang vor der sogenannten Dopamin-Falle. Diese sofortige Befriedigung wirkt auf den ersten Blick harmlos, doch sie untergräbt langfristig unsere essenzielle Fähigkeit, Widerstände und Reibung auszuhalten. Dabei ist genau diese Toleranz der Kern jeden unternehmerischen Erfolgs. Gründer*in müssen in der Lage sein, unklare Phasen zu überstehen, Umsatztäler zu durchschreiten sowie mit Kritik und Ablehnung professionell umzugehen. Wer stattdessen kontinuierlich nach schnellen Belohnungen greift, verliert unweigerlich die notwendige Ausdauer für den langfristigen Aufbau eines Unternehmens. Um als Gründer*in umgehend mehr Disziplin aufzubauen, gibt es vier konkrete Hebel.

Hebel 1: Disziplin als Ausdruck von Selbstrespekt begreifen

Zunächst muss man verinnerlichen, dass Selbstdisziplin keineswegs eine Bestrafung oder starre Maßregelung darstellt. Vielmehr ist sie ein Ausdruck von tiefem Respekt vor dem eigenen Potenzial. Romantisch betrachtet könnte man Selbstdisziplin sogar als eine Form der Selbstliebe bezeichnen. Wer sich selbst und seine Ambitionen ernst nimmt, behandelt seine Ziele nicht als bloße Option. Daher sollte die entscheidende Frage am Morgen niemals lauten, worauf man heute Lust hat. Die einzig zielführende Frage lautet stattdessen, was einen der eigenen Vision heute ein konkretes Stück näherbringt.

Hebel 2: Das Widerstandszentrum gezielt trainieren

Ein weiterer wichtiger Aspekt ist das Training des eigenen Widerstandszentrums. In unserem Gehirn existiert ein Bereich namens "anterior midcingulate cortex", der ähnlich wie ein Muskel funktioniert und wächst, wenn wir Aufgaben bewältigen, die hart für uns sind. Disziplin fällt uns zunehmend leichter, wenn wir uns regelmäßig und ganz bewusst für den unbequemen Weg entscheiden. Für den Gründungsalltag bedeutet das nach dem "eat the frog"-Prinzip, jeden Tag die unangenehmste Aufgabe zuerst zu erledigen. Man sollte täglich Akquise und umsatzbringende Maßnahmen priorisieren, anstatt sich in angeblichem Perfektionismus und endlosem Produkt-Feinschliff zu verlieren.

Ebenso wichtig ist es, Start-up-Events zu besuchen und dort proaktiv das Gespräch mit Investoren zu suchen. Wer es sich stets leicht macht, wird niemals wachsen. Schließlich verdienen diejenigen, die nur kleine Probleme lösen, auch nur kleines Geld, während jene, die große Probleme lösen, ganze Märkte verändern können. Man muss sich nur vor Augen führen, wie immens groß die Probleme von Elon Musk sind oder welche Herausforderungen Steve Jobs bewältigen musste, um aus einer kleinen Garage heraus eine der wertvollsten Marken der Welt zu formen.

Hebel 3: Die innere Stimme kontrollieren

Ein massives Hindernis auf dem Weg zur Disziplin ist oft unsere eigene innere Stimme. Sie möchte uns eigentlich schützen, bewirkt damit aber ironischerweise genau das Gegenteil und hält uns klein. Da unser Gehirn Ablehnung fälschlicherweise mit einer echten Gefahr verwechselt, produziert es hemmende Gedanken. Es redet uns ein, potenzielle Kontakte gar nicht erst anzusprechen, da sie ohnehin kein Interesse hätten. Es empfiehlt uns, lieber noch zu warten, bis wir mehr vorweisen können, oder warnt uns davor, dass der anstehende Cold Call ohnehin nur peinlich wird.

Um diese Stimme zu steuern, helfen drei konkrete Schritte. Zunächst muss man solche Gedanken aktiv entlarven und sich bewusst machen, dass sich hier lediglich das alte Steinzeit-Gehirn meldet, aber keine reale Gefahr vorliegt. Anschließend greift man auf die Methode aus Mel Robbins' Buch "The 5 Second Rule" zurück: Man zählt von fünf rückwärts und kommt sofort ins Handeln, ohne Raum für Ausreden zu lassen. Ergänzend dazu ist es elementar, feste Routinen zu bauen, denn diese sind stets stärker als flüchtige Emotionen. Wenn beispielsweise dienstags und donnerstags von 10 bis 11.30 Uhr feste Akquise-Zeiten im Kalender stehen, gilt dies als absolut fix und nicht verhandelbar.

Hebel 4: Typische Disziplin-Killer konsequent eliminieren

Zu guter Letzt bedeutet mehr Disziplin immer auch weniger Selbstsabotage. Das gelingt am besten, indem man die klassischen Disziplin-Killer im Gründungsalltag eliminiert. Dazu zählen Multitasking, das permanente Checken des Smartphones, die ständige Jagd nach Social-Media-Dopamin, die Erwartung dauerhafter Erreichbarkeit sowie Meetings, die ohne klares Ergebnis verlaufen. Jede dieser ständigen Unterbrechungen trainiert uns lediglich darauf, zu reagieren, anstatt selbst die Richtung vorzugeben.

Um dem effektiv entgegenzuwirken, sind konkrete Maßnahmen gefragt. Push-Benachrichtigungen sollten konsequent deaktiviert und das Handy außer Reichweite gelegt werden. Social Media hat nur in klar definierten Zeitfenstern Platz, während für fokussiertes Arbeiten sogenannte Deep-Work-Blöcke fest im Kalender verankert werden müssen. Zudem sollten schlichtweg keine Meetings mehr ohne vorab definierte Agenda und ohne klares Ziel stattfinden. Letztlich entsteht Disziplin deutlich leichter, wenn man Versuchungen durch klare Strukturen von vornherein erschwert.

Warte also nicht darauf, dass du dich irgendwann motiviert fühlst. Baue stattdessen belastbare Systeme, eiserne Routinen und echte mentale Härte auf. Mit jedem Mal, wenn du dich ganz bewusst für die Disziplin und gegen die Ablenkung entscheidest, entwickelst du dich ein Stück weiter zu der Person, die Investoren restlos überzeugt, Kund*innen magisch anzieht und ein Unternehmen mit echter Substanz formt. Disziplin ist somit kein lästiger Nachteil. Sie ist dein absolut unfairer Vorteil.

Der Autor Timo Sven Bauer zählt zu den bekanntesten Verkaufstrainern in der DACH-Region, ist Mitgründer zahlreicher Start-ups sowie Buchautor, www.soldbybauer.com

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

MedTech-Start-up RAYDIAX holt 7,5 Mio. Euro für neuartiges CT-System

RAYDIAX sichert sich 7,5 Mio. Euro, um mit einem speziell für minimal-invasive Eingriffe entwickelten Computertomographen die Krebsbehandlung zu verbessern. Doch der Weg vom universitären Forschungslabor in die globalen Operationssäle ist im hochregulierten Gesundheitsmarkt lang. Ein Blick auf ein DeepTech-Geschäftsmodell, das sich nun in der klinischen Praxis beweisen muss.

Die erfolgreiche Series-A1-Finanzierungsrunde über 7,5 Millionen Euro für RAYDIAX markiert einen wichtigen Meilenstein von der universitären Forschung in den Gesundheitsmarkt. Das 2022 gegründete Unternehmen mit Hauptsitz im Magdeburger Wissenschaftshafen ist eine Ausgründung des Forschungscampus STIMULATE und der Otto-von-Guericke-Universität Magdeburg. Unter der Führung eines fünfköpfigen Gründerteams – bestehend aus CEO Dr. Thomas Hoffmann, Dr. Tim Pfeiffer, Dr. André Mewes, Benjamin Fritsch und Robert Frysch – konnte das Start-up nach einer erfolgreichen Seed-Phase nun erhebliche Mittel für den Eintritt in die klinische Phase sichern.

Das frische Kapital setzt sich aus 5 Millionen Euro Venture Capital von bestehenden Business Angels, dem Bestandsinvestor bmp Ventures mit den IBG Fonds sowie dem neu eingestiegenen GETEC Family Office um Dr. Karl Gerhold zusammen. Ergänzt wird diese Summe durch 2,5 Millionen Euro Fördermittel aus dem hochkompetitiven EIC Accelerator-Programm der Europäischen Kommission, das gezielt disruptive Deep-Tech-Innovationen mit hohem Skalierungspotenzial unterstützt.

TACT: Computertomographie für den OP neu gedacht

Im Zentrum dieser ambitionierten Wachstumspläne steht der Therapieassistenz-Computertomograph „TACT“, den RAYDIAX dediziert für minimal-invasive Krebstherapien entwickelt. Anders als herkömmliche CTs optimiert das Unternehmen sein System sowohl im Hardware- als auch im Softwarebereich speziell für den interventionellen Einsatz bei der Therapieplanung, -durchführung und -kontrolle. Wie Steffen Schmidt, CFO der GETEC-Gruppe, hervorhebt, ermöglicht die innovative Technologie eine fokussierte Live-Bildgebung, welche die Strahlenbelastung für Patient*innen und Operateur*innen senkt und die Operationszeit verringert.

Zudem bietet das System durch eine größere Geräteöffnung völlig neue Operationsmethoden im CT, wie beispielsweise den Einsatz von Robotik. Der Markt für solche Lösungen wächst, da minimal-invasive Eingriffe angesichts einer alternden Bevölkerung und steigender Krebsinzidenzen massiv an Bedeutung gewinnen. Sie ermöglichen in vielen Fällen eine schonendere Behandlung im Vergleich zu offenen chirurgischen Eingriffen, verkürzen potenziell Operations- sowie Liegezeiten, verringern Komplikationen und können so zusätzliche Behandlungskapazitäten schaffen, um die Krankenhausstrukturen zu entlasten.

Harter Wettbewerb und regulatorische Hürden

Trotz der vielversprechenden Technologie steht das Geschäftsmodell in der Praxis vor erheblichen Herausforderungen. Der globale Markt für medizinische Bildgebung ist hart umkämpft, und der Vertrieb an Kliniken ist durch extrem lange, hochkomplexe B2B-Entscheidungszyklen geprägt. RAYDIAX tritt diesem Wettbewerb entgegen, indem es anstrebt, eine funktional dringend benötigte, neue Gerätekategorie in der interventionellen Onkologie zu etablieren, um so eine Lücke im OP-Betrieb zu füllen.

Der Beweisdruck auf dem jungen Unternehmen ist dennoch enorm: Das neu eingeworbene Kapital wird nun für First-in-Human-Studien eingesetzt, um die frühe klinische Evidenz am Patienten zu generieren. Diese Phase legt die Grundlage für die regulatorische Zulassung und kommerzielle Skalierung. Parallel dazu erfordert die Weiterentwicklung zur Serienreife einen konsequenten Ausbau in den Bereichen Vertrieb, Produktion und Qualitätsmanagement, um die ersten kommerziellen Installationen systematisch vorzubereiten.

Lehrstück für europäisches DeepTech

Dieser Fall zeigt eindrucksvoll die Realität und die hohen Anforderungen europäischen DeepTech-Unternehmertums. Der Abschluss dieser Finanzierungsrunde belegt deutlich, wie essenziell die intelligente Kombination aus wissenschaftlicher Grundlagenforschung, klassischem Risikokapital und strategischen europäischen Fördergeldern ist. Nur so lässt sich die extrem kapitalintensive Entwicklungsphase von Hardware in der Medizintechnik erfolgreich überstehen. Wenn es dem Gründerteam nun gelingt, die klinische Wirksamkeit in der Praxis zu belegen und die regulatorischen Hürden zu meistern, hat dieses Spin-off das Potenzial, die Anwendung minimal-invasiver Krebstherapien erheblich auszuweiten.

eeden: Die Alchemie der Altkleider

Das Münsteraner Unternehmen eeden verwandelt Textilmüll in hochwertige Rohstoffe. Mit Millioneninvestments baut das Team um Steffen Gerlach und Tobias Börnhorst nun die erste Demonstrationsanlage auf.

Steffen Gerlach saß entspannt mit seinem Schulfreund Reiner Mantsch auf einer Couch in einer Kölner Wohngemeinschaft. Mantsch hatte zuvor an der Universität in Mönchengladbach Textiltechnik studiert. Er berichtete leidenschaftlich von seinen naturwissenschaftlichen Forschungen zur Kreislaufwirtschaft. Dieses Gespräch veränderte Gerlachs gesamte berufliche Planung radikal. Mantsch suchte jemanden für die Marktseite seiner technischen Vision. Gerlach war sofort fasziniert von dem ökonomischen Potenzial. Er wollte wissen, ob man daraus ein echtes Unternehmen formen kann. „Das war der eigentliche Startpunkt für eeden. Wir entschieden uns für einen vollen Fokus auf das Projekt. Und wir wollten das Recyclingproblem der Branche grundlegend lösen“, erinnert sich Gerlach.

Der langsame Weg zum technologischen Durchbruch

Es gab keinen plötzlichen Heureka-Moment in einem winzigen und improvisierten Labor. Die Entwicklung war eher eine gezielte Suche nach einer Problemlösung. Mantsch war früher Leistungssportler und brachte den nötigen Fokus mit. Er sah den Frust seiner Kommilitonen nach Praktika in der Industrie. Die Branche wirkte starr und wenig dynamisch für junge Talente. Das Duo suchte stattdessen nach den Megatrends der Zukunft. „Die Kreislaufwirtschaft kristallisierte sich schnell als das zentrale Thema heraus. Ich habe die Marktseite intensiv analysiert und viele Gespräche geführt“, so Gerlach. Er erkannte die Verknüpfungen zwischen technischer Machbarkeit und ökonomischen Anforderungen. Die Suche nach dem technologischen Sweetspot dauerte Monate. Am Anfang stand lediglich die reine Faszination für das Recycling. Es war ein schleichender Prozess mit vielen Etappenentscheidungen.

Die wachsende Last der globalen Fast Fashion

Das Umweltproblem der globalen Textilindustrie ist mittlerweile gewaltig. Die Branche verdoppelt ihren Durchsatz alle 20 bis 30 Jahre. Jährlich werden mittlerweile mehr als 120 Mio. Tonnen Textilien produziert. Nach Angaben der Ellen MacArthur Foundation werden weltweit ungefähr zwei Drittel dieser Mengen praktisch direkt nach der Nutzung entsorgt; sie landen auf riesigen Deponien oder werden ungenutzt verbrannt. In Deutschland steht das klassische Rücknahmesystem laut Experten vor dem Kollaps. Es gibt nach seiner Aussage derzeit eine gestiegene Anzahl an Insolvenzen bei Sammel- und Sortierbetrieben. Die Qualität der Kleidung sinkt durch den Trend zur Fast Fashion massiv. Der Wiederverkauf der gebrauchten Ware lohnt sich oft nicht mehr. Neuware aus Asien ist meistens günstiger als Second Hand-Stücke aus Europa. In Deutschland verursacht die Entsorgung einer Tonne Altkleider zudem Kosten – das Material wird somit zur finanziellen Belastung für die Sammel- und Sortierbetriebe.

Chemische Trennung als industrieller Schlüssel

Das Unternehmen aus Münster setzt genau an diesem Punkt an. Die Technologie ermöglicht die Trennung von Baumwolle und Polyester und macht beide Materialien wieder nutzbar. Das ist entscheidend für den Erfolg der Kreislaufwirtschaft. Die meisten Textilien bestehen heute aus komplexen Mischgeweben. Gerlach erklärt, dass das Unternehmen aus dem Abfall eine hochwertige Cellulose und chemische Bausteine für neues Polyester gewinnt. Die Cellulose dient als sauberes Vorprodukt für die neue Faserherstellung. Das Polyester wird in seine Grundbausteine zerlegt, die für die Herstellung von neuem Polyester verwendet werden können. „Wir stellen aus Baumwolle eine hochwertige Cellulose her und gewinnen aus dem Polyester die chemischen Bausteine zurück“, sagt Gerlach. Beide Materialströme können direkt wieder in der Textilproduktion eingesetzt werden. Damit wird der Kreislauf zwischen Abfall und Kleidung geschlossen. Seit Anfang 2025 hilft zudem eine neue gesetzliche Regelung. Die EU-weite Getrenntsammlungspflicht für Textilabfälle ist in Kraft getreten: Unternehmen dürfen Textilien nun nicht mehr über den Restmüll entsorgen. Das sichert den Zugang zu großen Mengen an Rohstoffen.

Harte Verhandlungen in der Welt des Wagniskapitals

Der Weg von der ersten Idee zur fertig gebauten Industrieanlage ist lang. Deeptech-Unternehmen brauchen oft viel Geduld und Zeit für die Entwicklung. Das erfordert Investoren mit einem sehr langen Atem. In einer frühen Phase kam der High-Tech Gründerfonds an Bord. Auch die NRW.Bank und der TechVision Fonds unterstützen das Vorhaben. Später stiegen Forbion und der Chemiekonzern Henkel als Investor ein. Gerlach erinnert sich im Gespräch an einen intensiven Lernprozess bei den ersten Finanzierungsrunden. Man müsse technische Begeisterung mit harten Umsatzprognosen anreichern. Auch D11Z.Ventures, das Family Office von Dieter Schwarz (Lidl/Kaufland), investierte in das Unternehmen. Die Investoren verstehen laut Gerlach die Entwicklungszyklen und Skalierung von Deeptech-Unternehmen. Mittlerweile flossen über 20 Mio. EUR an Kapital in die Firma. Dieses Geld ermöglicht nun den nächsten großen Schritt.

Ein neues Team für die industrielle Skalierung

Das Start-up ist mittlerweile den Kinderschuhen entwachsen. In Münster entsteht derzeit eine industrielle Demonstrationsanlage. Gerlach erinnert sich an den Moment der Schlüsselübergabe: Zuerst wirkte die leere Halle riesig auf das Team. Inzwischen planen die Ingenieure bereits jeden Zentimeter der Fläche. Das Team ist auf über 25 Köpfe gewachsen. Es ist eine Mischung aus jungen Talenten und erfahrenen Kräften. Viele Mitarbeitende wechselten von großen Konzernen wie BASF nach Münster. Gerlach beobachtet eine große Lust auf die Arbeit an innovativen Prozessen. Die flachen Hierarchien im Unternehmen ziehen Experten an. Er schätzt das Know-how dieser Fachkräfte für den Anlagenbau. Erfahrene Chemiker bringen eine neue Qualität in die Prozesse. Die Zusammenarbeit zwischen Alt und Jung funktioniert hervorragend.

Führung zwischen Agilität und unternehmerischer Verantwortung

Die Unternehmenskultur hat sich mit der Größe weiterentwickelt. Gerlach betont, dass viele Impulse direkt aus der Belegschaft kommen. So wurde die Regelung für die Präsenz im Büro gemeinsam erarbeitet. Die Mitarbeitenden wünschten sich feste Tage für den Austausch. „Die schönsten Tage sind jene mit viel Begegnung“, berichtet Gerlach. Die bürokratischen Pflichten eines Geschäftsführers gehören einfach dazu. Trotzdem bleibt die Mission der Firma der wichtigste Treiber. Die Motivation im gesamten Team sei extrem hoch. Jeder packt an und treibt das Unternehmen voran. Der Spagat zwischen Entwicklung und Business ist fordernd. Gerlach jedoch genießt diese tägliche Herausforderung sehr.

Der Standort Deutschland als Zentrum für Innovation

Viele Fachleute kritisieren die Bedingungen für die Chemieindustrie. Hohe Energiekosten belasten die traditionsreichen Unternehmen stark. Gerlach sieht das differenzierter aus der Perspektive von innovativen Start-ups: „Für die Entwicklung neuer Technologien ist der Standort Deutschland weiter exzellent. Und die Qualifikation der Technologen ist hervorragend. Die aktuelle Krise führt bei uns auch zu Bewerbungen von erfahrenen Talenten aus der chemischen Industrie – die hätte es vor einigen Jahren in der Menge nicht gegeben.“ Die vorhandene Infrastruktur sei ein klarer Vorteil. Auch Konzerne beobachten solche Innovationen genau. Die Nähe zum Mittelstand fördert zudem die Skalierung. Für die beiden Gründer ist die aktuelle Produktionsanlage nur ein Anfang. Langfristig soll die Technologie weltweit lizenziert werden; überall auf der Welt fällt schließlich Textilmüll an. Die Kombination aus Ingenieurskunst und Skalierung ist das Ziel. Auch die aktuellen Investoren von eeden sehen dieses globale Potenzial. Das Unternehmen will beweisen, dass sich Kreislaufwirtschaft lohnt. Deutschland bleibt dafür ein wichtiger Ankerpunkt.

Gründer*in der Woche: Picturo – Local Photography, European Scale

Mit der Picturo Photography UG baut Jean Witt eine europaweite Plattform zur einfachen Suche nach lokalen Fotograf*innen auf. Ziel ist es, einen stark fragmentierten Markt zu bündeln, Fotograf*innen sichtbar zu machen und Nutzer*innen eine zentrale Anlaufstelle zu bieten. Mehr dazu im Interview mit dem Gründer.

Picturo klingt nach dem großen Bild. Beschreibe uns deine Idee in wenigen Sätzen – dein Elevator Pitch!

Picturo ist ein internationaler Marktplatz, der die Suche nach lokalen Fotograf*innen weltweit radikal vereinfacht. Statt unübersichtlicher Recherche auf Social Media oder Google bietet Picturo eine zentrale, standortbasierte Plattform. Nutzer*innen finden mit wenigen Klicks die passenden Fotograf*innen für jeden Anlass, während diese wiederum gezielt neue Kund*innen gewinnen. So professionalisiert Picturo einen stark fragmentierten Markt und macht die Suche nach Fotografie-Dienstleistungen so einfach wie die Buchung eines Hotels.

Es gibt bereits viele Plattformen für Fotograf*innen und Bilddatenbanken. Was war der konkrete Auslöser oder gar Pain Point, den du selbst erlebt hast, der dich dazu gebracht hat, Picturo zu gründen?

Der konkrete Auslöser war meine eigene Erfahrung als Reisender. Die Suche nach lokalen Fotografinnen lief fast immer über Direktnachrichten auf Social Media oder über einzelne Webseiten. Dabei musste man jedes Mal Preise, Verfügbarkeiten und Leistungen separat anfragen – oft ohne klare Antworten oder Vergleichsmöglichkeiten. Dieser Prozess ist zeitaufwendig, intransparent und für Nutzer*innen extrem umständlich. Gleichzeitig wurde deutlich, dass es für Fotograf*innen genauso ineffizient ist, jede Anfrage einzeln zu beantworten. Picturo ist aus genau diesem Pain Point entstanden: dem Wunsch nach einer zentralen, einfachen und transparenten Lösung für die Suche nach lokalen Profis.

Ihr sitzt in Esens, also im schönen Ostfriesland, habt aber den Anspruch, Fotograf*innen in „ganz Europa“ zu vernetzen. Wie baut man von einem eher ländlichen Standort aus eine so internationale Community auf?

Unser Standort in Ostfriesland ist für uns kein Nachteil, sondern Teil unserer Geschichte. Picturo ist von Anfang an als digitale Plattform konzipiert worden, bei der der Standort des Teams keine Rolle für die Reichweite spielt. Der Bedarf bei Fotograf*innen in ganz Europa ist so groß, dass Anfragen zur Teilnahme an unserer Plattform bereits heute organisch entstehen. Viele Fotograf*innen suchen gezielt nach Möglichkeiten, international sichtbar zu werden und neue Kund*innen zu erreichen. Durch klare Positionierung, einfache Nutzung und einen starken Fokus auf lokale Sichtbarkeit schaffen wir Vertrauen und Wachstum – unabhängig vom Standort. So bauen wir Schritt für Schritt eine internationale Community auf: digital, skalierbar und nachhaltig.

Euer Portfolio ist breiter als das der Konkurrenz. Wie genau funktioniert das Geschäftsmodell? Zahlt der/die Kund*in pro Bild oder ist es ein Abo-Modell?

Der Kern von Picturo liegt klar auf der Vermittlung und Sichtbarkeit von professionellen Fotografinnen. Unser Geschäftsmodell basiert auf abonnementbasierten Mitgliedschaften für die Fotografinnen. Für Kund*innen ist die Nutzung der Plattform vollständig kosten- und provisionsfrei; ebenso fallen keine Buchungsprovisionen an. Fotograf*innen zahlen eine monatliche Subscription für Sichtbarkeit, Reichweite und den Zugang zu qualifizierten Anfragen. Dieses Modell schafft Transparenz, vermeidet Reibung im Buchungsprozess und ist für beide Seiten fair und planbar.

Ihr bietet auch einen Guide zu lokalen Hotspots (Bars, Cafés) an. Ist das „nur“ ein Content-Marketing-Tool, um Traffic auf die Seite zu bekommen, oder plant ihr Kooperationen mit der Gastronomie als weitere Einnahmequelle?

Der Guide zu lokalen Hotspots ist aktuell in erster Linie als Mehrwert für Nutzer*innen gedacht und unterstützt den organischen Traffic sowie die Sichtbarkeit der Plattform. Gleichzeitig sehen wir darin großes strategisches Potenzial über reines Content-Marketing hinaus. Perspektivisch planen wir, diesen Bereich für Kooperationen mit lokalen Partnern wie Cafés, Bars oder Hotels zu öffnen.

Eine Plattform europaweit zu skalieren, kostet Geld und Ressourcen. Wie habt ihr euch bisher finanziert?

Aktuell ist Picturo vollständig eigenfinanziert und damit komplett gebootstrapped. Die Entwicklung der Plattform sowie der Markteintritt in erste Länder wurden aus eigenen Mitteln realisiert. Nun befinden wir uns an einem Punkt, an dem wir gezielt nach strategischen Partnern und Investor*innen suchen, um die nächste Skalierungsstufe zu erreichen. Ziel ist es, gemeinsam schneller zu wachsen und das internationale Potenzial von Picturo voll auszuschöpfen.

Wenn du auf die Zeit seit der Gründung der UG zurückblickst: Was war bisher der wichtigste Meilenstein, bei dem du wusstest: „Okay, das hier funktioniert wirklich“?

Der wichtigste Meilenstein war die Einführung des Abo-Modells. Trotz der Umstellung auf ein kostenpflichtiges Angebot lief das Onboarding ungebrochen weiter und neue Fotograf*innen traten der Plattform bei. In diesem Moment wurde klar, dass Picturo ein echtes Problem löst und einen echten Mehrwert bietet. Die Bereitschaft, für Sichtbarkeit und Reichweite zu bezahlen, hat bestätigt, dass der Bedarf im Markt vorhanden ist. Ab diesem Punkt war klar: Das Modell funktioniert.

Wo siehst du Picturo in drei Jahren?

In drei Jahren ist Picturo in vielen EU-Ländern aktiv und als internationaler Marktplatz für lokale Fotograf*innen etabliert. Gemeinsam mit starken Partnern ist die Plattform breit ausgerollt und für Nutzer*innen die erste Adresse bei der Fotografensuche.

Und last but not least: Welche Tipps würdest du anderen Gründer*innen geben, die gerade am Anfang stehen – vielleicht auch jenen, die nicht in den großen Hubs wie Berlin oder München sitzen?

Der wichtigste Tipp ist, sich konsequent an einem echten Problem zu orientieren und früh mit Nutzer*innen zu sprechen. Der Standort ist dabei zweitrangig – entscheidend sind Fokus, Umsetzungsstärke und Durchhaltevermögen. Gerade außerhalb großer Startup-Hubs kann man oft ruhiger, effizienter und näher am Markt arbeiten. Wichtig ist, früh zu testen, Feedback ernst zu nehmen und das Produkt Schritt für Schritt zu verbessern. Netzwerke, Partnerschaften und digitale Sichtbarkeit sind heute wichtiger als ein physischer Standort.

Hier geht’s zu Picturo

Das Interview führte StartingUp-Chefredakteur Hans Luthardt

Retourendaten als ungenutztes Potenzial

Retouren sind dein größter Kostenfaktor – aber auch eine wertvolle Datenquelle. Unser Artikel samt Praxis-Checkliste zeigt dir, wie du sie strategisch zum Marketing-Booster machst!

Retouren kosten den Handel jedes Jahr Millionen Euro. Dabei wird oft verkannt, dass sie auch eine wertvolle Quelle für mehr Umsatz und eine bessere Customer Journey sind. Aktuelle Daten aus dem Jahr 2025 zeigen, wie sich das Retourenverhalten von Verbrauchern entwickelt – und welche ungenutzten Chancen hierbei für dich und dein E-Commerce-Unternehmen liegen.

Die wichtigste Erkenntnis aus dem aktuellen Retouren-Report 2025: Immer weniger Kunden senden ihre Einkäufe zurück. Im Jahr 2025 waren es nur noch 46 Prozent – im Vergleich zu 51 Prozent in 2024 und 67 Prozent im gleichen Zeitraum 2023.

Trotz dieser sinkenden individuellen Retourenneigung prognostiziert die Universität Bamberg für Deutschland im Jahr 2025 ein neues Rekordvolumen von 550 Millionen Paketen. Um dieser Diskrepanz zu begegnen, musst du als Online-Händler deine Zielgruppen basierend auf den bei der Retoure gewonnenen Einsichten künftig präziser ansprechen.

Wenn Daten ungenutzt verpuffen

Noch immer ignorieren viele Online-Shops, wer welche Produkte warum zurückschickt. Betrachtest auch du Retouren oft ausschließlich aus der reinen Umsatzperspektive und übersiehst die damit verbundenen wertvollen Details zu Zielgruppen, Produkten und Kanälen? Viele erfassen zwar Retourengründe, doch nur ein Bruchteil wertet diese systematisch und automatisiert aus. Dabei könntest du genau diese Daten nutzen, um ein tiefgreifendes Verständnis für das Kauf- und Retourenverhalten deiner Kunden zu gewinnen.

Ohne diese Analyse gehst du das Risiko ein, dass beispielsweise Produkte mit einer hohen Retourenquote weiterhin bei Zielgruppen beworben werden, die sie überdurchschnittlich oft zurücksenden. Nutze deine Tools konsequent und schließe Kundengruppen, die deine Marge gefährden, vom Targeting aus. Bei durchschnittlichen Bearbeitungskosten von 5 bis 20 Euro pro Retoure – im komplexen Sortiment sogar bis zu 50 Euro – entstehen dir sonst erhebliche, aber vermeidbare Verluste.

Ein weiteres Beispiel für verpasste Chancen zeigt ein Blick auf die Rückgabepräferenzen. Demnach wünschen sich Frauen deutlich häufiger alternative Rückgabeoptionen als Männer (63 Prozent versus 53 Prozent). Ein klarer Hinweis darauf, dass Standardangebote hier weniger gut ankommen. Dennoch sprichst du in der Praxis vermutlich beide Zielgruppen identisch an.

Retourendaten als Marketing-Kompass

Die Lösung hast du paradoxerweise wahrscheinlich bereits im Haus: deine Retourendaten. Durch eine systematische und strategische Auswertung lassen sie sich als wertvolle Marketing-Intelligence nutzen. Ein zentraler Baustein sind datenbasierte Analysen, die Kaufhistorie, Kontaktpunkte, Retourenmuster sowie bevorzugte Produktkategorien verknüpfen.

Eine gezielte Steuerung der Kundenansprache und der Produktpositionierung nimmt unmittelbar Einfluss auf das Retourenverhalten. So wird es dir möglich, Produkte mit hoher Retourenquote für bestimmte Zielgruppen aus dem Fokus zu nehmen. Wird beispielsweise ein bestimmtes Schuhmodell bei den über 45-Jährigen überdurchschnittlich oft retourniert, solltest du es für diese Altersgruppe nicht mehr in Marketingkampagnen ausspielen.

Ebenso wie dein Produktportfolio kannst du auch deine Services an klare Kundenwünsche anpassen: 58 Prozent der Kunden wünschen sich neben der klassischen „Retoure gegen Erstattung“ auch andere Optionen wie Umtausch, Gutscheine oder Reparaturen. Diese Erkenntnis ermöglicht dir differenzierte, zielgruppengerechte Serviceangebote und schützt dich vor einem kompletten Umsatzverlust.

Auch eine datenbasierte Kanalbewertung wird möglich: Während 33 Prozent der 18- bis 34-Jährigen Social Commerce als Einkaufskanal nutzen, sind es bei den über 55-Jährigen nur rund 15 Prozent. Retourendaten zeigen dir präzise, welche Kanäle für bestimmte Produkte problematisch sind und wo du Budgets umschichten musst.

Erst eine konsequente Analyse der Retourengründe macht es dir möglich, Produktinformationen zu optimieren und Vertriebskanäle belastbar zu bewerten. Statt Millionen für Streuverluste auszugeben, kannst du deine Customer Journey gezielt verbessern.

Silos ade: Zusammenarbeit von Marketing, E-Commerce und Produktteams

Entscheidend für die optimale Nutzung dieser Einsichten ist der regelmäßige Austausch zwischen deinen Marketing-, E-Commerce- und Produktteams. Im Zusammenspiel können Erkenntnisse aus Retourengründen nahtlos in Produktbeschreibungen und Kampagnenbotschaften einfließen.

Wenn dein E-Commerce-Team beispielsweise feststellt, dass bestimmte Farbvarianten bei spezifischen Altersgruppen besonders oft mit dem Grund „sieht anders aus als erwartet“ retourniert werden, können Marketing und Produktentwicklung sofort reagieren: durch bessere Produktfotos, angepasste Beschreibungen und eine differenzierte Zielgruppenansprache.

Diese abteilungsübergreifende Verschränkung erfordert jedoch neue Prozesse: Wöchentliche Retourendaten-Reviews, gemeinsame KPIs und automatisierte Alerts bei auffälligen Retourenmustern sind Pflicht. Nur so wird aus der reaktiven Kostenstelle ein proaktives Steuerungsinstrument.

Daten bringen nachhaltigen Erfolg

Wenn du Retourendaten strategisch nutzt, sparst du nicht nur Kosten. Du steigerst die Konversion, senkst Streuverluste und reduzierst den Kundenfrust. Echter Erfolg stellt sich schließlich erst dann ein, wenn der Kunde sich nicht nur für den Kauf entscheidet, sondern das Produkt am Ende auch behält.

Begreife Retouren daher noch stärker als präzise Datenquelle für eine bessere Kundenbeziehung. Wenn du deine Retourendatenanalyse jetzt professionalisierst, verwandelst du den Kostenfaktor endgültig in deinen Marketing-Booster.

Der Autor Artjom Bruch ist CEO der Trusted Returns GmbH

StartingUp-Checkliste: So machst du deine Retourendaten zum Marketing-Booster

Prüfe dein aktuelles E-Commerce-Setup. Wie viele dieser Fragen kannst du bereits mit „Ja“ beantworten?

- [ ] Präzise Datenerfassung: Erfasst du detaillierte Retourengründe (über ein Dropdown-Menü im Retourenportal) statt nur eines pauschalen „Gefällt nicht“?

- [ ] Dynamisches Targeting: Schließt du Kunden oder Segmente, die ein bestimmtes Produkt überdurchschnittlich oft retournieren, automatisch von der weiteren Bewerbung dieses Artikels aus?

- [ ] Zielgruppengerechte Rückgabe-Optionen: Bietest du im Retourenprozess aktiv Alternativen wie Direkt-Umtausch, Store-Credit (Gutschein) oder Reparatur an, anstatt sofort den Kaufpreis zu erstatten?

- [ ] Kanal-Rentabilitäts-Check: Analysierst du, ob Kunden, die über Plattformen wie TikTok oder Instagram kaufen, eine signifikant höhere Retourenquote aufweisen als Käufer aus dem E-Mail-Marketing?

- [ ] Silos aufbrechen: Gibt es ein regelmäßiges (z. B. wöchentliches) Meeting zwischen Marketing, E-Commerce und Produktmanagement, um auffällige Retourenmuster zu besprechen?

- [ ] Automatisierte Warnsysteme: Erhält dein Team einen automatischen Alert, wenn die Retourenquote eines neu gelaunchten Produkts innerhalb der ersten 48 Stunden einen definierten Schwellenwert übersteigt?

Je mehr Haken du setzen kannst, desto näher bist du am profitablen Retouren-Management.

Strategischer Fokus auf Multimorbidität: Oska Health sichert sich 11 Mio. Euro

Das Frankfurter HealthTech-Unternehmen Oska Health hat eine Finanzierungsrunde über 11 Millionen Euro abgeschlossen. Angeführt von Capricorn Partners und SwissHealth Ventures, adressiert das Start-up die Versorgungslücke bei chronisch Kranken. Ein Blick auf das Geschäftsmodell, die personelle Aufstellung und die Herausforderungen im regulierten Gesundheitsmarkt.

In der aktuellen Seed-Runde haben sich neben den Lead-Investoren Capricorn Partners und SwissHealth Ventures auch Revent, Calm Storm, BMH, LBBW Venture Capital, GoHub Ventures und Aurum Impact beteiligt. Mit dem frischen Kapital plant Oska Health, die technologische Infrastruktur auszubauen und das Versorgungsmodell, das bereits mit über 20 Krankenkassen (darunter die KKH) etabliert wurde, in die Breite zu bringen.

Adhärenz als wirtschaftlicher Hebel

Der Fokus des 2022 gegründeten Unternehmens liegt auf sog. multimorbiden Patient*innen – Menschen, die gleichzeitig an mehreren chronischen Leiden wie Nierenerkrankungen (CKD), Diabetes und Bluthochdruck leiden. Ein Kernproblem in diesem Bereich ist die mangelnde Therapietreue im Alltag (Adhärenz). Statistiken des Gesundheitswesens belegen, dass etwa 50 % der chronisch Kranken ihre Medikamente nicht vorschriftsmäßig einnehmen. Oska Health setzt hier auf eine hybride Betreuung: Ein digitaler Begleiter (App) wird durch persönliches Coaching via Video und Chat ergänzt.