Aktuelle Events

Daniel Ek und die Spotify-Story

Neue Serie: Mega-Gründer und ihre Erfolgsgeheimnisse

Wie der Schwede Daniel Ek Spotify aufbaute und die Angriffe von Apple und der Musikindustrie kontert.

„Eigentlich habe ich mich nie als Entrepreneur gesehen, sondern als jemand, der viele interessante Probleme in der Welt erkennt, und fortwährend davon genervt ist, dass es hierfür noch keine Lösung gibt. Und dann habe ich festgestellt, dass es noch mehr Leute gibt, die diese Defizite als störend empfunden haben. Ok, habe ich gesagt, was machen wir also? Und nachdem sonst niemand diese Dinge angepackt hat, dachte ich: Dann muss ich das eben selbst angehen.“ So äußerte sich Daniel Ek in einem Gespräch mit KPCB-Venture-Capitalist Chi-Hua Chien an der Stanford University im Mai 2012.

Im Jahr 1997, Daniel war 14 Jahre, und hatte gerade seine erste Firma in Ragsved, einem Stockholmer Arbeitervorort, gestartet, verlangten Beratungsfirmen in Europa bis zu 50.000 Dollar, um eine Webseite zu programmieren. Daniel dachte sich: Das ist nun wirklich nicht so schwer, und begann Webseiten für seine ersten Kunden zu bauen. Seinen Mitschülern, die gut in Mathe waren, brachte er HTML bei und jenen, die gut zeichnen konnten, Photoshop. Am Ende war fast die ganze Klasse nach Unterrichtsschluss damit beschäftigt, Webseiten für Daniels Kunden zu entwickeln. „Ich habe das gar nicht so sehr als Firma betrachtet, ich wollte nur gute Ergebnisse erzielen“, sagt Daniel heute. Gleichzeitig hatte er das erste Mal in seinem Unternehmerleben das gute alte Tom-Sawyer-Prinzip angewandt: Das Anstreichen von Gartenzäunen nicht mehr als Arbeit darzustellen, sondern als Privileg. Man könnte auch sagen: Daniel hat auf höchstem Niveau delegiert.

Daniels Gründermarathon

Eks Eckdaten genügen für eine lebenslange Unternehmer-Biographie, aber das erste große Kapitel spielt sich in weniger als zehn Jahren ab: Nach seiner ersten Firmengründung mit 14 Jahren, verkaufte er seine Webagentur mit 19 und stieg – bereits Millionär – mit 21 als CTO bei Stardoll ein, einem heute noch verbreiteten Dress-Up-Game für Teenies, die hier ihre virtuellen Puppen ankleiden. Im Alter von 22 wurde Daniel CEO von uTorrent, einer Filesharing- und Streaming-Technologie, die auch von Piratenportalen genutzt wurde. Dazwischen fielen noch die Gründung und der Verkauf von Advertigo, einer Online-Marketing-Firma. Für rund 1,2 Millionen Dollar ging das Unternehmen an Tradedoubler, dessen CEO Martin Lorentzon später Daniels Co-Founder bei Spotify wurde. Nicht zu vergessen, da gab es noch Tradera, eine Auktionsplattform, die später von Ebay übernommen wurde.

Tech-Veteran mit 23 Jahren

Als Daniel sich mit 23 Jahren, das war 2006, an Spotify machte, war er bereits Multimillionär – und quasi ein Tech-Veteran mit knapp zehn Berufsjahren auf dem Buckel. Dem US-Musikmagazin Billboard erzählte er: „Ich war eigentlich noch ein Kind, ließ den Champagner fließen, fuhr schnelle Sportwagen und machte einen Haufen unanständige Dinge. Eines Morgens wachte ich auf, neben mir eine Frau – ich wusste nicht, wer sie war – und ich hatte nicht die geringste Erinnerung an die letzten drei Tage. Ich fühlte mich völlig leer.“

Daniel musste wieder runterkommen, fokussieren und zog in ein kleines Haus in der Nähe seiner Mutter, die ihn allein erzogen hatte, spielte Gitarre und plante seinen nächsten Schachzug. Seine Gedanken drehten sich um Napster, das er ja selbst nutzte, um Metallica-Tracks zu suchen und seinen ersten Led-Zeppelin-Song zu hören, „Kashmir“. Napster hatte ihn schon mit 14 Jahren fasziniert. Auf der einen Seite erkannte er, wie sich der Musikkonsum immer mehr in Richtung Piraterie verschob, und dass bereits eine halbe Milliarde Menschen weltweit illegal Musik hörten. Gleichzeitig sah er, dass die Musiker ums Überleben kämpften, und nicht mehr von ihrer Musik leben konnten. Apple verkaufte damals im iTunes-Store kopiergeschützte Musikfiles mit einer Qualität von 160 kBit/sek, während man zu PirateBay oder Kazaa gehen konnte, und hier die gleiche Datei fast ebenso schnell ohne Qualitätseinschränkung und ohne Kopierschutz herunterladen konnte. Also war klar, dass erstmalig ein Piratenprodukt dem legalen Produkt überlegen war. Kein Wunder, dass die Leute Piratenseiten nutzten.

Der Weg zu Spotify

Daniels Idee: Einen Musik-Service zu entwickeln, der mindestens so groß und bedienungsfreundlich wie Napster sein sollte, der aber legal betrieben werden sollte und der für die Übertragung der Rechte Geld an die Musikindustrie bezahlt. „Mein Ziel war es, mit Spotify einen Service zu bieten, der besser war als all die Piratenprodukte. Es sollte einfacher sein, Musik zu entdecken und zu teilen. Ich erkannte, dass wir mit einem derartigen Service die Chance hatten, rund 500 Millionen Menschen zu erreichen. Und zwar alle die, die Musik illegal konsumierten. Gleichzeitig war es das Ziel, wieder Wachstum in die Musikindustrie zu bringen und den Künstlern damit die Chance zu geben, weiter ihre Musik zu machen, die uns allen Freude macht. Ich wollte mit der Musikindustrie arbeiten, nicht gegen sie.“

Das aber erwies sich als extrem schwer. Daniels Freemium-Geschäftsmodell, das vorsah, sämtliche Musik dieser Welt legal und kostenlos zur Verfügung zu stellen, löste größte Bedenken bei den Managern der großen Plattenlabels wie Universal Music Group, Warner oder Sony aus. Vergeblich versprach Daniel Einnahmen über Werbefinanzierung zu generieren und kostenpflichtige Premium-Accounts zu verkaufen. Vergeblich versprach er vor allem, die angeschlagene Musikindustrie mit diesem Konzept wieder auf Wachstumskurs zu bringen. Das Trauma des Niedergangs und der Umsatzhalbierung der gesamten Sparte zwischen 1997 und 2005 in Folge der digitalen Veränderung war längst noch nicht verarbeitet, und Daniels Karriere bei uTorrent, dem Anbieter für illegale Streaming-Software, natürlich bekannt. Es musste so kommen: Daniel erhielt bei den großen Labels in New York zunächst eine Absage nach der anderen. „Ich war 25 und fühlte mich, als wäre mein Leben zu Ende“, erzählte er in einem Radio-Interview des schwedischen Rundfunks.

Dass er es doch schaffte, kann Daniel auch seiner Herkunft verdanken: Der Start in Schweden, einem vergleichsweise kleinen Musikmarkt, erwies sich als Vorteil für Spotify. Die schwedische Musikindustrie hatte nicht viel zu verlieren, war quasi am Boden durch die Piraterie, und so konnte Daniel seinen Proof of Concept in diesem kleinen Testmarkt erbringen, bevor er zunächst das übrige Europa und den US-Markt ins Visier nahm, Märkte in denen es für Spotify allerdings viel zu verlieren gab. Tatsächlich konnte der schwedische Musikmarkt, der infolge der Musikpiraterie praktisch tot war, ab ca. 2010 wieder zulegen, und sogar an die goldenen Zeiten vor 2001 anknüpfen. „Mehr und mehr andere Märkte wollten uns jetzt“ so Daniel.

Glücksfall Schweden – es gab noch weitere Gründe, die Daniel einen Standortvorteil einbrachten: Zum einen die starke Engineering-Tradition des Landes, zum anderen war der frühe Breitband-Ausbau der Netzinfrastruktur in Schweden ein wichtiger Faktor. Schon 2001 stand Daniel eine 100-Mbit-Download-Leitung zur Verfügung, also eine selbst nach heutigen Maßstäben hervorragende Infrastruktur. Dies inspirierte Daniel, er fragte sich: Wofür können wir dies nutzen? „Das Laden einer Webseite dauerte zwei Sekunden, also fingen wir an, größere Sachen zu laden, wie Videos und Musik, und das war neu.“

Eks Rezept: 95 Prozent Ausführung – 5 Prozent Idee

Was ist das Geheimnis, wenn man in komplexen „alten“ Branchen wie der Musikszene mit einem neuen Geschäftsmodell erfolgreich sein will? „Wenn ich von einer Sache überzeugt bin, gebe ich nie auf“, sagt Daniel. Ganz viel Geduld ist nötig, vor allem in Branchen, die von traditionellen Platzhirschen dominiert sind. Auch dass er all dies in so jungen Jahren gestartet hat, betrachtet Daniel heute als wesentlich für den Erfolg. „Ich war naiv, als ich Spotify startete. Zum Beispiel wusste ich am Anfang nicht, dass man zum Streamen Lizenzen von den Plattenfirmen brauchte, das habe ich erst später verstanden. Also sah ich nur die Lösungen, nicht die Schwierigkeiten auf dem Weg dahin, und dachte: Hey, das kann ja nicht so schwer sein. Leute mit entsprechender Erfahrung sagen über viele innovative Geschäftsideen, das funktioniert nicht, und zwar aus den Gründen XYZ. Tatsächlich aber stellt sich dann oft heraus, dass die meisten Sachen doch irgendwie möglich sind.“

Als Visionär oder Genie sieht sich Daniel dennoch nicht. „Immer wieder kommen Leute zu mir und fragen mich nach neuen Geschäftsideen, die sie umsetzen könnten, und ich sage: Ganz ehrlich, ich habe keine Ahnung, was funktionieren wird und was nicht, ich bin nicht der Prophet, der voraussagt, was der nächste große Erfolg sein wird.“ Zum Beispiel hatte Daniel um 2004 die Chance, sich bei Skype zu engagieren, doch er dachte, das wird nie was und lehnte ab. Überzeugt ist er allerdings, dass die Ausführung alles ist, die Ideen hingegen fast nichts. 95 Prozent Ausführung gegenüber fünf Prozent Idee, so beschreibt Daniel die Verhältnisse.

Rasantes Streaming-Wachstum

Was macht ein Software-Produkt gut, nach welchen Grundsätzen werden Anwendungen bei Spotify entwickelt? „Ich habe zwar als Techniker gestartet, aber bin wohl heute eher ein lausiger Programmierer. Aber ich denke lösungsorientiert“, sagt Daniel. „Das half mir.“ Daniel äußert sich, wie er Interfaces beurteilt: „Ich frage mich: Wozu ist es da? Was ist der Zweck des Interfaces? Und ich denke viel darüber nach, welches der kürzeste Weg von Punkt A nach Punkt B ist.“ Das zwingt zu Iterationen, zu Wiederholungsschleifen im Design und zu Tests. Bei Spotify sind es oft drei bis vier Versionen, die den Usern vorgelegt werden, bevor eine Entscheidung getroffen wird. Im Mittelpunkt steht die Frage: „Welches Problem will ich hier lösen, da muss man viel drüber nachdenken“, sagt Daniel.

Viele aktuelle Zahlen belegen, dass die meisten Überlegungen richtig waren. Der Wert von Spotify wird heute auf rund 8 Milliarden Dollar geschätzt. An den Standorten in neun Städten, u.a. London, New York und Stockholm, arbeiten knapp 1400 Leute und vor allem: Rund 75 Millionen Menschen in 58 Ländern nutzen den Streaming-Dienst, gut ein Viertel davon per kostenpflichtigem Abo zum Preis von 9,99 Dollar pro Monat. Von diesen Einnahmen sowie den Werbeerlösen aus den freien Accounts hat Spotify nach eigenen Angaben bislang mehr als drei Milliarden Dollar an die Musikindustrie ausbezahlt. Allein im ersten Jahresviertel 2015 betrugen demnach die Ausschüttungen für die Labels 300 Millionen Dollar.

Und so werden die Streaming-Umsätze für die Musikunternehmen immer wichtiger: Machten sie 2010 nur drei Prozent der globalen Gesamteinnahmen aus, stieg dieser Wert bis 2014 auf 15 Prozent. Gleichzeitig sank der Umsatz aus CD-Verkäufen von 54 Prozent auf 36 Prozent. Auch der Umsatz aus Downloads sinkt, wie eine Studie des Bundesverbands der Musikwirtschaft aus dem Jahr 2014 belegt. Hier heißt es: „Die Mutter des Digitalgeschäfts, der Downloadbereich, entwickelt sich tendenziell rückläufig.“ Streaming hingegen wächst rasant: In den letzten Wochen des Jahres 2014 wurden fast doppelt so viele Streams gezählt wie im Vergleichszeitraum des Vorjahres. Derzeit nutzen rund 11 Millionen Menschen in Deutschland Streamingdienste für ihren Musikkonsum, bis 2018 sollen es nach einer GfK-Studie 22 Millionen sein.

Schwarze Zahlen – Fehlanzeige!

Trotz glänzender Aussichten: Schwarze Zahlen hat Spotify noch nie geschrieben: Bei Einnahmen von rund 1,25 Milliarden Euro im Jahr 2014 verbuchte das Unternehmen 165 Millionen Euro Verlust. Und auch bei den Künstlern bleibt wenig Zählbares hängen: Pro Stream erhält ein Musiker im besten Fall nur 0,164 Cent ausbezahlt – dies rechnete der Hessische Rundfunk 2013 aus. Für ein gesamtes gestreamtes Album sind es zwei Cent, während die Erlöse für ein klassisch verkauftes Album durchaus drei Euro erreichen können. Das bedeutet: Das Album eines Künstlers muss etwa 150 Mal gestreamt werden, bis es Erlöse in der Höhe eines Verkaufs einspielt.

Manche Künstler spielen da nicht mehr mit. Prominentestes Beispiel ist die US-Sängerin Taylor Swift, Darling des amerikanischen Publikums, die ihr Portfolio Ende 2014 bei Spotify entfernen ließ: „Spotify feels to me like a grand experiment. I’m not willing to contribute my life’s work to an experiment that I don’t feel fairly compensates the writers, producers, artists and creators of this music.“ Das hat natürlich geschadet, mancher fragt sich: was bringt mir ein Streaming-Abo, wenn die aktuellen Hits nicht zu hören sind?

Ganz klar, Daniel Ek steht unter Druck. Der Typ, der immer in der Vorwärtsbewegung war, der die Musikbranche wie kein anderer zur Disruption zwang, der Offensivspieler im Strafraum dieser Industrie, er muss plötzlich Defensivaufgaben vor dem eigenen Tor übernehmen. Denn da wären noch mehr Fronten: Nicht nur die Künstler, auch die Musikindustrie macht Druck. Das Freemium-Modell ist vielen großen Playern ein Dorn im Auge. Und schließlich ist da seit Sommer 2015 ein noch mächtigerer Gegner, der mächtigste und reichste unserer Zeit: Apple mit seinem neuen Streaming-Dienst Apple Music.

Die mächtigen Spotify-Gegner

Keine Frage: Der Entrepreneur Daniel Ek muss sich neu beweisen. Nicht mehr Disruption, ganz andere Fähigkeiten sind gefragt. Wie macht er das, wird er das schaffen, und wenn ja, wie? Beginnen wir mit dem Problem Taylor Swift: Was schreibt Daniel Ek in seinem Blog? „Taylor Swift hat Recht. Musik ist Kunst, Kunst hat hohen Wert, und Künstler verdienen es, bezahlt zu werden. Wir starteten Spotify, weil wir Musik lieben und weil die Piraterie die Musik killte. Der Vorwurf, Spotify würde auf dem Rücken der Künstler Geld machen, regt mich auf.“ Und weiter, adressiert an alle Künstler: „Unser ganzes Business ist darauf ausgerichtet, den Wert Ihrer Musik zu maximieren.“ Dass Taylor Swifts Titel nach Löschung aus Spotify ganz oben in den Rankings von PirateBay und YouTube standen, war natürlich Daniels Killer-Argument zum Schluss dieser Apologie.

Nächstes Thema – die großen Player der Musikindustrie. Sony, Warner, UMG – sie alle halten mittlerweile ihre Anteile an Spotify, dank ihrer Verhandlungsposition als Rechteinhaber, kein Wunder. Doch das hindert sie nicht daran, Spotify offen in Frage zu stellen: Auf der Code/Media Konferenz im Frühjahr 2015 musste Spotify zwei vernichtende Urteile seiner wichtigsten Rechtelieferanten einstecken: Lucian Grainge, UMG-Chairman, sagte, auf lange Sicht sei das kostenlose, werbefinanzierte on-demand-Streaming nicht nachhaltig, und Sonys Music Entertainment CEO Doug Morris meinte gar: „In general, free is death.“

Freemium-Debatte und Börsengeflüster

Spotifys Umsätze aus Werbung sind nach wie vor gering, entsprechend auch die Tantiemen daraus für Labels und Künstler. Folglich drängen die großen Anbieter auf eine Beschneidung des Gratis-Services, etwa durch Drosselung von Qualität oder Nutzungszeit. Doch Spotify verteidigt das Freemium-Modell, in der Hoffnung Free-User noch zu Bezahl-Usern zu konvertieren. Daniels Entgegnung auf diesen Punkt: Die Freemium-Debatte gab es „von Anfang an. Glauben Sie, dass es künftig auch kein kostenloses Radio mehr gibt?“ Und dann kommt natürlich – gebetsmühlenartig – der Hinweis auf die Piraten, Daniels stärkste Waffe. Aber er hat noch ein anderes Ass im Ärmel: Den möglichen Börsengang von Spotify, über den immer wieder spekuliert wird. Vor allem seit Barry McCarthy im Sommer 2015 neuer Finanzvorstand von Spotify wurde, ein Spezialist für IPOs, der auch schon Netflix an die Börse gebracht hatte. Daniel weiß: Beim Börsengang wollen die großen Labels auch Kohle machen, ganz hart werden sie ihn vorher nicht fallen lassen.

Apple Music contra Spotify

Tja, und dann Apple. Apple Music, gelauncht Anfang Juli 2015, ist die Antwort auf sinkende Download-Zahlen in iTunes und auf den wachsenden Streaming-Markt. Es ist eine mächtige Replik. Denn auch Apples Streaming-Dienst bietet von Anfang an 30 Millionen Songs, ebenfalls zum Preis von 9,99 Dollar bzw. Euro pro Monat und für Familien sogar für nur 14,99 Dollar bzw. Euro. Die ersten drei Monate kann man kostenlos testen, ein Angebot, das nach einem Bericht der New York Post ca. 15 Millionen User weltweit angenommen haben und das für viele im Herbst 2015 ausläuft. Jetzt entscheidet es sich: Zwei bezahlte Streaming-Dienste parallel ergeben keinen Sinn, daher stellt sich die Frage: Gibt es eine Kündigungswelle für Spotify?

Letztlich stimmen die User ab, welche Plattform ihnen sympathischer ist. Apple kann eine Menge Argumente ins Feld führen: Spannend ist vor allem die kuratierte Musikauswahl, die sich genau an den Geschmack und die Hörgewohnheiten des Users anpasst. Außerdem: Die App ist auf Apple-Geräten vorhanden, man muss sie nicht mehr installieren, im Gegensatz zu Spotify. Doch Spotify besitzt einen ansehnlichen Vorsprung, und Jeff Levick, Chief Revenue Officer von Spotify, äußerte sich Anfang Oktober positiv, das gesteckte Ziel, nämlich 100 Millionen User, bis Ende 2015 zu erreichen.

Das ist auch die Haltung von Ek: Skandinavisch cool federt er den Angriff ab. Bereits legendär ist seine Reaktion auf Twitter zu Apple Music: „Oh, ok.“ Und auf der IAB MIXX Konferenz Anfang Oktober 2015 ergänzte er: „Für uns ist es wirklich großartig, dass Leute in diesen Bereich investieren, um die Musik nach vorn zu bringen, und dass wir nicht die einzigen sind, die sagen: Streaming ist die Zukunft.“ Und er fügte hinzu, dass es genug „Platz am Tisch gibt, weil das Streaming von Musik ganz am Anfang“ stehe. Außerdem, so Daniel in einem Videointerview mit Jason Calacanis: „Der einzige Weg in dieser sich schnell drehenden Welt zu gewinnen – und sie bewegt sich jeden Tag schneller, es gibt soviel Innovation weltweit – besteht darin, super-fokussiert auf ein bestimmtes Problem zu sein und das besser und schneller zu lösen als alle anderen.“ Allerdings: Dieses Statement steht in gewissem Widerspruch zu Daniels Aussage, am Tisch sei genug Platz für mehrere Anbieter ...

Spotify in allen Lebenslagen?

Zum Schluss der Ausblick, nur einige Details: Spotify setzt auf die Kombi Musik und Shows und bindet zunehmend Videos ein, dazu gehören auch Nachrichten, Unterhaltungsclips und Podcasts. Anwendungen wie Spotify Running wollen ein noch individuelleres Nutzererlebnis ermöglichen und machen Musikvorschläge, die sich genau dem Lauftempo des Users anpassen. Auch das Auto spielt bei Spotifys Plänen eine große Rolle. In Apple CarPlay und Android Auto ist Spotify bereits integriert. Nun kommt eine Kooperation mit Uber hinzu. Als Fahrgast hörte man bislang die Musik, die der Fahrer hörte. In Uber-Autos soll der Fahrgast mit Spotify-Account seinen eigenen Sound auflegen. Überhaupt, das ist Daniels Vision: Spotify soll für uns alle zum Bestandteil des täglichen Lebens werden. Wir werden mit Spannung verfolgen, ob Daniels Plan aufgeht und ob tatsächlich genug Platz am Tisch für alle ist.

Diese Artikel könnten Sie auch interessieren:

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

KI gegen Buchhaltungsriesen: Wie Bonster den Spesen-Markt aufmischen will

Pay-per-Use statt Abo-Falle: Das Oldenburger Start-up fast2work attackiert mit seiner App bonster komplexe Software-Giganten. Doch reicht das Versprechen maximaler Einfachheit im Haifischbecken der FinTechs? Wir haben nachgehakt.

Es ist eines der letzten großen Ärgernisse im Arbeitsalltag von Freelancer*innen und kleinen Agenturen: Der Freitagabend, der für das Sortieren verknitterter Tankbelege und das Abtippen von Bewirtungsbelegen in Excel-Listen draufgeht. Genau hier setzt die Oldenburger fast2work GmbH mit ihrer am 17. Februar 2026 gelaunchten App bonster an, um den Papierkram bei der Reisekostenabrechnung zu beenden. Das Versprechen von Gründer und CEO Ronald Bankowsky: Drei Minuten Aufwand, KI-Automatisierung und keine Einstiegshürden.

Das Versprechen: Simpel statt Systemintegration

Die Funktionsweise der App ist bewusst minimalistisch gehalten: Beleg fotografieren, woraufhin die KI relevante Werte wie Datum, Betrag und Mehrwertsteuer ausliest, auf Duplikate prüft und eine fertige Abrechnung erstellt. „Kein Onboarding-Projekt, kein Vertriebsgespräch, kein IT-Setup“, fasst Bankowsky den Ansatz der Standalone-Lösung zusammen.

Die Zielgruppe ist klar definiert: Selbständige, Freelancer*innen und Mini-Teams, denen Enterprise-Lösungen wie SAP Concur zu mächtig und Start-ups wie Circula oder Pleo oft noch zu prozesslastig sind. Mit einem Preismodell von 1,99 Euro für Einzelabrechnungen und 6,99 Euro (Stand Ende Febr. 2026) für eine Flatrate positioniert sich das Unternehmen im unteren Preissegment.

Im Haifischbecken der Neobanken und Buchhaltungsriesen

Laut fast2work gab es bislang „kaum eine Alternative zwischen Excel und Enterprise-Software“. Diese Aussage hält einem Realitätscheck im Jahr 2026 allerdings nur bedingt stand. Bonster betritt ein Haifischbecken, denn die vermeintliche Lücke wird längst geschlossen.

Zum einen integrieren Buchhaltungsriesen wie Lexoffice oder sevDesk Reisekosten-Features immer tiefer in ihre Standardpakete. Zum anderen wildern Neobanken wie Qonto, Finom oder Kontist im selben Revier: Wer dort ein Geschäftskonto hat, bekommt die Belegzuordnung oft als „Commodity“ gratis dazu. Mit knapp 7 Euro im Monat bewegt sich bonster in einer Preisregion, in der man fast schon eine komplette einfache Buchhaltungssoftware bekommt. Die App muss also einen enormen Mehrwert bieten, um gegen die „Eh-da-Lösungen“ (Software, die Kund*innen ohnehin bezahlen) zu bestehen.

Auf die Frage, warum Freelancer*innen für eine Insellösung extra zahlen sollten, entgegnet der Gründer, dass bonster bewusst früher ansetze als klassische Tools. Das Hauptproblem sei nicht die Buchhaltung, sondern das Erfassen von Belegen unterwegs. „Genau dort scheitert es oft, weil Mitarbeitende keine komplexen Systeme nutzen wollen oder gar keine Zugänge haben“, argumentiert Bankowsky. Der Mehrwert liege nicht in einer weiteren Buchhaltungssoftware, sondern darin, dass durch die Reduzierung auf ein Foto „überhaupt verwertbare Abrechnungsdaten/Belege entstehen“.

Kritische Faktoren: GoBD und Datensicherheit

Neben der Marktpositionierung ist die Rechtssicherheit ein kritischer Faktor. „Fertige Abrechnung für die Buchhaltung“ ist ein mutiges Versprechen, da in Deutschland ein Foto allein oft nicht ausreicht; es muss GoBD-konform und revisionssicher archiviert werden. Zudem ist die KI-Nutzung datenschutzrechtlich sensibel. Wenn Bewirtungsbelege, die offenbaren, mit wem man gegessen hat, über US-Schnittstellen (z.B. OpenAI) fließen, ist das für deutsche Geschäftskund*innen und Steuerberater oft ein K.O.-Kriterium.

Auf die sensiblen Vorgaben der Finanzämter und den Serverstandort angesprochen, betont Bankowsky, dass die Verarbeitung „ausschließlich auf europäischen Servern“ erfolge. Zwar nutze man OpenAI-basierte Modelle, diese liefen jedoch über Azure-Rechenzentren im europäischen Raum. Datenschutz und regulatorische Anforderungen seien Grundvoraussetzung. Auch beim Export zum Steuerberater zeigt sich der Gründer zuversichtlich: Buchhaltungssysteme könnten die Daten direkt und „ohne manuelle Nacharbeit“ weiterverarbeiten.

Beta-Test als Exklusiv-Club

Zum Start setzt das Unternehmen auf eine Gamification des Rollouts. Die ersten 500 Nutzer*innen erhalten im „Club 500“ einen lebenslangen Rabatt von 50 Prozent. Was als Belohnung für Early Adopters verkauft wird, ist strategisch notwendig: Die KI muss lernen. Der Algorithmus braucht dringend „Real World Data“ – echte, verknitterte, schlecht beleuchtete Belege. Das bedeutet auch: Die ersten User*innen sind Teil des Entwicklungsprozesses.

Dass die App im Alltag noch dazulernen muss, räumt Bankowsky ein. Bei der reinen Datenerkennung sei man technisch auf dem aktuellen Stand. „Entscheidend ist jedoch die Qualität realer Belege im Alltag – etwa schlecht fotografierte oder handschriftliche Quittungen“, erklärt er den Bedarf an Praxis-Feedback. Durch schnelle Updates solle die Genauigkeit für alle Nutzer*innen laufend steigen.

Gegenmodell zur Ökosystem-Abhängigkeit

Wer ein Feature-Feuerwerk suche, werde bei bonster enttäuscht sein – was laut Unternehmen aus Überzeugung geschehe. Anbieter wie Rydoo verfolgten eine Strategie der maximalen Integration und langfristiger Verträge, was eine Abhängigkeit erzeuge, die ihr eigentliches Geschäftsmodell sei, so der Gründer. Wer einmal im Ökosystem stecke, wechsle nicht mehr, weil der Ausstieg zu teuer geworden sei.

Bonster positioniert sich als Gegenmodell für Unternehmen, die nicht für ungewollte Komplexität zahlen möchten: Kein Vertrag, keine Mindestnutzerzahl, Setup in unter fünf Minuten und ein Pay-per-Use-Modell. „Wer aufhören will, hört auf, ohne Konsequenzen“, beschreibt das Start-up den Ansatz der bewussten Entscheidung, Kund*innen freizulassen. Wer bleibe, tue dies, weil es funktioniere, was laut Bankowsky „die interessantere Innovation“ sei.

Fazit

Bonster ist ein innovativer Angriff auf die Zettelwirtschaft und wirkt durch den Verzicht auf starre Abo-Modelle bei der Einzelabrechnung fair. Doch die App steht und fällt mit der Schnittstellenkompetenz. Wenn der Export zu DATEV & Co. hakt, wird aus der Zeitersparnis schnell Mehrarbeit. Bonster muss beweisen, dass es die Brücke zwischen dem schnellen Foto und der strengen deutschen Buchhaltung schlagen kann – und zwar besser als die Banken, die das Feature bereits kostenlos anbieten.

eeden: Die Alchemie der Altkleider

Das Münsteraner Unternehmen eeden verwandelt Textilmüll in hochwertige Rohstoffe. Mit Millioneninvestments baut das Team um Steffen Gerlach und Tobias Börnhorst nun die erste Demonstrationsanlage auf.

Steffen Gerlach saß entspannt mit seinem Schulfreund Reiner Mantsch auf einer Couch in einer Kölner Wohngemeinschaft. Mantsch hatte zuvor an der Universität in Mönchengladbach Textiltechnik studiert. Er berichtete leidenschaftlich von seinen naturwissenschaftlichen Forschungen zur Kreislaufwirtschaft. Dieses Gespräch veränderte Gerlachs gesamte berufliche Planung radikal. Mantsch suchte jemanden für die Marktseite seiner technischen Vision. Gerlach war sofort fasziniert von dem ökonomischen Potenzial. Er wollte wissen, ob man daraus ein echtes Unternehmen formen kann. „Das war der eigentliche Startpunkt für eeden. Wir entschieden uns für einen vollen Fokus auf das Projekt. Und wir wollten das Recyclingproblem der Branche grundlegend lösen“, erinnert sich Gerlach.

Der langsame Weg zum technologischen Durchbruch

Es gab keinen plötzlichen Heureka-Moment in einem winzigen und improvisierten Labor. Die Entwicklung war eher eine gezielte Suche nach einer Problemlösung. Mantsch war früher Leistungssportler und brachte den nötigen Fokus mit. Er sah den Frust seiner Kommilitonen nach Praktika in der Industrie. Die Branche wirkte starr und wenig dynamisch für junge Talente. Das Duo suchte stattdessen nach den Megatrends der Zukunft. „Die Kreislaufwirtschaft kristallisierte sich schnell als das zentrale Thema heraus. Ich habe die Marktseite intensiv analysiert und viele Gespräche geführt“, so Gerlach. Er erkannte die Verknüpfungen zwischen technischer Machbarkeit und ökonomischen Anforderungen. Die Suche nach dem technologischen Sweetspot dauerte Monate. Am Anfang stand lediglich die reine Faszination für das Recycling. Es war ein schleichender Prozess mit vielen Etappenentscheidungen.

Die wachsende Last der globalen Fast Fashion

Das Umweltproblem der globalen Textilindustrie ist mittlerweile gewaltig. Die Branche verdoppelt ihren Durchsatz alle 20 bis 30 Jahre. Jährlich werden mittlerweile mehr als 120 Mio. Tonnen Textilien produziert. Nach Angaben der Ellen MacArthur Foundation werden weltweit ungefähr zwei Drittel dieser Mengen praktisch direkt nach der Nutzung entsorgt; sie landen auf riesigen Deponien oder werden ungenutzt verbrannt. In Deutschland steht das klassische Rücknahmesystem laut Experten vor dem Kollaps. Es gibt nach seiner Aussage derzeit eine gestiegene Anzahl an Insolvenzen bei Sammel- und Sortierbetrieben. Die Qualität der Kleidung sinkt durch den Trend zur Fast Fashion massiv. Der Wiederverkauf der gebrauchten Ware lohnt sich oft nicht mehr. Neuware aus Asien ist meistens günstiger als Second Hand-Stücke aus Europa. In Deutschland verursacht die Entsorgung einer Tonne Altkleider zudem Kosten – das Material wird somit zur finanziellen Belastung für die Sammel- und Sortierbetriebe.

Chemische Trennung als industrieller Schlüssel

Das Unternehmen aus Münster setzt genau an diesem Punkt an. Die Technologie ermöglicht die Trennung von Baumwolle und Polyester und macht beide Materialien wieder nutzbar. Das ist entscheidend für den Erfolg der Kreislaufwirtschaft. Die meisten Textilien bestehen heute aus komplexen Mischgeweben. Gerlach erklärt, dass das Unternehmen aus dem Abfall eine hochwertige Cellulose und chemische Bausteine für neues Polyester gewinnt. Die Cellulose dient als sauberes Vorprodukt für die neue Faserherstellung. Das Polyester wird in seine Grundbausteine zerlegt, die für die Herstellung von neuem Polyester verwendet werden können. „Wir stellen aus Baumwolle eine hochwertige Cellulose her und gewinnen aus dem Polyester die chemischen Bausteine zurück“, sagt Gerlach. Beide Materialströme können direkt wieder in der Textilproduktion eingesetzt werden. Damit wird der Kreislauf zwischen Abfall und Kleidung geschlossen. Seit Anfang 2025 hilft zudem eine neue gesetzliche Regelung. Die EU-weite Getrenntsammlungspflicht für Textilabfälle ist in Kraft getreten: Unternehmen dürfen Textilien nun nicht mehr über den Restmüll entsorgen. Das sichert den Zugang zu großen Mengen an Rohstoffen.

Harte Verhandlungen in der Welt des Wagniskapitals

Der Weg von der ersten Idee zur fertig gebauten Industrieanlage ist lang. Deeptech-Unternehmen brauchen oft viel Geduld und Zeit für die Entwicklung. Das erfordert Investoren mit einem sehr langen Atem. In einer frühen Phase kam der High-Tech Gründerfonds an Bord. Auch die NRW.Bank und der TechVision Fonds unterstützen das Vorhaben. Später stiegen Forbion und der Chemiekonzern Henkel als Investor ein. Gerlach erinnert sich im Gespräch an einen intensiven Lernprozess bei den ersten Finanzierungsrunden. Man müsse technische Begeisterung mit harten Umsatzprognosen anreichern. Auch D11Z.Ventures, das Family Office von Dieter Schwarz (Lidl/Kaufland), investierte in das Unternehmen. Die Investoren verstehen laut Gerlach die Entwicklungszyklen und Skalierung von Deeptech-Unternehmen. Mittlerweile flossen über 20 Mio. EUR an Kapital in die Firma. Dieses Geld ermöglicht nun den nächsten großen Schritt.

Ein neues Team für die industrielle Skalierung

Das Start-up ist mittlerweile den Kinderschuhen entwachsen. In Münster entsteht derzeit eine industrielle Demonstrationsanlage. Gerlach erinnert sich an den Moment der Schlüsselübergabe: Zuerst wirkte die leere Halle riesig auf das Team. Inzwischen planen die Ingenieure bereits jeden Zentimeter der Fläche. Das Team ist auf über 25 Köpfe gewachsen. Es ist eine Mischung aus jungen Talenten und erfahrenen Kräften. Viele Mitarbeitende wechselten von großen Konzernen wie BASF nach Münster. Gerlach beobachtet eine große Lust auf die Arbeit an innovativen Prozessen. Die flachen Hierarchien im Unternehmen ziehen Experten an. Er schätzt das Know-how dieser Fachkräfte für den Anlagenbau. Erfahrene Chemiker bringen eine neue Qualität in die Prozesse. Die Zusammenarbeit zwischen Alt und Jung funktioniert hervorragend.

Führung zwischen Agilität und unternehmerischer Verantwortung

Die Unternehmenskultur hat sich mit der Größe weiterentwickelt. Gerlach betont, dass viele Impulse direkt aus der Belegschaft kommen. So wurde die Regelung für die Präsenz im Büro gemeinsam erarbeitet. Die Mitarbeitenden wünschten sich feste Tage für den Austausch. „Die schönsten Tage sind jene mit viel Begegnung“, berichtet Gerlach. Die bürokratischen Pflichten eines Geschäftsführers gehören einfach dazu. Trotzdem bleibt die Mission der Firma der wichtigste Treiber. Die Motivation im gesamten Team sei extrem hoch. Jeder packt an und treibt das Unternehmen voran. Der Spagat zwischen Entwicklung und Business ist fordernd. Gerlach jedoch genießt diese tägliche Herausforderung sehr.

Der Standort Deutschland als Zentrum für Innovation

Viele Fachleute kritisieren die Bedingungen für die Chemieindustrie. Hohe Energiekosten belasten die traditionsreichen Unternehmen stark. Gerlach sieht das differenzierter aus der Perspektive von innovativen Start-ups: „Für die Entwicklung neuer Technologien ist der Standort Deutschland weiter exzellent. Und die Qualifikation der Technologen ist hervorragend. Die aktuelle Krise führt bei uns auch zu Bewerbungen von erfahrenen Talenten aus der chemischen Industrie – die hätte es vor einigen Jahren in der Menge nicht gegeben.“ Die vorhandene Infrastruktur sei ein klarer Vorteil. Auch Konzerne beobachten solche Innovationen genau. Die Nähe zum Mittelstand fördert zudem die Skalierung. Für die beiden Gründer ist die aktuelle Produktionsanlage nur ein Anfang. Langfristig soll die Technologie weltweit lizenziert werden; überall auf der Welt fällt schließlich Textilmüll an. Die Kombination aus Ingenieurskunst und Skalierung ist das Ziel. Auch die aktuellen Investoren von eeden sehen dieses globale Potenzial. Das Unternehmen will beweisen, dass sich Kreislaufwirtschaft lohnt. Deutschland bleibt dafür ein wichtiger Ankerpunkt.

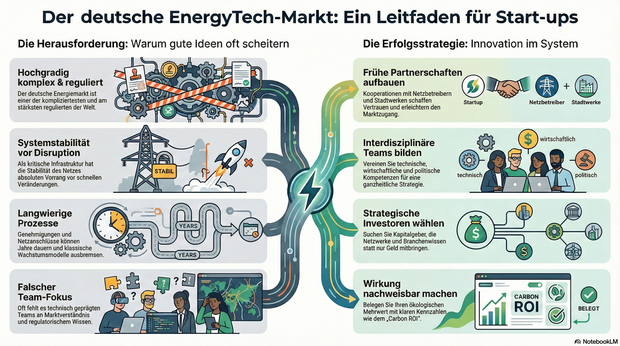

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

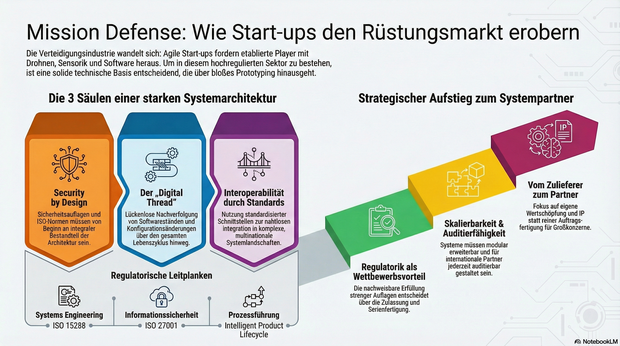

Mission Defense: Wie Start-ups im rüstungstechnischen Markt Fuß fassen

Immer mehr Start-ups drängen mit agilen Innovationen in die hochregulierte Verteidigungs- und Luftfahrtindustrie. Daher gut zu wissen: Wie junge Unternehmen durch die richtige Systemarchitektur die strengen Auflagen meistern und vom Zulieferer zum echten Systempartner aufsteigen.

Die Luft- und Raumfahrt sowie die Verteidigungsindustrie zählen zu den am stärksten regulierten und technologisch anspruchsvollsten Märkten der Welt. Lange galt: Wer hier mitspielen will, braucht jahrzehntelange Erfahrung, Milliardenbudgets und stabile Regierungsbeziehungen. Doch genau dieses Bild verschiebt sich.

Neue Player treten auf den Plan: Start-ups entwickeln Trägersysteme, Drohnenplattformen, Kommunikationslösungen oder Sensorik, und tun das in einer Geschwindigkeit, die vielen etablierten Anbietern Kopfzerbrechen bereitet. Die zentrale Frage lautet deshalb: Wie können junge Unternehmen in einer hochregulierten Branche nicht nur überleben, sondern mitgestalten?

Agilität als Superkraft – aber Prototypen reichen nicht

Ob neue unbemannte Plattformen, Software-Defined Defense Systeme oder taktische Kommunikation – überall gilt: Was heute entwickelt wird, muss morgen schon einsatzbereit sein. Der Bedarf an schneller Innovation ist nicht theoretisch, sondern operativ. Start-ups sind in der Lage, auf diesen Druck zu reagieren, mit kurzen Entscheidungswegen, agilen Teams und digitaler DNA.

Allerdings reichen gute Ideen und schnelles Prototyping nicht aus. Wer Systeme für den operativen Einsatz liefern will, muss Anforderungen erfüllen, die weit über funktionierende Technik hinausgehen: Cybersicherheit, regulatorische Nachvollziehbarkeit, Zertifizierungsfähigkeit und Interoperabilität mit internationalen Partnern.

Das Fundament: Die Systemarchitektur entscheidet

Von Anfang an auf die richtigen technischen Grundlagen zu setzen, ist entscheidend. Das betrifft vor allem drei Bereiche: Skalierbarkeit, Nachvollziehbarkeit und Interoperabilität. Systeme müssen so gebaut sein, dass sie modular erweitert, in komplexe Systemlandschaften integriert und nach internationalen Standards auditiert werden können.

Ein durchgängiger digitaler Entwicklungs- und Betriebsfaden, ein sogenannter Digital Thread oder auch Intelligent Product Lifecycle, ermöglicht es, Produktdaten, Softwarestände und Konfigurationsänderungen über den gesamten Lebenszyklus hinweg zu verfolgen. Für die Zulassung softwaredefinierter, sicherheitskritischer Systeme ist das ebenso essenziell wie für die spätere Wartung, Upgrades oder die Einbindung in multinationale Operationen.

Security by Design: Sicherheit lässt sich nicht nachrüsten

Verteidigungsnahe Produkte unterliegen Exportkontrollen, Sicherheitsauflagen und branchenspezifischen Normen, darunter etwa ISO 15288 für Systems Engineering, ISO 27001 für Informationssicherheit oder die europäischen Anforderungen für Luftfahrt und Raumfahrt. Diese Vorgaben lassen sich nicht einfach „nachrüsten“. Sie müssen von Beginn an ein integraler Bestandteil der Systemarchitektur und Prozessführung sein.

Gerade in sicherheitskritischen Bereichen ist die Fähigkeit, regulatorische Anforderungen nachweislich zu erfüllen, ein entscheidender Wettbewerbsvorteil. Sie entscheidet darüber, ob ein Produkt zugelassen, in Serie gefertigt und in multinationale Programme integriert werden kann.

Interoperabilität als Schlüssel zum Teamplay

Ein weiterer kritischer Faktor ist die Fähigkeit zur Kooperation. In den meisten großen Programmen arbeiten unterschiedliche Unternehmen, oft aus verschiedenen Ländern, mit unterschiedlichen Systemen zusammen. Wer hier bestehen will, muss in der Lage sein, mit standardisierten Schnittstellen, interoperablen Plattformarchitekturen und harmonisierten Datenmodellen zu arbeiten. Interoperabilität ist dafür die technische Grundlage. Ohne sie lassen sich Systeme weder integrieren noch gemeinsam weiterentwickeln.

Vom Zulieferer zum echten Systempartner

Start-ups, die sich diesen Anforderungen stellen, können mehr sein als Zulieferer. Sie haben das Potenzial, Systempartner zu werden: mit eigener Wertschöpfung, eigenem IP und eigenem Einfluss auf die technologische Entwicklung. Der Weg dorthin ist anspruchsvoll, aber offen. Er erfordert keine hundertjährige Firmengeschichte, sondern eine klare Architekturstrategie, ein tiefes Verständnis für regulatorische Anforderungen und den Willen, komplexe Systeme systematisch zu entwickeln.

Der Verteidigungs- und Luftfahrtsektor steht an einem Wendepunkt. Wer heute die richtigen Grundlagen legt, kann morgen zu denjenigen gehören, die nicht nur mitlaufen, sondern die Spielregeln neu definieren.

Der Autor Jens Stephan, Director Aerospace & Defence bei PTC, bringt über 20 Jahre Erfahrung im Bereich komplexer Software-/SaaS-Lösungen und IT-Infrastruktur mit.

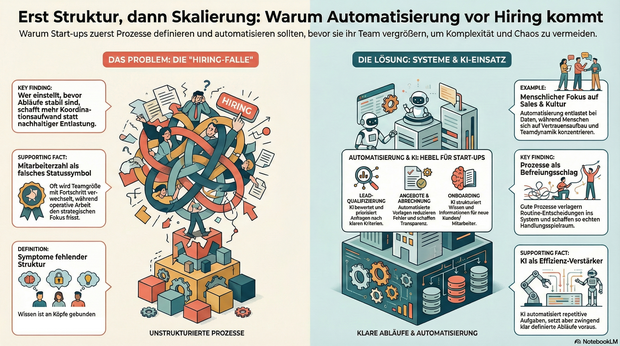

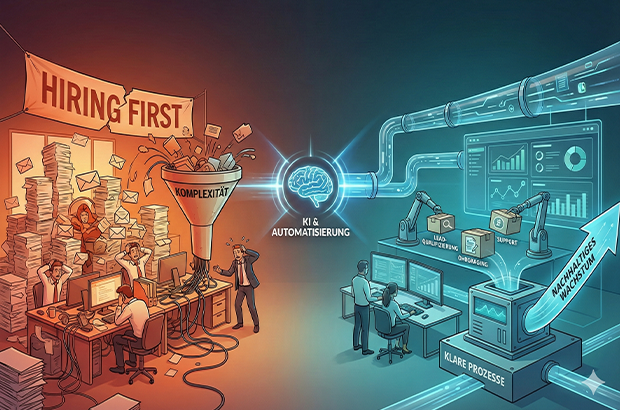

Automatisierung vor Hiring, sonst wird Komplexität skaliert

Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung. Tipps und To-Dos.

Wachstum wird in Start-ups oft sehr eindimensional gedacht: mehr Nachfrage gleich mehr Menschen. Sobald Anfragen steigen, Deals reinkommen oder neue Märkte locken, folgt fast automatisch der nächste Hiring-Plan. Dabei wird häufig die Ursache mit Wirkung verwechselt. Nicht fehlende Kapazität bremst junge Unternehmen, sondern fehlende Struktur. Prozesse entstehen improvisiert, Verantwortung wird situativ verteilt, operative Arbeit frisst Fokus. Und irgendwann fühlt sich Wachstum nicht mehr nach Fortschritt, sondern nach Dauerstress an.

Gerade in der Start-up-Branche wird Wachstum zudem stark über sichtbare Kennzahlen bewertet. In Gesprächen mit Investor*innen lautet eine der ersten Fragen häufig nicht Gewinn oder EBITA, sondern: Wie viele Mitarbeitende seid ihr und wie viel Umsatz macht ihr? Die Anzahl der Mitarbeitenden wird damit fast zu einem Statussymbol. Hiring wird nicht nur zur operativen, sondern auch zur psychologischen Größe und ein Zeichen von Fortschritt. Diese Logik verstärkt den Reflex, früh zu skalieren, auch wenn die strukturellen Voraussetzungen dafür noch fehlen. Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung.

Warum Hiring allein selten skaliert

Mehr Menschen im Team wirken wie eine schnelle Lösung. In der Praxis zeigt sich jedoch häufig ein ähnliches Muster: Neue Kolleg*innen übernehmen Aufgaben, die eigentlich nur deshalb existieren, weil Abläufe unklar oder manuell gewachsen sind. Statt nachhaltiger Entlastung entsteht zusätzliche Koordination.

Typische Symptome sind:

- operative Aufgaben blockieren strategische Arbeit,

- Wissen verteilt sich auf einzelne Köpfe,

- Entscheidungen hängen an Personen statt an klaren Abläufen,

- Abstimmungen nehmen zu, ohne dass die Wertschöpfung im gleichen Maß wächst.

Das Problem ist nicht Hiring an sich, sondern die Reihenfolge. In vielen Fällen wird Hiring eingesetzt, um kurzfristig Druck rauszunehmen, obwohl das eigentliche Nadelöhr fehlende Klarheit ist. Wer einstellt, bevor Abläufe stabil sind, schafft zwar mehr Kapazität, skaliert aber auch Komplexität.

Prozesse als Voraussetzung für wirksames Wachstum

Prozesse werden in Start-ups häufig mit Bürokratie verwechselt. Tatsächlich sind sie das Gegenteil: Sie reduzieren Reibung. Gute Prozesse verlagern Entscheidungen vom Einzelfall ins System. Sie beantworten zwei zentrale Fragen zuverlässig: Was passiert als Nächstes – und wer ist verantwortlich?

Gerade kleine Teams profitieren davon besonders. Prozesse schaffen keine Starrheit, sondern Handlungsspielraum. Sie machen Arbeit vorhersehbar, Übergaben sauber und Entscheidungen reproduzierbar. Erst auf dieser Grundlage kann ein wachsendes Team seine Stärke wirklich entfalten.

Automatisierung im KI-Zeitalter: neue Möglichkeiten, neue Verantwortung

Mit KI hat sich die Eintrittshürde für Automatisierung massiv gesenkt. Viele Aufgaben, die früher manuell oder individuell erledigt wurden, lassen sich heute zuverlässig unterstützen oder teilweise abnehmen, vorausgesetzt, der zugrunde liegende Ablauf ist klar definiert. Entscheidend ist dabei nicht die Tool-Auswahl, sondern die Frage, was automatisiert wird. Automatisierung verstärkt bestehende Strukturen, gute wie schlechte. Wer unklare Abläufe automatisiert, skaliert keine Effizienz, sondern Chaos. Gleichzeitig gibt es zentrale Bereiche, die sich bewusst nicht oder nur sehr begrenzt automatisieren lassen und auch nicht sollten. Recruiting ist einer davon. Der Aufbau eines funktionierenden Teams lebt von persönlicher Einschätzung, Teamdynamik und kulturellem Fit. Ähnliches gilt für Sales: Vertrauensaufbau, Verhandlung und das persönliche Gespräch bleiben essenziell. Automatisierung ist hier unterstützend, aber kein Ersatz. Besonders geeignet sind Tätigkeiten, die häufig auftreten, wenig kreativen Spielraum haben und auf wiederkehrenden Informationen basieren.

Bereiche, die sich heute besonders gut automatisieren lassen

Lead- und Anfragequalifizierung

Unstrukturierte Anfragen lassen sich mithilfe von KI zusammenfassen, bewerten und priorisieren. Statt jede Anfrage manuell zu prüfen, entstehen klare Kriterien, die relevante von irrelevanten Leads trennen und Follow-ups vorbereiten.

Angebots- und Abrechnungsprozesse

Angebote, Verträge und Rechnungen folgen in vielen Startups ähnlichen Mustern. Automatisierte Vorlagen, angebundene Datenquellen und definierte Freigaben sparen Zeit, reduzieren Fehler und schaffen Transparenz.

Onboarding von Kund:innen und Mitarbeitenden

Onboarding ist kein Einzelfall, sondern ein wiederkehrender Prozess. Checklisten, automatische Aufgaben und zentrale Informationspunkte sorgen für Verlässlichkeit. KI kann helfen, Informationen zu strukturieren und kontextbezogen bereitzustellen.

Support und interne Anfragen

Ein Großteil von Fragen wiederholt sich. Wissensbasen in Kombination mit KI-gestützter Suche und Antwortvorschlägen entlasten Teams und machen sichtbar, wo Standards fehlen.

Projektmanagement und Übergaben

Klare Projekt-Templates, automatisierte Status-Updates und definierte Trigger reduzieren Abstimmungsaufwand. KI kann dabei unterstützen, Risiken früh zu erkennen oder nächste Schritte vorzuschlagen.

Was Start-ups daraus lernen können

Automatisierung ersetzt keine Entscheidungen, sie macht sie skalierbar. Voraussetzung dafür ist Klarheit über Abläufe, Verantwortlichkeiten und Prioritäten. Wer versucht, Chaos zu automatisieren, verstärkt es lediglich.

Hilfreiche Leitfragen sind:

- Welche Aufgaben wiederholen sich regelmäßig?

- Wo entstehen manuelle Engpässe?

- Welche Tätigkeiten binden qualifizierte Menschen ohne echten Mehrwert?

Die Antworten darauf liefern meist schnell die größten Hebel.

Der KI-Wendepunkt: Systeme und Personal

Nachhaltiges Wachstum entsteht dort, wo Start-ups Systeme aufbauen und diese bewusst mit ihrem Team verzahnen. Nicht, weil Systeme Menschen ersetzen, sondern weil sie Menschen von struktureller Überforderung entlasten. Automatisierung schafft dabei nicht nur Effizienz, sondern Entscheidungsqualität: Wenn Daten sauber fließen, Übergaben klar sind und Standards greifen, werden Prioritäten weniger Bauchgefühl und stärker reproduzierbar.

Der gezielte Einsatz von KI-Tools verschiebt diesen Wendepunkt zusätzlich. Sie können Routinearbeiten abfangen, Informationen aus unstrukturierten Inputs verdichten und Entscheidungen vorbereiten – etwa durch Lead-Vorqualifizierung, Support-Clustering oder zusammengefasste Status-Updates. KI wirkt dabei nicht als Ersatz für Klarheit, sondern als Verstärker funktionierender Prozesse.

Hiring bleibt auch weiterhin essentiell. Seine Wirkung entfaltet es jedoch erst dann vollständig, wenn Prozesse klar sind und Automatisierung sowie KI gezielt unterstützen. So entsteht Wachstum, das nicht nur schneller, sondern auch gesünder ist.

Der Autor Markus Hetzenegger ist Gründer & CEO von NYBA Media. 2018 gegründet, zählt NYBA heute zu den führenden Marketing-Unternehmen im Live-Entertainment.

Von der Kochbox zum Hundenapf: Ex-HelloFresh-Duo startet Tasty Petfood

Wie Lisa Vannini und Nadja Chylla mit ihrem Start-up Tasty Petfood die etablierten Premium-Tierfuttermarken herausfordern.

Das Berliner Start-up Tasty Petfood ist offiziell in den Markt eingetreten. Das Unternehmen, gegründet von den ehemaligen HelloFresh-Kolleginnen Lisa Vannini und Nadja Chylla, positioniert sich im Premium-Segment für Hundefutter und setzt dabei auf ein digitales Vertriebsmodell. Der offizielle Marktstart in Deutschland und der Schweiz erfolgte am 6. Februar 2026.

Transfer von Food-Logistik auf den Heimtiermarkt

Die Gründerinnen arbeiteten zuvor über fünf Jahre gemeinsam beim Kochboxen-Versender HelloFresh. Das dort in den Bereichen Skalierung und Operations gewonnene Know-how wollen Lisa und Nadja nun auf den Heimtiermarkt übertragen.

„Wir haben gemerkt, dass viele Hundehalter entweder bei klassischem Trockenfutter bleiben oder sehr viel Zeit in aufwendige BARF-Konzepte investieren müssen. Genau diese Lücke zwischen Bequemlichkeit und echter Qualität wollten wir schließen“, berichtet Lisa.

Das Kernprodukt von Tasty Petfood unterscheidet sich logistisch von herkömmlichem Nassfutter oder Barf-Angeboten: Das Unternehmen vertreibt dampfgegartes Frischfutter im Glas. Ein wesentlicher Unterschied zu vielen Wettbewerbern im Frische-Segment ist die Haltbarmachung: Die Produkte benötigen keine geschlossene Kühlkette und können ungekühlt gelagert werden. Dies reduziert die Komplexität in der Lagerhaltung und im Versand erheblich – ein Faktor, der im D2C-Bereich direkten Einfluss auf die Unit Economics hat. „Unser Anspruch war Qualität wie selbstgekocht – aber ohne Kühlschrank und ohne komplizierte Logistik. Dass wir Frische, Haltbarkeit und Alltagstauglichkeit verbinden können, ist für viele Kundinnen und Kunden ein echter Gamechanger“, sagt Nadja.

Wachstumskurs in einem Milliardenmarkt

Mit ihrem Geschäftsmodell stoßen die Gründerinnen in ein wirtschaftlich hochattraktives Umfeld vor. Nach aktuellen Daten des Industrieverbands Heimtierbedarf (IVH) und des Zentralverbands Zoologischer Fachbetriebe (ZZF) liegt der Gesamtumsatz der Branche bei rund sieben Milliarden Euro, wobei allein das Segment für Fertignahrung gut 4,4 Milliarden Euro ausmacht. Trotz allgemeiner wirtschaftlicher Herausforderungen bleibt die Zahlungsbereitschaft der Halter hoch.

Während der Absatz im Standard-Segment teils stagniert, wächst der Bereich für Premium-Nahrung kontinuierlich. Tasty Petfood ordnet sich im oberen Preissegment ein und zielt auf eine kaufkräftige Zielgruppe, die den Trend zur „Humanisierung“ des Haustiers vorantreibt.

„Hunde werden heute immer stärker als Familienmitglieder gesehen. Entsprechend steigen die Ansprüche an Transparenz, Zutatenqualität und Nährstoffversorgung – ähnlich wie beim eigenen Essen“, so Lisa.

Die Nische zwischen Konzern und Tiefkühltruhe

In diesem dynamischen Umfeld muss sich Tasty Petfood gegen zwei Lager behaupten. Zum einen konkurriert das Start-up mit etablierten Premium-Marken im stationären Handel wie Terra Canis, das als Pionier für „Human Grade“-Nahrung gilt und seit 2017 mehrheitlich zum Nestlé-Konzern gehört. Zum anderen wächst der Druck durch rein digitale Player wie Butternut Box oder HelloBello, die ebenfalls auf personalisiertes Frischfutter setzen, dieses jedoch tiefgekühlt versenden.

Genau hier besetzt Tasty Petfood eine strategische Lücke: Start-ups fungieren in diesem Sektor aktuell als wesentliche Innovationstreiber, und die Berliner Gründerinnen nutzen dies für eine „Ambient Fresh“-Strategie. Mit ungekühlt haltbarem Frischfutter verbindet das Unternehmen den steigenden Wunsch nach Convenience mit der Qualität von Frische-Menüs – ein entscheidender Logistik-Vorteil gegenüber der aufwendigen Tiefkühl-Konkurrenz. „Wir sitzen genau zwischen Tiefkühltruhe und Trockenfutter. Unser Futter ist reisefähig, blockiert keinen Gefrierschrank und passt damit perfekt in den Alltag moderner Hundehalter“, sagt Nadja.

Datengetriebenes Abo-Modell

Der Bestellvorgang für den/die Endkund*in ist vollständig datengestützt aufgebaut. Zu Beginn erfassen Interessent*innen über ein Online-Quiz relevante Parameter wie Rasse, Alter und Gewicht des Tieres. Auf Grundlage dieser Daten berechnet das Unternehmen einen individuellen Futterplan, der exakt auf den Hund zugeschnitten ist. Um die Akzeptanz zu testen, erhalten Neukund*innen zunächst eine Probebox mit verschiedenen Sorten. Bei erfolgreicher Annahme geht das Modell automatisch in ein flexibles Abonnement über, bei dem sowohl die Rationsgröße als auch der Lieferrhythmus dynamisch an den tatsächlichen Bedarf des Hundes angepasst werden. „Viele Halter sind unsicher, ob sie ihren Hund wirklich bedarfsgerecht füttern. Unser Algorithmus nimmt ihnen diese Entscheidung ab und sorgt dafür, dass Menge und Nährstoffe langfristig passen“, so Lisa.

Positionierung im Premium-Segment

Das Produktportfolio umfasst zum Start sechs Sorten auf Monoprotein-Basis. Durch den hohen Fleischanteil und den Verzicht auf Füllstoffe oder Konservierungsmittel zielt das Start-up auf die „Human Grade“-Nische ab. Das Produkt ist dabei so designt, dass es optisch und qualitativ an selbstgekochtes Futter erinnert, um die Hürde für qualitätsbewusste Käufer*innen zu senken. Das Kalkül: Die Zielgruppe sucht die Qualität einer BARF-Ernährung, benötigt aber die Convenience eines Fertigprodukts. „Unser Ziel ist es, Pet Nutrition durch sichtbare Qualität und Transparenz neu zu definieren“, so Nadja über den Anspruch, moderne Halterbedürfnisse mit dem Produkt-Design zu adressieren.

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

Diese 10 Start-ups bauen an der Zukunft der AgriFood-Branche

Die deutsche Start-up-Landschaft verzeichnete 2025 ein Rekordhoch bei Neugründungen. Doch gerade im AgriFood-Sektor ist der Weg vom Prototyp zum Marktführer steinig. Kapitalintensive Hardware und strenge Regulatorik bremsen viele aus. Der Growth Alliance Accelerator zeigt, wie Gründer*innen diese Hürden überspringen – und präsentiert zehn Akteure, die auf der Erfolgsspur sind.

Es ist ein Paradoxon: Die Nachfrage nach nachhaltigen Lebensmitteln und effizienter Landwirtschaft ist so hoch wie nie, doch für Gründer*innen und junge Unternehmen in der AgriFood-Branche bleibt der Markteintritt ein Hürdenlauf. Während Software-Start-ups oft mit geringem Kapital skalieren, kämpfen Food- und AgTech-Pioniere mit der „Hardware-Falle“. Sie benötigen teure Produktionsanlagen, Labore und müssen langwierige Zulassungsverfahren (z.B. Novel-Food-Verordnung) durchlaufen.

Dennoch ist die Branche im Aufwind: Laut dem Deutschen Startup Monitor und aktuellen Zahlen des Startup-Verbands stiegen die Gründungszahlen 2025 um beachtliche 29 Prozent. Das Kapital ist da, doch es fließt selektiv. Investor*innen suchen heute keine reinen Ideen mehr, sondern validierte Geschäftsmodelle mit technologischem Tiefgang (DeepTech). Genau hier setzte das Finale des Growth Alliance Accelerator 2025 am 28. Januar 2026 in Frankfurt/Main an.

Brückenschlag zwischen Acker und Finanzwelt

Initiiert vom TechQuartier und der Landwirtschaftlichen Rentenbank, hat sich der Accelerator als Schmiede für die „Scale-up“-Phase etabliert. Vier Monate lang wurden zehn Start-ups, die bereits eine Nutzer*innenbasis vorweisen konnten, fit für die nächste Finanzierungsrunde gemacht.

Das Programm adressierte genau die Pain Points der Branche: Verhandlungstaktik, Rechtsfragen und vor allem den Zugang zu Kapital. Ein Highlight war das Investor Dinner im November 2025, bei dem die Gründer*innen direkten Zugang zu Risikokapitalgeber*innen erhielten – in der aktuellen Marktphase ein entscheidender Wettbewerbsvorteil.

Die „Class of 2025“: Wer die Transformation treibt

Die zehn Absolvent*innen decken die gesamte Wertschöpfungskette ab – vom Boden über das Labor bis zum Supermarktregal. Hier ein Blick auf die Köpfe hinter den Innovationen:

1. High-Tech auf dem Acker: Robotik und Daten

Die Digitalisierung der Landwirtschaft (Smart Farming) ist der stärkste Hebel für mehr Effizienz.

Paltech GmbH