Aktuelle Events

Smart Urban Mobility – quo vadis?

Warum sich die Frage nach der städtischen Mobilität der Zukunft nur (noch) bedingt um das Thema E-Mobilität dreht.

Kaum eine Branche verändert sich derzeit schneller als die Automobilindustrie. Dabei geht es längst nicht mehr nur um Verkaufszahlen, Fragen zu zukunftsfähigen Antriebstechnologien oder autonomen Fahrfunktionen, sondern immer mehr um eine gesellschaftliche Gesamtbetrachtung der Mobilität. Ein stärker werdendes Bewusstsein für Nachhaltigkeit sorgt ebenso für ein Umdenken wie neue technische Möglichkeiten, steigende Energiepreise oder die pandemiebedingte Änderung des Pendler*innenverhaltens und die damit verbundene Akzeptanz von Home- und Remote-Offices.

Metropolen treiben den Diskurs über eine grundsätzliche Verbannung von Autos aus den Stadtzentren an. Ridesharing und -hailing werden als Alternativen zum eigenen Fahrzeug entdeckt. Gleichzeitig tauchen nicht traditionelle Automobilunternehmen und Start-ups mit neuen Lösungen zum Beispiel für die letzte Meile in der Logistik oder im Individualverkehr auf. Im Ergebnis konkurrieren Automobilherstellende nicht mehr nur untereinander, sondern sind mit einem immer komplexer und dynamischer werdenden Wettbewerbsumfeld konfrontiert.

Mobilität ist im Wandel

Klar ist: Mobilität ist im Wandel begriffen und die Karten ihrer Protagonist*innen werden kräftig neu gemischt. Denn während sich die Prioritäten und Erwartungen an die Mobilität der Zukunft verändern, positionieren sich erfolgreich neue Thought Leader, die mit innovativen Ideen und starken Meinungen Gehör finden. An potenziell Diskussionsbeteiligten mangelt es hierbei nicht. Zu den Mobilitätsgestalter*innen von morgen gehören große Teile der Industrie – etwa Automobilherstellende oder Zuliefernde von Technologie –, aber eben auch Menschen und Institutionen aus anderen Bereichen, wie etwa Regierungsverantwortliche, Verkehrspolitiker*innen und NGOs.

Elektrifizierung, Konnektivität, autonomes Fahren, öffentlicher Nahverkehr und urbane Zentren, Infrastruktur, Klimaschutz – all diese Themen wurden und werden aktuell neu bewertet. Und obwohl viele Menschen während der Pandemie gerade das private Auto wieder als beste und sicherste Form der Mobilität zu schätzen gelernt haben, ist die öffentliche Debatte längst in eine andere Richtung gesteuert. Denn drehten sich die meisten Diskussionen zur Mobilität der Zukunft vor der Pandemie noch um den unausweichlichen Weg in Richtung Elektromobilität, scheinen in den letzten zwei Jahren mehr und mehr Konzepte für eine grundlegende Veränderung der Mobilität gefragt.

Für einen echten Wandel scheint die einfache Umstellung des Antriebskonzepts vielfach zu kurz gesprungen. Entsprechend häufig wird ein grundsätzlicher Mobilitätswandel gefordert. Das ergab eine zwischen Oktober 2020 und März 2022 durchgeführte Studie des Centers for Automotive Research (CAR Research, Ann Arbor) und UNICEPTA, einem globalen Anbieter für Media & Marketing Intelligence. Mit KI-getriebener Technologie und über 450 Analyse- und Monitoring-Expert*innen analysiert das Unternehmen weltweit verfügbare Inhalte aus Social Media, Online, Print, TV und Rundfunk sowie zahlreichen weiteren Datenquellen.

Untersucht wurden in der Studie über 350.000 Berichterstattungen in klassischen Medien und Social-Media-Posts nach thematischen Schwerpunkten rund um Smart Urban Mobility und ihre Absenderschaft.

Es geht nur noch selten um E-Mobilität

Das Ergebnis: Angetrieben von Pandemie und Klimakrise werden in der medialen Debatte langfristige Visionen gesucht. So geht es hier immer mehr um ganzheitliche Konzepte und die Frage, wie die Städte lebenswerter gestaltet werden können, als um kleinteilige technische Lösungen oder Produkte. Damit verbunden werden vor allem technologische Entwicklungen sowie autofreie Innenstädte, angetrieben von den Überlegungen großer Metropolen. Besonders häufig wurden dabei in der Diskussion die Begriffe „Urban Mobility Concept“ (186.000 Artikel und Posts), „Smart Cities“ (54.000 Artikel und Posts) und „Car-free Cities“ (38.000 Artikel und Posts) verwendet. Weit abgeschlagen: Begriffe wie „E-Mobility“ (4000 Artikel und Posts) oder „Charging Infrastructure“ (3000 Artikel und Posts).

Wirtschaft überlässt Politik die Kommunikation

Wenn jedoch Antriebsinnovationen, Höchstgeschwindigkeit und Blech-Design als Kommunikationsfokus ausgedient haben und an deren Stelle holistische Veränderungen in der Art und Weise treten, wie wir künftig leben, arbeiten und uns bewegen, dann ergeben sich daraus völlig neue Herausforderungen für Automobilunternehmen. Deren Kernkompetenz, automotive Individualmobilität, scheint in der öffentlichen Wahrnehmung immer mehr an Gewicht zu verlieren. Die Konsequenz: Automobilunternehmen spielen in den Debatten über Smart Citys und neue Mobilitätskonzepte für Städte keine führende Rolle und sind eher Gegenstand der Diskussionen als aktive(r) Teilnehmer*innen oder gar Absender*innen.

Zugunsten ihrer Glaubwürdigkeit fokussieren die Kommunikationsabteilungen und Unternehmenslenker*innen gezielt auf Produktthemen, die vor allem ihre eigenen Services betreffen – zum Beispiel eigene Elektroautos –, und verpassen es damit, den öffentlichen Diskurs um die Lösungsfindung aktiv und in ihrem Sinne zu gestalten.

Weitaus aktiver kommunizieren da Unternehmen aus der Elektronikbranche. Bei denjenigen, die in der Debatte zur urbanen Mobilität sichtbarer sind, handelt es sich vor allem um Tech-Player wie Google, Microsoft, Huawei oder CISCO sowie eben vermehrt um junge Start-ups aus der Mikromobilität. Doch auch diese zeichnen meist kein echtes Bild einer ganzheitlich urbanen Mobilitätsvision, sondern präsentieren ihre eigenen individuellen Geschichten und Lösungen – und lassen damit wichtiges Potenzial ungenutzt.

Denn auf diesem Weg überlässt die Wirtschaft vor allen Dingen den unabhängigen Expert*innen, Nichtregierungsorganisationen und politischen Entscheidungsträger*innen die Kommunikationshoheit zur urbanen Mobilität. So zitieren 59 Prozent aller in der Studie analysierten Berichterstattungen und Social-Media-Posts Entscheidungsträger*innen aus Politik und öffentlicher Verwaltung sowie engagierte Aktivist*innen/Organisationen, gefolgt von Journalist*innen (18 Prozent) und wissenschaftlichen Expert*innen (14 Prozent). Nur neun Prozent aller medialen Zitate entfallen überhaupt auf Sprecher*innen bzw. Führungspersönlichkeiten auf Industrieebene. Allein der Londoner Bürgermeister Sadiq Khan tritt mit 1.542 im Rahmen der Studie gefundenen Berichterstattungen und Posts häufiger in Erscheinung als die CEOs von Tesla (800 Artikel und Posts), Volkswagen (137 Artikel und Posts), GM (94 Artikel und Posts), Mercedes-Benz (83 Artikel und Posts) und Ford (21 Artikel und Posts) zusammen.

Thought Leadership braucht eine schnelle und tiefe Informationskultur

Das Fazit der Studie: Klare Haltung und visionäre Konzepte sind die neue Währung und haben im öffentlichen Diskurs die immer komplexer werdende Technologie abgelöst. Wenn jedoch Konsument*innen von der Wirtschaft zunehmend eine klare Haltung zu den relevanten Themen der Zukunft fordern, werden eine solche Haltung nur jene Unternehmen ausbilden und artikulieren können, die zuhören und aus den Erkenntnissen zielgerichtet Handlungen ableiten. Nur dann können Unternehmen sowohl ihrer unternehmerischen als auch gesellschaftlichen Verantwortung gerecht werden und darüber hinaus mögliche Risiken erkennen und diesen entgegensteuern.

Wenn sich auf diesem Wege informierte Automobilunternehmen künftig in der Kommunikation nicht auf kurzfristige technische Lösungen beschränken, sondern den Mut zu mehr langfristigen Visionen haben, dann werden sie nicht nur an der öffentlichen Diskussion wahrnehmbar teilhaben, sondern diese auch in ihrem Sinne mitgestalten können. Eine in Zeiten der Veränderung wichtige Zielsetzung.

Diese Artikel könnten Sie auch interessieren:

Zwischen Hausaufgaben und Datenschutz: Der mutige B2C-Vorstoß von innoGPT

Die Inno KI GmbH aus Vechta öffnet ihre bisher auf Geschäftskunden ausgerichtete KI-Plattform nun für Familien. Mit einem neuen "Family Package" wollen die Gründer Mike Koene und Maurice Brumund das Problem des Datenschutzes bei der KI-Nutzung von Jugendlichen lösen. Ein cleverer Schachzug in eine unbesetzte Nische – oder ein schwieriges B2C-Geschäftsmodell mit hoher Preishürde?

Die Zahlen der jüngsten JIM-Studie (Jugend, Information, Medien) sprechen eine deutliche Sprache: 70 Prozent der Jugendlichen nutzen Künstliche Intelligenz zur Informationssuche, 74 Prozent lassen sich bei den Hausaufgaben helfen. Die Kehrseite dieser rasanten Adaption: Die Nutzung erfolgt zumeist über die kostenlosen Web-Versionen von US-Giganten wie OpenAI oder Google. Sensible Daten – von persönlichen Fragen bis zu hochgeladenen Schuldokumenten – fließen oft ungefiltert in die globalen Trainingsdatenbanken der Anbieter, sofern nicht manuell widersprochen wird.

Während die Politik über Social-Media-Verbote für Minderjährige debattiert, bleibt der regulatorische blinde Fleck bei KI-Tools im Kinderzimmer bislang bestehen. Genau in diese Lücke stößt nun das niedersächsische Start-up Inno KI GmbH mit seiner Plattform innoGPT.

Von der Agentur zum KI-Aggregator

Hinter innoGPT steht kein klassisches, VC-finanziertes Silicon-Valley-Konstrukt, sondern mittelständischer Pragmatismus aus Vechta. Co-Founder Maurice Brumund und sein Team begannen bereits 2022 im Umfeld einer eigenen Digitalmarketing-Agentur, intensiv mit KI-Tools zu experimentieren.

Aus dem internen Pain Point – der Frage, wie Mitarbeitende rechtssicher und datenschutzkonform mit großen Sprachmodellen (LLMs) arbeiten können – entstand Ende 2024 die Plattform innoGPT. Bisher lag der Fokus des Startups strikt auf dem B2B-Segment: Mit rein europäischem Hosting, DSGVO-Konformität und einer Zero-Retention-Policy (keine Nutzung der API-Daten für das Modell-Training) positionierte sich innoGPT als Lösung gegen die „Schatten-IT“ in Unternehmen. Laut Unternehmensangaben nutzen bereits über 2.500 Privat- und Geschäftskund*innen den Service. Nun folgt die Ausweitung des Geschäftsmodells auf den B2C-Markt.

Das Produkt: Ein "Safe Space" für die Familie

Mit dem neuen „Family Package“ erhalten bis zu fünf Familienmitglieder für 34,90 Euro im Monat individuelle Logins zu einer zentralen Plattform. Über diese können sie gebündelt auf verschiedene führende KI-Modelle von OpenAI, Anthropic, Google, Meta, Mistral und Black Forest Labs zugreifen. Ein zusätzlich buchbares Add-on filtert persönliche Daten (Named Entity Recognition) wie Namen oder E-Mail-Adressen und ersetzt diese vor der Übermittlung an die Rechenzentren automatisch durch Platzhalter.

Das Geschäftsmodell und der Markt

Aus Start-up-Sicht ist der Vorstoß von B2B-SaaS in ein Family-Abo-Modell gleichermaßen spannend wie riskant. Eine kritische Analyse offenbart dabei mehrere Marktherausforderungen:

- Der technologische Burggraben (Moat): Das Geschäftsmodell von innoGPT ist im Kern ein Aggregator- oder Wrapper-Modell. Das Start-up entwickelt keine eigenen Foundation-Modelle, sondern baut eine sichere, europäische Middleware-Schicht über die Schnittstellen (APIs) der Tech-Giganten. Der technologische Burggraben ist folglich eher niedrig. Der primäre Unternehmenswert liegt in der User Experience, der reibungslosen Modellanbindung und dem abstrakten Vertrauensfaktor „Datenschutz“.

- Zahlungsbereitschaft: 34,90 Euro im Monat (knapp 420 Euro im Jahr) sind für ein klassisches Familienbudget eine erhebliche Summe. Der Preis entspricht fast den Kosten von anderthalb ChatGPT-Plus-Lizenzen. Die zentrale Herausforderung für das Marketing wird sein: Sind Eltern bereit, für den Schutz der Daten ihrer Kinder diesen Premium-Aufschlag zu zahlen, während der Nachwuchs die Basis-Tools de facto kostenlos und mit einem Klick auf dem Smartphone nutzen kann?

- Token-Ökonomie in der Praxis: Das Modell sieht einen geteilten Token-Pool für die fünf Accounts vor. In der Praxis könnte dies zu Reibereien führen, wenn beispielsweise ein Familienmitglied rechenintensive Bildgenerierungen (etwa über Black Forest Labs) durchführt und das Kontingent für die Text-Prompts der restlichen Familie vorzeitig aufbraucht.

- Wettbewerbslandschaft: InnoGPT bewegt sich in einem Sandwich-Markt. Von oben drohen die direkten B2C-Angebote der Tech-Riesen (es ist absehbar, dass OpenAI oder Google eigene „Family Plans“ ausrollen). Von der Seite drücken EdTech-Start-ups in den Markt, die KI DSGVO-konform direkt in die Lernplattformen der Schulen integrieren – was eine private Familienlizenz obsolet machen könnte.

Ein mutiger Testballon

Für das Start-up-Ökosystem ist die Inno KI GmbH dennoch ein Paradebeispiel für „bootstrapped“ Innovationskraft. Anstatt ein Produkt am Reißbrett zu entwerfen, hat das Team ein valides Angebot aus einem eigenen betrieblichen Schmerz heraus entwickelt.

Der Vorstoß in den B2C-Markt wirkt wie ein smarter, PR-wirksamer Testballon. Das Start-up greift eine hochaktuelle, emotionale gesellschaftliche Debatte auf (Jugendschutz bei KI) und besetzt rhetorisch geschickt die Rolle des Problemlösers. Ob sich das Family-Modell finanziell trägt, hängt letztlich davon ab, ob innoGPT den trockenen Begriff der „DSGVO-Konformität“ für Eltern emotional so aufladen kann, dass er als unverzichtbare Sicherheitsmaßnahme wahrgenommen wird. Gelingt dies nicht, ist das Risiko überschaubar: Das Start-up kann sich nahtlos wieder auf sein wachsendes B2B-Kerngeschäft konzentrieren.

StartingUp-DeepTech-Watchlist 2026

Von „German Engineering“ zu „German DeepTech“: Diese jungen Start-ups und Scale-ups zünden 2026 die nächste Stufe – und sollten zwingend auf dem Radar von Investor*innen und Entscheider*innen stehen.

„Prognosen sind schwierig, vor allem, wenn sie die Zukunft betreffen.“ Dieser Ausspruch unterstreicht die Herausforderung, die Dynamik unseres Start-up-Ökosystems vorherzusagen. Doch wer 2025 aufmerksam verfolgt hat, der spürt: Es hat sich etwas gedreht. Der Investor*innenfokus hat sich verschoben – weg von reinen E-Commerce-Modellen, hin zu substanzieller Technologie, die echte physikalische Probleme löst.

Die folgende Auswahl an Start-ups und Scale-ups, mit denen 2026 gerechnet werden sollte, ist mehr als eine Watchlist. Sie basiert auf einer Analyse der signifikanten Finanzierungsrunden 2025, der technologischen Reife und der Resonanz bei bedeutenden Preisen. Diese Unternehmen stehen beispielhaft für eine Gründer*innengeneration, die Wissenschaft und Skalierung vereint. Natürlich bleibt ein Restrisiko. Unwägbarkeiten – von geopolitischen Instabilitäten über regulatorische Verschärfungen wie dem EU AI Act bis hin zu volatilen Zinsmärkten – können die nahe Zukunft beeinflussen. Doch die Resilienz dieser Unternehmen stimmt optimistisch.

DefenseTech: Die neue Realität der Sicherheit

Lange war Verteidigungstechnologie in Deutschland ein Tabuthema für Risikokapitalgeber. Das hat sich grundlegend geändert. Ganz oben auf der Watchlist steht neben dem Münchner Start-up Helsing nun das 2024 gegründete Black Forest Labs. Das Geschäftsmodell ist faszinierend, weil es die Grenzen zwischen kreativer Zerstörung und Sicherheitstechnologie verwischt. Es basiert auf der Entwicklung proprietärer State-of-the-Art-Modelle für generative Videoerzeugung. Nach einer spektakulären 300-Mio.-USD-Runde im Dezember 2025 katapultierte sich die Bewertung auf satte 3,25 Milliarden USD. Das Start-up ist damit Deutschlands wertvollste KI-Firma und beweist, dass Europa bei Generative AI den Anschluss nicht verloren hat. Der globale Siegeszug deutet sich 2026 unter anderem in einem mehrjährigen Vertrag mit Meta sowie in Kooperationen mit US-Plattformen wie X und Hollywood-Studios an, die Produktionskosten senken wollen. Mitgründer Robin Rombach prognostizierte im Sifted-Podcast: „2026 wird generative Video-KI zum industriellen Standard in der Medienproduktion.“ Doch auch bei der Simulation für Sicherheitsszenarien spielt die Technologie eine wachsende Rolle.

Ein weiterer Schlüsselakteur ist Stark Defence. Das 2024 gegründete Münchner Start-up adressiert eine Lücke der modernen Kriegsführung: asymmetrische Bedrohungen. Stark Defence fokussiert sich auf softwaredefinierte, autonome Drohnensysteme, die „on the edge“ entscheiden und nicht auf ständige Funkverbindung angewiesen sind. Dass das Start-up durch seine KI-Schwarmtechnologie massiv an Bedeutung gewinnen wird, hat sich Ende Februar 2026 eindrucksvoll bestätigt: Der Haushaltsausschuss des Bundestages gab einen Auftrag über 540 Millionen Euro für Kampfdrohnen frei, den sich Stark Defence (Modell „Virtus“) und das nach einer Mega-Runde im Sommer 2025 mittlerweile mit 12 Milliarden Euro bewertete Münchner Unicorn Helsing (Modell „HX-2“) teilen. Um diese rasante Skalierung zu stemmen, hat Stark Defence kürzlich das Berliner Software-Start-up Pleno übernommen und eine neue Serienfertigung im britischen Swindon eröffnet. Mitgründer Florian Seibel dazu: „Unser Ziel für 2026 ist die erste vollautonome Verteidigungslinie für Europa.“

Better Sol: Zweites Leben für die Solarwende

Wie das 2023 von Mirko Laube und Luisa Schulze gegründete Start-up Better Sol den PV-Gebrauchtmarkt aufmischen will.

Das Braunschweiger Start-up Better Sol erhält rund 125.000 Euro Förderung aus dem „Green Startup“-Programm der Deutschen Bundesstiftung Umwelt (DBU), um gebrauchte Solarpaneele in großem Stil zurück in den Markt zu bringen.

Hinter dem Start-up stehen Luisa Schulze und Mirko Laube. Better Sol entstand ursprünglich im Sommer 2022 als Ausgründung des Magdeburger Recycling-Unternehmens Solar Materials und agiert seit 2023 als eigenständige GmbH am Standort Braunschweig. Während sich die ehemalige Muttergesellschaft auf das komplexe werkstoffliche Recycling von Modulen konzentriert, widmet sich Better Sol voll und ganz dem „Second Life“ – also der direkten Wiederverwendung der noch intakten Platten.

KI-gestützte Prüfung statt Schredder

Die Beschaffungsseite von Better Sol zielt primär auf große Solarparks ab. Die Betreiber tauschen dort häufig größere Mengen an Solarmodulen recht früh in ihrem Lebenszyklus durch neuere, leistungsstärkere Modelle aus. Um diese Module vor dem Müll zu bewahren, hat das Better-Sol-Team mittels DBU-Förderung ein in Teilen automatisiertes Testsystem mit eigener Software auf Basis künstlicher Intelligenz (KI) entwickelt.

Der Prüfprozess beginnt mit einer mehrstufigen optischen Untersuchung, bei der sowohl grobe Beschädigungen als auch jede Solarzelle einzeln begutachtet werden. Im Anschluss folgen eine eingehende Prüfung der elektrischen Sicherheit sowie eine Leistungsüberprüfung, die misst, wie viel Watt das Produkt im Vergleich zur ursprünglichen Leistung noch liefert. Die Software führt all diese Daten automatisiert zu einer detaillierten Leistungsprognose zusammen. Jedes funktionstüchtige Modul erhält ein Label mit den Testdaten, einer zugewiesenen Leistungsklasse und einem umfangreichen Prüfprotokoll. Nur der endgültige Rest wird zum Recycling aussortiert. Der Vertrieb erfolgt direkt über die Internetseite von Better Sol. Zielgruppe sind oft Privathaushalte oder die Dächer größerer Fabrikhallen.

Der Markt und die Technologie im Wettbewerbsvergleich

Nach Angaben des Statistischen Bundesamtes verbucht die Photovoltaik mittlerweile einen Anteil von etwa 24 Prozent und ist damit der zweitwichtigste Energieträger der inländischen Stromerzeugung. Das Reservoir an ausgemusterten, aber noch funktionierenden Modulen wächst rasant. Laut Schulze ist im Schnitt jedes zweite gebrauchte Solarmodul noch für eine erneute Nutzung geeignet. Doch der Gebrauchtmarkt professionalisiert sich zusehends.

Better Sol setzt aktuell auf eine pragmatische, KI-gestützte Teilautomatisierung und plant als nächsten logischen Entwicklungsschritt eine mobile Testanlage, um die Solarmodule direkt dort zu testen, wo sie ausgemustert werden. Genau in diesem logistisch entscheidenden Bereich der Vor-Ort-Prüfung operiert bereits der etablierte Wettbewerber 2ndlifesolar, eine Marke der großen Buhck Gruppe. 2ndlifesolar greift auf ein deutschlandweites Logistiknetzwerk zurück und kombiniert stationäre Erstbehandlungsanlagen mit mobilen Prüflaboren. Technologisch geht das Unternehmen tief in die industrielle Qualitätssicherung und führt standardmäßig Elektrolumineszenz-Prüfungen durch, um unsichtbare Mikrorisse im Vorfeld zu detektieren.

Einen völlig anderen, stark hochskalierten Weg bestreitet das österreichische CleanTech-Start-up 2nd Cycle. Das Unternehmen betreibt eine vollautomatische Inspektions- und Upcycling-Anlage im industriellen Hochdurchsatz und nutzt neben klassischer Robotik auch patentierte hyperspektrale Analysen aus der Raumfahrt, um Zellalterungen frühzeitig zu erkennen.

Der Schlüssel zum wirtschaftlichen Erfolg

Das Vorhaben von Better Sol leistet einen fundamentalen Beitrag, um noch leistungsfähige Materialien durch geschickte Kreislaufwirtschaft für eine Weiternutzung zu erhalten, damit die Bemühungen für mehr erneuerbare Energien nicht ins Stocken geraten. Dennoch muss sich das Geschäftsmodell in einem harten Wettbewerb beweisen.

Die Handwerkerkosten für den Aufbau einer PV-Anlage auf einem Eigenheim sind hoch und fallen völlig unabhängig davon an, ob man neue oder gebrauchte Paneele installiert. Gleichzeitig steht der Markt unter enormem Preisdruck durch historisch günstige asiatische Neuware. Wenn fabrikneue Module extrem billiger werden, schwindet das Argument der finanziellen Ersparnis bei Gebrauchtmodulen mit kürzerer Restlebensdauer. Der Schlüssel zum wirtschaftlichen Erfolg von Better Sol liegt daher in der rigorosen Minimierung der eigenen Logistik- und Prozesskosten. Die geplante mobile Testanlage und die zusätzliche Automatisierung des Testsystems sind für das Start-up essenziell, um künftig auch größere Ausmusterungen von Solarparks wirtschaftlich bewältigen zu können.

Die Müsli-Macher und die Kälte: Das neue Millionen-Projekt von Kraiss & Mahler

Dass sie Märkte revolutionieren können, haben die Freda-Gründer bereits bewiesen – nun steht die Tiefkühlkette auf dem Prüfstand. Mit einem mutigen Modul-Konzept fordern Philipp Kraiss und Christian Mahler die Industrie-Riesen im Supermarktregal heraus.

In der Start-up-Welt ist der Begriff Seriengründer*in oft ein zweischneidiges Schwert: Das Vertrauen der Investor*innen ist hoch, doch die Fallhöhe nach einem Erfolg wie mymuesli ebenso. Philipp Kraiss und Christian Mahler haben sich mit ihrem 2023 gegründeten Food-Start-up Freda bewusst gegen ein „Me-too-Produkt“ und für eine operative Wette auf die Zukunft der Tiefkühlkette entschieden. Mit einem mutigen Modul-Konzept fordern sie die etablierten Industrie-Riesen im Supermarktregal heraus. Die Prämisse: Der Markt für Tiefkühlkost (TK) wächst – auf über 22,6 Milliarden Euro im Jahr 2024 –, ist aber durch extremen Preisdruck und eine veraltete Produktlogik geprägt. Wir haben uns das Geschäftsmodell näher angesehen und die Gründer dazu befragt.

Pizza, Pasta, Gelato … und jetzt Blocks?

Die Pizza „Salami Sensation“ war für Freda der Türöffner. Mit dem Sieg bei Stiftung Warentest (2024) bewies das Team, dass es Qualität „kann“ und schuf einen starken USP. Strategisch ist Pizza jedoch kein leichtes Feld: Der Wettbewerb ist anspruchsvoll, die Regalplätze im Einzelhandel sind besetzt und die Differenzierung erfolgt meist über den Preis. Mit einer Innovation wie „Frozen Blocks“ erweitert Freda nun das Spielfeld und eröffnet eine neue Kategorie von Tiefkühlkost.

Es handelt sich dabei nicht mehr um ein fertiges Gericht, sondern um eine Systemkomponente. Das Konzept orientiert sich am gastronomischen „Mise en Place“: Vorbereitete, schockgefrostete Komponenten wie Beef Ragù oder Chili sin Carne fungieren als Basismodule für die heimische Küche. Strategisch gesehen erhöht dies die Wertdichte pro Kubikzentimeter im TK-Fach und verringert die Komplexität in der eigenen Produktion im Vergleich zu mehrkomponentigen Fertigmenüs.

Auf die Frage, ob der strategische Wechsel von der Pizza zu den „Frozen Blocks“ eine Flucht aus dem Commodity-Preiskampf der Pizza-Truhe hin zu einer proprietären Nische sei, widerspricht Philipp Kraiss. Vielmehr handele es sich um einen konsequenten Ausbau des Sortiments, denn Freda solle künftig den gesamten Alltag der Kund*innen abbilden – vom Frühstück bis zum Abendbrot. Das sei eben mehr als nur Pizza. „Unser Anspruch ist aber nicht nur Bekanntes besser zu machen – wie bei unserer Pizza, sondern auch neue Wege zu gehen“, stellt der Gründer klar. Die flexiblen Module seien auf diesem Weg der nächste logische Schritt. Er verspricht dabei maximale Vielfalt aus dem Gefrierfach, „denn jeder Block lässt sich vielfältig kombinieren.“

Die Retail-Herausforderung: Kaufland als Stresstest

Mit einer Basis von über 30.000 D2C-Kund*innen hat das Unternehmen bereits bewiesen, dass die Nachfrage nach seinen Produkten besteht. Um dieses Potenzial voll auszuschöpfen und die Margen zu stärken, wurde im August 2025 der Launch in 780 Kaufland-Märkten umgesetzt – ein strategischer Meilenstein, der die Reichweite massiv erhöht und über das Volumen des stationären Einzelhandels den Weg zu nachhaltigem, profitablem Wachstum ebnet – ohne aufwendigen Versand mit Isolierung und Trockeneis.

Hier zählt nun die Shelf Velocity (Abverkaufsgeschwindigkeit). Ein modulares System erfordert von der Kundschaft jedoch ein Umdenken: Man kauft kein fertiges Abendessen, sondern eine Zutat. Freda muss hier beweisen, dass der Mehrwert der Zeitersparnis am Point of Sale verstanden wird, bevor die harten Auslistungsmechanismen des Handels greifen.

Doch wie überzeugt man eine*n Einkäufer*in davon, dass ein modulares System mehr Flächenproduktivität bringt als die zehnte Sorte Standard-Lasagne? Christian Mahler kontert auf diese Retail-Frage mit einem anschaulichen Branchen-Vergleich: „Wir sind eben nicht die zehnte Lasagne. Eine klassische TK-Lasagne belegt viel Regalfläche, bedient genau einen Anlass und konkurriert mit neun anderen Lasagnen um denselben Kunden.“ Durch das kompakte Format und eine maximale SKU-Dichte der Blocks könne der Händler auf derselben Regalfläche mehrere Sorten listen und spreche damit dutzende Zubereitungsarten von der Bowl bis zum Curry an. Mahler zeigt sich selbstbewusst: „Wir eröffnen eine neue Kategorie statt in einer bestehenden zu kämpfen.“

Operative Exzellenz vs. bayerisches Handwerk

Ein weiterer Spagat wartet in der Produktion: Freda wirbt offensiv mit „Made in Bavaria“ und handwerklicher Herstellung. In der Start-up-Praxis beißt sich Handwerk jedoch oft mit Skalierung. Wer bundesweit fast 900 Supermärkte bedient, muss industrielle Prozesse beherrschen. Die Gefahr dabei ist offensichtlich: Wenn die Qualität durch die Masse sinkt, verliert Freda seinen wichtigsten USP. Gleichzeitig bleibt bei der exklusiven Zielgruppe, die bereit ist, für TK-Komponenten Premium-Preise zu zahlen, in Zeiten der Inflation die Frage der Preissensibilität bestehen.

Auf drohende Kapazitätsgrenzen angesprochen, räumt Philipp Kraiss ein, dass die Passauer Manufaktur zwar das Herzstück bleibe. „Aber wir waren von Anfang an ehrlich zu uns selbst: Eine Manufaktur skaliert nicht linear“, gibt der Seriengründer zu bedenken. Mit wachsendem Geschäft müsse man die Produktion auf breitere Schultern stellen und mit Partnern zusammenarbeiten. Sein Kernversprechen an die Kund*innen lautet dabei jedoch: „Wir lagern nicht die Rezeptur aus, sondern die Kapazität.“

Marktpsychologie: Convenience ohne Reue

Psychologisch besetzt Freda damit eine überaus geschickte Lücke. Die „Frozen Blocks“ nehmen der Käuferschaft zwar die Entscheidung für die aufwendige Kernkomponente ab, lassen das Gefühl des Selbstkochens durch das frische Ergänzen von Beilagen jedoch vollkommen intakt. Dies eliminiert die oft vorhandene „Convenience-Scham“ gesundheitsbewusster Zielgruppen und könnte die Lösung für die stagnierenden Marktanteile klassischer Fertiggerichte bei jüngeren Konsument*innen sein.

Fazit für die Start-up-Praxis

Freda ist ein Lehrstück für den Übergang von einer digitalen D2C-Brand zum Player im Massenmarkt. Die Gründer nutzen ihre Erfahrung, um eine etablierte Kategorie neu zu denken. Ob die Rechnung aufgeht, wird sich an der Regal-Rotation zeigen. Wenn die Kund*innen den Aufpreis für die „bayerische Handarbeit“ und das modulare System dauerhaft akzeptieren, könnte Freda die Blaupause für die nächste Generation von Food-Marken liefern.

Primogene: Muttermilch als Vorbild

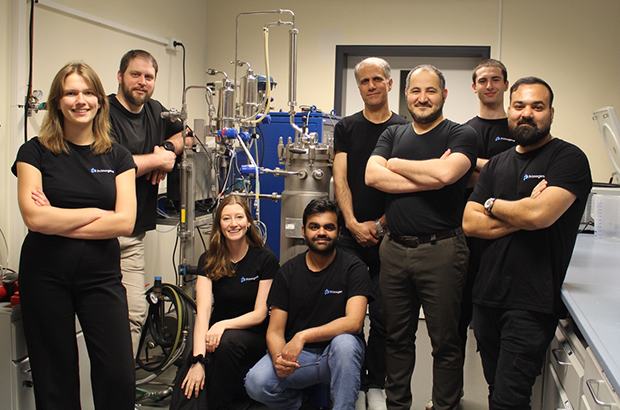

Primogene ist ein 2023 gegründetes BioTech-Start-up mit Sitz in Leipzig, das sich auf die Entwicklung biotechnologischer Herstellungsverfahren für bioidentische Inhaltsstoffe spezialisiert hat. Ein Schwerpunkt liegt auf Verbindungen, die der Muttermilch nachempfunden sind und die Gesundheit in allen Lebensphasen fördern können.

Auch wenn das Produkt als weißes Pulver eher unscheinbar aussieht, markiert seine Existenz einen wissenschaftlichen Meilenstein. „Wir haben eine spezielle Technologie entwickelt, dank der wir komplexe bioidentische humane Milchzucker skalierbar herstellen können“, erzählt Linda Karger, einst Managementstudentin an der Technischen Universität in München, heute COO der 2023 in Leipzig gegründeten Primogene GmbH. Die chemischen Verbindungen entsprechen also den im menschlichen Körper vorkommenden Molekülen bis ins kleinste biochemische Detail. Und sie übernehmen – obwohl industriell hergestellt – die gleichen Funktionen, die bisher nur Muttermilch garantierte.

Zum Verständnis: Die komplexen Zuckerstrukturen sind nach Fett und Laktose der drittgrößte feste Bestandteil menschlicher Milch. Sie bieten einzigartige gesundheitliche Vorteile, unterstützen beispielsweise das Immunsystem sowie die kognitive Entwicklung wie kein anderer Stoff. „Nach zahllosen Gesprächen mit Ärzten und Kliniken begann unsere Geschichte mit der Idee, nährstoffreiche Inhaltsstoffe als Zusatz für die Ernährung von Frühgeborenen herzustellen. Weitergedacht können bioaktive Bestandteile der Muttermilch ebenso zur Krankheitsprävention bei Erwachsenen sinnvoll eingesetzt werden“, erklärt Karger. „Um das Wirkungspotenzial unserer Human Milk Oligosaccharides (HMO) weiter zu erforschen, testen wir diese aktuell in enger Zusammenarbeit mit dem Leipziger Fraunhofer-Institut für Zelltherapie und Immunologie.“

Produktsortiment in der Breite offen

Gleichzeitig wird die von Dr.-Ing. Reza Mahour (CEO, Experte für Bioverfahrenstechnologie) und Valerian Grote (CTO, Molekularbiologe/Experte für Analytische Biochemie) entwickelte enzymatische Technologie genutzt, um bioidentische Moleküle für andere Märkte zu erzeugen, beispielsweise Inhaltsstoffe für Produkte der Körperpflege oder Rohmaterialien für die Pharmaindustrie. „Wir produzieren selbst. Dabei lässt sich jedes unserer Produkte auf die spezielle Technologie zurückführen. Unseren Kunden bieten wir Komplettlösungen – das reicht von der Suche nach der richtigen Produktionsplattform bis hin zu Entwicklung und Produktion“, bestätigt Karger. Erste Umsätze wurden nach ihren Angaben bereits früh erzielt. Inhaltsstoffe für den Kosmetikbereich sollen noch in diesem Jahr mithilfe bestehender Partnerschaften am Markt eingeführt werden. Im Pharmabereich wird ebenfalls mit ersten Kunden zusammengearbeitet.

Karger ergänzt: „Wir haben früh auf Partnerschaften und Vorbestellungen gesetzt, um den Markt besser zu verstehen.“ Um die bereits verabredeten hochwertigen Roh- und Inhaltsstoffe bald in größeren Mengen liefern zu können, ist das aktuell elfköpfige Team von Primogene gerade innerhalb Leipzigs umgezogen. Für die anstehende Skalierung war der Wechsel auf eine Betriebsstätte mit mehr Laborfläche und größerem Produktionsbereich wichtig. Große Mitspieler auf dem Feld der HMOs wie die niederländische DSM-Firmenich oder der dänische Konzern Chr. Hansen schrecken Karger nicht: „Bekannt sind mehr als 200 verschiedene HMOs, davon sind bisher sieben strukturell einfacher industriell herstellbar und auf dem Markt. Sie werden mit einer Fermentationstechnologie produziert. Unser enzymatisches Verfahren kann deutlich mehr und komplexere Zuckerstrukturen hervorbringen. Außerdem reicht unsere Produktpalette weit über HMOs hinaus.“

Sichtbarkeit durch Innovationsplattform futureSax erleichtert Investorensuche

Das bisher benötigte Kapital stammt unter anderem von Business Angels aus dem Bereich der Biotechnologie, darunter auch Climate Founders, bei deren Accelerator-Programm Mahour Grote und Karger einst zusammenfanden. Für Primogene als forschungs- und deshalb kapitalintensives Biotech-Unternehmen sind daneben die Mittel aus Förderprogrammen des Landes Sachsen und der Stadt Leipzig von wesentlicher Bedeutung. Darüber hinaus profitiert das Start-up noch heute von der Sichtbarkeit, die es durch den Gewinn des dritten Platzes beim Sächsischen Gründerpreis 2024 erhielt. Zunächst sorgten der professionelle Nominiertenfilm und die begleitende Öffentlichkeitsarbeit von futureSax für Aufmerksamkeit sowohl in den Medien als auch innerhalb des Netzwerks.

Dann bot die Preisübergabe auf der Sächsischen Innovationskonferenz vor über 1.000 Gästen Primogene eine wichtige Gelegenheit zur Präsentation. „Sachsen ist ein Innovationsstandort mit besonderer Dichte: Exzellente Forschung, starke Industrie- und Mittelstandsstrukturen und eine wachsende Start-up-Szene greifen ineinander. Hier entstehen Lösungen, die international wettbewerbsfähig sind. Entscheidend ist der Schulterschluss im Ökosystem – von Hochschulen über Unternehmen bis zu Kapitalgebern. futureSax schafft dafür die Bühne und die Verbindungen, damit aus Ideen schneller Produkte, Partnerschaften und Gründungen werden“, erklärt Susanne Stump, Geschäftsführerin der Innovationsplattform des Freistaats Sachsen. Das Interesse großer Investoren bestätigt, dass Primogene auf dem richtigen Weg ist. Im Jahr 2025 schloss das innovative Start-up eine Seed-Finanzierungsrunde mit namhaften Investoren wie HTGF, TGFS, der Sächsischen Beteiligungsgesellschaft und better ventures ab. Das geplante Personalwachstum sowie die Produktionsaktivitäten der nächsten zwei Jahre sind damit gesichert.

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen: https://t1p.de/p8gop

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

Vom Check-in zur Patient*innenakte: Wie Travel-Pionier Salim Sahi mit HoloLogix.AI die Health-IT aufmischt

Vom Reisebuchungssystem zur Sicherheits-Uhr für Senior*innen: Serial Entrepreneur Salim Sahi greift mit HoloLogix.AI greift gleich zwei Milliardenmärkte an: Gesundheitswesen und Hotellerie. Doch wie viel Substanz steckt hinter der Vision?

Gründungslegenden klingen oft zu glatt für die Realität – wie Sahis Skateboard-Unfall, der in einer Notaufnahme zur Idee für sein neuestes Venture führte. Wer den Mann kennt, der in den 90ern mit „Traffics“ die Reisebranche digitalisierte, weiß jedoch: Er macht keine halben Sachen. Jetzt, im Februar 2026, steht er mit einer europäischen Aktiengesellschaft (SE) und einem enorm breiten Versprechen wieder auf dem Platz.

Wie Touristik-Know-how in die Klinik kommt

Der Sprung von der Touristik zur Service-Automatisierung im Gesundheitswesen wirkt wie ein harter Bruch. Doch unter der Haube geht es in beiden Welten um hochvolumige Transaktionen, Termin-Slots und Datenabgleich in Echtzeit. Wer Millionen Pauschalreisen fehlerfrei abwickelt, so die Wette von HoloLogix.AI, beherrscht auch das Termin-Management von Kliniken, Hotels und Restaurants.

Für CEO und Gründer Salim Sahi ist das Projekt dennoch ein „kompletter unternehmerischer Neuanfang“. Gegenüber StartingUp räumt er ein, von 25 Jahren Travel-Tech-Erfahrung zu profitieren, doch seine wahre Passion gelte der künstlichen Intelligenz. Das Herzstück bilde dabei die MIA Service KI: „Wir haben eine holistische KI-Plattform geschaffen, also ein Tool, das ganzheitlich agiert und eingesetzt werden kann.“ MIA verstehe Gespräche, erledige parallel Aufgaben und verbinde Systeme – „rund um die Uhr und branchenübergreifend“. Auch wenn der Fokus aktuell auf Gesundheitswesen und Hospitality liege, sei das System laut Sahi letztlich „nahezu überall einsetzbar, wo Kunden- oder Patientenkontakt herrscht.“

Der Angriff auf die Platzhirsche

Der Markt für Conversational AI ist 2026 kein blauer Ozean mehr. Etablierte Player wie Aaron.ai haben sich tief in die Health-Landschaft eingegraben, flankiert von Plattform-Giganten wie Doctolib. HoloLogix.AI reagiert mit aggressiven Preisen ab 99 Euro im Monat und einer massiven technologischen Breite.

Aber warum sollten Klinikverantwortliche das Risiko eines Wechsels eingehen? Salim Sahi sieht den „Killer-USP“ in der Architektur der Interaktion: „Unser Ansatz ist ein anderer: Statt starrer Skripte bieten wir echte Gesprächsintelligenz durch Conversational AI an.“ Das System sei eine KI, die im laufenden Gespräch aktiv Aufgaben erledige, was eine beispiellose Integrationstiefe erfordere. „Hier gehen wir ganz tief rein und verarbeiten Daten in Echtzeit“, so der CEO. Da Aufgaben direkt ausgeführt werden, optimiere sich das Zeitmanagement drastisch – konzipiert als Omnichannel-Ansatz über Telefon, Website, E-Mail, Wearables oder bald sogar über Robotik.

Die schmale Gratwanderung am Handgelenk

HoloLogix.AI belässt es nicht bei Software, sondern bringt mit der MIA Watch eigene Hardware ins Spiel. Die Smartwatch für Senior*innen soll Stürze erkennen und sofort einen aktiven Sprachdialog führen. Eine Gratwanderung: Reines Assistenz-System oder medizinisches Gerät mit komplexer Zertifizierungspflicht (MDR)?

Prof. Dr. Thomas Fuchs, Co-Founder und Aufsichtsrat für den Bereich Health Care, ordnet das rechtlich eindeutig ein: „MIA Protect ist ein Teil der holistischen KI-Plattform, die mit verschiedenen Health Watches wie z.B. auch der Apple Watch kompatibel ist. Sie ist ein Assistenz- und Companion-System.“ Die Hardware erkenne Stürze, ersetze aber „keine ärztliche Untersuchung oder medizinische Entscheidung“. Um Geschwindigkeit und Nutzer*innenfreundlichkeit zu wahren, bewege man sich „bewusst außerhalb der Medizinprodukt-Zertifizierung (MDR), ohne den Sicherheitsrahmen zu verlassen“.

Ein mehrstufiges Sicherheitsnetz aus Sensorik, KI-Algorithmen und menschlichem Service-Team federt Fehlinterpretationen ab. Haftungsfragen sind laut Fuchs über klare Nutzungsbedingungen geregelt. Für den Mediziner steht ohnehin der „Companion Aspekt“ im Vordergrund: Nach einem Sturz, wenn Patient*innen hilflos am Boden liegen, alarmiere MIA in einer Kaskade Notfallkontakte und beruhige das Unfallopfer, bis Hilfe eintrifft. „MIA Protect soll an diesem Punkt Sicherheit und damit Lebensqualität geben, vielleicht sogar die Möglichkeit schaffen für Senioren, länger selbstbestimmt in ihrem Zuhause zu leben“, resümiert Fuchs.

Pflegeheim und Luxushotel: (K)ein operativer Widerspruch?

Das vielleicht Spannendste an HoloLogix.AI ist das Personal: Salim Sahi hat sich politische und ethische Schwergewichte in den Aufsichtsrat geholt. Darunter Dr. Marcel Klinge, ehemaliger FDP-Bundestagsabgeordneter und Tourismus-Experte. Er muss Investor*innen den Spagat erklären, warum ein Start-up gleichzeitig Pflegeheime und Luxushotels digitalisieren will – was oft als Warnsignal für operative Verzettelung gilt.

Dr. Marcel Klinge sieht darin jedoch keinen Widerspruch, sondern die Stärke der technischen Basis: „Der gemeinsame Nenner liegt im Kern: Unsere holistische KI-Infrastruktur kann über das Telefon Gespräche führen, kann aber auch über die Website, Health Watches und Devices und direkt im Gespräch Aufgaben ausführen.“ Das Backend orchestriere lediglich Termin-Slots, Daten und Anfragen in Hochgeschwindigkeit. Dabei spiele es schlichtweg keine Rolle, „ob der Kunde Patient in einem Pflegeheim oder Gast in einem Luxushotel ist.“

Wenn die KI-Vision auf den deutschen Fax-Alltag trifft

Ein Blick auf die Website verrät große Visionen, doch diese müssen sich im harten Alltag deutscher IT-Infrastrukturen und oft veralteter Praxis-Server beweisen. Zudem ist die Frage des Datenschutzes elementar: Nutzt das Unternehmen US-amerikanische Sprachmodelle via API, oder hostet man eigene „Sovereign AI“ in Europa?

Für Prof. Dr. Thomas Fuchs sind Datenschutz und Systemintegration absolute Kernpunkte. Um digitale Souveränität zu wahren, setzt das Unternehmen auf einen hybriden Weg: „Wir orchestrieren auf die gängigen sowie auf eigene Modelle auf deutschen Servern, die in Europa bereits genutzt werden.“ Laut Fuchs verlässt man sich dabei nicht nur auf das Versprechen von Sicherheit, sondern arbeitet seit der ersten Stunde eng mit dem renommierten Fraunhofer-Institut zusammen und lässt die eigene Infrastruktur „regelmäßig durch deren Experten prüfen“. Das bloße Versprechen von Sicherheit reicht HoloLogix.AI dabei nicht.

Mehr als nur ein GPT-Wrapper?

HoloLogix.AI ist eine der vielleicht ambitioniertesten Gründungen des Jahres. Technologisch muss es beweisen, dass es mehr ist als ein „GPT-Wrapper“ mit Smartwatch. Aber die Kombination aus Sahis Exekutiv-Erfahrung, Klinges Netzwerk und Fuchs‘ ethischem Korrektiv macht es zu einem spannenden Herausforderer. Wenn die Uhr im Alltag für Sicherheit sorgt – und die KI den deutschen Datenschutz überlebt – könnte aus Berlin der nächste europäische Champion kommen.

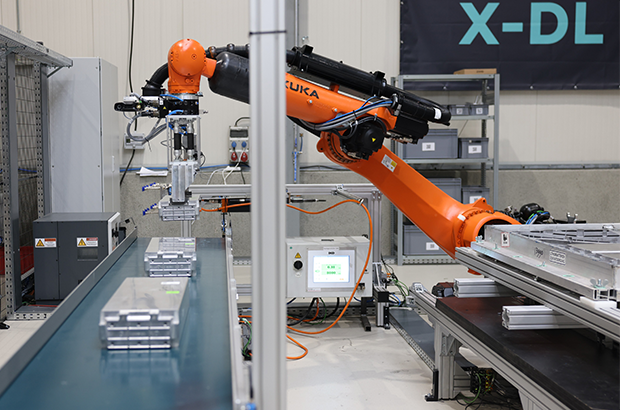

ChatGPT schreibt Texte. R3 Robotics zerlegt Batterien

Es gibt Probleme, die man mit Software lösen kann, und es gibt Probleme, für die man sich die Hände schmutzig machen muss – oder besser: Roboterhände nutzt. Antoine Welter und Dr. Xavier Kohll haben mit Circu Li-ion begonnen, um Batterien zu retten. Jetzt, unter dem neuen Namen R3 Robotics und mit 20 Millionen Euro frischem Kapital im Rücken, treten sie an, um den wohl größten Flaschenhals der kommenden Mobilitätswende zu beseitigen. Ihr Ansatz: Keine teuren Spezialmaschinen, sondern intelligente Standard-Roboter, die sehen, verstehen und sicher zupacken.

Wenn in den Vorstandsetagen der Automobilhersteller über die Zukunft gesprochen wird, geht es meist um Reichweiten und Software-Defined Vehicles. Doch am anderen Ende der Wertschöpfungskette braut sich ein Sturm zusammen. Millionen von Elektrofahrzeugen werden in den kommenden Jahren ihr Lebensende erreichen. Die derzeitige Realität in vielen Recyclinghöfen wirkt dagegen fast archaisch: Menschen, die mit Handwerkzeugen komplexe Systeme auseinanderschrauben. Das ist nicht nur teuer und schwer skalierbar, sondern bei Hochvolt-Systemen auch lebensgefährlich.

Genau hier setzen Antoine Welter und Xavier Kohll an. Die Nachricht, die das deutsch-luxemburgische Unternehmen Anfang Februar 2026 verkündete, ist mehr als nur eine Finanzierungsrunde. Die 20 Millionen Euro – aufgeteilt in 14 Millionen Euro Series-A-Kapital und 6 Millionen Euro öffentliche Fördergelder – heben die Gesamtfinanzierung des Unternehmens auf ein neues Level. Angeführt wird die Runde von HG Ventures und Suma Capital, unterstützt von Co-Investoren wie der Oetker Collection und dem EIC Fund.

Doch das Geld ist nur der Treibstoff für eine strategische Evolution. Aus Circu Li-ion wird R3 Robotics. Der neue Name ist Programm: Repair, Reuse, Recycle. Antoine Welter erklärt die Motivation hinter der Umbenennung pragmatisch: „Circu Li-ion hat beschrieben, wo wir angefangen haben. R3 Robotics beschreibt, was wir aufbauen: industrielle Robotik, die Demontage skalierbar, sicher und kosteneffizient macht.“

Wenn der Roboter Augen bekommt

Die größte Hürde im Recycling ist nicht die Chemie, sondern die Variabilität. Kein Batteriepack gleicht dem anderen, E-Motoren sind unterschiedlich verbaut, Schrauben sind korrodiert. Starre Fertigungsstraßen scheitern hier. R3 Robotics löst dies mit einer Plattform, die Computer Vision, künstliche Intelligenz und Robotik verschmilzt.

Das System fungiert dabei fast wie ein „ChatGPT für die physische Welt“: Anstatt Text zu generieren, plant die KI physische Handlungen. Sensoren scannen das Bauteil, die KI erkennt den Zustand und promptet den Roboterarm dynamisch durch den Demontageprozess. Der entscheidende Vorteil: Der Mensch wird aus der Gefahrenzone der Hochspannung genommen, während der Roboter Aufgaben erledigt, die für klassische Automatisierung zu komplex wären.

Angesprochen auf den Vergleich mit Generative AI und die Frage, wie die Roboter tatsächlich „sehen“ und „entscheiden“, bestätigt Welter die Parallele: „Der Vergleich mit Generative AI passt gut: Das Modell bekommt einen Input – keinen Text, sondern einen Scan des Bauteils – und generiert daraus eine Handlungssequenz.“ Es gehe darum zu erkennen, um welches Modell es sich handelt, wie der Zustand ist und wo die Verbindungspunkte liegen. „Das klingt simpel, ist es aber nicht – kein Pack ist identisch“, so Welter. Die eigentliche Herausforderung liege jedoch in der Entscheidung davor: „Welche Reihenfolge ist sicher? Ein falscher Griff an ein Hochvoltsystem kann tödlich sein. Unser System sieht, bewertet und entscheidet.“

Smart Hardware: Warum das Rad neu erfinden?

Ein Detail, das Investor*innen besonders aufhorchen lässt, ist die Kapitaleffizienz der Gründer. Wer an Industrie-Robotik denkt, denkt an teure Hardware-Entwicklung. R3 Robotics geht einen pragmatischen Weg: Ein Großteil der verwendeten Hardware wird „von der Stange“ gekauft.

Die Roboterarme sind Standardprodukte. Die Innovation – und damit das geistige Eigentum – steckt in den spezialisierten „End-Effektoren“ (den Roboterhänden), den Sensorsystemen und vor allem dem Software-Stack, der alles steuert. Das erlaubt eine Skalierung, die mit proprietärer Hardware kaum möglich wäre. Mitgründer Dr. Xavier Kohll betont, dass dies eine bewusste Entscheidung gegen „Over-Engineering“ war: „Der Roboterarm ist Standard und die Intelligenz sitzt in den Endeffektoren, der Sensorik und dem Software-Stack, der alles zusammenbringt. Das ist unser geistiges Eigentum, und genau das lässt sich skalieren.“

David gegen Goliath – oder Partner?

Während große Recycling-Konzerne oft noch auf den Schredder setzen und die manuelle Demontage an ihre Grenzen stößt, positioniert sich R3 Robotics in einer neuen Nische. Es geht nicht darum, die Chemie-Giganten zu ersetzen, sondern ihnen den Rohstoff so rein wie möglich zu liefern – als strategische Quelle für kritische Materialien. Doch der Markt schläft nicht: Weltweit entstehen Initiativen zur Automatisierung.

Trotz des aktuellen „Gegners“ – dem Menschen mit dem Schraubenzieher – und potenzieller Konkurrenz durch Tech-Start-ups oder Autohersteller, bleibt Welter gelassen. „Wir konkurrieren nicht mit den Chemie-Giganten, wir liefern ihnen den reinsten möglichen Stoffstrom“, stellt er klar. Gegenüber potenziellen Nachahmern sieht er einen entscheidenden Vorteil, den „Unfair Advantage“: die Kombination aus Flexibilität und industrieller Automatisierungstiefe. „Wir sind aktuell die einzige Plattform, die sowohl Variabilität managt als auch für kontinuierlichen Industriebetrieb ausgelegt ist.“

Deutschland als Labor, USA als Skalierungsmarkt

Die Wachstumsstrategie von R3 Robotics ruht auf zwei massiven Säulen: technologischer Tiefe in Europa und kommerzieller Breite in den USA.

Deutschland fungiert dabei als das technologische Rückgrat. Mit der Erweiterung der Anlage in Karlsruhe zur Lighthouse Facility demonstriert das Unternehmen industrielle Leistungsfähigkeit direkt vor der Haustür der großen Autobauer. Hier wird die Technologie gehärtet. Das zeigt sich auch im Leuchtturmprojekt ReDriveS, wo R3 Robotics Seite an Seite mit Giganten wie Schaeffler und VW an der Demontage von E-Achsen arbeitet.

Doch für das massive Volumen blickt das Team über den Atlantik. Der für 2026 geplante Markteintritt in den USA ist Kern der neuen Strategie. Die frischen 20 Millionen Euro sollen gezielt in den Aufbau strategischer Partnerschaften vor Ort fließen, um die Technologie dort auszurollen, wo Pragmatismus auf riesige „End-of-Life“-Volumina trifft. Für Welter ist dieser Doppelschlag essenziell: „Deutschland ist unser Beweisstand. Hier zeigen wir Schaeffler, VW und Co., dass unsere Technologie industriellen Maßstäben in Deutschland standhält.“ Die USA seien hingegen der wichtige Skalierungsmarkt, wo pragmatische Entscheider auf gigantische Volumina treffen. „Beides brauchen wir: die Glaubwürdigkeit aus Europa und das Volumen aus Amerika.“

Industrialisierung statt Romantik

Mit Peter Mohnen, dem ehemaligen CEO des Roboter-Riesen KUKA, holte sich das Start-up zudem einen Beirat, der wie kaum ein anderer weiß, was Industriestandard bedeutet. Er beschreibt den Ansatz von R3 als Beweis für die nötige Automatisierungsexpertise, um Variabilität und Sicherheit gleichzeitig zu managen.

Um diese Expertise weiter auszubauen, wächst das Team rasant. Die Belegschaft soll mit der neuen Finanzierung massiv aufgestockt werden, vor allem im Bereich Engineering und KI. R3 Robotics hat den Beweis erbracht, dass Kreislaufwirtschaft kein ökologisches Nischenprojekt sein muss, sondern ein harter industrieller Prozess ist, der sich rechnet.

Denn letztlich, so das Fazit von Antoine Welter, sei Automatisierung der einzige Weg, das Problem wirklich zu lösen – nicht allein aus ökologischen Gründen, sondern weil es wirtschaftlich Sinn ergibt. „Was wir aufbauen, ist am Ende ein harter industrieller Prozess: Er muss zuverlässig funktionieren und sich rechnen.“ Es gehe aber um mehr als ein Geschäftsmodell: „Europa braucht eine Antwort auf die Frage, woher seine kritischen Materialien in Zukunft kommen“, mahnt Welter abschließend. „Wenn Europa diesen Zugang sichern will, braucht es Unternehmen, die genau das industriell umsetzen können. Dafür bauen wir diese Infrastruktur, und mit dem neuen Kapital und Team haben wir jetzt die Mittel dazu.“

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

Europa kann KI!

Was wir von den besten EU-AI-Companies lernen können, erläutert KI-Experte Fabian Westerheide.

Europa muss sich bei KI nicht kleinreden. Wir sehen gerade sehr deutlich: Aus Europa heraus entstehen Unternehmen, die Kategorien besetzen – und dann auch das große Kapital anziehen. Beispiele gibt es genug: Mistral AI, DeepL, Black Forest Labs, Parloa, Helsing, Lovable oder n8n.

Ich schreibe das aus drei Blickwinkeln: als Investor (AI.FUND), als Konferenz-Initiator (Rise of AI Conference) und als Autor von „Die KI-Nation“. Was du hier bekommst, ist kein „Europa-hat-ein-Problem“-Essay – sondern eine Analyse plus ein Execution-Set an Empfehlungen, das du direkt auf dein Start-up übertragen kannst.

Die Realität: Seed geht oft – Scale ist das Spiel

Am Anfang brauchst du selten „zu viel“ Geld. MVP, erste Kunden, Iteration: Das klappt in Deutschland in vielen Fällen mit Seed. Die echte Trennlinie kommt später – wenn du aus einem starken Start-up einen Kategorie-Gewinner bauen willst.

Denn KI ist zunehmend Winner-takes-most. Und das gilt auch fürs Kapital: In vielen Fällen ist die Growth-Finanzierung in den USA grob 25-mal größer – bei den aktuellen Front-Runnern (Modelle, Infrastruktur, Distribution) wirkt es teilweise wie 100-mal, weil Kapital sich auf die vermuteten Sieger stapelt. (Nicht „fair“, aber Marktmechanik.)

Die gute Nachricht: Genau die EU-Vorbilder oben zeigen, dass du das nicht wegdiskutieren musst – du musst es exekutieren.

Was die EU-Winner gemeinsam haben: 6 Execution-Prinzipien

1. Starkes Gründerteam – aber vor allem: vollständig

Alle genannten Vorbilder hatten (oder bauten sehr schnell) ein Team, das drei Dinge gleichzeitig kann:

- Tech & Produkt (nicht nur „Model-IQ“, sondern Produktgeschmack)

- Go-to-Market (Vertrieb, Buyer-Verständnis, Pricing)

- Tempo (entscheiden, shippen, lernen)

Wenn eine Säule fehlt, zahlst du später mit Zeit. Und Zeit ist in KI eine Währung, die dir niemand schenkt.

Founder-Move: Benenne eine Person, die Umsatz genauso hart verantwortet wie Modellqualität. Wenn das „später“ ist, ist das sehr wahrscheinlich dein Bottleneck.

2. Global denken – aber spitz: KI-Nische statt Bauchladen

Die EU-Winner sind nicht „KI für alles“. Sie besetzen klare Nischen:

Language-AI (DeepL), Customer-Experience-Agents (Parloa), GenAI-Modelle (Black Forest Labs), Defence-Tech (Helsing), Builder/Vibe-Coding (Lovable), Orchestration & Automation (n8n), Foundation-Model-Ambition (Mistral).

Founder-Move: Formuliere deinen Claim so, dass er in einem Satz sagt, welche Kategorie du dominierst. Wenn du drei Absätze brauchst, bist du noch zu breit.

3. Umsatz ist keine Nebenwirkung – Umsatz ist Souveränität

Der schnellste Weg zu Growth-Capital ist nicht „noch ein Pilot“, sondern Revenue, der deine Kategorie glaubwürdig macht.

Parloa kommuniziert z.B. ARR > 50 Mio. USD und wächst international – genau die Art Signal, die große Runden freischaltet.

Founder-Move (gegen Pilotitis): Kein PoC ohne schriftlichen Pfad in einen Vertrag (Budget, KPI, Entscheidungstermin). Sonst finanzierst du mit deiner Runway den Lernprozess des Kunden.

4. Internationales Kapital früh anbahnen – bevor du es brauchst

Das Muster ist klar: Erst Kategorie-Story + Traktion, dann große Checks.

Mistral (Series C 1,7 Mrd. €) oder Lovable (330 Mio. USD bei 6,6 Mrd. Bewertung) sind kein „Glück“ – das ist Momentum + Positionierung + Timing.

Founder-Move (90-Tage-Plan):

- Baue eine Capital Map deiner Nische (wer zahlt Growth-Checks?)

- Definiere die drei Metriken, die diese Investor:innen sehen wollen

- Organisiere zehn Intros jetzt, nicht erst bei sechs Monaten Runway

5. Compute ist keine IT-Zeile – es ist ein Wachstumshebel

In KI ist Compute Teil deiner Wettbewerbsfähigkeit. Geschwindigkeit beim Trainieren, Testen und Deployen entscheidet, wie schnell du am Markt lernst.

Founder-Move: Plane Compute-Runway wie Cash-Runway. Verhandle früh Kontingente, bevor dein Verbrauch explodiert – sonst wird Wachstum plötzlich zur Margen-Frage.

6. Trust & Compliance als Verkaufsargument – nicht als Ausrede

Gerade in DACH gilt: Wer secure, audit-fähig, enterprise-ready wirklich liefern kann, gewinnt Deals.

DeepL betont genau diesen Business-Wert: verlässliche, sichere Lösungen statt Hype.

Founder-Move: Baue Trust-Artefakte früh – Dokumentation, Governance, Datenflüsse, Rollen, Audit-Spuren. Das beschleunigt Enterprise-Vertrieb, statt ihn zu bremsen.

Kurz-Checkliste: Wenn du in Europa KI gewinnen willst

- Kategorie in einem Satz (spitze Nische, globaler Anspruch)

- Klarer Revenue-Pfad (weniger Piloten, mehr Verträge)

- Capital Map (international früh andocken)

- Compute-Runway (wie Cash planen)

- Trust by Design (verkaufsfähig machen)

- Tempo als Kultur (shippen, messen, nachschärfen)

Europa kann KI. Die Frage ist nicht, ob hier Talent existiert – das ist bewiesen.

Die Frage ist, ob du Execution so aufsetzt, dass aus Talent Marktführerschaft wird.

Der Autor Fabian Westerheide gestaltet als KI-Vordenker, Investor, Ökosystem-Pionier und Keynote Speaker seit über einem Jahrzehnt die Debatte um KI, Macht und digitale Zukunft mit.

Diese 10 Start-ups bauen an der Zukunft der AgriFood-Branche

Die deutsche Start-up-Landschaft verzeichnete 2025 ein Rekordhoch bei Neugründungen. Doch gerade im AgriFood-Sektor ist der Weg vom Prototyp zum Marktführer steinig. Kapitalintensive Hardware und strenge Regulatorik bremsen viele aus. Der Growth Alliance Accelerator zeigt, wie Gründer*innen diese Hürden überspringen – und präsentiert zehn Akteure, die auf der Erfolgsspur sind.

Es ist ein Paradoxon: Die Nachfrage nach nachhaltigen Lebensmitteln und effizienter Landwirtschaft ist so hoch wie nie, doch für Gründer*innen und junge Unternehmen in der AgriFood-Branche bleibt der Markteintritt ein Hürdenlauf. Während Software-Start-ups oft mit geringem Kapital skalieren, kämpfen Food- und AgTech-Pioniere mit der „Hardware-Falle“. Sie benötigen teure Produktionsanlagen, Labore und müssen langwierige Zulassungsverfahren (z.B. Novel-Food-Verordnung) durchlaufen.

Dennoch ist die Branche im Aufwind: Laut dem Deutschen Startup Monitor und aktuellen Zahlen des Startup-Verbands stiegen die Gründungszahlen 2025 um beachtliche 29 Prozent. Das Kapital ist da, doch es fließt selektiv. Investor*innen suchen heute keine reinen Ideen mehr, sondern validierte Geschäftsmodelle mit technologischem Tiefgang (DeepTech). Genau hier setzte das Finale des Growth Alliance Accelerator 2025 am 28. Januar 2026 in Frankfurt/Main an.

Brückenschlag zwischen Acker und Finanzwelt

Initiiert vom TechQuartier und der Landwirtschaftlichen Rentenbank, hat sich der Accelerator als Schmiede für die „Scale-up“-Phase etabliert. Vier Monate lang wurden zehn Start-ups, die bereits eine Nutzer*innenbasis vorweisen konnten, fit für die nächste Finanzierungsrunde gemacht.

Das Programm adressierte genau die Pain Points der Branche: Verhandlungstaktik, Rechtsfragen und vor allem den Zugang zu Kapital. Ein Highlight war das Investor Dinner im November 2025, bei dem die Gründer*innen direkten Zugang zu Risikokapitalgeber*innen erhielten – in der aktuellen Marktphase ein entscheidender Wettbewerbsvorteil.

Die „Class of 2025“: Wer die Transformation treibt

Die zehn Absolvent*innen decken die gesamte Wertschöpfungskette ab – vom Boden über das Labor bis zum Supermarktregal. Hier ein Blick auf die Köpfe hinter den Innovationen:

1. High-Tech auf dem Acker: Robotik und Daten

Die Digitalisierung der Landwirtschaft (Smart Farming) ist der stärkste Hebel für mehr Effizienz.

Paltech GmbH

Die Brüder Felix und Florian Schiegg gründeten 2022 Paltech zusammen mit Jorge Decombe im Allgäu. Ihr autonomer Roboter für chemiefreie Unkrautbekämpfung im Grünland ist eine Antwort auf strengere Pestizid-Gesetze und Personalmangel.

Bacchus Software GmbH

Das 2023 gegründete Start-up bacchus Weinbau-Software um das Trio Maximilian Dick, Julian Herrlich und Philipp Bletzer digitalisiert den Weinbau. Ihre Software ersetzt das händische Fahrtenbuch und koordiniert die komplette Weinbergsarbeit.

Agrario Energy

Die Energiewende macht Landwirt*innen zu Energiewirt*innen. Seit 2023 bieten die Gründer Alexander von Breitenbach und Chris Weber mit Agrario Energy eine unabhängige Vergleichsplattform, die Flächeneigentümer mit Betreiber*innen von Erneuerbare-Energien-Anlagen zusammenbringt.

2. Deep Tech & Sicherheit: Das Labor als Wächter

Lebensmittelsicherheit wird durch globale Lieferketten immer komplexer. Hier setzen wissenschaftsbasierte Ausgründungen an.

NanoStruct GmbH

NanoStruct wurde 2021 als Spin-off der Universität Würzburg gegründet. Das Team nutzt Nanotechnologie, um gefährliche Bakterien in Lebensmitteln in Minuten statt Tagen aufzuspüren.

SAFIA Technologies

Gegründet 2020 von Timm Schwaar (aus der Bundesanstalt für Materialforschung), entwickelt das Berliner Start-up SAFIA Technologies Schnelltests für Mykotoxine (Schimmelpilzgifte). Ihre Technologie ermöglicht Laborqualität im Schnelltest-Format.

Landman.Bio

Das noch junge Unternehmen (Gründung 2023) Landman.Bio nutzt Bakteriophagen (Viren, die Bakterien fressen) als natürliche Waffe gegen Pflanzenkrankheiten – eine dringend benötigte Alternative zu Antibiotika und klassischen Pestiziden in der Nutzpflanzenzucht.

3. Sustainability & Climate: Kohlenstoff als Währung

CO2-Tracking ist kein Marketing-Gimmick mehr, sondern ökonomische Notwendigkeit.

CinSOIL

Das 2024 in Berlin gegründete CinSOIL-Team um Dr. Giorgi Shuradze, Dr. Antonella Succurro und Dr. Tavseef Shah kommt aus der Wissenschaft. Ihr KI-Tool nutzt Satellitendaten, um Bodenkohlenstoff zu erfassen. Das ermöglicht Agrarunternehmen, Dekarbonisierung nicht nur zu behaupten, sondern zu beweisen.

Niatsu

Gegründet 2023 von Marius Semm und Jakob Tresch in Zürich, adressiert Niatsu die Lebensmittelindustrie. Ihre Software berechnet den Product Carbon Footprint (PCF) automatisiert und kostengünstig, was gerade für den Mittelstand entscheidend ist.

4. Future Food

Was wir morgen essen (und trinken).

VANOZZA

Eines der etabliertesten Start-ups der Runde. Gegründet 2019 von Nico Hansen in Hamburg, hat sich Vanozza mit fermentierten Käsealternativen auf Cashew-Basis einen Namen gemacht und arbeitet nun an der „zweiten Generation“ ihrer Produkte.

food42morrow/JUMA

Die Frankfurter Gründer Raoul und Max Kammann sowie Carlos Lopez Granado gründeten die GmbH bereits 2020 und brachten 2022 ihre Marke JUMA (Tee-Eistees auf Guayusa-Basis) auf den Markt. Sie bedienen den Trend zu „Functional Food“.

Fazit

Die AgriFood-Start-ups des Abschlussjahrgangs des Growth Alliance Accelerators 2025 haben die Phase der reinen Ideen-Findung bereits eindrucksvoll gemeistert. Jetzt geht es um Skalierung, industrielle Anwendung und messbaren Impact. Programme wie die Growth Alliance sind dabei der Katalysator, der wissenschaftliche Exzellenz mit dem nötigen Geschäftssinn verbindet.

Optocycle: Bauschutt-Recycling auf KI-Basis

Die Optocycle-Gründer Max-Frederick Gerken und Lars Wolff Optocycle zeigen, wie aus Bauschutt neuer Rohstoff wird und erhalten dafür eine Förderung der Deutschen Bundesstiftung Umwelt (DBU).

Jährlich fallen in Deutschland laut Umweltbundesamt rund 86 Mio. Tonnen Schutt und Abfälle auf Baustellen an. Häufig landen diese Materialien auf Deponien. So gehen allerdings wertvolle Ressourcen verloren. Der Ausweg: Ein hochqualitatives Recycling des Schutts vermeidet klimaschädliche Emissionen und hält wertvolle Materialien im Wertstoffkreislauf – und das bei zertifiziert gleichwertiger Qualität.

Um das Recycling von Material im Bausektor zu automatisieren, entwickelt das 2022 von Max-Frederick Gerken und Lars Wolff gegründete Start-up Optocycle aus Tübingen ein System auf Grundlage künstlicher Intelligenz (KI) zum Echtzeit-Monitoring.

Echtzeit-Monitoring im Recycling-Prozess

Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit rund 170.000 Euro. Im Rahmen der DBU-Green Startup-Förderung haben die Gründer ein KI-basiertes System zur automatischen, reproduzierbaren Klassifizierung von Bauabfällen entwickelt. Darauf aufbauend soll nun ein Prototyp das Echtzeit-Monitoring von RC-Körnungen – also recycelten Gesteinskörnungen aus Bauschutt – ermöglichen.

„Aktuell basiert in der Branche der Aufbereitungsprozess von Bauschutt meist auf subjektiven Schätzungen“, so Max-Frederick Gerken. Auch das Endprodukt werde nur stichprobenartig im Labor überprüft. Mit dem System sei „Echtzeitmonitoring von Recycling-Gesteinskörnungen möglich. Somit können die Qualität der Körnung verbessert und mehr Material in die Beton-Produktion überführt werden“, so Gerken.

Die Qualität von Sekundärrohstoffen verbessern

Das System kombiniert laut Gerken moderne, optische Sensorik mit KI – und löse so ein altbekanntes Problem in der Baubranche. „Zurzeit schwankt oft die Beschaffenheit der recycelten Rohstoffe. Das bedeutet einerseits ein wirtschaftliches Risiko für Unternehmen und führt andererseits zum Verlust von wertvollen Materialien“, so Gerken. Optocycle erwartet mithilfe seiner Entwicklung eine 20 Prozent höhere Menge an recycelten, hochqualitativen Gesteinskörnungen sowie 15 Prozent geringere Abfallreste, die sonst auf Deponien landen würden. Dazu werden nach Gerkens Angaben sowohl der eingehende Schutt „optimal klassifiziert“ als auch das Ergebnis transparent überprüft. Kooperationspartner ist hierbei die Heinrich Feeß GmbH, die laut Gerken bereits seit vielen Jahren mit Optocycle zusammenarbeitet. Der Mitgründer weiter: „Die Technologie leistet einen Beitrag für Kreislaufwirtschaft im Bauwesen. Wir helfen dabei, die Qualität von Sekundärrohstoffen zu verbessern, die aus dem Bauschutt gewonnen werden. Diese Lösung lässt sich zudem perspektivisch auf alle Abfallströme übertragen."

Das System von Optocycle kann Gerken zufolge direkt in bereits bestehende Anlagen zur Verarbeitung von Bauabfällen installiert werden – „direkt über dem Fließband.“ Diese einfache Nachrüstung spare Kosten und ermögliche die schnelle Umsetzung eines innovativen Bauschutt-Recyclings. „Denn nur wenn das Recycling finanziell machbar ist, kann die Kreislaufwirtschaft in der Baubranche Erfolg haben“, so Gerken.

Kreislaufwirtschaft in der Baubranche ist aktiver Klimaschutz

Kreislaufwirtschaft in der Baubranche hat nach den Worten des zuständigen DBU-Referenten Dr. Volker Berding wichtige Effekte für den Klimaschutz: „Die Produktion von immer neuem Beton sorgt für hohen Ausstoß von klimaschädlichen Treibhausgasen.“ Einer WWF-Studie zufolge entstehen bei der Herstellung von Zement – dem wichtigsten Bestandteil von Beton – acht Prozent der gesamten globalen Treibhausgasemissionen. Berding: „Alles, was zur einer Emissionsreduzierung beiträgt, hat also bereits einen großen Effekt für den Klimaschutz.“ Eine Kreislaufwirtschaft funktioniere jedoch nur, „wenn die Sekundärrohstoffe sich qualitativ nicht von einer Neuproduktion unterscheiden. Genau diesen Schritt kann Optocycle mit einem skalierbaren, optimierten Prototypen gehen.“

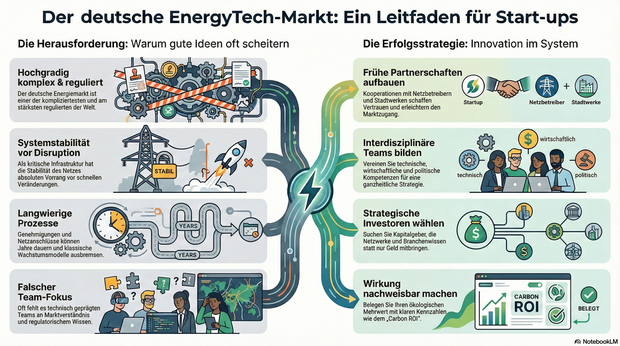

Report: Inside Germany’s EnergyTech Market

Aktuelle Ein- und Ausblicke für Gründer*innen und Start-ups im EnergyTech-Markt.

EnergyTech gehört in Deutschland zu den spannendsten, aber auch herausforderndsten Märkten für Gründer*innen. Die Kombination aus technologischer Innovation, wirtschaftlichem Potenzial und der Dringlichkeit, das Energiesystem klimaneutral zu gestalten, schafft enorme Chancen. Gleichzeitig ist die Eintrittsbarriere hoch, denn der deutsche Energiemarkt ist einer der komplexesten und am stärksten regulierten weltweit.

Laut der Internationalen Energieagentur werden im Jahr 2025 weltweit rund 2,1 Billionen Euro in saubere Energien investiert. Damit übertreffen die Investitionen in erneuerbare Energien erstmals die in fossile Brennstoffe deutlich. Deutschland spielt dabei eine zentrale Rolle, denn kein anderes Land in Europa verfügt über eine vergleichbare Durchdringung mit erneuerbaren Energien. Diese Vorreiterrolle macht den Markt attraktiv, aber auch kompliziert.