Aktuelle Events

Die Zukunft der digitalen Infrastruktur

Mit „DI 2020. IT-Infrastruktur für das digitale Zeitalter“ von TechData liegt eine Studie vor, die sich mit allen Trends befasst, die im Bereich Digitalisierung und IT-Infrastrukturen in Zukunft für Unternehmen wichtig werden. Viele sind es schon jetzt, ihre Bedeutung wird aber weiter wachsen. Um zukunftsfähig zu bleiben, müssen sich nicht nur etablierte Firmen rechtzeitig auf diese Trends einstellen.

Die Evolution der IT-Infrastruktur

Die digitale Transformation beschleunigt weiter und stellt Unternehmen damit vor immer größere Herausforderungen. Denn die IT-Anwendungen der Zukunft bringen neue Anforderungen mit sich, die mit den herkömmlichen Infrastrukturen nicht mehr bewältigen lassen.

Wer nicht nur reagieren, sondern proaktiv handeln möchte, muss daher bei grundlegenden Elementen ansetzen – das gilt vor allem für die Rechenzentren. Diese müssen immer leistungsfähiger werden, was vor allem der Forderung nach zunehmender Flexibilität geschuldet ist.

An ihnen lässt sich deutlich aufzeigen, wie sich die Anforderungen an die digitale Infrastruktur insgesamt geändert haben. Die Gründe hierfür liegen wiederum in den Veränderungen, die das digitale Arbeiten mit sich bringt. Zum Beispiel dessen weitere Verbreitung, die nur noch weniger als ein Viertel der Unternehmen ausklammert.

Mehr Geschwindigkeit, mehr Komplexität

Die grundlegenden Aspekte, um die sich eine funktionierende, zukunftsfähige digitale Infrastruktur dreht, lassen sich auf die einfache Formel herunterbrechen: mehr Geschwindigkeit und mehr Komplexität. Mehr Daten sollen so schnell wie möglich gesammelt, gespeichert, analysiert, visualisiert und weiterverarbeitet werden.

Traditionelle Workloads greifen in diesem Big-Data-Umfeld deshalb nicht mehr. Sie sind auf Standardprozesse ausgelegt, die ein hohes Maß an Stabilität (nicht zuletzt im Sinne der Ausfallsicherheit) bieten und kosteneffizient sind. Durch die fortschreitende Digitalisierung gewinnen neben diesen beiden aber weitere Faktoren an Bedeutung.

Flexiblere und agilere Anwendungen und Prozesse

Die Datenmengen erfordern durch ihr Ausmaß eine andere Herangehensweise. Zusammenhänge zu erkennen und wirtschaftlich sinnvolle Schlüsse zu ziehen, wird eine immer komplexere Aufgabe:

Rechenzentren müssen darauf eingestellt sein, denn sie ermöglichen wiederum innovative Strategien und Prozesse, um die gewonnenen Daten richtig nutzen zu können. Das schließt unter anderem die Arbeit mit verschiedenen Cloud-Architekturen ein.

Daneben müssen, in einem fortlaufenden Prozess, technologische Neuerungen berücksichtigt und gegebenenfalls in die bestehende Infrastruktur integriert werden. Nur so kann beispielsweise der notwendige Automationsgrad erreicht werden, um riesige Datenmengen verarbeiten zu können.

Schneller, komplexer, umfangreicher: Der Umgang mit verschiedenen Workloads

Moderne IT-Strukturen müssen letztlich einen schwierigen Balance-Akt schaffen:

Einerseits verlangt die digitale Transformation mehr Agilität in der Infrastruktur, um auf technologische Neuerungen, digitale Trends und Big-Data schnell genug reagieren zu können – das ist auch unter Wettbewerbsgesichtspunkten eine Notwendigkeit.

Andererseits gelten die „alten“ Prinzipien weiterhin, ihr Zusammenwirken mit neuen Komponenten wird allerdings komplexer. Agilität und Stabilität müssen in Einklang gebracht werden und das vor einem finanziellen Hintergrund, in dem Kosteneffizienz nach wie vor wichtig, Investitionen in die Ausgestaltung der Infrastruktur aber erforderlich sind.

Thema Sicherheit: Relevanter als jemals zuvor

Bei aller Anpassungs- und Leistungsfähigkeit bleibt das Thema Sicherheit ein überaus relevanter Punkt. Server-Systeme müssen unabhängig von der Unternehmensgröße technisch in der Lage sein, die Sicherheit von immer größeren Mengen sensibler Daten zu gewährleisten.

Das ist, auch dank Cloud-Technologie, nicht mehr so sehr eine Frage der Hardware, dafür umso mehr eine der Software. Diese auf dem neuesten technischen Stand zu halten ist deshalb eine der dringlichsten Aufgaben für moderne IT-Strukturen. Veraltete Server-Software kann zu gravierenden Sicherheitslücken führen.

Dass Server-Betriebssysteme altersbedingt nicht weiter supportet werden, sollte daher für die Verantwortlichen Anlass genug sein, schnell aktuelle Alternativen zu finden. Thomas-Krenn bietet als OEM Partner von Microsoft einen schnellen Umstieg für alle Unternehmen, die vom End of Support für Windows Server 2008/R2 und SBS 2011 betroffen sind.

Mit dem Microsoft Windows Server 2019 lassen sich nicht nur etwaige Sicherheitslücken schließen, die Server-Software lässt sich auch für individuelle Wünsche von KMU anpassen. Damit sind nicht nur etwaige Sicherheitsprobleme gelöst, sondern zugleich die Weichen gestellt für vielfältige Serverfunktionen.

Für datengetriebene Geschäftsmodelle ist eine leistungsfähige und skalierbare Infrastruktur unerlässlich. Voraussetzung für Lösungen, die den unterschiedlichen Anforderungen – Skalierbarkeit, Agilität und Innovation, Ausfallsicherheit, Automation, Kosteneffizienz, Sicherheit – an moderne IT-Strukturen gerecht werden kann, ist die Auseinandersetzung mit strategischen Trends der Digitalisierung.

Strategien für die Digitalisierung

Mit den IT-Infrastrukturen die Grundlagen schaffen, um die digitalen Strategien der Zukunft umsetzen zu können – das ist die Herausforderung, die Unternehmen in zunehmendem Maße bewältigen müssen. Diese strategischen Trends beeinflussen alle Unternehmensbereiche, von der Automatisierung von Arbeitsprozessen über die Geschäftsmodelle bis hin zur User Experience.

Agilität und Innovation

Digitale Infrastruktur muss nicht nur selbst agil und innovativ sein, um mit den Anforderungen des Digitalen Wandels Schritt halten zu können. Sie muss außerdem ausreichende Flexibilität in Sachen Organisation, Geschäftsmodelle und Unternehmensprozesse ermöglichen.

Anpassungsfähigkeit ist ein zentraler Erfolgsfaktor, da auch der Innovationsdruck auf die Unternehmen weiter steigt. Den IT-Plattformen und -Prozessen kommt dabei eine Schlüsselrolle zu. Dazu müssen die entsprechenden Systeme unterschiedlichste Anforderungen bewältigen und technologische Neuerungen integrieren können.

Der Großteil der Unternehmen (rund 85 Prozent) investiert deshalb laut TechData in diesem Bereich. Fast 40 Prozent der befragten Betriebe sehen sogar ein konstantes Wachstum über die nächsten Jahre vor – so die Studie von TechData. Damit schaffen sie die Grundlagen, um neue Technologien früher zu erkennen und für die eigenen Bedürfnisse adaptieren zu können.

Digital User Experience

Die Digitale Transformation hat die Schnittstellen zwischen Mensch und Maschine keineswegs obsolet gemacht, sie sind vielmehr wichtiger geworden. Vor allem in der Interaktion mit Kunden sind sie ein zentraler Aspekt. Diese Bedeutung hängt nicht zuletzt mit den vielen Kommunikationsmöglichkeiten zusammen, die zwischen Nutzern und Unternehmen bestehen.

Damit einher gehen unterschiedliche Erwartungen an die jeweiligen Kanäle, die dementsprechend unterschiedliche technische Lösungen umfassen können – und müssen. Eine solche Lösung sind beispielsweise Chatbots, die mit Künstlicher Intelligenz verschiedene Bereiche des Kundenservice übernehmen können, vom Support bis zur Kaufberatung.

Den Unternehmen scheint die Bedeutung dieser Schnittstellen für die digitalen Erfahrungen ihrer Kunden durchaus bewusst zu sein. Zumindest zeichnet sich bei den geplanten Investitionen in entsprechende Technologien ein ähnliches Bild wie im Bereich Agilität und Innovation – nur knapp über 8 Prozent gehen von geringeren Ausgaben aus. Dagegen sehen rund 41 Prozent ein konstantes Wachstum der Ressourcen für die Digital User Experience kommen.

Data Driven Business

Daten werden zunehmend wichtiger für zahlreiche Geschäftsmodelle. Die Handhabung immer größerer Datenströme und die Umwandlung in einen relevanten Nutzen sind entscheidende Werkzeuge im Wettbewerb, den die digitale Transformation nur noch mehr beschleunigt.

Dabei geht es längst nicht mehr darum, möglichst viele Daten zu sammeln. Big Data war im Grunde genommen nur der Anfang, die anfallenden Datenmengen sind nur die Grundlage für Entscheidungen und neue Entwicklungen in den Unternehmen.

Denn die Daten sind prinzipiell in jedem Konzern vorhanden: Kundendaten, Unternehmensdaten, Prozesse, Marktanalysen, Verkaufszahlen und andere. Sie alle werden ohnehin gesammelt, deswegen ist die wichtigste Frage, wie mit ihnen umzugehen ist, um daraus ein „reasonable product“ zu erschaffen.

Funktionieren kann das nur, wenn aus den Daten die richtigen Insights gefolgert und diese wiederum in konkrete Entscheidungen einfließen können. Die Daten sollen dabei helfen, interne Prozesse zu optimieren und zu automatisieren, was letztlich auch das Daten-Handling selbst betrifft. Im Idealfall besteht das Ergebnis in effizienteren Dienstleistungen und Produkten und somit in zufriedeneren Kunden.

Die Grundlagen hierfür zu schaffen, ist die eigentliche Herausforderung, welcher die Unternehmen mit mehr Investitionen begegnen wollen. Damit soll beispielsweise das Problem der Datenarchivierung und -sicherung angegangen werden. Darüber hinaus gilt es geeignete Methoden und Strategien zu finden, um Daten digital verfügbar und automatisiert analysierbar zu machen.

Im Data Driven Business laufen darum all jene Aspekte zusammen, die im Zusammenhang mit einer zukunftsfähigen IT-Struktur relevant sind: Technologische Voraussetzungen, flexible und agile Systeme, Möglichkeiten für Innovationen in allen Unternehmensbereichen, basierend auf den gewonnenen Daten.

Cognitive Company

Ein Schlüssel, um das Daten-Handling zu verbessern, ist Cognitive Computing. Dabei handelt es sich um Systeme, die Kontextelemente erkennen und verstehen können. Das ermöglicht es ihnen, strukturierte und unstrukturierte Daten zu verwenden und darin Bezüge zu finden.

Auf der Basis von Informationen und Prozessen können solche kognitiven Systeme selbständig und automatisiert an Problemlösungen arbeiten. Gleichzeitig entwickelt sich das System durch Machine Learning kontinuierlich weiter und verbessert seine eigenen Fähigkeiten. Dabei ist es deutlich breiter aufgestellt als KI-Systeme, die üblicherweise spezialisiert auf die Lösung für ein bestimmtes Problem sind.

In einer „Cognitive Company“ sollen kognitive Systeme durch ihre Lern- und Anpassungsfähigkeit Aufgaben übernehmen, für die bislang vornehmlich Menschen zuständig waren. Digitale Kommunikationsschnittstellen wie die bereits erwähnten Chatbots helfen, die gewonnenen Erkenntnisse wieder an menschliche Gesprächspartner zu vermitteln.

Vorläufig ist die Zahl der Unternehmen, die Cognitive Computing bereits anwenden, noch in einem überschaubaren Bereich. Anders sieht es bei der Implementierung von Künstlicher Intelligenz in die digitale Unternehmensstrategie aus – hier ist der Anteil mit 65 Prozent deutlich höher.

Internet of Things und Smart Products

Die Möglichkeiten digitaler Infrastrukturen betreffen aber selbstverständlich nicht nur jene Prozesse, die sich um das Sammeln, Verwalten, Analysieren und Nutzbarmachen von Daten drehen. Über die Wertschöpfungskette hinaus lassen sich außerdem Logistik und Produktion verbessern.

Die Infrastruktur bildet, zusammen mit modernen Sensoren, die Grundlage für ein umfassendes Internet of Things, in dem vernetzte Maschinen miteinander interagieren können. Die Umsetzung von Industrie 4.0-Konzepten ist unter anderem wegen der Möglichkeiten für innerbetriebliche Optimierungen weit verbreitet, der Fortschritt dabei ist laut TechData jedoch recht unterschiedlich.

Da vor allem in produzierenden Betrieben die Potenziale – Stichwort Automatisierung – sehr groß sind, besteht ein großes Interesse daran, Lösungen für die eigenen Bedürfnisse zu entwickeln.

Automatisierung

In digitalen Systemen spielt die Automatisierung auf verschiedenen Ebenen eine wichtige Rolle. Beziehungsweise eröffnet die Digitalisierung neue Möglichkeiten für automatisiert ablaufende Unternehmensprozesse. Als prominentestes Beispiel fallen dazu smarte Fabriken ein, in der die Produktion weitgehend oder sogar vollständig digital und automatisiert abläuft. Überwiegend betrifft das repetitive Arbeitsabläufe ohne große Veränderungen.

Dank flexibler digitaler Infrastrukturen und Cloud Computing können diese Prozesse aber ebenfalls deutlich flexibler gestaltet werden. Das ist etwa für personalisierte und individualisierte Produkte ein großer Vorteil, denn diese können ohne größeren Mehraufwand realisiert werden.

Die Produktion wird dadurch kosteneffizient, wie sie überhaupt insgesamt effizienter wird: Ressourcen können besser verplant werden, von den zu verarbeitenden Materialien bis hin zum notwendigen Energieeinsatz.

Grundsätzlich ist das genauso in kleineren mittelständischen Unternehmen möglich, auch wenn die Herangehensweisen bei der Digitalisierung sich von denen der Global Player unterscheiden. Denn gerade in diesen Betrieben fallen die Investitionen in eine langfristige Verbesserung von IT-Infrastruktur und Automatisierung häufig am schwersten.

Trends für die IT-Infrastruktur der Zukunft

Big Data verspricht zahllose unternehmerische Möglichkeiten. Voraussetzung ist allerdings, die wachsenden Datenmengen sinnvoll nutzen und sicher aufbewahren zu können. Dazu braucht es sowohl technische Lösungen als auch neue Konzepte, damit die IT-Infrastruktur bei der Bewältigung der Daten helfen kann.

Auf diese Weise können Unternehmen ganz neue Vorteile für ihre Wertschöpfungskette ziehen, beispielsweise durch neue Geschäftsmodelle. Grundvoraussetzung für alle sich abzeichnenden Trends bleibt aber ein leistungsstarkes Rechenzentrum.

Infrastructure-as-a-Service (IaaS) und Platform-as-a-Service (Paas)

Daneben ist es vor allem das Cloud Computing, das Unternehmen in Sachen Digitalisierung zahlreiche Möglichkeiten eröffnet. Denn es geht hier schon lange nicht mehr nur um einen praktischen Weg, Daten zu archivieren, ohne eigene Speicherkapazitäten zu belasten.

Vor allem Start-ups können über die Cloud eine Vielzahl an Diensten beziehen, für die sie dann keine eigenen IT-Ressourcen aufbringen müssen. Telefonie, Mail, Meetings und andere Aspekte des Arbeitsalltags lassen sich beispielsweise per Cloud-Service nutzen, denkbar sind aber noch viel weitreichendere Cloud-Anwendungen. Infrastructure‑as‑a‑Service (IaaS) etwa stellt Ressourcen rund um die IT‑Infrastruktur bereit. Das umfasst Rechenleistung genauso wie Netzwerkkapazitäten.

Auf diesem Wege kann das unternehmenseigene Rechenzentrum erheblich entlastet werden, da es die digitale Infrastruktur nicht mehr alleine tragen muss – selbst Infrastrukturen ohne eigenen physischen Server sind realisierbar. Damit entfallen nicht zuletzt die Kosten für Anschaffung und Wartung der ansonsten notwendigen Hardware.

Platform-as-a-service (PaaS) schafft die Arbeitsumgebung im engeren Sinne. Dazu gehören beispielsweise Betriebssysteme, Datenbanken und Anwendungen.

Der große Vorteil besteht unter anderem darin, dass die bereitgestellten Applikationen immer in der aktuellsten Version vorliegen. Die Entwicklung übernimmt dabei der Cloud-Provider, das Unternehmen selbst spart dadurch Zeit und Geld. Da sich die Anwendungen außerdem in ihrem Umfang ganz an die individuellen Bedürfnisse der Nutzer anpassen lassen, können auch damit freigewordene Ressourcen an anderer Stelle eingesetzt werden.

Beide Ansätze bedeuten in ihren jeweiligen Bereichen Einsparungspotenziale für die Unternehmen, da wichtige und arbeitsintensive Aufgabenbereiche ausgelagert werden können. Die virtuelle Infrastruktur bietet außerdem ein hohes Maß an Flexibilität für die Ausgestaltung und die Ressourceneinteilung.

Sowohl IaaS als auch PaaS können IT-Infrastrukturen in Unternehmen verschiedenste Möglichkeiten bieten, um die gewünschten Leistungsanforderungen – stabil, sicher, flexibel, agil, schnell – zu erreichen. Das gilt für unterschiedliche Anwendungsgebiete, von der Datenanalyse über E-Commerce, Digital Marketing und CRM bis hin zu IoT-Lösungen und Content Management für Online-Portale.

Eine vollständige Umstellung auf Cloud-Services ist dabei gar nicht zwingend notwendig. Stattdessen können Unternehmen sich über die für sie interessantesten Anwendungsmöglichkeiten an die Thematik herantasten.

In Zukunft wird der Umgang mit Cloud-Lösungen aber mit großer Wahrscheinlichkeit auf breiterer Ebene stattfinden. Obwohl Cloud Computing nicht ganz ohne Nachteile ist und gerade bei den Themen Datenschutz und Performanceabhängigkeit von der Internetverbindung kritisch betrachtet werden muss.

Hybrid Cloud und hyperkonvergente Infrastrukturen

Cloud-Konzepte sind zwar einer der bestimmenden Trends bei der Entwicklung moderner digitaler Infrastrukturen, aber längst nicht die einzigen. Dass verschiedene Cloud-Modelle in Hybrid Clouds aufgehen, unterstreicht aber nochmals den Stellenwert dieser Technologie.

Die Idee hinter hybriden Cloud-Lösungen besteht darin, möglichst viele Vorteile zu erhalten, ohne gleichzeitig die Nachteile in Kauf nehmen zu müssen:

- Public Clouds bieten die oben beschriebene Flexibilität, wie sie in IaaS- und PaaS-Ansätzen zum Tragen kommt.

- Private Clouds hingegen versprechen das Maß an Datensicherheit, die in einer Public Cloud nicht unbedingt gewährleistet werden können.

- Kombiniert werden beide Modelle mit traditioneller Infrastruktur. Diese bindet zwar mehr Ressourcen als eine reine Cloud-Lösung, auf der anderen Seite bleiben Unternehmen so unabhängiger von den Providern.

Insgesamt wird die Infrastruktur dadurch komplexer, vor allem beim Verwaltungsaufwand. Das wirkt sich unter Umständen auf die Effizienz der Arbeitsprozesse und Sicherheitsbelange aus, die eigentlich auf diesem Weg umgangen werden sollten.

Deshalb werden beispielsweise hyperkonvergente Infrastrukturen (Hyper Converged Infrastructures) zunehmend zu einer Alternative. Diese versprechen eine weitreichende Vereinfachung der Infrastruktur, bei der Rechenleistung, Speicher und Netzwerk als virtuelle Ressourcen bereitgestellt und von einer einzigen Management-Lösung verwaltet werden.

Die IT-Infrastruktur wird damit vollständig virtualisiert und unabhängig von der Hardware. Waren derartige Lösungen bis vor einigen Jahren noch aufwändig und teuer – eigene Server-Architekturen und weitere Elemente erforderten hohe Investitionen und den Einsatz von Spezialisten – werden HCI‑Lösungen inzwischen als Plug & Play-Modell angeboten.

Neue Speichertechnologien

Eine Herausforderung für sämtliche digitalen Infrastrukturen bleibt das Speichern von großen, unstrukturierten Datenmengen. Neben den lange Zeit üblichen Methoden Block Storage und File Storage hat sich in den vergangenen Jahren die Objektspeicherung als Möglichkeit für diese Aufgabe etabliert.

Insofern ist Object Storage keine gänzlich neue Technologie, sie hat aber enorm an Bedeutung gewonnen. Denn die Beschreibung von Daten als Objekte – unter anderem mit Hilfe der Meta-Daten – vereinfacht die Speicherung, gerade bei großen Datenmengen. Dienste wie Dropbox oder Google Docs haben das vorgemacht.

Unkomplizierter lässt sich prinzipiell auch der Zugriff auf die einzelnen Objekte in einer Cloud-Umgebung gestalten. Da dieser über das Internet geschieht, können mehrere Nutzer gleichzeitig auf die Objekte zugreifen. Dazu ist Object Storage bestens geeignet für das Erstellen von Backups und die Archivierung von Daten. Gegenüber anderen Speichertechnologien und NAS‑Infrastrukturen ist diese Methode daher im Vorteil.

Auch physisch entwickeln sich die Speichermedien weiter, die wichtigste Technologie in dieser Hinsicht sind Flash-Speicher. Diese versprechen deutlich schnellere Verarbeitungsgeschwindigkeiten im Vergleich zu magnetischen Festplatten.

Das macht Flash Storage zu einer attraktiven Alternative in vielen Anwendungsgebieten. Etwa dort, wo es um die Verarbeitung von vielen Daten geht, die möglichst in Echtzeit ablaufen soll – von der Datenanalyse bis zum Maschinenlernen bieten sich Unternehmen zahlreiche Einsatzmöglichkeiten für All-Flash-Arrays.

Digitale Infrastrukturen als Herausforderungen

Für Unternehmen, unabhängig von ihrer Größe, bestehen also weiterhin viele Handlungsfelder in Bezug auf den Aufbau zukunftsfähiger digitaler Infrastrukturen. Im Kern müssen überall wachsende Datenmengen gemanagt und die Voraussetzungen dafür geschaffen werden. Die verschiedenen digitalen und technologischen Trends eröffnen individuelle Möglichkeiten, um sich gemäß den speziellen Anforderungen im eigenen Unternehmen passgenau aufzustellen.

Dabei ist es nicht mehr zwingend notwendig, die IT grundsätzlich alleine aufzubauen. Die meisten Dienste lassen sich auslagern. Das geht zwar zu Lasten der Unabhängigkeit, reduziert aber beispielsweise gleichzeitig Investitionen in Hard- und Software.

Unerlässlich ist jedoch die Auseinandersetzung mit einer möglichen digitalen Strategie, die einerseits den Bedarf erfasst und andererseits langfristige Ziele definiert. Aufbauen darauf lässt sich eine digitale Infrastruktur errichten, die bestmöglich zum Unternehmen passt und diesem ausreichend Flexibilität lässt, um neue Trends und Entwicklungen schnell integrieren zu können.

Diese Artikel könnten Sie auch interessieren:

Amba: Der Schlüssel zum Digital Detox

Drei Stunden und 19 Minuten – so lange hängen junge Erwachsene täglich auf Social Media, oft völlig unbewusst. Das Kölner Start-up Amba will diesen Scroll-Automatismus nun mit einem simplen haptischen Trick durchbrechen: Ein NFC-Schlüsselanhänger erzwingt eine physische Hürde. Doch kann das Konzept im Alltag wirklich bestehen?

Das 2025 von Yves Maurice Clever und Bastian Fischer gegründete Kölner Start-up Amba positioniert sich mutig im umkämpften Digital-Wellbeing-Markt. Statt auf strenge App-Verbote zu setzen, wollen die beiden 27-Jährigen das unbewusste Dauer-Scrollen auf Social Media mit einem physischen Schlüsselanhänger stoppen. Angesichts einer durchschnittlichen Social-Media-Nutzungsdauer von drei Stunden und 19 Minuten bei jungen Erwachsenen – wovon viel Zeit für rein gewohnheitsmäßiges Scrollen draufgeht – zielt Amba darauf ab, dieses Muster durch eine haptische Hürde zu durchbrechen.

Yves, der in Neuss Marketing studierte, beschäftigt sich schon lange mit digitaler Achtsamkeit, während Bastian als Informatiker das technische Know-how aus der Softwareentwicklung mitbringt. Angetrieben aus dem eigenen Frust über gängige Software-Lösungen, die sich mit wenigen Klicks umgehen ließen, begannen sie im Sommer vergangenen Jahres mit der Produktentwicklung, bevor im Oktober 2025 die offizielle Gründung in Köln folgte.

Haptik schlägt Habit

Doch wie verhindert man, dass der Griff zum NFC-Chip nicht bald zur nächsten unbewussten Gewohnheit wird? „Unbewusstes Scrollen funktioniert so gut, weil alles in derselben Bewegung passiert: Man nimmt das Handy in die Hand und ist sofort in der App“, analysiert Mitgründer Bastian. Ein physisches Element unterbreche genau diesen Automatismus.

Der entscheidende Vorteil gegenüber klassischer Software liege im Timing, so Bastian weiter: „Bildschirmzeit-Limits erscheinen meist erst im Scroll-Moment, wenn viele schon im Autopilot sind und sie reflexartig wegklicken. Bei Amba fällt die Entscheidung vorher.“ Nach dem haptischen Entsperren legen die Nutzer*innen fest, wie viel Zeit sie in der App verbringen möchten. Bastian betont: „Dieser kleine mentale Rahmen macht Social Media wieder zu einer bewussten Entscheidung statt zu einer Gewohnheit.“ Erste Tests scheinen den Gründern recht zu geben: Eigenen Angaben zufolge sei die Social-Media-Nutzung der Tester auf durchschnittlich 49 Minuten pro Tag gesunken.

Das Hardware-Paradoxon und die Konkurrenz

Der Ansatz der „Intentional Friction“ ist clever, doch der Markt verzeiht keine Fehler. Mit dem niederländischen Start-up Unpluq existiert bereits ein etablierter Konkurrent mit einem fast identischen NFC-Konzept. Yves sieht den Unterschied seines Produkts vor allem in der Systematik. „Viele bestehende Lösungen [...] funktionieren nach dem Prinzip: Man hält den Tag ans Smartphone, um Apps zu sperren, und deaktiviert die Sperre später wieder. Wir haben die Logik umgedreht“, kontert Yves. Bei Amba seien die Apps standardmäßig gesperrt und würden erst durch den Schlüssel freigeschaltet.

Zudem wolle man sich über eine extrem niedrige Einstiegshürde abheben: „Deshalb kostet der physische Tag bei uns nur einen symbolischen Euro und Nutzer können Amba zwei Wochen lang testen“, erklärt Yves den aggressiven Markteinstieg.

Der Kampf gegen die Abo-Müdigkeit

Dennoch muss sich Amba langfristig beweisen, insbesondere da laut einer ExpressVPN-Umfrage 38 Prozent der Konsument*innen explizit unter „Abo-Müdigkeit“ leiden. Ob die Nutzerschaft dauerhaft bereit ist, knapp 20 Euro im Jahr für einen softwarebasierten Verzicht zu zahlen, bleibt abzuwarten.

Bastian räumt offen ein: „Mit den physischen Tags verdienen wir tatsächlich kein Geld, sie decken lediglich die Produktionskosten.“ Er ist jedoch überzeugt, dass die Abo-Investition für die Nutzer*innen unverzichtbar bleibt, da das Suchtpotenzial der Apps nicht verschwinde. „Social-Media-Plattformen sind bewusst so gestaltet, dass sie möglichst lange Aufmerksamkeit binden. Viele Nutzer berichten uns, dass sie nach kurzer Zeit wieder in alte Muster zurückfallen, sobald sie die Unterstützung entfernen“, warnt Bastian. Das Ziel sei daher keine einmalige „Detox“-Kur, sondern ein Rahmen, um die Nutzung „langfristig kontrollierter zu gestalten“.

Technischer Flaschenhals zum Start

Erschwerend kommt aktuell ein stark restriktives System hinzu: Durch die Begrenzung auf das Betriebssystem iOS 18 bleiben der gesamte Android-Markt sowie Besitzer*innen älterer Apple-Geräte vorerst kategorisch ausgeschlossen. „Die aktuelle Einschränkung auf neuere iOS-Versionen hat vor allem technische Gründe“, verteidigt Yves diesen harten Schnitt. Einige NFC-Funktionen liefen auf älteren Systemen schlichtweg noch nicht stabil genug. Eine Android-Version sei geplant, befinde sich aber noch nicht in der Entwicklung.

Und was passiert, wenn man den rettenden Chip zu Hause vergisst und komplett blockiert ist? Yves beschwichtigt: Für solche Fälle gebe es eine Notfallfunktion in der App, die eine temporäre Entsperrung erlaube. Er verspricht: „Amba soll eine bewusste Hürde schaffen, aber keine Situation, in der Nutzer komplett von ihrem Smartphone abgeschnitten sind.“

Letztlich wandert das Kölner Start-up auf dem schmalen Grat zwischen Achtsamkeit und Deinstallation. Der Erfolg steht und fällt mit dem Hardware-Paradoxon: Nur wenn die Community den Schlüsselanhänger langfristig als befreiendes Werkzeug und nicht als frustrierende Barriere wahrnimmt, wird sich das subventionierte Abo-Modell gegen die Platzhirsche rentieren.

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

KI gegen Buchhaltungsriesen: Wie Bonster den Spesen-Markt aufmischen will

Pay-per-Use statt Abo-Falle: Das Oldenburger Start-up fast2work attackiert mit seiner App bonster komplexe Software-Giganten. Doch reicht das Versprechen maximaler Einfachheit im Haifischbecken der FinTechs? Wir haben nachgehakt.

Es ist eines der letzten großen Ärgernisse im Arbeitsalltag von Freelancer*innen und kleinen Agenturen: Der Freitagabend, der für das Sortieren verknitterter Tankbelege und das Abtippen von Bewirtungsbelegen in Excel-Listen draufgeht. Genau hier setzt die Oldenburger fast2work GmbH mit ihrer am 17. Februar 2026 gelaunchten App bonster an, um den Papierkram bei der Reisekostenabrechnung zu beenden. Das Versprechen von Gründer und CEO Ronald Bankowsky: Drei Minuten Aufwand, KI-Automatisierung und keine Einstiegshürden.

Das Versprechen: Simpel statt Systemintegration

Die Funktionsweise der App ist bewusst minimalistisch gehalten: Beleg fotografieren, woraufhin die KI relevante Werte wie Datum, Betrag und Mehrwertsteuer ausliest, auf Duplikate prüft und eine fertige Abrechnung erstellt. „Kein Onboarding-Projekt, kein Vertriebsgespräch, kein IT-Setup“, fasst Bankowsky den Ansatz der Standalone-Lösung zusammen.

Die Zielgruppe ist klar definiert: Selbständige, Freelancer*innen und Mini-Teams, denen Enterprise-Lösungen wie SAP Concur zu mächtig und Start-ups wie Circula oder Pleo oft noch zu prozesslastig sind. Mit einem Preismodell von 1,99 Euro für Einzelabrechnungen und 6,99 Euro (Stand Ende Febr. 2026) für eine Flatrate positioniert sich das Unternehmen im unteren Preissegment.

Im Haifischbecken der Neobanken und Buchhaltungsriesen

Laut fast2work gab es bislang „kaum eine Alternative zwischen Excel und Enterprise-Software“. Diese Aussage hält einem Realitätscheck im Jahr 2026 allerdings nur bedingt stand. Bonster betritt ein Haifischbecken, denn die vermeintliche Lücke wird längst geschlossen.

Zum einen integrieren Buchhaltungsriesen wie Lexoffice oder sevDesk Reisekosten-Features immer tiefer in ihre Standardpakete. Zum anderen wildern Neobanken wie Qonto, Finom oder Kontist im selben Revier: Wer dort ein Geschäftskonto hat, bekommt die Belegzuordnung oft als „Commodity“ gratis dazu. Mit knapp 7 Euro im Monat bewegt sich bonster in einer Preisregion, in der man fast schon eine komplette einfache Buchhaltungssoftware bekommt. Die App muss also einen enormen Mehrwert bieten, um gegen die „Eh-da-Lösungen“ (Software, die Kund*innen ohnehin bezahlen) zu bestehen.

Auf die Frage, warum Freelancer*innen für eine Insellösung extra zahlen sollten, entgegnet der Gründer, dass bonster bewusst früher ansetze als klassische Tools. Das Hauptproblem sei nicht die Buchhaltung, sondern das Erfassen von Belegen unterwegs. „Genau dort scheitert es oft, weil Mitarbeitende keine komplexen Systeme nutzen wollen oder gar keine Zugänge haben“, argumentiert Bankowsky. Der Mehrwert liege nicht in einer weiteren Buchhaltungssoftware, sondern darin, dass durch die Reduzierung auf ein Foto „überhaupt verwertbare Abrechnungsdaten/Belege entstehen“.

Kritische Faktoren: GoBD und Datensicherheit

Neben der Marktpositionierung ist die Rechtssicherheit ein kritischer Faktor. „Fertige Abrechnung für die Buchhaltung“ ist ein mutiges Versprechen, da in Deutschland ein Foto allein oft nicht ausreicht; es muss GoBD-konform und revisionssicher archiviert werden. Zudem ist die KI-Nutzung datenschutzrechtlich sensibel. Wenn Bewirtungsbelege, die offenbaren, mit wem man gegessen hat, über US-Schnittstellen (z.B. OpenAI) fließen, ist das für deutsche Geschäftskund*innen und Steuerberater oft ein K.O.-Kriterium.

Auf die sensiblen Vorgaben der Finanzämter und den Serverstandort angesprochen, betont Bankowsky, dass die Verarbeitung „ausschließlich auf europäischen Servern“ erfolge. Zwar nutze man OpenAI-basierte Modelle, diese liefen jedoch über Azure-Rechenzentren im europäischen Raum. Datenschutz und regulatorische Anforderungen seien Grundvoraussetzung. Auch beim Export zum Steuerberater zeigt sich der Gründer zuversichtlich: Buchhaltungssysteme könnten die Daten direkt und „ohne manuelle Nacharbeit“ weiterverarbeiten.

Beta-Test als Exklusiv-Club

Zum Start setzt das Unternehmen auf eine Gamification des Rollouts. Die ersten 500 Nutzer*innen erhalten im „Club 500“ einen lebenslangen Rabatt von 50 Prozent. Was als Belohnung für Early Adopters verkauft wird, ist strategisch notwendig: Die KI muss lernen. Der Algorithmus braucht dringend „Real World Data“ – echte, verknitterte, schlecht beleuchtete Belege. Das bedeutet auch: Die ersten User*innen sind Teil des Entwicklungsprozesses.

Dass die App im Alltag noch dazulernen muss, räumt Bankowsky ein. Bei der reinen Datenerkennung sei man technisch auf dem aktuellen Stand. „Entscheidend ist jedoch die Qualität realer Belege im Alltag – etwa schlecht fotografierte oder handschriftliche Quittungen“, erklärt er den Bedarf an Praxis-Feedback. Durch schnelle Updates solle die Genauigkeit für alle Nutzer*innen laufend steigen.

Gegenmodell zur Ökosystem-Abhängigkeit

Wer ein Feature-Feuerwerk suche, werde bei bonster enttäuscht sein – was laut Unternehmen aus Überzeugung geschehe. Anbieter wie Rydoo verfolgten eine Strategie der maximalen Integration und langfristiger Verträge, was eine Abhängigkeit erzeuge, die ihr eigentliches Geschäftsmodell sei, so der Gründer. Wer einmal im Ökosystem stecke, wechsle nicht mehr, weil der Ausstieg zu teuer geworden sei.

Bonster positioniert sich als Gegenmodell für Unternehmen, die nicht für ungewollte Komplexität zahlen möchten: Kein Vertrag, keine Mindestnutzerzahl, Setup in unter fünf Minuten und ein Pay-per-Use-Modell. „Wer aufhören will, hört auf, ohne Konsequenzen“, beschreibt das Start-up den Ansatz der bewussten Entscheidung, Kund*innen freizulassen. Wer bleibe, tue dies, weil es funktioniere, was laut Bankowsky „die interessantere Innovation“ sei.

Fazit

Bonster ist ein innovativer Angriff auf die Zettelwirtschaft und wirkt durch den Verzicht auf starre Abo-Modelle bei der Einzelabrechnung fair. Doch die App steht und fällt mit der Schnittstellenkompetenz. Wenn der Export zu DATEV & Co. hakt, wird aus der Zeitersparnis schnell Mehrarbeit. Bonster muss beweisen, dass es die Brücke zwischen dem schnellen Foto und der strengen deutschen Buchhaltung schlagen kann – und zwar besser als die Banken, die das Feature bereits kostenlos anbieten.

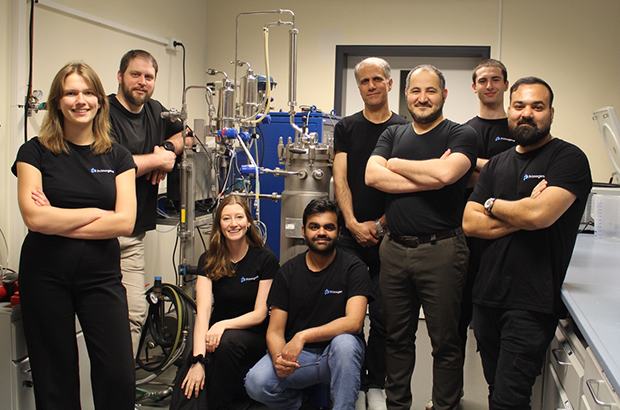

Primogene: Muttermilch als Vorbild

Primogene ist ein 2023 gegründetes BioTech-Start-up mit Sitz in Leipzig, das sich auf die Entwicklung biotechnologischer Herstellungsverfahren für bioidentische Inhaltsstoffe spezialisiert hat. Ein Schwerpunkt liegt auf Verbindungen, die der Muttermilch nachempfunden sind und die Gesundheit in allen Lebensphasen fördern können.

Auch wenn das Produkt als weißes Pulver eher unscheinbar aussieht, markiert seine Existenz einen wissenschaftlichen Meilenstein. „Wir haben eine spezielle Technologie entwickelt, dank der wir komplexe bioidentische humane Milchzucker skalierbar herstellen können“, erzählt Linda Karger, einst Managementstudentin an der Technischen Universität in München, heute COO der 2023 in Leipzig gegründeten Primogene GmbH. Die chemischen Verbindungen entsprechen also den im menschlichen Körper vorkommenden Molekülen bis ins kleinste biochemische Detail. Und sie übernehmen – obwohl industriell hergestellt – die gleichen Funktionen, die bisher nur Muttermilch garantierte.

Zum Verständnis: Die komplexen Zuckerstrukturen sind nach Fett und Laktose der drittgrößte feste Bestandteil menschlicher Milch. Sie bieten einzigartige gesundheitliche Vorteile, unterstützen beispielsweise das Immunsystem sowie die kognitive Entwicklung wie kein anderer Stoff. „Nach zahllosen Gesprächen mit Ärzten und Kliniken begann unsere Geschichte mit der Idee, nährstoffreiche Inhaltsstoffe als Zusatz für die Ernährung von Frühgeborenen herzustellen. Weitergedacht können bioaktive Bestandteile der Muttermilch ebenso zur Krankheitsprävention bei Erwachsenen sinnvoll eingesetzt werden“, erklärt Karger. „Um das Wirkungspotenzial unserer Human Milk Oligosaccharides (HMO) weiter zu erforschen, testen wir diese aktuell in enger Zusammenarbeit mit dem Leipziger Fraunhofer-Institut für Zelltherapie und Immunologie.“

Produktsortiment in der Breite offen

Gleichzeitig wird die von Dr.-Ing. Reza Mahour (CEO, Experte für Bioverfahrenstechnologie) und Valerian Grote (CTO, Molekularbiologe/Experte für Analytische Biochemie) entwickelte enzymatische Technologie genutzt, um bioidentische Moleküle für andere Märkte zu erzeugen, beispielsweise Inhaltsstoffe für Produkte der Körperpflege oder Rohmaterialien für die Pharmaindustrie. „Wir produzieren selbst. Dabei lässt sich jedes unserer Produkte auf die spezielle Technologie zurückführen. Unseren Kunden bieten wir Komplettlösungen – das reicht von der Suche nach der richtigen Produktionsplattform bis hin zu Entwicklung und Produktion“, bestätigt Karger. Erste Umsätze wurden nach ihren Angaben bereits früh erzielt. Inhaltsstoffe für den Kosmetikbereich sollen noch in diesem Jahr mithilfe bestehender Partnerschaften am Markt eingeführt werden. Im Pharmabereich wird ebenfalls mit ersten Kunden zusammengearbeitet.

Karger ergänzt: „Wir haben früh auf Partnerschaften und Vorbestellungen gesetzt, um den Markt besser zu verstehen.“ Um die bereits verabredeten hochwertigen Roh- und Inhaltsstoffe bald in größeren Mengen liefern zu können, ist das aktuell elfköpfige Team von Primogene gerade innerhalb Leipzigs umgezogen. Für die anstehende Skalierung war der Wechsel auf eine Betriebsstätte mit mehr Laborfläche und größerem Produktionsbereich wichtig. Große Mitspieler auf dem Feld der HMOs wie die niederländische DSM-Firmenich oder der dänische Konzern Chr. Hansen schrecken Karger nicht: „Bekannt sind mehr als 200 verschiedene HMOs, davon sind bisher sieben strukturell einfacher industriell herstellbar und auf dem Markt. Sie werden mit einer Fermentationstechnologie produziert. Unser enzymatisches Verfahren kann deutlich mehr und komplexere Zuckerstrukturen hervorbringen. Außerdem reicht unsere Produktpalette weit über HMOs hinaus.“

Sichtbarkeit durch Innovationsplattform futureSax erleichtert Investorensuche

Das bisher benötigte Kapital stammt unter anderem von Business Angels aus dem Bereich der Biotechnologie, darunter auch Climate Founders, bei deren Accelerator-Programm Mahour Grote und Karger einst zusammenfanden. Für Primogene als forschungs- und deshalb kapitalintensives Biotech-Unternehmen sind daneben die Mittel aus Förderprogrammen des Landes Sachsen und der Stadt Leipzig von wesentlicher Bedeutung. Darüber hinaus profitiert das Start-up noch heute von der Sichtbarkeit, die es durch den Gewinn des dritten Platzes beim Sächsischen Gründerpreis 2024 erhielt. Zunächst sorgten der professionelle Nominiertenfilm und die begleitende Öffentlichkeitsarbeit von futureSax für Aufmerksamkeit sowohl in den Medien als auch innerhalb des Netzwerks.

Dann bot die Preisübergabe auf der Sächsischen Innovationskonferenz vor über 1.000 Gästen Primogene eine wichtige Gelegenheit zur Präsentation. „Sachsen ist ein Innovationsstandort mit besonderer Dichte: Exzellente Forschung, starke Industrie- und Mittelstandsstrukturen und eine wachsende Start-up-Szene greifen ineinander. Hier entstehen Lösungen, die international wettbewerbsfähig sind. Entscheidend ist der Schulterschluss im Ökosystem – von Hochschulen über Unternehmen bis zu Kapitalgebern. futureSax schafft dafür die Bühne und die Verbindungen, damit aus Ideen schneller Produkte, Partnerschaften und Gründungen werden“, erklärt Susanne Stump, Geschäftsführerin der Innovationsplattform des Freistaats Sachsen. Das Interesse großer Investoren bestätigt, dass Primogene auf dem richtigen Weg ist. Im Jahr 2025 schloss das innovative Start-up eine Seed-Finanzierungsrunde mit namhaften Investoren wie HTGF, TGFS, der Sächsischen Beteiligungsgesellschaft und better ventures ab. Das geplante Personalwachstum sowie die Produktionsaktivitäten der nächsten zwei Jahre sind damit gesichert.

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen: https://t1p.de/p8gop

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

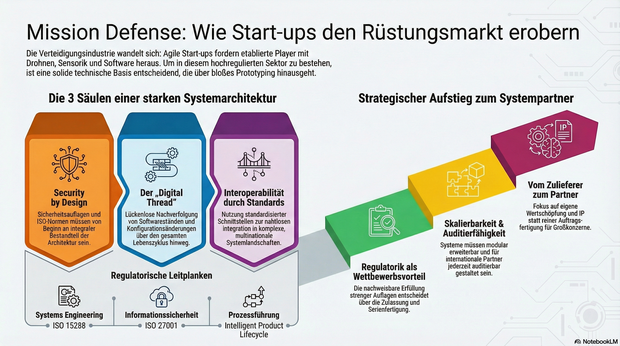

Mission Defense: Wie Start-ups im rüstungstechnischen Markt Fuß fassen

Immer mehr Start-ups drängen mit agilen Innovationen in die hochregulierte Verteidigungs- und Luftfahrtindustrie. Daher gut zu wissen: Wie junge Unternehmen durch die richtige Systemarchitektur die strengen Auflagen meistern und vom Zulieferer zum echten Systempartner aufsteigen.

Die Luft- und Raumfahrt sowie die Verteidigungsindustrie zählen zu den am stärksten regulierten und technologisch anspruchsvollsten Märkten der Welt. Lange galt: Wer hier mitspielen will, braucht jahrzehntelange Erfahrung, Milliardenbudgets und stabile Regierungsbeziehungen. Doch genau dieses Bild verschiebt sich.

Neue Player treten auf den Plan: Start-ups entwickeln Trägersysteme, Drohnenplattformen, Kommunikationslösungen oder Sensorik, und tun das in einer Geschwindigkeit, die vielen etablierten Anbietern Kopfzerbrechen bereitet. Die zentrale Frage lautet deshalb: Wie können junge Unternehmen in einer hochregulierten Branche nicht nur überleben, sondern mitgestalten?

Agilität als Superkraft – aber Prototypen reichen nicht

Ob neue unbemannte Plattformen, Software-Defined Defense Systeme oder taktische Kommunikation – überall gilt: Was heute entwickelt wird, muss morgen schon einsatzbereit sein. Der Bedarf an schneller Innovation ist nicht theoretisch, sondern operativ. Start-ups sind in der Lage, auf diesen Druck zu reagieren, mit kurzen Entscheidungswegen, agilen Teams und digitaler DNA.

Allerdings reichen gute Ideen und schnelles Prototyping nicht aus. Wer Systeme für den operativen Einsatz liefern will, muss Anforderungen erfüllen, die weit über funktionierende Technik hinausgehen: Cybersicherheit, regulatorische Nachvollziehbarkeit, Zertifizierungsfähigkeit und Interoperabilität mit internationalen Partnern.

Das Fundament: Die Systemarchitektur entscheidet

Von Anfang an auf die richtigen technischen Grundlagen zu setzen, ist entscheidend. Das betrifft vor allem drei Bereiche: Skalierbarkeit, Nachvollziehbarkeit und Interoperabilität. Systeme müssen so gebaut sein, dass sie modular erweitert, in komplexe Systemlandschaften integriert und nach internationalen Standards auditiert werden können.

Ein durchgängiger digitaler Entwicklungs- und Betriebsfaden, ein sogenannter Digital Thread oder auch Intelligent Product Lifecycle, ermöglicht es, Produktdaten, Softwarestände und Konfigurationsänderungen über den gesamten Lebenszyklus hinweg zu verfolgen. Für die Zulassung softwaredefinierter, sicherheitskritischer Systeme ist das ebenso essenziell wie für die spätere Wartung, Upgrades oder die Einbindung in multinationale Operationen.

Security by Design: Sicherheit lässt sich nicht nachrüsten

Verteidigungsnahe Produkte unterliegen Exportkontrollen, Sicherheitsauflagen und branchenspezifischen Normen, darunter etwa ISO 15288 für Systems Engineering, ISO 27001 für Informationssicherheit oder die europäischen Anforderungen für Luftfahrt und Raumfahrt. Diese Vorgaben lassen sich nicht einfach „nachrüsten“. Sie müssen von Beginn an ein integraler Bestandteil der Systemarchitektur und Prozessführung sein.

Gerade in sicherheitskritischen Bereichen ist die Fähigkeit, regulatorische Anforderungen nachweislich zu erfüllen, ein entscheidender Wettbewerbsvorteil. Sie entscheidet darüber, ob ein Produkt zugelassen, in Serie gefertigt und in multinationale Programme integriert werden kann.

Interoperabilität als Schlüssel zum Teamplay

Ein weiterer kritischer Faktor ist die Fähigkeit zur Kooperation. In den meisten großen Programmen arbeiten unterschiedliche Unternehmen, oft aus verschiedenen Ländern, mit unterschiedlichen Systemen zusammen. Wer hier bestehen will, muss in der Lage sein, mit standardisierten Schnittstellen, interoperablen Plattformarchitekturen und harmonisierten Datenmodellen zu arbeiten. Interoperabilität ist dafür die technische Grundlage. Ohne sie lassen sich Systeme weder integrieren noch gemeinsam weiterentwickeln.

Vom Zulieferer zum echten Systempartner

Start-ups, die sich diesen Anforderungen stellen, können mehr sein als Zulieferer. Sie haben das Potenzial, Systempartner zu werden: mit eigener Wertschöpfung, eigenem IP und eigenem Einfluss auf die technologische Entwicklung. Der Weg dorthin ist anspruchsvoll, aber offen. Er erfordert keine hundertjährige Firmengeschichte, sondern eine klare Architekturstrategie, ein tiefes Verständnis für regulatorische Anforderungen und den Willen, komplexe Systeme systematisch zu entwickeln.

Der Verteidigungs- und Luftfahrtsektor steht an einem Wendepunkt. Wer heute die richtigen Grundlagen legt, kann morgen zu denjenigen gehören, die nicht nur mitlaufen, sondern die Spielregeln neu definieren.

Der Autor Jens Stephan, Director Aerospace & Defence bei PTC, bringt über 20 Jahre Erfahrung im Bereich komplexer Software-/SaaS-Lösungen und IT-Infrastruktur mit.

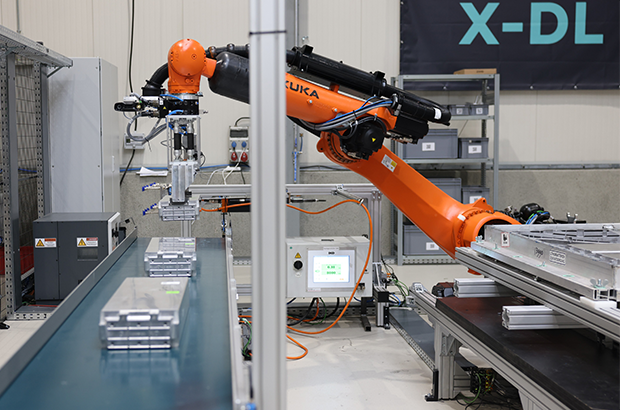

ChatGPT schreibt Texte. R3 Robotics zerlegt Batterien

Es gibt Probleme, die man mit Software lösen kann, und es gibt Probleme, für die man sich die Hände schmutzig machen muss – oder besser: Roboterhände nutzt. Antoine Welter und Dr. Xavier Kohll haben mit Circu Li-ion begonnen, um Batterien zu retten. Jetzt, unter dem neuen Namen R3 Robotics und mit 20 Millionen Euro frischem Kapital im Rücken, treten sie an, um den wohl größten Flaschenhals der kommenden Mobilitätswende zu beseitigen. Ihr Ansatz: Keine teuren Spezialmaschinen, sondern intelligente Standard-Roboter, die sehen, verstehen und sicher zupacken.

Wenn in den Vorstandsetagen der Automobilhersteller über die Zukunft gesprochen wird, geht es meist um Reichweiten und Software-Defined Vehicles. Doch am anderen Ende der Wertschöpfungskette braut sich ein Sturm zusammen. Millionen von Elektrofahrzeugen werden in den kommenden Jahren ihr Lebensende erreichen. Die derzeitige Realität in vielen Recyclinghöfen wirkt dagegen fast archaisch: Menschen, die mit Handwerkzeugen komplexe Systeme auseinanderschrauben. Das ist nicht nur teuer und schwer skalierbar, sondern bei Hochvolt-Systemen auch lebensgefährlich.

Genau hier setzen Antoine Welter und Xavier Kohll an. Die Nachricht, die das deutsch-luxemburgische Unternehmen Anfang Februar 2026 verkündete, ist mehr als nur eine Finanzierungsrunde. Die 20 Millionen Euro – aufgeteilt in 14 Millionen Euro Series-A-Kapital und 6 Millionen Euro öffentliche Fördergelder – heben die Gesamtfinanzierung des Unternehmens auf ein neues Level. Angeführt wird die Runde von HG Ventures und Suma Capital, unterstützt von Co-Investoren wie der Oetker Collection und dem EIC Fund.

Doch das Geld ist nur der Treibstoff für eine strategische Evolution. Aus Circu Li-ion wird R3 Robotics. Der neue Name ist Programm: Repair, Reuse, Recycle. Antoine Welter erklärt die Motivation hinter der Umbenennung pragmatisch: „Circu Li-ion hat beschrieben, wo wir angefangen haben. R3 Robotics beschreibt, was wir aufbauen: industrielle Robotik, die Demontage skalierbar, sicher und kosteneffizient macht.“

Wenn der Roboter Augen bekommt

Die größte Hürde im Recycling ist nicht die Chemie, sondern die Variabilität. Kein Batteriepack gleicht dem anderen, E-Motoren sind unterschiedlich verbaut, Schrauben sind korrodiert. Starre Fertigungsstraßen scheitern hier. R3 Robotics löst dies mit einer Plattform, die Computer Vision, künstliche Intelligenz und Robotik verschmilzt.

Das System fungiert dabei fast wie ein „ChatGPT für die physische Welt“: Anstatt Text zu generieren, plant die KI physische Handlungen. Sensoren scannen das Bauteil, die KI erkennt den Zustand und promptet den Roboterarm dynamisch durch den Demontageprozess. Der entscheidende Vorteil: Der Mensch wird aus der Gefahrenzone der Hochspannung genommen, während der Roboter Aufgaben erledigt, die für klassische Automatisierung zu komplex wären.

Angesprochen auf den Vergleich mit Generative AI und die Frage, wie die Roboter tatsächlich „sehen“ und „entscheiden“, bestätigt Welter die Parallele: „Der Vergleich mit Generative AI passt gut: Das Modell bekommt einen Input – keinen Text, sondern einen Scan des Bauteils – und generiert daraus eine Handlungssequenz.“ Es gehe darum zu erkennen, um welches Modell es sich handelt, wie der Zustand ist und wo die Verbindungspunkte liegen. „Das klingt simpel, ist es aber nicht – kein Pack ist identisch“, so Welter. Die eigentliche Herausforderung liege jedoch in der Entscheidung davor: „Welche Reihenfolge ist sicher? Ein falscher Griff an ein Hochvoltsystem kann tödlich sein. Unser System sieht, bewertet und entscheidet.“

Smart Hardware: Warum das Rad neu erfinden?

Ein Detail, das Investor*innen besonders aufhorchen lässt, ist die Kapitaleffizienz der Gründer. Wer an Industrie-Robotik denkt, denkt an teure Hardware-Entwicklung. R3 Robotics geht einen pragmatischen Weg: Ein Großteil der verwendeten Hardware wird „von der Stange“ gekauft.

Die Roboterarme sind Standardprodukte. Die Innovation – und damit das geistige Eigentum – steckt in den spezialisierten „End-Effektoren“ (den Roboterhänden), den Sensorsystemen und vor allem dem Software-Stack, der alles steuert. Das erlaubt eine Skalierung, die mit proprietärer Hardware kaum möglich wäre. Mitgründer Dr. Xavier Kohll betont, dass dies eine bewusste Entscheidung gegen „Over-Engineering“ war: „Der Roboterarm ist Standard und die Intelligenz sitzt in den Endeffektoren, der Sensorik und dem Software-Stack, der alles zusammenbringt. Das ist unser geistiges Eigentum, und genau das lässt sich skalieren.“

David gegen Goliath – oder Partner?

Während große Recycling-Konzerne oft noch auf den Schredder setzen und die manuelle Demontage an ihre Grenzen stößt, positioniert sich R3 Robotics in einer neuen Nische. Es geht nicht darum, die Chemie-Giganten zu ersetzen, sondern ihnen den Rohstoff so rein wie möglich zu liefern – als strategische Quelle für kritische Materialien. Doch der Markt schläft nicht: Weltweit entstehen Initiativen zur Automatisierung.

Trotz des aktuellen „Gegners“ – dem Menschen mit dem Schraubenzieher – und potenzieller Konkurrenz durch Tech-Start-ups oder Autohersteller, bleibt Welter gelassen. „Wir konkurrieren nicht mit den Chemie-Giganten, wir liefern ihnen den reinsten möglichen Stoffstrom“, stellt er klar. Gegenüber potenziellen Nachahmern sieht er einen entscheidenden Vorteil, den „Unfair Advantage“: die Kombination aus Flexibilität und industrieller Automatisierungstiefe. „Wir sind aktuell die einzige Plattform, die sowohl Variabilität managt als auch für kontinuierlichen Industriebetrieb ausgelegt ist.“

Deutschland als Labor, USA als Skalierungsmarkt

Die Wachstumsstrategie von R3 Robotics ruht auf zwei massiven Säulen: technologischer Tiefe in Europa und kommerzieller Breite in den USA.

Deutschland fungiert dabei als das technologische Rückgrat. Mit der Erweiterung der Anlage in Karlsruhe zur Lighthouse Facility demonstriert das Unternehmen industrielle Leistungsfähigkeit direkt vor der Haustür der großen Autobauer. Hier wird die Technologie gehärtet. Das zeigt sich auch im Leuchtturmprojekt ReDriveS, wo R3 Robotics Seite an Seite mit Giganten wie Schaeffler und VW an der Demontage von E-Achsen arbeitet.

Doch für das massive Volumen blickt das Team über den Atlantik. Der für 2026 geplante Markteintritt in den USA ist Kern der neuen Strategie. Die frischen 20 Millionen Euro sollen gezielt in den Aufbau strategischer Partnerschaften vor Ort fließen, um die Technologie dort auszurollen, wo Pragmatismus auf riesige „End-of-Life“-Volumina trifft. Für Welter ist dieser Doppelschlag essenziell: „Deutschland ist unser Beweisstand. Hier zeigen wir Schaeffler, VW und Co., dass unsere Technologie industriellen Maßstäben in Deutschland standhält.“ Die USA seien hingegen der wichtige Skalierungsmarkt, wo pragmatische Entscheider auf gigantische Volumina treffen. „Beides brauchen wir: die Glaubwürdigkeit aus Europa und das Volumen aus Amerika.“

Industrialisierung statt Romantik

Mit Peter Mohnen, dem ehemaligen CEO des Roboter-Riesen KUKA, holte sich das Start-up zudem einen Beirat, der wie kaum ein anderer weiß, was Industriestandard bedeutet. Er beschreibt den Ansatz von R3 als Beweis für die nötige Automatisierungsexpertise, um Variabilität und Sicherheit gleichzeitig zu managen.

Um diese Expertise weiter auszubauen, wächst das Team rasant. Die Belegschaft soll mit der neuen Finanzierung massiv aufgestockt werden, vor allem im Bereich Engineering und KI. R3 Robotics hat den Beweis erbracht, dass Kreislaufwirtschaft kein ökologisches Nischenprojekt sein muss, sondern ein harter industrieller Prozess ist, der sich rechnet.

Denn letztlich, so das Fazit von Antoine Welter, sei Automatisierung der einzige Weg, das Problem wirklich zu lösen – nicht allein aus ökologischen Gründen, sondern weil es wirtschaftlich Sinn ergibt. „Was wir aufbauen, ist am Ende ein harter industrieller Prozess: Er muss zuverlässig funktionieren und sich rechnen.“ Es gehe aber um mehr als ein Geschäftsmodell: „Europa braucht eine Antwort auf die Frage, woher seine kritischen Materialien in Zukunft kommen“, mahnt Welter abschließend. „Wenn Europa diesen Zugang sichern will, braucht es Unternehmen, die genau das industriell umsetzen können. Dafür bauen wir diese Infrastruktur, und mit dem neuen Kapital und Team haben wir jetzt die Mittel dazu.“

Rouge: Vom Tabu zum Geschäftsmodell

Die Menstruation ist ein Milliardenmarkt – und dennoch oft unsichtbar. Das von Tina Frey und Patrick Gsell gegründete Start-up Rouge bricht mit diesem Muster. Was Ende 2022 als Vision in der Schweiz begann, hat sich durch geschickte Positionierung und Expansion nach Deutschland zu einem ernstzunehmenden Player im FemTech-Bereich entwickelt.

Die Grundidee von Rouge ist so simpel wie strategisch klug: Statt die Menstruation zu verstecken, wird sie zum sichtbaren Lifestyle-Element. „Mich hat fasziniert, wie sehr die Menstruation unseren Alltag beeinflusst und wie konsequent wir trotzdem darüber schweigen“, erklärt Mitgründerin Tina Frey. „Bald wurde mir klar: Das ist ein gesellschaftliches Problem.“ Dass dieser Ansatz einen Nerv trifft, zeigt der rasche Aufstieg des Unternehmens. Durch gezielte Medienarbeit gelang es dem Team, das Thema aus der Nische in den Mainstream zu heben – Tina Frey positioniert sich dabei konsequent nicht nur als Unternehmerin, sondern als Expertin für Frauengesundheit.

Differenzierung im "Red Ocean"

Im Zentrum der Marke steht der Rouge-Drink, ein Pulver-Supplement mit Eisen, Vitamin B12 und Granatapfel. Doch der eigentliche USP liegt nicht in den Inhaltsstoffen, sondern in der Inszenierung. Die transparente Flasche mit der roten Flüssigkeit fungiert als bewusstes „Statement-Piece“.

Hier gelingt dem Start-up ein entscheidender Schachzug im wachsenden Markt für Zyklusgesundheit: Während Wettbewerber wie FEMNA oder MYLILY auf funktionale Nahrungsergänzung in diskreter Kapselform setzen, inszeniert Rouge die Einnahme als genussvollen Wellness-Moment. Gleichzeitig emanzipiert sich das Duo von den „lauten“ Tabubrechern der Branche wie The Female Company: Rouge setzt weniger auf Provokation durch Hygieneartikel, sondern transformiert die Linderung von Regelbeschwerden von einer medizinischen Notwendigkeit in eine „ästhetische Selbstverständlichkeit“.

„Sichtbarkeit verändert Verhalten“, so Tina Frey. „Die Flasche macht den Zyklus im Alltag sichtbar und löst Gespräche aus. Noch wichtiger: Viele Frauen erleben dadurch eine neue Selbstverständlichkeit und mehr Selbstbewusstsein.“ Dieser Social-Impact-Gedanke ist fest im Geschäftsmodell verankert: Ein Teil der Erlöse fließt in Aufklärungsprojekte. „Sozialer Impact ist kein Marketing-Trick, sondern eine Notwendigkeit“, ergänzt Co-Founder Patrick Gsell. „Gleichzeitig braucht es wirtschaftliche Stabilität, um langfristig bestehen zu können.“

Diverse Kompetenzen als Wachstumstreiber

Hinter der Marke steht ein komplementäres Gründungs-Duo. Tina Frey bringt als Marketing-Expertin das kommunikative Rüstzeug mit, während Patrick Gsell – seit über 20 Jahren Geschäftsführer eines Softwareunternehmens – die strategische Struktur und Skalierungserfahrung liefert. Patrick Gsell, der 2022 den Bund-Essay-Preis gewann, liefert zudem den intellektuellen Unterbau. „Die Hälfte der Menschheit erlebt die Menstruation. Trotzdem betrifft sie die ganze Gesellschaft und nicht zuletzt das Verständnis zwischen Mann und Frau. Genau deshalb finde ich es so spannend, mit Rouge am Anfang eines gesellschaftlichen Wandels zu stehen“, so Patrick Gsell.

Expansion mit lokaler Strategie

Nach der Etablierung auf dem Schweizer Heimatmarkt erreichte Rouge im Herbst 2025 den nächsten Meilenstein: den Markteintritt in Deutschland. Anders als bei reinen Export-Modellen setzt das Start-up hierbei auf lokale Strukturen und Partner vor Ort. „Der deutsche Markt bietet großes Potenzial, aber jede Gesellschaft tickt anders“, begründet Tina Frey den Schritt. Das Ziel bleibt grenzüberschreitend gleich: Die Menstruation soll kein Nischenthema bleiben, sondern als normaler Teil der weiblichen Gesundheit akzeptiert werden – sichtbar gemacht durch eine rote Flasche, die den Dialog eröffnet.

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

Europa kann KI!

Was wir von den besten EU-AI-Companies lernen können, erläutert KI-Experte Fabian Westerheide.

Europa muss sich bei KI nicht kleinreden. Wir sehen gerade sehr deutlich: Aus Europa heraus entstehen Unternehmen, die Kategorien besetzen – und dann auch das große Kapital anziehen. Beispiele gibt es genug: Mistral AI, DeepL, Black Forest Labs, Parloa, Helsing, Lovable oder n8n.

Ich schreibe das aus drei Blickwinkeln: als Investor (AI.FUND), als Konferenz-Initiator (Rise of AI Conference) und als Autor von „Die KI-Nation“. Was du hier bekommst, ist kein „Europa-hat-ein-Problem“-Essay – sondern eine Analyse plus ein Execution-Set an Empfehlungen, das du direkt auf dein Start-up übertragen kannst.

Die Realität: Seed geht oft – Scale ist das Spiel

Am Anfang brauchst du selten „zu viel“ Geld. MVP, erste Kunden, Iteration: Das klappt in Deutschland in vielen Fällen mit Seed. Die echte Trennlinie kommt später – wenn du aus einem starken Start-up einen Kategorie-Gewinner bauen willst.

Denn KI ist zunehmend Winner-takes-most. Und das gilt auch fürs Kapital: In vielen Fällen ist die Growth-Finanzierung in den USA grob 25-mal größer – bei den aktuellen Front-Runnern (Modelle, Infrastruktur, Distribution) wirkt es teilweise wie 100-mal, weil Kapital sich auf die vermuteten Sieger stapelt. (Nicht „fair“, aber Marktmechanik.)

Die gute Nachricht: Genau die EU-Vorbilder oben zeigen, dass du das nicht wegdiskutieren musst – du musst es exekutieren.