Aktuelle Events

KI für echte Nachhaltigkeit

Wie künstliche Intelligenz (KI) bei der Nachhaltigkeitstransformation helfen kann.

Wie nur wenige andere Technologien ist künstliche Intelligenz von geradezu magischen Versprechungen umgeben, die sich gut in die seit Langem bestehende Erzählung von der bevorstehenden digitalen Revolution einfügen, die durch ein scheinbar aktuelles Zitat von Hubert L. Dreyfus beschrieben wurde: „Jeden Tag lesen wir, dass digitale Computer Schach spielen, Sprachen übersetzen, Muster erkennen und bald in der Lage sein werden, unsere Arbeit zu übernehmen. In der Tat scheint dies heute ein Kinderspiel zu sein.“ Die Tatsache, dass das Zitat aus dem Jahr 1972 stammt, zeigt, wie notwendig eine nuancierte Analyse des KI-Bereichs ist.

Ursprünglich bezog sich der Begriff KI auf ein Gebiet der Informatik, das zunächst den trockenen Namen Automatentheorie trug. Die Informatiker John McCarthy und Marvin Minsky waren jedoch der Meinung, dass der Begriff Artificial Intelligence (Deutsch: künstliche Intelligenz) passender wäre, vor allem im Hinblick auf die Popularität und Finanzierbarkeit des Fachgebiets, und benannten es anlässlich eines Workshops im Jahr 1955 entsprechend um.

KI ist keine eigenständige Technologie, sondern ein vielschichtiger Bereich innerhalb der Informatik. Lange Zeit stellten KI-Systeme Wissen explizit dar oder „symbolisierten“ es, indem sie logische Schlussfolgerungen und Entscheidungsbäume ermöglichten. Diese symbolischen Ansätze ermöglichen formale Schlussfolgerungen wie „alle süßen Dinge sind klebrig und Marmelade ist süß, also ist Marmelade klebrig“.

In den 1980er-Jahren kamen die sogenannten subsymbolischen Ansätze auf, wie künstliche neuronale Netze (ANN), genetische Algorithmen oder andere statistische und heuristische Annäherungen. Diese Ansätze erfordern eine Vorkonfiguration mit großen Datenmengen in vielen Iterationen, die oft als Training bezeichnet werden und bei denen das Wissen nur implizit repräsentiert wird und schwer zu überprüfen ist. Aktuelle Bilderkennungs- und große Sprachmodelle sowie Übersetzungssysteme arbeiten auf diese Weise.

Starke, schwache und Zeitgeist-KI

In der akademischen KI-Diskussion werden gewöhnlich zwei Arten von KI unterschieden: starke KI und schwache KI. Ich möchte jedoch einen dritten Typus hinzufügen, den ich Zeitgeist-KI nenne. Starke KI, auch bekannt als Artificial General Intelligence (AGI), bezieht sich auf ein System, das über eine allgemeine und flexible Intelligenz verfügt, Fragen stellen kann und echte Kreativität, vielleicht sogar Bewusstsein, aufweist. Ein solches System könnte eigenständig handeln, hätte möglicherweise eigene Ziele und müsste daher die Verantwortung für sein Handeln übernehmen. Diese Art von KI existiert nur im Bereich der Science-Fiction, und in der technischen KI-Forschung gibt es keine Anzeichen dafür, dass sich dies in absehbarer Zeit ändern wird.

Schwache KI, auch als Artificial Narrow Intelligence (ANI) bekannt, bezieht sich auf ein System, das nur eng definierte, hoch spezialisierte und domänenspezifische Aufgaben ausführen kann. Es kann nicht die Domäne wechseln oder eigene Ziele setzen; es ist ein Werkzeug, wenn auch ein sehr komplexes. Zu dieser Kategorie gehören Systeme, die Muster erkennen (visuelle und akustische Objekterkennung oder Datenanalyse wie die Optimierung der Ressourcennutzung, z.B. des Strom- und Wasserverbrauchs) oder automatisch andere domänenspezifische Aufgaben mit klaren Zielen ausführen (z.B. Go spielen, abgeleitete Texte oder Bilder produzieren). Alle aktuellen KI-Systeme fallen in diese Kategorie, einschließlich der aktuellen großen Sprachmodelle.

Drittens möchte ich Zeitgeist-KI als ein diskursives Phänomen definieren, bei dem sich politische, gesellschaftliche und sogar akademische Akteure auf KI beziehen, obwohl sie eigentlich alles meinen, was mit komplexen digitalen Technologien wie Algorithmen, Big Data, Software, Programmen, Computersystemen, Automatisierung, IT, tatsächlicher KI, Statistik und sogar Digitalisierung im Allgemeinen zu tun hat. Mit einem derart vagen KI-Konzept sind ernsthafte und fruchtbare KI-Debatten schwierig, weshalb sie regelmäßig eingedämmt werden müssen.

Präzise Sprache

Darüber hinaus ist bei der Wahl der Sprache für die Diskussion über KI große Vorsicht geboten, da viele der vorherrschenden Fachbegriffe historisch gesehen auf menschliche Tätigkeiten und Fähigkeiten verweisen, aber nicht als Analogien verstanden werden sollten. Die Begriffe handeln, entscheiden, erkennen, verstehen, (selbst)lernen, wissen, trainieren, Autonomie, vorhersagen und sogar Intelligenz sind höchst irreführend. Falsche Begriffe wecken falsche Assoziationen, schüren unbegründete technologische Fiktionen und implizieren unsinnige oder sogar (gesellschaftlich) schädliche Anwendungen. Geeignete Begriffe wurden vorgeschlagen, z.B. bewegen, ausführen, erkennen, den Erwartungen entsprechen, dynamische Konfiguration, Daten/Information, Vorkonfiguration, Automatisierung, Projektion und komplexe Daten/Informationsverarbeitung. Solche Begriffe sind besonders in interdisziplinären Kontexten oder in der Wissenschaftskommunikation relevant.

Was KI nicht gut kann

KI-Systeme können bestimmte Aufgaben effektiv erledigen, für die klare Regeln, geeignete Modelle, spezifische Ziele und geeignete Daten zur Verfügung stehen. Zu diesen Aufgaben gehören die vorausschauende technische Wartung (z.B. für rotierende Teile), die Optimierung des Ressourcenverbrauchs (z.B. Wasserverbrauch in der Landwirtschaft, Energieverbrauch in Rechenzentren), Sprach-/Bilderkennung (z.B. Sprache, Landmarken und Tiere) und Sprach-/Bildsynthese. Darüber hinaus kann KI eingesetzt werden, um beliebige Daten nach Mustern zu durchsuchen (Kompartimentierung, Clustering usw.). Es gibt auch beeindruckende generative KI-Anwendungen in den Bereichen Bild, Sprache und Musik, aber sie lösen keine spezifischen Aufgaben und haben bisher nur explorativen Wert.

Viele der Eigenschaften, die der KI zugeschrieben werden, sind oft klassische Methoden der Informatik, gerade Zeitgeist-KI oder auch nur menschliche Arbeit im globalen Süden. Doch um das Potenzial von KI richtig zu diskutieren, müssen wir differenzieren, wovon wir sprechen. Zwei aufschlussreiche Beispiele:

1. Der Kern des automatisierten Fahrens (AD) ist nicht KI, da KI bisher nur für die Bilderkennung (z.B. Verkehrszeichenerkennung) zuständig ist, der Rest ist keine KI. Daher würde die Finanzierung von KI nicht unbedingt AD verbessern.

2. KI-Systeme können per se keine Prognosen erstellen. Was KI leisten kann, ist die statistische Analyse vergangener Daten und die daraus resultierende Berechnung einer mathematischen Prognose. Ob das berechnete Ergebnis eine sinnvolle Vorhersage ist, hängt jedoch stark vom Themenbereich ab. Wetterdaten unterscheiden sich grundlegend von sozialen Daten. Daher funktionieren „Vorhersagen“ im sozialen Bereich nur, wenn eine soziale Physik angenommen wird, was in Theorie und Praxis höchst umstritten ist. Nicht nur im Bereich der Kriminalität, z.B. bei der vorausschauenden Polizeiarbeit oder der Rückfallprognose, sind solche Vorhersageversuche im Allgemeinen gescheitert. Bevor wir also KI anwenden können, müssen wir den betreffenden Bereich erst einmal verstehen.

Selbst wenn der Bereich mathematisch gut verstanden ist, wollen wir als Gesellschaft oft nicht einmal korrekte „unvoreingenommene“ Vorhersagen auf der Grundlage der Vergangenheit als Grundlage für unser Handeln treffen. Eine rein mathematisch begründete Kreditvergabe auf der Grundlage des Einkommens beispielsweise würde, wenn sie korrekt angewandt würde, lediglich das geschlechtsspezifische Lohngefälle reproduzieren und systematisch niedrigere Kredite an Frauen vergeben. In diesem Fall wären mathematisch korrekte Ergebnisse ungerecht, und gerechte Ergebnisse wären mathematisch falsch. Um es anschaulich zu formulieren: Vorhersagen mit KI zu treffen, ist wie Autofahren, bei dem man ausschließlich in den Rückspiegel schaut. Trotz der großen Anstrengungen zur Bekämpfung von Vorurteilen in diesem Bereich gibt es eine prinzipielle Grenze für die Neutralität und Fairness, die KI verspricht.

KI und Digitalisierung als Organisationsmittel

Im Lichte der Überlegungen zu den Möglichkeiten von KI wird deutlich, dass das im Zusammenhang mit KI häufig aufgeworfene Thema „Mensch versus Maschine“ ein Pseudoproblem ist, das nur in der Science-Fiction vorkommt. Gegenwärtig existierende und denkbare KI hat keine persönlichen Ziele oder Motivationen – selbst wenn sie in Form von Robotern auftritt – und muss daher als ein komplexes Werkzeug verstanden werden.

Die Betrachtung von KI als mächtiges Werkzeug erfordert jedoch eine Ausweitung der Analyse von der ausschließlichen Konzentration auf spezifische KI-Techniken, so interessant und einzigartig sie auch sein mögen, auf die Organisationen, die sie entwickeln, implementieren und verbreiten. Werkzeuge werden von Akteuren eingesetzt, um Interessen und Ziele zu verfolgen, möglicherweise gegen andere Organisationen oder Einzelpersonen.

Zeitgeist-KI (einschließlich KI) ist immer eine Erweiterung einer Organisation. Wenn überhaupt, entstehen KI-Konflikte entlang der Linie „Organisation gegen Organisation“, weshalb die Interessen der beteiligten Akteure immer im Mittelpunkt von KI-Analysen stehen sollten. Wenn also das Interesse einer Organisation nicht die Nachhaltigkeit umfasst, wird KI nicht dafür eingesetzt werden (oder auf den Rebound-Effekt stoßen).

Diese organisatorische Sichtweise ist besonders wichtig und spezifisch für KI, da diese in der Regel datenintensive Technologien umfasst und damit – der Vergleich mit der Kernkraft drängt sich auf – eine machtzentrierende Wirkung hat. Die Tatsache, dass große Unternehmen ihre KI-Frameworks und -Dienste frei zur Verfügung stellen, ändert nichts daran, dass KI ohne die entsprechenden und immensen Datengrundlagen kaum einen wirklichen Nutzen haben kann. KI ist daher nur die jüngste Entwicklung des digitalen Feudalismus, bei dem nur wenige große KI-Anbieter*innen ihre Dienste vermieten.

KI für die Nachhaltigkeit

Grundsätzlich ist es wünschenswert, wenn KI für Nachhaltigkeit, „gesellschaftliches und ökologisches Wohlergehen“ (EU High-Level Expert Group on Artificial Intelligence) oder für den Naturschutz (Art. 20a Grundgesetz) eingesetzt wird. Allerdings muss bei jedem durchdachten Einsatz von Technik eine ganzheitliche Betrachtung erfolgen, insbesondere bei so ressourcenintensiven und zentralisierenden Technologien, wie sie unter dem Oberbegriff KI zusammengefasst werden.

Der gesamte Lebenszyklus von KI darf keinen großen ökologischen Fußabdruck an anderer Stelle auf dem Planeten hinterlassen. Andernfalls würde die KI-Anwendung selbst, trotz guter Absichten, zur Zerstörung unserer Lebensgrundlagen beitragen. Es muss also immer ein positiver Nettonutzen angestrebt werden, auch wenn dieser manchmal kaum abschließend bewertet werden kann. Es gibt viele Beispiele, wie bestimmte KI-Systeme konkret zum Schutz von Ressourcen, Biodiversität und Natur eingesetzt werden können, und mit einem breiten Verständnis von Nachhaltigkeit lassen sich weitere Anwendungen hinzufügen. In diesen Bereichen sind gute Ergebnisse zu erwarten.

Wenn das Versprechen, dass KI die Nachhaltigkeit verändern wird, eingelöst werden soll, muss jedoch immer eine ernsthafte Frage gestellt werden: Ist KI die beste Lösung, um bei einem bestimmten Problem voranzukommen? Wissen wir derzeit zu wenig über die genaue Anzahl bestimmter Insekten, die beste Art, Autos in Städten zu parken, oder den Stromverbrauch von Rechenzentren? Werden neue Daten aus der KI eine Informationslücke schließen und somit Maßnahmen ermöglichen?

Wenn ja, dann sollten wir weitermachen. Lautet die Antwort jedoch, dass wir in dem betreffenden Bereich bereits genug wissen, dann verbraucht der Einsatz von KI lediglich wichtige Ressourcen, lenkt den politischen Fokus ab und dient letztlich als Ausrede für Untätigkeit, während die Zeit abläuft. Schließlich würde eine AGI mit echter Intelligenz uns wahrscheinlich empfehlen, viele Dinge, die wir bereits wissen, schnell zu tun, von der Nutzung 100 Prozent erneuerbarer Energien über Fahrradstädte bis hin zur konsequenten Entkolonialisierung; warum also nicht eine Abkürzung nehmen und bereits damit beginnen?

Dieser Beitrag wurde ursprünglich in Englisch veröffentlicht und stammt aus der Publikation: Jankowski, P., Höfner, A., Hoffmann, M. L., Rohde, F., Rehak, R. & Graf, J. (Eds.) (2023), Shaping Digital Transformation for a Sustainable Society. Contributions from Bits & Bäume. TU Berlin

Dieses Werk ist lizenziert unter einer Creative Commons Namensnennung 4.0 International License (CC BY 4.0). Es steht allen frei, das Material in jedem Medium oder Format weiterzugeben, zu bearbeiten und zu veröffentlichen unter folgenden Bedingungen: Nötig sind 1) eine angemessene Urheber- und Rechteangabe, 2) ein Link zur Lizenz (https://creativecommons.org/licenses/by/4.0/deed.de) und 3) eine Angabe, ob und welche Änderungen vorgenommen wurden.

Diese Artikel könnten Sie auch interessieren:

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

KI gegen Buchhaltungsriesen: Wie Bonster den Spesen-Markt aufmischen will

Pay-per-Use statt Abo-Falle: Das Oldenburger Start-up fast2work attackiert mit seiner App bonster komplexe Software-Giganten. Doch reicht das Versprechen maximaler Einfachheit im Haifischbecken der FinTechs? Wir haben nachgehakt.

Es ist eines der letzten großen Ärgernisse im Arbeitsalltag von Freelancer*innen und kleinen Agenturen: Der Freitagabend, der für das Sortieren verknitterter Tankbelege und das Abtippen von Bewirtungsbelegen in Excel-Listen draufgeht. Genau hier setzt die Oldenburger fast2work GmbH mit ihrer am 17. Februar 2026 gelaunchten App bonster an, um den Papierkram bei der Reisekostenabrechnung zu beenden. Das Versprechen von Gründer und CEO Ronald Bankowsky: Drei Minuten Aufwand, KI-Automatisierung und keine Einstiegshürden.

Das Versprechen: Simpel statt Systemintegration

Die Funktionsweise der App ist bewusst minimalistisch gehalten: Beleg fotografieren, woraufhin die KI relevante Werte wie Datum, Betrag und Mehrwertsteuer ausliest, auf Duplikate prüft und eine fertige Abrechnung erstellt. „Kein Onboarding-Projekt, kein Vertriebsgespräch, kein IT-Setup“, fasst Bankowsky den Ansatz der Standalone-Lösung zusammen.

Die Zielgruppe ist klar definiert: Selbständige, Freelancer*innen und Mini-Teams, denen Enterprise-Lösungen wie SAP Concur zu mächtig und Start-ups wie Circula oder Pleo oft noch zu prozesslastig sind. Mit einem Preismodell von 1,99 Euro für Einzelabrechnungen und 6,99 Euro (Stand Ende Febr. 2026) für eine Flatrate positioniert sich das Unternehmen im unteren Preissegment.

Im Haifischbecken der Neobanken und Buchhaltungsriesen

Laut fast2work gab es bislang „kaum eine Alternative zwischen Excel und Enterprise-Software“. Diese Aussage hält einem Realitätscheck im Jahr 2026 allerdings nur bedingt stand. Bonster betritt ein Haifischbecken, denn die vermeintliche Lücke wird längst geschlossen.

Zum einen integrieren Buchhaltungsriesen wie Lexoffice oder sevDesk Reisekosten-Features immer tiefer in ihre Standardpakete. Zum anderen wildern Neobanken wie Qonto, Finom oder Kontist im selben Revier: Wer dort ein Geschäftskonto hat, bekommt die Belegzuordnung oft als „Commodity“ gratis dazu. Mit knapp 7 Euro im Monat bewegt sich bonster in einer Preisregion, in der man fast schon eine komplette einfache Buchhaltungssoftware bekommt. Die App muss also einen enormen Mehrwert bieten, um gegen die „Eh-da-Lösungen“ (Software, die Kund*innen ohnehin bezahlen) zu bestehen.

Auf die Frage, warum Freelancer*innen für eine Insellösung extra zahlen sollten, entgegnet der Gründer, dass bonster bewusst früher ansetze als klassische Tools. Das Hauptproblem sei nicht die Buchhaltung, sondern das Erfassen von Belegen unterwegs. „Genau dort scheitert es oft, weil Mitarbeitende keine komplexen Systeme nutzen wollen oder gar keine Zugänge haben“, argumentiert Bankowsky. Der Mehrwert liege nicht in einer weiteren Buchhaltungssoftware, sondern darin, dass durch die Reduzierung auf ein Foto „überhaupt verwertbare Abrechnungsdaten/Belege entstehen“.

Kritische Faktoren: GoBD und Datensicherheit

Neben der Marktpositionierung ist die Rechtssicherheit ein kritischer Faktor. „Fertige Abrechnung für die Buchhaltung“ ist ein mutiges Versprechen, da in Deutschland ein Foto allein oft nicht ausreicht; es muss GoBD-konform und revisionssicher archiviert werden. Zudem ist die KI-Nutzung datenschutzrechtlich sensibel. Wenn Bewirtungsbelege, die offenbaren, mit wem man gegessen hat, über US-Schnittstellen (z.B. OpenAI) fließen, ist das für deutsche Geschäftskund*innen und Steuerberater oft ein K.O.-Kriterium.

Auf die sensiblen Vorgaben der Finanzämter und den Serverstandort angesprochen, betont Bankowsky, dass die Verarbeitung „ausschließlich auf europäischen Servern“ erfolge. Zwar nutze man OpenAI-basierte Modelle, diese liefen jedoch über Azure-Rechenzentren im europäischen Raum. Datenschutz und regulatorische Anforderungen seien Grundvoraussetzung. Auch beim Export zum Steuerberater zeigt sich der Gründer zuversichtlich: Buchhaltungssysteme könnten die Daten direkt und „ohne manuelle Nacharbeit“ weiterverarbeiten.

Beta-Test als Exklusiv-Club

Zum Start setzt das Unternehmen auf eine Gamification des Rollouts. Die ersten 500 Nutzer*innen erhalten im „Club 500“ einen lebenslangen Rabatt von 50 Prozent. Was als Belohnung für Early Adopters verkauft wird, ist strategisch notwendig: Die KI muss lernen. Der Algorithmus braucht dringend „Real World Data“ – echte, verknitterte, schlecht beleuchtete Belege. Das bedeutet auch: Die ersten User*innen sind Teil des Entwicklungsprozesses.

Dass die App im Alltag noch dazulernen muss, räumt Bankowsky ein. Bei der reinen Datenerkennung sei man technisch auf dem aktuellen Stand. „Entscheidend ist jedoch die Qualität realer Belege im Alltag – etwa schlecht fotografierte oder handschriftliche Quittungen“, erklärt er den Bedarf an Praxis-Feedback. Durch schnelle Updates solle die Genauigkeit für alle Nutzer*innen laufend steigen.

Gegenmodell zur Ökosystem-Abhängigkeit

Wer ein Feature-Feuerwerk suche, werde bei bonster enttäuscht sein – was laut Unternehmen aus Überzeugung geschehe. Anbieter wie Rydoo verfolgten eine Strategie der maximalen Integration und langfristiger Verträge, was eine Abhängigkeit erzeuge, die ihr eigentliches Geschäftsmodell sei, so der Gründer. Wer einmal im Ökosystem stecke, wechsle nicht mehr, weil der Ausstieg zu teuer geworden sei.

Bonster positioniert sich als Gegenmodell für Unternehmen, die nicht für ungewollte Komplexität zahlen möchten: Kein Vertrag, keine Mindestnutzerzahl, Setup in unter fünf Minuten und ein Pay-per-Use-Modell. „Wer aufhören will, hört auf, ohne Konsequenzen“, beschreibt das Start-up den Ansatz der bewussten Entscheidung, Kund*innen freizulassen. Wer bleibe, tue dies, weil es funktioniere, was laut Bankowsky „die interessantere Innovation“ sei.

Fazit

Bonster ist ein innovativer Angriff auf die Zettelwirtschaft und wirkt durch den Verzicht auf starre Abo-Modelle bei der Einzelabrechnung fair. Doch die App steht und fällt mit der Schnittstellenkompetenz. Wenn der Export zu DATEV & Co. hakt, wird aus der Zeitersparnis schnell Mehrarbeit. Bonster muss beweisen, dass es die Brücke zwischen dem schnellen Foto und der strengen deutschen Buchhaltung schlagen kann – und zwar besser als die Banken, die das Feature bereits kostenlos anbieten.

Distart: Vom Agentur-Frust zum EdTech-Champion

Wie das 2021 von Thomy Roecklin gegründete und seit 2025 zusammen mit Lucia-Miriam Selbert geführte Leipziger EdTech Distart das Bildungssystem „gegen den Strich bürstet“.

Wer in Deutschland über Start-up-Hubs spricht, landet meist schnell in Berlin oder München. Doch in der sächsischen Metropole Leipzig wächst seit einigen Jahren ein Player heran, der beweist, dass Innovation auch abseits der üblichen Verdächtigen gedeiht: Die Distart Education GmbH. Ihr Treibstoff ist der eklatante Mangel an digitaler Kompetenz in der deutschen Wirtschaft – und der Mut, das „System Bildung“ gegen den Strich zu bürsten.

Wenn „Done for You“ nicht mehr reicht

Die Wurzeln des Unternehmens reichen weiter zurück als das offizielle Gründungsjahr 2021. Gründer Thomy Roecklin setzte jahrelang mit seinen Agenturen MNKY lab und TRDIGITAL digitale Kampagnen für Kund*innen um. Doch im Tagesgeschäft bremste das fehlende Digitalverständnis auf Kundenseite die Projekte immer wieder aus. Die Erkenntnis, dass Deutschland weniger neue Agenturen, sondern mehr digitale Mündigkeit braucht, führte schließlich zum Pivot.

Interessanterweise war der Auslöser für diesen Kurswechsel kein konkretes Kundenprojekt. Auf die Frage nach dem „Aha-Moment“ erklärt Roecklin, dass er lediglich versuchte, Lucia-Miriam Selbert einzuarbeiten, und dabei schockiert feststellte, wie wenig praxisnahe digitale Weiterbildungen existierten. Er baute kurzerhand selbst ein Lernprogramm – ohne zu ahnen, dass daraus einmal Distart entstehen würde. Im Januar 2021 fiel der Startschuss für Distart learn. Mitten in der Pandemie setzte Roecklin auf ein Modell, das sich radikal von klassischen Bildungsträgern unterschied: 100 Prozent remote, aber mit enger persönlicher Betreuung und einem klaren Fokus auf die Praxis.

Das Schnellboot zwischen den Tankern

Distart operiert im sogenannten AZAV-Markt (Akkreditierungs- und Zulassungsverordnung Arbeitsförderung). Während etablierte Bildungsriesen oft mit der Trägheit ihrer Größe kämpfen und bis zu 24 Monate für Lehrplananpassungen benötigen, hat sich Distart als agiler „Qualitäts-Vorreiter“ positioniert.

Für Roecklin ist diese Agilität eine Frage des Überlebens, da sich Jobs und Skills heute schneller verändern als jede klassische Bildungslogik. Er betont, dass man ohne permanente Weiterentwicklung der Inhalte zwangsläufig am Markt vorbei ausbilden würde. Diese Flexibilität ist zudem essenziell für die Zielgruppe: Viele Teilnehmende bilden sich neben ihrem 9-to-5-Job weiter, betreuen Kinder oder pflegen Angehörige und benötigen daher flexible statt starrer Strukturen.

Agency-DNA statt Schulbank-Feeling

Der entscheidende Wettbewerbsvorteil liegt in der Herkunft: Distart ist keine klassische Schule, sondern wurde von Marketern für Marketer gebaut. Diese „Agency-DNA“ durchzieht das gesamte Geschäftsmodell. Mit einer modernen Lernumgebung aus Live-Sessions und asynchronen Deep-Dives spricht das Unternehmen alle Altersgruppen gleichermaßen an.

Auch technologisch ist man der Konkurrenz oft einen Schritt voraus: Als ChatGPT Ende 2022 die Arbeitswelt veränderte, reagierte Distart fast in Echtzeit. Auf die kritische Frage, ob KI das vermittelte Wissen nicht bald obsolet mache, findet Roecklin eine klare Antwort: KI ersetzt keine Menschen, sie ersetzt lediglich Mittelmaß. Während KI das Netz mit generischen Inhalten flutet, steige paradoxerweise der Hunger nach echten Stimmen, Ideen und Perspektiven – Marketing werde also menschlicher.

Bootstrapping und gesundes Wachstum

Der Erfolg gibt dem Konzept recht. Im September 2024 erfolgte die Umfirmierung zur Distart Education GmbH, was den Übergang vom Start-up zum etablierten Bildungsinstitut markierte. Während andere Tech-Unternehmen Personal abbauen mussten, verdoppelte Distart seine Belegschaft beinahe auf über 100 Köpfe und bezog im Oktober 2025 neue Räumlichkeiten im NEO Leipzig.

Besonders bemerkenswert: Das Wachstum ist organisch und gebootstrapped – finanziert aus dem eigenen Cashflow ohne externe Risikokapitalgeber. Das macht Distart unabhängig von Exit-Druck. Seit Februar 2025 verstärkt Lucia-Miriam Selbert als Geschäftsführerin die strategische Ausrichtung.

Dennoch birgt die Skalierung Risiken, da das Geschäftsmodell stark von staatlichen Bildungsgutscheinen abhängt. Auf einen möglichen „Plan B“ angesprochen, erklärt das Unternehmen, dass Förderungen zwar beim Beschleunigen helfen, man Distart aber bewusst so aufbaue, dass langfristig strukturelle Unabhängigkeit erreicht wird. Auch die Qualitätssicherung bei über 100 Mitarbeitenden ist eine Herausforderung. Thomy Roecklin gibt offen zu, dass Wachstum kein Wellnessprogramm ist und es im Getriebe zwangsläufig knirscht. Sein Schlüssel: Qualität darf nicht an Einzelpersonen hängen, sondern muss im gesamten System verankert sein, kombiniert mit echtem Vertrauen in das Team statt Kontrolle.

Der Standort als Statement und Vision

Dass Distart in Leipzig verwurzelt bleibt, ist Teil der Identität. Roecklin sieht im Osten Deutschlands ein enormes, oft unterschätztes Potenzial und erlebt dort viel Talent, Pragmatismus und Lernhunger. Distart versteht sich hier auch als Regionalentwickler.

Die Vision der Gründer geht jedoch über reine Kurse hinaus. Unterstrichen durch Auszeichnungen wie „Top Fernschule 2025“ und „2026“, arbeitet das Team nun an der Gründung der Distart University of Applied Sciences. Das Ziel bis 2030 ist ambitioniert: Ein Alumni-Netzwerk von 25.000 Absolvent*innen. Sollte der komplexe Weg zur staatlichen Anerkennung gelingen, wird Distart endgültig zum gewichtigen Faktor für die digitale Wettbewerbsfähigkeit der Bundesrepublik.

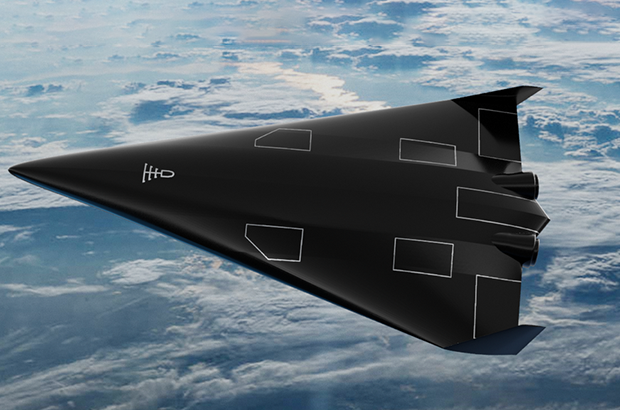

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

VESTIO: Wenn ein Solar-Entrepreneur auf einen Stil-Rebellen trifft

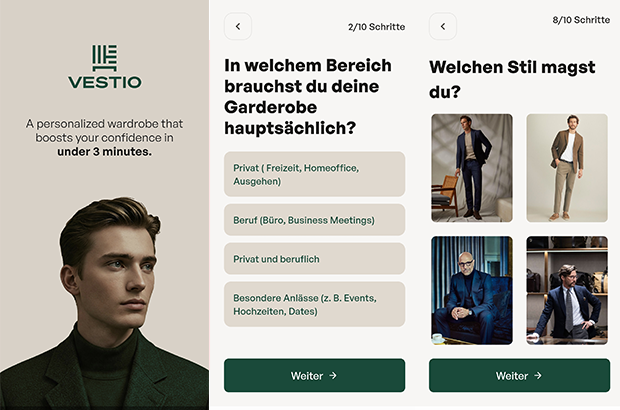

Die Geschichte der jungen FashionTech-App VESTIO ist zugleich die zweier Gründer, die sich in einem gemeinsamen Ziel treffen: Die Demokratisierung von gutem Stil durch algorithmische Logik.

Hinter der FashionTech-App VESTIO steht die im Jahr 2024 von Bastian Arend und Justus Hansen gegründete Opus Stilberater GmbH, die den Anspruch erhebt, professionelle Stilberatung erstmals digital, logisch und kostenlos zugänglich zu machen.

Der „Solar-Entrepreneur“ trifft den Stil-Rebell

Die persönlichen Hintergründe der Gründer bieten spannende Kontraste, die weit über ein übliches Business-Profil hinausgehen. Bastian Arend, Co-Founder und CEO, kam über die Energiewende zur Mode. Als Seriengründer baute er den Online-Solar-Anbieter Klarsolar auf und verkaufte ihn im Dezember 2023 erfolgreich an den Energiekonzern E.ON. Die Übernahme erfolgte in einer für die Solarbranche schwierigen Marktphase, was Bastian Arend als Krisen-erprobten Strategen auszeichnet.

VESTIO entwickelte er 2024 jedoch aus einem ganz persönlichen „Pain Point“ heraus: Während er internationale Millionen-Finanzierungsrunden leitete, bestand sein eigener Stil mangels Zeit lediglich aus Hoodie, Jeans und Sneakern. „Ich wollte nur jemanden, der für mich einkauft“, erinnert er sich an diese Phase. Seine Abneigung gegen zeitraubendes Shopping führte ihn schließlich zu Justus Hansen.

Justus Hansen, Co-Founder und Chief Styling Officer, bringt eine Biografie ein, in der Mode schon immer eine zentrale Rolle spielte. Sein Gespür für klassische Mode ist tief verwurzelt: Justus Hansen trug bereits im Kindergarten eine Fliege und provozierte später Lehrer, indem er im Sakko zum Unterricht erschien. Bevor er mit über 1,6 Millionen Follower*innen zu einem der bekanntesten Männerstilberater Deutschlands aufstieg, studierte er Jura und absolvierte Praktika im Bankensektor, unter anderem bei der Dresdner Bank.

Diese Erfahrungen schärften seinen Blick für die Anforderungen moderner „Business-Garderoben“. Als Arend ihn fragte, ob er für ihn einkaufen könne, antwortete Justus Hansen bestimmt: „Einfach irgendwas kaufen? Nein. Ich muss verstehen, wer du bist.“ Bastian Arend begriff Hansens modulare Styling-Methode sofort als logisches System und schlug vor: „Wir sollten deine Methode digitalisieren und kostenlos für jeden Mann zugänglich machen.“ Für Justus Hansen wurde damit ein „Lebenstraum“ wahr.

Das Konzept: „Weniger Teile, mehr Outfits“

Das Herzstück der App bildet ein algorithmisches Styling-System, das strikt dem Leitsatz „Weniger Teile. Mehr Outfits“ folgt. In nur drei Minuten erstellt ein Stilfinder-Fragebogen eine persönliche Grundgarderobe. Der digitale Kleiderschrank funktioniert dabei bewusst ohne das mühsame Hochladen von Fotos; das System kennt die wichtigsten Basics, erkennt Lücken und empfiehlt gezielt Ergänzungen. Justus Hansen betont dabei die Wichtigkeit der Basis: „Die wenigsten Männer besitzen eine echte Basisgarderobe. Und das ist die Grundlage, aus der ihre besten Outfits entstehen.“

Ziel ist es, automatisch kombinierbare Outfits für alle Anlässe zu generieren. Dabei verfolgen die Gründer eine klare ästhetische Linie: „Outfits müssen nicht kompliziert sein, um zu wirken. Sie brauchen lediglich eine klar erkennbare Linie“, so Hansen. Bastian Arend ergänzt: „Die besten Outfits für Männer sind nicht kompliziert, sondern harmonisch und durchdacht.“

Das Affiliate-Dilemma: Geschäftsmodell im kritischen Check

Wirtschaftlich operiert VESTIO über ein Affiliate-Modell. Die App ist für Nutzer kostenlos, während das Unternehmen Provisionen von Partner-Anbietern bei einem erfolgreichen Kauf erhält. Hier liegt für den kritischen Betrachter ein interessanter systemischer Interessenkonflikt: Das erklärte Ziel „Weniger Konsum – bessere Entscheidungen“ steht ökonomisch potenziell im Widerspruch zu einem Modell, das von Transaktionen lebt. Zudem stellt sich die Frage der langfristigen Nutzerbindung: Sobald ein Mann seine „perfekte Garderobe“ aufgebaut hat, sinkt der Bedarf für weitere Anschaffungen. Dass das Unternehmen dennoch auf Wachstum setzt, zeigt die Erhöhung des Stammkapitals auf knapp 30.000 Euro im September 2025. Langfristig plant VESTIO die Integration eines Marktplatzes, der Partnerprodukte und eigene Kollektionen vereint, um basierend auf Daten den größten Mehrwert zu liefern.

Marktpositionierung und technologischer Vorsprung

Im Vergleich zum Wettbewerb besetzt VESTIO eine spezifische Nische. Während Curated-Shopping-Anbieter (z.B. Outfittery) auf den Versand physischer Boxen setzen, bleibt VESTIO ein rein digitaler Guide, der dem Nutzer die volle Freiheit bei der Wahl des Händlers überlässt. Andere Styling-Apps verlangen oft zeitintensive Foto-Inventuren, während VESTIO auf logische Kombinationen setzt.

Das Risiko bleibt jedoch die Abhängigkeit von der Personal Brand Justus Hansens. Letztlich ist VESTIO der Versuch, Mode so effizient wie eine Prozessoptimierung zu gestalten – oder wie Bastian Arend es formuliert: „Viele Männer haben mehr Kleidung als Stil. Vestio ändert das.“ Mit dem Aufbau der App wolle man Männern „genau diese Arbeit abnehmen“, damit sie sich ultimativ „besser fühlen“ können.

Rouge: Vom Tabu zum Geschäftsmodell

Die Menstruation ist ein Milliardenmarkt – und dennoch oft unsichtbar. Das von Tina Frey und Patrick Gsell gegründete Start-up Rouge bricht mit diesem Muster. Was Ende 2022 als Vision in der Schweiz begann, hat sich durch geschickte Positionierung und Expansion nach Deutschland zu einem ernstzunehmenden Player im FemTech-Bereich entwickelt.

Die Grundidee von Rouge ist so simpel wie strategisch klug: Statt die Menstruation zu verstecken, wird sie zum sichtbaren Lifestyle-Element. „Mich hat fasziniert, wie sehr die Menstruation unseren Alltag beeinflusst und wie konsequent wir trotzdem darüber schweigen“, erklärt Mitgründerin Tina Frey. „Bald wurde mir klar: Das ist ein gesellschaftliches Problem.“ Dass dieser Ansatz einen Nerv trifft, zeigt der rasche Aufstieg des Unternehmens. Durch gezielte Medienarbeit gelang es dem Team, das Thema aus der Nische in den Mainstream zu heben – Tina Frey positioniert sich dabei konsequent nicht nur als Unternehmerin, sondern als Expertin für Frauengesundheit.

Differenzierung im "Red Ocean"

Im Zentrum der Marke steht der Rouge-Drink, ein Pulver-Supplement mit Eisen, Vitamin B12 und Granatapfel. Doch der eigentliche USP liegt nicht in den Inhaltsstoffen, sondern in der Inszenierung. Die transparente Flasche mit der roten Flüssigkeit fungiert als bewusstes „Statement-Piece“.

Hier gelingt dem Start-up ein entscheidender Schachzug im wachsenden Markt für Zyklusgesundheit: Während Wettbewerber wie FEMNA oder MYLILY auf funktionale Nahrungsergänzung in diskreter Kapselform setzen, inszeniert Rouge die Einnahme als genussvollen Wellness-Moment. Gleichzeitig emanzipiert sich das Duo von den „lauten“ Tabubrechern der Branche wie The Female Company: Rouge setzt weniger auf Provokation durch Hygieneartikel, sondern transformiert die Linderung von Regelbeschwerden von einer medizinischen Notwendigkeit in eine „ästhetische Selbstverständlichkeit“.

„Sichtbarkeit verändert Verhalten“, so Tina Frey. „Die Flasche macht den Zyklus im Alltag sichtbar und löst Gespräche aus. Noch wichtiger: Viele Frauen erleben dadurch eine neue Selbstverständlichkeit und mehr Selbstbewusstsein.“ Dieser Social-Impact-Gedanke ist fest im Geschäftsmodell verankert: Ein Teil der Erlöse fließt in Aufklärungsprojekte. „Sozialer Impact ist kein Marketing-Trick, sondern eine Notwendigkeit“, ergänzt Co-Founder Patrick Gsell. „Gleichzeitig braucht es wirtschaftliche Stabilität, um langfristig bestehen zu können.“

Diverse Kompetenzen als Wachstumstreiber

Hinter der Marke steht ein komplementäres Gründungs-Duo. Tina Frey bringt als Marketing-Expertin das kommunikative Rüstzeug mit, während Patrick Gsell – seit über 20 Jahren Geschäftsführer eines Softwareunternehmens – die strategische Struktur und Skalierungserfahrung liefert. Patrick Gsell, der 2022 den Bund-Essay-Preis gewann, liefert zudem den intellektuellen Unterbau. „Die Hälfte der Menschheit erlebt die Menstruation. Trotzdem betrifft sie die ganze Gesellschaft und nicht zuletzt das Verständnis zwischen Mann und Frau. Genau deshalb finde ich es so spannend, mit Rouge am Anfang eines gesellschaftlichen Wandels zu stehen“, so Patrick Gsell.

Expansion mit lokaler Strategie

Nach der Etablierung auf dem Schweizer Heimatmarkt erreichte Rouge im Herbst 2025 den nächsten Meilenstein: den Markteintritt in Deutschland. Anders als bei reinen Export-Modellen setzt das Start-up hierbei auf lokale Strukturen und Partner vor Ort. „Der deutsche Markt bietet großes Potenzial, aber jede Gesellschaft tickt anders“, begründet Tina Frey den Schritt. Das Ziel bleibt grenzüberschreitend gleich: Die Menstruation soll kein Nischenthema bleiben, sondern als normaler Teil der weiblichen Gesundheit akzeptiert werden – sichtbar gemacht durch eine rote Flasche, die den Dialog eröffnet.

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

Europa kann KI!

Was wir von den besten EU-AI-Companies lernen können, erläutert KI-Experte Fabian Westerheide.

Europa muss sich bei KI nicht kleinreden. Wir sehen gerade sehr deutlich: Aus Europa heraus entstehen Unternehmen, die Kategorien besetzen – und dann auch das große Kapital anziehen. Beispiele gibt es genug: Mistral AI, DeepL, Black Forest Labs, Parloa, Helsing, Lovable oder n8n.

Ich schreibe das aus drei Blickwinkeln: als Investor (AI.FUND), als Konferenz-Initiator (Rise of AI Conference) und als Autor von „Die KI-Nation“. Was du hier bekommst, ist kein „Europa-hat-ein-Problem“-Essay – sondern eine Analyse plus ein Execution-Set an Empfehlungen, das du direkt auf dein Start-up übertragen kannst.

Die Realität: Seed geht oft – Scale ist das Spiel

Am Anfang brauchst du selten „zu viel“ Geld. MVP, erste Kunden, Iteration: Das klappt in Deutschland in vielen Fällen mit Seed. Die echte Trennlinie kommt später – wenn du aus einem starken Start-up einen Kategorie-Gewinner bauen willst.

Denn KI ist zunehmend Winner-takes-most. Und das gilt auch fürs Kapital: In vielen Fällen ist die Growth-Finanzierung in den USA grob 25-mal größer – bei den aktuellen Front-Runnern (Modelle, Infrastruktur, Distribution) wirkt es teilweise wie 100-mal, weil Kapital sich auf die vermuteten Sieger stapelt. (Nicht „fair“, aber Marktmechanik.)

Die gute Nachricht: Genau die EU-Vorbilder oben zeigen, dass du das nicht wegdiskutieren musst – du musst es exekutieren.

Was die EU-Winner gemeinsam haben: 6 Execution-Prinzipien

1. Starkes Gründerteam – aber vor allem: vollständig

Alle genannten Vorbilder hatten (oder bauten sehr schnell) ein Team, das drei Dinge gleichzeitig kann:

- Tech & Produkt (nicht nur „Model-IQ“, sondern Produktgeschmack)

- Go-to-Market (Vertrieb, Buyer-Verständnis, Pricing)

- Tempo (entscheiden, shippen, lernen)

Wenn eine Säule fehlt, zahlst du später mit Zeit. Und Zeit ist in KI eine Währung, die dir niemand schenkt.

Founder-Move: Benenne eine Person, die Umsatz genauso hart verantwortet wie Modellqualität. Wenn das „später“ ist, ist das sehr wahrscheinlich dein Bottleneck.

2. Global denken – aber spitz: KI-Nische statt Bauchladen

Die EU-Winner sind nicht „KI für alles“. Sie besetzen klare Nischen:

Language-AI (DeepL), Customer-Experience-Agents (Parloa), GenAI-Modelle (Black Forest Labs), Defence-Tech (Helsing), Builder/Vibe-Coding (Lovable), Orchestration & Automation (n8n), Foundation-Model-Ambition (Mistral).

Founder-Move: Formuliere deinen Claim so, dass er in einem Satz sagt, welche Kategorie du dominierst. Wenn du drei Absätze brauchst, bist du noch zu breit.

3. Umsatz ist keine Nebenwirkung – Umsatz ist Souveränität

Der schnellste Weg zu Growth-Capital ist nicht „noch ein Pilot“, sondern Revenue, der deine Kategorie glaubwürdig macht.

Parloa kommuniziert z.B. ARR > 50 Mio. USD und wächst international – genau die Art Signal, die große Runden freischaltet.

Founder-Move (gegen Pilotitis): Kein PoC ohne schriftlichen Pfad in einen Vertrag (Budget, KPI, Entscheidungstermin). Sonst finanzierst du mit deiner Runway den Lernprozess des Kunden.

4. Internationales Kapital früh anbahnen – bevor du es brauchst

Das Muster ist klar: Erst Kategorie-Story + Traktion, dann große Checks.

Mistral (Series C 1,7 Mrd. €) oder Lovable (330 Mio. USD bei 6,6 Mrd. Bewertung) sind kein „Glück“ – das ist Momentum + Positionierung + Timing.

Founder-Move (90-Tage-Plan):

- Baue eine Capital Map deiner Nische (wer zahlt Growth-Checks?)

- Definiere die drei Metriken, die diese Investor:innen sehen wollen

- Organisiere zehn Intros jetzt, nicht erst bei sechs Monaten Runway

5. Compute ist keine IT-Zeile – es ist ein Wachstumshebel

In KI ist Compute Teil deiner Wettbewerbsfähigkeit. Geschwindigkeit beim Trainieren, Testen und Deployen entscheidet, wie schnell du am Markt lernst.

Founder-Move: Plane Compute-Runway wie Cash-Runway. Verhandle früh Kontingente, bevor dein Verbrauch explodiert – sonst wird Wachstum plötzlich zur Margen-Frage.

6. Trust & Compliance als Verkaufsargument – nicht als Ausrede

Gerade in DACH gilt: Wer secure, audit-fähig, enterprise-ready wirklich liefern kann, gewinnt Deals.

DeepL betont genau diesen Business-Wert: verlässliche, sichere Lösungen statt Hype.

Founder-Move: Baue Trust-Artefakte früh – Dokumentation, Governance, Datenflüsse, Rollen, Audit-Spuren. Das beschleunigt Enterprise-Vertrieb, statt ihn zu bremsen.

Kurz-Checkliste: Wenn du in Europa KI gewinnen willst

- Kategorie in einem Satz (spitze Nische, globaler Anspruch)

- Klarer Revenue-Pfad (weniger Piloten, mehr Verträge)

- Capital Map (international früh andocken)

- Compute-Runway (wie Cash planen)

- Trust by Design (verkaufsfähig machen)

- Tempo als Kultur (shippen, messen, nachschärfen)

Europa kann KI. Die Frage ist nicht, ob hier Talent existiert – das ist bewiesen.

Die Frage ist, ob du Execution so aufsetzt, dass aus Talent Marktführerschaft wird.

Der Autor Fabian Westerheide gestaltet als KI-Vordenker, Investor, Ökosystem-Pionier und Keynote Speaker seit über einem Jahrzehnt die Debatte um KI, Macht und digitale Zukunft mit.

Diese 10 Start-ups bauen an der Zukunft der AgriFood-Branche

Die deutsche Start-up-Landschaft verzeichnete 2025 ein Rekordhoch bei Neugründungen. Doch gerade im AgriFood-Sektor ist der Weg vom Prototyp zum Marktführer steinig. Kapitalintensive Hardware und strenge Regulatorik bremsen viele aus. Der Growth Alliance Accelerator zeigt, wie Gründer*innen diese Hürden überspringen – und präsentiert zehn Akteure, die auf der Erfolgsspur sind.

Es ist ein Paradoxon: Die Nachfrage nach nachhaltigen Lebensmitteln und effizienter Landwirtschaft ist so hoch wie nie, doch für Gründer*innen und junge Unternehmen in der AgriFood-Branche bleibt der Markteintritt ein Hürdenlauf. Während Software-Start-ups oft mit geringem Kapital skalieren, kämpfen Food- und AgTech-Pioniere mit der „Hardware-Falle“. Sie benötigen teure Produktionsanlagen, Labore und müssen langwierige Zulassungsverfahren (z.B. Novel-Food-Verordnung) durchlaufen.

Dennoch ist die Branche im Aufwind: Laut dem Deutschen Startup Monitor und aktuellen Zahlen des Startup-Verbands stiegen die Gründungszahlen 2025 um beachtliche 29 Prozent. Das Kapital ist da, doch es fließt selektiv. Investor*innen suchen heute keine reinen Ideen mehr, sondern validierte Geschäftsmodelle mit technologischem Tiefgang (DeepTech). Genau hier setzte das Finale des Growth Alliance Accelerator 2025 am 28. Januar 2026 in Frankfurt/Main an.

Brückenschlag zwischen Acker und Finanzwelt

Initiiert vom TechQuartier und der Landwirtschaftlichen Rentenbank, hat sich der Accelerator als Schmiede für die „Scale-up“-Phase etabliert. Vier Monate lang wurden zehn Start-ups, die bereits eine Nutzer*innenbasis vorweisen konnten, fit für die nächste Finanzierungsrunde gemacht.

Das Programm adressierte genau die Pain Points der Branche: Verhandlungstaktik, Rechtsfragen und vor allem den Zugang zu Kapital. Ein Highlight war das Investor Dinner im November 2025, bei dem die Gründer*innen direkten Zugang zu Risikokapitalgeber*innen erhielten – in der aktuellen Marktphase ein entscheidender Wettbewerbsvorteil.

Die „Class of 2025“: Wer die Transformation treibt

Die zehn Absolvent*innen decken die gesamte Wertschöpfungskette ab – vom Boden über das Labor bis zum Supermarktregal. Hier ein Blick auf die Köpfe hinter den Innovationen:

1. High-Tech auf dem Acker: Robotik und Daten

Die Digitalisierung der Landwirtschaft (Smart Farming) ist der stärkste Hebel für mehr Effizienz.

Paltech GmbH

Die Brüder Felix und Florian Schiegg gründeten 2022 Paltech zusammen mit Jorge Decombe im Allgäu. Ihr autonomer Roboter für chemiefreie Unkrautbekämpfung im Grünland ist eine Antwort auf strengere Pestizid-Gesetze und Personalmangel.

Bacchus Software GmbH

Das 2023 gegründete Start-up bacchus Weinbau-Software um das Trio Maximilian Dick, Julian Herrlich und Philipp Bletzer digitalisiert den Weinbau. Ihre Software ersetzt das händische Fahrtenbuch und koordiniert die komplette Weinbergsarbeit.

Agrario Energy

Die Energiewende macht Landwirt*innen zu Energiewirt*innen. Seit 2023 bieten die Gründer Alexander von Breitenbach und Chris Weber mit Agrario Energy eine unabhängige Vergleichsplattform, die Flächeneigentümer mit Betreiber*innen von Erneuerbare-Energien-Anlagen zusammenbringt.

2. Deep Tech & Sicherheit: Das Labor als Wächter

Lebensmittelsicherheit wird durch globale Lieferketten immer komplexer. Hier setzen wissenschaftsbasierte Ausgründungen an.

NanoStruct GmbH

NanoStruct wurde 2021 als Spin-off der Universität Würzburg gegründet. Das Team nutzt Nanotechnologie, um gefährliche Bakterien in Lebensmitteln in Minuten statt Tagen aufzuspüren.

SAFIA Technologies

Gegründet 2020 von Timm Schwaar (aus der Bundesanstalt für Materialforschung), entwickelt das Berliner Start-up SAFIA Technologies Schnelltests für Mykotoxine (Schimmelpilzgifte). Ihre Technologie ermöglicht Laborqualität im Schnelltest-Format.

Landman.Bio

Das noch junge Unternehmen (Gründung 2023) Landman.Bio nutzt Bakteriophagen (Viren, die Bakterien fressen) als natürliche Waffe gegen Pflanzenkrankheiten – eine dringend benötigte Alternative zu Antibiotika und klassischen Pestiziden in der Nutzpflanzenzucht.

3. Sustainability & Climate: Kohlenstoff als Währung

CO2-Tracking ist kein Marketing-Gimmick mehr, sondern ökonomische Notwendigkeit.

CinSOIL

Das 2024 in Berlin gegründete CinSOIL-Team um Dr. Giorgi Shuradze, Dr. Antonella Succurro und Dr. Tavseef Shah kommt aus der Wissenschaft. Ihr KI-Tool nutzt Satellitendaten, um Bodenkohlenstoff zu erfassen. Das ermöglicht Agrarunternehmen, Dekarbonisierung nicht nur zu behaupten, sondern zu beweisen.

Niatsu

Gegründet 2023 von Marius Semm und Jakob Tresch in Zürich, adressiert Niatsu die Lebensmittelindustrie. Ihre Software berechnet den Product Carbon Footprint (PCF) automatisiert und kostengünstig, was gerade für den Mittelstand entscheidend ist.

4. Future Food

Was wir morgen essen (und trinken).

VANOZZA

Eines der etabliertesten Start-ups der Runde. Gegründet 2019 von Nico Hansen in Hamburg, hat sich Vanozza mit fermentierten Käsealternativen auf Cashew-Basis einen Namen gemacht und arbeitet nun an der „zweiten Generation“ ihrer Produkte.

food42morrow/JUMA

Die Frankfurter Gründer Raoul und Max Kammann sowie Carlos Lopez Granado gründeten die GmbH bereits 2020 und brachten 2022 ihre Marke JUMA (Tee-Eistees auf Guayusa-Basis) auf den Markt. Sie bedienen den Trend zu „Functional Food“.

Fazit

Die AgriFood-Start-ups des Abschlussjahrgangs des Growth Alliance Accelerators 2025 haben die Phase der reinen Ideen-Findung bereits eindrucksvoll gemeistert. Jetzt geht es um Skalierung, industrielle Anwendung und messbaren Impact. Programme wie die Growth Alliance sind dabei der Katalysator, der wissenschaftliche Exzellenz mit dem nötigen Geschäftssinn verbindet.

to teach: Vom KI-Hype zur Schulinfrastruktur

Wie das 2022 gegründete EdTech to teach die Lücke zwischen Chatbot und Klassenzimmer schließt.

Vor drei Jahren begann mit dem öffentlichen Zugang zu generativer künstlicher Intelligenz ein weltweiter Hype, der auch vor den Schultoren nicht haltmachte. Doch im Bildungsmarkt entscheidet sich derzeit, ob die Technologie tatsächlich Produktivität schafft oder in einer digitalen Sackgasse endet. Das Hamburger EdTech to teach liefert hierzu eine Blaupause: Was 2022 als Experiment begann, hat sich innerhalb von drei Jahren zu einer Arbeitsplattform für hunderttausende Lehrkräfte entwickelt.

Das Problem: US-Tools verstehen deutsche Schulen nicht

Als generative KI erstmals verfügbar wurde, wirkte ihr Einsatz im Bildungsbereich naheliegend. Doch der Blick auf die internationale Konkurrenz zeigt das Dilemma: Während US-Platzhirsche wie MagicSchool AI oder Diffit den Markt mit hunderten Mikro-Tools fluten und technisch beeindrucken, fehlt ihnen der kulturelle Fit. „Einfach nur Texte aus ChatGPT zu kopieren, löst kein einziges Problem von Lehrkräften“, erklärt Felix Weiß, Co-Founder und CEO von to teach.

Die Diskrepanz zwischen dem Versprechen der KI und dem tatsächlichen Schulalltag war groß. US-Lösungen scheitern oft an spezifischen deutschen Lehrplänen oder liefern reine Multiple-Choice-Formate, die hierzulande kaum Anwendung finden. Lehrkräfte benötigten keine unstrukturierten Textwüsten, sondern didaktisch saubere, lehrplankonforme und sofort einsetzbare Materialien. Genau hier setzte das 2022 von Felix Weiß und Marius Lindenmeier gegründete Unternehmen an.

Der Pivot: Datenschutz als Burggraben

Der entscheidende Wendepunkt kam 2023. Das Start-up vollzog einen Strategiewechsel (Pivot) weg von einer SaaS-Lösung für Verlage hin zu einer direkten Plattform für Lehrkräfte. Anstatt Nutzer*innen mit freien Eingabefeldern (Prompts) allein zu lassen, entwickelte das Team feste Arbeitsblattvorlagen. Dies wurde zum entscheidenden Wettbewerbsvorteil gegenüber internationalen Anbietern: Während diese oft an der strikten DSGVO scheitern, bietet to teach durch Serverstandorte in der EU und Rechtssicherheit eine Lösung, die Schulträger akzeptieren.

Dabei mussten technische Kinderkrankheiten überwunden werden: Frühe KI-Modelle „halluzinierten“ Fakten. To teach reagierte mit der systematischen Integration von Quellen und profitierte zugleich von der rasanten Evolution der Sprachmodelle.

Skalierung im Ökosystem gegen nationale Konkurrenz

Der Markt nahm die Lösung schnell an: Im Januar 2023 meldete sich der erste Nutzer an, bis Ende des Jahres waren es laut Unternehmen bereits knapp 16.000 Lehrkräfte. Das Jahr 2024 markierte dann den Übergang vom Start-up zur Plattform: Durch die Übernahme von fobizz (101skills GmbH) wurde to teach Teil eines größeren Bildungsökosystems. Die Gründer blieben als Geschäftsführer an Bord.

Dieser Schritt war strategisch überlebenswichtig in einem sich konsolidierenden Markt. Einerseits gegenüber agilen Herausforderern, da Konkurrenten wie schulKI, Teachino, KIULY oder Kuraplan zum Teil aggressiv um Landeslizenzen kämpfen bzw. auf dem Markt für KI-gestützte Unterrichtsplanung und Materialerstellung durchgestartet sind.

Andererseits war der Schritte in Hinblick auf etablierte Verlage notwendig. Denn Häuser wie Cornelsen ziehen inzwischen mit eigenen KI-Assistenten nach, sperren ihre Inhalte jedoch oft in geschlossene Systeme, d.h. binden sie oft an die eigenen Verlagswerke.

Durch die erfolgreiche Integration in fobizz ist to teach kein isoliertes Insel-Tool mehr, sondern profitiert von bestehenden Landesrahmenverträgen und einem riesigen Vertriebsnetz. Die Nutzer*innenzahlen explodierten förmlich auf über 140.000 Lehrkräfte bis Ende 2024, so die Angaben von to teach.

Status Quo 2025: KI als neue Infrastruktur

Heute, im dritten Jahr nach der Gründung, hat sich der Fokus erneut verschoben. To teach versteht sich inzwischen als Arbeitsinfrastruktur. Die Zahlen unterstreichen diesen Anspruch: Nach Angaben von to teach nutzen über 300.000 Lehrkräfte die Plattform, und mehr als 4.000 Schulen sind angebunden. Das bedeutet: Millionen von Inhalten wurden so bereits KI-gestützt vorbereitet.

Das Unternehmen treibt nun den systematischen Schulvertrieb voran. Damit beweisen EdTechs wie to teach, dass sich Qualität und Personalisierung im sonst oft als innovationsresistent geltenden Bildungsmarkt skalieren lassen.

Für CEO Felix Weiß ist die Diskussion über das „Ob“ längst beendet: „Die Frage ist nicht mehr, ob KI im Klassenzimmer ankommt, sondern, wie und auf welche Weise sie dort wirklich hilft.“

Social Engineering auf dem Vormarsch

Wie Deepfakes die Sicherheit von Führungskräften stärker in den Fokus rücken.

Fotorealistische KI liefert innerhalb von kürzester Zeit realistische Visuals. Was in vielerlei Hinsicht den Arbeitsalltag erleichtert, bedeutet für Social Engineering jedoch eine neue Eskalationsstufe, wie nicht zuletzt die hitzige Debatte um massenhaft sexualisierte Deepfakes von realen Personen durch Grok eindrücklich vor Augen führte.

Auch Personen in leitenden Funktionen in Unternehmen sind vor solchen Manipulationen nicht gefeit. Zunehmend zielen Angriffe auf Menschen mit Zugriffsrechten und Entscheidungsbefugnissen, deren Freigaben unmittelbare Wirkung auf die Sicherheit einer ganzen Organisation haben. „Fotorealistische KI und hybride Social-Engineering-Kampagnen erhöhen den Druck auf Schlüsselpersonen. Daher brauchen Unternehmen belastbare Verifikationsprozesse, Krisenroutinen und integrierte Schutzkonzepte“, erklärt Markus Weidenauer, geschäftsführender Gesellschafter der SecCon Group GmbH.

Deepfakes zielen auf privates Umfeld

Nach Angaben des Bundesamts für Sicherheit in der Informationstechnik (BSI) lassen sich Deepfakes als Verfahren beschreiben, die gezielt Spear-Phishing und andere Social-Engineering-Angriffe nutzen, um Vertrauen aufzubauen und Autorität zu simulieren. Generative KI fungiert dabei als zentraler technischer Enabler, da sie die realistische Erzeugung manipulativer Audio-, Video- und Textinhalte erstmals in industriellem Maßstab ermöglicht. „Die eigentliche Bedrohung ergibt sich dabei nicht aus einzelnen KI-generierten Inhalten, sondern aus deren koordinierter Nutzung“, weiß der Sicherheitsexperte.