Aktuelle Events

Geschäftsideen Nachhaltigkeit: Alles aus zweiter Hand

Einkaufszentrum für Second-Hand

Im schwedischen Eskilstuna, etwa 120 Kilometer von Stockholm entfernt, hat im letzten Jahr das erste Second-Hand-Einkaufszentrum namens Retuna die Türen geöffnet. Eine nachhaltige Geschäftsidee!

Im Retuna werden in 15 Geschäften nur Produkte verkauft, denen via Recycling oder Upcycling ein "zweites Leben" geschenkt wurde. Dazu gehören Haushaltswaren, Möbel, Computer, Fahrräder, Baustoffe, Gartenwerkzeuge, Blumen und Pflanzen.

In diesem Einkaufszentrum kann man aber nicht nur Second-Hand-Produkte kaufen. Vielmehr gehört zur Geschäftsidee auch, dass man man Alltagswaren, die man nicht benötigt, in einer Recycling-Annahmestelle oder in speziellen Drop-Off-Zonen abgeben kann. In Weiterbildungskursen kann man lernen, wie man Produkte repariert, recycelt oder upcycelt. In einer Cafeteria kann man sich erholen und Biokuchen essen.

Sie möchten selbst ein Unternehmen gründen oder sich nebenberuflich selbständig machen? Nutzen Sie jetzt Gründerberater.de. Dort erhalten Sie kostenlos u.a.:

- Rechtsformen-Analyser zur Überprüfung Ihrer Entscheidung

- Step-by-Step Anleitung für Ihre Gründung

- Fördermittel-Sofort-Check passend zu Ihrem Vorhaben

Diese Artikel könnten Sie auch interessieren:

Angriff auf die Portal-Giganten: PropTech Mietz steigt in den Immo-Verkauf ein

Pünktlich zum bevorstehenden fünfjährigen Jubiläum wagt das Berliner Start-up Mietz den nächsten großen Schritt. Die PropTech-Plattform von Gründerin Lena Tuckermann erweitert ihr Geschäftsmodell und bietet ab sofort neben der digitalen Vermietung auch den Immobilienverkauf über eine End-to-End-Plattform an.

Damit positioniert sich das Unternehmen künftig als umfassende digitale Lösung für Vermietung und Verkauf von Wohnimmobilien in Deutschland. Was als nutzerinnenfreundliche App-Alternative für die Wohnungssuche begann, soll sich nun zu einer umfassenden Infrastruktur entwickeln, die nahezu den gesamten Verkaufsprozess digital organisieren soll.

Das Bemerkenswerte daran: Laut Gründerin Lena Tuckermann hat ein dreiköpfiges Kernteam das neue Segment in nur 14 Tagen mithilfe von KI aus dem Boden gestampft – eine klare Kampfansage an die etablierten Marktgiganten.

Vom eigenen Wohnungs-Frust zum PropTech-Challenger

Die Mietz GmbH ist eine 2021 gegründete SaaS-Plattform für digitale Immobilienvermarktung mit Sitz in Berlin. Entstanden aus der eigenen Frustration bei der Wohnungssuche, startete Tuckermann mit der Mission, Vermietende und Mietende von Mailfluten zu befreien und den gesamten Prozess der Wohnraumvermietung zu digitalisieren. Das reicht von der Inseratserstellung über das Bewerbermanagement bis hin zur rechtssicheren Vertragsunterzeichnung.

+++ Tipp der Redaktion: 2023 was Lena Tuckermann bereits unsere „Gründerin der Woche“ – hier das Interview zum Nachlesen. +++

Das Konzept ging auf: Inzwischen wird die Plattform nach Unternehmensangaben deutschlandweit von über 150.000 Nutzerinnen verwendet. Flankiert wird das aktuelle Wachstum durch strategische Verstärkung im Management: Der Münchner Unternehmer Lukas Schwaiger ist als neuer Partner an Bord. Er schließe laut Tuckermann vor allem eine inhaltliche Lücke im Team. „Lukas teilt unsere Vision und Ambition und ist damit eine große Bereicherung für Mietz“, freut sich die Gründerin. Und schiebt den strategischen Mehrwert gleich hinterher: „Zudem bringt er viel operative Expertise aus dem Verkaufssegment ein – dieses Wissen ist wertvoll für die Weiterentwicklung unserer Software Prozesse.“

KI-Tempo vs. Konzernstrukturen

Besonders aufsehenerregend ist die Geschwindigkeit der Produktentwicklung. Dass das neue Marktsegment des Immobilienverkaufs dank des massiven Einsatzes künstlicher Intelligenz von nur drei Personen innerhalb von zwei Wochen aufgebaut wurde, ist eine Kampfansage. Mietz positioniert sich bewusst als schnelle, technologiegetriebene Alternative zu einem Monopol mit 1049 Mitarbeitenden – ein unverhohlener Seitenhieb auf die dominierenden Immobilienportale. In einer traditionell stark von Männern dominierten Immobilienbranche setzt Tuckermann als Female Founder damit ein echtes Ausrufezeichen für agile Softwareentwicklung.

Doch wie viel an den 14 Tagen Entwicklungszeit ist reines KI-Prompting und wie viel echte Programmierarbeit? „Das war ein ambitionierter Plan, aber ich war mir sicher, mit dem aktuellen Tech-Setup schaffen wir das“, blickt Tuckermann zurück. Sie ordnet die Euphorie jedoch realistisch ein: „Der Großteil ist nach wie vor klassisches Coding, die Einzelprozesse werden jedoch durch K-Produkte in einer wesentlich höheren Geschwindigkeit abgewickelt, als vorher.“ Dennoch sei der Sprung gewaltig: „Vor einem Jahr beispielsweise hätten wir mit Coding allein noch viel länger für so ein Produkt gebraucht. Das ist eine riesige Chance für Start-ups in der aktuellen Zeit.“

Diese neuen technischen Möglichkeiten will Mietz nutzen, um gezielt die Schwächen des großen Goliaths anzugreifen. Dieser habe laut der Gründerin in den letzten Jahren durch eine sehr aggressive Preispolitik im Markt viele Teilnehmer verärgert. Zudem liefen viele Prozesse immer noch arbeitsintensiv, intransparent und vor allem ineffizient ab. „Kein Mensch braucht 1.000+ E-Mails pro Vermietung“, kontert Tuckermann scharf. Ihre Kampfansage lautet daher: „Wir sehen die Chance darin, diese Probleme zu lösen und einen Prozess zur Verfügung zu stellen, der fair, kosteneffizient und schnell funktioniert. Ohne eine einzige E-Mail.“

Tinder-Prinzip trifft auf KI und B2B-Effizienz

Der Verkaufsbereich richtet sich wie auch die Vermietung sowohl an Privatpersonen als auch an professionelle Anbieter*innen. Die Plattform digitalisiert sämtliche Schritte der Immobilienvermarktung und soll dadurch Kosten und administrativen Aufwand erheblich reduzieren. Das System basiert auf mehreren technologischen Säulen, die nun auch den Verkauf skalierbar machen sollen.

Um das zu erreichen, setzt Mietz auf eine radikale Vereinfachung der User Experience: Für Suchende adaptiert die Plattform das gelernte Tinder-Prinzip. Nach der einmaligen Anlage einer digitalen Bewerbungsmappe reicht ein simpler Swipe nach rechts, um sich auf passende Objekte zu bewerben. Auf Anbieterseite verspricht die Software dank KI-gestützter Automatisierung eine massive Arbeitserleichterung. So soll die Künstliche Intelligenz selbständig Exposé-Texte basierend auf hochgeladenen Bildern verfassen und diese eigenständig um Mikro- sowie Makrolage-Daten ergänzen.

Flankiert wird dies vom sogenannten Mietz Score: Ein eigens entwickelter Algorithmus wertet Bewerberinnendokumente vollautomatisch aus und zeigt den Anbieterinnen sofort die Passgenauigkeit und Bonität der Interessenten an. Doch Mietz zielt nicht nur auf private Eigentümerinnen ab: Mit einem klaren B2B-Fokus unterstützt die Plattform auch Massenimporte sowie Schnittstellen zu ERP-Systemen, wodurch sich die Lösung ebenso nahtlos für Wohnungsunternehmen, Projektentwicklerinnen und Maklerinnen eignet.

Laut Tuckermann reduziert die digitale End-to-End-Lösung die Kosten um bis zu 80 Prozent und wickelt den Vermietungsprozess im Schnitt doppelt so schnell ab wie übliche Immobilienplattformen.

Zwischen Convenience und Notariat

Der Kauf einer Immobilie ist jedoch eine hochvolumige, oft lebensverändernde Entscheidung. Ob eine schnelle, auf Bequemlichkeit getrimmte UX dem enormen Informations- und Sicherheitsbedürfnis beim Immobilienkauf gerecht wird, muss sich erst noch zeigen. Auf die Nachfrage, wie sie diesem Anspruch gerecht werden wolle, betont die Gründerin: „Gerade bei einer solchen Kauf-Entscheidung geht es um Verlässlichkeit, Sicherheit und Transparenz.“ Man verstehe sich nicht nur als Plattform, sondern als Unterstützer für die Nutzer*innen. Das setze man um, indem nur geprüfte Angebote von seriösen Anbieter*innen gelistet und auch Informationen rund um den Prozess zur Verfügung gestellt werden.

Ein weiteres Nadelöhr ist der in Deutschland zwingend erforderliche Gang zum Notariat. Tuckermann räumt ein, dass die Software in diesem streng regulierten analogen Schritt aktuell noch an juristische Grenzen stößt. „Im Verkauf ist das Vertrauen in der Anbahnung und die Verbindung der richtigen Vertragsparteien ein sehr wesentlicher Prozess. Hierauf konzentrieren wir uns für den Start in diesem Jahr“, erklärt sie die aktuelle Roadmap. Langfristig wolle man die Grenzen aber verschieben: „Im Anschluss geht es darum, den Prozess möglichst weit für den Notar vorzubereiten – etwa durch Features, die den Datenraum automatisch aufbereiten.“

Wo Mietz angreift – und was zum Überleben nötig ist

Der Blick auf die Konkurrenz zeigt, dass Mietz sich auf ein hart umkämpftes Schlachtfeld begibt. Das von Lena Tuckermann erwähnte Monopol mit 1049 Mitarbeitenden ist ein kaum verhüllter Fingerzeig auf den Branchenriesen ImmoScout24. Flankiert von Playern wie Immowelt dominiert dieser das klassische Classifieds-Geschäft. Gleichzeitig tummeln sich im PropTech-Sektor bereits etablierte Start-ups wie McMakler, die den Verkaufsprozess als hybride Makler digitalisieren wollen.

Wie kann und muss sich Mietz in diesem Sandwich aus Milliardenkonzernen und Unicorn-Hoffnungen absetzen? Die Strategie der Berliner ruht dabei auf drei tragenden Säulen. Anstatt wie klassische Immobilienportale überwiegend auf kostenintensive Anzeigenmodelle zu setzen – und damit viel Frustration im Markt zu verursachen –, verfolgt Mietz einen technologiegetriebenen Ansatz. Das Ziel ist es, Immobilientransaktionen und das gesamte Ökosystem rund um die Immobilie als digitales Home Ecosystem völlig neu zu denken.

Um sich zudem die KI-gestützte Preisführerschaft zu sichern, greift das Start-up die teuren Verkaufs-Inserate der klassischen Portale sowie die kostenintensiven Vertriebsteams der Hybrid-Makler an. Mietz setzt als SaaS-Modell stattdessen voll auf KI und Automatisierung, um die Kosten für Anbieter*innen drastisch zu senken. Der dritte entscheidende Hebel gegen die großen Portale ist ein gezielter B2B-Lock-in-Effekt: Durch eine tiefe Integration in die Arbeitsabläufe der Immobilienprofis mittels ERP-Schnittstellen will Mietz für Wohnungsunternehmen langfristig unverzichtbar werden.

Bei der Monetarisierung des Verkaufssegments weicht Tuckermann von reinen Abo-Modellen ab: „Es wird eine Kombination geben“, verspricht sie. „Wir überlassen unseren Nutzern die Wahl, ob sie Mietz in einem pay-per-use Modell nutzen möchten oder als SaaS Abo.“

Der Lackmustest

Lukas Schwaiger ist überzeugt, dass klassische Plattformmodelle in den kommenden Jahren durch technologische Entwicklungen und KI zunehmend an Bedeutung verlieren werden. Dennoch bleibt der Immobilienmarkt ein „Winner-takes-all-Spielfeld“. Platzhirsche verfügen über gewaltige Netzwerkeffekte und Millionen von Seitenbesucher*innen. Eine End-to-End-Lösung muss zwingend genügend Käuferinnen und Verkäuferinnen vereinen, um echte Liquidität im Markt zu schaffen.

Wie will Mietz ohne gigantisches Marketingbudget diese Netzwerkeffekte erzielen? Tuckermann gibt sich hier überaus selbstbewusst: „Beide Parteien sind schon da und kommen aktuell aus dem Markt proaktiv auf uns zu.“ Sie verweist auf die Vorarbeit der letzten Jahre: „Wir haben in den vergangenen Jahren ein starkes Immobiliennetzwerk aufgebaut. Die Produktwünsche hat der Markt klar formuliert.“ Für ihr agiles Team sei die Mission nun simpel: „Für uns geht es jetzt vor allem um deren Umsetzung in hoher, technischer Geschwindigkeit.“

Dass ein 3-Personen-Team nach eigenen Angaben in 14 Tagen ein Verkaufs-Tool baut, beweist beispiellose Agilität. Ob das ausreicht, um hochvolumige Transaktionen von den etablierten Playern abzuziehen, wird die Zukunft zeigen.

Amba: Der Schlüssel zum Digital Detox

Drei Stunden und 19 Minuten – so lange hängen junge Erwachsene täglich auf Social Media, oft völlig unbewusst. Das Kölner Start-up Amba will diesen Scroll-Automatismus nun mit einem simplen haptischen Trick durchbrechen: Ein NFC-Schlüsselanhänger erzwingt eine physische Hürde. Doch kann das Konzept im Alltag wirklich bestehen?

Das 2025 von Yves Maurice Clever und Bastian Fischer gegründete Kölner Start-up Amba positioniert sich mutig im umkämpften Digital-Wellbeing-Markt. Statt auf strenge App-Verbote zu setzen, wollen die beiden 27-Jährigen das unbewusste Dauer-Scrollen auf Social Media mit einem physischen Schlüsselanhänger stoppen. Angesichts einer durchschnittlichen Social-Media-Nutzungsdauer von drei Stunden und 19 Minuten bei jungen Erwachsenen – wovon viel Zeit für rein gewohnheitsmäßiges Scrollen draufgeht – zielt Amba darauf ab, dieses Muster durch eine haptische Hürde zu durchbrechen.

Yves, der in Neuss Marketing studierte, beschäftigt sich schon lange mit digitaler Achtsamkeit, während Bastian als Informatiker das technische Know-how aus der Softwareentwicklung mitbringt. Angetrieben aus dem eigenen Frust über gängige Software-Lösungen, die sich mit wenigen Klicks umgehen ließen, begannen sie im Sommer vergangenen Jahres mit der Produktentwicklung, bevor im Oktober 2025 die offizielle Gründung in Köln folgte.

Haptik schlägt Habit

Doch wie verhindert man, dass der Griff zum NFC-Chip nicht bald zur nächsten unbewussten Gewohnheit wird? „Unbewusstes Scrollen funktioniert so gut, weil alles in derselben Bewegung passiert: Man nimmt das Handy in die Hand und ist sofort in der App“, analysiert Mitgründer Bastian. Ein physisches Element unterbreche genau diesen Automatismus.

Der entscheidende Vorteil gegenüber klassischer Software liege im Timing, so Bastian weiter: „Bildschirmzeit-Limits erscheinen meist erst im Scroll-Moment, wenn viele schon im Autopilot sind und sie reflexartig wegklicken. Bei Amba fällt die Entscheidung vorher.“ Nach dem haptischen Entsperren legen die Nutzer*innen fest, wie viel Zeit sie in der App verbringen möchten. Bastian betont: „Dieser kleine mentale Rahmen macht Social Media wieder zu einer bewussten Entscheidung statt zu einer Gewohnheit.“ Erste Tests scheinen den Gründern recht zu geben: Eigenen Angaben zufolge sei die Social-Media-Nutzung der Tester auf durchschnittlich 49 Minuten pro Tag gesunken.

Das Hardware-Paradoxon und die Konkurrenz

Der Ansatz der „Intentional Friction“ ist clever, doch der Markt verzeiht keine Fehler. Mit dem niederländischen Start-up Unpluq existiert bereits ein etablierter Konkurrent mit einem fast identischen NFC-Konzept. Yves sieht den Unterschied seines Produkts vor allem in der Systematik. „Viele bestehende Lösungen [...] funktionieren nach dem Prinzip: Man hält den Tag ans Smartphone, um Apps zu sperren, und deaktiviert die Sperre später wieder. Wir haben die Logik umgedreht“, kontert Yves. Bei Amba seien die Apps standardmäßig gesperrt und würden erst durch den Schlüssel freigeschaltet.

Zudem wolle man sich über eine extrem niedrige Einstiegshürde abheben: „Deshalb kostet der physische Tag bei uns nur einen symbolischen Euro und Nutzer können Amba zwei Wochen lang testen“, erklärt Yves den aggressiven Markteinstieg.

Der Kampf gegen die Abo-Müdigkeit

Dennoch muss sich Amba langfristig beweisen, insbesondere da laut einer ExpressVPN-Umfrage 38 Prozent der Konsument*innen explizit unter „Abo-Müdigkeit“ leiden. Ob die Nutzerschaft dauerhaft bereit ist, knapp 20 Euro im Jahr für einen softwarebasierten Verzicht zu zahlen, bleibt abzuwarten.

Bastian räumt offen ein: „Mit den physischen Tags verdienen wir tatsächlich kein Geld, sie decken lediglich die Produktionskosten.“ Er ist jedoch überzeugt, dass die Abo-Investition für die Nutzer*innen unverzichtbar bleibt, da das Suchtpotenzial der Apps nicht verschwinde. „Social-Media-Plattformen sind bewusst so gestaltet, dass sie möglichst lange Aufmerksamkeit binden. Viele Nutzer berichten uns, dass sie nach kurzer Zeit wieder in alte Muster zurückfallen, sobald sie die Unterstützung entfernen“, warnt Bastian. Das Ziel sei daher keine einmalige „Detox“-Kur, sondern ein Rahmen, um die Nutzung „langfristig kontrollierter zu gestalten“.

Technischer Flaschenhals zum Start

Erschwerend kommt aktuell ein stark restriktives System hinzu: Durch die Begrenzung auf das Betriebssystem iOS 18 bleiben der gesamte Android-Markt sowie Besitzer*innen älterer Apple-Geräte vorerst kategorisch ausgeschlossen. „Die aktuelle Einschränkung auf neuere iOS-Versionen hat vor allem technische Gründe“, verteidigt Yves diesen harten Schnitt. Einige NFC-Funktionen liefen auf älteren Systemen schlichtweg noch nicht stabil genug. Eine Android-Version sei geplant, befinde sich aber noch nicht in der Entwicklung.

Und was passiert, wenn man den rettenden Chip zu Hause vergisst und komplett blockiert ist? Yves beschwichtigt: Für solche Fälle gebe es eine Notfallfunktion in der App, die eine temporäre Entsperrung erlaube. Er verspricht: „Amba soll eine bewusste Hürde schaffen, aber keine Situation, in der Nutzer komplett von ihrem Smartphone abgeschnitten sind.“

Letztlich wandert das Kölner Start-up auf dem schmalen Grat zwischen Achtsamkeit und Deinstallation. Der Erfolg steht und fällt mit dem Hardware-Paradoxon: Nur wenn die Community den Schlüsselanhänger langfristig als befreiendes Werkzeug und nicht als frustrierende Barriere wahrnimmt, wird sich das subventionierte Abo-Modell gegen die Platzhirsche rentieren.

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Better Sol: Zweites Leben für die Solarwende

Wie das 2023 von Mirko Laube und Luisa Schulze gegründete Start-up Better Sol den PV-Gebrauchtmarkt aufmischen will.

Das Braunschweiger Start-up Better Sol erhält rund 125.000 Euro Förderung aus dem „Green Startup“-Programm der Deutschen Bundesstiftung Umwelt (DBU), um gebrauchte Solarpaneele in großem Stil zurück in den Markt zu bringen.

Hinter dem Start-up stehen Luisa Schulze und Mirko Laube. Better Sol entstand ursprünglich im Sommer 2022 als Ausgründung des Magdeburger Recycling-Unternehmens Solar Materials und agiert seit 2023 als eigenständige GmbH am Standort Braunschweig. Während sich die ehemalige Muttergesellschaft auf das komplexe werkstoffliche Recycling von Modulen konzentriert, widmet sich Better Sol voll und ganz dem „Second Life“ – also der direkten Wiederverwendung der noch intakten Platten.

KI-gestützte Prüfung statt Schredder

Die Beschaffungsseite von Better Sol zielt primär auf große Solarparks ab. Die Betreiber tauschen dort häufig größere Mengen an Solarmodulen recht früh in ihrem Lebenszyklus durch neuere, leistungsstärkere Modelle aus. Um diese Module vor dem Müll zu bewahren, hat das Better-Sol-Team mittels DBU-Förderung ein in Teilen automatisiertes Testsystem mit eigener Software auf Basis künstlicher Intelligenz (KI) entwickelt.

Der Prüfprozess beginnt mit einer mehrstufigen optischen Untersuchung, bei der sowohl grobe Beschädigungen als auch jede Solarzelle einzeln begutachtet werden. Im Anschluss folgen eine eingehende Prüfung der elektrischen Sicherheit sowie eine Leistungsüberprüfung, die misst, wie viel Watt das Produkt im Vergleich zur ursprünglichen Leistung noch liefert. Die Software führt all diese Daten automatisiert zu einer detaillierten Leistungsprognose zusammen. Jedes funktionstüchtige Modul erhält ein Label mit den Testdaten, einer zugewiesenen Leistungsklasse und einem umfangreichen Prüfprotokoll. Nur der endgültige Rest wird zum Recycling aussortiert. Der Vertrieb erfolgt direkt über die Internetseite von Better Sol. Zielgruppe sind oft Privathaushalte oder die Dächer größerer Fabrikhallen.

Der Markt und die Technologie im Wettbewerbsvergleich

Nach Angaben des Statistischen Bundesamtes verbucht die Photovoltaik mittlerweile einen Anteil von etwa 24 Prozent und ist damit der zweitwichtigste Energieträger der inländischen Stromerzeugung. Das Reservoir an ausgemusterten, aber noch funktionierenden Modulen wächst rasant. Laut Schulze ist im Schnitt jedes zweite gebrauchte Solarmodul noch für eine erneute Nutzung geeignet. Doch der Gebrauchtmarkt professionalisiert sich zusehends.

Better Sol setzt aktuell auf eine pragmatische, KI-gestützte Teilautomatisierung und plant als nächsten logischen Entwicklungsschritt eine mobile Testanlage, um die Solarmodule direkt dort zu testen, wo sie ausgemustert werden. Genau in diesem logistisch entscheidenden Bereich der Vor-Ort-Prüfung operiert bereits der etablierte Wettbewerber 2ndlifesolar, eine Marke der großen Buhck Gruppe. 2ndlifesolar greift auf ein deutschlandweites Logistiknetzwerk zurück und kombiniert stationäre Erstbehandlungsanlagen mit mobilen Prüflaboren. Technologisch geht das Unternehmen tief in die industrielle Qualitätssicherung und führt standardmäßig Elektrolumineszenz-Prüfungen durch, um unsichtbare Mikrorisse im Vorfeld zu detektieren.

Einen völlig anderen, stark hochskalierten Weg bestreitet das österreichische CleanTech-Start-up 2nd Cycle. Das Unternehmen betreibt eine vollautomatische Inspektions- und Upcycling-Anlage im industriellen Hochdurchsatz und nutzt neben klassischer Robotik auch patentierte hyperspektrale Analysen aus der Raumfahrt, um Zellalterungen frühzeitig zu erkennen.

Der Schlüssel zum wirtschaftlichen Erfolg

Das Vorhaben von Better Sol leistet einen fundamentalen Beitrag, um noch leistungsfähige Materialien durch geschickte Kreislaufwirtschaft für eine Weiternutzung zu erhalten, damit die Bemühungen für mehr erneuerbare Energien nicht ins Stocken geraten. Dennoch muss sich das Geschäftsmodell in einem harten Wettbewerb beweisen.

Die Handwerkerkosten für den Aufbau einer PV-Anlage auf einem Eigenheim sind hoch und fallen völlig unabhängig davon an, ob man neue oder gebrauchte Paneele installiert. Gleichzeitig steht der Markt unter enormem Preisdruck durch historisch günstige asiatische Neuware. Wenn fabrikneue Module extrem billiger werden, schwindet das Argument der finanziellen Ersparnis bei Gebrauchtmodulen mit kürzerer Restlebensdauer. Der Schlüssel zum wirtschaftlichen Erfolg von Better Sol liegt daher in der rigorosen Minimierung der eigenen Logistik- und Prozesskosten. Die geplante mobile Testanlage und die zusätzliche Automatisierung des Testsystems sind für das Start-up essenziell, um künftig auch größere Ausmusterungen von Solarparks wirtschaftlich bewältigen zu können.

Die Müsli-Macher und die Kälte: Das neue Millionen-Projekt von Kraiss & Mahler

Dass sie Märkte revolutionieren können, haben die Freda-Gründer bereits bewiesen – nun steht die Tiefkühlkette auf dem Prüfstand. Mit einem mutigen Modul-Konzept fordern Philipp Kraiss und Christian Mahler die Industrie-Riesen im Supermarktregal heraus.

In der Start-up-Welt ist der Begriff Seriengründer*in oft ein zweischneidiges Schwert: Das Vertrauen der Investor*innen ist hoch, doch die Fallhöhe nach einem Erfolg wie mymuesli ebenso. Philipp Kraiss und Christian Mahler haben sich mit ihrem 2023 gegründeten Food-Start-up Freda bewusst gegen ein „Me-too-Produkt“ und für eine operative Wette auf die Zukunft der Tiefkühlkette entschieden. Mit einem mutigen Modul-Konzept fordern sie die etablierten Industrie-Riesen im Supermarktregal heraus. Die Prämisse: Der Markt für Tiefkühlkost (TK) wächst – auf über 22,6 Milliarden Euro im Jahr 2024 –, ist aber durch extremen Preisdruck und eine veraltete Produktlogik geprägt. Wir haben uns das Geschäftsmodell näher angesehen und die Gründer dazu befragt.

Pizza, Pasta, Gelato … und jetzt Blocks?

Die Pizza „Salami Sensation“ war für Freda der Türöffner. Mit dem Sieg bei Stiftung Warentest (2024) bewies das Team, dass es Qualität „kann“ und schuf einen starken USP. Strategisch ist Pizza jedoch kein leichtes Feld: Der Wettbewerb ist anspruchsvoll, die Regalplätze im Einzelhandel sind besetzt und die Differenzierung erfolgt meist über den Preis. Mit einer Innovation wie „Frozen Blocks“ erweitert Freda nun das Spielfeld und eröffnet eine neue Kategorie von Tiefkühlkost.

Es handelt sich dabei nicht mehr um ein fertiges Gericht, sondern um eine Systemkomponente. Das Konzept orientiert sich am gastronomischen „Mise en Place“: Vorbereitete, schockgefrostete Komponenten wie Beef Ragù oder Chili sin Carne fungieren als Basismodule für die heimische Küche. Strategisch gesehen erhöht dies die Wertdichte pro Kubikzentimeter im TK-Fach und verringert die Komplexität in der eigenen Produktion im Vergleich zu mehrkomponentigen Fertigmenüs.

Auf die Frage, ob der strategische Wechsel von der Pizza zu den „Frozen Blocks“ eine Flucht aus dem Commodity-Preiskampf der Pizza-Truhe hin zu einer proprietären Nische sei, widerspricht Philipp Kraiss. Vielmehr handele es sich um einen konsequenten Ausbau des Sortiments, denn Freda solle künftig den gesamten Alltag der Kund*innen abbilden – vom Frühstück bis zum Abendbrot. Das sei eben mehr als nur Pizza. „Unser Anspruch ist aber nicht nur Bekanntes besser zu machen – wie bei unserer Pizza, sondern auch neue Wege zu gehen“, stellt der Gründer klar. Die flexiblen Module seien auf diesem Weg der nächste logische Schritt. Er verspricht dabei maximale Vielfalt aus dem Gefrierfach, „denn jeder Block lässt sich vielfältig kombinieren.“

Die Retail-Herausforderung: Kaufland als Stresstest

Mit einer Basis von über 30.000 D2C-Kund*innen hat das Unternehmen bereits bewiesen, dass die Nachfrage nach seinen Produkten besteht. Um dieses Potenzial voll auszuschöpfen und die Margen zu stärken, wurde im August 2025 der Launch in 780 Kaufland-Märkten umgesetzt – ein strategischer Meilenstein, der die Reichweite massiv erhöht und über das Volumen des stationären Einzelhandels den Weg zu nachhaltigem, profitablem Wachstum ebnet – ohne aufwendigen Versand mit Isolierung und Trockeneis.

Hier zählt nun die Shelf Velocity (Abverkaufsgeschwindigkeit). Ein modulares System erfordert von der Kundschaft jedoch ein Umdenken: Man kauft kein fertiges Abendessen, sondern eine Zutat. Freda muss hier beweisen, dass der Mehrwert der Zeitersparnis am Point of Sale verstanden wird, bevor die harten Auslistungsmechanismen des Handels greifen.

Doch wie überzeugt man eine*n Einkäufer*in davon, dass ein modulares System mehr Flächenproduktivität bringt als die zehnte Sorte Standard-Lasagne? Christian Mahler kontert auf diese Retail-Frage mit einem anschaulichen Branchen-Vergleich: „Wir sind eben nicht die zehnte Lasagne. Eine klassische TK-Lasagne belegt viel Regalfläche, bedient genau einen Anlass und konkurriert mit neun anderen Lasagnen um denselben Kunden.“ Durch das kompakte Format und eine maximale SKU-Dichte der Blocks könne der Händler auf derselben Regalfläche mehrere Sorten listen und spreche damit dutzende Zubereitungsarten von der Bowl bis zum Curry an. Mahler zeigt sich selbstbewusst: „Wir eröffnen eine neue Kategorie statt in einer bestehenden zu kämpfen.“

Operative Exzellenz vs. bayerisches Handwerk

Ein weiterer Spagat wartet in der Produktion: Freda wirbt offensiv mit „Made in Bavaria“ und handwerklicher Herstellung. In der Start-up-Praxis beißt sich Handwerk jedoch oft mit Skalierung. Wer bundesweit fast 900 Supermärkte bedient, muss industrielle Prozesse beherrschen. Die Gefahr dabei ist offensichtlich: Wenn die Qualität durch die Masse sinkt, verliert Freda seinen wichtigsten USP. Gleichzeitig bleibt bei der exklusiven Zielgruppe, die bereit ist, für TK-Komponenten Premium-Preise zu zahlen, in Zeiten der Inflation die Frage der Preissensibilität bestehen.

Auf drohende Kapazitätsgrenzen angesprochen, räumt Philipp Kraiss ein, dass die Passauer Manufaktur zwar das Herzstück bleibe. „Aber wir waren von Anfang an ehrlich zu uns selbst: Eine Manufaktur skaliert nicht linear“, gibt der Seriengründer zu bedenken. Mit wachsendem Geschäft müsse man die Produktion auf breitere Schultern stellen und mit Partnern zusammenarbeiten. Sein Kernversprechen an die Kund*innen lautet dabei jedoch: „Wir lagern nicht die Rezeptur aus, sondern die Kapazität.“

Marktpsychologie: Convenience ohne Reue

Psychologisch besetzt Freda damit eine überaus geschickte Lücke. Die „Frozen Blocks“ nehmen der Käuferschaft zwar die Entscheidung für die aufwendige Kernkomponente ab, lassen das Gefühl des Selbstkochens durch das frische Ergänzen von Beilagen jedoch vollkommen intakt. Dies eliminiert die oft vorhandene „Convenience-Scham“ gesundheitsbewusster Zielgruppen und könnte die Lösung für die stagnierenden Marktanteile klassischer Fertiggerichte bei jüngeren Konsument*innen sein.

Fazit für die Start-up-Praxis

Freda ist ein Lehrstück für den Übergang von einer digitalen D2C-Brand zum Player im Massenmarkt. Die Gründer nutzen ihre Erfahrung, um eine etablierte Kategorie neu zu denken. Ob die Rechnung aufgeht, wird sich an der Regal-Rotation zeigen. Wenn die Kund*innen den Aufpreis für die „bayerische Handarbeit“ und das modulare System dauerhaft akzeptieren, könnte Freda die Blaupause für die nächste Generation von Food-Marken liefern.

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

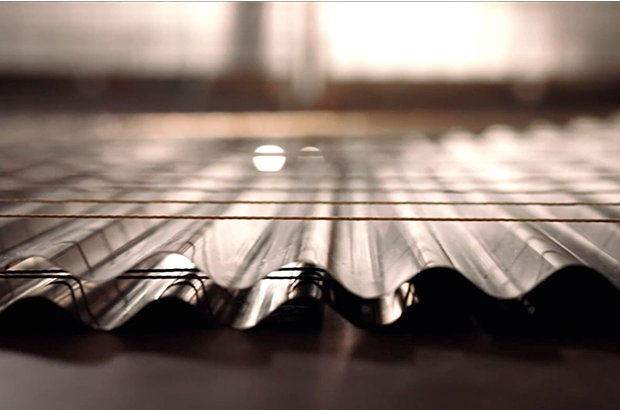

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Agentic AI als Erfolgsgrundlage für Start-ups

KI befeuert den aktuellen Gründungsboom, doch für eine erfolgreiche Skalierung braucht es mehr. Warum Agentic AI auf Basis einer soliden Datenarchitektur zum entscheidenden Erfolgsfaktor für Start-ups wird.

Das Jahr startete für Start-ups mit einer Rekordmeldung: In Deutschland wurden im vergangenen Jahr fast ein Drittel mehr Gründungen verzeichnet. In absoluten Zahlen wurden 2025 insgesamt 3.568 neue Firmen geschaffen – ein neuer Höchststand, wie der Start-up-Verband im Januar verkündete. Dies ist auch der künstlichen Intelligenz (KI) zu verdanken, wie sich beim genauen Hinschauen herausstellt. 853 dieser neuen Unternehmen kommen aus dem Bereich Software. Doch nicht nur sie verwenden KI; bei einer Umfrage gab ein Drittel aller Gründer und Gründerinnen an, dass sie mit KI arbeiten. Dementsprechend sehen die Sprecher des Verbands in der Technologie auch die treibende Kraft hinter dem Start-up-Rekord.

Wirft man einen Blick über den Tellerrand hinaus, so lässt sich feststellen, dass die Start-up-Szene in Europa insgesamt floriert. Der „State of European Tech 2025“-Report im Auftrag von Atomico und anderen schätzt, dass im letzten Jahr Investitionen in Höhe von 44 Milliarden US-Dollar (umgerechnet ca. 38 Mrd. EUR) in diesen Sektor geflossen sind. Geldgeber erwarten inzwischen, dass Start-ups mit KI und Deep Tech arbeiten, so der Report. Demnach flossen auch 36 Prozent der europäischen Start-up-Investitionen in genau diese beiden Felder.

Das Gründungsumfeld könnte also kaum besser sein. Doch ein Rekord an Start-ups und steigende Investitionssummen bedeuten nicht zwangsläufig auch eine einfache Skalierung der Geschäftsmodelle. Viele – zu viele – Start-ups scheitern nach erfolgreichen ersten Jahren an der Weiterentwicklung ihres Geschäfts. Neben einer Reihe üblicher Herausforderungen stehen vor allem Bürokratie, Fragen zur Datenhoheit und ein Betrieb über Landesgrenzen und Wirtschaftszonen hinweg im Vordergrund. Start-ups müssen nachweisen, dass ihre Nutzung von KI auf soliden, regulierten Datenfundamenten basiert und den Compliance-Vorgaben entspricht.

Hier kommt Agentic AI ins Spiel. Die Einbettung von KI-Agenten in den Kern der Betriebsabläufe ist die Antwort auf viele dieser Herausforderungen und wird für das Wachstum im Jahr 2026 von entscheidender Bedeutung sein.

Solide Datenbasis vor KI-Einsatz

Start-ups, die dies erreichen wollen, sollten sich darauf konzentrieren, ihre KI-Nutzung auf einer soliden Datenbasis aufzubauen, deren Fundament eine einheitliche Datenarchitektur ist. Sie tun sich deutlich leichter damit, die dafür nötigen Architekturentscheidungen zu treffen, als etablierte Unternehmen mit entsprechender Legacy-IT. Gründer und Gründerinnen sollten daher von Beginn an darüber nachdenken, wie sie eine starke Datenarchitektur aufsetzen, Silos abbauen und KI als Herzstück ihrer Prozesse einbetten.

Diese Grundlage hilft bei der Einführung von KI-Agenten, damit deren Output auch die Erwartungen erfüllt: Geschäftsprozesse effizienter zu strukturieren und zu optimieren sowie die Entscheidungsfindung zu beschleunigen. Start-ups, die dies umsetzen, werden sich gegen ihre Konkurrenten durchsetzen und letztlich erfolgreich sein.

KI-Agenten als Innovationsbeschleuniger

Indem Start-ups KI-Agenten von Beginn an in den Kern ihrer Geschäftsabläufe integrieren, skalieren sie schneller als mit dem Einsatz von nur einem reinen Large Language Model (LLM). Der Grund dafür liegt in der Standardisierung der Daten, die für KI-Agenten notwendig ist. Auf dieser Grundlage können die Agenten ihre einzigartigen, autonomen Fähigkeiten ausspielen, da sie mit unternehmenseigenen Daten trainiert werden. Vor allem bei Start-ups können Potenziale schnell gehoben werden: Wenn Agenten für bestimmte Aufgaben entwickelt werden, können sie diese auch lösen – egal wie komplex und fachspezifisch sie sein mögen. Stimmt die Datenbasis, lassen sich auch mehrere Agenten miteinander verknüpfen, um sogar noch komplexere Herausforderungen zu bewältigen.

Ein Beispiel dafür ist die mögliche Kooperation zwischen einem Kundensupport-Agenten und einem Prognose-Agenten. Wenn ein Kunde einen Support-Fall auslöst, kann der andere Agent sogleich die Kosten berechnen, was die Kundenzufriedenheit durch eine schnellere Reaktion steigern kann. Für die Skalierung von Start-ups ist ein enges Zusammenspiel der Abteilungen wichtig, um die Geschäftsbeziehungen zu zufriedenen Kunden weiter ausbauen zu können. Der Einsatz von KI-Agenten kann, gepaart mit dem menschlichen Element, begrenzte personelle Ressourcen ausgleichen und eine bessere Serviceleistung ermöglichen, was für ein schnelles Wachstum unabdingbar ist.

Doch nicht nur der Kundenkontakt lässt sich automatisieren, sondern auch eine ganze Reihe von Routinevorgängen in der internen Verwaltung der Firmen selbst. Dies ermöglicht nicht nur dem Management, sondern auch den Investoren, schnell einen fundierten Überblick über Liquidität, Umsatz, Einnahmen und Gewinn zu erhalten. Die Erkenntnisse in Echtzeit führen zu schnellen und datenbasierten Entscheidungen, was für junge Unternehmen Gold wert ist und es ihnen ermöglicht, flexibel zu bleiben.

Die Datenbasis muss stimmen

Für Start-ups sind Probleme beim Datenzugriff ein kritisches Risiko für den Geschäftserfolg. Eine einheitliche, moderne Datenarchitektur ermöglicht die Demokratisierung des Datenzugriffs und löst Datensilos auf. Der Vorteil liegt auf der Hand: Schneller Datenzugriff schafft Transparenz gegenüber Kunden und Aufsichtsbehörden. Darüber hinaus erhöht dies auch das Vertrauen der Mitarbeitenden und schafft ein Gefühl des Zusammenhalts.

Governance ist auch bei der Verwendung von KI-Agenten von entscheidender Bedeutung. Der Druck zur Einhaltung von Vorschriften sollte daher als Vorteil betrachtet werden.

Der Dreiklang aus Datenherkunft, Versionierung und automatisierter Auswertung der Ergebnisse hilft jungen Unternehmen dabei, Governance auf einem soliden Fundament aufzubauen. Die Teams erhalten direkte Transparenz darüber, wie sich die KI-Agenten verhalten, auf welchen Daten sie basieren und wie sie ihre Ergebnisse im Laufe der Zeit verändern. Laufende Bewertungen tragen dazu bei, dass KI-Agenten präziser werden, um genau jene hochwertigen Ergebnisse zu liefern, die Start-ups für die Skalierung ihrer Geschäftsmodelle benötigen. Dies ist besonders wichtig, wenn proprietäre KI-Modelle entwickelt und von der Testphase in die Produktion überführt werden, wobei gesetzliche Vorschriften wie die DSGVO oder der EU AI Act zwingend einzuhalten sind.

Parloa, ein deutsches Start-up-Unternehmen mit einer Bewertung von drei Milliarden US-Dollar, ist ein hervorragendes Beispiel dafür, wie dieser Ansatz in der Praxis aussehen kann: Das Unternehmen hat KI-Agenten zum Kern seines Kundenservice gemacht und gleichzeitig eine einheitliche, kontrollierte Datenbasis aufgebaut, die vollständig mit der DSGVO und dem EU AI Act konform ist. Seine Plattform folgt den Prinzipien des „Privacy by Design“, sodass sensible Kundendaten ohne Kontrollverlust verwendet werden können. Durch die Verwaltung des gesamten Lebenszyklus von KI-Agenten macht Parloa Governance zu etwas Greifbarem und gibt den Teams Klarheit darüber, welche Daten verwendet wurden, wie sich die Agenten verhalten haben und wie sich die Ergebnisse im Laufe der Zeit entwickelt haben. Diese Kombination aus moderner Architektur und starker Governance ermöglicht es den Kunden von Parloa, Zugang zu hochwertigen Daten zu erhalten und die Transparenz für Regulierungsbehörden sowie Endnutzer zu erhöhen – und dennoch KI-gesteuerte Kundeninteraktionen in Umgebungen zu skalieren, in denen Fehler oder Missbrauch inakzeptabel sind.

Fazit

KI-Agenten bieten europäischen Start-ups eine einmalige Gelegenheit, schnell zu wachsen und gleichzeitig Investoren anzuziehen, die bekanntermaßen ihr Geld bevorzugt in Unternehmen investieren, die Wert auf Datenverwaltung, Genauigkeit, Qualität und die Schaffung von echtem Mehrwert durch Technologie legen. Es ist jedoch ein Fehler, sich ohne sorgfältige Überlegungen auf die Einführung von Agenten zu stürzen. Start-ups, die KI-Agenten einsetzen, ohne zuvor eine einheitliche Datenbasis aufzubauen und eine solide Verwaltung sowie Bewertung sicherzustellen, riskieren, mehr Komplexität als Mehrwert zu schaffen. Letztlich werden jene Gründer und Gründerinnen erfolgreich sein, die ihre Geschäftsmodelle branchen- und länderübergreifend skalieren können – hierbei spielt der Einsatz von KI-Agenten bereits jetzt eine entscheidende Rolle.

Der Autor Nico Gaviola ist VP Digital Natives & Emerging Enterprise bei Databricks EMEA.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

Rouge: Vom Tabu zum Geschäftsmodell

Die Menstruation ist ein Milliardenmarkt – und dennoch oft unsichtbar. Das von Tina Frey und Patrick Gsell gegründete Start-up Rouge bricht mit diesem Muster. Was Ende 2022 als Vision in der Schweiz begann, hat sich durch geschickte Positionierung und Expansion nach Deutschland zu einem ernstzunehmenden Player im FemTech-Bereich entwickelt.

Die Grundidee von Rouge ist so simpel wie strategisch klug: Statt die Menstruation zu verstecken, wird sie zum sichtbaren Lifestyle-Element. „Mich hat fasziniert, wie sehr die Menstruation unseren Alltag beeinflusst und wie konsequent wir trotzdem darüber schweigen“, erklärt Mitgründerin Tina Frey. „Bald wurde mir klar: Das ist ein gesellschaftliches Problem.“ Dass dieser Ansatz einen Nerv trifft, zeigt der rasche Aufstieg des Unternehmens. Durch gezielte Medienarbeit gelang es dem Team, das Thema aus der Nische in den Mainstream zu heben – Tina Frey positioniert sich dabei konsequent nicht nur als Unternehmerin, sondern als Expertin für Frauengesundheit.

Differenzierung im "Red Ocean"

Im Zentrum der Marke steht der Rouge-Drink, ein Pulver-Supplement mit Eisen, Vitamin B12 und Granatapfel. Doch der eigentliche USP liegt nicht in den Inhaltsstoffen, sondern in der Inszenierung. Die transparente Flasche mit der roten Flüssigkeit fungiert als bewusstes „Statement-Piece“.

Hier gelingt dem Start-up ein entscheidender Schachzug im wachsenden Markt für Zyklusgesundheit: Während Wettbewerber wie FEMNA oder MYLILY auf funktionale Nahrungsergänzung in diskreter Kapselform setzen, inszeniert Rouge die Einnahme als genussvollen Wellness-Moment. Gleichzeitig emanzipiert sich das Duo von den „lauten“ Tabubrechern der Branche wie The Female Company: Rouge setzt weniger auf Provokation durch Hygieneartikel, sondern transformiert die Linderung von Regelbeschwerden von einer medizinischen Notwendigkeit in eine „ästhetische Selbstverständlichkeit“.

„Sichtbarkeit verändert Verhalten“, so Tina Frey. „Die Flasche macht den Zyklus im Alltag sichtbar und löst Gespräche aus. Noch wichtiger: Viele Frauen erleben dadurch eine neue Selbstverständlichkeit und mehr Selbstbewusstsein.“ Dieser Social-Impact-Gedanke ist fest im Geschäftsmodell verankert: Ein Teil der Erlöse fließt in Aufklärungsprojekte. „Sozialer Impact ist kein Marketing-Trick, sondern eine Notwendigkeit“, ergänzt Co-Founder Patrick Gsell. „Gleichzeitig braucht es wirtschaftliche Stabilität, um langfristig bestehen zu können.“

Diverse Kompetenzen als Wachstumstreiber

Hinter der Marke steht ein komplementäres Gründungs-Duo. Tina Frey bringt als Marketing-Expertin das kommunikative Rüstzeug mit, während Patrick Gsell – seit über 20 Jahren Geschäftsführer eines Softwareunternehmens – die strategische Struktur und Skalierungserfahrung liefert. Patrick Gsell, der 2022 den Bund-Essay-Preis gewann, liefert zudem den intellektuellen Unterbau. „Die Hälfte der Menschheit erlebt die Menstruation. Trotzdem betrifft sie die ganze Gesellschaft und nicht zuletzt das Verständnis zwischen Mann und Frau. Genau deshalb finde ich es so spannend, mit Rouge am Anfang eines gesellschaftlichen Wandels zu stehen“, so Patrick Gsell.

Expansion mit lokaler Strategie

Nach der Etablierung auf dem Schweizer Heimatmarkt erreichte Rouge im Herbst 2025 den nächsten Meilenstein: den Markteintritt in Deutschland. Anders als bei reinen Export-Modellen setzt das Start-up hierbei auf lokale Strukturen und Partner vor Ort. „Der deutsche Markt bietet großes Potenzial, aber jede Gesellschaft tickt anders“, begründet Tina Frey den Schritt. Das Ziel bleibt grenzüberschreitend gleich: Die Menstruation soll kein Nischenthema bleiben, sondern als normaler Teil der weiblichen Gesundheit akzeptiert werden – sichtbar gemacht durch eine rote Flasche, die den Dialog eröffnet.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

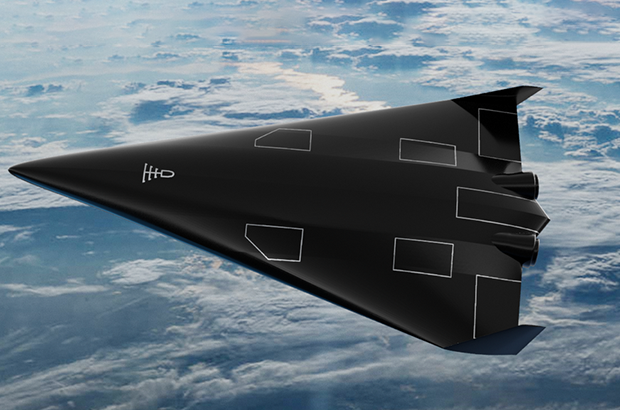

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

Wie viel verdienen Twitch Streamer wirklich? Zahlen und Verdienstmöglichkeiten im Blick

Wer als passionierter Spieler noch nicht an eine Gaming Karriere gedacht hat, sollte dies jetzt nachholen: Schließlich ergeben sich aus dieser von Esport-Turnieren bis hin zum Streaming einige Verdienstmöglichkeiten. Creatoren verdienen mit der Echtzeit-Übertragung ihres Spielerlebnisses Geld. Was sich einfach anhört, kann für so manchen Spieler auch zum komplexen Unterfangen werden. Wie hoch der Streamer Verdienst in diesen Fällen ausfällt und welche Einnahmemöglichkeiten es für Twitch Streamer noch gibt, erfahren Sie hier.

Die Top 10 Twitch Streamer im Jahr 2025

„Es gewinnt nicht der beste Spieler, sondern der beste Entertainer.“ |

Auf Plattformen wie Twitch gilt: Die Community beeinflusst stark, wie viel Geld Streamer verdienen können. Wer eine starke Zuschauergemeinde aufbauen kann, freut sich in der Regel über ein höheres Einkommen – dabei spielt vor allem die Interaktion der Viewer eine zentrale Rolle.

Aktuell weisen diese top 10 Twitch Channels die höchsten Zuschauerzahlen vor:

Streamer | Durchschnittliche Zuschauerzahl | Follower |

126.449 | 19,8 Millionen | |

52.024 | 7,9 Millionen | |

46.844 | 3,3 Millionen | |

36.903 | 2,2 Millionen | |

29.320 | 2,2 Millionen | |

71.045 | 1,5 Millionen | |

31.839 | 1,5 Millionen | |

42.837 | 1,4 Millionen | |

34.996 | 1,1 Millionen | |

30.438 | 993.817 |

Geld verdienen mit Streaming: Diese Faktoren wirken sich auf Twitch Einnahmen aus

Die Twitch-Einnahmen der verschiedenen Streamer setzen sich aus unterschiedlichen Verdienstquellen zusammen. So können die Kontoinhaber Werbung in ihren Live-Übertragungen schalten, die ihnen je nach Zuschauerzahl und Länge der Werbepause einen kleinen bis mittleren Betrag einbringen. Hierbei handelt es sich jedoch um ein eher statisches Nebeneinkommen, das die meisten Streamer auch als nebensächlich empfinden. Den größeren Teil des Twitch Einkommens machen Abonnements und Spenden der Zuschauer aus, aber auch Sponsoring und Markenpartnerschaften.

Übrigens: Twitch Auszahlungen erfolgen automatisch via PayPal oder Banküberweisung, sofern ein gewisser Mindestbetrag erreicht wurde. In diesem Zusammenhang bieten mobile casinos, ähnlich wie Streaming-Plattformen, eine bequeme Möglichkeit für Spieler, jederzeit und überall zu spielen, ohne auf traditionelle Zahlungsmethoden angewiesen zu sein. Diese Art von Plattformen hat sich zu einer beliebten Option entwickelt, da sie den Nutzern schnelle Auszahlungen und einfache Handhabung bieten.

Twitch Daten Leak 2021: Das verdienen Top-Streamer

Ende 2021 wurde die bekannte Plattform Twitch gehackt. Bei einem Datenleck kam heraus, dass die 2014 von Amazon gekaufte Plattform kaum Sicherheitsvorkehrungen geschaffen hatte – weshalb große Teile des Programmiercodes sowie Login-Daten und Zahlen zum Streamer Verdienst veröffentlicht werden konnten. Zu sehen waren vor allem die Gesamteinnahmen der Top Spieler aus den Twitch Statistiken des Zeitraumes August 2018 bis Oktober 2021 in US-Dollar:

- CriticalRole: 9,6 Millionen

- xQc: 8,5 Millionen

- summit1g: 5,8 Millionen

- Tfue: 5,3 Millionen

- Nickmercs: 5,1 Millionen

Zum Vergleich: Der deutsche Twitch Streamer Marcel Eris (alias MontanaBlack88) hat über Twitch 2,4 Millionen US-Dollar eingenommen. Der Streamer MontanaBlack88 gehört zu den bestbezahlten deutschen Spielern auf Twitch.

Damit werden die großen Unterschiede zwischen den Verdiensten der Streamer aus Deutschland und den USA deutlich. Rund vier Millionen Deutsche verfolgen Twitch-Übertragungen – und das sogar täglich. In den USA liegt die tägliche Zuschauerzahl bei stolzen 35 Millionen Nutzern, sodass amerikanische Streamer auch einen deutlich größeren Markt bedienen und die Einkommensunterschiede nicht verwunderlich sind. MontanaBlack88 ist allerdings auch auf anderen Plattformen wie YouTube zu finden, sodass sein Gesamtverdienst womöglich deutlich höher liegt.

Gut zu wissen: Twitch Partner (von Twitch ausgewählte Streamer mit qualitativem Content) können sich über höhere Einnahmen freuen – etwa einen höheren Anteil aus dem Abonnenten-Verdienst.

Im Detail: So setzt sich der Verdienst zusammen

Wie eingangs erwähnt, verdienen Twitch Streamer vor allem durch Abonnenten einen großen Teil ihres Einkommens. Das Abonnement kostet Subscribern in der ersten Stufe 4,99 Euro – wovon Streamer in der Regel 50% (2,50 Euro) behalten dürfen. Dafür erhalten Abonnenten bestimmte Vorteile wie etwa die Möglichkeit, per Chat mit dem Streamer interagieren zu können. Wer also 1.000 Abonnenten hat, kann deshalb schon mit Einnahmen von 2.500 Euro monatlich rechnen.

Einen Großteil ihrer Einnahmen generieren Gaming-Streamer aber auch mit Hilfe von Subscriber-Spenden. Diese werden in Twitch Bits genannt und von der Plattform ausgezahlt. Die Spenden rufen bei einigen Streamern emotionale Reaktionen hervor, was wiederum mehr Menschen zum Spenden anregt.

Eine weitere Möglichkeit stellt Affiliate-Marketing dar: Streamer bewerben in dem Fall für ihre Zuschauer interessante Produkte in ihren Videos. Kaufen Zuschauer die Produkte, profitieren Streamer von einer Provision – die nicht selten 30% des Kaufbetrages ausmacht.

Sponsoren und Markendeals als größte Einnahmequelle für Streamer

An Streamer mit besonders hohen Zuschauer- und Followerzahlen treten oft auch bekannte Marken heran. Sie bezahlen die Gamer dafür, ihre Produkte im Live-Stream anzupreisen – beispielsweise Gaming-Peripherie oder Energy-Drinks. Soll dies über einen längeren Zeitraum geschehen, werden solche Marken oft auch zum Sponsor des Spielers, um ihre eigene Reichweite zu erhöhen.

Kosten und Abzüge: Dem steht der Streamer Gehalt in Deutschland gegenüber

Die genannten Streamer Gehälter stellen Brutto-Summen dar – also den Verdienst vor Abzug der deutschen Einkommens-, Umsatz- und Gewerbesteuer, sowie Sozialversicherungen. Wer all diese Beträge zusammenzählt, muss oft bis zu 45% seines Brutto-Einkommens an den Fiskus abführen. Doch damit nicht genug: Die meisten Twitch-Streamer müssen auch Chat-Moderatoren bezahlen, die für eine angenehme Atmosphäre unter den Kommentierenden sorgen und Community-Richtlinien durchsetzen.

Darüber hinaus wollen sich Zuschauer nur Streams ansehen, die eine hohe Qualität aufweisen. Um leistungsstark spielen und den Verlauf optimal übertragen zu können, brauchen Streamer bestimmtes Gaming-Equipment, das selbst zwischen 2.000 und 10.000 Euro kosten kann. Auch eine stabile Internetverbindung und die damit verbundenen Kosten sind zu bedenken.

Alternative Plattformen zur Diversifizierung

Um noch mehr Einkommen zu generieren, können passionierte Spieler ihre Streams allerdings zusätzlich auf anderen Plattformen veröffentlichen und monetarisieren – beispielsweise durch Werbung und Affiliate-Marketing. Zur Diversifizierung kommen Plattformen wie YouTube und Kick in Frage, die teilweise sogar bessere Konditionen bieten. Denn: Bei Kick werden Streamer zu 95% an den Einnahmen durch Abonnements beteiligt, was im Gegensatz zu Twitch deutlich attraktiver erscheint.

to teach: Vom KI-Hype zur Schulinfrastruktur

Wie das 2022 gegründete EdTech to teach die Lücke zwischen Chatbot und Klassenzimmer schließt.

Vor drei Jahren begann mit dem öffentlichen Zugang zu generativer künstlicher Intelligenz ein weltweiter Hype, der auch vor den Schultoren nicht haltmachte. Doch im Bildungsmarkt entscheidet sich derzeit, ob die Technologie tatsächlich Produktivität schafft oder in einer digitalen Sackgasse endet. Das Hamburger EdTech to teach liefert hierzu eine Blaupause: Was 2022 als Experiment begann, hat sich innerhalb von drei Jahren zu einer Arbeitsplattform für hunderttausende Lehrkräfte entwickelt.

Das Problem: US-Tools verstehen deutsche Schulen nicht

Als generative KI erstmals verfügbar wurde, wirkte ihr Einsatz im Bildungsbereich naheliegend. Doch der Blick auf die internationale Konkurrenz zeigt das Dilemma: Während US-Platzhirsche wie MagicSchool AI oder Diffit den Markt mit hunderten Mikro-Tools fluten und technisch beeindrucken, fehlt ihnen der kulturelle Fit. „Einfach nur Texte aus ChatGPT zu kopieren, löst kein einziges Problem von Lehrkräften“, erklärt Felix Weiß, Co-Founder und CEO von to teach.

Die Diskrepanz zwischen dem Versprechen der KI und dem tatsächlichen Schulalltag war groß. US-Lösungen scheitern oft an spezifischen deutschen Lehrplänen oder liefern reine Multiple-Choice-Formate, die hierzulande kaum Anwendung finden. Lehrkräfte benötigten keine unstrukturierten Textwüsten, sondern didaktisch saubere, lehrplankonforme und sofort einsetzbare Materialien. Genau hier setzte das 2022 von Felix Weiß und Marius Lindenmeier gegründete Unternehmen an.

Der Pivot: Datenschutz als Burggraben

Der entscheidende Wendepunkt kam 2023. Das Start-up vollzog einen Strategiewechsel (Pivot) weg von einer SaaS-Lösung für Verlage hin zu einer direkten Plattform für Lehrkräfte. Anstatt Nutzer*innen mit freien Eingabefeldern (Prompts) allein zu lassen, entwickelte das Team feste Arbeitsblattvorlagen. Dies wurde zum entscheidenden Wettbewerbsvorteil gegenüber internationalen Anbietern: Während diese oft an der strikten DSGVO scheitern, bietet to teach durch Serverstandorte in der EU und Rechtssicherheit eine Lösung, die Schulträger akzeptieren.

Dabei mussten technische Kinderkrankheiten überwunden werden: Frühe KI-Modelle „halluzinierten“ Fakten. To teach reagierte mit der systematischen Integration von Quellen und profitierte zugleich von der rasanten Evolution der Sprachmodelle.

Skalierung im Ökosystem gegen nationale Konkurrenz

Der Markt nahm die Lösung schnell an: Im Januar 2023 meldete sich der erste Nutzer an, bis Ende des Jahres waren es laut Unternehmen bereits knapp 16.000 Lehrkräfte. Das Jahr 2024 markierte dann den Übergang vom Start-up zur Plattform: Durch die Übernahme von fobizz (101skills GmbH) wurde to teach Teil eines größeren Bildungsökosystems. Die Gründer blieben als Geschäftsführer an Bord.

Dieser Schritt war strategisch überlebenswichtig in einem sich konsolidierenden Markt. Einerseits gegenüber agilen Herausforderern, da Konkurrenten wie schulKI, Teachino, KIULY oder Kuraplan zum Teil aggressiv um Landeslizenzen kämpfen bzw. auf dem Markt für KI-gestützte Unterrichtsplanung und Materialerstellung durchgestartet sind.

Andererseits war der Schritte in Hinblick auf etablierte Verlage notwendig. Denn Häuser wie Cornelsen ziehen inzwischen mit eigenen KI-Assistenten nach, sperren ihre Inhalte jedoch oft in geschlossene Systeme, d.h. binden sie oft an die eigenen Verlagswerke.

Durch die erfolgreiche Integration in fobizz ist to teach kein isoliertes Insel-Tool mehr, sondern profitiert von bestehenden Landesrahmenverträgen und einem riesigen Vertriebsnetz. Die Nutzer*innenzahlen explodierten förmlich auf über 140.000 Lehrkräfte bis Ende 2024, so die Angaben von to teach.

Status Quo 2025: KI als neue Infrastruktur

Heute, im dritten Jahr nach der Gründung, hat sich der Fokus erneut verschoben. To teach versteht sich inzwischen als Arbeitsinfrastruktur. Die Zahlen unterstreichen diesen Anspruch: Nach Angaben von to teach nutzen über 300.000 Lehrkräfte die Plattform, und mehr als 4.000 Schulen sind angebunden. Das bedeutet: Millionen von Inhalten wurden so bereits KI-gestützt vorbereitet.

Das Unternehmen treibt nun den systematischen Schulvertrieb voran. Damit beweisen EdTechs wie to teach, dass sich Qualität und Personalisierung im sonst oft als innovationsresistent geltenden Bildungsmarkt skalieren lassen.

Für CEO Felix Weiß ist die Diskussion über das „Ob“ längst beendet: „Die Frage ist nicht mehr, ob KI im Klassenzimmer ankommt, sondern, wie und auf welche Weise sie dort wirklich hilft.“

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.