Aktuelle Events

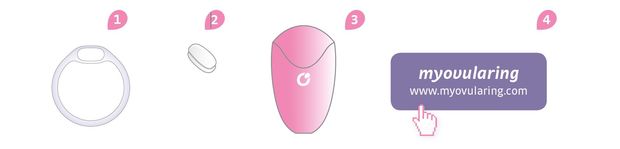

OvulaRing: dem Eisprung auf der Spur

Die Leipziger VivoSensMedical GmbH hat mit seinem OvulaRing eine Methode entwickelt, die Frauen ganz natürlich dabei unterstützt, schwanger zu werden. Wie das „Zyklusmonitoring 2.0“ entwickelt wurde und wie es funktioniert.

Den richtigen Partner gefunden? Lebenstechnisch fest im Sattel? Na dann kann es ja losgehen mit dem Kinderkriegen. Häufig klappt es aber nicht so schnell, wie manches Paar sich das wünscht. Ein ganz einfacher Grund könnte sein: Über den weiblichen Zyklus wissen die meisten Frauen weniger als sie denken.

Genau hier setzt das Leipziger Start-up VivoSensMedical mit seinem Produkt OvulaRing an. Viel zu schnell landen Frauen ohne gründliche Zyklusdiagnostik in der Kinderwunschklinik und unterziehen sich teilweise unnötigen Hormonbehandlungen mit starken Nebenwirkungen. Reproduktionsmediziner Professor Henry Alexander ist Erfinder von OvulaRing und hat seit den 90er-Jahren die Vision, eine Methode zu entwickeln, die Frauen ganz natürlich dabei unterstützt, schwanger zu werden. Mittlerweile ist aus der Vision ein Unternehmen mit acht Angestellten geworden.

Zyklusmonitoring 2.0

OvulaRing ist bislang das einzige Medizinprodukt, das dauerhaft im Körperinneren getragen werden kann und alle fünf Minuten die Körperkerntemperatur misst. Alle hormonellen Prozesse im Zyklus spiegeln sich in der Körperkerntemperatur, deshalb ist sie ein wichtiger Indikator für die Zyklusgesundheit. Der Biosensor erfasst und speichert täglich 288 Messpunkte. „So ist es erstmals möglich, den Zyklus exakt abzubilden“, erklärt Alexander. Mit diesem Scan gelingt laut dem Mediziner ein hundertprozentiger Überblick über den Zyklus, und zwar von zu Hause aus, ohne häufige Arztbesuche.

Zudem können laut Alexander durch die genaue Berechnung und Abbildung des individuellen Zyklus hormonelle Störungen frühzeitig erkannt und erfolgreich behandelt werden. „Das war bisher so nicht möglich und wir denken, dass wir die Medizin und die Forschung ein ganzes Stück weiterbringen“, so der Arzt. Bereits 1999 meldete der heute emeritierte Leiter der Abteilung für Reproduktionsmedizin an der Uni Leipzig das erste Patent für OvulaRing an.

Wie funktioniert OvulaRing?

OvulaRing besteht aus einem Kunststoffring mit integriertem Biosensor. Mit Beginn des neuen Zyklus wird der Ring von der Anwenderin eigenständig vaginal eingeführt und mit dem Einsetzen der Periode wieder herausgenommen. Anschließend wird der Sensor mithilfe eines speziellen Lesegerätes via USB-Schnittstelle an die webbasierte Software übertragen, wo die Daten mit Hilfe von medizinisch validierten Algorithmen ausgewertet werden.

Die Vielzahl der Temperaturdaten ermöglicht eine genaue Erfassung der Zykluskurve, die von der Software als sogenanntes Cyclofertilogramm (CFG) ausgegeben wird. Dieses markiert den genauen Ovulationszeitpunkt und den Fruchtbarkeitszeitraum.

Nach der Aufzeichnung von drei Zyklen kann dann der Eisprung für die folgenden Zyklen zuverlässig prognostiziert werden, vorausgesetzt natürlich, die Anwenderin nutzt OvulaRing weiter. Paare mit Kinderwunsch wissen auf diese Weise genau, wann es sich besonders lohnt, Sex zu haben. Doch das System funktioniert auch andersherum: Viele Frauen können oder wollen nicht hormonell verhüten, da etwa die Pille das Risiko für Schlaganfälle erhöht. Diese müssen dann nur in der fruchtbaren Zeit zum Beispiel mit Kondom verhüten.

Und was macht die Konkurrenz?

OvulaRing ist ein Produkt an der Schnittstelle zwischen Patientin und Arzt: Es kann von der Frau eigenständig zum Selftracking eingesetzt werden. Gleichzeitig ermöglicht es aber auch dem Arzt eine genaue Diagnose und individuelle Therapiepläne für eine Kinderwunsch-Behandlung zu erstellen, was weit erfolgversprechender ist als ohne die genaue Kenntnis des Zyklus. Ein entscheidender Vorteil: Im Gegensatz zu anderen Verfahren sind Anwendungsfehler von vornherein ausgeschlossen. Äußere Faktoren können die Messung nicht beeinflussen, Vergessen ist nicht möglich. „Alle anderen Methoden sind einfach nicht so zuverlässig“, erklärt der Mediziner. „Armbänder oder ein am Finger getragener Ring zum Beispiel messen nur die Hauttemperatur. Aber das ist viel zu ungenau, denn die Temperaturschwankungen innerhalb des Zyklus spielen sich im Bereich von 0,25-0,5 Grad ab. Zyklus-Apps, die nur auf selbst eingetragenen Werten basieren, sind nett, aber liefern keine belastbaren Daten“.

Die Frauen, die OvulaRing nutzen, können also ungestört ihrer täglichen Routine nachgehen, anstatt sich mit mühsamen Messmethoden herumschlagen zu müssen: Temperaturmessen vor dem Aufstehen, Bestimmen des Hormonspiegels mit Urinstreifen etc. Laut Alexander ist der OvulaRing ein vielseitiges Diagnosemittel, da auch Fieber, Sportaktivitäten, Stress und sogar das Schlafverhalten aus den Temperaturkurven abgelesen werden können, ohne die Zyklusanalyse zu verfälschen.

Vom Prototyp zum Start-up VivoSensMedical

Die VivoSensMedical GmbH wurde 2011 gegründet. Das Team rund um Professor Alexander konnte schnell Kapitalgeber von OvulaRing überzeugen: „Wir hatten eine halbe Million in der Tasche, um den Prototyp zur Serienreife zu bringen“, erinnert sich Sebastian Alexander, Schwiegersohn des Professors und heute Geschäftsführer des Unternehmens.

Nachdem die ersten beiden Finanzierungsrunden 2011 und 2012 mit dem Technologiegründerfonds Sachsen gestemmt waren, kamen 2014 drei weitere Gesellschafter hinzu. Eine davon ist Diplom-Medienwirtin Bettina Brammer, die sich bei der VivoSensMedical um Vertrieb und Marketing kümmert. Als ehemalige Patientin einer hormonellen Kinderwunschbehandlung ist sie überzeugt von OvulaRing: „Ich kann mich beruflich nur mit Dingen befassen, die ich auch privat spannend und richtig finde“. Brammer kennt die Bedürfnisse von Frauen mit Kinderwunsch zwischen 30 und 45, der Kernzielgruppe der VivoSensMedical, ganz genau und steht mit ganzem Herzen hinter dem Produkt, das sie vertreibt.

Auf dem Weg zum Kunden

Bei einer Crowdfunding-Kampagne auf Seedmatch.de wurden außerdem 300.000 Euro für die Vermarktung eingeworben. Mit dem akquirierten Kapital konnte das Produkt fertig entwickelt und medizinisch zugelassen werden. Außerdem wurde das Geld für Markttests in Deutschland, Österreich und der Schweiz eingesetzt, um ein skalierbares Geschäftsmodell zu entwickeln.

OvulaRing wird über einen eigenen Webshop direkt an die Endkundin vertrieben. Gynäkologen, Heilpraktiker und Hebammen dienen dabei als Vertriebsmittler. Das Produkt wird bereits von mehr als 1700 Kundinnen genutzt, von über 200 Gynäkologen empfohlen und hat bisher etwa 75 Familien zu einem Baby verholfen. Als Startpaket ist OvulaRing zur Nutzung für drei Monate zu einem Preis von 254 Euro erhältlich. Abhängig von der jeweiligen weiteren Anwendungsdauer liegt der monatliche Preis zwischen 59 und 29 Euro.

Mit den Ergebnissen der Markttests konnte die Exeltis Germany GmbH als Distributionspartner gewonnen werden. Seit Mai 2017 vertreibt Exeltis das Medizinprodukt. „Das Feedback von Kunden und Gynäkologen und die Ergebnisse der bisherigen Markttests haben uns vom großen Potential von OvulaRing überzeugt. Wir freuen uns, unser Portfolio um eines der innovativsten Produkte im Bereich der Frauengesundheit zu erweitern“, so Silvia Steyrer-Gruber, Geschäftsführerin der Exeltis Germany GmbH. Das Unternehmen ist eine Tochtergesellschaft der spanischen Chemo Group und verfügt über einen der größten Außendienste für gynäkologische Produkte in Deutschland. Das Unternehmen hat die Rechte zur Vermarktung von OvulaRing in Deutschland bis 2027 erworben.

Und wie geht es weiter?

Natürlich wird bei der VivoSensMedical bereits an weiteren Zielen zur Etablierung von OvulaRing am Markt gearbeitet. Der Fokus richtet sich zunächst auf den Ausbau des Vertriebs im europäischen und amerikanischen Markt. In den nächsten Jahren will das Unternehmen eine Funkvariante des Mess-Systems entwickeln und die Krankenkassenzulassung des Medizinprodukts vorantreiben.

Darüber hinaus ist die Verwendung des Systems auch in anderen medizinischen Bereichen denkbar, wie zum Beispiel in der Ernährungs- und Sportmedizin sowie in der Früherkennung von Frühgeburten oder Autoimmunerkrankungen. „Unser Ziel ist es, OvulaRing als führende Methode für die natürliche Familienplanung zu etablieren“, sagt Professor Alexander, „der Temperaturmessring soll im gynäkologischen Bereich ebenso selbstverständlich werden wie Ultraschall oder die Pille.“

Sie möchten selbst ein Unternehmen gründen oder sich nebenberuflich selbständig machen? Nutzen Sie jetzt Gründerberater.de. Dort erhalten Sie kostenlos u.a.:

- Rechtsformen-Analyser zur Überprüfung Ihrer Entscheidung

- Step-by-Step Anleitung für Ihre Gründung

- Fördermittel-Sofort-Check passend zu Ihrem Vorhaben

Diese Artikel könnten Sie auch interessieren:

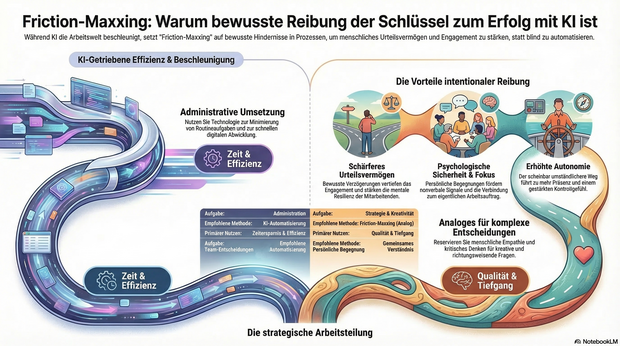

KI-Müdigkeit im Team? Warum Friction-Maxxing jetzt die Antwort ist

Nach all der Euphorie über KI-Tools macht sich bei immer mehr Menschen eine gewisse KI-Müdigkeit breit. Die Technologie hat die Arbeitswelt im Sturm erobert – doch in Unternehmen wachsen die Zweifel: Macht KI wirklich alles einfacher oder trägt sie sogar zu sinkendem Engagement bei? Dr. Arne Sjöström von Culture Amp erklärt, warum Unternehmen jetzt auf Friction-Maxxing setzen sollten.

Friction-Maxxing ist ein Trend aus dem Lifestyle-Bereich, der jedoch auch großes Potenzial für die Arbeitswelt und den strategischen Einsatz von KI in Unternehmen hat. Gemeint ist damit ein Verhalten, bei dem man bewusst mehr kleine Hindernisse und Hürden in Arbeitsprozessen akzeptiert.

Der große Vorteil: Durch eine bewusste Verzögerung wird das Urteilsvermögen geschärft, das Engagement vertieft und die mentale Resilienz der Mitarbeitenden gestärkt.

Friction-Maxxing als Gegengewicht zur KI-Dominanz

Insbesondere für Führungskräfte und das mittlere Management bietet Friction-Maxxing die Möglichkeit, produktive Reibung in Entscheidungsprozesse zurückzubringen. Durch die Rückkehr zu mehr persönlichen Begegnungen und analogen Arbeitsabläufen entstehen Dinge, die in digitalen Formaten schlicht verloren gehen:

- Konzentrierte Aufmerksamkeit.

- Psychologische Sicherheit.

- Wichtige nonverbale Signale.

Persönliche Begegnungen ermöglichen einen konstruktiven Austausch und helfen Teams dabei, ein gemeinsames Verständnis von Qualität zu entwickeln. Am Ende geht es nicht darum, unnötige Hürden aufzubauen, sondern das richtige Maß an „Reibung“ zu gestalten: Analoges für einen besseren Umgang mit Ambiguität, Kreativität und richtungsweisenden Entscheidungen – Digitales für die Umsetzung.

Fokus und Sinnhaftigkeit zurückerobern

Positive Reibung kann als dringend benötigtes Gegengewicht zur KI-getriebenen Beschleunigung in der Arbeitswelt fungieren und den Fokus wiederherstellen. Sei es durch das gründliche, manuelle Überdenken eines Briefings oder den bewussten Wunsch nach persönlichem Austausch anstelle eines asynchronen Chats. Wer sich Zeit zum Denken, Begegnen und Gestalten zurückerobert, ermöglicht es Teams, sich wieder mit ihrem eigentlichen Auftrag und ihren Ansprüchen zu verbinden – Qualitäten, die KI-Automatisierung allein niemals erreichen kann.

Dieses geänderte Verhalten führt zu mehr Präsenz, weniger Angst und einem gestärkten Gefühl der Kontrolle. Der bewusst gewählte, nur scheinbar umständlichere Weg kann somit zu mehr Autonomie und tieferer Zufriedenheit am Arbeitsplatz beitragen.

Ein Plädoyer für intentionale Reibung

Die Aufgabe moderner Führungskräfte ist es daher, bei menschenzentrierten Tätigkeiten ganz bewusst sogenannte intentionale Reibung herbeizuführen und KI parallel dazu zu nutzen, den täglichen administrativen Arbeitsaufwand zu minimieren.

Unternehmen müssen klar benennen, wo KI ihre Stärken hat und eingesetzt werden soll – und wo menschliche Fähigkeiten wie Empathie, Urteilsvermögen und kritisches Denken absolut unersetzlich sind. So gibt man Mitarbeitenden die Möglichkeit, sich auf die Arbeit zu konzentrieren, die wirklich zählt und echten Mehrwert schafft.

Friction-Maxxing ist somit weniger ein Plädoyer gegen die Technologie, sondern vielmehr ein Aufruf zur Intentionalität: Dem bewussten Abwägen darüber, wann Prozesse automatisiert werden sollten und wann gerade der Widerstand den entscheidenden Unterschied machen kann.

Der Autor Dr. Arne Sjöström ist Regional Director, People Science EMEA bei Culture Amp. Sein Schwerpunkt liegt in der Organisationspsychologie und der angewandten Forschung.

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

KI gegen Buchhaltungsriesen: Wie Bonster den Spesen-Markt aufmischen will

Pay-per-Use statt Abo-Falle: Das Oldenburger Start-up fast2work attackiert mit seiner App bonster komplexe Software-Giganten. Doch reicht das Versprechen maximaler Einfachheit im Haifischbecken der FinTechs? Wir haben nachgehakt.

Es ist eines der letzten großen Ärgernisse im Arbeitsalltag von Freelancer*innen und kleinen Agenturen: Der Freitagabend, der für das Sortieren verknitterter Tankbelege und das Abtippen von Bewirtungsbelegen in Excel-Listen draufgeht. Genau hier setzt die Oldenburger fast2work GmbH mit ihrer am 17. Februar 2026 gelaunchten App bonster an, um den Papierkram bei der Reisekostenabrechnung zu beenden. Das Versprechen von Gründer und CEO Ronald Bankowsky: Drei Minuten Aufwand, KI-Automatisierung und keine Einstiegshürden.

Das Versprechen: Simpel statt Systemintegration

Die Funktionsweise der App ist bewusst minimalistisch gehalten: Beleg fotografieren, woraufhin die KI relevante Werte wie Datum, Betrag und Mehrwertsteuer ausliest, auf Duplikate prüft und eine fertige Abrechnung erstellt. „Kein Onboarding-Projekt, kein Vertriebsgespräch, kein IT-Setup“, fasst Bankowsky den Ansatz der Standalone-Lösung zusammen.

Die Zielgruppe ist klar definiert: Selbständige, Freelancer*innen und Mini-Teams, denen Enterprise-Lösungen wie SAP Concur zu mächtig und Start-ups wie Circula oder Pleo oft noch zu prozesslastig sind. Mit einem Preismodell von 1,99 Euro für Einzelabrechnungen und 6,99 Euro (Stand Ende Febr. 2026) für eine Flatrate positioniert sich das Unternehmen im unteren Preissegment.

Im Haifischbecken der Neobanken und Buchhaltungsriesen

Laut fast2work gab es bislang „kaum eine Alternative zwischen Excel und Enterprise-Software“. Diese Aussage hält einem Realitätscheck im Jahr 2026 allerdings nur bedingt stand. Bonster betritt ein Haifischbecken, denn die vermeintliche Lücke wird längst geschlossen.

Zum einen integrieren Buchhaltungsriesen wie Lexoffice oder sevDesk Reisekosten-Features immer tiefer in ihre Standardpakete. Zum anderen wildern Neobanken wie Qonto, Finom oder Kontist im selben Revier: Wer dort ein Geschäftskonto hat, bekommt die Belegzuordnung oft als „Commodity“ gratis dazu. Mit knapp 7 Euro im Monat bewegt sich bonster in einer Preisregion, in der man fast schon eine komplette einfache Buchhaltungssoftware bekommt. Die App muss also einen enormen Mehrwert bieten, um gegen die „Eh-da-Lösungen“ (Software, die Kund*innen ohnehin bezahlen) zu bestehen.

Auf die Frage, warum Freelancer*innen für eine Insellösung extra zahlen sollten, entgegnet der Gründer, dass bonster bewusst früher ansetze als klassische Tools. Das Hauptproblem sei nicht die Buchhaltung, sondern das Erfassen von Belegen unterwegs. „Genau dort scheitert es oft, weil Mitarbeitende keine komplexen Systeme nutzen wollen oder gar keine Zugänge haben“, argumentiert Bankowsky. Der Mehrwert liege nicht in einer weiteren Buchhaltungssoftware, sondern darin, dass durch die Reduzierung auf ein Foto „überhaupt verwertbare Abrechnungsdaten/Belege entstehen“.

Kritische Faktoren: GoBD und Datensicherheit

Neben der Marktpositionierung ist die Rechtssicherheit ein kritischer Faktor. „Fertige Abrechnung für die Buchhaltung“ ist ein mutiges Versprechen, da in Deutschland ein Foto allein oft nicht ausreicht; es muss GoBD-konform und revisionssicher archiviert werden. Zudem ist die KI-Nutzung datenschutzrechtlich sensibel. Wenn Bewirtungsbelege, die offenbaren, mit wem man gegessen hat, über US-Schnittstellen (z.B. OpenAI) fließen, ist das für deutsche Geschäftskund*innen und Steuerberater oft ein K.O.-Kriterium.

Auf die sensiblen Vorgaben der Finanzämter und den Serverstandort angesprochen, betont Bankowsky, dass die Verarbeitung „ausschließlich auf europäischen Servern“ erfolge. Zwar nutze man OpenAI-basierte Modelle, diese liefen jedoch über Azure-Rechenzentren im europäischen Raum. Datenschutz und regulatorische Anforderungen seien Grundvoraussetzung. Auch beim Export zum Steuerberater zeigt sich der Gründer zuversichtlich: Buchhaltungssysteme könnten die Daten direkt und „ohne manuelle Nacharbeit“ weiterverarbeiten.

Beta-Test als Exklusiv-Club

Zum Start setzt das Unternehmen auf eine Gamification des Rollouts. Die ersten 500 Nutzer*innen erhalten im „Club 500“ einen lebenslangen Rabatt von 50 Prozent. Was als Belohnung für Early Adopters verkauft wird, ist strategisch notwendig: Die KI muss lernen. Der Algorithmus braucht dringend „Real World Data“ – echte, verknitterte, schlecht beleuchtete Belege. Das bedeutet auch: Die ersten User*innen sind Teil des Entwicklungsprozesses.

Dass die App im Alltag noch dazulernen muss, räumt Bankowsky ein. Bei der reinen Datenerkennung sei man technisch auf dem aktuellen Stand. „Entscheidend ist jedoch die Qualität realer Belege im Alltag – etwa schlecht fotografierte oder handschriftliche Quittungen“, erklärt er den Bedarf an Praxis-Feedback. Durch schnelle Updates solle die Genauigkeit für alle Nutzer*innen laufend steigen.

Gegenmodell zur Ökosystem-Abhängigkeit

Wer ein Feature-Feuerwerk suche, werde bei bonster enttäuscht sein – was laut Unternehmen aus Überzeugung geschehe. Anbieter wie Rydoo verfolgten eine Strategie der maximalen Integration und langfristiger Verträge, was eine Abhängigkeit erzeuge, die ihr eigentliches Geschäftsmodell sei, so der Gründer. Wer einmal im Ökosystem stecke, wechsle nicht mehr, weil der Ausstieg zu teuer geworden sei.

Bonster positioniert sich als Gegenmodell für Unternehmen, die nicht für ungewollte Komplexität zahlen möchten: Kein Vertrag, keine Mindestnutzerzahl, Setup in unter fünf Minuten und ein Pay-per-Use-Modell. „Wer aufhören will, hört auf, ohne Konsequenzen“, beschreibt das Start-up den Ansatz der bewussten Entscheidung, Kund*innen freizulassen. Wer bleibe, tue dies, weil es funktioniere, was laut Bankowsky „die interessantere Innovation“ sei.

Fazit

Bonster ist ein innovativer Angriff auf die Zettelwirtschaft und wirkt durch den Verzicht auf starre Abo-Modelle bei der Einzelabrechnung fair. Doch die App steht und fällt mit der Schnittstellenkompetenz. Wenn der Export zu DATEV & Co. hakt, wird aus der Zeitersparnis schnell Mehrarbeit. Bonster muss beweisen, dass es die Brücke zwischen dem schnellen Foto und der strengen deutschen Buchhaltung schlagen kann – und zwar besser als die Banken, die das Feature bereits kostenlos anbieten.

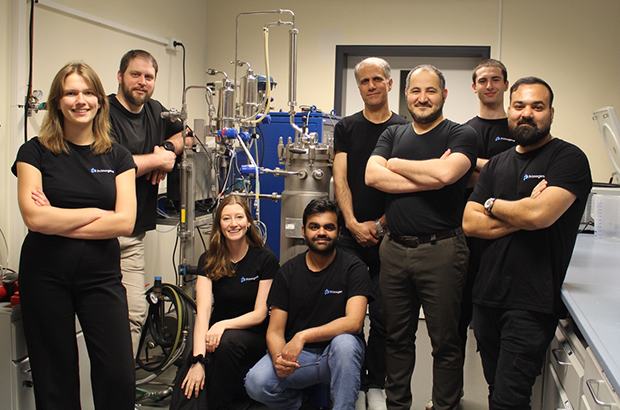

Primogene: Muttermilch als Vorbild

Primogene ist ein 2023 gegründetes BioTech-Start-up mit Sitz in Leipzig, das sich auf die Entwicklung biotechnologischer Herstellungsverfahren für bioidentische Inhaltsstoffe spezialisiert hat. Ein Schwerpunkt liegt auf Verbindungen, die der Muttermilch nachempfunden sind und die Gesundheit in allen Lebensphasen fördern können.

Auch wenn das Produkt als weißes Pulver eher unscheinbar aussieht, markiert seine Existenz einen wissenschaftlichen Meilenstein. „Wir haben eine spezielle Technologie entwickelt, dank der wir komplexe bioidentische humane Milchzucker skalierbar herstellen können“, erzählt Linda Karger, einst Managementstudentin an der Technischen Universität in München, heute COO der 2023 in Leipzig gegründeten Primogene GmbH. Die chemischen Verbindungen entsprechen also den im menschlichen Körper vorkommenden Molekülen bis ins kleinste biochemische Detail. Und sie übernehmen – obwohl industriell hergestellt – die gleichen Funktionen, die bisher nur Muttermilch garantierte.

Zum Verständnis: Die komplexen Zuckerstrukturen sind nach Fett und Laktose der drittgrößte feste Bestandteil menschlicher Milch. Sie bieten einzigartige gesundheitliche Vorteile, unterstützen beispielsweise das Immunsystem sowie die kognitive Entwicklung wie kein anderer Stoff. „Nach zahllosen Gesprächen mit Ärzten und Kliniken begann unsere Geschichte mit der Idee, nährstoffreiche Inhaltsstoffe als Zusatz für die Ernährung von Frühgeborenen herzustellen. Weitergedacht können bioaktive Bestandteile der Muttermilch ebenso zur Krankheitsprävention bei Erwachsenen sinnvoll eingesetzt werden“, erklärt Karger. „Um das Wirkungspotenzial unserer Human Milk Oligosaccharides (HMO) weiter zu erforschen, testen wir diese aktuell in enger Zusammenarbeit mit dem Leipziger Fraunhofer-Institut für Zelltherapie und Immunologie.“

Produktsortiment in der Breite offen

Gleichzeitig wird die von Dr.-Ing. Reza Mahour (CEO, Experte für Bioverfahrenstechnologie) und Valerian Grote (CTO, Molekularbiologe/Experte für Analytische Biochemie) entwickelte enzymatische Technologie genutzt, um bioidentische Moleküle für andere Märkte zu erzeugen, beispielsweise Inhaltsstoffe für Produkte der Körperpflege oder Rohmaterialien für die Pharmaindustrie. „Wir produzieren selbst. Dabei lässt sich jedes unserer Produkte auf die spezielle Technologie zurückführen. Unseren Kunden bieten wir Komplettlösungen – das reicht von der Suche nach der richtigen Produktionsplattform bis hin zu Entwicklung und Produktion“, bestätigt Karger. Erste Umsätze wurden nach ihren Angaben bereits früh erzielt. Inhaltsstoffe für den Kosmetikbereich sollen noch in diesem Jahr mithilfe bestehender Partnerschaften am Markt eingeführt werden. Im Pharmabereich wird ebenfalls mit ersten Kunden zusammengearbeitet.

Karger ergänzt: „Wir haben früh auf Partnerschaften und Vorbestellungen gesetzt, um den Markt besser zu verstehen.“ Um die bereits verabredeten hochwertigen Roh- und Inhaltsstoffe bald in größeren Mengen liefern zu können, ist das aktuell elfköpfige Team von Primogene gerade innerhalb Leipzigs umgezogen. Für die anstehende Skalierung war der Wechsel auf eine Betriebsstätte mit mehr Laborfläche und größerem Produktionsbereich wichtig. Große Mitspieler auf dem Feld der HMOs wie die niederländische DSM-Firmenich oder der dänische Konzern Chr. Hansen schrecken Karger nicht: „Bekannt sind mehr als 200 verschiedene HMOs, davon sind bisher sieben strukturell einfacher industriell herstellbar und auf dem Markt. Sie werden mit einer Fermentationstechnologie produziert. Unser enzymatisches Verfahren kann deutlich mehr und komplexere Zuckerstrukturen hervorbringen. Außerdem reicht unsere Produktpalette weit über HMOs hinaus.“

Sichtbarkeit durch Innovationsplattform futureSax erleichtert Investorensuche

Das bisher benötigte Kapital stammt unter anderem von Business Angels aus dem Bereich der Biotechnologie, darunter auch Climate Founders, bei deren Accelerator-Programm Mahour Grote und Karger einst zusammenfanden. Für Primogene als forschungs- und deshalb kapitalintensives Biotech-Unternehmen sind daneben die Mittel aus Förderprogrammen des Landes Sachsen und der Stadt Leipzig von wesentlicher Bedeutung. Darüber hinaus profitiert das Start-up noch heute von der Sichtbarkeit, die es durch den Gewinn des dritten Platzes beim Sächsischen Gründerpreis 2024 erhielt. Zunächst sorgten der professionelle Nominiertenfilm und die begleitende Öffentlichkeitsarbeit von futureSax für Aufmerksamkeit sowohl in den Medien als auch innerhalb des Netzwerks.

Dann bot die Preisübergabe auf der Sächsischen Innovationskonferenz vor über 1.000 Gästen Primogene eine wichtige Gelegenheit zur Präsentation. „Sachsen ist ein Innovationsstandort mit besonderer Dichte: Exzellente Forschung, starke Industrie- und Mittelstandsstrukturen und eine wachsende Start-up-Szene greifen ineinander. Hier entstehen Lösungen, die international wettbewerbsfähig sind. Entscheidend ist der Schulterschluss im Ökosystem – von Hochschulen über Unternehmen bis zu Kapitalgebern. futureSax schafft dafür die Bühne und die Verbindungen, damit aus Ideen schneller Produkte, Partnerschaften und Gründungen werden“, erklärt Susanne Stump, Geschäftsführerin der Innovationsplattform des Freistaats Sachsen. Das Interesse großer Investoren bestätigt, dass Primogene auf dem richtigen Weg ist. Im Jahr 2025 schloss das innovative Start-up eine Seed-Finanzierungsrunde mit namhaften Investoren wie HTGF, TGFS, der Sächsischen Beteiligungsgesellschaft und better ventures ab. Das geplante Personalwachstum sowie die Produktionsaktivitäten der nächsten zwei Jahre sind damit gesichert.

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen: https://t1p.de/p8gop

Agentic AI als Erfolgsgrundlage für Start-ups

KI befeuert den aktuellen Gründungsboom, doch für eine erfolgreiche Skalierung braucht es mehr. Warum Agentic AI auf Basis einer soliden Datenarchitektur zum entscheidenden Erfolgsfaktor für Start-ups wird.

Das Jahr startete für Start-ups mit einer Rekordmeldung: In Deutschland wurden im vergangenen Jahr fast ein Drittel mehr Gründungen verzeichnet. In absoluten Zahlen wurden 2025 insgesamt 3.568 neue Firmen geschaffen – ein neuer Höchststand, wie der Start-up-Verband im Januar verkündete. Dies ist auch der künstlichen Intelligenz (KI) zu verdanken, wie sich beim genauen Hinschauen herausstellt. 853 dieser neuen Unternehmen kommen aus dem Bereich Software. Doch nicht nur sie verwenden KI; bei einer Umfrage gab ein Drittel aller Gründer und Gründerinnen an, dass sie mit KI arbeiten. Dementsprechend sehen die Sprecher des Verbands in der Technologie auch die treibende Kraft hinter dem Start-up-Rekord.

Wirft man einen Blick über den Tellerrand hinaus, so lässt sich feststellen, dass die Start-up-Szene in Europa insgesamt floriert. Der „State of European Tech 2025“-Report im Auftrag von Atomico und anderen schätzt, dass im letzten Jahr Investitionen in Höhe von 44 Milliarden US-Dollar (umgerechnet ca. 38 Mrd. EUR) in diesen Sektor geflossen sind. Geldgeber erwarten inzwischen, dass Start-ups mit KI und Deep Tech arbeiten, so der Report. Demnach flossen auch 36 Prozent der europäischen Start-up-Investitionen in genau diese beiden Felder.

Das Gründungsumfeld könnte also kaum besser sein. Doch ein Rekord an Start-ups und steigende Investitionssummen bedeuten nicht zwangsläufig auch eine einfache Skalierung der Geschäftsmodelle. Viele – zu viele – Start-ups scheitern nach erfolgreichen ersten Jahren an der Weiterentwicklung ihres Geschäfts. Neben einer Reihe üblicher Herausforderungen stehen vor allem Bürokratie, Fragen zur Datenhoheit und ein Betrieb über Landesgrenzen und Wirtschaftszonen hinweg im Vordergrund. Start-ups müssen nachweisen, dass ihre Nutzung von KI auf soliden, regulierten Datenfundamenten basiert und den Compliance-Vorgaben entspricht.

Hier kommt Agentic AI ins Spiel. Die Einbettung von KI-Agenten in den Kern der Betriebsabläufe ist die Antwort auf viele dieser Herausforderungen und wird für das Wachstum im Jahr 2026 von entscheidender Bedeutung sein.

Solide Datenbasis vor KI-Einsatz

Start-ups, die dies erreichen wollen, sollten sich darauf konzentrieren, ihre KI-Nutzung auf einer soliden Datenbasis aufzubauen, deren Fundament eine einheitliche Datenarchitektur ist. Sie tun sich deutlich leichter damit, die dafür nötigen Architekturentscheidungen zu treffen, als etablierte Unternehmen mit entsprechender Legacy-IT. Gründer und Gründerinnen sollten daher von Beginn an darüber nachdenken, wie sie eine starke Datenarchitektur aufsetzen, Silos abbauen und KI als Herzstück ihrer Prozesse einbetten.

Diese Grundlage hilft bei der Einführung von KI-Agenten, damit deren Output auch die Erwartungen erfüllt: Geschäftsprozesse effizienter zu strukturieren und zu optimieren sowie die Entscheidungsfindung zu beschleunigen. Start-ups, die dies umsetzen, werden sich gegen ihre Konkurrenten durchsetzen und letztlich erfolgreich sein.

KI-Agenten als Innovationsbeschleuniger

Indem Start-ups KI-Agenten von Beginn an in den Kern ihrer Geschäftsabläufe integrieren, skalieren sie schneller als mit dem Einsatz von nur einem reinen Large Language Model (LLM). Der Grund dafür liegt in der Standardisierung der Daten, die für KI-Agenten notwendig ist. Auf dieser Grundlage können die Agenten ihre einzigartigen, autonomen Fähigkeiten ausspielen, da sie mit unternehmenseigenen Daten trainiert werden. Vor allem bei Start-ups können Potenziale schnell gehoben werden: Wenn Agenten für bestimmte Aufgaben entwickelt werden, können sie diese auch lösen – egal wie komplex und fachspezifisch sie sein mögen. Stimmt die Datenbasis, lassen sich auch mehrere Agenten miteinander verknüpfen, um sogar noch komplexere Herausforderungen zu bewältigen.

Ein Beispiel dafür ist die mögliche Kooperation zwischen einem Kundensupport-Agenten und einem Prognose-Agenten. Wenn ein Kunde einen Support-Fall auslöst, kann der andere Agent sogleich die Kosten berechnen, was die Kundenzufriedenheit durch eine schnellere Reaktion steigern kann. Für die Skalierung von Start-ups ist ein enges Zusammenspiel der Abteilungen wichtig, um die Geschäftsbeziehungen zu zufriedenen Kunden weiter ausbauen zu können. Der Einsatz von KI-Agenten kann, gepaart mit dem menschlichen Element, begrenzte personelle Ressourcen ausgleichen und eine bessere Serviceleistung ermöglichen, was für ein schnelles Wachstum unabdingbar ist.

Doch nicht nur der Kundenkontakt lässt sich automatisieren, sondern auch eine ganze Reihe von Routinevorgängen in der internen Verwaltung der Firmen selbst. Dies ermöglicht nicht nur dem Management, sondern auch den Investoren, schnell einen fundierten Überblick über Liquidität, Umsatz, Einnahmen und Gewinn zu erhalten. Die Erkenntnisse in Echtzeit führen zu schnellen und datenbasierten Entscheidungen, was für junge Unternehmen Gold wert ist und es ihnen ermöglicht, flexibel zu bleiben.

Die Datenbasis muss stimmen

Für Start-ups sind Probleme beim Datenzugriff ein kritisches Risiko für den Geschäftserfolg. Eine einheitliche, moderne Datenarchitektur ermöglicht die Demokratisierung des Datenzugriffs und löst Datensilos auf. Der Vorteil liegt auf der Hand: Schneller Datenzugriff schafft Transparenz gegenüber Kunden und Aufsichtsbehörden. Darüber hinaus erhöht dies auch das Vertrauen der Mitarbeitenden und schafft ein Gefühl des Zusammenhalts.

Governance ist auch bei der Verwendung von KI-Agenten von entscheidender Bedeutung. Der Druck zur Einhaltung von Vorschriften sollte daher als Vorteil betrachtet werden.

Der Dreiklang aus Datenherkunft, Versionierung und automatisierter Auswertung der Ergebnisse hilft jungen Unternehmen dabei, Governance auf einem soliden Fundament aufzubauen. Die Teams erhalten direkte Transparenz darüber, wie sich die KI-Agenten verhalten, auf welchen Daten sie basieren und wie sie ihre Ergebnisse im Laufe der Zeit verändern. Laufende Bewertungen tragen dazu bei, dass KI-Agenten präziser werden, um genau jene hochwertigen Ergebnisse zu liefern, die Start-ups für die Skalierung ihrer Geschäftsmodelle benötigen. Dies ist besonders wichtig, wenn proprietäre KI-Modelle entwickelt und von der Testphase in die Produktion überführt werden, wobei gesetzliche Vorschriften wie die DSGVO oder der EU AI Act zwingend einzuhalten sind.

Parloa, ein deutsches Start-up-Unternehmen mit einer Bewertung von drei Milliarden US-Dollar, ist ein hervorragendes Beispiel dafür, wie dieser Ansatz in der Praxis aussehen kann: Das Unternehmen hat KI-Agenten zum Kern seines Kundenservice gemacht und gleichzeitig eine einheitliche, kontrollierte Datenbasis aufgebaut, die vollständig mit der DSGVO und dem EU AI Act konform ist. Seine Plattform folgt den Prinzipien des „Privacy by Design“, sodass sensible Kundendaten ohne Kontrollverlust verwendet werden können. Durch die Verwaltung des gesamten Lebenszyklus von KI-Agenten macht Parloa Governance zu etwas Greifbarem und gibt den Teams Klarheit darüber, welche Daten verwendet wurden, wie sich die Agenten verhalten haben und wie sich die Ergebnisse im Laufe der Zeit entwickelt haben. Diese Kombination aus moderner Architektur und starker Governance ermöglicht es den Kunden von Parloa, Zugang zu hochwertigen Daten zu erhalten und die Transparenz für Regulierungsbehörden sowie Endnutzer zu erhöhen – und dennoch KI-gesteuerte Kundeninteraktionen in Umgebungen zu skalieren, in denen Fehler oder Missbrauch inakzeptabel sind.

Fazit

KI-Agenten bieten europäischen Start-ups eine einmalige Gelegenheit, schnell zu wachsen und gleichzeitig Investoren anzuziehen, die bekanntermaßen ihr Geld bevorzugt in Unternehmen investieren, die Wert auf Datenverwaltung, Genauigkeit, Qualität und die Schaffung von echtem Mehrwert durch Technologie legen. Es ist jedoch ein Fehler, sich ohne sorgfältige Überlegungen auf die Einführung von Agenten zu stürzen. Start-ups, die KI-Agenten einsetzen, ohne zuvor eine einheitliche Datenbasis aufzubauen und eine solide Verwaltung sowie Bewertung sicherzustellen, riskieren, mehr Komplexität als Mehrwert zu schaffen. Letztlich werden jene Gründer und Gründerinnen erfolgreich sein, die ihre Geschäftsmodelle branchen- und länderübergreifend skalieren können – hierbei spielt der Einsatz von KI-Agenten bereits jetzt eine entscheidende Rolle.

Der Autor Nico Gaviola ist VP Digital Natives & Emerging Enterprise bei Databricks EMEA.

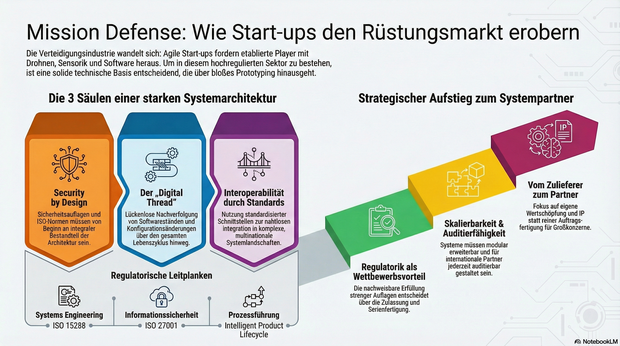

Mission Defense: Wie Start-ups im rüstungstechnischen Markt Fuß fassen

Immer mehr Start-ups drängen mit agilen Innovationen in die hochregulierte Verteidigungs- und Luftfahrtindustrie. Daher gut zu wissen: Wie junge Unternehmen durch die richtige Systemarchitektur die strengen Auflagen meistern und vom Zulieferer zum echten Systempartner aufsteigen.

Die Luft- und Raumfahrt sowie die Verteidigungsindustrie zählen zu den am stärksten regulierten und technologisch anspruchsvollsten Märkten der Welt. Lange galt: Wer hier mitspielen will, braucht jahrzehntelange Erfahrung, Milliardenbudgets und stabile Regierungsbeziehungen. Doch genau dieses Bild verschiebt sich.

Neue Player treten auf den Plan: Start-ups entwickeln Trägersysteme, Drohnenplattformen, Kommunikationslösungen oder Sensorik, und tun das in einer Geschwindigkeit, die vielen etablierten Anbietern Kopfzerbrechen bereitet. Die zentrale Frage lautet deshalb: Wie können junge Unternehmen in einer hochregulierten Branche nicht nur überleben, sondern mitgestalten?

Agilität als Superkraft – aber Prototypen reichen nicht

Ob neue unbemannte Plattformen, Software-Defined Defense Systeme oder taktische Kommunikation – überall gilt: Was heute entwickelt wird, muss morgen schon einsatzbereit sein. Der Bedarf an schneller Innovation ist nicht theoretisch, sondern operativ. Start-ups sind in der Lage, auf diesen Druck zu reagieren, mit kurzen Entscheidungswegen, agilen Teams und digitaler DNA.

Allerdings reichen gute Ideen und schnelles Prototyping nicht aus. Wer Systeme für den operativen Einsatz liefern will, muss Anforderungen erfüllen, die weit über funktionierende Technik hinausgehen: Cybersicherheit, regulatorische Nachvollziehbarkeit, Zertifizierungsfähigkeit und Interoperabilität mit internationalen Partnern.

Das Fundament: Die Systemarchitektur entscheidet

Von Anfang an auf die richtigen technischen Grundlagen zu setzen, ist entscheidend. Das betrifft vor allem drei Bereiche: Skalierbarkeit, Nachvollziehbarkeit und Interoperabilität. Systeme müssen so gebaut sein, dass sie modular erweitert, in komplexe Systemlandschaften integriert und nach internationalen Standards auditiert werden können.

Ein durchgängiger digitaler Entwicklungs- und Betriebsfaden, ein sogenannter Digital Thread oder auch Intelligent Product Lifecycle, ermöglicht es, Produktdaten, Softwarestände und Konfigurationsänderungen über den gesamten Lebenszyklus hinweg zu verfolgen. Für die Zulassung softwaredefinierter, sicherheitskritischer Systeme ist das ebenso essenziell wie für die spätere Wartung, Upgrades oder die Einbindung in multinationale Operationen.

Security by Design: Sicherheit lässt sich nicht nachrüsten

Verteidigungsnahe Produkte unterliegen Exportkontrollen, Sicherheitsauflagen und branchenspezifischen Normen, darunter etwa ISO 15288 für Systems Engineering, ISO 27001 für Informationssicherheit oder die europäischen Anforderungen für Luftfahrt und Raumfahrt. Diese Vorgaben lassen sich nicht einfach „nachrüsten“. Sie müssen von Beginn an ein integraler Bestandteil der Systemarchitektur und Prozessführung sein.

Gerade in sicherheitskritischen Bereichen ist die Fähigkeit, regulatorische Anforderungen nachweislich zu erfüllen, ein entscheidender Wettbewerbsvorteil. Sie entscheidet darüber, ob ein Produkt zugelassen, in Serie gefertigt und in multinationale Programme integriert werden kann.

Interoperabilität als Schlüssel zum Teamplay

Ein weiterer kritischer Faktor ist die Fähigkeit zur Kooperation. In den meisten großen Programmen arbeiten unterschiedliche Unternehmen, oft aus verschiedenen Ländern, mit unterschiedlichen Systemen zusammen. Wer hier bestehen will, muss in der Lage sein, mit standardisierten Schnittstellen, interoperablen Plattformarchitekturen und harmonisierten Datenmodellen zu arbeiten. Interoperabilität ist dafür die technische Grundlage. Ohne sie lassen sich Systeme weder integrieren noch gemeinsam weiterentwickeln.

Vom Zulieferer zum echten Systempartner

Start-ups, die sich diesen Anforderungen stellen, können mehr sein als Zulieferer. Sie haben das Potenzial, Systempartner zu werden: mit eigener Wertschöpfung, eigenem IP und eigenem Einfluss auf die technologische Entwicklung. Der Weg dorthin ist anspruchsvoll, aber offen. Er erfordert keine hundertjährige Firmengeschichte, sondern eine klare Architekturstrategie, ein tiefes Verständnis für regulatorische Anforderungen und den Willen, komplexe Systeme systematisch zu entwickeln.

Der Verteidigungs- und Luftfahrtsektor steht an einem Wendepunkt. Wer heute die richtigen Grundlagen legt, kann morgen zu denjenigen gehören, die nicht nur mitlaufen, sondern die Spielregeln neu definieren.

Der Autor Jens Stephan, Director Aerospace & Defence bei PTC, bringt über 20 Jahre Erfahrung im Bereich komplexer Software-/SaaS-Lösungen und IT-Infrastruktur mit.

Rouge: Vom Tabu zum Geschäftsmodell

Die Menstruation ist ein Milliardenmarkt – und dennoch oft unsichtbar. Das von Tina Frey und Patrick Gsell gegründete Start-up Rouge bricht mit diesem Muster. Was Ende 2022 als Vision in der Schweiz begann, hat sich durch geschickte Positionierung und Expansion nach Deutschland zu einem ernstzunehmenden Player im FemTech-Bereich entwickelt.

Die Grundidee von Rouge ist so simpel wie strategisch klug: Statt die Menstruation zu verstecken, wird sie zum sichtbaren Lifestyle-Element. „Mich hat fasziniert, wie sehr die Menstruation unseren Alltag beeinflusst und wie konsequent wir trotzdem darüber schweigen“, erklärt Mitgründerin Tina Frey. „Bald wurde mir klar: Das ist ein gesellschaftliches Problem.“ Dass dieser Ansatz einen Nerv trifft, zeigt der rasche Aufstieg des Unternehmens. Durch gezielte Medienarbeit gelang es dem Team, das Thema aus der Nische in den Mainstream zu heben – Tina Frey positioniert sich dabei konsequent nicht nur als Unternehmerin, sondern als Expertin für Frauengesundheit.

Differenzierung im "Red Ocean"

Im Zentrum der Marke steht der Rouge-Drink, ein Pulver-Supplement mit Eisen, Vitamin B12 und Granatapfel. Doch der eigentliche USP liegt nicht in den Inhaltsstoffen, sondern in der Inszenierung. Die transparente Flasche mit der roten Flüssigkeit fungiert als bewusstes „Statement-Piece“.

Hier gelingt dem Start-up ein entscheidender Schachzug im wachsenden Markt für Zyklusgesundheit: Während Wettbewerber wie FEMNA oder MYLILY auf funktionale Nahrungsergänzung in diskreter Kapselform setzen, inszeniert Rouge die Einnahme als genussvollen Wellness-Moment. Gleichzeitig emanzipiert sich das Duo von den „lauten“ Tabubrechern der Branche wie The Female Company: Rouge setzt weniger auf Provokation durch Hygieneartikel, sondern transformiert die Linderung von Regelbeschwerden von einer medizinischen Notwendigkeit in eine „ästhetische Selbstverständlichkeit“.

„Sichtbarkeit verändert Verhalten“, so Tina Frey. „Die Flasche macht den Zyklus im Alltag sichtbar und löst Gespräche aus. Noch wichtiger: Viele Frauen erleben dadurch eine neue Selbstverständlichkeit und mehr Selbstbewusstsein.“ Dieser Social-Impact-Gedanke ist fest im Geschäftsmodell verankert: Ein Teil der Erlöse fließt in Aufklärungsprojekte. „Sozialer Impact ist kein Marketing-Trick, sondern eine Notwendigkeit“, ergänzt Co-Founder Patrick Gsell. „Gleichzeitig braucht es wirtschaftliche Stabilität, um langfristig bestehen zu können.“

Diverse Kompetenzen als Wachstumstreiber

Hinter der Marke steht ein komplementäres Gründungs-Duo. Tina Frey bringt als Marketing-Expertin das kommunikative Rüstzeug mit, während Patrick Gsell – seit über 20 Jahren Geschäftsführer eines Softwareunternehmens – die strategische Struktur und Skalierungserfahrung liefert. Patrick Gsell, der 2022 den Bund-Essay-Preis gewann, liefert zudem den intellektuellen Unterbau. „Die Hälfte der Menschheit erlebt die Menstruation. Trotzdem betrifft sie die ganze Gesellschaft und nicht zuletzt das Verständnis zwischen Mann und Frau. Genau deshalb finde ich es so spannend, mit Rouge am Anfang eines gesellschaftlichen Wandels zu stehen“, so Patrick Gsell.

Expansion mit lokaler Strategie

Nach der Etablierung auf dem Schweizer Heimatmarkt erreichte Rouge im Herbst 2025 den nächsten Meilenstein: den Markteintritt in Deutschland. Anders als bei reinen Export-Modellen setzt das Start-up hierbei auf lokale Strukturen und Partner vor Ort. „Der deutsche Markt bietet großes Potenzial, aber jede Gesellschaft tickt anders“, begründet Tina Frey den Schritt. Das Ziel bleibt grenzüberschreitend gleich: Die Menstruation soll kein Nischenthema bleiben, sondern als normaler Teil der weiblichen Gesundheit akzeptiert werden – sichtbar gemacht durch eine rote Flasche, die den Dialog eröffnet.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

Wie viel verdienen Twitch Streamer wirklich? Zahlen und Verdienstmöglichkeiten im Blick

Wer als passionierter Spieler noch nicht an eine Gaming Karriere gedacht hat, sollte dies jetzt nachholen: Schließlich ergeben sich aus dieser von Esport-Turnieren bis hin zum Streaming einige Verdienstmöglichkeiten. Creatoren verdienen mit der Echtzeit-Übertragung ihres Spielerlebnisses Geld. Was sich einfach anhört, kann für so manchen Spieler auch zum komplexen Unterfangen werden. Wie hoch der Streamer Verdienst in diesen Fällen ausfällt und welche Einnahmemöglichkeiten es für Twitch Streamer noch gibt, erfahren Sie hier.

Die Top 10 Twitch Streamer im Jahr 2025

„Es gewinnt nicht der beste Spieler, sondern der beste Entertainer.“ |

Auf Plattformen wie Twitch gilt: Die Community beeinflusst stark, wie viel Geld Streamer verdienen können. Wer eine starke Zuschauergemeinde aufbauen kann, freut sich in der Regel über ein höheres Einkommen – dabei spielt vor allem die Interaktion der Viewer eine zentrale Rolle.

Aktuell weisen diese top 10 Twitch Channels die höchsten Zuschauerzahlen vor:

Streamer | Durchschnittliche Zuschauerzahl | Follower |

126.449 | 19,8 Millionen | |

52.024 | 7,9 Millionen | |

46.844 | 3,3 Millionen | |

36.903 | 2,2 Millionen | |

29.320 | 2,2 Millionen | |

71.045 | 1,5 Millionen | |

31.839 | 1,5 Millionen | |

42.837 | 1,4 Millionen | |

34.996 | 1,1 Millionen | |

30.438 | 993.817 |

Geld verdienen mit Streaming: Diese Faktoren wirken sich auf Twitch Einnahmen aus

Die Twitch-Einnahmen der verschiedenen Streamer setzen sich aus unterschiedlichen Verdienstquellen zusammen. So können die Kontoinhaber Werbung in ihren Live-Übertragungen schalten, die ihnen je nach Zuschauerzahl und Länge der Werbepause einen kleinen bis mittleren Betrag einbringen. Hierbei handelt es sich jedoch um ein eher statisches Nebeneinkommen, das die meisten Streamer auch als nebensächlich empfinden. Den größeren Teil des Twitch Einkommens machen Abonnements und Spenden der Zuschauer aus, aber auch Sponsoring und Markenpartnerschaften.

Übrigens: Twitch Auszahlungen erfolgen automatisch via PayPal oder Banküberweisung, sofern ein gewisser Mindestbetrag erreicht wurde. In diesem Zusammenhang bieten mobile casinos, ähnlich wie Streaming-Plattformen, eine bequeme Möglichkeit für Spieler, jederzeit und überall zu spielen, ohne auf traditionelle Zahlungsmethoden angewiesen zu sein. Diese Art von Plattformen hat sich zu einer beliebten Option entwickelt, da sie den Nutzern schnelle Auszahlungen und einfache Handhabung bieten.

Twitch Daten Leak 2021: Das verdienen Top-Streamer

Ende 2021 wurde die bekannte Plattform Twitch gehackt. Bei einem Datenleck kam heraus, dass die 2014 von Amazon gekaufte Plattform kaum Sicherheitsvorkehrungen geschaffen hatte – weshalb große Teile des Programmiercodes sowie Login-Daten und Zahlen zum Streamer Verdienst veröffentlicht werden konnten. Zu sehen waren vor allem die Gesamteinnahmen der Top Spieler aus den Twitch Statistiken des Zeitraumes August 2018 bis Oktober 2021 in US-Dollar:

- CriticalRole: 9,6 Millionen

- xQc: 8,5 Millionen

- summit1g: 5,8 Millionen

- Tfue: 5,3 Millionen

- Nickmercs: 5,1 Millionen

Zum Vergleich: Der deutsche Twitch Streamer Marcel Eris (alias MontanaBlack88) hat über Twitch 2,4 Millionen US-Dollar eingenommen. Der Streamer MontanaBlack88 gehört zu den bestbezahlten deutschen Spielern auf Twitch.

Damit werden die großen Unterschiede zwischen den Verdiensten der Streamer aus Deutschland und den USA deutlich. Rund vier Millionen Deutsche verfolgen Twitch-Übertragungen – und das sogar täglich. In den USA liegt die tägliche Zuschauerzahl bei stolzen 35 Millionen Nutzern, sodass amerikanische Streamer auch einen deutlich größeren Markt bedienen und die Einkommensunterschiede nicht verwunderlich sind. MontanaBlack88 ist allerdings auch auf anderen Plattformen wie YouTube zu finden, sodass sein Gesamtverdienst womöglich deutlich höher liegt.

Gut zu wissen: Twitch Partner (von Twitch ausgewählte Streamer mit qualitativem Content) können sich über höhere Einnahmen freuen – etwa einen höheren Anteil aus dem Abonnenten-Verdienst.

Im Detail: So setzt sich der Verdienst zusammen

Wie eingangs erwähnt, verdienen Twitch Streamer vor allem durch Abonnenten einen großen Teil ihres Einkommens. Das Abonnement kostet Subscribern in der ersten Stufe 4,99 Euro – wovon Streamer in der Regel 50% (2,50 Euro) behalten dürfen. Dafür erhalten Abonnenten bestimmte Vorteile wie etwa die Möglichkeit, per Chat mit dem Streamer interagieren zu können. Wer also 1.000 Abonnenten hat, kann deshalb schon mit Einnahmen von 2.500 Euro monatlich rechnen.

Einen Großteil ihrer Einnahmen generieren Gaming-Streamer aber auch mit Hilfe von Subscriber-Spenden. Diese werden in Twitch Bits genannt und von der Plattform ausgezahlt. Die Spenden rufen bei einigen Streamern emotionale Reaktionen hervor, was wiederum mehr Menschen zum Spenden anregt.

Eine weitere Möglichkeit stellt Affiliate-Marketing dar: Streamer bewerben in dem Fall für ihre Zuschauer interessante Produkte in ihren Videos. Kaufen Zuschauer die Produkte, profitieren Streamer von einer Provision – die nicht selten 30% des Kaufbetrages ausmacht.

Sponsoren und Markendeals als größte Einnahmequelle für Streamer

An Streamer mit besonders hohen Zuschauer- und Followerzahlen treten oft auch bekannte Marken heran. Sie bezahlen die Gamer dafür, ihre Produkte im Live-Stream anzupreisen – beispielsweise Gaming-Peripherie oder Energy-Drinks. Soll dies über einen längeren Zeitraum geschehen, werden solche Marken oft auch zum Sponsor des Spielers, um ihre eigene Reichweite zu erhöhen.

Kosten und Abzüge: Dem steht der Streamer Gehalt in Deutschland gegenüber

Die genannten Streamer Gehälter stellen Brutto-Summen dar – also den Verdienst vor Abzug der deutschen Einkommens-, Umsatz- und Gewerbesteuer, sowie Sozialversicherungen. Wer all diese Beträge zusammenzählt, muss oft bis zu 45% seines Brutto-Einkommens an den Fiskus abführen. Doch damit nicht genug: Die meisten Twitch-Streamer müssen auch Chat-Moderatoren bezahlen, die für eine angenehme Atmosphäre unter den Kommentierenden sorgen und Community-Richtlinien durchsetzen.

Darüber hinaus wollen sich Zuschauer nur Streams ansehen, die eine hohe Qualität aufweisen. Um leistungsstark spielen und den Verlauf optimal übertragen zu können, brauchen Streamer bestimmtes Gaming-Equipment, das selbst zwischen 2.000 und 10.000 Euro kosten kann. Auch eine stabile Internetverbindung und die damit verbundenen Kosten sind zu bedenken.

Alternative Plattformen zur Diversifizierung

Um noch mehr Einkommen zu generieren, können passionierte Spieler ihre Streams allerdings zusätzlich auf anderen Plattformen veröffentlichen und monetarisieren – beispielsweise durch Werbung und Affiliate-Marketing. Zur Diversifizierung kommen Plattformen wie YouTube und Kick in Frage, die teilweise sogar bessere Konditionen bieten. Denn: Bei Kick werden Streamer zu 95% an den Einnahmen durch Abonnements beteiligt, was im Gegensatz zu Twitch deutlich attraktiver erscheint.

to teach: Vom KI-Hype zur Schulinfrastruktur

Wie das 2022 gegründete EdTech to teach die Lücke zwischen Chatbot und Klassenzimmer schließt.

Vor drei Jahren begann mit dem öffentlichen Zugang zu generativer künstlicher Intelligenz ein weltweiter Hype, der auch vor den Schultoren nicht haltmachte. Doch im Bildungsmarkt entscheidet sich derzeit, ob die Technologie tatsächlich Produktivität schafft oder in einer digitalen Sackgasse endet. Das Hamburger EdTech to teach liefert hierzu eine Blaupause: Was 2022 als Experiment begann, hat sich innerhalb von drei Jahren zu einer Arbeitsplattform für hunderttausende Lehrkräfte entwickelt.

Das Problem: US-Tools verstehen deutsche Schulen nicht

Als generative KI erstmals verfügbar wurde, wirkte ihr Einsatz im Bildungsbereich naheliegend. Doch der Blick auf die internationale Konkurrenz zeigt das Dilemma: Während US-Platzhirsche wie MagicSchool AI oder Diffit den Markt mit hunderten Mikro-Tools fluten und technisch beeindrucken, fehlt ihnen der kulturelle Fit. „Einfach nur Texte aus ChatGPT zu kopieren, löst kein einziges Problem von Lehrkräften“, erklärt Felix Weiß, Co-Founder und CEO von to teach.

Die Diskrepanz zwischen dem Versprechen der KI und dem tatsächlichen Schulalltag war groß. US-Lösungen scheitern oft an spezifischen deutschen Lehrplänen oder liefern reine Multiple-Choice-Formate, die hierzulande kaum Anwendung finden. Lehrkräfte benötigten keine unstrukturierten Textwüsten, sondern didaktisch saubere, lehrplankonforme und sofort einsetzbare Materialien. Genau hier setzte das 2022 von Felix Weiß und Marius Lindenmeier gegründete Unternehmen an.

Der Pivot: Datenschutz als Burggraben

Der entscheidende Wendepunkt kam 2023. Das Start-up vollzog einen Strategiewechsel (Pivot) weg von einer SaaS-Lösung für Verlage hin zu einer direkten Plattform für Lehrkräfte. Anstatt Nutzer*innen mit freien Eingabefeldern (Prompts) allein zu lassen, entwickelte das Team feste Arbeitsblattvorlagen. Dies wurde zum entscheidenden Wettbewerbsvorteil gegenüber internationalen Anbietern: Während diese oft an der strikten DSGVO scheitern, bietet to teach durch Serverstandorte in der EU und Rechtssicherheit eine Lösung, die Schulträger akzeptieren.

Dabei mussten technische Kinderkrankheiten überwunden werden: Frühe KI-Modelle „halluzinierten“ Fakten. To teach reagierte mit der systematischen Integration von Quellen und profitierte zugleich von der rasanten Evolution der Sprachmodelle.

Skalierung im Ökosystem gegen nationale Konkurrenz

Der Markt nahm die Lösung schnell an: Im Januar 2023 meldete sich der erste Nutzer an, bis Ende des Jahres waren es laut Unternehmen bereits knapp 16.000 Lehrkräfte. Das Jahr 2024 markierte dann den Übergang vom Start-up zur Plattform: Durch die Übernahme von fobizz (101skills GmbH) wurde to teach Teil eines größeren Bildungsökosystems. Die Gründer blieben als Geschäftsführer an Bord.

Dieser Schritt war strategisch überlebenswichtig in einem sich konsolidierenden Markt. Einerseits gegenüber agilen Herausforderern, da Konkurrenten wie schulKI, Teachino, KIULY oder Kuraplan zum Teil aggressiv um Landeslizenzen kämpfen bzw. auf dem Markt für KI-gestützte Unterrichtsplanung und Materialerstellung durchgestartet sind.

Andererseits war der Schritte in Hinblick auf etablierte Verlage notwendig. Denn Häuser wie Cornelsen ziehen inzwischen mit eigenen KI-Assistenten nach, sperren ihre Inhalte jedoch oft in geschlossene Systeme, d.h. binden sie oft an die eigenen Verlagswerke.

Durch die erfolgreiche Integration in fobizz ist to teach kein isoliertes Insel-Tool mehr, sondern profitiert von bestehenden Landesrahmenverträgen und einem riesigen Vertriebsnetz. Die Nutzer*innenzahlen explodierten förmlich auf über 140.000 Lehrkräfte bis Ende 2024, so die Angaben von to teach.

Status Quo 2025: KI als neue Infrastruktur

Heute, im dritten Jahr nach der Gründung, hat sich der Fokus erneut verschoben. To teach versteht sich inzwischen als Arbeitsinfrastruktur. Die Zahlen unterstreichen diesen Anspruch: Nach Angaben von to teach nutzen über 300.000 Lehrkräfte die Plattform, und mehr als 4.000 Schulen sind angebunden. Das bedeutet: Millionen von Inhalten wurden so bereits KI-gestützt vorbereitet.

Das Unternehmen treibt nun den systematischen Schulvertrieb voran. Damit beweisen EdTechs wie to teach, dass sich Qualität und Personalisierung im sonst oft als innovationsresistent geltenden Bildungsmarkt skalieren lassen.

Für CEO Felix Weiß ist die Diskussion über das „Ob“ längst beendet: „Die Frage ist nicht mehr, ob KI im Klassenzimmer ankommt, sondern, wie und auf welche Weise sie dort wirklich hilft.“

Social Engineering auf dem Vormarsch

Wie Deepfakes die Sicherheit von Führungskräften stärker in den Fokus rücken.

Fotorealistische KI liefert innerhalb von kürzester Zeit realistische Visuals. Was in vielerlei Hinsicht den Arbeitsalltag erleichtert, bedeutet für Social Engineering jedoch eine neue Eskalationsstufe, wie nicht zuletzt die hitzige Debatte um massenhaft sexualisierte Deepfakes von realen Personen durch Grok eindrücklich vor Augen führte.

Auch Personen in leitenden Funktionen in Unternehmen sind vor solchen Manipulationen nicht gefeit. Zunehmend zielen Angriffe auf Menschen mit Zugriffsrechten und Entscheidungsbefugnissen, deren Freigaben unmittelbare Wirkung auf die Sicherheit einer ganzen Organisation haben. „Fotorealistische KI und hybride Social-Engineering-Kampagnen erhöhen den Druck auf Schlüsselpersonen. Daher brauchen Unternehmen belastbare Verifikationsprozesse, Krisenroutinen und integrierte Schutzkonzepte“, erklärt Markus Weidenauer, geschäftsführender Gesellschafter der SecCon Group GmbH.

Deepfakes zielen auf privates Umfeld

Nach Angaben des Bundesamts für Sicherheit in der Informationstechnik (BSI) lassen sich Deepfakes als Verfahren beschreiben, die gezielt Spear-Phishing und andere Social-Engineering-Angriffe nutzen, um Vertrauen aufzubauen und Autorität zu simulieren. Generative KI fungiert dabei als zentraler technischer Enabler, da sie die realistische Erzeugung manipulativer Audio-, Video- und Textinhalte erstmals in industriellem Maßstab ermöglicht. „Die eigentliche Bedrohung ergibt sich dabei nicht aus einzelnen KI-generierten Inhalten, sondern aus deren koordinierter Nutzung“, weiß der Sicherheitsexperte.

Infolge der steigenden Qualität und der zunehmenden Verfügbarkeit generativer KI wird es darüber hinaus zunehmend schwieriger, Fakt von Fiktion zu unterscheiden „Zwar können isolierte Inhalte für sich betrachtet zweifelhaft sein, doch das konsistente Zusammenspiel mehrerer manipulierter Medieninhalte erhöht die wahrgenommene Glaubwürdigkeit erheblich“, ergänzt der Profi und weist darauf hin, dass sich diese Entwicklung in der Praxis zuspitzt. „Social Engineering, Deepfakes und digitale Erpressung werden immer häufiger mit Observationen des privaten Umfelds sowie Angriffen auf die Heim-IT kombiniert. Durch diese Eskalation der Angriffsmittel bauen Täter gezielt psychologischen Druck auf, der die Widerstandsfähigkeit der Betroffenen weiter reduziert.“

Risiken kennen, Wege einüben

Kompromittierte Schlüsselpersonen mit Steuerungs- und Entscheidungsfähigkeiten bergen hohes Schadenspotenzial für Betriebe. Das reicht von unmittelbaren finanziellen Verlusten bis zu dauerhaften Reputationsschäden. Dieses Risiko wird insbesondere dort verstärkt, wo organisatorische und prozessuale Absicherungen fehlen. „Resilienz bedeutet aber, auch in potenziellen Krisensituationen sichere Entscheidungen treffen zu können“, betont Markus Weidenauer. Trotzdem mangelt es vielen Unternehmen sowohl an speziellen Trainings zum Thema Social Engineering als auch an Meldewegen, klaren Freigabeprozessen, die auch unter Druck funktionieren, sowie alternativen Kommunikationskanälen. „Nur wenn Mitarbeiter diese Strukturen kennen und regelmäßig einüben, entsteht eine Kultur, in der eine frühzeitige Eskalation in der Meldekette als notwendiger Beitrag zur Sicherheit des gesamten Betriebs wahrgenommen wird“, fügt Markus Weidenauer hinzu.

Dringender Handlungsbedarf in Unternehmen

Um hier Abhilfe zu schaffen, verabschiedete im September 2025 das Bundeskabinett das sogenannte KRITIS-Dachgesetz zur Stärkung der Resilienz kritischer Einrichtungen. Es verpflichtet die Unternehmensleitung, Schutz- und Präventionsmaßnahmen umzusetzen, deren Wirksamkeit nachzuweisen ist. Der dem Regelwerk zugrunde liegende All-Gefahren-Ansatz fordert, dabei physische, digitale und organisatorische Dimensionen gemeinsam zu betrachten. „Auch wenn Führungskräftesicherheit hier kein eigener Rechtsbegriff ist, sollte sie Teil der Anforderungen an ein modernes Sicherheitsmanagement sein“, so der Geschäftsführer der SecCon Group.

Das bedeutet: Führungskräfte etwa vor Erpressungsversuchen durch Social Engineering zu schützen, ist weder persönlicher Luxus noch Symbolpolitik, sondern ein Element der nachweisbaren Unternehmensresilienz. Schließlich ist die Sicherung von Steuerungs- und Entscheidungsfähigkeit ein Governance-Baustein. Nicht die Person steht im Mittelpunkt, sondern die Handlungsfähigkeit des Instituts.