Aktuelle Events

NEONLAB – digitales Lernmanagement für Schulen

Das 2020 von Julian Weissbach gegründete Start-up NEONLAB bietet DSGVO-konformes Lernmanagementsystem für Schulen, das Kommunikation und digitalen Unterricht verbindet.

Während der Zeit des Homeschoolings und Distanzlernens wurden viele Schulen in Deutschland vor neue Herausforderungen gestellt: Unterricht musste vom einen Tag auf den anderen digital stattfinden. Lehrkräfte benötigten Möglichkeiten der Videoübertragung, Dateiablage und Kommunikation zwischen Schule, Lehrkraft und Schülern. Schnell wurde klar, dass die bis Dato vorhandenen Plattformen den Anforderungen nicht gerecht wurden, wie auch Andreas Bartsch, Präsident des Nordrhein-Westfälischen Lehrerverbands, bestätigt: „In vielen Schulen, auch in NRW, fehlen WLAN, Ausstattung, Lehrerfortbildungen und passende Plattformen, um das Distanzlernen sinnvoll umzusetzen. Viele wichen deshalb auf Plattformen wie MS Teams, WhatsApp oder Moodle- basierte Tools aus. Diese sind jedoch entweder sehr komplex zu handhaben oder erfüllen die Datenschutzanforderungen nicht. Deshalb kommt NEONLAB nun zur richtigen Zeit.”

DSGVO-Konformität, einfache Bedienbarkeit und schnelle Integration

16 Bildungssysteme, verschiedene Schulformen und eine unüberschaubare Anzahl von digitalen Kommunikationslösungen - Julian Weissbach, ehemaliger Youtuber und Referent für Social-Media-Themen an Schulen, will mit seinem 2020 gegründeten Start-up NEONLAB mehr Demokratie in die Bildung bringen: „Digitale Lernmanagementsysteme sind in deutschen Schulen kaum mehr wegzudenken. Wir wollen diesen aber mit unserem LMS die Möglichkeit geben, digitale Kommunikation und digitalen Unterricht unter Einhaltung der DSGVO-Norm in Einklang zu bringen.”

Besonders Gleichberechtigung und Chancengleichheit sind dabei wichtige Ziele der Plattform: Auch Grundschulen, Mittelschulen und Förderschulen sollen schnell mit dem Tool umgehen können und damit den Anschluss an die Digitalisierung nicht verlieren. Besonders wichtig war Weissbach bei der Entwicklung daher, dass das Lernmanagementsystem einfach zu bedienen ist, auch auf älteren Endgeräten funktioniert und schnell in der Schule integriert werden kann. So ist es zum Beispiel möglich, zu Beginn nur zwei oder drei Klassen an das System anzubinden.

Die Stemweder-Berg-Schule und Schulleitungsmitglied Michael Niehaus haben NEONLAB bereits getestet: „Nach dem ersten Einsatz kann ich mit gutem Gewissen sagen, dass wir mit NEONLAB eine Plattform geschaffen haben, die alle Grundbedürfnisse einer Schule erfüllt. Besonders die schrittweise Implementierung ist sehr hilfreich. Und auch das Baukastenprinzip zur Erstellung von Unterrichtseinheiten ist selbsterklärend und einfach in den Unterricht zu integrieren“, erläutert Niehaus, der selbst von Beginn an NEONLAB beraten hat.

Unterstützung bekommt das Start-up auch vom Nordrhein-Westfälischen Lehrerverband: „An NEONLAB schätzen wir besonders den Austausch zwischen Lehrkräften und Schülern sowie die Offenheit, das Tool nach den Bedürfnissen der Schulen weiter zu optimieren. Unsere Unterstützung ist zu 100 Prozent gewiss, denn ich bin davon überzeugt, dass NEONLAB eine gute Alternative gegenüber den vorhandenen Plattformen bietet”, erklärt Bartsch.

Unterrichtsgestaltung, interne Kommunikation und Fortbildungen

Neben der modulartigen Erstellung von Unterrichtseinheiten bieten auch Chats, Pinnwände, Videokonferenzen, Verwaltungsfunktionen sowie ein Organisationstool die Möglichkeit, sich intern auszutauschen und zu organisieren. Das Tools ermöglicht so eine breite Medienvielfalt im Unterricht sowie das Lernen auf Distanz. Durch diese Funktionen ist es eine Kommunikations-, aber auch eine Bildungsplattform. Für Lehrkräfte wird ein Netzwerk geschaffen, in dem sie sich über Unterrichtsmaterialien und -methoden austauschen können, um die Herausforderung des digitalen Lernens gemeinsam zu meistern.

Zusätzlich zur Materialerstellung für den Unterricht bietet das Start-up auch Fortbildungen für Lehrkräfte und Schüler zu digitalen Themen an. So erhalten die Teilnehmenden zugleich auch einen tieferen Einblick in das Thema Digitalisierung.

Diese Artikel könnten Sie auch interessieren:

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

StartingUp-DeepTech-Watchlist 2026

Von „German Engineering“ zu „German DeepTech“: Diese jungen Start-ups und Scale-ups zünden 2026 die nächste Stufe – und sollten zwingend auf dem Radar von Investor*innen und Entscheider*innen stehen.

„Prognosen sind schwierig, vor allem, wenn sie die Zukunft betreffen.“ Dieser Ausspruch unterstreicht die Herausforderung, die Dynamik unseres Start-up-Ökosystems vorherzusagen. Doch wer 2025 aufmerksam verfolgt hat, der spürt: Es hat sich etwas gedreht. Der Investor*innenfokus hat sich verschoben – weg von reinen E-Commerce-Modellen, hin zu substanzieller Technologie, die echte physikalische Probleme löst.

Die folgende Auswahl an Start-ups und Scale-ups, mit denen 2026 gerechnet werden sollte, ist mehr als eine Watchlist. Sie basiert auf einer Analyse der signifikanten Finanzierungsrunden 2025, der technologischen Reife und der Resonanz bei bedeutenden Preisen. Diese Unternehmen stehen beispielhaft für eine Gründer*innengeneration, die Wissenschaft und Skalierung vereint. Natürlich bleibt ein Restrisiko. Unwägbarkeiten – von geopolitischen Instabilitäten über regulatorische Verschärfungen wie dem EU AI Act bis hin zu volatilen Zinsmärkten – können die nahe Zukunft beeinflussen. Doch die Resilienz dieser Unternehmen stimmt optimistisch.

DefenseTech: Die neue Realität der Sicherheit

Lange war Verteidigungstechnologie in Deutschland ein Tabuthema für Risikokapitalgeber. Das hat sich grundlegend geändert. Ganz oben auf der Watchlist steht neben dem Münchner Start-up Helsing nun das 2024 gegründete Black Forest Labs. Das Geschäftsmodell ist faszinierend, weil es die Grenzen zwischen kreativer Zerstörung und Sicherheitstechnologie verwischt. Es basiert auf der Entwicklung proprietärer State-of-the-Art-Modelle für generative Videoerzeugung. Nach einer spektakulären 300-Mio.-USD-Runde im Dezember 2025 katapultierte sich die Bewertung auf satte 3,25 Milliarden USD. Das Start-up ist damit Deutschlands wertvollste KI-Firma und beweist, dass Europa bei Generative AI den Anschluss nicht verloren hat. Der globale Siegeszug deutet sich 2026 unter anderem in einem mehrjährigen Vertrag mit Meta sowie in Kooperationen mit US-Plattformen wie X und Hollywood-Studios an, die Produktionskosten senken wollen. Mitgründer Robin Rombach prognostizierte im Sifted-Podcast: „2026 wird generative Video-KI zum industriellen Standard in der Medienproduktion.“ Doch auch bei der Simulation für Sicherheitsszenarien spielt die Technologie eine wachsende Rolle.

Ein weiterer Schlüsselakteur ist Stark Defence. Das 2024 gegründete Münchner Start-up adressiert eine Lücke der modernen Kriegsführung: asymmetrische Bedrohungen. Stark Defence fokussiert sich auf softwaredefinierte, autonome Drohnensysteme, die „on the edge“ entscheiden und nicht auf ständige Funkverbindung angewiesen sind. Dass das Start-up durch seine KI-Schwarmtechnologie massiv an Bedeutung gewinnen wird, hat sich Ende Februar 2026 eindrucksvoll bestätigt: Der Haushaltsausschuss des Bundestages gab einen Auftrag über 540 Millionen Euro für Kampfdrohnen frei, den sich Stark Defence (Modell „Virtus“) und das nach einer Mega-Runde im Sommer 2025 mittlerweile mit 12 Milliarden Euro bewertete Münchner Unicorn Helsing (Modell „HX-2“) teilen. Um diese rasante Skalierung zu stemmen, hat Stark Defence kürzlich das Berliner Software-Start-up Pleno übernommen und eine neue Serienfertigung im britischen Swindon eröffnet. Mitgründer Florian Seibel dazu: „Unser Ziel für 2026 ist die erste vollautonome Verteidigungslinie für Europa.“

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

KI gegen Buchhaltungsriesen: Wie Bonster den Spesen-Markt aufmischen will

Pay-per-Use statt Abo-Falle: Das Oldenburger Start-up fast2work attackiert mit seiner App bonster komplexe Software-Giganten. Doch reicht das Versprechen maximaler Einfachheit im Haifischbecken der FinTechs? Wir haben nachgehakt.

Es ist eines der letzten großen Ärgernisse im Arbeitsalltag von Freelancer*innen und kleinen Agenturen: Der Freitagabend, der für das Sortieren verknitterter Tankbelege und das Abtippen von Bewirtungsbelegen in Excel-Listen draufgeht. Genau hier setzt die Oldenburger fast2work GmbH mit ihrer am 17. Februar 2026 gelaunchten App bonster an, um den Papierkram bei der Reisekostenabrechnung zu beenden. Das Versprechen von Gründer und CEO Ronald Bankowsky: Drei Minuten Aufwand, KI-Automatisierung und keine Einstiegshürden.

Das Versprechen: Simpel statt Systemintegration

Die Funktionsweise der App ist bewusst minimalistisch gehalten: Beleg fotografieren, woraufhin die KI relevante Werte wie Datum, Betrag und Mehrwertsteuer ausliest, auf Duplikate prüft und eine fertige Abrechnung erstellt. „Kein Onboarding-Projekt, kein Vertriebsgespräch, kein IT-Setup“, fasst Bankowsky den Ansatz der Standalone-Lösung zusammen.

Die Zielgruppe ist klar definiert: Selbständige, Freelancer*innen und Mini-Teams, denen Enterprise-Lösungen wie SAP Concur zu mächtig und Start-ups wie Circula oder Pleo oft noch zu prozesslastig sind. Mit einem Preismodell von 1,99 Euro für Einzelabrechnungen und 6,99 Euro (Stand Ende Febr. 2026) für eine Flatrate positioniert sich das Unternehmen im unteren Preissegment.

Im Haifischbecken der Neobanken und Buchhaltungsriesen

Laut fast2work gab es bislang „kaum eine Alternative zwischen Excel und Enterprise-Software“. Diese Aussage hält einem Realitätscheck im Jahr 2026 allerdings nur bedingt stand. Bonster betritt ein Haifischbecken, denn die vermeintliche Lücke wird längst geschlossen.

Zum einen integrieren Buchhaltungsriesen wie Lexoffice oder sevDesk Reisekosten-Features immer tiefer in ihre Standardpakete. Zum anderen wildern Neobanken wie Qonto, Finom oder Kontist im selben Revier: Wer dort ein Geschäftskonto hat, bekommt die Belegzuordnung oft als „Commodity“ gratis dazu. Mit knapp 7 Euro im Monat bewegt sich bonster in einer Preisregion, in der man fast schon eine komplette einfache Buchhaltungssoftware bekommt. Die App muss also einen enormen Mehrwert bieten, um gegen die „Eh-da-Lösungen“ (Software, die Kund*innen ohnehin bezahlen) zu bestehen.

Auf die Frage, warum Freelancer*innen für eine Insellösung extra zahlen sollten, entgegnet der Gründer, dass bonster bewusst früher ansetze als klassische Tools. Das Hauptproblem sei nicht die Buchhaltung, sondern das Erfassen von Belegen unterwegs. „Genau dort scheitert es oft, weil Mitarbeitende keine komplexen Systeme nutzen wollen oder gar keine Zugänge haben“, argumentiert Bankowsky. Der Mehrwert liege nicht in einer weiteren Buchhaltungssoftware, sondern darin, dass durch die Reduzierung auf ein Foto „überhaupt verwertbare Abrechnungsdaten/Belege entstehen“.

Kritische Faktoren: GoBD und Datensicherheit

Neben der Marktpositionierung ist die Rechtssicherheit ein kritischer Faktor. „Fertige Abrechnung für die Buchhaltung“ ist ein mutiges Versprechen, da in Deutschland ein Foto allein oft nicht ausreicht; es muss GoBD-konform und revisionssicher archiviert werden. Zudem ist die KI-Nutzung datenschutzrechtlich sensibel. Wenn Bewirtungsbelege, die offenbaren, mit wem man gegessen hat, über US-Schnittstellen (z.B. OpenAI) fließen, ist das für deutsche Geschäftskund*innen und Steuerberater oft ein K.O.-Kriterium.

Auf die sensiblen Vorgaben der Finanzämter und den Serverstandort angesprochen, betont Bankowsky, dass die Verarbeitung „ausschließlich auf europäischen Servern“ erfolge. Zwar nutze man OpenAI-basierte Modelle, diese liefen jedoch über Azure-Rechenzentren im europäischen Raum. Datenschutz und regulatorische Anforderungen seien Grundvoraussetzung. Auch beim Export zum Steuerberater zeigt sich der Gründer zuversichtlich: Buchhaltungssysteme könnten die Daten direkt und „ohne manuelle Nacharbeit“ weiterverarbeiten.

Beta-Test als Exklusiv-Club

Zum Start setzt das Unternehmen auf eine Gamification des Rollouts. Die ersten 500 Nutzer*innen erhalten im „Club 500“ einen lebenslangen Rabatt von 50 Prozent. Was als Belohnung für Early Adopters verkauft wird, ist strategisch notwendig: Die KI muss lernen. Der Algorithmus braucht dringend „Real World Data“ – echte, verknitterte, schlecht beleuchtete Belege. Das bedeutet auch: Die ersten User*innen sind Teil des Entwicklungsprozesses.

Dass die App im Alltag noch dazulernen muss, räumt Bankowsky ein. Bei der reinen Datenerkennung sei man technisch auf dem aktuellen Stand. „Entscheidend ist jedoch die Qualität realer Belege im Alltag – etwa schlecht fotografierte oder handschriftliche Quittungen“, erklärt er den Bedarf an Praxis-Feedback. Durch schnelle Updates solle die Genauigkeit für alle Nutzer*innen laufend steigen.

Gegenmodell zur Ökosystem-Abhängigkeit

Wer ein Feature-Feuerwerk suche, werde bei bonster enttäuscht sein – was laut Unternehmen aus Überzeugung geschehe. Anbieter wie Rydoo verfolgten eine Strategie der maximalen Integration und langfristiger Verträge, was eine Abhängigkeit erzeuge, die ihr eigentliches Geschäftsmodell sei, so der Gründer. Wer einmal im Ökosystem stecke, wechsle nicht mehr, weil der Ausstieg zu teuer geworden sei.

Bonster positioniert sich als Gegenmodell für Unternehmen, die nicht für ungewollte Komplexität zahlen möchten: Kein Vertrag, keine Mindestnutzerzahl, Setup in unter fünf Minuten und ein Pay-per-Use-Modell. „Wer aufhören will, hört auf, ohne Konsequenzen“, beschreibt das Start-up den Ansatz der bewussten Entscheidung, Kund*innen freizulassen. Wer bleibe, tue dies, weil es funktioniere, was laut Bankowsky „die interessantere Innovation“ sei.

Fazit

Bonster ist ein innovativer Angriff auf die Zettelwirtschaft und wirkt durch den Verzicht auf starre Abo-Modelle bei der Einzelabrechnung fair. Doch die App steht und fällt mit der Schnittstellenkompetenz. Wenn der Export zu DATEV & Co. hakt, wird aus der Zeitersparnis schnell Mehrarbeit. Bonster muss beweisen, dass es die Brücke zwischen dem schnellen Foto und der strengen deutschen Buchhaltung schlagen kann – und zwar besser als die Banken, die das Feature bereits kostenlos anbieten.

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

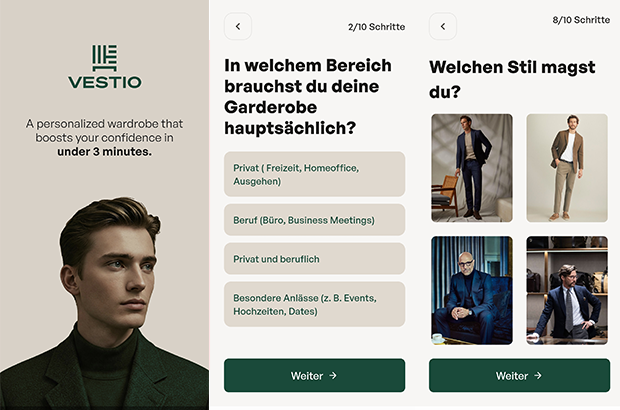

VESTIO: Wenn ein Solar-Entrepreneur auf einen Stil-Rebellen trifft

Die Geschichte der jungen FashionTech-App VESTIO ist zugleich die zweier Gründer, die sich in einem gemeinsamen Ziel treffen: Die Demokratisierung von gutem Stil durch algorithmische Logik.

Hinter der FashionTech-App VESTIO steht die im Jahr 2024 von Bastian Arend und Justus Hansen gegründete Opus Stilberater GmbH, die den Anspruch erhebt, professionelle Stilberatung erstmals digital, logisch und kostenlos zugänglich zu machen.

Der „Solar-Entrepreneur“ trifft den Stil-Rebell

Die persönlichen Hintergründe der Gründer bieten spannende Kontraste, die weit über ein übliches Business-Profil hinausgehen. Bastian Arend, Co-Founder und CEO, kam über die Energiewende zur Mode. Als Seriengründer baute er den Online-Solar-Anbieter Klarsolar auf und verkaufte ihn im Dezember 2023 erfolgreich an den Energiekonzern E.ON. Die Übernahme erfolgte in einer für die Solarbranche schwierigen Marktphase, was Bastian Arend als Krisen-erprobten Strategen auszeichnet.

VESTIO entwickelte er 2024 jedoch aus einem ganz persönlichen „Pain Point“ heraus: Während er internationale Millionen-Finanzierungsrunden leitete, bestand sein eigener Stil mangels Zeit lediglich aus Hoodie, Jeans und Sneakern. „Ich wollte nur jemanden, der für mich einkauft“, erinnert er sich an diese Phase. Seine Abneigung gegen zeitraubendes Shopping führte ihn schließlich zu Justus Hansen.

Justus Hansen, Co-Founder und Chief Styling Officer, bringt eine Biografie ein, in der Mode schon immer eine zentrale Rolle spielte. Sein Gespür für klassische Mode ist tief verwurzelt: Justus Hansen trug bereits im Kindergarten eine Fliege und provozierte später Lehrer, indem er im Sakko zum Unterricht erschien. Bevor er mit über 1,6 Millionen Follower*innen zu einem der bekanntesten Männerstilberater Deutschlands aufstieg, studierte er Jura und absolvierte Praktika im Bankensektor, unter anderem bei der Dresdner Bank.

Diese Erfahrungen schärften seinen Blick für die Anforderungen moderner „Business-Garderoben“. Als Arend ihn fragte, ob er für ihn einkaufen könne, antwortete Justus Hansen bestimmt: „Einfach irgendwas kaufen? Nein. Ich muss verstehen, wer du bist.“ Bastian Arend begriff Hansens modulare Styling-Methode sofort als logisches System und schlug vor: „Wir sollten deine Methode digitalisieren und kostenlos für jeden Mann zugänglich machen.“ Für Justus Hansen wurde damit ein „Lebenstraum“ wahr.

Das Konzept: „Weniger Teile, mehr Outfits“

Das Herzstück der App bildet ein algorithmisches Styling-System, das strikt dem Leitsatz „Weniger Teile. Mehr Outfits“ folgt. In nur drei Minuten erstellt ein Stilfinder-Fragebogen eine persönliche Grundgarderobe. Der digitale Kleiderschrank funktioniert dabei bewusst ohne das mühsame Hochladen von Fotos; das System kennt die wichtigsten Basics, erkennt Lücken und empfiehlt gezielt Ergänzungen. Justus Hansen betont dabei die Wichtigkeit der Basis: „Die wenigsten Männer besitzen eine echte Basisgarderobe. Und das ist die Grundlage, aus der ihre besten Outfits entstehen.“

Ziel ist es, automatisch kombinierbare Outfits für alle Anlässe zu generieren. Dabei verfolgen die Gründer eine klare ästhetische Linie: „Outfits müssen nicht kompliziert sein, um zu wirken. Sie brauchen lediglich eine klar erkennbare Linie“, so Hansen. Bastian Arend ergänzt: „Die besten Outfits für Männer sind nicht kompliziert, sondern harmonisch und durchdacht.“

Das Affiliate-Dilemma: Geschäftsmodell im kritischen Check

Wirtschaftlich operiert VESTIO über ein Affiliate-Modell. Die App ist für Nutzer kostenlos, während das Unternehmen Provisionen von Partner-Anbietern bei einem erfolgreichen Kauf erhält. Hier liegt für den kritischen Betrachter ein interessanter systemischer Interessenkonflikt: Das erklärte Ziel „Weniger Konsum – bessere Entscheidungen“ steht ökonomisch potenziell im Widerspruch zu einem Modell, das von Transaktionen lebt. Zudem stellt sich die Frage der langfristigen Nutzerbindung: Sobald ein Mann seine „perfekte Garderobe“ aufgebaut hat, sinkt der Bedarf für weitere Anschaffungen. Dass das Unternehmen dennoch auf Wachstum setzt, zeigt die Erhöhung des Stammkapitals auf knapp 30.000 Euro im September 2025. Langfristig plant VESTIO die Integration eines Marktplatzes, der Partnerprodukte und eigene Kollektionen vereint, um basierend auf Daten den größten Mehrwert zu liefern.

Marktpositionierung und technologischer Vorsprung

Im Vergleich zum Wettbewerb besetzt VESTIO eine spezifische Nische. Während Curated-Shopping-Anbieter (z.B. Outfittery) auf den Versand physischer Boxen setzen, bleibt VESTIO ein rein digitaler Guide, der dem Nutzer die volle Freiheit bei der Wahl des Händlers überlässt. Andere Styling-Apps verlangen oft zeitintensive Foto-Inventuren, während VESTIO auf logische Kombinationen setzt.

Das Risiko bleibt jedoch die Abhängigkeit von der Personal Brand Justus Hansens. Letztlich ist VESTIO der Versuch, Mode so effizient wie eine Prozessoptimierung zu gestalten – oder wie Bastian Arend es formuliert: „Viele Männer haben mehr Kleidung als Stil. Vestio ändert das.“ Mit dem Aufbau der App wolle man Männern „genau diese Arbeit abnehmen“, damit sie sich ultimativ „besser fühlen“ können.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

Die Wächter des Firmengedächtnisses

Wie das 2025 von Christian Kirsch und Stefan Kirsch gegründete Start-up amaiko den Strukturwandel im Mittelstand adressiert.

Der demografische Wandel und eine erhöhte Personalfluktuation stellen mittelständische Unternehmen zunehmend vor die Herausforderung, internes Know-how zu bewahren. Viele Unternehmen stehen vor der Schwierigkeit, dass Firmenwissen fragmentiert vorliegt. Informationen sind häufig in unterschiedlichen Systemen oder ausschließlich in den Köpfen der Mitarbeitenden gespeichert. Verlassen langjährige Fachkräfte den Betrieb in den Ruhestand oder wechseln jüngere Arbeitnehmerinnen und Arbeitnehmer kurzfristig die Stelle, gehen diese Informationen oft verloren. Zudem bindet die Suche nach relevanten Dokumenten in verwaisten Ordnerstrukturen Arbeitszeit, die in operativen Prozessen fehlt.

Das 2025 gegründete Start-up amaiko aus Niederbayern setzt hierbei auf einen technischen Ansatz, der auf die Einführung neuer Plattformen verzichtet und stattdessen eine KI-Lösung direkt in die bestehende Infrastruktur von Microsoft Teams integriert. Vor diesem Hintergrund entwickelten die Brüder Christian und Stefan Kirsch mit amaiko eine Softwarelösung, die spezifisch auf die Ressourcenstruktur mittelständischer Betriebe ausgelegt ist.

Integration statt neuer Insellösungen – und die Abgrenzung zu Copilot

Ein wesentliches Merkmal des Ansatzes ist die Entscheidung gegen eine separate Software-Plattform. Christian Kirsch, Geschäftsführer von PASSION4IT und amaiko, positioniert die Lösung als „Teams-native“. Das bedeutet, dass der KI-Assistent technisch in Microsoft Teams eingebettet wird – jene Umgebung, die in vielen Büros bereits als primäres Kommunikationswerkzeug dient. Ziel ist es, die Hürden bei der Implementierung zu senken, da Nutzer ihre gewohnte Arbeitsumgebung nicht verlassen müssen.

Angesichts der Tatsache, dass Microsoft mit dem „Microsoft 365 Copilot“ derzeit eine eigene, tief integrierte KI-Lösung ausrollt, stellt sich die Frage nach der Positionierung. Christian Kirsch sieht hier jedoch keine direkte Konkurrenzsituation, sondern eine klare Differenzierung: Copilot sei eine sehr breite, Microsoft-zentrische KI-Funktion. Amaiko hingegen verstehe sich als spezialisierter, mittelstandsorientierter Wissensassistent, der Beziehungen, Rollen, Prozesse und Unternehmenslogik tiefgreifend abbildet.

Ein entscheidender Vorteil liegt laut Kirsch zudem in der Offenheit des Systems: „Während Copilot naturgemäß an Microsoft‑Systeme gebunden ist, lässt sich amaiko herstellerunabhängig in eine viel breitere Softwarelandschaft integrieren – vom ERP über CRM bis zu Branchenlösungen. Unser Ziel ist nicht, Copilot zu kopieren, sondern reale Mittelstandsprozesse nutzbar zu machen“, so der Co-Founder.

Funktionsweise, Sicherheit und Haftung

Funktional unterscheidet sich das System von herkömmlichen Suchmasken durch eine agentenähnliche Logik. Die Software bündelt Wissen aus internen Quellen wie Richtlinien oder Projektdokumentationen und stellt diese kontextbezogen zur Verfügung. Ein Fokus liegt dabei auf der Datensouveränität. Hierbei betont Christian Kirsch, dass Kundendaten nicht in öffentlichen Modellen verarbeitet werden: „Die Modelle laufen in der europäischen Azure AI Foundry, unsere eigenen Dienste auf deutschen Servern. Die Daten des Kunden bleiben on rest vollständig im jeweiligen Microsoft‑365‑Tenant. Es findet kein Training der Foundation Models mit Kundendaten statt – weder bei Microsoft noch bei uns. Grundlage dafür sind die Azure OpenAI Non‑Training Guarantees, die Microsoft in den Product Terms sowie in SOC‑2/SOC‑3‑ und ISO‑27001‑Reports dokumentiert.“

Auch rechtlich zieht das Start-up eine klare Grenze, sollte die KI einmal fehlerhafte Informationen, sogenannte Halluzinationen, liefern. „Amaiko generiert Vorschläge, keine rechts‑ oder sicherheitsverbindlichen Anweisungen. Das stellen wir in unseren AGB klar: Die Entscheidungshoheit bleibt beim Unternehmen. Wir haften für den sicheren Betrieb der Plattform, nicht für kundenseitig freigegebene Inhalte oder daraus abgeleitete Maßnahmen. Es geht um eine saubere Abgrenzung – technische Verantwortung bei uns, inhaltliche Verantwortung beim Unternehmen“, so Christian Kirsch.

Geschäftsmodell und Markteintritt

Seit der Vorstellung der Version amaiko.ai im Juli 2025 wird das System nach Angaben des Unternehmens mittlerweile von über 200 Anwendern genutzt. Durch die Integration in die bestehende Microsoft-365-Landschaft entfällt für mittelständische Kunden eine aufwendige Systemmigration, was die technische Eintrittsbarriere gering hält.

Passend zu diesem Ansatz ist amaiko als reines SaaS-Produkt konzipiert, das Unternehmen ohne Einstiegshürde direkt online buchen können. Laut Kirsch sind keine Vorprojekte, individuellen Integrationspfade oder teuren Beratungspflichten notwendig: „Die Nutzung ist selbsterklärend und leichtgewichtig. Wer zusätzlich Unterstützung möchte – etwa zur Wissensstrukturierung oder Governance – kann sie bekommen. Aber die technische Einführung selbst ist bewusst so gestaltet, dass Mittelständler ohne Implementierungsaufwand starten können.“

Unterm Strich liefert amaiko damit eine pragmatische Antwort auf den drohenden Wissensverlust durch den demografischen Wandel: Statt auf komplexe IT-Großprojekte zu setzen, holt das bayerische Start-up die Mitarbeitenden dort ab, wo sie ohnehin kommunizieren. Ob sich die „Teams-native“-Strategie langfristig gegen die Feature-Macht von Microsoft behauptet, bleibt abzuwarten – doch mit dem Fokus auf Datensouveränität und mittelständische Prozesslogik hat amaiko gewichtige Argumente auf seiner Seite, um sich als spezialisierter Wächter des Firmengedächtnisses zu etablieren.

Diese 10 Start-ups bauen an der Zukunft der AgriFood-Branche

Die deutsche Start-up-Landschaft verzeichnete 2025 ein Rekordhoch bei Neugründungen. Doch gerade im AgriFood-Sektor ist der Weg vom Prototyp zum Marktführer steinig. Kapitalintensive Hardware und strenge Regulatorik bremsen viele aus. Der Growth Alliance Accelerator zeigt, wie Gründer*innen diese Hürden überspringen – und präsentiert zehn Akteure, die auf der Erfolgsspur sind.

Es ist ein Paradoxon: Die Nachfrage nach nachhaltigen Lebensmitteln und effizienter Landwirtschaft ist so hoch wie nie, doch für Gründer*innen und junge Unternehmen in der AgriFood-Branche bleibt der Markteintritt ein Hürdenlauf. Während Software-Start-ups oft mit geringem Kapital skalieren, kämpfen Food- und AgTech-Pioniere mit der „Hardware-Falle“. Sie benötigen teure Produktionsanlagen, Labore und müssen langwierige Zulassungsverfahren (z.B. Novel-Food-Verordnung) durchlaufen.

Dennoch ist die Branche im Aufwind: Laut dem Deutschen Startup Monitor und aktuellen Zahlen des Startup-Verbands stiegen die Gründungszahlen 2025 um beachtliche 29 Prozent. Das Kapital ist da, doch es fließt selektiv. Investor*innen suchen heute keine reinen Ideen mehr, sondern validierte Geschäftsmodelle mit technologischem Tiefgang (DeepTech). Genau hier setzte das Finale des Growth Alliance Accelerator 2025 am 28. Januar 2026 in Frankfurt/Main an.

Brückenschlag zwischen Acker und Finanzwelt

Initiiert vom TechQuartier und der Landwirtschaftlichen Rentenbank, hat sich der Accelerator als Schmiede für die „Scale-up“-Phase etabliert. Vier Monate lang wurden zehn Start-ups, die bereits eine Nutzer*innenbasis vorweisen konnten, fit für die nächste Finanzierungsrunde gemacht.

Das Programm adressierte genau die Pain Points der Branche: Verhandlungstaktik, Rechtsfragen und vor allem den Zugang zu Kapital. Ein Highlight war das Investor Dinner im November 2025, bei dem die Gründer*innen direkten Zugang zu Risikokapitalgeber*innen erhielten – in der aktuellen Marktphase ein entscheidender Wettbewerbsvorteil.

Die „Class of 2025“: Wer die Transformation treibt

Die zehn Absolvent*innen decken die gesamte Wertschöpfungskette ab – vom Boden über das Labor bis zum Supermarktregal. Hier ein Blick auf die Köpfe hinter den Innovationen:

1. High-Tech auf dem Acker: Robotik und Daten

Die Digitalisierung der Landwirtschaft (Smart Farming) ist der stärkste Hebel für mehr Effizienz.

Paltech GmbH

Die Brüder Felix und Florian Schiegg gründeten 2022 Paltech zusammen mit Jorge Decombe im Allgäu. Ihr autonomer Roboter für chemiefreie Unkrautbekämpfung im Grünland ist eine Antwort auf strengere Pestizid-Gesetze und Personalmangel.

Bacchus Software GmbH

Das 2023 gegründete Start-up bacchus Weinbau-Software um das Trio Maximilian Dick, Julian Herrlich und Philipp Bletzer digitalisiert den Weinbau. Ihre Software ersetzt das händische Fahrtenbuch und koordiniert die komplette Weinbergsarbeit.

Agrario Energy

Die Energiewende macht Landwirt*innen zu Energiewirt*innen. Seit 2023 bieten die Gründer Alexander von Breitenbach und Chris Weber mit Agrario Energy eine unabhängige Vergleichsplattform, die Flächeneigentümer mit Betreiber*innen von Erneuerbare-Energien-Anlagen zusammenbringt.

2. Deep Tech & Sicherheit: Das Labor als Wächter

Lebensmittelsicherheit wird durch globale Lieferketten immer komplexer. Hier setzen wissenschaftsbasierte Ausgründungen an.

NanoStruct GmbH

NanoStruct wurde 2021 als Spin-off der Universität Würzburg gegründet. Das Team nutzt Nanotechnologie, um gefährliche Bakterien in Lebensmitteln in Minuten statt Tagen aufzuspüren.

SAFIA Technologies

Gegründet 2020 von Timm Schwaar (aus der Bundesanstalt für Materialforschung), entwickelt das Berliner Start-up SAFIA Technologies Schnelltests für Mykotoxine (Schimmelpilzgifte). Ihre Technologie ermöglicht Laborqualität im Schnelltest-Format.

Landman.Bio

Das noch junge Unternehmen (Gründung 2023) Landman.Bio nutzt Bakteriophagen (Viren, die Bakterien fressen) als natürliche Waffe gegen Pflanzenkrankheiten – eine dringend benötigte Alternative zu Antibiotika und klassischen Pestiziden in der Nutzpflanzenzucht.

3. Sustainability & Climate: Kohlenstoff als Währung

CO2-Tracking ist kein Marketing-Gimmick mehr, sondern ökonomische Notwendigkeit.

CinSOIL

Das 2024 in Berlin gegründete CinSOIL-Team um Dr. Giorgi Shuradze, Dr. Antonella Succurro und Dr. Tavseef Shah kommt aus der Wissenschaft. Ihr KI-Tool nutzt Satellitendaten, um Bodenkohlenstoff zu erfassen. Das ermöglicht Agrarunternehmen, Dekarbonisierung nicht nur zu behaupten, sondern zu beweisen.

Niatsu

Gegründet 2023 von Marius Semm und Jakob Tresch in Zürich, adressiert Niatsu die Lebensmittelindustrie. Ihre Software berechnet den Product Carbon Footprint (PCF) automatisiert und kostengünstig, was gerade für den Mittelstand entscheidend ist.

4. Future Food

Was wir morgen essen (und trinken).

VANOZZA

Eines der etabliertesten Start-ups der Runde. Gegründet 2019 von Nico Hansen in Hamburg, hat sich Vanozza mit fermentierten Käsealternativen auf Cashew-Basis einen Namen gemacht und arbeitet nun an der „zweiten Generation“ ihrer Produkte.

food42morrow/JUMA

Die Frankfurter Gründer Raoul und Max Kammann sowie Carlos Lopez Granado gründeten die GmbH bereits 2020 und brachten 2022 ihre Marke JUMA (Tee-Eistees auf Guayusa-Basis) auf den Markt. Sie bedienen den Trend zu „Functional Food“.

Fazit

Die AgriFood-Start-ups des Abschlussjahrgangs des Growth Alliance Accelerators 2025 haben die Phase der reinen Ideen-Findung bereits eindrucksvoll gemeistert. Jetzt geht es um Skalierung, industrielle Anwendung und messbaren Impact. Programme wie die Growth Alliance sind dabei der Katalysator, der wissenschaftliche Exzellenz mit dem nötigen Geschäftssinn verbindet.

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.

Wenn Dr. Martin Baumgärtl erklären will, wie er die chemische Industrie revolutionieren möchte, wählt er ein Bild, das jeder versteht: „Im Grunde ist es wie ein Wasserkocher in der heimischen Küche – nur im industriellen Maßstab.“ Baumgärtl ist CTO von SYPOX, und was er beschreibt, könnte einer der wichtigsten Hebel für die Dekarbonisierung einer der schmutzigsten Branchen der Welt sein.

Die chemische Industrie ist süchtig nach Energie. Um Basischemikalien wie Methanol oder Ammoniak herzustellen, wird sogenanntes Synthesegas benötigt – eine Mischung aus Wasserstoff und Kohlenmonoxid. Die Herstellung geschieht in gewaltigen Hochtemperaturprozessen. Bisher wird die dafür nötige Hitze fast ausschließlich durch das Verbrennen von Erdgas oder Öl erzeugt. Die Folge: Gigantische CO₂-Emissionen.

Strom statt Flamme

Genau hier setzt SYPOX an. Das 2021 in Freising gegründete Unternehmen ersetzt die offenen Gasflammen durch elektrischen Strom. In ihren Reaktoren, die von außen wie gewöhnliche Druckbehälter aussehen, stecken hochkomplexe elektrische Heizelemente, die direkt hinter den Katalysatoren platziert sind.

Der Effekt ist enorm: „In konventionellen Verfahren entfallen rund 40 Prozent der Emissionen allein auf die Wärmeerzeugung aus fossilen Energieträgern“, rechnet Baumgärtl vor. Durch die Elektrifizierung des Reaktors fallen diese Emissionen weg – vorausgesetzt, der Strom kommt aus erneuerbaren Quellen. Zudem lässt sich der Prozess laut den Gründern präziser und sicherer steuern.

Der Anti-Trend im Silicon Valley

Doch nicht nur technologisch, auch ökonomisch schwimmt SYPOX gegen den Strom. In der Tech-Szene ist es üblich, dass Start-ups jahrelang Verluste schreiben und sich von einer Venture-Capital-Runde zur nächsten hangeln, getrieben von Investoren, die schnelles Wachstum fordern.

Die bayerischen Gründer wählten einen konservativeren, fast schon mittelständischen Ansatz. „Es entsprach nicht unserem Stil, Geld einzuwerben – wir haben vielmehr von Anfang an versucht, auf Basis unserer Technologie ein tragfähiges Geschäft aufzubauen“, erklärt CEO Dr. Gianluca Pauletto. Man wolle bodenständig bleiben und sich aus Umsätzen finanzieren, statt sich in Abhängigkeiten zu begeben.

Vom Container im Altmühltal zum Großkunden

Die Wurzeln des Unternehmens liegen an der Technischen Universität München (TUM). Die Idee brachte Pauletto aus seiner Zeit in Montréal mit, an der TUM fand er in Prof. Johannes Lercher und dem damaligen Doktoranden Martin Baumgärtl die wissenschaftlichen Mitstreiter.

Der Weg zum marktreifen Produkt war – typisch für „Deep Tech“ – langwierig. „Vier Jahre Forschung und zahlreiche Versuchsreihen waren notwendig“, erinnert sich Lercher. Während andere Software im Co-Working-Space programmierten, baute das SYPOX-Team eine Pilotanlage in einem einfachen Stahlcontainer auf dem Gelände einer Biogasanlage im ländlichen Dollnstein (Altmühltal).

Diese Beharrlichkeit zahlt sich nun aus. Das Start-up hat, unterstützt durch den Spezialchemie-Konzern Clariant, seinen ersten Großkunden an Land gezogen. Ab 2026 soll eine erste industrielle Anlage in Betrieb gehen, die täglich 150 Tonnen Synthesegas produziert. „Das ist nicht nur ein Meilenstein für uns, sondern auch ein starkes Signal an die gesamte chemische Industrie“, so Baumgärtl.

Für das Team, das inzwischen in Langenbach bei Freising sitzt und weiterhin Labore auf dem Forschungscampus Garching betreibt, ist das der Beweis: Die Elektrifizierung der Chemie ist keine Zukunftsmusik mehr, sie beginnt jetzt.