Aktuelle Events

Sportive Geschäftsideen: Videoübertragung von Amateurspielen

Amateurfußball im Rampenlicht

Nicht nur in der Bundesliga, auch in den unteren Klassen wird fleißig gekickt. Und mit den Amateurvereinen wollen immer mehr Start-ups gute Geschäfte machen. Das Essener Start-up Soccerwatch.tv hat ein vollautomatisches Kamerasystem und einen Online-Streamingdienst für die Liveübertragung von Fußballspielen entwickelt. Mithilfe dieser Geschäftsidee brauchen die Fans kein Spiel ihrer Amateurteams mehr zu verpassen.

Die Spiele werden jeweils vom Flutlichtmast aus mit einem 180-Grad-Blickwinkel erfasst. Zuschauer können ihr Team per Live-Stream oder on demand verfolgen. Auch Highlight-Clips werden bereitgestellt. Im YouTube-Kanal von Soccerwatch.tv kann man sich schon einige Demobeispiele ansehen.

Der große Vorteil der Geschäftsidee für die Amateurvereine besteht darin, dass Soccerwatch.tv die Installation, Inbetriebnahme und Wartung übernimmt. Da am Stadion keine baulichen Veränderungen vorgenommen werden, muss auch kein Bauantrag gestellt werden. Einmal installiert, streamt Soccerwatch.tv alle Spiele, das Kamerasystem schaltet sich bei Spielbeginn automatisch ein und nach dem Abpfiff auch wieder aus.

Da während der Übertragung Werbung von regionalen und überregionalen Partnern gezeigt wird, kann der Verein, der einen Teil der Einnahmen erhält, damit eine zusätzliche Einnahmequelle generieren. Und letztlich können die Trainer dank eines speziell entwickelten Trainer-Tools die Spiele nachträglich professionell analysieren.

Sie möchten selbst ein Unternehmen gründen oder sich nebenberuflich selbständig machen? Nutzen Sie jetzt Gründerberater.de. Dort erhalten Sie kostenlos u.a.:

- Rechtsformen-Analyser zur Überprüfung Ihrer Entscheidung

- Step-by-Step Anleitung für Ihre Gründung

- Fördermittel-Sofort-Check passend zu Ihrem Vorhaben

Diese Artikel könnten Sie auch interessieren:

Amba: Der Schlüssel zum Digital Detox

Drei Stunden und 19 Minuten – so lange hängen junge Erwachsene täglich auf Social Media, oft völlig unbewusst. Das Kölner Start-up Amba will diesen Scroll-Automatismus nun mit einem simplen haptischen Trick durchbrechen: Ein NFC-Schlüsselanhänger erzwingt eine physische Hürde. Doch kann das Konzept im Alltag wirklich bestehen?

Das 2025 von Yves Maurice Clever und Bastian Fischer gegründete Kölner Start-up Amba positioniert sich mutig im umkämpften Digital-Wellbeing-Markt. Statt auf strenge App-Verbote zu setzen, wollen die beiden 27-Jährigen das unbewusste Dauer-Scrollen auf Social Media mit einem physischen Schlüsselanhänger stoppen. Angesichts einer durchschnittlichen Social-Media-Nutzungsdauer von drei Stunden und 19 Minuten bei jungen Erwachsenen – wovon viel Zeit für rein gewohnheitsmäßiges Scrollen draufgeht – zielt Amba darauf ab, dieses Muster durch eine haptische Hürde zu durchbrechen.

Yves, der in Neuss Marketing studierte, beschäftigt sich schon lange mit digitaler Achtsamkeit, während Bastian als Informatiker das technische Know-how aus der Softwareentwicklung mitbringt. Angetrieben aus dem eigenen Frust über gängige Software-Lösungen, die sich mit wenigen Klicks umgehen ließen, begannen sie im Sommer vergangenen Jahres mit der Produktentwicklung, bevor im Oktober 2025 die offizielle Gründung in Köln folgte.

Haptik schlägt Habit

Doch wie verhindert man, dass der Griff zum NFC-Chip nicht bald zur nächsten unbewussten Gewohnheit wird? „Unbewusstes Scrollen funktioniert so gut, weil alles in derselben Bewegung passiert: Man nimmt das Handy in die Hand und ist sofort in der App“, analysiert Mitgründer Bastian. Ein physisches Element unterbreche genau diesen Automatismus.

Der entscheidende Vorteil gegenüber klassischer Software liege im Timing, so Bastian weiter: „Bildschirmzeit-Limits erscheinen meist erst im Scroll-Moment, wenn viele schon im Autopilot sind und sie reflexartig wegklicken. Bei Amba fällt die Entscheidung vorher.“ Nach dem haptischen Entsperren legen die Nutzer*innen fest, wie viel Zeit sie in der App verbringen möchten. Bastian betont: „Dieser kleine mentale Rahmen macht Social Media wieder zu einer bewussten Entscheidung statt zu einer Gewohnheit.“ Erste Tests scheinen den Gründern recht zu geben: Eigenen Angaben zufolge sei die Social-Media-Nutzung der Tester auf durchschnittlich 49 Minuten pro Tag gesunken.

Das Hardware-Paradoxon und die Konkurrenz

Der Ansatz der „Intentional Friction“ ist clever, doch der Markt verzeiht keine Fehler. Mit dem niederländischen Start-up Unpluq existiert bereits ein etablierter Konkurrent mit einem fast identischen NFC-Konzept. Yves sieht den Unterschied seines Produkts vor allem in der Systematik. „Viele bestehende Lösungen [...] funktionieren nach dem Prinzip: Man hält den Tag ans Smartphone, um Apps zu sperren, und deaktiviert die Sperre später wieder. Wir haben die Logik umgedreht“, kontert Yves. Bei Amba seien die Apps standardmäßig gesperrt und würden erst durch den Schlüssel freigeschaltet.

Zudem wolle man sich über eine extrem niedrige Einstiegshürde abheben: „Deshalb kostet der physische Tag bei uns nur einen symbolischen Euro und Nutzer können Amba zwei Wochen lang testen“, erklärt Yves den aggressiven Markteinstieg.

Der Kampf gegen die Abo-Müdigkeit

Dennoch muss sich Amba langfristig beweisen, insbesondere da laut einer ExpressVPN-Umfrage 38 Prozent der Konsument*innen explizit unter „Abo-Müdigkeit“ leiden. Ob die Nutzerschaft dauerhaft bereit ist, knapp 20 Euro im Jahr für einen softwarebasierten Verzicht zu zahlen, bleibt abzuwarten.

Bastian räumt offen ein: „Mit den physischen Tags verdienen wir tatsächlich kein Geld, sie decken lediglich die Produktionskosten.“ Er ist jedoch überzeugt, dass die Abo-Investition für die Nutzer*innen unverzichtbar bleibt, da das Suchtpotenzial der Apps nicht verschwinde. „Social-Media-Plattformen sind bewusst so gestaltet, dass sie möglichst lange Aufmerksamkeit binden. Viele Nutzer berichten uns, dass sie nach kurzer Zeit wieder in alte Muster zurückfallen, sobald sie die Unterstützung entfernen“, warnt Bastian. Das Ziel sei daher keine einmalige „Detox“-Kur, sondern ein Rahmen, um die Nutzung „langfristig kontrollierter zu gestalten“.

Technischer Flaschenhals zum Start

Erschwerend kommt aktuell ein stark restriktives System hinzu: Durch die Begrenzung auf das Betriebssystem iOS 18 bleiben der gesamte Android-Markt sowie Besitzer*innen älterer Apple-Geräte vorerst kategorisch ausgeschlossen. „Die aktuelle Einschränkung auf neuere iOS-Versionen hat vor allem technische Gründe“, verteidigt Yves diesen harten Schnitt. Einige NFC-Funktionen liefen auf älteren Systemen schlichtweg noch nicht stabil genug. Eine Android-Version sei geplant, befinde sich aber noch nicht in der Entwicklung.

Und was passiert, wenn man den rettenden Chip zu Hause vergisst und komplett blockiert ist? Yves beschwichtigt: Für solche Fälle gebe es eine Notfallfunktion in der App, die eine temporäre Entsperrung erlaube. Er verspricht: „Amba soll eine bewusste Hürde schaffen, aber keine Situation, in der Nutzer komplett von ihrem Smartphone abgeschnitten sind.“

Letztlich wandert das Kölner Start-up auf dem schmalen Grat zwischen Achtsamkeit und Deinstallation. Der Erfolg steht und fällt mit dem Hardware-Paradoxon: Nur wenn die Community den Schlüsselanhänger langfristig als befreiendes Werkzeug und nicht als frustrierende Barriere wahrnimmt, wird sich das subventionierte Abo-Modell gegen die Platzhirsche rentieren.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

MedTech-Start-up RAYDIAX holt 7,5 Mio. Euro für neuartiges CT-System

RAYDIAX sichert sich 7,5 Mio. Euro, um mit einem speziell für minimal-invasive Eingriffe entwickelten Computertomographen die Krebsbehandlung zu verbessern. Doch der Weg vom universitären Forschungslabor in die globalen Operationssäle ist im hochregulierten Gesundheitsmarkt lang. Ein Blick auf ein DeepTech-Geschäftsmodell, das sich nun in der klinischen Praxis beweisen muss.

Die erfolgreiche Series-A1-Finanzierungsrunde über 7,5 Millionen Euro für RAYDIAX markiert einen wichtigen Meilenstein von der universitären Forschung in den Gesundheitsmarkt. Das 2022 gegründete Unternehmen mit Hauptsitz im Magdeburger Wissenschaftshafen ist eine Ausgründung des Forschungscampus STIMULATE und der Otto-von-Guericke-Universität Magdeburg. Unter der Führung eines fünfköpfigen Gründerteams – bestehend aus CEO Dr. Thomas Hoffmann, Dr. Tim Pfeiffer, Dr. André Mewes, Benjamin Fritsch und Robert Frysch – konnte das Start-up nach einer erfolgreichen Seed-Phase nun erhebliche Mittel für den Eintritt in die klinische Phase sichern.

Das frische Kapital setzt sich aus 5 Millionen Euro Venture Capital von bestehenden Business Angels, dem Bestandsinvestor bmp Ventures mit den IBG Fonds sowie dem neu eingestiegenen GETEC Family Office um Dr. Karl Gerhold zusammen. Ergänzt wird diese Summe durch 2,5 Millionen Euro Fördermittel aus dem hochkompetitiven EIC Accelerator-Programm der Europäischen Kommission, das gezielt disruptive Deep-Tech-Innovationen mit hohem Skalierungspotenzial unterstützt.

TACT: Computertomographie für den OP neu gedacht

Im Zentrum dieser ambitionierten Wachstumspläne steht der Therapieassistenz-Computertomograph „TACT“, den RAYDIAX dediziert für minimal-invasive Krebstherapien entwickelt. Anders als herkömmliche CTs optimiert das Unternehmen sein System sowohl im Hardware- als auch im Softwarebereich speziell für den interventionellen Einsatz bei der Therapieplanung, -durchführung und -kontrolle. Wie Steffen Schmidt, CFO der GETEC-Gruppe, hervorhebt, ermöglicht die innovative Technologie eine fokussierte Live-Bildgebung, welche die Strahlenbelastung für Patient*innen und Operateur*innen senkt und die Operationszeit verringert.

Zudem bietet das System durch eine größere Geräteöffnung völlig neue Operationsmethoden im CT, wie beispielsweise den Einsatz von Robotik. Der Markt für solche Lösungen wächst, da minimal-invasive Eingriffe angesichts einer alternden Bevölkerung und steigender Krebsinzidenzen massiv an Bedeutung gewinnen. Sie ermöglichen in vielen Fällen eine schonendere Behandlung im Vergleich zu offenen chirurgischen Eingriffen, verkürzen potenziell Operations- sowie Liegezeiten, verringern Komplikationen und können so zusätzliche Behandlungskapazitäten schaffen, um die Krankenhausstrukturen zu entlasten.

Harter Wettbewerb und regulatorische Hürden

Trotz der vielversprechenden Technologie steht das Geschäftsmodell in der Praxis vor erheblichen Herausforderungen. Der globale Markt für medizinische Bildgebung ist hart umkämpft, und der Vertrieb an Kliniken ist durch extrem lange, hochkomplexe B2B-Entscheidungszyklen geprägt. RAYDIAX tritt diesem Wettbewerb entgegen, indem es anstrebt, eine funktional dringend benötigte, neue Gerätekategorie in der interventionellen Onkologie zu etablieren, um so eine Lücke im OP-Betrieb zu füllen.

Der Beweisdruck auf dem jungen Unternehmen ist dennoch enorm: Das neu eingeworbene Kapital wird nun für First-in-Human-Studien eingesetzt, um die frühe klinische Evidenz am Patienten zu generieren. Diese Phase legt die Grundlage für die regulatorische Zulassung und kommerzielle Skalierung. Parallel dazu erfordert die Weiterentwicklung zur Serienreife einen konsequenten Ausbau in den Bereichen Vertrieb, Produktion und Qualitätsmanagement, um die ersten kommerziellen Installationen systematisch vorzubereiten.

Lehrstück für europäisches DeepTech

Dieser Fall zeigt eindrucksvoll die Realität und die hohen Anforderungen europäischen DeepTech-Unternehmertums. Der Abschluss dieser Finanzierungsrunde belegt deutlich, wie essenziell die intelligente Kombination aus wissenschaftlicher Grundlagenforschung, klassischem Risikokapital und strategischen europäischen Fördergeldern ist. Nur so lässt sich die extrem kapitalintensive Entwicklungsphase von Hardware in der Medizintechnik erfolgreich überstehen. Wenn es dem Gründerteam nun gelingt, die klinische Wirksamkeit in der Praxis zu belegen und die regulatorischen Hürden zu meistern, hat dieses Spin-off das Potenzial, die Anwendung minimal-invasiver Krebstherapien erheblich auszuweiten.

Die Müsli-Macher und die Kälte: Das neue Millionen-Projekt von Kraiss & Mahler

Dass sie Märkte revolutionieren können, haben die Freda-Gründer bereits bewiesen – nun steht die Tiefkühlkette auf dem Prüfstand. Mit einem mutigen Modul-Konzept fordern Philipp Kraiss und Christian Mahler die Industrie-Riesen im Supermarktregal heraus.

In der Start-up-Welt ist der Begriff Seriengründer*in oft ein zweischneidiges Schwert: Das Vertrauen der Investor*innen ist hoch, doch die Fallhöhe nach einem Erfolg wie mymuesli ebenso. Philipp Kraiss und Christian Mahler haben sich mit ihrem 2023 gegründeten Food-Start-up Freda bewusst gegen ein „Me-too-Produkt“ und für eine operative Wette auf die Zukunft der Tiefkühlkette entschieden. Mit einem mutigen Modul-Konzept fordern sie die etablierten Industrie-Riesen im Supermarktregal heraus. Die Prämisse: Der Markt für Tiefkühlkost (TK) wächst – auf über 22,6 Milliarden Euro im Jahr 2024 –, ist aber durch extremen Preisdruck und eine veraltete Produktlogik geprägt. Wir haben uns das Geschäftsmodell näher angesehen und die Gründer dazu befragt.

Pizza, Pasta, Gelato … und jetzt Blocks?

Die Pizza „Salami Sensation“ war für Freda der Türöffner. Mit dem Sieg bei Stiftung Warentest (2024) bewies das Team, dass es Qualität „kann“ und schuf einen starken USP. Strategisch ist Pizza jedoch kein leichtes Feld: Der Wettbewerb ist anspruchsvoll, die Regalplätze im Einzelhandel sind besetzt und die Differenzierung erfolgt meist über den Preis. Mit einer Innovation wie „Frozen Blocks“ erweitert Freda nun das Spielfeld und eröffnet eine neue Kategorie von Tiefkühlkost.

Es handelt sich dabei nicht mehr um ein fertiges Gericht, sondern um eine Systemkomponente. Das Konzept orientiert sich am gastronomischen „Mise en Place“: Vorbereitete, schockgefrostete Komponenten wie Beef Ragù oder Chili sin Carne fungieren als Basismodule für die heimische Küche. Strategisch gesehen erhöht dies die Wertdichte pro Kubikzentimeter im TK-Fach und verringert die Komplexität in der eigenen Produktion im Vergleich zu mehrkomponentigen Fertigmenüs.

Auf die Frage, ob der strategische Wechsel von der Pizza zu den „Frozen Blocks“ eine Flucht aus dem Commodity-Preiskampf der Pizza-Truhe hin zu einer proprietären Nische sei, widerspricht Philipp Kraiss. Vielmehr handele es sich um einen konsequenten Ausbau des Sortiments, denn Freda solle künftig den gesamten Alltag der Kund*innen abbilden – vom Frühstück bis zum Abendbrot. Das sei eben mehr als nur Pizza. „Unser Anspruch ist aber nicht nur Bekanntes besser zu machen – wie bei unserer Pizza, sondern auch neue Wege zu gehen“, stellt der Gründer klar. Die flexiblen Module seien auf diesem Weg der nächste logische Schritt. Er verspricht dabei maximale Vielfalt aus dem Gefrierfach, „denn jeder Block lässt sich vielfältig kombinieren.“

Die Retail-Herausforderung: Kaufland als Stresstest

Mit einer Basis von über 30.000 D2C-Kund*innen hat das Unternehmen bereits bewiesen, dass die Nachfrage nach seinen Produkten besteht. Um dieses Potenzial voll auszuschöpfen und die Margen zu stärken, wurde im August 2025 der Launch in 780 Kaufland-Märkten umgesetzt – ein strategischer Meilenstein, der die Reichweite massiv erhöht und über das Volumen des stationären Einzelhandels den Weg zu nachhaltigem, profitablem Wachstum ebnet – ohne aufwendigen Versand mit Isolierung und Trockeneis.

Hier zählt nun die Shelf Velocity (Abverkaufsgeschwindigkeit). Ein modulares System erfordert von der Kundschaft jedoch ein Umdenken: Man kauft kein fertiges Abendessen, sondern eine Zutat. Freda muss hier beweisen, dass der Mehrwert der Zeitersparnis am Point of Sale verstanden wird, bevor die harten Auslistungsmechanismen des Handels greifen.

Doch wie überzeugt man eine*n Einkäufer*in davon, dass ein modulares System mehr Flächenproduktivität bringt als die zehnte Sorte Standard-Lasagne? Christian Mahler kontert auf diese Retail-Frage mit einem anschaulichen Branchen-Vergleich: „Wir sind eben nicht die zehnte Lasagne. Eine klassische TK-Lasagne belegt viel Regalfläche, bedient genau einen Anlass und konkurriert mit neun anderen Lasagnen um denselben Kunden.“ Durch das kompakte Format und eine maximale SKU-Dichte der Blocks könne der Händler auf derselben Regalfläche mehrere Sorten listen und spreche damit dutzende Zubereitungsarten von der Bowl bis zum Curry an. Mahler zeigt sich selbstbewusst: „Wir eröffnen eine neue Kategorie statt in einer bestehenden zu kämpfen.“

Operative Exzellenz vs. bayerisches Handwerk

Ein weiterer Spagat wartet in der Produktion: Freda wirbt offensiv mit „Made in Bavaria“ und handwerklicher Herstellung. In der Start-up-Praxis beißt sich Handwerk jedoch oft mit Skalierung. Wer bundesweit fast 900 Supermärkte bedient, muss industrielle Prozesse beherrschen. Die Gefahr dabei ist offensichtlich: Wenn die Qualität durch die Masse sinkt, verliert Freda seinen wichtigsten USP. Gleichzeitig bleibt bei der exklusiven Zielgruppe, die bereit ist, für TK-Komponenten Premium-Preise zu zahlen, in Zeiten der Inflation die Frage der Preissensibilität bestehen.

Auf drohende Kapazitätsgrenzen angesprochen, räumt Philipp Kraiss ein, dass die Passauer Manufaktur zwar das Herzstück bleibe. „Aber wir waren von Anfang an ehrlich zu uns selbst: Eine Manufaktur skaliert nicht linear“, gibt der Seriengründer zu bedenken. Mit wachsendem Geschäft müsse man die Produktion auf breitere Schultern stellen und mit Partnern zusammenarbeiten. Sein Kernversprechen an die Kund*innen lautet dabei jedoch: „Wir lagern nicht die Rezeptur aus, sondern die Kapazität.“

Marktpsychologie: Convenience ohne Reue

Psychologisch besetzt Freda damit eine überaus geschickte Lücke. Die „Frozen Blocks“ nehmen der Käuferschaft zwar die Entscheidung für die aufwendige Kernkomponente ab, lassen das Gefühl des Selbstkochens durch das frische Ergänzen von Beilagen jedoch vollkommen intakt. Dies eliminiert die oft vorhandene „Convenience-Scham“ gesundheitsbewusster Zielgruppen und könnte die Lösung für die stagnierenden Marktanteile klassischer Fertiggerichte bei jüngeren Konsument*innen sein.

Fazit für die Start-up-Praxis

Freda ist ein Lehrstück für den Übergang von einer digitalen D2C-Brand zum Player im Massenmarkt. Die Gründer nutzen ihre Erfahrung, um eine etablierte Kategorie neu zu denken. Ob die Rechnung aufgeht, wird sich an der Regal-Rotation zeigen. Wenn die Kund*innen den Aufpreis für die „bayerische Handarbeit“ und das modulare System dauerhaft akzeptieren, könnte Freda die Blaupause für die nächste Generation von Food-Marken liefern.

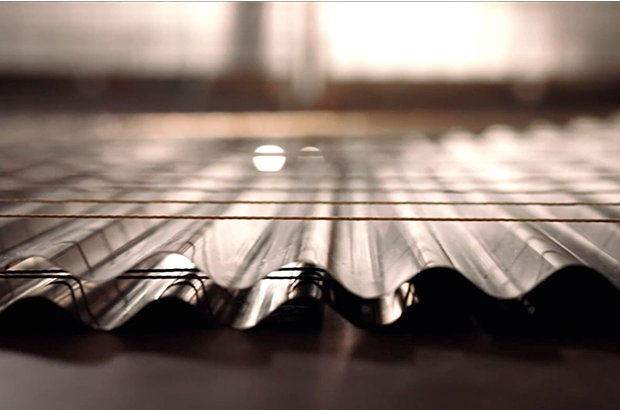

Das Thermoskannen-Prinzip: Kann V21 die Logistik-Welt revolutionieren?

Das Team des Hamburger DeepTech-Start-up V21 – Roland Wiedenroth, Dr.-Ing. Tom Marr, Kristina Rübenkamp, Dr. Jens Struckmeier und Nicolas Röhrs – entwickelt extrem dünne und robuste Dämmplatten aus Edelstahl, die nach dem Prinzip einer flachen Thermoskanne funktionieren und Container oder Gebäude hocheffizient sowie platzsparend isolieren. Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit 125.000 Euro.

Ob Impfstoffe, Südfrüchte oder modulare Klassenzimmer: Container sind das Rückgrat der globalen Wirtschaft. Doch sie sind energetische Sorgenkinder. Um Innentemperaturen stabil zu halten, fressen Kühlaggregate (Reefer) enorme Mengen Strom, während herkömmliche Dämmstoffe wie Styropor oder Mineralwolle wertvollen Laderaum rauben. Hier setzt die 2019 gegründete V21 GmbH (kurz V21) an. Die Vision: Eine Dämmung, die so dünn wie effizient ist.

An der Spitze des Unternehmens steht ein Team, das tief in der Industrie verwurzelt ist. CEO Roland Wiedenroth, ein erfahrener Logistik- und Industrieexperte, leitet die Strategie und den Markteintritt. Er weiß um die Schmerzpunkte der Branche und treibt die Vision voran, die „Thermoskanne flach zu machen“. Mitbegründer und CIO Dr. Jens Struckmeier bringt die nötige wissenschaftliche Tiefe ein: Der promovierte Physiker und Mathematiker gilt als Clean-Tech-Pionier und hat bereits mit dem Start-up Cloud&Heat bewiesen, wie man physikalische Prinzipien in nachhaltige Geschäftsmodelle übersetzt. Über die Kerninnovation sagt er: „Wir haben die Thermoskanne flach gemacht und bringen sie an die Wand. Grundlage dafür war ein Patent, in dessen Kern der Verbund vieler kleiner Thermoskannen stand.“

DeepTech gegen das Vakuum-Dilemma

Dass V21 als klassisches DeepTech-Unternehmen gilt, liegt an der Überwindung einer massiven ingenieurtechnischen Hürde. Vakuum ist physikalisch der beste Isolator, doch bisherige Vakuumisolationspaneele (VIP) waren empfindlich wie rohe Eier. Das Produkt „ZeroCoreVac“ von V21 schlägt hier einen technologisch radikalen Weg ein, der sich fundamental von etablierten Lösungen unterscheidet. Während Marktführer wie va-Q-tec oder Panasonic primär auf Paneele setzen, die aus einem silikabasierten Kern bestehen, der von einer metallisierten Kunststoffverbundfolie umschlossen wird, verzichtet V21 komplett auf diese fragile Außenhaut.

Anstelle der Folie nutzt das Start-up eine robuste Kapselung aus hauchdünnem Edelstahl. Verantwortlich für diese Materialinnovation ist CTO Dr.-Ing. Tom Marr. Als Werkstoffingenieur mit einem Fokus auf Automatisierung und Fertigung treibt er die Serienreife der Technologie voran. Wo herkömmliche VIPs einen Stützkern aus Pulver benötigen, ermöglicht die von Marr und Struckmeier entwickelte, patentierte Struktur ein System, das ohne klassische Füllmaterialien auskommt. Diese Konstruktion macht das Paneel nicht nur mechanisch extrem belastbar, sondern löst auch das Thema Brandschutz, da keinerlei brennbare Kunststoffe verbaut sind. Ein weiterer Vorteil ist die vollständige Kreislauffähigkeit: Das Paneel kann am Ende seiner Lebenszeit – die V21 auf über 50 Jahre schätzt – als wertvoller Edelstahlschrott recycelt werden.

Das Geschäftsmodell: Skalierung durch Lizenzen?

V21 verfolgt eine zweistufige Strategie: Zunächst adressiert man B2B-Nischen wie den Modulbau, bevor der globale Container-Markt angegriffen wird. Dabei setzt das Start-up auf ein Lizenzmodell. Unterstützt wird dieser Skalierungskurs durch den Mitbegründer und Chairman Nicolas Röhrs, einen erfahrenen Technologieunternehmer, der auf den Aufbau strategischer Industriepartnerschaften spezialisiert ist. Finanziell wird das Wachstum von CFO Kristina Rübenkamp gesteuert, die ihre Expertise in Planung und Investorenkommunikation einbringt, um die nötige Transparenz für großangelegte Rollouts zu schaffen.

Ein solcher Lizenzansatz verspricht zwar schnelle Skalierung ohne massiven Kapitalaufwand für den eigenen Maschinenpark, doch Vakuumtechnik verzeiht keine Fehler. Die Herausforderung wird sein, sicherzustellen, dass Lizenzpartner weltweit die nötige Präzision beim Verschweißen der Edelstahlhüllen einhalten. Zudem bleibt der Margendruck in der Logistikbranche brutal. Die Rechnung geht für Reedereien nur auf, wenn die versprochene Energieeinsparung von bis zu 50 % und der Raumgewinn (ca. 10 bis 20 % mehr Nutzlast) die Initialkosten zügig amortisieren.

Die Belastungsprobe: Zwischen Theorie und Hochsee-Realität

Trotz technologischer Brillanz muss sich V21 in der Praxis beweisen. In der maritimen Logistik herrschen gnadenlose Bedingungen: Halten die präzisen Schweißnähte den permanenten Vibrationen und der aggressiven Salzwasserbelastung auf einem Containerschiff über Jahrzehnte stand? Ohne diese belastbaren Langzeitnachweise unter Realbedingungen bleibt das Risiko eines schleichenden Vakuumverlusts ein Argument, das gerade konservative Reedereien zögern lässt.

Parallel dazu steht die ökonomische Hürde im Raum. Solange CO₂-Zertifikate noch verhältnismäßig günstig bepreist sind, bleibt die High-End-Dämmung ein erklärungsbedürftiges Investment mit hohem „Green Premium“. Damit die Technologie den Sprung aus der Nische schafft, müssen die Produktionskosten durch konsequente Automatisierung massiv sinken. Erst wenn der ökologische Vorsprung auch betriebswirtschaftlich zum sofortigen Selbstläufer wird, dürfte das Hamburger Start-up die Branche nachhaltig umkrempeln.

Fazit

V21 hat ein technologisch exzellentes Produkt, das ein reales Problem der Dekarbonisierung löst. Die eigentliche unternehmerische Leistung wird nun darin bestehen, die Skalierung so effizient zu gestalten, dass der Preis für den Massenmarkt akzeptabel wird. Wenn die Hamburger den Beweis der Langlebigkeit unter Realbedingungen antreten, könnten sie zum neuen Standard für temperaturgeführte Logistik aufsteigen. Bis dahin bleibt es ein mutiger Ritt gegen etablierte Chemie-Riesen und die billige Dominanz von Styropor.

Agentic AI als Erfolgsgrundlage für Start-ups

KI befeuert den aktuellen Gründungsboom, doch für eine erfolgreiche Skalierung braucht es mehr. Warum Agentic AI auf Basis einer soliden Datenarchitektur zum entscheidenden Erfolgsfaktor für Start-ups wird.

Das Jahr startete für Start-ups mit einer Rekordmeldung: In Deutschland wurden im vergangenen Jahr fast ein Drittel mehr Gründungen verzeichnet. In absoluten Zahlen wurden 2025 insgesamt 3.568 neue Firmen geschaffen – ein neuer Höchststand, wie der Start-up-Verband im Januar verkündete. Dies ist auch der künstlichen Intelligenz (KI) zu verdanken, wie sich beim genauen Hinschauen herausstellt. 853 dieser neuen Unternehmen kommen aus dem Bereich Software. Doch nicht nur sie verwenden KI; bei einer Umfrage gab ein Drittel aller Gründer und Gründerinnen an, dass sie mit KI arbeiten. Dementsprechend sehen die Sprecher des Verbands in der Technologie auch die treibende Kraft hinter dem Start-up-Rekord.

Wirft man einen Blick über den Tellerrand hinaus, so lässt sich feststellen, dass die Start-up-Szene in Europa insgesamt floriert. Der „State of European Tech 2025“-Report im Auftrag von Atomico und anderen schätzt, dass im letzten Jahr Investitionen in Höhe von 44 Milliarden US-Dollar (umgerechnet ca. 38 Mrd. EUR) in diesen Sektor geflossen sind. Geldgeber erwarten inzwischen, dass Start-ups mit KI und Deep Tech arbeiten, so der Report. Demnach flossen auch 36 Prozent der europäischen Start-up-Investitionen in genau diese beiden Felder.

Das Gründungsumfeld könnte also kaum besser sein. Doch ein Rekord an Start-ups und steigende Investitionssummen bedeuten nicht zwangsläufig auch eine einfache Skalierung der Geschäftsmodelle. Viele – zu viele – Start-ups scheitern nach erfolgreichen ersten Jahren an der Weiterentwicklung ihres Geschäfts. Neben einer Reihe üblicher Herausforderungen stehen vor allem Bürokratie, Fragen zur Datenhoheit und ein Betrieb über Landesgrenzen und Wirtschaftszonen hinweg im Vordergrund. Start-ups müssen nachweisen, dass ihre Nutzung von KI auf soliden, regulierten Datenfundamenten basiert und den Compliance-Vorgaben entspricht.

Hier kommt Agentic AI ins Spiel. Die Einbettung von KI-Agenten in den Kern der Betriebsabläufe ist die Antwort auf viele dieser Herausforderungen und wird für das Wachstum im Jahr 2026 von entscheidender Bedeutung sein.

Solide Datenbasis vor KI-Einsatz

Start-ups, die dies erreichen wollen, sollten sich darauf konzentrieren, ihre KI-Nutzung auf einer soliden Datenbasis aufzubauen, deren Fundament eine einheitliche Datenarchitektur ist. Sie tun sich deutlich leichter damit, die dafür nötigen Architekturentscheidungen zu treffen, als etablierte Unternehmen mit entsprechender Legacy-IT. Gründer und Gründerinnen sollten daher von Beginn an darüber nachdenken, wie sie eine starke Datenarchitektur aufsetzen, Silos abbauen und KI als Herzstück ihrer Prozesse einbetten.

Diese Grundlage hilft bei der Einführung von KI-Agenten, damit deren Output auch die Erwartungen erfüllt: Geschäftsprozesse effizienter zu strukturieren und zu optimieren sowie die Entscheidungsfindung zu beschleunigen. Start-ups, die dies umsetzen, werden sich gegen ihre Konkurrenten durchsetzen und letztlich erfolgreich sein.

KI-Agenten als Innovationsbeschleuniger

Indem Start-ups KI-Agenten von Beginn an in den Kern ihrer Geschäftsabläufe integrieren, skalieren sie schneller als mit dem Einsatz von nur einem reinen Large Language Model (LLM). Der Grund dafür liegt in der Standardisierung der Daten, die für KI-Agenten notwendig ist. Auf dieser Grundlage können die Agenten ihre einzigartigen, autonomen Fähigkeiten ausspielen, da sie mit unternehmenseigenen Daten trainiert werden. Vor allem bei Start-ups können Potenziale schnell gehoben werden: Wenn Agenten für bestimmte Aufgaben entwickelt werden, können sie diese auch lösen – egal wie komplex und fachspezifisch sie sein mögen. Stimmt die Datenbasis, lassen sich auch mehrere Agenten miteinander verknüpfen, um sogar noch komplexere Herausforderungen zu bewältigen.

Ein Beispiel dafür ist die mögliche Kooperation zwischen einem Kundensupport-Agenten und einem Prognose-Agenten. Wenn ein Kunde einen Support-Fall auslöst, kann der andere Agent sogleich die Kosten berechnen, was die Kundenzufriedenheit durch eine schnellere Reaktion steigern kann. Für die Skalierung von Start-ups ist ein enges Zusammenspiel der Abteilungen wichtig, um die Geschäftsbeziehungen zu zufriedenen Kunden weiter ausbauen zu können. Der Einsatz von KI-Agenten kann, gepaart mit dem menschlichen Element, begrenzte personelle Ressourcen ausgleichen und eine bessere Serviceleistung ermöglichen, was für ein schnelles Wachstum unabdingbar ist.

Doch nicht nur der Kundenkontakt lässt sich automatisieren, sondern auch eine ganze Reihe von Routinevorgängen in der internen Verwaltung der Firmen selbst. Dies ermöglicht nicht nur dem Management, sondern auch den Investoren, schnell einen fundierten Überblick über Liquidität, Umsatz, Einnahmen und Gewinn zu erhalten. Die Erkenntnisse in Echtzeit führen zu schnellen und datenbasierten Entscheidungen, was für junge Unternehmen Gold wert ist und es ihnen ermöglicht, flexibel zu bleiben.

Die Datenbasis muss stimmen

Für Start-ups sind Probleme beim Datenzugriff ein kritisches Risiko für den Geschäftserfolg. Eine einheitliche, moderne Datenarchitektur ermöglicht die Demokratisierung des Datenzugriffs und löst Datensilos auf. Der Vorteil liegt auf der Hand: Schneller Datenzugriff schafft Transparenz gegenüber Kunden und Aufsichtsbehörden. Darüber hinaus erhöht dies auch das Vertrauen der Mitarbeitenden und schafft ein Gefühl des Zusammenhalts.

Governance ist auch bei der Verwendung von KI-Agenten von entscheidender Bedeutung. Der Druck zur Einhaltung von Vorschriften sollte daher als Vorteil betrachtet werden.

Der Dreiklang aus Datenherkunft, Versionierung und automatisierter Auswertung der Ergebnisse hilft jungen Unternehmen dabei, Governance auf einem soliden Fundament aufzubauen. Die Teams erhalten direkte Transparenz darüber, wie sich die KI-Agenten verhalten, auf welchen Daten sie basieren und wie sie ihre Ergebnisse im Laufe der Zeit verändern. Laufende Bewertungen tragen dazu bei, dass KI-Agenten präziser werden, um genau jene hochwertigen Ergebnisse zu liefern, die Start-ups für die Skalierung ihrer Geschäftsmodelle benötigen. Dies ist besonders wichtig, wenn proprietäre KI-Modelle entwickelt und von der Testphase in die Produktion überführt werden, wobei gesetzliche Vorschriften wie die DSGVO oder der EU AI Act zwingend einzuhalten sind.

Parloa, ein deutsches Start-up-Unternehmen mit einer Bewertung von drei Milliarden US-Dollar, ist ein hervorragendes Beispiel dafür, wie dieser Ansatz in der Praxis aussehen kann: Das Unternehmen hat KI-Agenten zum Kern seines Kundenservice gemacht und gleichzeitig eine einheitliche, kontrollierte Datenbasis aufgebaut, die vollständig mit der DSGVO und dem EU AI Act konform ist. Seine Plattform folgt den Prinzipien des „Privacy by Design“, sodass sensible Kundendaten ohne Kontrollverlust verwendet werden können. Durch die Verwaltung des gesamten Lebenszyklus von KI-Agenten macht Parloa Governance zu etwas Greifbarem und gibt den Teams Klarheit darüber, welche Daten verwendet wurden, wie sich die Agenten verhalten haben und wie sich die Ergebnisse im Laufe der Zeit entwickelt haben. Diese Kombination aus moderner Architektur und starker Governance ermöglicht es den Kunden von Parloa, Zugang zu hochwertigen Daten zu erhalten und die Transparenz für Regulierungsbehörden sowie Endnutzer zu erhöhen – und dennoch KI-gesteuerte Kundeninteraktionen in Umgebungen zu skalieren, in denen Fehler oder Missbrauch inakzeptabel sind.

Fazit

KI-Agenten bieten europäischen Start-ups eine einmalige Gelegenheit, schnell zu wachsen und gleichzeitig Investoren anzuziehen, die bekanntermaßen ihr Geld bevorzugt in Unternehmen investieren, die Wert auf Datenverwaltung, Genauigkeit, Qualität und die Schaffung von echtem Mehrwert durch Technologie legen. Es ist jedoch ein Fehler, sich ohne sorgfältige Überlegungen auf die Einführung von Agenten zu stürzen. Start-ups, die KI-Agenten einsetzen, ohne zuvor eine einheitliche Datenbasis aufzubauen und eine solide Verwaltung sowie Bewertung sicherzustellen, riskieren, mehr Komplexität als Mehrwert zu schaffen. Letztlich werden jene Gründer und Gründerinnen erfolgreich sein, die ihre Geschäftsmodelle branchen- und länderübergreifend skalieren können – hierbei spielt der Einsatz von KI-Agenten bereits jetzt eine entscheidende Rolle.

Der Autor Nico Gaviola ist VP Digital Natives & Emerging Enterprise bei Databricks EMEA.

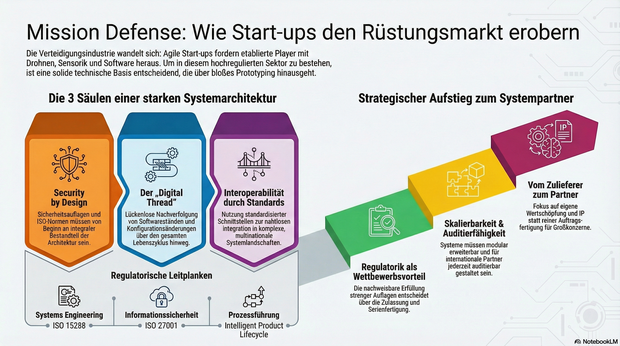

Mission Defense: Wie Start-ups im rüstungstechnischen Markt Fuß fassen

Immer mehr Start-ups drängen mit agilen Innovationen in die hochregulierte Verteidigungs- und Luftfahrtindustrie. Daher gut zu wissen: Wie junge Unternehmen durch die richtige Systemarchitektur die strengen Auflagen meistern und vom Zulieferer zum echten Systempartner aufsteigen.

Die Luft- und Raumfahrt sowie die Verteidigungsindustrie zählen zu den am stärksten regulierten und technologisch anspruchsvollsten Märkten der Welt. Lange galt: Wer hier mitspielen will, braucht jahrzehntelange Erfahrung, Milliardenbudgets und stabile Regierungsbeziehungen. Doch genau dieses Bild verschiebt sich.

Neue Player treten auf den Plan: Start-ups entwickeln Trägersysteme, Drohnenplattformen, Kommunikationslösungen oder Sensorik, und tun das in einer Geschwindigkeit, die vielen etablierten Anbietern Kopfzerbrechen bereitet. Die zentrale Frage lautet deshalb: Wie können junge Unternehmen in einer hochregulierten Branche nicht nur überleben, sondern mitgestalten?

Agilität als Superkraft – aber Prototypen reichen nicht

Ob neue unbemannte Plattformen, Software-Defined Defense Systeme oder taktische Kommunikation – überall gilt: Was heute entwickelt wird, muss morgen schon einsatzbereit sein. Der Bedarf an schneller Innovation ist nicht theoretisch, sondern operativ. Start-ups sind in der Lage, auf diesen Druck zu reagieren, mit kurzen Entscheidungswegen, agilen Teams und digitaler DNA.

Allerdings reichen gute Ideen und schnelles Prototyping nicht aus. Wer Systeme für den operativen Einsatz liefern will, muss Anforderungen erfüllen, die weit über funktionierende Technik hinausgehen: Cybersicherheit, regulatorische Nachvollziehbarkeit, Zertifizierungsfähigkeit und Interoperabilität mit internationalen Partnern.

Das Fundament: Die Systemarchitektur entscheidet

Von Anfang an auf die richtigen technischen Grundlagen zu setzen, ist entscheidend. Das betrifft vor allem drei Bereiche: Skalierbarkeit, Nachvollziehbarkeit und Interoperabilität. Systeme müssen so gebaut sein, dass sie modular erweitert, in komplexe Systemlandschaften integriert und nach internationalen Standards auditiert werden können.

Ein durchgängiger digitaler Entwicklungs- und Betriebsfaden, ein sogenannter Digital Thread oder auch Intelligent Product Lifecycle, ermöglicht es, Produktdaten, Softwarestände und Konfigurationsänderungen über den gesamten Lebenszyklus hinweg zu verfolgen. Für die Zulassung softwaredefinierter, sicherheitskritischer Systeme ist das ebenso essenziell wie für die spätere Wartung, Upgrades oder die Einbindung in multinationale Operationen.

Security by Design: Sicherheit lässt sich nicht nachrüsten

Verteidigungsnahe Produkte unterliegen Exportkontrollen, Sicherheitsauflagen und branchenspezifischen Normen, darunter etwa ISO 15288 für Systems Engineering, ISO 27001 für Informationssicherheit oder die europäischen Anforderungen für Luftfahrt und Raumfahrt. Diese Vorgaben lassen sich nicht einfach „nachrüsten“. Sie müssen von Beginn an ein integraler Bestandteil der Systemarchitektur und Prozessführung sein.

Gerade in sicherheitskritischen Bereichen ist die Fähigkeit, regulatorische Anforderungen nachweislich zu erfüllen, ein entscheidender Wettbewerbsvorteil. Sie entscheidet darüber, ob ein Produkt zugelassen, in Serie gefertigt und in multinationale Programme integriert werden kann.

Interoperabilität als Schlüssel zum Teamplay

Ein weiterer kritischer Faktor ist die Fähigkeit zur Kooperation. In den meisten großen Programmen arbeiten unterschiedliche Unternehmen, oft aus verschiedenen Ländern, mit unterschiedlichen Systemen zusammen. Wer hier bestehen will, muss in der Lage sein, mit standardisierten Schnittstellen, interoperablen Plattformarchitekturen und harmonisierten Datenmodellen zu arbeiten. Interoperabilität ist dafür die technische Grundlage. Ohne sie lassen sich Systeme weder integrieren noch gemeinsam weiterentwickeln.

Vom Zulieferer zum echten Systempartner

Start-ups, die sich diesen Anforderungen stellen, können mehr sein als Zulieferer. Sie haben das Potenzial, Systempartner zu werden: mit eigener Wertschöpfung, eigenem IP und eigenem Einfluss auf die technologische Entwicklung. Der Weg dorthin ist anspruchsvoll, aber offen. Er erfordert keine hundertjährige Firmengeschichte, sondern eine klare Architekturstrategie, ein tiefes Verständnis für regulatorische Anforderungen und den Willen, komplexe Systeme systematisch zu entwickeln.

Der Verteidigungs- und Luftfahrtsektor steht an einem Wendepunkt. Wer heute die richtigen Grundlagen legt, kann morgen zu denjenigen gehören, die nicht nur mitlaufen, sondern die Spielregeln neu definieren.

Der Autor Jens Stephan, Director Aerospace & Defence bei PTC, bringt über 20 Jahre Erfahrung im Bereich komplexer Software-/SaaS-Lösungen und IT-Infrastruktur mit.

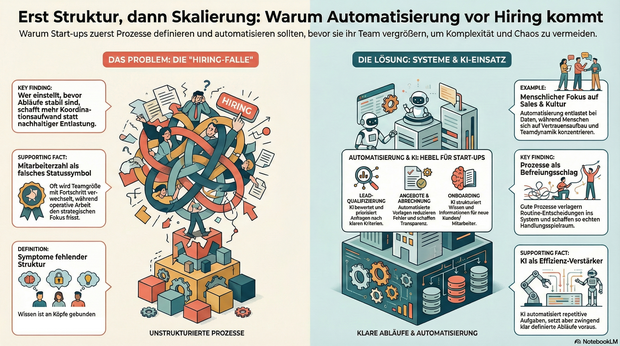

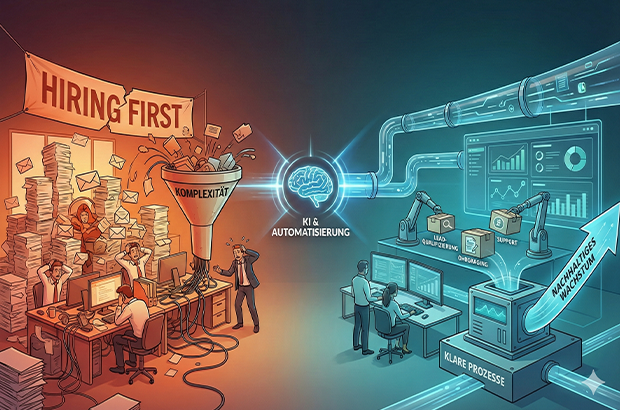

Automatisierung vor Hiring, sonst wird Komplexität skaliert

Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung. Tipps und To-Dos.

Wachstum wird in Start-ups oft sehr eindimensional gedacht: mehr Nachfrage gleich mehr Menschen. Sobald Anfragen steigen, Deals reinkommen oder neue Märkte locken, folgt fast automatisch der nächste Hiring-Plan. Dabei wird häufig die Ursache mit Wirkung verwechselt. Nicht fehlende Kapazität bremst junge Unternehmen, sondern fehlende Struktur. Prozesse entstehen improvisiert, Verantwortung wird situativ verteilt, operative Arbeit frisst Fokus. Und irgendwann fühlt sich Wachstum nicht mehr nach Fortschritt, sondern nach Dauerstress an.

Gerade in der Start-up-Branche wird Wachstum zudem stark über sichtbare Kennzahlen bewertet. In Gesprächen mit Investor*innen lautet eine der ersten Fragen häufig nicht Gewinn oder EBITA, sondern: Wie viele Mitarbeitende seid ihr und wie viel Umsatz macht ihr? Die Anzahl der Mitarbeitenden wird damit fast zu einem Statussymbol. Hiring wird nicht nur zur operativen, sondern auch zur psychologischen Größe und ein Zeichen von Fortschritt. Diese Logik verstärkt den Reflex, früh zu skalieren, auch wenn die strukturellen Voraussetzungen dafür noch fehlen. Wer Wachstum vor allem mit Hiring beantwortet, verzichtet damit oft unbewusst auf einen der wichtigsten Hebel moderner Organisationen: Klarheit durch Prozesse und Automatisierung.

Warum Hiring allein selten skaliert

Mehr Menschen im Team wirken wie eine schnelle Lösung. In der Praxis zeigt sich jedoch häufig ein ähnliches Muster: Neue Kolleg*innen übernehmen Aufgaben, die eigentlich nur deshalb existieren, weil Abläufe unklar oder manuell gewachsen sind. Statt nachhaltiger Entlastung entsteht zusätzliche Koordination.

Typische Symptome sind:

- operative Aufgaben blockieren strategische Arbeit,

- Wissen verteilt sich auf einzelne Köpfe,

- Entscheidungen hängen an Personen statt an klaren Abläufen,

- Abstimmungen nehmen zu, ohne dass die Wertschöpfung im gleichen Maß wächst.

Das Problem ist nicht Hiring an sich, sondern die Reihenfolge. In vielen Fällen wird Hiring eingesetzt, um kurzfristig Druck rauszunehmen, obwohl das eigentliche Nadelöhr fehlende Klarheit ist. Wer einstellt, bevor Abläufe stabil sind, schafft zwar mehr Kapazität, skaliert aber auch Komplexität.

Prozesse als Voraussetzung für wirksames Wachstum

Prozesse werden in Start-ups häufig mit Bürokratie verwechselt. Tatsächlich sind sie das Gegenteil: Sie reduzieren Reibung. Gute Prozesse verlagern Entscheidungen vom Einzelfall ins System. Sie beantworten zwei zentrale Fragen zuverlässig: Was passiert als Nächstes – und wer ist verantwortlich?

Gerade kleine Teams profitieren davon besonders. Prozesse schaffen keine Starrheit, sondern Handlungsspielraum. Sie machen Arbeit vorhersehbar, Übergaben sauber und Entscheidungen reproduzierbar. Erst auf dieser Grundlage kann ein wachsendes Team seine Stärke wirklich entfalten.

Automatisierung im KI-Zeitalter: neue Möglichkeiten, neue Verantwortung

Mit KI hat sich die Eintrittshürde für Automatisierung massiv gesenkt. Viele Aufgaben, die früher manuell oder individuell erledigt wurden, lassen sich heute zuverlässig unterstützen oder teilweise abnehmen, vorausgesetzt, der zugrunde liegende Ablauf ist klar definiert. Entscheidend ist dabei nicht die Tool-Auswahl, sondern die Frage, was automatisiert wird. Automatisierung verstärkt bestehende Strukturen, gute wie schlechte. Wer unklare Abläufe automatisiert, skaliert keine Effizienz, sondern Chaos. Gleichzeitig gibt es zentrale Bereiche, die sich bewusst nicht oder nur sehr begrenzt automatisieren lassen und auch nicht sollten. Recruiting ist einer davon. Der Aufbau eines funktionierenden Teams lebt von persönlicher Einschätzung, Teamdynamik und kulturellem Fit. Ähnliches gilt für Sales: Vertrauensaufbau, Verhandlung und das persönliche Gespräch bleiben essenziell. Automatisierung ist hier unterstützend, aber kein Ersatz. Besonders geeignet sind Tätigkeiten, die häufig auftreten, wenig kreativen Spielraum haben und auf wiederkehrenden Informationen basieren.

Bereiche, die sich heute besonders gut automatisieren lassen

Lead- und Anfragequalifizierung

Unstrukturierte Anfragen lassen sich mithilfe von KI zusammenfassen, bewerten und priorisieren. Statt jede Anfrage manuell zu prüfen, entstehen klare Kriterien, die relevante von irrelevanten Leads trennen und Follow-ups vorbereiten.

Angebots- und Abrechnungsprozesse

Angebote, Verträge und Rechnungen folgen in vielen Startups ähnlichen Mustern. Automatisierte Vorlagen, angebundene Datenquellen und definierte Freigaben sparen Zeit, reduzieren Fehler und schaffen Transparenz.

Onboarding von Kund:innen und Mitarbeitenden

Onboarding ist kein Einzelfall, sondern ein wiederkehrender Prozess. Checklisten, automatische Aufgaben und zentrale Informationspunkte sorgen für Verlässlichkeit. KI kann helfen, Informationen zu strukturieren und kontextbezogen bereitzustellen.

Support und interne Anfragen

Ein Großteil von Fragen wiederholt sich. Wissensbasen in Kombination mit KI-gestützter Suche und Antwortvorschlägen entlasten Teams und machen sichtbar, wo Standards fehlen.

Projektmanagement und Übergaben

Klare Projekt-Templates, automatisierte Status-Updates und definierte Trigger reduzieren Abstimmungsaufwand. KI kann dabei unterstützen, Risiken früh zu erkennen oder nächste Schritte vorzuschlagen.

Was Start-ups daraus lernen können

Automatisierung ersetzt keine Entscheidungen, sie macht sie skalierbar. Voraussetzung dafür ist Klarheit über Abläufe, Verantwortlichkeiten und Prioritäten. Wer versucht, Chaos zu automatisieren, verstärkt es lediglich.

Hilfreiche Leitfragen sind:

- Welche Aufgaben wiederholen sich regelmäßig?

- Wo entstehen manuelle Engpässe?

- Welche Tätigkeiten binden qualifizierte Menschen ohne echten Mehrwert?

Die Antworten darauf liefern meist schnell die größten Hebel.

Der KI-Wendepunkt: Systeme und Personal

Nachhaltiges Wachstum entsteht dort, wo Start-ups Systeme aufbauen und diese bewusst mit ihrem Team verzahnen. Nicht, weil Systeme Menschen ersetzen, sondern weil sie Menschen von struktureller Überforderung entlasten. Automatisierung schafft dabei nicht nur Effizienz, sondern Entscheidungsqualität: Wenn Daten sauber fließen, Übergaben klar sind und Standards greifen, werden Prioritäten weniger Bauchgefühl und stärker reproduzierbar.

Der gezielte Einsatz von KI-Tools verschiebt diesen Wendepunkt zusätzlich. Sie können Routinearbeiten abfangen, Informationen aus unstrukturierten Inputs verdichten und Entscheidungen vorbereiten – etwa durch Lead-Vorqualifizierung, Support-Clustering oder zusammengefasste Status-Updates. KI wirkt dabei nicht als Ersatz für Klarheit, sondern als Verstärker funktionierender Prozesse.

Hiring bleibt auch weiterhin essentiell. Seine Wirkung entfaltet es jedoch erst dann vollständig, wenn Prozesse klar sind und Automatisierung sowie KI gezielt unterstützen. So entsteht Wachstum, das nicht nur schneller, sondern auch gesünder ist.

Der Autor Markus Hetzenegger ist Gründer & CEO von NYBA Media. 2018 gegründet, zählt NYBA heute zu den führenden Marketing-Unternehmen im Live-Entertainment.

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

Wie viel verdienen Twitch Streamer wirklich? Zahlen und Verdienstmöglichkeiten im Blick

Wer als passionierter Spieler noch nicht an eine Gaming Karriere gedacht hat, sollte dies jetzt nachholen: Schließlich ergeben sich aus dieser von Esport-Turnieren bis hin zum Streaming einige Verdienstmöglichkeiten. Creatoren verdienen mit der Echtzeit-Übertragung ihres Spielerlebnisses Geld. Was sich einfach anhört, kann für so manchen Spieler auch zum komplexen Unterfangen werden. Wie hoch der Streamer Verdienst in diesen Fällen ausfällt und welche Einnahmemöglichkeiten es für Twitch Streamer noch gibt, erfahren Sie hier.

Die Top 10 Twitch Streamer im Jahr 2025

„Es gewinnt nicht der beste Spieler, sondern der beste Entertainer.“ |

Auf Plattformen wie Twitch gilt: Die Community beeinflusst stark, wie viel Geld Streamer verdienen können. Wer eine starke Zuschauergemeinde aufbauen kann, freut sich in der Regel über ein höheres Einkommen – dabei spielt vor allem die Interaktion der Viewer eine zentrale Rolle.

Aktuell weisen diese top 10 Twitch Channels die höchsten Zuschauerzahlen vor:

Streamer | Durchschnittliche Zuschauerzahl | Follower |

126.449 | 19,8 Millionen | |

52.024 | 7,9 Millionen | |

46.844 | 3,3 Millionen | |

36.903 | 2,2 Millionen | |

29.320 | 2,2 Millionen | |

71.045 | 1,5 Millionen | |

31.839 | 1,5 Millionen | |

42.837 | 1,4 Millionen | |

34.996 | 1,1 Millionen | |

30.438 | 993.817 |

Geld verdienen mit Streaming: Diese Faktoren wirken sich auf Twitch Einnahmen aus

Die Twitch-Einnahmen der verschiedenen Streamer setzen sich aus unterschiedlichen Verdienstquellen zusammen. So können die Kontoinhaber Werbung in ihren Live-Übertragungen schalten, die ihnen je nach Zuschauerzahl und Länge der Werbepause einen kleinen bis mittleren Betrag einbringen. Hierbei handelt es sich jedoch um ein eher statisches Nebeneinkommen, das die meisten Streamer auch als nebensächlich empfinden. Den größeren Teil des Twitch Einkommens machen Abonnements und Spenden der Zuschauer aus, aber auch Sponsoring und Markenpartnerschaften.

Übrigens: Twitch Auszahlungen erfolgen automatisch via PayPal oder Banküberweisung, sofern ein gewisser Mindestbetrag erreicht wurde. In diesem Zusammenhang bieten mobile casinos, ähnlich wie Streaming-Plattformen, eine bequeme Möglichkeit für Spieler, jederzeit und überall zu spielen, ohne auf traditionelle Zahlungsmethoden angewiesen zu sein. Diese Art von Plattformen hat sich zu einer beliebten Option entwickelt, da sie den Nutzern schnelle Auszahlungen und einfache Handhabung bieten.

Twitch Daten Leak 2021: Das verdienen Top-Streamer

Ende 2021 wurde die bekannte Plattform Twitch gehackt. Bei einem Datenleck kam heraus, dass die 2014 von Amazon gekaufte Plattform kaum Sicherheitsvorkehrungen geschaffen hatte – weshalb große Teile des Programmiercodes sowie Login-Daten und Zahlen zum Streamer Verdienst veröffentlicht werden konnten. Zu sehen waren vor allem die Gesamteinnahmen der Top Spieler aus den Twitch Statistiken des Zeitraumes August 2018 bis Oktober 2021 in US-Dollar:

- CriticalRole: 9,6 Millionen

- xQc: 8,5 Millionen

- summit1g: 5,8 Millionen

- Tfue: 5,3 Millionen

- Nickmercs: 5,1 Millionen

Zum Vergleich: Der deutsche Twitch Streamer Marcel Eris (alias MontanaBlack88) hat über Twitch 2,4 Millionen US-Dollar eingenommen. Der Streamer MontanaBlack88 gehört zu den bestbezahlten deutschen Spielern auf Twitch.

Damit werden die großen Unterschiede zwischen den Verdiensten der Streamer aus Deutschland und den USA deutlich. Rund vier Millionen Deutsche verfolgen Twitch-Übertragungen – und das sogar täglich. In den USA liegt die tägliche Zuschauerzahl bei stolzen 35 Millionen Nutzern, sodass amerikanische Streamer auch einen deutlich größeren Markt bedienen und die Einkommensunterschiede nicht verwunderlich sind. MontanaBlack88 ist allerdings auch auf anderen Plattformen wie YouTube zu finden, sodass sein Gesamtverdienst womöglich deutlich höher liegt.

Gut zu wissen: Twitch Partner (von Twitch ausgewählte Streamer mit qualitativem Content) können sich über höhere Einnahmen freuen – etwa einen höheren Anteil aus dem Abonnenten-Verdienst.

Im Detail: So setzt sich der Verdienst zusammen

Wie eingangs erwähnt, verdienen Twitch Streamer vor allem durch Abonnenten einen großen Teil ihres Einkommens. Das Abonnement kostet Subscribern in der ersten Stufe 4,99 Euro – wovon Streamer in der Regel 50% (2,50 Euro) behalten dürfen. Dafür erhalten Abonnenten bestimmte Vorteile wie etwa die Möglichkeit, per Chat mit dem Streamer interagieren zu können. Wer also 1.000 Abonnenten hat, kann deshalb schon mit Einnahmen von 2.500 Euro monatlich rechnen.

Einen Großteil ihrer Einnahmen generieren Gaming-Streamer aber auch mit Hilfe von Subscriber-Spenden. Diese werden in Twitch Bits genannt und von der Plattform ausgezahlt. Die Spenden rufen bei einigen Streamern emotionale Reaktionen hervor, was wiederum mehr Menschen zum Spenden anregt.

Eine weitere Möglichkeit stellt Affiliate-Marketing dar: Streamer bewerben in dem Fall für ihre Zuschauer interessante Produkte in ihren Videos. Kaufen Zuschauer die Produkte, profitieren Streamer von einer Provision – die nicht selten 30% des Kaufbetrages ausmacht.

Sponsoren und Markendeals als größte Einnahmequelle für Streamer

An Streamer mit besonders hohen Zuschauer- und Followerzahlen treten oft auch bekannte Marken heran. Sie bezahlen die Gamer dafür, ihre Produkte im Live-Stream anzupreisen – beispielsweise Gaming-Peripherie oder Energy-Drinks. Soll dies über einen längeren Zeitraum geschehen, werden solche Marken oft auch zum Sponsor des Spielers, um ihre eigene Reichweite zu erhöhen.

Kosten und Abzüge: Dem steht der Streamer Gehalt in Deutschland gegenüber

Die genannten Streamer Gehälter stellen Brutto-Summen dar – also den Verdienst vor Abzug der deutschen Einkommens-, Umsatz- und Gewerbesteuer, sowie Sozialversicherungen. Wer all diese Beträge zusammenzählt, muss oft bis zu 45% seines Brutto-Einkommens an den Fiskus abführen. Doch damit nicht genug: Die meisten Twitch-Streamer müssen auch Chat-Moderatoren bezahlen, die für eine angenehme Atmosphäre unter den Kommentierenden sorgen und Community-Richtlinien durchsetzen.

Darüber hinaus wollen sich Zuschauer nur Streams ansehen, die eine hohe Qualität aufweisen. Um leistungsstark spielen und den Verlauf optimal übertragen zu können, brauchen Streamer bestimmtes Gaming-Equipment, das selbst zwischen 2.000 und 10.000 Euro kosten kann. Auch eine stabile Internetverbindung und die damit verbundenen Kosten sind zu bedenken.

Alternative Plattformen zur Diversifizierung

Um noch mehr Einkommen zu generieren, können passionierte Spieler ihre Streams allerdings zusätzlich auf anderen Plattformen veröffentlichen und monetarisieren – beispielsweise durch Werbung und Affiliate-Marketing. Zur Diversifizierung kommen Plattformen wie YouTube und Kick in Frage, die teilweise sogar bessere Konditionen bieten. Denn: Bei Kick werden Streamer zu 95% an den Einnahmen durch Abonnements beteiligt, was im Gegensatz zu Twitch deutlich attraktiver erscheint.

Diese 10 Start-ups bauen an der Zukunft der AgriFood-Branche

Die deutsche Start-up-Landschaft verzeichnete 2025 ein Rekordhoch bei Neugründungen. Doch gerade im AgriFood-Sektor ist der Weg vom Prototyp zum Marktführer steinig. Kapitalintensive Hardware und strenge Regulatorik bremsen viele aus. Der Growth Alliance Accelerator zeigt, wie Gründer*innen diese Hürden überspringen – und präsentiert zehn Akteure, die auf der Erfolgsspur sind.

Es ist ein Paradoxon: Die Nachfrage nach nachhaltigen Lebensmitteln und effizienter Landwirtschaft ist so hoch wie nie, doch für Gründer*innen und junge Unternehmen in der AgriFood-Branche bleibt der Markteintritt ein Hürdenlauf. Während Software-Start-ups oft mit geringem Kapital skalieren, kämpfen Food- und AgTech-Pioniere mit der „Hardware-Falle“. Sie benötigen teure Produktionsanlagen, Labore und müssen langwierige Zulassungsverfahren (z.B. Novel-Food-Verordnung) durchlaufen.

Dennoch ist die Branche im Aufwind: Laut dem Deutschen Startup Monitor und aktuellen Zahlen des Startup-Verbands stiegen die Gründungszahlen 2025 um beachtliche 29 Prozent. Das Kapital ist da, doch es fließt selektiv. Investor*innen suchen heute keine reinen Ideen mehr, sondern validierte Geschäftsmodelle mit technologischem Tiefgang (DeepTech). Genau hier setzte das Finale des Growth Alliance Accelerator 2025 am 28. Januar 2026 in Frankfurt/Main an.

Brückenschlag zwischen Acker und Finanzwelt

Initiiert vom TechQuartier und der Landwirtschaftlichen Rentenbank, hat sich der Accelerator als Schmiede für die „Scale-up“-Phase etabliert. Vier Monate lang wurden zehn Start-ups, die bereits eine Nutzer*innenbasis vorweisen konnten, fit für die nächste Finanzierungsrunde gemacht.

Das Programm adressierte genau die Pain Points der Branche: Verhandlungstaktik, Rechtsfragen und vor allem den Zugang zu Kapital. Ein Highlight war das Investor Dinner im November 2025, bei dem die Gründer*innen direkten Zugang zu Risikokapitalgeber*innen erhielten – in der aktuellen Marktphase ein entscheidender Wettbewerbsvorteil.

Die „Class of 2025“: Wer die Transformation treibt

Die zehn Absolvent*innen decken die gesamte Wertschöpfungskette ab – vom Boden über das Labor bis zum Supermarktregal. Hier ein Blick auf die Köpfe hinter den Innovationen:

1. High-Tech auf dem Acker: Robotik und Daten

Die Digitalisierung der Landwirtschaft (Smart Farming) ist der stärkste Hebel für mehr Effizienz.

Paltech GmbH

Die Brüder Felix und Florian Schiegg gründeten 2022 Paltech zusammen mit Jorge Decombe im Allgäu. Ihr autonomer Roboter für chemiefreie Unkrautbekämpfung im Grünland ist eine Antwort auf strengere Pestizid-Gesetze und Personalmangel.

Bacchus Software GmbH

Das 2023 gegründete Start-up bacchus Weinbau-Software um das Trio Maximilian Dick, Julian Herrlich und Philipp Bletzer digitalisiert den Weinbau. Ihre Software ersetzt das händische Fahrtenbuch und koordiniert die komplette Weinbergsarbeit.

Agrario Energy

Die Energiewende macht Landwirt*innen zu Energiewirt*innen. Seit 2023 bieten die Gründer Alexander von Breitenbach und Chris Weber mit Agrario Energy eine unabhängige Vergleichsplattform, die Flächeneigentümer mit Betreiber*innen von Erneuerbare-Energien-Anlagen zusammenbringt.

2. Deep Tech & Sicherheit: Das Labor als Wächter

Lebensmittelsicherheit wird durch globale Lieferketten immer komplexer. Hier setzen wissenschaftsbasierte Ausgründungen an.

NanoStruct GmbH

NanoStruct wurde 2021 als Spin-off der Universität Würzburg gegründet. Das Team nutzt Nanotechnologie, um gefährliche Bakterien in Lebensmitteln in Minuten statt Tagen aufzuspüren.

SAFIA Technologies

Gegründet 2020 von Timm Schwaar (aus der Bundesanstalt für Materialforschung), entwickelt das Berliner Start-up SAFIA Technologies Schnelltests für Mykotoxine (Schimmelpilzgifte). Ihre Technologie ermöglicht Laborqualität im Schnelltest-Format.

Landman.Bio

Das noch junge Unternehmen (Gründung 2023) Landman.Bio nutzt Bakteriophagen (Viren, die Bakterien fressen) als natürliche Waffe gegen Pflanzenkrankheiten – eine dringend benötigte Alternative zu Antibiotika und klassischen Pestiziden in der Nutzpflanzenzucht.

3. Sustainability & Climate: Kohlenstoff als Währung

CO2-Tracking ist kein Marketing-Gimmick mehr, sondern ökonomische Notwendigkeit.

CinSOIL

Das 2024 in Berlin gegründete CinSOIL-Team um Dr. Giorgi Shuradze, Dr. Antonella Succurro und Dr. Tavseef Shah kommt aus der Wissenschaft. Ihr KI-Tool nutzt Satellitendaten, um Bodenkohlenstoff zu erfassen. Das ermöglicht Agrarunternehmen, Dekarbonisierung nicht nur zu behaupten, sondern zu beweisen.

Niatsu

Gegründet 2023 von Marius Semm und Jakob Tresch in Zürich, adressiert Niatsu die Lebensmittelindustrie. Ihre Software berechnet den Product Carbon Footprint (PCF) automatisiert und kostengünstig, was gerade für den Mittelstand entscheidend ist.

4. Future Food

Was wir morgen essen (und trinken).

VANOZZA

Eines der etabliertesten Start-ups der Runde. Gegründet 2019 von Nico Hansen in Hamburg, hat sich Vanozza mit fermentierten Käsealternativen auf Cashew-Basis einen Namen gemacht und arbeitet nun an der „zweiten Generation“ ihrer Produkte.

food42morrow/JUMA

Die Frankfurter Gründer Raoul und Max Kammann sowie Carlos Lopez Granado gründeten die GmbH bereits 2020 und brachten 2022 ihre Marke JUMA (Tee-Eistees auf Guayusa-Basis) auf den Markt. Sie bedienen den Trend zu „Functional Food“.

Fazit

Die AgriFood-Start-ups des Abschlussjahrgangs des Growth Alliance Accelerators 2025 haben die Phase der reinen Ideen-Findung bereits eindrucksvoll gemeistert. Jetzt geht es um Skalierung, industrielle Anwendung und messbaren Impact. Programme wie die Growth Alliance sind dabei der Katalysator, der wissenschaftliche Exzellenz mit dem nötigen Geschäftssinn verbindet.

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.

Wenn Dr. Martin Baumgärtl erklären will, wie er die chemische Industrie revolutionieren möchte, wählt er ein Bild, das jeder versteht: „Im Grunde ist es wie ein Wasserkocher in der heimischen Küche – nur im industriellen Maßstab.“ Baumgärtl ist CTO von SYPOX, und was er beschreibt, könnte einer der wichtigsten Hebel für die Dekarbonisierung einer der schmutzigsten Branchen der Welt sein.

Die chemische Industrie ist süchtig nach Energie. Um Basischemikalien wie Methanol oder Ammoniak herzustellen, wird sogenanntes Synthesegas benötigt – eine Mischung aus Wasserstoff und Kohlenmonoxid. Die Herstellung geschieht in gewaltigen Hochtemperaturprozessen. Bisher wird die dafür nötige Hitze fast ausschließlich durch das Verbrennen von Erdgas oder Öl erzeugt. Die Folge: Gigantische CO₂-Emissionen.

Strom statt Flamme

Genau hier setzt SYPOX an. Das 2021 in Freising gegründete Unternehmen ersetzt die offenen Gasflammen durch elektrischen Strom. In ihren Reaktoren, die von außen wie gewöhnliche Druckbehälter aussehen, stecken hochkomplexe elektrische Heizelemente, die direkt hinter den Katalysatoren platziert sind.

Der Effekt ist enorm: „In konventionellen Verfahren entfallen rund 40 Prozent der Emissionen allein auf die Wärmeerzeugung aus fossilen Energieträgern“, rechnet Baumgärtl vor. Durch die Elektrifizierung des Reaktors fallen diese Emissionen weg – vorausgesetzt, der Strom kommt aus erneuerbaren Quellen. Zudem lässt sich der Prozess laut den Gründern präziser und sicherer steuern.

Der Anti-Trend im Silicon Valley

Doch nicht nur technologisch, auch ökonomisch schwimmt SYPOX gegen den Strom. In der Tech-Szene ist es üblich, dass Start-ups jahrelang Verluste schreiben und sich von einer Venture-Capital-Runde zur nächsten hangeln, getrieben von Investoren, die schnelles Wachstum fordern.

Die bayerischen Gründer wählten einen konservativeren, fast schon mittelständischen Ansatz. „Es entsprach nicht unserem Stil, Geld einzuwerben – wir haben vielmehr von Anfang an versucht, auf Basis unserer Technologie ein tragfähiges Geschäft aufzubauen“, erklärt CEO Dr. Gianluca Pauletto. Man wolle bodenständig bleiben und sich aus Umsätzen finanzieren, statt sich in Abhängigkeiten zu begeben.

Vom Container im Altmühltal zum Großkunden

Die Wurzeln des Unternehmens liegen an der Technischen Universität München (TUM). Die Idee brachte Pauletto aus seiner Zeit in Montréal mit, an der TUM fand er in Prof. Johannes Lercher und dem damaligen Doktoranden Martin Baumgärtl die wissenschaftlichen Mitstreiter.

Der Weg zum marktreifen Produkt war – typisch für „Deep Tech“ – langwierig. „Vier Jahre Forschung und zahlreiche Versuchsreihen waren notwendig“, erinnert sich Lercher. Während andere Software im Co-Working-Space programmierten, baute das SYPOX-Team eine Pilotanlage in einem einfachen Stahlcontainer auf dem Gelände einer Biogasanlage im ländlichen Dollnstein (Altmühltal).

Diese Beharrlichkeit zahlt sich nun aus. Das Start-up hat, unterstützt durch den Spezialchemie-Konzern Clariant, seinen ersten Großkunden an Land gezogen. Ab 2026 soll eine erste industrielle Anlage in Betrieb gehen, die täglich 150 Tonnen Synthesegas produziert. „Das ist nicht nur ein Meilenstein für uns, sondern auch ein starkes Signal an die gesamte chemische Industrie“, so Baumgärtl.

Für das Team, das inzwischen in Langenbach bei Freising sitzt und weiterhin Labore auf dem Forschungscampus Garching betreibt, ist das der Beweis: Die Elektrifizierung der Chemie ist keine Zukunftsmusik mehr, sie beginnt jetzt.