Aktuelle Events

Datenqualität für KI verbessern – so geht‘s

Damit Unternehmen durch künstliche Intelligenz (KI) korrekte und verwertbare Erkenntnisse erhalten, benötigen sie riesige Datenmengen in hoher Qualität innerhalb kurzer Zeit, und zwar unabhängig vom Format. Keine leichte Aufgabe, denn oftmals sind die Daten über verschiedene Standorte, Abteilungen, Datenbanken und Applikationen in der Firma verteilt und liegen in unterschiedlichen Formaten vor. Nur eine solide Strategie stellt sicher, dass die Daten stets verfügbar, präzise und konsistent sind. Die gute Nachricht: Datenmanagement kann dabei helfen, die KI ordentlich aufzusetzen und in der Praxis zu unterstützen.

Laut McKinsey fließen ganze 70 Prozent der Bemühungen bei der Entwicklung KI-basierter Lösungen in die Datenbereinigung und -abstimmung. Wie können Unternehmen also langfristig erfolgreich sein? Die folgenden sechs Tipps helfen dabei, die Datenqualität sicherzustellen.

1. Standards für die Datenqualität festlegen

Standards bilden die Grundlage für qualitativ hochwertige Daten. Dazu zählen Genauigkeit, Vollständigkeit, Konsistenz, Aktualität und Relevanz. Um diese präzise festzulegen, müssen alle relevanten Personen und Interessensgruppen im Unternehmen zusammenarbeiten und ihre unterschiedlichen Perspektiven, Bedürfnisse und Fachkenntnisse einbringen.

Datenqualitätsstandards bilden die Grundlage für eine effektive Data Governance, da sie klare Erwartungen und Richtlinien für die Erfassung, Speicherung, Nutzung und Sicherheit von Daten definieren. Standards vereinfachen zudem die Datenmigration und -integration, ohne Probleme durch Inkompatibilität oder Inkonsistenz zu verursachen. Außerdem stellen sie sicher, dass die Daten, die für KI-Modelle und Analysealgorithmen zum Einsatz kommen, verlässlich und aussagekräftig sind. Nur so entstehen genaue und gewinnbringende Ergebnisse.

Klare Datenqualitätsstandards geben Experten Richtlinien für die Überprüfung von Daten vor. Dies verdeutlicht allen Teams im Unternehmen die Bedeutung der Datenqualität und zeigt ihre Auswirkungen auf.

2. Data-Governance-Praktiken regeln

Data Governance bezieht sich auf den Prozess, die Rahmenbedingungen, Richtlinien und Kontrollmechanismen, die sicherstellen, dass Daten in einer Organisation effektiv verwaltet, geschützt, verfügbar gemacht und genutzt werden können.

Die Implementierung von Data-Governance-Praktiken definiert und dokumentiert unmissverständlich datenbezogene Aufgaben und Verantwortlichkeiten im gesamten Unternehmen. Dies trägt dazu bei, dass diese Aufgaben ernst genommen und eingehalten werden. Die Beschäftigten verstehen, dass das Datenmanagement ein wichtiger Bestandteil ihrer Verantwortlichkeiten ist und eine entscheidende Rolle spielt.

Ohne diesen wichtigen Schritt besteht die Gefahr, dass eine Kultur des Misstrauens entsteht. Die Mitarbeitenden könnten etwa Zweifel an der Genauigkeit, Integrität und Verlässlichkeit der Daten haben, die sie verwenden. Das wiederum kann zu einem Mangel an Vertrauen in die Daten und Entscheidungen, die auf ihnen basieren, führen.

Im schlimmsten Fall führt ein Fehlen von Data-Governance-Praktiken zu falschen Entscheidungen, die sich negativ auf den Ruf und den Gewinn des gesamten Unternehmens auswirken.

3. Mit Data Profiling Inkonsistenzen aufdecken

Die Qualität der Daten (Vollständigkeit, Genauigkeit, Konsistenz und Aktualität) sollte regelmäßigen Prüfungen unterliegen, um Probleme frühzeitig aufzudecken. Sonst könnten Entscheidungen fallen, die auf falschen Informationen beruhen. Wenn etwa Daten in verschiedenen Teilen eines Systems inkonsistent sind, führt dies zu Widersprüchen und Verwirrung. Unterschiedliche Datensätze können beispielsweise verschiedene Werte für dasselbe Merkmal enthalten. Auch die Missachtung von Vorschriften steht im Raum, was rechtliche und finanzielle Auswirkungen nach sich ziehen kann.

Zuständig für die Qualität der Daten sind Experten für Data Profiling und Datenvalidierung. Die Datenprofilierung ist der erste Schritt der Datenaufbereitung und verschafft einen Überblick darüber, über welche Informationen das Unternehmen überhaupt verfügt. So entsteht ein Verständnis für die grundlegenden Eigenschaften, Qualität und Struktur der Daten. Dieser Schritt spielt eine wichtige Rolle, da Daten oft in verschiedenen Tools und Anwendungen verstreut sind, etwa in der Customer-Data-Plattform, im ERP- oder dem Bezahlsystem. Mithilfe von Data Profiling gelingt es, das gesamte Unternehmensdatenökosystem zu durchforsten und herauszufinden, wo zum Beispiel überall Kundendaten gespeichert sind und welche Anwendungen sie nutzen.

Dieser Prozess deckt potenzielle Fehler oder Inkonsistenzen auf wie unterschiedliche Schreibweisen von Adressen oder Kontaktdaten. Data Profiling bringt ans Tageslicht, ob wichtige Informationen fehlen. Dazu zählt zum Beispiel, dass in einem anderen System Daten über den Familienstand eines Kunden vorliegen, die bisher nicht genutzt wurden und für gezielte Marketingaktionen in Form eines Familienrabatts eingesetzt werden. Fehlende Informationen können sich auch direkt auf die Zufriedenheit der Kunden auswirken und damit einen guten Kundenservice erschweren.

4. Auf Data Observability setzen

Data Observability bezieht sich auf die Fähigkeit, Daten in einem Informationssystem kontinuierlich zu überwachen, zu verstehen und zu steuern. Das soll gewährleisten, dass sie zuverlässig, konsistent und qualitativ einwandfrei vorliegen. Unternehmen gewinnen so die notwendigen Erkenntnisse, die bei der Verwaltung ihrer Datenprozesse helfen und potenzielle Risiken im Zusammenhang mit Datenqualität, Datenschutz und Compliance proaktiv identifizieren und mindern. So bleiben die Datensätze nicht nur zuverlässig und genau, sondern lassen sich auch zeitnah abrufen.

Data Observability baut ein System auf, das proaktiv auf Probleme aufmerksam macht. Es erkennt, wo Inkonsistenzen bestehen und ermöglicht ein frühzeitiges Gegensteuern. Zudem lassen sich damit Data-Governance-Praktiken verbessern sowie Datenpipelines und Daten-Workflows optimieren, indem es Einsicht in Performance-Metriken, Datenlatenz und Ressourcennutzung gewährt.

Auch hier kann die KI unterstützen, indem sie etwa automatisch Anomalien in Datenströmen erkennt, die auf Datenqualitätsprobleme, Leistungsprobleme oder Sicherheitsrisiken hinweist. Dies ermöglicht es Firmen, Datenprobleme proaktiv zu erkennen und schnell zu beheben.

5. Gemeinsame Datennutzung und Zusammenarbeit fördern

Experten tragen wesentlich dazu bei, eine gemeinsame Datennutzung und Zusammenarbeit zu fördern, insbesondere vor dem Hintergrund der stetig wachsenden Anzahl von Datenquellen und Nutzern. Sie verfügen über ein tiefes Verständnis für Datenmanagement, -analyse und -interpretation und können beispielsweise andere Angestellte im Umgang mit Daten schulen oder als Vermittler zwischen verschiedenen Abteilungen und Teams fungieren. So lassen sich Silos abbauen und der Informationsaustausch erleichtern.

Laut IDG Research greifen die meisten IT-Systeme von Unternehmen heutzutage auf 400 verschiedene Datenquellen zurück, wobei die großen Firmen sogar mit tausend oder mehr Datenquellen arbeiten. Deshalb sollten die Unternehmen auf einen Datenmarktplatz zum Austausch zwischen Datengebenden und Datennutzenden setzen.

Hier können Data Scientists, Analysten und weitere Fachleute auf eine Bandbreite an Datensätzen aus vielen verschiedenen Quellen zugreifen. Dies fördert die abteilungsübergreifende Zusammenarbeit und unterstützt dabei, neue Erkenntnisse und Lösungen durch Datennutzung und -analyse zu entwickeln. Zudem ergeben sich daraus zusätzliche Einnahmequellen und ein höherer ROI.

6. Selfservice-Datenzugriff anbieten

Nutzer sollten die Möglichkeit haben, genau dann auf die Daten zuzugreifen, wenn sie sie benötigen, ohne auf das IT-Team angewiesen zu sein. Die Vorteile liegen auf der Hand: Die Teams arbeiten so agiler und können besser auf neue Geschäftsanforderungen reagieren. Das führt zu mehr Eigenverantwortung und stellt den Zugriff auf sichere und zuverlässige Inhalte für sämtliche Nutzergruppen sicher, unabhängig von ihrem technischen Fachwissen. Außerdem kann sich das IT-Team so besser auf geschäftskritische, strategische Aufgaben konzentrieren.

Der Selfservice-Zugriff garantiert außerdem, dass Data-Governance- und Compliance-Vorgaben eingehalten werden, da jeder die Daten auf eine einheitliche und geregelte Art und Weise nutzt. Das revolutioniert die Datennutzung, erhöht die Produktivität und steigert die Arbeitsmoral.

Fazit

Mit diesen Empfehlungen befinden sich Unternehmen auf einem guten Weg, hochwertige Daten zu erhalten und für KI gewappnet zu sein: Sie können Daten auf jede mögliche Art und Weise nutzen und analysieren, um intelligentere Entscheidungen zu treffen, ihre KI- und Analytics-Projekte erfolgreich umzusetzen und Abläufe zu optimieren.

Der Autor Jens Kambor ist Vice President of Sales für Deutschland, Österreich und der Schweiz bei Informatica. Das Unternehmen ist führend im Bereich Enterprise Cloud Data Management.

Diese Artikel könnten Sie auch interessieren:

Verkaufen ohne Shop: Zahlungen erhalten mit PayPal Open

Sie verkaufen digitale Kunst, Online-Kurse oder Handgemachtes? Dafür ist ein Shop nicht zwingend nötig. Mit Zahlungslinks und Kaufen-Buttons von PayPal erhalten Sie Ihre Zahlungen, wo die Verkäufe entstehen – schnell, sicher und unkompliziert.

Zahlungen empfangen, wo Ihre Community ist

Viele Soloselbständige nutzen Social Media, E-Mails oder Messenger nicht nur zur Kommunikation, sondern auch zur Vermarktung ihrer Produkte. Mit den passenden Tools können sie dort zusätzlich direkt Zahlungen empfangen – ganz ohne Onlineshop oder technisches Setup.

PayPal Open bietet drei flexible Möglichkeiten, Zahlungen zu erhalten:

- Zahlungslinks, die schnell geteilt werden können, etwa per E-Mail, DM, Post oder QR-Code.

- Kaufen-Buttons, die sich in eine bestehende Seite integrieren lassen, zum Beispiel in ein Link-in-Bio-Tool oder eine Landingpage.

- Tap to Pay macht Ihr Smartphone zum Zahlungsterminal (kompatibles Smartphone vorausgesetzt).

Alle Varianten funktionieren schnell, mobiloptimiert und bieten eine vertraute Nutzererfahrung. Damit wird der Ort, an dem Interesse entsteht, direkt zum Verkaufsort.

Zahlungslinks: Vom Post zur Bezahlung in Sekunden

Ein Kauf beginnt nicht im Warenkorb, sondern dort, wo Interesse entsteht: in einem Post, einer Story oder einer E-Mail. Genau hier setzen Zahlungslinks von PayPal an: Sie führen direkt von der Produktinfo zur Zahlung, ohne Umwege über externe Plattformen.

Das ist besonders hilfreich bei:

- digitalen Produkten

- E-Book-, Kurs- oder Software-Verkäufen

- (Online-)Vorbestellungen oder Trinkgeld-Modellen

Ein Zahlungslink erzeugt eine eigene Bezahlseite mit Titel, Preis, Beschreibung und Produktbild. Varianten wie Größen oder Farben sind ebenso integrierbar wie frei wählbare Preise. Versandkosten und Steuern können automatisch berechnet werden.

Der fertige Zahlunglink lässt sich flexibel teilen: per Messenger, E-Mail, Social Media oder als QR-Code auf einem Produktetikett oder Tischaufsteller. Die Zahlungsseite unterstützt gängige Zahlarten wie Kreditkarte, Wallets sowie ausgewählte regionale Methoden wie SEPA-Lastschrift, iDEAL oder Swish – je nach Land und Verfügbarkeit für die jeweiligen Käufer:innen.

Besonders praktisch: Ihre Kund:innen brauchen dafür kein eigenes PayPal-Konto. So können Zahlungen sicher und bequem online abgewickelt werden.

Für Selbständige, die regelmäßig digitale Inhalte verkaufen, ist das eine einfache Möglichkeit, Zahlungen mit PayPal zu empfangen, ohne ein klassisches Shopsystem aufsetzen zu müssen.

Kaufen-Buttons: Ihre Seite wird zur Verkaufsfläche

Wer bereits eine Website oder ein Link-in-Bio-Tool nutzt, kann PayPals Warenkorb- oder Kaufen-Buttons mit wenigen Zeilen Code integrieren. Damit verwandeln Sie eine einfache Landingpage in eine funktionale Verkaufsfläche. Sie erstellen den Button in Ihrem PayPal-Konto und erhalten automatisch den passenden HTML-Code, der nur noch kopiert und in die Website eingefügt wird. Kund:innen klicken, zahlen mit ihrer bevorzugten Methode und der Betrag wird direkt gutgeschrieben.

Sie behalten die volle Kontrolle über Ihre Gestaltung, Storytelling und Nutzerführung und profitieren gleichzeitig von einem verlässlichen Check-out, der hilft Vertrauen zu schaffen. Eine schlanke Lösung für alle, die ihr Angebot online präsentieren und Zahlungen direkt abwickeln möchten.

Mit Tap to Pay ganz einfach vor Ort verkaufen

Neben den digitalen Optionen können Sie auch vor Ort Zahlungen annehmen: direkt über Ihr Smartphone. Mit der PayPal-Funktion „Tap to Pay“ akzeptieren Sie kontaktlose Zahlungen per Karte oder Wallet ohne separates Kartenlesegerät. Alles, was Sie benötigen, ist ein kompatibles iPhone oder Android-Gerät mit NFC-Funktion (Tap to Pay funktioniert auf Geräten mit Android 8.0, NFC-Funktionen und Google Play Services. iOS ab iPhone XS und höher).

Besonders praktisch ist das beispielsweise für:

- Märkte, Pop-up-Stores

- Workshops und Live-Events

- Verkäufe im kleinen Rahmen, bei denen Flexibilität zählt

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

Diese 10 Start-ups bauen an der Zukunft der AgriFood-Branche

Die deutsche Start-up-Landschaft verzeichnete 2025 ein Rekordhoch bei Neugründungen. Doch gerade im AgriFood-Sektor ist der Weg vom Prototyp zum Marktführer steinig. Kapitalintensive Hardware und strenge Regulatorik bremsen viele aus. Der Growth Alliance Accelerator zeigt, wie Gründer*innen diese Hürden überspringen – und präsentiert zehn Akteure, die auf der Erfolgsspur sind.

Es ist ein Paradoxon: Die Nachfrage nach nachhaltigen Lebensmitteln und effizienter Landwirtschaft ist so hoch wie nie, doch für Gründer*innen und junge Unternehmen in der AgriFood-Branche bleibt der Markteintritt ein Hürdenlauf. Während Software-Start-ups oft mit geringem Kapital skalieren, kämpfen Food- und AgTech-Pioniere mit der „Hardware-Falle“. Sie benötigen teure Produktionsanlagen, Labore und müssen langwierige Zulassungsverfahren (z.B. Novel-Food-Verordnung) durchlaufen.

Dennoch ist die Branche im Aufwind: Laut dem Deutschen Startup Monitor und aktuellen Zahlen des Startup-Verbands stiegen die Gründungszahlen 2025 um beachtliche 29 Prozent. Das Kapital ist da, doch es fließt selektiv. Investor*innen suchen heute keine reinen Ideen mehr, sondern validierte Geschäftsmodelle mit technologischem Tiefgang (DeepTech). Genau hier setzte das Finale des Growth Alliance Accelerator 2025 am 28. Januar 2026 in Frankfurt/Main an.

Brückenschlag zwischen Acker und Finanzwelt

Initiiert vom TechQuartier und der Landwirtschaftlichen Rentenbank, hat sich der Accelerator als Schmiede für die „Scale-up“-Phase etabliert. Vier Monate lang wurden zehn Start-ups, die bereits eine Nutzer*innenbasis vorweisen konnten, fit für die nächste Finanzierungsrunde gemacht.

Das Programm adressierte genau die Pain Points der Branche: Verhandlungstaktik, Rechtsfragen und vor allem den Zugang zu Kapital. Ein Highlight war das Investor Dinner im November 2025, bei dem die Gründer*innen direkten Zugang zu Risikokapitalgeber*innen erhielten – in der aktuellen Marktphase ein entscheidender Wettbewerbsvorteil.

Die „Class of 2025“: Wer die Transformation treibt

Die zehn Absolvent*innen decken die gesamte Wertschöpfungskette ab – vom Boden über das Labor bis zum Supermarktregal. Hier ein Blick auf die Köpfe hinter den Innovationen:

1. High-Tech auf dem Acker: Robotik und Daten

Die Digitalisierung der Landwirtschaft (Smart Farming) ist der stärkste Hebel für mehr Effizienz.

Paltech GmbH

Die Brüder Felix und Florian Schiegg gründeten 2022 Paltech zusammen mit Jorge Decombe im Allgäu. Ihr autonomer Roboter für chemiefreie Unkrautbekämpfung im Grünland ist eine Antwort auf strengere Pestizid-Gesetze und Personalmangel.

Bacchus Software GmbH

Das 2023 gegründete Start-up bacchus Weinbau-Software um das Trio Maximilian Dick, Julian Herrlich und Philipp Bletzer digitalisiert den Weinbau. Ihre Software ersetzt das händische Fahrtenbuch und koordiniert die komplette Weinbergsarbeit.

Agrario Energy

Die Energiewende macht Landwirt*innen zu Energiewirt*innen. Seit 2023 bieten die Gründer Alexander von Breitenbach und Chris Weber mit Agrario Energy eine unabhängige Vergleichsplattform, die Flächeneigentümer mit Betreiber*innen von Erneuerbare-Energien-Anlagen zusammenbringt.

2. Deep Tech & Sicherheit: Das Labor als Wächter

Lebensmittelsicherheit wird durch globale Lieferketten immer komplexer. Hier setzen wissenschaftsbasierte Ausgründungen an.

NanoStruct GmbH

NanoStruct wurde 2021 als Spin-off der Universität Würzburg gegründet. Das Team nutzt Nanotechnologie, um gefährliche Bakterien in Lebensmitteln in Minuten statt Tagen aufzuspüren.

SAFIA Technologies

Gegründet 2020 von Timm Schwaar (aus der Bundesanstalt für Materialforschung), entwickelt das Berliner Start-up SAFIA Technologies Schnelltests für Mykotoxine (Schimmelpilzgifte). Ihre Technologie ermöglicht Laborqualität im Schnelltest-Format.

Landman.Bio

Das noch junge Unternehmen (Gründung 2023) Landman.Bio nutzt Bakteriophagen (Viren, die Bakterien fressen) als natürliche Waffe gegen Pflanzenkrankheiten – eine dringend benötigte Alternative zu Antibiotika und klassischen Pestiziden in der Nutzpflanzenzucht.

3. Sustainability & Climate: Kohlenstoff als Währung

CO2-Tracking ist kein Marketing-Gimmick mehr, sondern ökonomische Notwendigkeit.

CinSOIL

Das 2024 in Berlin gegründete CinSOIL-Team um Dr. Giorgi Shuradze, Dr. Antonella Succurro und Dr. Tavseef Shah kommt aus der Wissenschaft. Ihr KI-Tool nutzt Satellitendaten, um Bodenkohlenstoff zu erfassen. Das ermöglicht Agrarunternehmen, Dekarbonisierung nicht nur zu behaupten, sondern zu beweisen.

Niatsu

Gegründet 2023 von Marius Semm und Jakob Tresch in Zürich, adressiert Niatsu die Lebensmittelindustrie. Ihre Software berechnet den Product Carbon Footprint (PCF) automatisiert und kostengünstig, was gerade für den Mittelstand entscheidend ist.

4. Future Food

Was wir morgen essen (und trinken).

VANOZZA

Eines der etabliertesten Start-ups der Runde. Gegründet 2019 von Nico Hansen in Hamburg, hat sich Vanozza mit fermentierten Käsealternativen auf Cashew-Basis einen Namen gemacht und arbeitet nun an der „zweiten Generation“ ihrer Produkte.

food42morrow/JUMA

Die Frankfurter Gründer Raoul und Max Kammann sowie Carlos Lopez Granado gründeten die GmbH bereits 2020 und brachten 2022 ihre Marke JUMA (Tee-Eistees auf Guayusa-Basis) auf den Markt. Sie bedienen den Trend zu „Functional Food“.

Fazit

Die AgriFood-Start-ups des Abschlussjahrgangs des Growth Alliance Accelerators 2025 haben die Phase der reinen Ideen-Findung bereits eindrucksvoll gemeistert. Jetzt geht es um Skalierung, industrielle Anwendung und messbaren Impact. Programme wie die Growth Alliance sind dabei der Katalysator, der wissenschaftliche Exzellenz mit dem nötigen Geschäftssinn verbindet.

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.

Wenn Dr. Martin Baumgärtl erklären will, wie er die chemische Industrie revolutionieren möchte, wählt er ein Bild, das jeder versteht: „Im Grunde ist es wie ein Wasserkocher in der heimischen Küche – nur im industriellen Maßstab.“ Baumgärtl ist CTO von SYPOX, und was er beschreibt, könnte einer der wichtigsten Hebel für die Dekarbonisierung einer der schmutzigsten Branchen der Welt sein.

Die chemische Industrie ist süchtig nach Energie. Um Basischemikalien wie Methanol oder Ammoniak herzustellen, wird sogenanntes Synthesegas benötigt – eine Mischung aus Wasserstoff und Kohlenmonoxid. Die Herstellung geschieht in gewaltigen Hochtemperaturprozessen. Bisher wird die dafür nötige Hitze fast ausschließlich durch das Verbrennen von Erdgas oder Öl erzeugt. Die Folge: Gigantische CO₂-Emissionen.

Strom statt Flamme

Genau hier setzt SYPOX an. Das 2021 in Freising gegründete Unternehmen ersetzt die offenen Gasflammen durch elektrischen Strom. In ihren Reaktoren, die von außen wie gewöhnliche Druckbehälter aussehen, stecken hochkomplexe elektrische Heizelemente, die direkt hinter den Katalysatoren platziert sind.

Der Effekt ist enorm: „In konventionellen Verfahren entfallen rund 40 Prozent der Emissionen allein auf die Wärmeerzeugung aus fossilen Energieträgern“, rechnet Baumgärtl vor. Durch die Elektrifizierung des Reaktors fallen diese Emissionen weg – vorausgesetzt, der Strom kommt aus erneuerbaren Quellen. Zudem lässt sich der Prozess laut den Gründern präziser und sicherer steuern.

Der Anti-Trend im Silicon Valley

Doch nicht nur technologisch, auch ökonomisch schwimmt SYPOX gegen den Strom. In der Tech-Szene ist es üblich, dass Start-ups jahrelang Verluste schreiben und sich von einer Venture-Capital-Runde zur nächsten hangeln, getrieben von Investoren, die schnelles Wachstum fordern.

Die bayerischen Gründer wählten einen konservativeren, fast schon mittelständischen Ansatz. „Es entsprach nicht unserem Stil, Geld einzuwerben – wir haben vielmehr von Anfang an versucht, auf Basis unserer Technologie ein tragfähiges Geschäft aufzubauen“, erklärt CEO Dr. Gianluca Pauletto. Man wolle bodenständig bleiben und sich aus Umsätzen finanzieren, statt sich in Abhängigkeiten zu begeben.

Vom Container im Altmühltal zum Großkunden

Die Wurzeln des Unternehmens liegen an der Technischen Universität München (TUM). Die Idee brachte Pauletto aus seiner Zeit in Montréal mit, an der TUM fand er in Prof. Johannes Lercher und dem damaligen Doktoranden Martin Baumgärtl die wissenschaftlichen Mitstreiter.

Der Weg zum marktreifen Produkt war – typisch für „Deep Tech“ – langwierig. „Vier Jahre Forschung und zahlreiche Versuchsreihen waren notwendig“, erinnert sich Lercher. Während andere Software im Co-Working-Space programmierten, baute das SYPOX-Team eine Pilotanlage in einem einfachen Stahlcontainer auf dem Gelände einer Biogasanlage im ländlichen Dollnstein (Altmühltal).

Diese Beharrlichkeit zahlt sich nun aus. Das Start-up hat, unterstützt durch den Spezialchemie-Konzern Clariant, seinen ersten Großkunden an Land gezogen. Ab 2026 soll eine erste industrielle Anlage in Betrieb gehen, die täglich 150 Tonnen Synthesegas produziert. „Das ist nicht nur ein Meilenstein für uns, sondern auch ein starkes Signal an die gesamte chemische Industrie“, so Baumgärtl.

Für das Team, das inzwischen in Langenbach bei Freising sitzt und weiterhin Labore auf dem Forschungscampus Garching betreibt, ist das der Beweis: Die Elektrifizierung der Chemie ist keine Zukunftsmusik mehr, sie beginnt jetzt.

Optocycle: Bauschutt-Recycling auf KI-Basis

Die Optocycle-Gründer Max-Frederick Gerken und Lars Wolff Optocycle zeigen, wie aus Bauschutt neuer Rohstoff wird und erhalten dafür eine Förderung der Deutschen Bundesstiftung Umwelt (DBU).

Jährlich fallen in Deutschland laut Umweltbundesamt rund 86 Mio. Tonnen Schutt und Abfälle auf Baustellen an. Häufig landen diese Materialien auf Deponien. So gehen allerdings wertvolle Ressourcen verloren. Der Ausweg: Ein hochqualitatives Recycling des Schutts vermeidet klimaschädliche Emissionen und hält wertvolle Materialien im Wertstoffkreislauf – und das bei zertifiziert gleichwertiger Qualität.

Um das Recycling von Material im Bausektor zu automatisieren, entwickelt das 2022 von Max-Frederick Gerken und Lars Wolff gegründete Start-up Optocycle aus Tübingen ein System auf Grundlage künstlicher Intelligenz (KI) zum Echtzeit-Monitoring.

Echtzeit-Monitoring im Recycling-Prozess

Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit rund 170.000 Euro. Im Rahmen der DBU-Green Startup-Förderung haben die Gründer ein KI-basiertes System zur automatischen, reproduzierbaren Klassifizierung von Bauabfällen entwickelt. Darauf aufbauend soll nun ein Prototyp das Echtzeit-Monitoring von RC-Körnungen – also recycelten Gesteinskörnungen aus Bauschutt – ermöglichen.

„Aktuell basiert in der Branche der Aufbereitungsprozess von Bauschutt meist auf subjektiven Schätzungen“, so Max-Frederick Gerken. Auch das Endprodukt werde nur stichprobenartig im Labor überprüft. Mit dem System sei „Echtzeitmonitoring von Recycling-Gesteinskörnungen möglich. Somit können die Qualität der Körnung verbessert und mehr Material in die Beton-Produktion überführt werden“, so Gerken.

Die Qualität von Sekundärrohstoffen verbessern

Das System kombiniert laut Gerken moderne, optische Sensorik mit KI – und löse so ein altbekanntes Problem in der Baubranche. „Zurzeit schwankt oft die Beschaffenheit der recycelten Rohstoffe. Das bedeutet einerseits ein wirtschaftliches Risiko für Unternehmen und führt andererseits zum Verlust von wertvollen Materialien“, so Gerken. Optocycle erwartet mithilfe seiner Entwicklung eine 20 Prozent höhere Menge an recycelten, hochqualitativen Gesteinskörnungen sowie 15 Prozent geringere Abfallreste, die sonst auf Deponien landen würden. Dazu werden nach Gerkens Angaben sowohl der eingehende Schutt „optimal klassifiziert“ als auch das Ergebnis transparent überprüft. Kooperationspartner ist hierbei die Heinrich Feeß GmbH, die laut Gerken bereits seit vielen Jahren mit Optocycle zusammenarbeitet. Der Mitgründer weiter: „Die Technologie leistet einen Beitrag für Kreislaufwirtschaft im Bauwesen. Wir helfen dabei, die Qualität von Sekundärrohstoffen zu verbessern, die aus dem Bauschutt gewonnen werden. Diese Lösung lässt sich zudem perspektivisch auf alle Abfallströme übertragen."

Das System von Optocycle kann Gerken zufolge direkt in bereits bestehende Anlagen zur Verarbeitung von Bauabfällen installiert werden – „direkt über dem Fließband.“ Diese einfache Nachrüstung spare Kosten und ermögliche die schnelle Umsetzung eines innovativen Bauschutt-Recyclings. „Denn nur wenn das Recycling finanziell machbar ist, kann die Kreislaufwirtschaft in der Baubranche Erfolg haben“, so Gerken.

Kreislaufwirtschaft in der Baubranche ist aktiver Klimaschutz

Kreislaufwirtschaft in der Baubranche hat nach den Worten des zuständigen DBU-Referenten Dr. Volker Berding wichtige Effekte für den Klimaschutz: „Die Produktion von immer neuem Beton sorgt für hohen Ausstoß von klimaschädlichen Treibhausgasen.“ Einer WWF-Studie zufolge entstehen bei der Herstellung von Zement – dem wichtigsten Bestandteil von Beton – acht Prozent der gesamten globalen Treibhausgasemissionen. Berding: „Alles, was zur einer Emissionsreduzierung beiträgt, hat also bereits einen großen Effekt für den Klimaschutz.“ Eine Kreislaufwirtschaft funktioniere jedoch nur, „wenn die Sekundärrohstoffe sich qualitativ nicht von einer Neuproduktion unterscheiden. Genau diesen Schritt kann Optocycle mit einem skalierbaren, optimierten Prototypen gehen.“

LegalTech-Trends 2026

KI, strategische Fähigkeiten und mehr Technikverständnis stehen 2026 auf der Agenda der Rechtsbranche – gut zu wissen nicht nur für LegalTech-Start-ups und -Gründer*innen.

Die LegalTech-Trends des Jahres 2026 machen deutlich, dass die Rechtsbranche vor einem grundlegenden Wandel steht: Routinetätigkeiten werden zunehmend in den Hintergrund gedrängt, da sie automatisiert oder von KI übernommen werden. Gleichzeitig gewinnen neue Kompetenzen an Bedeutung und Up-Skilling wird zur Schlüsselqualifikation, während traditionelle Karrierepfade ins Wanken geraten. Dementsprechend werden 2026 das Technologieverständnis, Prozessdesign sowie strategische Fähigkeiten in der Rechtsbranche immer wichtiger.

1. Integrierte Cloud LegalTech-Plattformen etablieren sich

Die LegalTech-Landschaft befindet sich in einem tiefgreifenden Wandel und konsolidiert sich zunehmend zu integrierten Cloud-Ökosystemen. Diese vereinen zentrale Funktionen wie Mandats- und Fallmanagement, Dokumentenautomatisierung, Ausgaben- und Risikoanalysen sowie Kollaborations- und Workflow-Funktionen auf einer gemeinsamen Plattform. Sie lösen die bislang weitverbreiteten, voneinander getrennten Einzelsysteme ab. Diese integrierten Plattformen versetzen juristische Teams in die Lage, auf eine einheitliche, konsistente Datenbasis (Single Source of Truth) zuzugreifen und fundierte Analysen durchzuführen. Das Ergebnis sind deutlich schnellere Arbeitsabläufe, eine verbesserte Transparenz über Team- und Abteilungsgrenzen hinweg sowie eine höhere operative Resilienz der Rechtsorganisation.

2. Eingebettete agentenbasierte KI (embedded agentic AI)

Embedded Agentic AI entwickelt sich rasant zu einem der prägendsten Trends im LegalTech-Markt. Im Gegensatz zu klassischen KI-Assistenzsystemen agieren agentische KI-Module direkt innerhalb juristischer Fachanwendungen und übernehmen eigenständig klar definierte Aufgaben – etwa die Fristenüberwachung, Vertragsprüfung oder Aktenvorbereitung. Nahtlos in bestehende Workflows eingebettet, reduzieren sie manuellen Aufwand, minimieren Risiken und steigern die Produktivität spürbar. Für Kanzleien bedeutet Embedded Agentic AI einen strategischen Schritt hin zu skalierbaren, zukunftssicheren Prozessen, bei denen juristische Expertise gezielt durch autonome, kontextbewusste KI ergänzt wird.

3. KI-Sicherheit & Governance

KI ist längst mehr als nur ein Werkzeug – sie entwickelt sich zu einer operativen Notwendigkeit. Im Jahr 2026 werden LegalTech-Pioniere deshalb über reine Pilotprojekte hinausgehen und Rahmenwerke für die KI-Governance, Risikokontrollen, Compliance und ethische Rahmenbedingungen einführen. In diesem Kontext gilt es beispielsweise Transparenzanforderungen zu definieren, Prompt-Audits und Human-in-the-Loop-Kontrollen einzuführen sowie für die Nachverfolgbarkeit von Datenquellen zu sorgen. Kanzleien und Rechtsabteilungen, die eine strukturierte KI-Governance integrieren, reduzieren Haftungsrisiken, stärken das Vertrauen und können KI skalieren. Wenn sie dabei auch noch den ethischen und regulatorischen Compliance-Anforderungen gerecht werden, sind sie für die Herausforderungen der Zukunft gut aufgestellt.

4. Predictive Legal Analytics

KI steht 2026 nicht mehr nur für unterstützende oder automatisierende Funktionen, sondern entwickelt sich zunehmend zum strategischen Faktor. Generative KI und fortschrittliche Analyseverfahren werden gezielt zum Einsatz kommen, um den Ausgang von Gerichtsverfahren zu prognostizieren, umfangreiche Beweis- und E-Discovery-Daten auszuwerten und bislang verborgene Muster in der Rechtsprechung zu identifizieren. Im Jahr 2026 wird KI-generierter Content in immer mehr Verfahren eine zentrale Rolle bei der Sichtung, Bewertung und Einordnung von Beweismitteln spielen. Dadurch verändern sich die Vorgehensweisen bei der Vorbereitung von Fällen, dem Entwickeln von Argumentationsketten sowie der strategischen Entscheidungsfindung. All das führt dazu, dass Technologie vom reinen Hilfsmittel zum strategischen Entscheidungsfaktor aufsteigt.

5. Juristische Talente entwickeln sich zu technisch versierten Fachkräften

Anwältinnen und Anwälte müssen sich zunehmend zu technologieaffinen Gestaltern entwickeln, die digitale Tools, Automatisierung und KI souverän in ihre tägliche Arbeit integrieren. Statt reiner Rechtsanwendung rücken Prozessverständnis, Systemkompetenz und Dateninterpretation in den Fokus. Kanzleien profitieren von effizienteren Abläufen, höherer Skalierbarkeit und besserer Mandantenorientierung. Tech-fluente Legal Professionals werden damit zum entscheidenden Wettbewerbsfaktor in einem zunehmend digitalisierten Rechtsmarkt.

6. KI-gestütztes Smart Contracting & Compliance Automation

KI geht im Vertragswesen weit über einfache Prüfungsfunktionen hinaus und wird zum zentralen Instrument für umfassendes Contract Lifecycle Management, Compliance-Monitoring sowie eine automatisierte Vertragserstellung. Zudem lassen sich durch Predictive Analytics Risiken, Inkonsistenzen und Compliance-Probleme immer früher identifizieren – ein Trend, der insbesondere für Unternehmensrechtsabteilungen und international tätige Kanzleien von Bedeutung ist. Im Jahr 2026 werden sich vor allem diese drei Anwendungsszenarien etablieren:

- KI-gestützte Vertragsanalysen, die potenzielle Risiken identifizieren und konkrete Korrekturvorschläge liefern.

- Automatisierte Compliance-Berichte zur lückenlosen Nachverfolgung regulatorischer Vorgaben.

- KI-Unterstützung bei der Erstellung von Dokumenten.

7. Cybersicherheit wird zum Wettbewerbsvorteil

Mit der zunehmenden Nutzung von LegalTech steigen auch die Risiken im Bereich Cybersecurity. Umso wichtiger ist es, dass Jurist*innen die Daten ihrer Mandant*innen, vertrauliche Fallakten sowie ihre KI-Systeme vor Ransomware-Angriffe, Datenpannen und der unbefugten Offenlegung sensibler Informationen schützen. Robuste Cybersecurity-Tools und datenschutzorientierte LegalTech-Architekturen sind daher unverzichtbar und werden häufig direkt in die Plattformen integriert. Kanzleien und Rechtsabteilungen, die hier proaktiv investieren, schützen nicht nur ihre Reputation und das Vertrauen ihrer Mandant*innen, sondern erfüllen zugleich die zunehmend strengeren globalen Datenschutzvorschriften.

8. Ergebnisorientierte und ROI-nachweisbare KI-Einführung

2026 steht LegalTech nicht mehr im Testmodus – sie muss konkrete Mehrwerte nachweisen. Sowohl Anbietende als auch Anwendende sind zunehmend gefordert, Investitionen in Technologie klar mit messbaren Ergebnissen zu verknüpfen, etwa durch Zeit- und Kostenersparnis, Reduzierung von Fehlern oder eine höhere Mandant*innenzufriedenheit. Für die Praxis bedeutet das: Pilotprojekte sollten stets mit klar definierten KPIs starten, um den Erfolg messbar zu machen. Analysen spielen eine entscheidende Rolle, um den geschäftlichen Nutzen gegenüber Führungskräften und Mandant*innen transparent darzustellen. Gleichzeitig verlagern sich Budgetentscheidungen weg von „Innovation um der Innovation willen“ hin zu einer klaren ROI-orientierten Ausrichtung.

9. Innovation in der Rechtsberatung & alternative Business-Modelle

Die Veränderung in der Rechtsbranche betrifft die gesamte Struktur juristischer Dienstleistungen. Klassische Stundenhonorare verlieren an Bedeutung, während alternative Preismodelle wie Festpreise, Abonnements oder wertbasierte Vergütungen an Bedeutung gewinnen. Diese Entwicklung wird durch Technologien unterstützt, die Ergebnisse zuverlässig vorhersagen und standardisierte Leistungen effizient bereitstellen. Für Rechtsabteilungen und Mandant*innen wird Kalkulierbarkeit zunehmend zum Standard. Kanzleien, die ihre Liefermodelle entsprechend innovativ gestalten, sichern sich einen Wettbewerbsvorteil gegenüber Wettbewerber*innen, die weiterhin auf traditionelle Stundenhonorare setzen.

10. Lawbots & Vertikale Automatisierung

„Lawbots“ stehen kurz davor, zum festen Bestandteil der Rechtsbranche zu werden. Diese spezialisierten Bots sind darauf ausgelegt, spezifische juristische Aufgaben zu automatisieren – von der Mandantenaufnahme über Dokumentenautomatisierung und Compliance-Prüfungen bis hin zu rechtlicher Recherche. Typische Einsatzszenarien sind etwa maßgeschneiderte Bots für Einwanderungsanträge, Markenanmeldungen oder Routineverfahren in der Prozessführung. Sie übernehmen klar definierte, standardisierte Aufgaben auf höchst effiziente Weise. So gewinnen Anwält*innen wertvolle Zeit, um sich auf komplexe, urteilsbasierte Arbeiten zu konzentrieren und strategische Entscheidungen zu treffen.

Der Autor Oliver Bendig ist CEO von stp.one, einem der führenden Anbietern von Legal-Tech-Komplettlösungen.

Infinite Roots: Hamburger BioTech bringt pilzbasierte Gerichte ins Kühlregal

Das 2018 von Dr. Mazen Rizk, Anne-Cathrine Hutz und Dr. Thibault Godard als Mushlabs gegründete Hamburger Start-up Infinite Roots (ehemals Mushlabs) bringt die Vorteile der Pilzwelt erstmals als eigenständige Hauptzutat ins Kühlregal.

Infinite Roots ist ein forschungsgetriebenes BioTech-Unternehmen aus Hamburg. Seit 2018 entwickelt das Unternehmen (zunächst unter dem Namen Mushlab) neuartige Lebensmittel auf Basis von Pilzen – inspiriert vom Myzel, dem unterirdischen Wurzelgeflecht essbarer Pilze. Durch Fermentation schafft Infinite Roots Produkte, die über bloße Fleischalternativen hinausgehen. Das Ziel ist es, eine neue Kategorie zu etablieren: Lebensmittel, die echtes Umami und wertvolle Nährstoffe liefern, mit kurzen Zutatenlisten auskommen und die Umwelt entlasten.

Mit mehr als 60 Expert*innen aus Biotechnologie, Data, Lebensmittelwissenschaft und Kulinarik will das Team neue Standards für Geschmack, Qualität und Nachhaltigkeit setzen und zeigen, dass die Ernährung der Zukunft nicht Verzicht bedeutet, sondern Vielfalt und Genuss.

Die MushRoots-Produkte des Unternehmens sind keine Fleischimitate, sondern bieten ein eigenständiges, pilzbasiertes Geschmackserlebnis. Sie zeichnen sich durch einen saftigen, herzhaften Biss und ausgeprägte Umami-Noten aus. Die Hamburger setzen dabei auf Speisepilze, kombiniert mit vertrauten, hochwertigen Zutaten. Entsprechend bauen die Produkte auf einer natürlichen Zutatenliste auf und verzichten auf künstliche Aromen, Geschmacksverstärker und Farbstoffe. So entsteht ein Geschmackserlebnis, das an herzhafte Hausmannskost erinnert. Die Produkte lassen sich vielseitig im Alltag, etwa als Hack, Bällchen oder Patties.

„Im Kühlregal sehen Konsument*innen seit Jahren dieselbe Logik: Tierprotein hier, Pflanzenprotein dort“, sagt Philip Tigges, CCO/CFO von Infinite Roots. „Mit MushRoots bringen wir nicht nur eine dritte Option ins Regal, sondern kehren auch zu Lebensmitteln mit einer natürlichen Hauptzutat zurück. Pilze bieten einen herzhaften Geschmack, sind vielseitig, in allen gewohnten Rezepten einsetzbar und können kinderleicht zubereitet werden.“

MushRoots setzt dabei auf eine Proteinquelle mit vergleichsweise geringem ökologischen Fußabdruck. Pilze lassen sich lokal und ressourcenschonend kultivieren. „Wir wollten nie ein weiteres Fleischimitat herstellen, sondern eine eigene Kategorie umami-reicher Pilzprodukte schaffen, die durch Charakter und Geschmack überzeugen“, ergänzt Tigges. „Unser Ziel ist es jetzt, Menschen für Pilzprodukte zu gewinnen, ohne dass sie Fleisch vermissen.“

Jetzt meldet Infinite Roots, dass vier MushRoots-Produkte ab sofort bei REWE Nord in Norddeutschland und Billa Plus in Österreich erhältlich sind und damit eine neue Kategorie an Pilz-Produkten in die Kühlregale Einzug gehalten haben.

Gaming & digitale Medien – eine Perspektive für Start-ups?

Diese Voraussetzungen sollten Gründerinnen und Gründer von Start-ups in der Gamingbranche oder der Gestaltung digitaler Medien mitbringen, um erfolgreich zu sein.

Digitale Start-ups verbinden attraktive Zukunftsperspektiven mit einem geringen Startkapital. Für die digitale Generation aktueller Schul- und Universitätsabgänger stellt sich die Frage, ob ein Einstieg in die Gamingbranche oder die Gestaltung digitaler Medien für die Gründung eines Start-ups ausreichen kann. Solche Perspektiven sind gegeben, die neben ausreichend Kreativität eine fundierte Ausbildung in Computertechnik und Business gleichermaßen voraussetzen.

Indie-Games – eine Perspektive für Entwickler?

Noch vor einigen Jahren war die Gamingbranche als Perspektive für Gründer eher unattraktiv. Die großen, internationalen Studios dominierten die Szene, wobei für Triple-A-Titel längst Tausende von Entwicklern an unterschiedlichen Standorten benötigt wurden. Unter dem Zeit- und Kostengrund vieler Studios sowie der Entlassungswelle der letzten Jahre ist es für immer mehr Developer uninteressant, auf die Anstellung in einem der großen Softwarehäuser zu hoffen.

Die unabhängige Entwicklung von digitalen Medien oder Spielen bleibt jedoch beliebt und kann zur Basis eines Start-ups werden. Immer mehr Gamer wenden sich von den überteuerten, großen Marken der Szene ab und vertrauen auf kleinere Entwickler mit mehr Freiheiten bei der Umsetzung. Selbst die großen Gaming-Plattformen halten regelmäßig eine Auswahl beliebter und neuer Indie-Games für Millionen Nutzer bereit.

Unabhängig von Größe und Art eines Studios bleibt die Gamingbranche international und setzt verschiedene Skills vom Development bis zum erfolgreichen Marketing voraus. Dies alles lässt sich längst in speziell abgestimmten Studiengängen erlernen.

Spielentwicklung der neuesten Generation als Studiengang

Studiengänge wie Games & Immersive Media an der Hochschule Furtwangen erlauben es, einen Bachelor im Gaming-Umfeld zu erlangen und alle relevanten Fähigkeiten für den zukünftigen Berufsweg zu gewinnen. Neben Computer Science und Anwendungen im spielerischen Bereich nehmen Business, Design und Medien als zweiter Bereich einen wesentlichen Stellenwert im Studium ein.

Diese Kombination des bilingualen Studiengangs ergibt Sinn. Schließlich ist nicht jeder kreative Programmierer und Spieleentwickler ein Geschäftsmann, genauso wenig wie Marketer gerne stundenlang mit Quellcode arbeiten. Moderne Studiengänge wie dieser führen beide Welten zusammen und sorgen für eine fundierte Ausbildung, um tiefe Einblicke in beide relevanten Arbeitsfelder zu gewinnen.

Starke Unterstützung für zukünftige Start-ups

Die Hochschule Furtwangen geht mit ihrer Unterstützung weit über den reinen Studiengang hinaus. Bewusst wird angehenden Start-ups unter die Arme gegriffen, die ihre ersten Schritte ins Gaming-Business mit kreativen Spielen und Studienprojekten gehen möchten.

Neben einer umfassenden Beratung auf dem Weg zum eigenen Business werden ein Support für Fördermittel sowie Räumlichkeiten für das gemeinschaftliche Arbeiten an Spielen oder digitalen Medien geboten. Viele Formalitäten und Unsicherheiten, die sich bei Start-ups unabhängig von Branche und Geschäftsfeld ergeben, werden so seitens der Hochschule kompetent und professionell unterstützt.

Für den Einstieg sind Kenntnisse im Gaming-Bereich ideal, die über die reine „Freude am Zocken“ hinausgehen. Kreativität in der Planung und Umsetzung eigener Projekte sollte nachgewiesen werden – anders als die zwingende Notwendigkeit, eine Programmiersprache zu beherrschen.

Sichtbarkeit im digitalen Umfeld entscheidend

Wie bei allen Produkten entscheidet weniger die tatsächliche Qualität, sondern die Sichtbarkeit und eine wirkungsvolle Werbung über Erfolg von Misserfolg von Games. Gerade das Marketing für digitale Produkte ist wegen der hohen Konkurrenz und einer Fülle an Informationen in der digitalen Welt eine immense Herausforderung. Hier eine fachkundige Unterstützung von Anfang an zu erhalten, bewahrt Entwickler und kreative Köpfe davor, grundlegende Fehler zu begehen und frühzeitig den Traum vom Gaming-Job zu begraben.

KI-Hype: mittel- bis langfristiger Weg zur Monetarisierung noch unklar

Aktueller Marktkommentar zum KI-Hype und den möglichen Folgen von Justin Thomson, Head Investment Institute and CIO bei T. Rowe Price.

Die Investitionsausgaben für künstliche Intelligenz (KI) haben ein erstaunliches Niveau erreicht, aber der Weg zur Monetarisierung bleibt unklar. Der Markt-Hype schaukelt sich selbst hoch, und die Tech-Giganten greifen nun zu Krediten, um ihre Expansion zu finanzieren. Blasen sind nicht immer schädlich und können zu erheblichen Produktivitätssteigerungen führen, aber Überkapazitäten sind ein reales Risiko, das beobachtet werden sollte.

Während eines hochkarätigen Finanzgipfels, an dem ich kürzlich in Hongkong teilgenommen habe, sagte der CEO einer führenden Vermögensverwaltungsgesellschaft, der es eigentlich besser wissen müsste: „Im Kontext der Ausstattung von Hyperscalern sind 2,5 Billionen US-Dollar [für Investitionen] über fünf Jahre keine große Summe.“ Ich war über diese Bemerkung erstaunt. In welchem Paralleluniversum sind 2,5 Billionen US-Dollar eine unbedeutende Summe? Antwort: in einem, in dem Nvidia innerhalb von drei Monaten eine Marktkapitalisierung von 1 Billion US-Dollar erreichen kann. Aber wie erzielt man eine Rendite auf Investitionen in Höhe von 2,5 Billionen US-Dollar, wenn der mittel- bis langfristige Weg zur Monetarisierung der KI noch unklar ist?

Dies deutet auf zwei verschiedene AI-Investitionsbooms hin: einen relativ kurzfristigen, der durch eine erkennbare tatsächliche Nachfrage gestützt wird, und einen längerfristigen spekulativen Boom, der mit einem quasi-religiösen Glauben an exponentielles Wachstum verbunden ist.

Betrachten wir zunächst einige beeindruckende Zahlen. Die Ausgaben für KI erreichten gerade 1 % des US-Bruttoinlandsprodukts (BIP) in einer Wirtschaft mit 1,8 % Wachstum – das ist mehr als die Hälfte der gesamten neuen Nachfrage. Allein Nividia erreichte Ende Oktober einen Wert von 5 Billionen US-Dollar, was 15 % der gesamten US-Wirtschaft entspricht. Zum Vergleich: Als Cisco im Jahr 2000 als weltweit größtes Unternehmen seinen Höhepunkt erreichte, betrug sein Anteil am BIP nur 5,5 %. Während viel Aufsehen um den 3 Milliarden US-Dollar teuren Hauptsitz von JP Morgan in Manhattan gemacht wurde, werden in Texas still und leise 40 Milliarden US-Dollar teure Rechenzentrumsprojekte gestartet. Niemand scheint sich dafür zu interessieren.

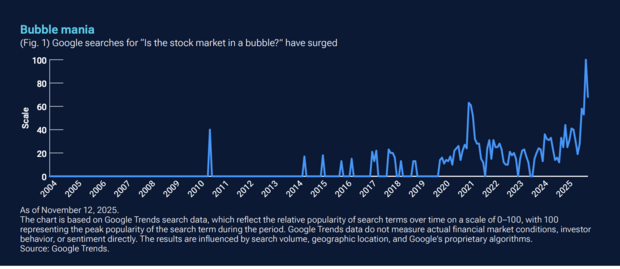

Sind wir also in einer Blase? Es gibt sicherlich eine Blase von Menschen, die über Blasen sprechen – werfen Sie einfach einen Blick auf Google Trends.

Unterdessen gibt es diejenigen, die glauben, dass wir uns gerade deshalb nicht in einer Blase befinden können, weil wir über eine solche sprechen. Meiner Meinung nach gibt es drei Schlüsselwörter in den jüngsten Marktentwicklungen, die Beachtung verdienen: Reflexivität, Zirkularität und Verschuldung. Reflexivität besagt, dass Preise tatsächlich die Fundamentaldaten beeinflussen und dass diese neu beeinflussten Fundamentaldaten dann die Erwartungen verändern und somit die Preise beeinflussen. Dieser Prozess setzt sich in einem sich selbst verstärkenden Muster fort. Die lebhafte Reaktion des Marktes auf die jüngsten KI-Megadeals ist ein Beispiel für einen solchen Feedback-Kreislauf. Hinzu kommt der zirkuläre Charakter dieser Deals. Im Wesentlichen investieren die Anbieter von Recheninfrastruktur in native KI-Akteure, die sich in einer Investitionsphase befinden. In der Dotcom-Ära war dies als „Vendor Financing” bekannt und wurde zu einer Art Schimpfwort.

Schließlich gibt es noch die Verschuldung. Bislang haben die finanzstarken Tech-Giganten diesen KI-Boom mit ihren eigenen tiefen Taschen und Eigenkapitalfinanzierungen finanziert. Aber jetzt treten wir in die Kreditphase ein – Unternehmen wenden sich den Schuldenmärkten zu, oft außerhalb der Bilanz, und die Kreditaufnahme wird sich wahrscheinlich beschleunigen. Wir wissen, dass wir mit generativer KI und später mit künstlicher Superintelligenz vor einem neuen technologischen Paradigma stehen – und möglicherweise vor einem massiven Produktivitätssprung. Das sind alles großartige Dinge, und es ist leicht zu verstehen, dass man der Versuchung erliegt, weiter auf der lukrativen KI-Welle zu reiten, die mit der Einführung von ChatGPT im November 2022 begann. Angesichts der aktuellen Indexkonzentration würde es in der Tat Mut erfordern, auszusteigen.

Schnelles Wachstum kann zu einem Überschuss führen

Eine wichtige Lehre aus der Geschichte ist, dass es zu Blasen kommt, wenn wir schöne Dinge erfinden. Aber nicht alle Blasen sind gleich. Es gibt „schlechte“ Blasen (Tulpen, Gold, Grundstücke), und wenn schlechte Blasen durch Schulden finanziert werden, kann dies ein systemisches Risiko für die Wirtschaft darstellen. Es gibt auch „gute“ Blasen, die zu Überkapazitäten bei Produktionsmitteln führen – man denke an die Eisenbahnen im goldenen Zeitalter der Expansion der USA zwischen 1870 und 1900, die Elektrizität in den frühen 1900er Jahren und den Dotcom-Boom Ende der 1990er Jahre. Letztendlich wurde in jedem Fall Wohlstand geschaffen, aber die frühen Investoren verloren viel Geld.

Es ist noch zu früh, um vorherzusagen, zu welcher Art von Blase sich der AI-Investitionsboom entwickeln wird. Die langfristigen Auswirkungen werden davon abhängen, ob die heutigen massiven Investitionen letztendlich die Grundlage für dauerhafte Produktivitätssteigerungen schaffen oder ob sie zu Überkapazitäten führen, die keine nachhaltigen Renditen erzielen. Wenn die Kapazitäten so schnell wachsen, ist es immer wahrscheinlich, dass sich das Ungleichgewicht zwischen Angebot und Nachfrage von einem Mangel zu einem Überschuss umkehrt. In der Dotcom-Ära verloren Investoren viel Geld mit Glasfaserkabeln und Switches, die in den Boden verlegt wurden, und etwas Ähnliches könnte mit KI passieren, wenn durch Überbauung riesige Kapitalmengen in Anlagen gebunden werden, die möglicherweise nicht annähernd mit voller Effizienz betrieben werden können – oder noch schlimmer, wenn die Schnelllebigkeit des Chip-Zyklus die Rechenleistung obsolet macht.

Erschwerend kommt hinzu, dass die Anreize für Infrastrukturanbieter („Picks and Shovels”-Akteure) und Entwickler von KI-Anwendungen nicht aufeinander abgestimmt sind. Während Infrastrukturunternehmen von einer kontinuierlichen Expansion und Investitionen profitieren, konzentrieren sich Anwendungsentwickler auf die Verbesserung der Effizienz und die Senkung der Kosten. Um den Kommentar des Dodos nach dem Caucus-Rennen in Lewis Carrolls Alice im Wunderland umzukehren: „Nicht jeder kann gewinnen, und nicht jeder kann einen Preis bekommen.” Die optimistischen Prognosen für die KI-Infrastruktur zeigen, wie viel Hype in den heutigen Bewertungen der Hyperscaler steckt. Es ist ironisch, dass Rechenzentrumsprojekte nach den griechischen Titanen Prometheus und Hyperion benannt werden. In der griechischen Mythologie folgt auf Hybris immer Nemesis. Um noch ein bisschen Latein mit einzubringen: caveat emptor.

KI & Bewertungen: Sichtbarkeit in einer neuen Suchrealität

Tipps und To-dos: Wie du dein Bewertungsmanagement strategisch aufsetzt und Sichtbarkeit und Vertrauen im KI-Zeitalter steigerst.

Generative Antworten in Suchmaschinen und Assistenten verändern die Spielregeln der Online-Sichtbarkeit. Nicht mehr nur klassische Rankings entscheiden, sondern die Frage, wem die KI genug vertraut, um es überhaupt zu nennen. Aktuelle, glaubwürdige und inhaltlich konkrete Bewertungen werden dabei zum Schlüsselsignal. Für kleine und mittlere Unternehmen bedeutet das: Bewertungsmanagement ist kein Nice-to-have mehr, sondern ein Pflichtprogramm, das Auffindbarkeit, Auswahl und Conversion spürbar beeinflusst. Im Folgenden erfährst du, wie du dein Bewertungsmanagement strategisch aufsetzen solltest, um Sichtbarkeit und Vertrauen im KI-Zeitalter zu steigern.

Warum Bewertungen jetzt geschäftskritisch sind

KI-Modelle zerlegen Rezensionen in viele kleine Bedeutungseinheiten und ziehen daraus ein konsistentes Bild. Welche Leistung wurde erbracht, an welchem Ort, mit welcher Qualität und für welchen Anlass. Aus den einzelnen Stimmen entsteht so ein Vertrauensprofil, das über bloße Sternesummen hinausgeht. Entscheidend ist nicht die bloße Menge, sondern die Frische und die inhaltliche Dichte der Aussagen. Eine Rezension wie „Schnell geholfen am Sonntag, sehr kompetente Beratung zu Reiseimpfungen“ liefert gleich mehrere Signale. Zeitliche Verfügbarkeit, thematische Expertise und konkreter Nutzen. Genau solche Details erhöhen die Wahrscheinlichkeit, in generativen Antworten aufzutauchen, wenn Menschen in ihrer Nähe nach einer Lösung suchen. Wer regelmäßig neue, authentische und präzise Bewertungen erhält, verschafft der KI verlässliche Hinweise und sichert sich dadurch mehr Sichtbarkeit in genau den Momenten, in denen Entscheidungen vorbereitet werden.

Bewertungsmanagement als Prozess, nicht als Aktion

Wirksam wird Bewertungsarbeit, wenn sie selbstverständlich Teil der täglichen Abläufe ist. Nach dem Kontakt freundlich um Feedback bitten, den Weg zur passenden Plattform so kurz wie möglich machen, interne Zuständigkeiten klar regeln und Reaktionszeiten verbindlich festlegen. Aus diesen scheinbar kleinen Schritten entsteht ein stabiler Rhythmus, der kontinuierlich neue Kund*innenstimmen hervorbringt und der KI immer wieder frische Kontexte liefert. Ein solcher Prozess ist robuster als jede einmalige Kampagne, weil er verlässlich Vertrauen aufbaut und saisonale Schwankungen abfedert. Teams profitieren, wenn sie Zielkorridore definieren, etwa eine bestimmte Zahl neuer Rezensionen pro Woche und wenn sie Fortschritte sichtbar machen. So wird aus gutem Vorsatz ein gelebter Ablauf, der die gesamte Organisation stärkt.

Sprache der Kund*innen wirkt wie natürliches SEO

KI versteht Alltagssprache deutlich besser als Listen isolierter Schlagwörter. Unternehmen gewinnen, wenn sie um freie, aber konkrete Formulierungen bitten, ohne Vorgabetexte und ohne Druck. Eine höfliche Bitte wie: „Wenn es für Sie passt, nennen Sie gern, was Ihnen besonders geholfen hat“ öffnet den Raum für präzise Hinweise auf Leistungen, Erreichbarkeit, Barrierefreiheit oder Schnelligkeit. Solche natürlich entstandenen Details sind für Menschen überzeugend und zugleich für Maschinen gut interpretierbar. Sie zeigen, wofür ein Betrieb tatsächlich steht, und verankern die passenden Begriffe in einem echten Nutzungskontext. Das Ergebnis ist eine Sprache, die Vertrauen schafft und die Auffindbarkeit stärkt, ohne künstlich zu wirken.

Antworten trainieren Vertrauen für Menschen und Maschinen

Jede Reaktion auf eine Bewertung ist ein sichtbares Zeichen von Serviceorientierung und zugleich zusätzlicher Kontext für die KI. Gute Antworten bedanken sich aufrichtig, beziehen sich konkret auf das Erlebte und bieten einen klaren nächsten Schritt an. Bei Kritik zählt ein professioneller Umgang. Das Anliegen nachvollziehen, Verantwortung übernehmen, eine realistische Lösung anbieten und einen direkten Kontaktweg nennen. So entsteht ein Bild von Verlässlichkeit, das Hemmschwellen senkt und Wiederbesuche wahrscheinlicher macht. Die KI erkennt diesen Umgang ebenso und ordnet das Unternehmen eher als vertrauenswürdig ein. Mit der Zeit entsteht ein stabiler Kreislauf aus guter Erfahrung, konstruktiver Reaktion und wachsendem Vertrauen.

Lokaler Content und Social Proof gehören zusammen

Bewertungen entfalten ihre volle Wirkung, wenn sie auf eine solide Informationsbasis treffen. Konsistente Unternehmensdaten, vollständige Leistungsseiten pro Standort, klare Öffnungszeiten inklusive Ausnahmen und eine schnelle, mobil optimierte Webseite erleichtern die Einordnung für Nutzer*innen und Maschine. Wenn ausgewählte Zitate oder Bewertungsschnipsel an relevanten Stellen sichtbar werden, etwa auf der Startseite, in der Buchungsstrecke oder in den häufigen Fragen, entsteht ein schlüssiges Gesamtbild. Der lokale Bezug bleibt klar erkennbar, die Erwartungen sind gut gesetzt, und die nächsten Schritte sind ohne Umwege möglich. So wird aus Social Proof ein handfester Conversion Hebel.

Vom Feedback zur Verbesserungsschleife

Rezensionen sind fortlaufende Marktforschung aus erster Hand. Wer wiederkehrende Themen auswertet, etwa Wartezeiten, Erreichbarkeit oder Bezahloptionen, erkennt schnell die Stellschrauben mit der größten Wirkung. Wichtig ist, die daraus abgeleiteten Verbesserungen konsequent umzusetzen und sichtbar zu machen. Informieren, handeln, erneut um Rückmeldung bitten. Dieser offene Kreislauf wirkt nach innen und nach außen. Mitarbeitende erleben, dass Feedback Veränderungen anstößt, Kund*innen erleben, dass ihre Hinweise ernst genommen werden, und die KI registriert die fortlaufende Pflege der Qualität. Mit jeder Runde werden Erlebnisse besser und Bewertungen stärker, was die Sichtbarkeit weiter erhöht.

Fazit

Sichtbarkeit entsteht heute dort, wo Menschen nach konkreten Lösungen fragen und wo KIs verlässliche Hinweise zu Qualität und Relevanz finden. Unternehmen, die Bewertungen als strategischen, kontinuierlichen Prozess verstehen, erhöhen ihre Chance, in generativen Antworten genannt zu werden und gewinnen genau in den entscheidenden Momenten an Präsenz. Vieles davon ist eine Frage kluger Organisation und klarer Abläufe. Der finanzielle Aufwand bleibt überschaubar, der Nutzen für Auffindbarkeit, Vertrauen und Umsatz ist deutlich spürbar.

Die Autorin Franziska Ortner ist Produktmanagerin bei SELLWERK

NICAMA Naturkosmetik: Von der Studienidee zum nachhaltigen Erfolgsunternehmen

NICAMA Naturkosmetik feiert sein fünfjähriges Bestehen: Was mit kleinen Experimenten während des Studiums begann, ist heute ein etabliertes Naturkosmetikunternehmen mit über 600 Handelspartnern im DACH-Raum.

Was 2019 als mutige Idee von vier Studierenden begann, wurde rasch zu einem inspirierenden Beispiel für gelebte Nachhaltigkeit. In einer Zeit, in der Umweltschutz noch kein selbstverständlicher Trend war, experimentierten die Gründerinnen und Gründer mit festen Shampoos, um eine plastikfreie Alternative zu herkömmlicher Kosmetik zu schaffen. Das erste Produkt entstand mit viel Leidenschaft, Neugier und Improvisation. Damit war der Grundstein für den späteren Unternehmenserfolg gelegt.

Ein erfolgreiches Crowdfunding finanzierte 2019 die erste Produktcharge und machte den Traum vom eigenen Webshop möglich. Es folgten die ersten Partnerschaften mit Bioläden, Outdoorhändlern, Friseuren und Geschenkeläden, die an die Vision glaubten. Heute zählt NICAMA stolz über 600 Vertriebspartner und wächst weiter.

Ein entscheidender Meilenstein war die Entwicklung des 1plus1 Meeresschutz-Prinzips: Für jedes verkaufte Produkt werden 100 Gramm Plastik in Küstenregionen gesammelt. Dieses Prinzip ist transparent, messbar und von jedem/jeder Kund*in nachvollziehbar. Bis heute konnten so über 33.290 Kilogramm Plastik aus der Umwelt entfernt werden. Das entspricht mehr als 3,2 Millionen Plastikflaschen. Darüber hinaus hat das Team mehrere Elbreinigungen organisiert, unter anderem gemeinsam mit der Naturschutzjugend NAJU und Charlotte Meentzen.

Mit dem Schritt in die Upcycling Beauty wurde NICAMA zum Pionier in Deutschland. Dabei werden wertvolle Nebenprodukte aus der Lebensmittelproduktion wie Ingwertrester und Kaffeekirsche zu hochwertigen Inhaltsstoffen verarbeitet. Heute umfasst das Sortiment über 50 plastikfreie Produkte, darunter Seifen, Shampoos, Deocremes, Pflegeöle und Körperpeelings – alle minimalistisch verpackt und mit reduzierten, sorgfältig ausgewählten Rezepturen.

Die Reise war jedoch nicht ohne Herausforderungen: Die Corona Pandemie und die Inflationsfolgen des Ukraine-Krieges setzten auch NICAMA stark zu. Das einst 15-köpfige Team musste sich zwischenzeitlich deutlich verkleinern. Trotz dieser Rückschläge bewies das Unternehmen Durchhaltevermögen. Heute steht es so solide da wie nie zuvor. Seit zwei Jahren verzeichnet NICAMA wieder überdurchschnittliches Wachstum und das deutlich über dem allgemeinen Naturkosmetikmarkt in Deutschland.

Für sein Engagement und seine Innovationskraft wurde das Unternehmen mehrfach ausgezeichnet: 2021 gewann NICAMA den Sächsischen Gründerpreis und erhielt bereits viermal den eku Zukunftspreis des Sächsischen Staatsministeriums für Umwelt und Landwirtschaft.

GreenTech – der Boom geht zu Ende

Zwar zählt Deutschland rund 3000 Start-ups aus dem GreenTech-Bereich, doch viele kämpfen mit Kapitalmangel, Fachkräftedefizit und einer überlasteten Infrastruktur. Der Boom ist vorbei – eine Einschätzung von Seriengründer und Transformationsexperte Daniel Fellhauer.

Die deutsche Wirtschaft steht vor einer ihrer größten Transformationen seit der Industrialisierung. Jahrzehntelang galten Auto- und Stahlindustrie als Rückgrat des Wohlstands. Nun rückt Nachhaltigkeit in den Mittelpunkt. Daniel Fellhauer sieht die GreenTech-Branche an einem kritischen Punkt: „GreenTech ist kein Hype, sondern Realität mit echten Herausforderungen. Die Frage ist: Wer bleibt übrig, wenn die Subventionen verschwinden?“ Seine Aussage bringt auf den Punkt, was viele Brancheninsider beschäftigt: der Übergang von gefördertem Wachstum zu marktwirtschaftlicher Reife. Jetzt entscheidet sich, welche Unternehmen Innovation und Wirtschaftlichkeit in Einklang bringen können – und wer an überzogenen Erwartungen scheitert.

Der Boom geht zu Ende

„Der Anteil grüner Gründungen ist zuletzt deutlich gesunken“, sagt Daniel Fellhauer. „Vor zwei Jahren war noch jedes dritte neue Start-up nachhaltig ausgerichtet. Heute ist es nicht einmal mehr jedes Vierte. Das ist ein deutliches Warnsignal. Der Markt sortiert sich, Kapital wird selektiver, und viele Ideen schaffen es nicht mehr über die Pilotphase hinaus.“ In den vergangenen fünf Jahren flossen zwar rund 11,7 Milliarden Euro in grüne Start-ups – etwa ein Viertel aller deutschen Risikoinvestitionen –, doch das Geld konzentriert sich zunehmend auf wenige, große Player. „Das zeigt eine Reifung, aber auch eine gefährliche Schieflage“, so Fellhauer. „Wir brauchen Breite, nicht nur Leuchttürme. Wenn die Finanzierungsströme versiegen, bevor Skalierung einsetzt, kippt der ganze Innovationspfad.“ Hinzu kommen steigende Zinsen, langwierige Genehmigungen und überlastete Netze. „Viele unterschätzen, wie stark Infrastruktur über Wachstum entscheidet“, erklärt er. „Eine Solarfirma kann heute Aufträge für 1.000 Anlagen im Jahr haben. Aber wenn der Netzanschluss neun Monate dauert, bleibt sie auf halber Strecke stehen.“

Deutschland ist längst auf dem Weg zur nachhaltigen Wirtschaft – doch der Anstieg wird steiler. Die entscheidende Frage lautet: Wird GreenTech zum Fundament der nächsten industriellen Ära, oder zur vertanen Chance einer Generation? Laut einer aktuellen Analyse fließt ein erheblicher Teil staatlicher Investitionen und Subventionen in Deutschland weiterhin in fossile Strukturen – über 60 Milliarden Euro jährlich. Da-bei hatte sich die Bundesregierung bereits 2009 gemeinsam mit anderen Industrieländern verpflichtet, ineffiziente Förderungen für fossile Energieträger bis 2025 zu beenden. Ein Ziel, das laut Fachleuten von Fraunhofer ISI, ZEW und Umweltbundesamt klar verfehlt wird. Daniel Fellhauer warnt: „Das ist kein ideologisches, sondern ein ökonomisches Problem. Solange Kapital und Fördermittel in alte Industrien gelenkt werden, anstatt in skalierbare GreenTech-Lösungen, bleibt Deutschland in der Vergangenheit verhaftet.“

Herausforderungen im deutschen GreenTech-Sektor

Trotz technologischer Fortschritte wird das Wachstum der Branche weiterhin durch strukturelle Probleme gebremst. Zu den größten Hindernissen zählen laut Fellhauer vor allem die unzureichende Netzinfrastruktur, die hohe Kapitalintensität sowie fragmentierte Märkte. Hochqualifizierte Arbeitskräfte in den Bereichen Energie, Elektronik und Software sind rar, wodurch die Entwicklung und Umsetzung neuer Technologien verlangsamt wird. Gleichzeitig behindert der schleppende Ausbau der Strom- und Wärmenetze eine schnelle Skalierung innovativer Lösungen. Daniel Fellhauer erklärt: „Hinzu kommt, dass viele GreenTech-Unternehmen aufgrund langer Entwicklungszeiten und hoher Anfangsinvestitionen auf beträchtliches Kapital angewiesen sind. Schließlich sorgen unterschiedliche Förderprogramme und komplexe regulatorische Vorgaben dafür, dass Innovationen und Markteintritte ausgebremst werden. Diese Faktoren erschweren nicht nur das Wachstum bereits bestehender Firmen, sondern machen auch den Einstieg für neue Gründerinnen und Gründer deutlich schwieriger.“

Zweite Generation der Nachhaltigkeit für mehr wirtschaftliche Tragfähigkeit

„Nur wer wirtschaftlich denkt, kann nachhaltig handeln“, sagt Daniel Fellhauer. Für ihn ist klar: Die nächste Phase der GreenTech-Bewegung entscheidet sich nicht an Visionen, sondern an Umsetzungsdisziplin. „Wir haben die Ideen, die Technologien und den gesellschaftlichen Rückhalt – jetzt geht es um Strukturen, Prozesse und betriebswirtschaftliche Fitness.“ Er spricht damit vor allem zu Gründerinnen und Gründern, die gerade überlegen, in den Markt einzusteigen. „Ich sehe viele junge Teams, die voller Energie starten – aber ohne belastbares Geschäftsmodell. Das ist gefährlich, weil GreenTech kapitalintensiv ist und die Anlaufphase oft Jahre dauert. Wer heute gründet, braucht einen klaren Plan für Cashflow, Partnerschaften und Skalierung, nicht nur für Storytelling.“

Fellhauer plädiert für eine zweite Generation der Nachhaltigkeit: weniger Ideologie, mehr Industriekompetenz. „Wir müssen wieder lernen, wie man produziert, automatisiert und skaliert, nicht nur, wie man pitcht. Nachhaltigkeit ist kein Marketingbegriff, sondern eine Frage des industriellen Könnens.“ Er empfiehlt, früh Kooperationen mit etablierten Mittelständlern oder Industriebetrieben zu suchen, um Skaleneffekte und Erfahrung zu nutzen. Statt auf Subventionen zu bauen, rät er zu robusten Wertschöpfungsmodellen, die auch ohne politische Förderung bestehen können. „Die besten Green-Tech-Firmen der nächsten Jahre werden die sein, die unabhängig funktionieren – weil sie echte Marktprobleme lösen, nicht weil sie im Förderdschungel überleben.“

Politik und Wirtschaft in gemeinsamer Verantwortung

Damit Nachhaltigkeit tatsächlich zum tragfähigen Standbein der deutschen Wirtschaft wird, braucht es planbare Rahmenbedingungen – aber auch Eigeninitiative. Fellhauer betont, dass Gründerinnen und Gründer nicht auf die perfekte Politik warten dürfen. „Wir brauchen beides: verlässliche Energie- und Förderpolitik und unternehmerischen Pragmatismus.“ Politik müsse langfristige Investitionen ermöglichen, den Kapitalzugang vereinfachen und Fachkräfte mobilisieren. Fellhauer nennt staatlich unterstützte Risikokapitalfonds und europäische GreenTech-Programme als zentrale Hebel, damit Innovationen nicht im Frühstadium scheitern. Zugleich müsse Deutschland die Infrastruktur modernisieren: Netze, Standards, Digitalisierung. „Solange ein Windpark genehmigt, aber nicht ans Netz angeschlossen werden kann, bleibt das alles Theorie“, warnt er. Sein Fazit fällt entsprechend klar aus: „GreenTech wird die neue industrielle Basis – wenn wir sie als solche behandeln. Gründer müssen rechnen, Politiker müssen liefern, und die Gesellschaft muss akzeptieren, dass Nachhaltigkeit ein Geschäftsmodell braucht, keinen Idealismuspreis.“

Daniel Fellhauer hat mehrere Unternehmen im Bereich Solar, Wärmepumpen und erneuerbare Energien erfolgreich aufgebaut. Heute ist er Chief Transformation Officer bei Thermondo und eingesetzter CEO seiner ursprünglich gegründeten Firma FEBESOL.

Die Top 10 Grafikdesigntrends 2026

Grafikdesign setzt Impulse, um dein Branding aufzufrischen, deine Marke gekonnt zu inszenieren oder deine Zielgruppe persönlich und emotional anzusprechen. Daher gut zu wissen: Diese zehn Grafikdesigntrends werden von den Profis aktuell favorisiert.

2026 wird das Jahr, in dem Grafikdesign Menschlichkeit betont. Während KI im Alltag eine immer größere Rolle spielt, wächst die Sehnsucht nach Echtheit – nach Entwürfen, die berühren. Zu diesem Schluss kommt das Expert*innen-Team von VistaPrint auf Basis der umfassenden Beobachtungen seiner internationalen Freelancer-Community auf 99designs by Vista.

Die zentrale Erkenntnis: Grafikdesign wird wieder deutlich persönlicher. Es zeichnet sich ab, dass sich die Trends weg vom Glatten, hin zum Echten entwickeln. Marken wollen bei ihren Zielgruppen Gefühle wecken und setzen deshalb auf Geschichten statt Marketingbotschaften. So wird Design zur Bühne für Individualität und damit zum wirksamsten Werkzeug, um echte Verbindungen aufzubauen.

„Kleine Unternehmen haben den entscheidenden Vorteil, mutig, eigenwillig und authentisch auftreten zu können – großen Marken fällt das oft schwer,“ weiß Patrick Llewellyn, VP of Digital and Design Services bei VistaPrint. „In unserer laut und unpersönlich gewordenen Welt wirken unperfekte Designs ehrlich. Genau das macht sie so kraftvoll.“

Die Designtrends 2026 holen das Handgemachte ins Digitale, erzählen von kultureller Identität, feiern Unvollkommenheit und lassen Gefühle sichtbar werden. Nicht der Algorithmus, sondern der Mensch steht im Mittelpunkt.

Die Designtrends 2026 im Überblick:

Elemental Folk

Tradition trifft moderne Gestaltung: Inspiriert von regionaler Handwerkskunst und kulturellem Erbe, entstehen warme, ausdrucksstarke Designs mit floralen Mustern, ornamentalen Details und kräftigen Farben. Die Gestaltung wirkt vertraut und zeitgemäß zugleich. Elemental Folk ist ein visueller Rückgriff auf das Ursprüngliche, der die Identität und Herkunft feiert.

Hyper-Individualism

Dieser Trend bringt frischen Wind ins Design. Er setzt auf surreale Bildwelten, spielt mit verzerrten Formen und bricht ganz bewusst mit Konventionen. Die Darstellungen wirken mal verspielt, mal provokant, aber immer individuell. Während viele ihre Gestaltungsprozesse komplett von der künstlichen Intelligenz erledigen lassen, begeistert dieser Stil mit der kreativen Handschrift der Menschen.

Tactile Craft

Stickerei, Stoffstrukturen und handgemachte Details finden ihren Weg zurück ins digitale Design. Was dabei entsteht, fühlt sich fast schon greifbar an: Die visuellen Oberflächen erzeugen eine besondere Tiefe, die den BetrachterInnen Wärme spendet. Zwischen DIY-Charme und nostalgischer Anmutung generiert dieser Trend – als Gegenentwurf zur glatten, oft distanzierten Ästhetik der digitalen Welt – eine emotionale Nähe.

Distorted Cut

Wenn Gestaltung zum Widerstand wird, entstehen visuelle Statements mit Ecken und Kanten. Klassische Collage-Techniken werden neu interpretiert, indem Bilder zerschnitten, Schichten überlagert und Formen fragmentiert werden. Das Ergebnis wirkt roh, rebellisch und voller Energie. Fest steht: Dieser Designstil will nicht gefallen – es geht darum, Haltung zu zeigen.

Candid Camera Roll

Kreative bringen mit diesem Trend das Echte zurück ins Visuelle. Unperfekte Schnappschüsse, Filmkorn, Blitzlicht und spontane Momente wirken persönlich und nahbar. Im Zusammenspiel mit reduzierter Typografie entstehen Designs, die mit ihrer Ehrlichkeit wirken und berühren.

Hyper-Bloom

Manchmal braucht es einen visuellen Rückzugsort – einen Ort zum Durchatmen. Sanfte Verläufe, zarte Blumenmotive und pudrige Pastelltöne entführen in eine Welt zwischen Traum und Realität. Der Stil wirkt wie ein Gegenpol zum hektischen Alltag und öffnet Raum für Leichtigkeit, Optimismus und ein bisschen Tagträumerei.

Digit-Cute

Die Ästhetik bewegt sich zwischen Nostalgie und digitaler Verspieltheit und sorgt vom ersten Moment an für richtig gute Laune. Klare Strukturen treffen auf bunte Pixelgrafiken, niedliche Figuren und kräftige Farben. Der Look versprüht den Charme der frühen Computerspiele und Popkultur. Gerade weil er so verspielt wirkt, ist er gestalterisch besonders raffiniert.

Micro-Industrial

Was früher rein funktional war, wird jetzt zum Gestaltungskonzept. Inspiriert von Verpackungen, technischen Etiketten und Informationsgrafiken bildet sich ein Designstil, der Klarheit feiert. Der gezielte Einsatz von Elementen wie Barcodes, QR-Codes und Rasterstrukturen verleiht den Entwürfen eine rohe, sachliche und zugleich moderne Ästhetik.

Neon Noir

Dunkel, intensiv und voller Spannung – der Stil erinnert an Szenen aus einem Neo-Noir-Film. Knallige Farben, wie elektrisches Rot, treffen auf tiefes Schwarz, kombiniert mit Bewegungsunschärfen und rauen Texturen. Der urbane, energiegeladene Look fällt sofort ins Auge und bleibt lange im Kopf.

Frutiger Aero Revival