Aktuelle Events

Geschäftsideen Garten: Pflanzensets aus dem Internet

Pflanzensets online bestellen

Das Start-up "etagen-erika" liefert seit der letzten Saison nach Onlinebestellung regionale Pflanzensets für Balkone und Terrassen zum Selbstgärtnern aus. Eine grüne Geschäftsidee.

Die Kunden können aus einem Sortiment an saisonalen Pflanzen, Kräutern und Gemüsesorten wählen bzw. sich beraten lassen und anschließend online bestellen. Die Bestellung wird samt Pflanzgefäß, Bio-Blumenerde, Gärtnerhandschuhen sowie "Gärtnerrezept" (Pflanz- und Pflegeanleitung) nach Hause geliefert.

Nachdem es mit dieser Geschäftsidee in Berlin losging, werden mittlerweile Kunden in ganz Deutschland direkt beliefert. Etagen-Erika arbeitet dabei bevorzugt mit regionalen Gärtnereien vor Ort zusammen. Somit erhalten die Gärtnereien dank dieser Geschäftsidee Anschluss ans Onlinegeschäft, ohne selbst aktiv werden zu müssen.

Diese Artikel könnten Sie auch interessieren:

KI-Hype: mittel- bis langfristiger Weg zur Monetarisierung noch unklar

Aktueller Marktkommentar zum KI-Hype und den möglichen Folgen von Justin Thomson, Head Investment Institute and CIO bei T. Rowe Price.

Die Investitionsausgaben für künstliche Intelligenz (KI) haben ein erstaunliches Niveau erreicht, aber der Weg zur Monetarisierung bleibt unklar. Der Markt-Hype schaukelt sich selbst hoch, und die Tech-Giganten greifen nun zu Krediten, um ihre Expansion zu finanzieren. Blasen sind nicht immer schädlich und können zu erheblichen Produktivitätssteigerungen führen, aber Überkapazitäten sind ein reales Risiko, das beobachtet werden sollte.

Während eines hochkarätigen Finanzgipfels, an dem ich kürzlich in Hongkong teilgenommen habe, sagte der CEO einer führenden Vermögensverwaltungsgesellschaft, der es eigentlich besser wissen müsste: „Im Kontext der Ausstattung von Hyperscalern sind 2,5 Billionen US-Dollar [für Investitionen] über fünf Jahre keine große Summe.“ Ich war über diese Bemerkung erstaunt. In welchem Paralleluniversum sind 2,5 Billionen US-Dollar eine unbedeutende Summe? Antwort: in einem, in dem Nvidia innerhalb von drei Monaten eine Marktkapitalisierung von 1 Billion US-Dollar erreichen kann. Aber wie erzielt man eine Rendite auf Investitionen in Höhe von 2,5 Billionen US-Dollar, wenn der mittel- bis langfristige Weg zur Monetarisierung der KI noch unklar ist?

Dies deutet auf zwei verschiedene AI-Investitionsbooms hin: einen relativ kurzfristigen, der durch eine erkennbare tatsächliche Nachfrage gestützt wird, und einen längerfristigen spekulativen Boom, der mit einem quasi-religiösen Glauben an exponentielles Wachstum verbunden ist.

Betrachten wir zunächst einige beeindruckende Zahlen. Die Ausgaben für KI erreichten gerade 1 % des US-Bruttoinlandsprodukts (BIP) in einer Wirtschaft mit 1,8 % Wachstum – das ist mehr als die Hälfte der gesamten neuen Nachfrage. Allein Nividia erreichte Ende Oktober einen Wert von 5 Billionen US-Dollar, was 15 % der gesamten US-Wirtschaft entspricht. Zum Vergleich: Als Cisco im Jahr 2000 als weltweit größtes Unternehmen seinen Höhepunkt erreichte, betrug sein Anteil am BIP nur 5,5 %. Während viel Aufsehen um den 3 Milliarden US-Dollar teuren Hauptsitz von JP Morgan in Manhattan gemacht wurde, werden in Texas still und leise 40 Milliarden US-Dollar teure Rechenzentrumsprojekte gestartet. Niemand scheint sich dafür zu interessieren.

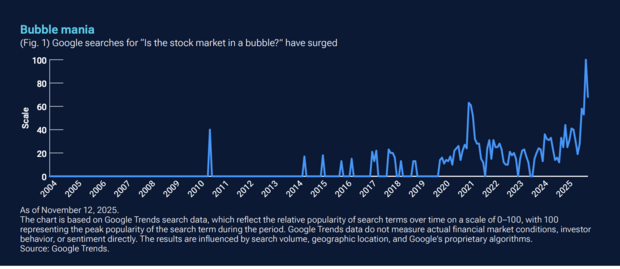

Sind wir also in einer Blase? Es gibt sicherlich eine Blase von Menschen, die über Blasen sprechen – werfen Sie einfach einen Blick auf Google Trends.

Unterdessen gibt es diejenigen, die glauben, dass wir uns gerade deshalb nicht in einer Blase befinden können, weil wir über eine solche sprechen. Meiner Meinung nach gibt es drei Schlüsselwörter in den jüngsten Marktentwicklungen, die Beachtung verdienen: Reflexivität, Zirkularität und Verschuldung. Reflexivität besagt, dass Preise tatsächlich die Fundamentaldaten beeinflussen und dass diese neu beeinflussten Fundamentaldaten dann die Erwartungen verändern und somit die Preise beeinflussen. Dieser Prozess setzt sich in einem sich selbst verstärkenden Muster fort. Die lebhafte Reaktion des Marktes auf die jüngsten KI-Megadeals ist ein Beispiel für einen solchen Feedback-Kreislauf. Hinzu kommt der zirkuläre Charakter dieser Deals. Im Wesentlichen investieren die Anbieter von Recheninfrastruktur in native KI-Akteure, die sich in einer Investitionsphase befinden. In der Dotcom-Ära war dies als „Vendor Financing” bekannt und wurde zu einer Art Schimpfwort.

Schließlich gibt es noch die Verschuldung. Bislang haben die finanzstarken Tech-Giganten diesen KI-Boom mit ihren eigenen tiefen Taschen und Eigenkapitalfinanzierungen finanziert. Aber jetzt treten wir in die Kreditphase ein – Unternehmen wenden sich den Schuldenmärkten zu, oft außerhalb der Bilanz, und die Kreditaufnahme wird sich wahrscheinlich beschleunigen. Wir wissen, dass wir mit generativer KI und später mit künstlicher Superintelligenz vor einem neuen technologischen Paradigma stehen – und möglicherweise vor einem massiven Produktivitätssprung. Das sind alles großartige Dinge, und es ist leicht zu verstehen, dass man der Versuchung erliegt, weiter auf der lukrativen KI-Welle zu reiten, die mit der Einführung von ChatGPT im November 2022 begann. Angesichts der aktuellen Indexkonzentration würde es in der Tat Mut erfordern, auszusteigen.

Schnelles Wachstum kann zu einem Überschuss führen

Eine wichtige Lehre aus der Geschichte ist, dass es zu Blasen kommt, wenn wir schöne Dinge erfinden. Aber nicht alle Blasen sind gleich. Es gibt „schlechte“ Blasen (Tulpen, Gold, Grundstücke), und wenn schlechte Blasen durch Schulden finanziert werden, kann dies ein systemisches Risiko für die Wirtschaft darstellen. Es gibt auch „gute“ Blasen, die zu Überkapazitäten bei Produktionsmitteln führen – man denke an die Eisenbahnen im goldenen Zeitalter der Expansion der USA zwischen 1870 und 1900, die Elektrizität in den frühen 1900er Jahren und den Dotcom-Boom Ende der 1990er Jahre. Letztendlich wurde in jedem Fall Wohlstand geschaffen, aber die frühen Investoren verloren viel Geld.

Es ist noch zu früh, um vorherzusagen, zu welcher Art von Blase sich der AI-Investitionsboom entwickeln wird. Die langfristigen Auswirkungen werden davon abhängen, ob die heutigen massiven Investitionen letztendlich die Grundlage für dauerhafte Produktivitätssteigerungen schaffen oder ob sie zu Überkapazitäten führen, die keine nachhaltigen Renditen erzielen. Wenn die Kapazitäten so schnell wachsen, ist es immer wahrscheinlich, dass sich das Ungleichgewicht zwischen Angebot und Nachfrage von einem Mangel zu einem Überschuss umkehrt. In der Dotcom-Ära verloren Investoren viel Geld mit Glasfaserkabeln und Switches, die in den Boden verlegt wurden, und etwas Ähnliches könnte mit KI passieren, wenn durch Überbauung riesige Kapitalmengen in Anlagen gebunden werden, die möglicherweise nicht annähernd mit voller Effizienz betrieben werden können – oder noch schlimmer, wenn die Schnelllebigkeit des Chip-Zyklus die Rechenleistung obsolet macht.

Erschwerend kommt hinzu, dass die Anreize für Infrastrukturanbieter („Picks and Shovels”-Akteure) und Entwickler von KI-Anwendungen nicht aufeinander abgestimmt sind. Während Infrastrukturunternehmen von einer kontinuierlichen Expansion und Investitionen profitieren, konzentrieren sich Anwendungsentwickler auf die Verbesserung der Effizienz und die Senkung der Kosten. Um den Kommentar des Dodos nach dem Caucus-Rennen in Lewis Carrolls Alice im Wunderland umzukehren: „Nicht jeder kann gewinnen, und nicht jeder kann einen Preis bekommen.” Die optimistischen Prognosen für die KI-Infrastruktur zeigen, wie viel Hype in den heutigen Bewertungen der Hyperscaler steckt. Es ist ironisch, dass Rechenzentrumsprojekte nach den griechischen Titanen Prometheus und Hyperion benannt werden. In der griechischen Mythologie folgt auf Hybris immer Nemesis. Um noch ein bisschen Latein mit einzubringen: caveat emptor.

KI & Bewertungen: Sichtbarkeit in einer neuen Suchrealität

Tipps und To-dos: Wie du dein Bewertungsmanagement strategisch aufsetzt und Sichtbarkeit und Vertrauen im KI-Zeitalter steigerst.

Generative Antworten in Suchmaschinen und Assistenten verändern die Spielregeln der Online-Sichtbarkeit. Nicht mehr nur klassische Rankings entscheiden, sondern die Frage, wem die KI genug vertraut, um es überhaupt zu nennen. Aktuelle, glaubwürdige und inhaltlich konkrete Bewertungen werden dabei zum Schlüsselsignal. Für kleine und mittlere Unternehmen bedeutet das: Bewertungsmanagement ist kein Nice-to-have mehr, sondern ein Pflichtprogramm, das Auffindbarkeit, Auswahl und Conversion spürbar beeinflusst. Im Folgenden erfährst du, wie du dein Bewertungsmanagement strategisch aufsetzen solltest, um Sichtbarkeit und Vertrauen im KI-Zeitalter zu steigern.

Warum Bewertungen jetzt geschäftskritisch sind

KI-Modelle zerlegen Rezensionen in viele kleine Bedeutungseinheiten und ziehen daraus ein konsistentes Bild. Welche Leistung wurde erbracht, an welchem Ort, mit welcher Qualität und für welchen Anlass. Aus den einzelnen Stimmen entsteht so ein Vertrauensprofil, das über bloße Sternesummen hinausgeht. Entscheidend ist nicht die bloße Menge, sondern die Frische und die inhaltliche Dichte der Aussagen. Eine Rezension wie „Schnell geholfen am Sonntag, sehr kompetente Beratung zu Reiseimpfungen“ liefert gleich mehrere Signale. Zeitliche Verfügbarkeit, thematische Expertise und konkreter Nutzen. Genau solche Details erhöhen die Wahrscheinlichkeit, in generativen Antworten aufzutauchen, wenn Menschen in ihrer Nähe nach einer Lösung suchen. Wer regelmäßig neue, authentische und präzise Bewertungen erhält, verschafft der KI verlässliche Hinweise und sichert sich dadurch mehr Sichtbarkeit in genau den Momenten, in denen Entscheidungen vorbereitet werden.

Bewertungsmanagement als Prozess, nicht als Aktion

Wirksam wird Bewertungsarbeit, wenn sie selbstverständlich Teil der täglichen Abläufe ist. Nach dem Kontakt freundlich um Feedback bitten, den Weg zur passenden Plattform so kurz wie möglich machen, interne Zuständigkeiten klar regeln und Reaktionszeiten verbindlich festlegen. Aus diesen scheinbar kleinen Schritten entsteht ein stabiler Rhythmus, der kontinuierlich neue Kund*innenstimmen hervorbringt und der KI immer wieder frische Kontexte liefert. Ein solcher Prozess ist robuster als jede einmalige Kampagne, weil er verlässlich Vertrauen aufbaut und saisonale Schwankungen abfedert. Teams profitieren, wenn sie Zielkorridore definieren, etwa eine bestimmte Zahl neuer Rezensionen pro Woche und wenn sie Fortschritte sichtbar machen. So wird aus gutem Vorsatz ein gelebter Ablauf, der die gesamte Organisation stärkt.

Sprache der Kund*innen wirkt wie natürliches SEO

KI versteht Alltagssprache deutlich besser als Listen isolierter Schlagwörter. Unternehmen gewinnen, wenn sie um freie, aber konkrete Formulierungen bitten, ohne Vorgabetexte und ohne Druck. Eine höfliche Bitte wie: „Wenn es für Sie passt, nennen Sie gern, was Ihnen besonders geholfen hat“ öffnet den Raum für präzise Hinweise auf Leistungen, Erreichbarkeit, Barrierefreiheit oder Schnelligkeit. Solche natürlich entstandenen Details sind für Menschen überzeugend und zugleich für Maschinen gut interpretierbar. Sie zeigen, wofür ein Betrieb tatsächlich steht, und verankern die passenden Begriffe in einem echten Nutzungskontext. Das Ergebnis ist eine Sprache, die Vertrauen schafft und die Auffindbarkeit stärkt, ohne künstlich zu wirken.

Antworten trainieren Vertrauen für Menschen und Maschinen

Jede Reaktion auf eine Bewertung ist ein sichtbares Zeichen von Serviceorientierung und zugleich zusätzlicher Kontext für die KI. Gute Antworten bedanken sich aufrichtig, beziehen sich konkret auf das Erlebte und bieten einen klaren nächsten Schritt an. Bei Kritik zählt ein professioneller Umgang. Das Anliegen nachvollziehen, Verantwortung übernehmen, eine realistische Lösung anbieten und einen direkten Kontaktweg nennen. So entsteht ein Bild von Verlässlichkeit, das Hemmschwellen senkt und Wiederbesuche wahrscheinlicher macht. Die KI erkennt diesen Umgang ebenso und ordnet das Unternehmen eher als vertrauenswürdig ein. Mit der Zeit entsteht ein stabiler Kreislauf aus guter Erfahrung, konstruktiver Reaktion und wachsendem Vertrauen.

Lokaler Content und Social Proof gehören zusammen

Bewertungen entfalten ihre volle Wirkung, wenn sie auf eine solide Informationsbasis treffen. Konsistente Unternehmensdaten, vollständige Leistungsseiten pro Standort, klare Öffnungszeiten inklusive Ausnahmen und eine schnelle, mobil optimierte Webseite erleichtern die Einordnung für Nutzer*innen und Maschine. Wenn ausgewählte Zitate oder Bewertungsschnipsel an relevanten Stellen sichtbar werden, etwa auf der Startseite, in der Buchungsstrecke oder in den häufigen Fragen, entsteht ein schlüssiges Gesamtbild. Der lokale Bezug bleibt klar erkennbar, die Erwartungen sind gut gesetzt, und die nächsten Schritte sind ohne Umwege möglich. So wird aus Social Proof ein handfester Conversion Hebel.

Vom Feedback zur Verbesserungsschleife

Rezensionen sind fortlaufende Marktforschung aus erster Hand. Wer wiederkehrende Themen auswertet, etwa Wartezeiten, Erreichbarkeit oder Bezahloptionen, erkennt schnell die Stellschrauben mit der größten Wirkung. Wichtig ist, die daraus abgeleiteten Verbesserungen konsequent umzusetzen und sichtbar zu machen. Informieren, handeln, erneut um Rückmeldung bitten. Dieser offene Kreislauf wirkt nach innen und nach außen. Mitarbeitende erleben, dass Feedback Veränderungen anstößt, Kund*innen erleben, dass ihre Hinweise ernst genommen werden, und die KI registriert die fortlaufende Pflege der Qualität. Mit jeder Runde werden Erlebnisse besser und Bewertungen stärker, was die Sichtbarkeit weiter erhöht.

Fazit

Sichtbarkeit entsteht heute dort, wo Menschen nach konkreten Lösungen fragen und wo KIs verlässliche Hinweise zu Qualität und Relevanz finden. Unternehmen, die Bewertungen als strategischen, kontinuierlichen Prozess verstehen, erhöhen ihre Chance, in generativen Antworten genannt zu werden und gewinnen genau in den entscheidenden Momenten an Präsenz. Vieles davon ist eine Frage kluger Organisation und klarer Abläufe. Der finanzielle Aufwand bleibt überschaubar, der Nutzen für Auffindbarkeit, Vertrauen und Umsatz ist deutlich spürbar.

Die Autorin Franziska Ortner ist Produktmanagerin bei SELLWERK

GreenTech – der Boom geht zu Ende

Zwar zählt Deutschland rund 3000 Start-ups aus dem GreenTech-Bereich, doch viele kämpfen mit Kapitalmangel, Fachkräftedefizit und einer überlasteten Infrastruktur. Der Boom ist vorbei – eine Einschätzung von Seriengründer und Transformationsexperte Daniel Fellhauer.

Die deutsche Wirtschaft steht vor einer ihrer größten Transformationen seit der Industrialisierung. Jahrzehntelang galten Auto- und Stahlindustrie als Rückgrat des Wohlstands. Nun rückt Nachhaltigkeit in den Mittelpunkt. Daniel Fellhauer sieht die GreenTech-Branche an einem kritischen Punkt: „GreenTech ist kein Hype, sondern Realität mit echten Herausforderungen. Die Frage ist: Wer bleibt übrig, wenn die Subventionen verschwinden?“ Seine Aussage bringt auf den Punkt, was viele Brancheninsider beschäftigt: der Übergang von gefördertem Wachstum zu marktwirtschaftlicher Reife. Jetzt entscheidet sich, welche Unternehmen Innovation und Wirtschaftlichkeit in Einklang bringen können – und wer an überzogenen Erwartungen scheitert.

Der Boom geht zu Ende

„Der Anteil grüner Gründungen ist zuletzt deutlich gesunken“, sagt Daniel Fellhauer. „Vor zwei Jahren war noch jedes dritte neue Start-up nachhaltig ausgerichtet. Heute ist es nicht einmal mehr jedes Vierte. Das ist ein deutliches Warnsignal. Der Markt sortiert sich, Kapital wird selektiver, und viele Ideen schaffen es nicht mehr über die Pilotphase hinaus.“ In den vergangenen fünf Jahren flossen zwar rund 11,7 Milliarden Euro in grüne Start-ups – etwa ein Viertel aller deutschen Risikoinvestitionen –, doch das Geld konzentriert sich zunehmend auf wenige, große Player. „Das zeigt eine Reifung, aber auch eine gefährliche Schieflage“, so Fellhauer. „Wir brauchen Breite, nicht nur Leuchttürme. Wenn die Finanzierungsströme versiegen, bevor Skalierung einsetzt, kippt der ganze Innovationspfad.“ Hinzu kommen steigende Zinsen, langwierige Genehmigungen und überlastete Netze. „Viele unterschätzen, wie stark Infrastruktur über Wachstum entscheidet“, erklärt er. „Eine Solarfirma kann heute Aufträge für 1.000 Anlagen im Jahr haben. Aber wenn der Netzanschluss neun Monate dauert, bleibt sie auf halber Strecke stehen.“

Deutschland ist längst auf dem Weg zur nachhaltigen Wirtschaft – doch der Anstieg wird steiler. Die entscheidende Frage lautet: Wird GreenTech zum Fundament der nächsten industriellen Ära, oder zur vertanen Chance einer Generation? Laut einer aktuellen Analyse fließt ein erheblicher Teil staatlicher Investitionen und Subventionen in Deutschland weiterhin in fossile Strukturen – über 60 Milliarden Euro jährlich. Da-bei hatte sich die Bundesregierung bereits 2009 gemeinsam mit anderen Industrieländern verpflichtet, ineffiziente Förderungen für fossile Energieträger bis 2025 zu beenden. Ein Ziel, das laut Fachleuten von Fraunhofer ISI, ZEW und Umweltbundesamt klar verfehlt wird. Daniel Fellhauer warnt: „Das ist kein ideologisches, sondern ein ökonomisches Problem. Solange Kapital und Fördermittel in alte Industrien gelenkt werden, anstatt in skalierbare GreenTech-Lösungen, bleibt Deutschland in der Vergangenheit verhaftet.“

Herausforderungen im deutschen GreenTech-Sektor

Trotz technologischer Fortschritte wird das Wachstum der Branche weiterhin durch strukturelle Probleme gebremst. Zu den größten Hindernissen zählen laut Fellhauer vor allem die unzureichende Netzinfrastruktur, die hohe Kapitalintensität sowie fragmentierte Märkte. Hochqualifizierte Arbeitskräfte in den Bereichen Energie, Elektronik und Software sind rar, wodurch die Entwicklung und Umsetzung neuer Technologien verlangsamt wird. Gleichzeitig behindert der schleppende Ausbau der Strom- und Wärmenetze eine schnelle Skalierung innovativer Lösungen. Daniel Fellhauer erklärt: „Hinzu kommt, dass viele GreenTech-Unternehmen aufgrund langer Entwicklungszeiten und hoher Anfangsinvestitionen auf beträchtliches Kapital angewiesen sind. Schließlich sorgen unterschiedliche Förderprogramme und komplexe regulatorische Vorgaben dafür, dass Innovationen und Markteintritte ausgebremst werden. Diese Faktoren erschweren nicht nur das Wachstum bereits bestehender Firmen, sondern machen auch den Einstieg für neue Gründerinnen und Gründer deutlich schwieriger.“

Zweite Generation der Nachhaltigkeit für mehr wirtschaftliche Tragfähigkeit

„Nur wer wirtschaftlich denkt, kann nachhaltig handeln“, sagt Daniel Fellhauer. Für ihn ist klar: Die nächste Phase der GreenTech-Bewegung entscheidet sich nicht an Visionen, sondern an Umsetzungsdisziplin. „Wir haben die Ideen, die Technologien und den gesellschaftlichen Rückhalt – jetzt geht es um Strukturen, Prozesse und betriebswirtschaftliche Fitness.“ Er spricht damit vor allem zu Gründerinnen und Gründern, die gerade überlegen, in den Markt einzusteigen. „Ich sehe viele junge Teams, die voller Energie starten – aber ohne belastbares Geschäftsmodell. Das ist gefährlich, weil GreenTech kapitalintensiv ist und die Anlaufphase oft Jahre dauert. Wer heute gründet, braucht einen klaren Plan für Cashflow, Partnerschaften und Skalierung, nicht nur für Storytelling.“

Fellhauer plädiert für eine zweite Generation der Nachhaltigkeit: weniger Ideologie, mehr Industriekompetenz. „Wir müssen wieder lernen, wie man produziert, automatisiert und skaliert, nicht nur, wie man pitcht. Nachhaltigkeit ist kein Marketingbegriff, sondern eine Frage des industriellen Könnens.“ Er empfiehlt, früh Kooperationen mit etablierten Mittelständlern oder Industriebetrieben zu suchen, um Skaleneffekte und Erfahrung zu nutzen. Statt auf Subventionen zu bauen, rät er zu robusten Wertschöpfungsmodellen, die auch ohne politische Förderung bestehen können. „Die besten Green-Tech-Firmen der nächsten Jahre werden die sein, die unabhängig funktionieren – weil sie echte Marktprobleme lösen, nicht weil sie im Förderdschungel überleben.“

Politik und Wirtschaft in gemeinsamer Verantwortung

Damit Nachhaltigkeit tatsächlich zum tragfähigen Standbein der deutschen Wirtschaft wird, braucht es planbare Rahmenbedingungen – aber auch Eigeninitiative. Fellhauer betont, dass Gründerinnen und Gründer nicht auf die perfekte Politik warten dürfen. „Wir brauchen beides: verlässliche Energie- und Förderpolitik und unternehmerischen Pragmatismus.“ Politik müsse langfristige Investitionen ermöglichen, den Kapitalzugang vereinfachen und Fachkräfte mobilisieren. Fellhauer nennt staatlich unterstützte Risikokapitalfonds und europäische GreenTech-Programme als zentrale Hebel, damit Innovationen nicht im Frühstadium scheitern. Zugleich müsse Deutschland die Infrastruktur modernisieren: Netze, Standards, Digitalisierung. „Solange ein Windpark genehmigt, aber nicht ans Netz angeschlossen werden kann, bleibt das alles Theorie“, warnt er. Sein Fazit fällt entsprechend klar aus: „GreenTech wird die neue industrielle Basis – wenn wir sie als solche behandeln. Gründer müssen rechnen, Politiker müssen liefern, und die Gesellschaft muss akzeptieren, dass Nachhaltigkeit ein Geschäftsmodell braucht, keinen Idealismuspreis.“

Daniel Fellhauer hat mehrere Unternehmen im Bereich Solar, Wärmepumpen und erneuerbare Energien erfolgreich aufgebaut. Heute ist er Chief Transformation Officer bei Thermondo und eingesetzter CEO seiner ursprünglich gegründeten Firma FEBESOL.

Happy Homeoffice Club gestartet

Gründerin Caterina Hirt startet ein digitales Netzwerk als kollaborative Kommunikationsplattform für selbständige Mütter im Homeoffice.

Mit dem Start des Happy Homeoffice Clubs entsteht ein neues digitales Angebot für selbständige Mütter – mit Liveformaten, Co-Working, einer innovativen Softwareplattform und vielen nützlichen Business-Hacks. Die Gründerin Caterina Hirt bringt damit ein strukturiertes, unterstützendes Netzwerk an den Start, das den oft isolierten Homeoffice-Alltag in einen Ort der Verbindung, Motivation und echten Weiterentwicklung verwandelt. „Ich habe selbst erlebt, wie herausfordernd es ist, Beruf, Familie und Selbstverwirklichung unter einen Hut zu bringen – vor allem im Homeoffice. Mit dem Happy Homeoffice Club möchte ich Frauen zeigen, dass sie nicht alleine sind“, so die Gründerin. Caterina Hirt ist Unternehmerin, Autorin, systemische Coachin und Mutter von zwei Kindern. Mit ihrem Agenturbackground und über zehn Jahren Erfahrung im Homeoffice weiß die Marketingspezialistin aus erster Hand, welche Chancen – aber auch welche Herausforderungen – dieser Arbeitsalltag birgt.

Kern der Zusammenarbeit ist eine kollaborative Kommunikationsplattform, über die die Mütter dauerhaft in einem echten Netzwerk verbunden sind. Dazu setzt das Angebot auf Livecalls, Community-Austausch, Expertenvorträge und snackable Businesstipps, die den Workflow im Homeoffice effizienter machen. Das Angebot richtet sich explizit an selbständige Frauen oder Mütter im Homeoffice. „Bei uns fühlt sich keine Teilnehmerin mehr allein. Hier treffen sich Frauen, die genau wissen, wie es ist, mit Laptop, Kaffee, Kind und manchmal ein bisschen Chaos zu jonglieren. Sie arbeiten, lachen, tauschen sich aus und motivieren sich gegenseitig. So modern, vernetzt und unterstützend, wie man es sich als Selbstständige immer gewünscht hat “, sagt Caterina Hirt.

Die zugrundeliegende Softwarelösung bietet eine hochmoderne Nutzeroberfläche, Chats, Calls in einer geschützten Umgebung sowie Daten- und Wissensaustausch an. So gibt es zum Beispiel den Monday Motivation Call mit allen Teilnehmerinnen oder eine interaktive Kaffeeküche, in der man sich einfach mal über alle Themen abseits des Business interaktiv austauschen kann. Die Plattform wird jeder Teilnehmerin zur Verfügung gestellt, die Nutzung ist in der monatlichen Mitgliedsgebühr von 49 Euro (Einführungspreis) enthalten. Interessentinnen können die Community inklusive aller Angebote zwei Wochen kostenlos testen.

KI und Selbstreflexion: Was macht KI mit dir?

Wie du innovative KI-Technologie und persönliche Entwicklung strategisch geschickt kombinierst, um dein Start-up nachhaltig zu skalieren.

Künstliche Intelligenz (KI) gilt als Wachstumsbooster. Doch wer dabei nur auf Technik setzt, lässt ein entscheidendes Potenzial ungenutzt – die eigene persönliche Entwicklung. Warum es gerade die Verbindung aus KI und Selbstreflexion ist, die Gründer*innen und Start-ups langfristig erfolgreich macht, liest du hier.

Gründen bedeutet, Entscheidungen unter Unsicherheit zu treffen

Wer ein Start-up aufbaut, bewegt sich im Spannungsfeld von Vision und Verantwortung. Geschäftsmodell, Finanzierung, Teamführung, Produktentwicklung – all das passiert meist parallel und unter enormem Zeitdruck. Technologie wird dabei oft als Hebel gesehen, um schneller und effizienter zu arbeiten. Und das stimmt: Tools, die auf KI basieren, können Prozesse automatisieren, Muster erkennen, Kund*innenbeziehungen vertiefen. Doch Technik allein garantiert keinen Erfolg. Entscheidend ist, wer sie wie einsetzt. Und hier kommt ein oft unterschätzter Faktor ins Spiel: der/die Gründer*in selbst mit den Mustern seiner/ihrer Persönlichkeit.

Jede einzelne Erfahrung, die die Marke rund um eine(n) Gründer*in prägt, kann niemals von einer KI erzeugt werden. Diese kann im zweiten Schritt sachlich analysieren, wie Erlebnisse für zukünftige Prozesse genutzt werden, die dazugehörigen Werte oder Ängste aber stecken in der Person selbst als Fundament.

Markenkern, Werte und Identität – das unsichtbare Fundament des Erfolgs

Jede Marke beginnt mit einer Geschichte, und diese umfasst den Menschen als Dreh- und Angelpunkt. Die Erfahrungen, Werte und Überzeugungen der Gründer*in formen den Kern eines Start-ups weit vor dem ersten Pitchdeck. Während KI dabei helfen kann, diese Identität greifbar zu machen, zu analysieren oder in die Kommunikation zu übersetzen, erzeugen kann sie diese nicht.

Gerade in der frühen Phase entscheidet nicht nur das Produkt über den Erfolg, sondern die Haltung dahinter: Wofür steht das Unternehmen? Welche Werte prägen die Entscheidungen? Welches Bedürfnis treibt den/die Gründer*in auch jenseits der KPIs an? Eine klare Positionierung entsteht nicht im Workshop, sondern im inneren Prozess. Es ist die Fähigkeit zur Selbstreflexion, die hier als Kompass dient:

- Was ist mir wirklich wichtig?

- Was darf sich nie ändern, selbst wenn wir skalieren?

- Was wäre ein Deal, den ich nie eingehen würde – egal wie lukrativ er erscheint?

Wer diesen Markenkern kennt, trifft strategische Entscheidungen konsistenter, kommuniziert authentischer und baut Vertrauen bei Investor*innen, Mitarbeitenden und Kund*innen auf. Und erst dann lohnt sich der Einsatz von KI wirklich, um diese klare Positionierung zum Beispiel zu verstärken, nicht aber zu ersetzen.

KI – mehr als nur Effizienzmaschine

KI hat längst ihren Platz in der Start-up-Welt gefunden. Vom Recruiting über Sales bis hin zum Customer Support. KI-gestützte Tools erleichtern die Arbeit und verschaffen jungen Unternehmen echte Wettbewerbsvorteile:

- Automatisierung: Mithilfe von KI lassen sich zeitintensive Prozesse wie Terminplanung, Rechnungsstellung oder E-Mail-Korrespondenz automatisieren. Das schafft Raum für strategische Aufgaben.

- Personalisierung: Wer seine Kund*innen wirklich verstehen will, profitiert von datenbasierten Insights. KI hilft dabei, Verhalten zu analysieren, Bedürfnisse vorherzusagen und Inhalte gezielt auszuspielen.

- Recruiting: Im „War for Talents“ zählt Geschwindigkeit, ergänzend aber unbedingt auch Qualität. KI-Tools unterstützen dabei, Bewerber*innen effizient zu sichten und unbewusste Bias zu reduzieren.

Richtig eingesetzt, ermöglicht KI mehr Fokus, schnellere Iterationen und datengestützte Entscheidungen. Aber genau hier beginnt auch das Problem: Technologie kann nur das verstärken, was ohnehin vorhanden ist oder eben (noch) nicht.

Selbstreflexion – der unterschätzte Erfolgsfaktor

Gründer*innen stehen täglich vor Entscheidungen mit Tragweite. Doch unter Druck, Unsicherheit und Wachstumsschmerz wird oft reaktiv gehandelt statt reflektiert geführt. Genau hier setzt Selbstreflexion an. Wer sich seiner Stärken, Muster und blinden Flecken bewusst ist, trifft bessere Entscheidungen – für sich, das Team und das Unternehmen. Selbstreflexion ist kein esoterisches Extra, sondern ein pragmatisches Führungsinstrument. Einige wirkungsvolle Methoden:

- Regelmäßige Selbstchecks: Was hat in dieser Woche funktioniert und warum? Was nicht? Was sagt das über meine Prioritäten aus?

- Feedback aktiv einholen: nicht nur von Mitgründer*innen oder Coaches, sondern auch vom Team. Nicht defensiv reagieren, sondern neugierig auf das Feedback sein.

- Mentoring und Coaching: Externe Sparringspartner*innen helfen, Perspektiven zu erweitern und Denkfehler zu entlarven.

- Reflexionstools nutzen: vom (digitalen) Journal bis zur strukturierten Entscheidungsanalyse gibt es einfache Hilfsmittel, die Klarheit schaffen.

Wer bereit ist, sich selbst zu hinterfragen, entwickelt nicht nur sich, sondern auch sein Start-up weiter. Denn Führung beginnt nicht mit der Verantwortung für andere, sondern mit der Verantwortung für sich selbst.

Die Synergie – wenn KI auf Selbstreflexion trifft

Die wirklich erfolgreichen Gründer*innen sind nicht entweder Tech-Expert*innen oder People-Leader*innen. Sie verbinden beides. Sie nutzen KI, um operative Exzellenz zu schaffen und reflektieren gleichzeitig, wie sie führen, entscheiden, kommunizieren. Diese Kombination erzeugt eine Form von unternehmerischer Klarheit, die sowohl innovativ als auch resilient ist.

KI kann Erkenntnisse liefern. Aber nur, wer sie richtig einordnet, profitiert davon. Selbstreflexion schafft den Raum, um mit Technologie sinnvoll umzugehen. Umgekehrt kann KI helfen, Reflexionsprozesse zu unterstützen, etwa durch gezielte Feedback-Auswertung oder datengestützte Teamanalysen.

Ein Beispiel aus der Praxis: Ein Start-up im HR-Tech-Bereich nutzt KI, um Kund*innenfeedback in Echtzeit zu analysieren. Gleichzeitig reflektieren die Gründer*innen wöchentlich im Führungsteam, welche Learnings daraus für Produkt und Kommunikation folgen und welche persönlichen Muster sie bei sich selbst erkennen. Diese Kombination aus technologischem Blick nach außen und menschlichem Blick nach innen führt dazu, dass das Unternehmen nicht nur schneller wächst, sondern dabei auch klar bleibt.

Skalierung braucht Klarheit in der Technik und im Kopf

Start-ups, die skalieren wollen, müssen effizient sein, gleichzeitig aber auch fokussiert, werteorientiert und anpassungsfähig. KI ist dabei ein mächtiges Werkzeug. Doch ohne die Fähigkeit zur Selbstreflexion bleibt sie oft bloß ein weiteres Tool im Tech-Stack.

Deshalb gilt: Die Kombination aus klugem KI-Einsatz und bewusster persönlicher Entwicklung ist kein Luxus, sondern unternehmerische Notwendigkeit. Wer beides ernst nimmt, schafft ein Unternehmen, das nicht nur wächst, sondern dabei auch „gesund“ bleibt.

Die Autorin Lea Baptista ist Geschäftsführerin der GG Consulting Agency und unterstützt Unternehmer*innen, Führungskräfte und Teams dabei, ihren Führungsstil klar zu definieren, Selbstreflexion als Werkzeug zu nutzen und authentisch erfolgreich zu sein.

Code für die künstliche Intelligenz: technische Optimierung für die Ära der KI-Suche

Code für die KI: So optimierst du deine Website technisch mit strukturierten Daten und Protokollen für die besten generativen Suchergebnisse.

Die Regeln der Online-Sichtbarkeit werden neu geschrieben. Es geht nicht mehr nur darum, von einem herkömmlichen Algorithmus indiziert zu werden. Stattdessen müssen Websites so aufbereitet werden, dass sie von künstlicher Intelligenz (KI) und großen Sprachmodellen (LLMs) fehlerfrei interpretiert und verarbeitet werden können.

KI erstellt ihre Antworten, indem sie Inhalte blitzschnell liest, deren Bedeutung versteht und die wichtigsten Fakten daraus extrahiert. Wenn der technische Unterbau einer Website unsauber ist, kann die KI die Informationen entweder nicht zuverlässig finden oder sie falsch interpretieren.

Das bedeutet, die technische Seite der Website – der Code – wird zum Fundament für eine gute Platzierung in den generativen Suchergebnissen. Wer hier Nachholbedarf hat, riskiert, als vertrauenswürdige Quelle für die KI unsichtbar zu werden.

Dieser Artikel beleuchtet die entscheidenden technischen Anpassungen, die notwendig sind, um deine Website optimal für die neue Ära der KI-Suche vorzubereiten.

Kontrolle und Zugang: Die Regeln für Sprachmodelle

Der erste technische Schritt zur Optimierung für KI-Ergebnisse ist die Steuerung des Zugriffs durch die großen Sprachmodelle (LLMs). Traditionell wird der Zugang durch die robots.txt Datei geregelt, die festlegt, welche Bereiche der Website von herkömmlichen Suchmaschinen-Crawlern besucht werden dürfen.

Mit dem Aufkommen verschiedener, spezialisierter KI-Crawler (die nicht immer identisch mit dem Googlebot oder Bingbot sind) entsteht jedoch die Notwendigkeit, diesen neuen Akteuren eigene Regeln zu geben. Es geht darum, Transparenz darüber zu schaffen, welche Daten zur Generierung von Antworten verwendet werden dürfen und welche nicht.

Neue Protokolle für neue Crawler

Experten diskutieren und entwickeln neue Protokolle, um diese Unterscheidung zu ermöglichen. Ein viel diskutierter Ansatz ist die Einführung von Protokollen, die spezifisch den Umgang mit generativer KI regeln. Dies könnte die Einführung von Protokollen wie einer llms.txt Datei beinhalten. Solche spezifischen Dateien könnten festlegen, ob ein KI-Modell Inhalte zur Schulung oder zur generativen Beantwortung von Nutzeranfragen nutzen darf.

Diese Kontrollmechanismen sind entscheidend. Sie geben den Website-Betreibern die Autorität darüber zurück, wie ihre Inhalte in der KI-Ära verwendet werden. Wer hier klare Regeln setzt, schafft die technische Grundlage für eine kontrollierte und damit vertrauenswürdige Sichtbarkeit in den KI-Ergebnissen.

Strukturierte Daten als universelle KI-Sprache

Nach der Regelung des Zugangs durch Protokolle ist die Strukturierung der Inhalte der wichtigste technische Schritt. Suchmaschinen nutzen strukturierte Daten schon lange, um Rich Snippets in den klassischen Ergebnissen anzuzeigen. Für die KI sind diese Daten jedoch absolut essenziell.

Strukturierte Daten, die auf dem Vokabular von Schema.org basieren, sind im Grunde eine Übersetzungshilfe im Code, die dem Sprachmodell den Kontext des Inhalts direkt mitteilt. Sie sind die "Sprache", die die KI am schnellsten und präzisesten versteht.

Die Bedeutung für die Generierung

Wenn ein Nutzer eine Frage stellt, sucht die KI nicht nur nach Stichwörtern, sondern nach definierten Informationstypen. Mit strukturierten Daten liefert man der KI diese Informationen als fertige, fehlerfreie Bausteine.

- Fehlerfreie Extraktion: Die KI muss keine Textpassagen interpretieren, um beispielsweise ein Rezept, die Bewertung eines Produkts oder einen FAQ-Abschnitt zu identifizieren. Die korrekte Auszeichnung macht die Daten sofort nutzbar.

- Vertrauensbildung: Fehlerhafte oder inkonsistente strukturierte Daten führen zu einer falschen Interpretation und können bewirken, dass die KI deine Seite als unzuverlässig einstuft.

Die Implementierung muss fehlerfrei sein und sollte alle relevanten Inhaltstypen der Website abdecken. Nur eine saubere Schema-Implementierung garantiert, dass deine Fakten korrekt in die generativen Antworten der KI einfließen.

Ladezeit und Interaktivität als Vertrauenssignal

Die Geschwindigkeit und die Nutzbarkeit einer Website sind in der Ära der KI-Suche nicht mehr nur ein Komfortfaktor, sondern ein entscheidendes technisches Vertrauenssignal. Wenn deine Seite langsam lädt oder schlecht bedienbar ist, wird das von der KI als Indikator für mangelnde Qualität und niedrige Autorität gewertet.

Die Basis dafür sind die sogenannten Core Web Vitals (CWVs). Diese Messwerte, die sich auf das Nutzererlebnis konzentrieren, sind feste Ranking-Faktoren und haben direkten Einfluss darauf, ob eine KI deine Seite als zitierwürdig einstuft:

- LCP (Largest Contentful Paint): Misst die Zeit, bis der größte sichtbare Inhalt geladen ist.

- FID/INP (First Input Delay / Interaction to Next Paint): Misst die Zeit bis zur ersten Interaktion und die allgemeine Reaktionsfähigkeit der Seite.

- CLS (Cumulative Layout Shift): Misst die visuelle Stabilität.

Mobile Performance ist der Schlüssel

Da ein Großteil der Online-Aktivität über mobile Geräte stattfindet, legt die KI höchsten Wert auf die Optimierung der Mobilversion. Eine schlechte mobile Performance kann das gesamte Ranking negativ beeinflussen.

Die technische Anpassung muss daher darauf abzielen, die CWVs zu perfektionieren. Dies beinhaltet die Optimierung von Bildern, das Bereinigen unnötiger Code-Lasten und das Priorisieren wichtiger Ressourcen. Eine schnell ladende und reaktionsfreudige Website signalisiert nicht nur dem Nutzer, sondern auch der KI, dass die Quelle professionell und damit vertrauenswürdig ist.

Redundanz vermeiden: kanonische Klarheit

Eines der größten technischen Probleme für KI-Modelle ist die Verwirrung durch doppelte Inhalte (Duplikate). Wenn die gleiche Information unter verschiedenen URLs verfügbar ist, weiß die KI nicht, welche die Originalquelle darstellt. Dies zersplittert deine Autorität.

Der technische Schlüssel zur Lösung ist der Canonical Tag (<link rel="canonical" ...>). Dieser Tag im Code muss auf jeder Seite korrekt auf die bevorzugte, indexierbare URL zeigen. Durch die Vermeidung von Duplikaten und die korrekte Nutzung dieses Tags stellst du technisch sicher, dass die KI deine Inhalte als eindeutig und autoritär wahrnimmt und dich als zuverlässigen Faktenlieferanten zitiert.

Schlussworte

Die Zukunft der Online-Sichtbarkeit wird durch künstliche Intelligenz neu definiert. Der Erfolg hängt von einer technisch sauberen Vorbereitung ab.

Die wichtigsten Schritte in der Generative Engine Optimization (GEO) sind:

1. Zugangskontrolle durch Protokolle wie die diskutierte llms.txt Datei.

2. Die Nutzung von strukturierten Daten als unverzichtbare KI-Sprache.

3. Die Perfektionierung der Core Web Vitals als Vertrauenssignal.

4. Die Vermeidung von Duplikaten durch kanonische Klarheit.

Investiere in diese technische Qualität, um Autorität und Sichtbarkeit in der Ära der KI-generierten Antworten zu sichern.

eleQtron: It's MAGIC

In nur fünf Jahren vom Laborgerät zum 24/7-betriebenen Quantencomputer: Wie das 2020 von Jan Leisse, Christof Wunderlich und Michael Johanning gegründete eleQtron mit seiner MAGIC-Technologie neue Wege ebnet.

Was ihr da macht, ist der Wahnsinn – und genau deswegen bin ich dabei.“ Mit diesen Worten beschreibt Jan Leisse, einer der Gründer von eleQtron, die Anfänge des Unternehmens. Das erste Treffen mit dem Physiker Christof Wunderlich war geprägt von einer Mischung aus Skepsis und Begeisterung. Der Wissenschaftler hatte an der Universität Siegen einen Quantencomputer gebaut – mitten in der deutschen Provinz und ohne das Millionenbudget, das Konzernen wie Google oder IBM zur Verfügung steht. Doch genau das reizte Leisse: „Hier wurde nicht einfach nachgemacht, was andere tun. Hier wurde Neuland betreten.“

Es war ein ungewöhnlicher Ort für eine bahnbrechende

Innovation in der Quantentechnologie. Siegen, eine Mittelstadt im Süden Nordrhein-Westfalens, ist nicht gerade als Hotspot für Hochtechnologie bekannt. Doch manchmal entstehen die Top-Innovationen fernab der etablierten Zentren; die Universität Siegen hatte über Jahre hinweg eine bemerkenswerte Expertise in der Quantenphysik aufgebaut, ohne große mediale Aufmerksamkeit.

Von der Universität ...

Im Jahr 2020, als das globale Interesse an Quantentechnologien exponentiell zunahm, erwuchs aus dieser mutigen Pionierarbeit das Start-up eleQtron – als Spin-off der Universität Siegen. Die Gründer – Jan Leisse, Christof Wunderlich und Michael Johanning – verbindet eine Vision: Quantencomputer für industrielle Anwendungen nutzbar zu machen.

Die Anfangsjahre waren geprägt von Experimentierfreude, Improvisation und dem festen Glauben an die eigene technologische Innovationskraft. Während Tech-Giganten wie IBM, Google und Amazon Milliarden Euro in ihre Quantenprogramme investierten und viele Start-ups auf bekannte Technologien setzten, wagte eleQtron den Schritt in eine völlig neue Richtung.

In den Laboren der Gründer entstand die sogenannte MAGIC-Technologie (Magnetic Gradient Induced Coupling), eine Methode, Qubits (das Quantencomputing-Äquivalent zum klassischen Bit in der Digitaltechnik) nicht wie bislang üblich mit Lasern, sondern mit Mikrowellen zu steuern.

... zum technologischen Durchbruch

Die MAGIC-Technologie basiert auf einem raffinierten Zusammenspiel physikalischer Prinzipien: Magnetische Gradienten (räumliche Veränderungen der Magnetfeldstärke) ermöglichen es als lokale Felder, einzelne Ionen in einer sogenannten Falle selektiv anzusprechen. Die technischen Vorteile sind beeindruckend: Die Fidelity (Genauigkeit) bei Operationen an einzelnen Qubits liegt bei etwa 99,95 Prozent, die Gate-Zeiten (Gate-Zeit steht für die Dauer, die ein Quanten-Gate benötigt, um eine Operation auf einem Qubit auszuführen) betragen nur wenige Mikrosekunden. Gleichzeitig ermöglicht die Technologie eine bessere Skalierbarkeit, da sich Mikrowellenfelder einfacher erzeugen und verteilen lassen als komplexe Lasersysteme. „Der Vorteil liegt nicht nur in der höheren Präzision, sondern auch in der deutlich geringeren Komplexität der Systeme“, erklärt Johanning. „Wir brauchen keine aufwändigen Optiken oder ultrastabile Umgebungen. Unsere Technologie funktioniert auch unter realen Bedingungen.“

Früh erkannten die drei Forscher das große Potenzial ihrer Technologie für praktische Anwendungen. „Durch das gezielte Ersetzen sensibler High-End-Komponenten – insbesondere Lasertechnologie – durch bewährte Mikrowellentechnik und Elektronik, vermeiden wir unnötige Komplexität, minimieren Aufwand und senken die Kosten“, fasst es Leisse zusammen.

Wachstumsschub und strategische Entwicklung

2022 gelang eleQtron ein entscheidender Schritt: Durch Earlybird und den Siegerlandfonds als Investoren sowie das vom BMBF geförderte Projekt „MAGIC App“ sicherte sich das Start-up eine Finanzierung in Höhe von 16 Millionen Euro. Diese Finanzierungsrunde war ein Wendepunkt für das Unternehmen und signalisierte das Vertrauen der Investor*innen in die MAGIC-Technologie.

„Mit diesem Kapitalschub konnten wir von einer reinen Forschungsorganisation zu einem echten Technologieunternehmen werden“, erklärt Leisse. Die Mittel flossen in den Ausbau der Produktionskapazitäten, die Vergrößerung des Teams und die Weiterentwicklung der Technologie-Roadmap. Auch die Mitwirkung von Infineon im Rahmen von MAGIC App war strategisch von Bedeutung: „Die Zusammenarbeit mit Infineon hat uns die Augen für die Realitäten des Industriemarkts geöffnet“, erklärt Leisse.

Indirekter Einkauf: Versteckter Kostenfresser oder unentdeckter Goldschatz?

Im Interview sprechen wir mit Bettina Fischer, Gründerin von Hivebuy, über die Chancen und Risiken des indirekten Einkaufs und darüber, wie Unternehmen mit der richtigen Software Kosten senken und Prozesse optimieren können.

In vielen Unternehmen wird der indirekte Einkauf häufig unterschätzt – dabei liegen hier oft erhebliche Einsparpotenziale verborgen. Durch die wachsende Digitalisierung und die zunehmende Verfügbarkeit von B2B eCommerce-Plattformen bestellen Mitarbeitende Waren und Dienstleistungen immer häufiger außerhalb klassischer Einkaufsprozesse. Diese Entwicklung bringt einerseits Flexibilität und Effizienz, stellt Unternehmen aber auch vor neue Herausforderungen: Wie lassen sich Ausgaben kontrollieren und Transparenz über die gesamte Einkaufskette sicherstellen?

Die beste Einkaufssoftware für den Mittelstand adressiert genau diese Herausforderungen. Hivebuy hat sich als moderne, benutzerfreundliche Lösung etabliert, die den indirekten Einkaufsprozess von der Bestellung bis zur Rechnungsprüfung digitalisiert und automatisiert. Die Software integriert sich nahtlos in bestehende ERP-, Buchhaltungs- und Kommunikationstools wie SAP, Microsoft Dynamics, Teams oder Slack – und das ohne aufwändige technische Implementierung.

Gegründet von erfahrenen Einkaufs- und Finanzexpert*innen aus Frustration über bisherige Lösungen, verfolgt Hivebuy die Mission, versteckte Kosten sichtbar zu machen, Budgets in Echtzeit zu kontrollieren und Einkaufsprozesse effizienter zu gestalten. Mit höchsten Sicherheitsstandards, inklusive ISO/IEC 27001-Zertifizierung und DSGVO-konformer Datenhaltung in Deutschland, schafft Hivebuy Transparenz und Vertrauen entlang der gesamten Einkaufskette.

Im Interview sprechen wir mit Bettina Fischer, Gründerin von Hivebuy, über die Chancen und Risiken des indirekten Einkaufs und darüber, wie Unternehmen mit der richtigen Software Kosten senken und Prozesse optimieren können.

StartingUp: Frau Fischer, viele Unternehmen sehen im indirekten Einkauf eher einen Kostenfaktor, der schwer zu kontrollieren ist. Was macht den indirekten Einkauf aus Ihrer Sicht zu einem versteckten Kostenfresser?

Bettina Fischer: Die große Herausforderung im indirekten Einkauf liegt darin, dass die einkaufenden Personen über das gesamte Unternehmen verteilt sind – anders als im direkten Einkauf, wo spezialisierte Einkaufsabteilungen tätig sind. Das bedeutet: Jede*r Mitarbeitende, der oder die einmal etwas bestellt, wird zum Einkäufer oder zur Einkäuferin – oft ohne die notwendige Erfahrung in Einkaufsprozessen.

Dadurch entstehen typische Muster: Es wird bei bekannten Lieferanten bestellt – oft aus dem privaten Umfeld, wie etwa Amazon Business – ohne Preisvergleiche, ohne Berücksichtigung von Lieferzeiten oder bereits verhandelten Konditionen. Das führt schnell zu ineffizienten und teuren Entscheidungen.

Hinzu kommt, dass im indirekten Einkauf eine hohe Produktvielfalt auf eine extrem heterogene Lieferantenlandschaft trifft. Das erschwert es, durch Bündelung bessere Konditionen zu erzielen. Es fehlt die klare, strategische Beziehung zu bestimmten Lieferanten – und genau dort entstehen die versteckten Kosten.

StartingUp: Wie hilft Hivebuy Mittelständlern konkret dabei, diese versteckten Kosten aufzudecken und zu reduzieren?

Bettina Fischer: Hivebuy verfolgt einen ganzheitlichen Ansatz, um die Herausforderungen des indirekten Einkaufs zu lösen. Zum einen ermöglichen wir es Mitarbeitenden, direkt über integrierte Lieferanten zu bestellen. Das bedeutet: Die Bestellungen erfolgen zentral über Hivebuy – ohne Umwege über externe Plattformen oder individuelle Beschaffungswege. Die Bestellübermittlung ist automatisiert und erfolgt effizient über unser System.

Darüber hinaus bietet Hivebuy einen integrierten Preisvergleich für B2B-Webshops. So wird sichergestellt, dass stets der beste Preis und die optimalen Lieferzeiten berücksichtigt werden – ein entscheidender Hebel zur Kostensenkung.

Ein weiterer zentraler Punkt ist die Budgetkontrolle: Sobald eine Bestellanforderung erstellt wird, sehen Budgetverantwortliche sofort die Auswirkungen auf ihr Budget – in Echtzeit. Dadurch lassen sich Entscheidungen schnell, fundiert und transparent treffen.

Auch die Freigabeprozesse sind flexibel und konfigurierbar: Mitarbeitenden wird Freiheit für alltägliche Bestellungen gegeben, während bei kritischen oder kostenintensiven Vorgängen automatische Eskalationen und Genehmigungen greifen.

Nicht zuletzt ermöglicht Hivebuy dem Einkauf, sein Wissen an die Organisation weiterzugeben. Vorverhandelte Verträge, Katalogartikel oder bevorzugte Lieferanten sind direkt im System sichtbar – wie ein digitaler Einkaufsberater im Hintergrund. So treffen selbst unerfahrene Nutzer bessere Entscheidungen – ganz im Sinne von Kostenkontrolle und Prozesssicherheit.

StartingUp: Ihre Software ist bekannt für ihre Nutzerfreundlichkeit. Wie schaffen Sie es, auch nicht-einkaufserfahrene Mitarbeitende einzubinden?

Bettina Fischer: Benutzerfreundlichkeit steht bei Hivebuy an oberster Stelle. Wann immer wir eine neue Funktion entwickeln, testen wir diese gemeinsam mit unseren Nutzerinnen und Nutzern – direkt aus der Praxis. Unser Ziel ist es, dass Hivebuy genauso intuitiv bedienbar ist wie eine Online-Überweisung: Jeder soll auf Anhieb verstehen, was zu tun ist.

Mit Funktionen wie unserem B2B-Preisvergleich und dem sogenannten Guided Buying führen wir Mitarbeitende gezielt durch den Einkaufsprozess – Schritt für Schritt, ganz ohne Schulungsaufwand. So wird selbst komplexes Einkaufswissen einfach zugänglich gemacht.

Für Freigabeverantwortliche haben wir zusätzlich eine besonders komfortable Lösung geschaffen: Freigaben können direkt über Messenger-Apps wie Microsoft Teams erteilt werden – ohne sich ins System einloggen zu müssen. Die relevanten Informationen kommen automatisch dorthin, wo man ohnehin schon arbeitet – aufs Handy oder den Desktop. Das senkt die Einstiegshürden enorm und sorgt für eine breite Akzeptanz im gesamten Unternehmen.

StartingUp: Welche Rolle spielen Transparenz und Echtzeit-Reporting in der Budgetkontrolle?

Bettina Fischer: Wir sind überzeugt: Budgetkontrolle funktioniert nur in Echtzeit. Es bringt wenig, wenn Budgetübersichten nur monatlich, quartalsweise oder gar halbjährlich zur Verfügung stehen. Entscheidungen im Einkauf werden täglich getroffen – also muss auch die Budgettransparenz jederzeit aktuell sein.

Deshalb haben wir bei der Entwicklung von Hivebuy besonderen Fokus auf eine unmittelbare Budgeteinsicht gelegt. Sobald eine Bestellung angefragt wird, sieht der oder die Budgetverantwortliche sofort, wie sich diese auf das verfügbare Budget auswirkt. Diese Echtzeit-Transparenz ist ein zentrales Element unserer Software.

Gleichzeitig möchten wir Mitarbeitende befähigen, innerhalb ihrer Befugnisse selbstständig Entscheidungen zu treffen. Nicht jede Anfrage muss durch mehrere Instanzen laufen. Vielmehr setzen wir auf smarte, automatisierte Prozesse – kombiniert mit dem Vertrauen in die Souveränität der Nutzer. Das spart nicht nur Zeit, sondern steigert auch die Effizienz und Zufriedenheit im Unternehmen.

StartingUp: Die Einführung neuer Software bedeutet oft hohen Aufwand. Wie gestaltet sich die Implementierung von Hivebuy?

Bettina Fischer: Ich habe selbst über viele Jahre ERP- und Einkaufssoftwareprojekte geleitet – und ehrlich gesagt: Es war jedes Mal ein enormer Aufwand. Genau diese Erfahrungen haben mich dazu motiviert, Hivebuy so zu entwickeln, dass Implementierung eben nicht zur Belastung wird.

Unsere Lösung ist bewusst so aufgebaut, dass sie schnell, unkompliziert und ohne großen IT-Aufwand eingeführt werden kann. Neue Unternehmen können innerhalb kürzester Zeit starten – oft sogar innerhalb eines Tages mit einem eigenen Testsystem.

Die Einführung begleiten wir durch leicht verständliche Videotutorials und Onboarding-Materialien. Darüber hinaus gibt es persönliche Sessions, in denen die Nutzer befähigt werden, das System selbstständig für ihr Unternehmen zu konfigurieren. Schnittstellen zu ERP-Systemen wie SAP, Microsoft Dynamics oder DATEV richten wir in der Regel innerhalb weniger Stunden bis Tage ein.

Wenn beide Seiten fokussiert an das Projekt herangehen, können wir bei Unternehmen mit mehreren tausend Mitarbeitenden innerhalb von acht Wochen vollständig live gehen – inklusive Integration, Schulung und Rollout.

StartingUp: Wie unterstützt Hivebuy IT-Teams und technische Entscheider bei der Integration?

Bettina Fischer: Unsere größte Stärke in der Zusammenarbeit mit IT-Teams ist unsere Schnelligkeit. Bereits im ersten Kick-Off mit der IT tauschen wir alle relevanten technischen Dokumentationen aus, klären die Rahmenbedingungen und ermöglichen in kürzester Zeit die Integration in ein Testsystem. Wir verzichten bewusst auf langwierige Business-Blueprint-Phasen und setzen stattdessen auf eine praxisnahe, direkte Umsetzung.

Hivebuy verfolgt eine klare Integration-First-Strategie. Das bedeutet: Unsere Lösung ist von Grund auf so konzipiert, dass sie sich schnell und flexibel in bestehende ERP-Systeme und IT-Landschaften integrieren lässt. Für alle gängigen Systeme – ob SAP, Microsoft Dynamics, DATEV oder NetSuite – stellen wir vollständige Schnittstellen-Dokumentationen zur Verfügung.

Mein Mitgründer Stefan Kiehne bringt aus seiner Zeit bei PwC tiefes technisches Know-how mit und hat zahlreiche ERP-Implementierungen verantwortet. Dieses Wissen fließt direkt in unsere Projekte ein. Inzwischen haben wir Hivebuy in so viele verschiedene Systeme integriert, dass kaum noch Überraschungen aufkommen. Für IT-Verantwortliche bedeutet das: minimale Unsicherheiten, schnelle Umsetzung und maximale Kompatibilität.

StartingUp: Wie sieht die Zukunft des indirekten Einkaufs aus? Welche Trends beobachten Sie?

Bettina Fischer: Ich sehe im indirekten Einkauf ganz klar einen Wandel hin zu intelligenter Automatisierung und echter Transparenz. Schon heute beobachten wir den Trend in Richtung „Agent AI“ – also digitale Einkaufsassistenten, die Nutzer durch Prozesse begleiten und Entscheidungen mit datenbasierten Empfehlungen unterstützen. Das wird sich in den nächsten Jahren deutlich verstärken.

Was mich persönlich schon lange wundert: Im B2C-Bereich haben wir mit Plattformen wie Idealo längst Preis- und Konditionsvergleiche. Im B2B gibt es das kaum. Deshalb war es uns wichtig, mit Hivebuy eine Lösung zu schaffen, die genau das möglich macht – inklusive der hinterlegten, unternehmensspezifischen Konditionen. Das ist ein echter Gamechanger.

In Zukunft wird der indirekte Einkauf zunehmend automatisiert ablaufen – von der Bedarfserkennung bis hin zur Bestellung. Vergleichbar mit einem intelligenten Kühlschrank, der automatisch Milch nachbestellt, wird auch im Unternehmen vieles automatisch geschehen: Bedarfe erkennen, Angebote vergleichen, Bestellungen auslösen – ganz ohne manuelles Zutun.

Strategische Beschaffung wird dabei zur Grundlage. Das Ziel ist nicht, jede Bestellung individuell zu behandeln, sondern Prozesse zu standardisieren, auf Unternehmensziele auszurichten und individuelle Bedarfe intelligent einzubinden.

Und auch die Rückseite des Einkaufs wird sich stark verändern: Rechnungsprüfung, Buchung und Zahlungsfreigabe werden zunehmend automatisiert ablaufen. In einer idealen Zukunft brauchen wir keine manuelle Rechnungserfassung mehr – weil alles systemgestützt, regelbasiert und transparent funktioniert.

StartingUp: Vielen Dank für das Gespräch, Frau Fischer. Ihre Einblicke verdeutlichen, wie entscheidend es für Unternehmen ist, den indirekten Einkauf transparent und effizient zu gestalten. Mit Lösungen wie Hivebuy können Mittelständler versteckte Kosten sichtbar machen und ihre Beschaffungsprozesse nachhaltig optimieren. Wir wünschen Ihnen weiterhin viel Erfolg bei Ihrer Mission, Einkaufsteams bestmöglich zu unterstützen.

Careertune: Vergleichsplattform für Weiterbildungsangebote gestartet

Das 2025 von Felix Hüsgen und Finn Prietzel in Mannheim gegründete Start-up Careertune hat eine Vergleichsplattform für staatlich geförderte Weiterbildungen gestartet. Ziel ist es, Arbeitssuchenden den Zugang zu passenden Kursen zu erleichtern – und so den Weg in zukunftssichere Jobs zu ebnen.

Erst vor wenigen Tagen ging durch die Medien: Die Zahl der Arbeitslosen in Deutschland ist zum ersten Mal seit 2015 wieder auf über 3 Millionen gestiegen. Gleichzeitig verändert sich der Arbeitsmarkt rasant: Automatisierung und künstliche Intelligenz lassen traditionelle Tätigkeiten verschwinden, während neue Berufsbilder wie etwa „Prompt Engineer“ entstehen.

Allein 2024 nutzten über 200.000 Menschen einen Bildungsgutschein der Bundesagentur für Arbeit, um sich für neue Jobs zu qualifizieren. Doch bisher mussten Arbeitssuchende geeignete Kurse mühsam selbst recherchieren – Erfahrungsberichte sind oft unübersichtlich, Bewertungen fehlen, und die Vielzahl an Bildungsträgern erschwert die Entscheidung.

Careertune: Mit wenigen Klicks zum passenden Kurs

Genau hier setzt Careertune an: Nutzer*innen geben ihre Interessen, Vorerfahrungen, den gewünschten Zeitrahmen und Standort an. Ein Algorithmus schlägt daraufhin passende, geförderte Weiterbildungen vor. Anbietende und Kurse können anschließend transparent nach Inhalten, Dauer, Lernform (Präsenz oder Online) sowie Bewertungen verglichen werden.

Zum Start sind bereits über 20 Bildungsträger mit mehr als 500 Kursen auf der Plattform vertreten – von IT-Weiterbildungen über kaufmännische Angebote bis hin zu Pflege- und Handwerksqualifikationen.

„Bislang mussten Arbeitslose stundenlang Kurse recherchieren – wir wollen, dass sie mit wenigen Klicks den passenden Weg in ihre berufliche Zukunft finden“, erklärt Mitgründer Felix Hüsgen.

Die Plattform ist für Nutzer*innen kostenlos. Careertune vermittelt lediglich die Kursanfragen an die Bildungsträger.

Mehr Transparenz in der Weiterbildung schaffen

Careertune wurde im April 2025 von Felix Hüsgen und Finn Prietzel in Mannheim gegründet. Nach ersten Erfahrungen als Gründer und App-Entwickler entwickelten die beiden ihre Idee gemeinsam mit Arbeitslosen und Bildungsträgern.

„Wir brennen für das, was wir beruflich machen“, sagt Finn Prietzel. „Genau das wünschen wir uns auch für unsere Nutzer: eine Weiterbildung, die wirklich passt – und die Chance auf einen Job, für den sie selbst brennen.“

Neben Arbeitslosen sollen auch Mitarbeitende von Jobcentern und Arbeitsagenturen profitieren: Die Plattform soll sie bei der zeitaufwändigen Beratung entlasten. Langfristig plant das Start-up, zusätzlich die Vermittlung in passende Jobs aufzubauen.

Luxusuhren: Darum ist es sinnvoll, Preise zu vergleichen

Entdecken Sie, warum sich der Preisvergleich bei Luxusuhren lohnt. Sparen Sie beim Online-Kauf.

Preisvergleiche bei Luxusuhren lohnen sich durch erhebliche Preisdifferenzen zwischen verschiedenen Händlern, die mehrere hundert bis tausend Euro betragen können. Diese Unterschiede entstehen hauptsächlich durch verschiedene Kostenberechnungen und unterschiedliche Margenstrategien der Anbieter. Während manche Händler auf Premium-Service setzen, bieten andere günstigere Preise durch schlankere Betriebsstrukturen. Besonders bei begehrten Modellen von Rolex, Patek Philippe oder Audemars Piguet variieren die Preise stark zwischen den Anbietern. Ein gründlicher Preisvergleich kann daher zu beträchtlichen Einsparungen von bis zu 30 Prozent führen. Gleichzeitig hilft er dabei, den tatsächlichen Marktwert einer Luxusuhr präzise zu ermitteln. Die Investition in eine hochwertige Armbanduhr rechtfertigt den Aufwand für einen detaillierten Vergleich verschiedener Anbieter vollständig. Die folgenden Abschnitte zeigen, worauf man achten sollte.

Zwischen den einzelnen Händlern existieren teilweise deutliche Preisunterschiede

Konkrete Beispiele verdeutlichen das Sparpotenzial beim Uhrenkauf: Spezialisierte Händler bieten permanent Armbanduhren mit Rabatten von mehreren tausend Euro unter dem Neupreis an. Diese deutlichen Preisvorteile entstehen durch unterschiedliche Beschaffungswege, Lagerbestände und Verkaufsstrategien der Anbieter. Plattformen wie Watchy24.de ermöglichen es, diese Preisunterschiede transparent zu vergleichen und das beste Angebot zu identifizieren. Während Boutiquen oft Listenpreise verlangen, können autorisierte Händler erhebliche Rabatte gewähren. Online-Händler profitieren von geringeren Betriebskosten und geben diese Kostenvorteile häufig an Kunden weiter.

Besonders bei limitierten Editionen oder seltenen aktuellen Modellen können die Preisunterschiede zwischen verschiedenen Anbietern deutlich ausfallen und eine sorgfältige Recherche rechtfertigen.

Internationale Preisunterschiede und Währungseffekte: Worauf sollte man achten?

Länderspezifische Preisdifferenzen bei Luxusuhren ergeben sich aus verschiedenen wirtschaftlichen Faktoren. Währungsschwankungen beeinflussen die Preisgestaltung deutlich, besonders bei hochwertigen Herstellern aus der Schweiz, die – ebenso wie viele Start-Ups – verstärkt darauf achten, ein hohes Maß an Markenschutz zu gewährleisten. Die unterschiedlichen Mehrwertsteuersätze zwischen den Ländern wirken sich direkt auf die Listenpreise aus. So liegt die Mehrwertsteuer in Deutschland bei 19 Prozent, während sie in der Schweiz und in einigen anderen Ländern deutlich niedriger ist.

Außereuropäische Märkte wie Hongkong oder Singapur bieten teilweise deutlich günstigere Preise, wobei Import- und Zollbestimmungen unbedingt zu beachten sind. Ein internationaler Preisvergleich kann erhebliche Kostenvorteile offenbaren, setzt jedoch Kenntnisse über Garantie- und Servicebedingungen voraus.

Lohnt es sich, auf dem Gebrauchtmarkt Ausschau zu halten?

Der Gebrauchtmarkt für Luxusuhren bietet Einsparpotenziale von bis zu 30 Prozent bei meist stabiler Wertentwicklung. Hochwertige Marken behalten auch als gebrauchte Modelle eine hohe Werterhaltungsrate von durchschnittlich 70 bis 80 Prozent. Plattformen für den Second-Hand-Handel verfügen über umfangreiche Bestände mit detaillierten Zustandsbeschreibungen.

Gebrauchte Luxusuhren werden häufig professionell aufbereitet und einer Qualitätsprüfung durch Fachbetriebe unterzogen. Die Wertstabilität macht den Gebrauchtmarkt zu einer attraktiven Investitionsmöglichkeit für Sammler. Seltene oder nicht mehr produzierte Modelle können sogar an Wert gewinnen. Die transparente Preisgestaltung ermöglicht fundierte Vergleiche und realistische Einschätzungen bei deutlich geringeren Anschaffungskosten.

Expertise als wichtiger Faktor für den Kauf einer Luxusuhr

So gut wie jeder hat individuelle Vorstellungen davon, was er sich gönnen möchte. Manche träumen davon, als digitaler Nomade die Welt zu sehen, andere möchten sich irgendwann eine Luxusuhr leisten können.

Daher ist es wichtig, sich zunächst über die eigenen Ansprüche klar zu werden. Falls die Wahl auf die Luxusuhr fällt, gilt: Die Authentizitätsprüfung bildet die Grundlage für sichere Transaktionen im Luxusuhrenmarkt und beeinflusst maßgeblich die Preisgestaltung. Erfahrene Fachhändler verfügen über spezialisierte Prüfverfahren wie Seriennummern-Checks, Analyse von Werkscodes und Materialuntersuchungen.

Zertifikate, Originalverpackungen und Servicedokumente erhöhen die Glaubwürdigkeit und den Wert einer Uhr erheblich. Experten bewerten den Zustand des Uhrwerks, die Originalität der Komponenten sowie die historische Bedeutung. Die Zusammenarbeit mit erfahrenen Uhrmachern minimiert Risiken beim Kauf hochwertiger Zeitmesser.

Seriöse Händler bieten Echtheitsgarantien und übernehmen die Haftung für die Authentizität ihrer Angebote.

Ein Ausblick auf die (mögliche) langfristige Wertentwicklung

Ein fundierter Preisvergleich bei Luxusuhren zahlt sich oft langfristig über einen Zeitraum von fünf bis zehn Jahren durch bessere Investitionsentscheidungen aus. Die Analyse großer Mengen weltweiter Angebote ermöglicht realistische Markteinschätzungen und das Erkennen von Trends bei renommierten Marken. Erfolgreiche Sammler berücksichtigen sowohl aktuelle Preise als auch die historische Wertentwicklung ihrer Wunschmodelle.

Die Nutzung professioneller Vergleichsplattformen und eine regelmäßige Marktbeobachtung helfen, Risiken zu minimieren und das Preis-Leistungs-Verhältnis zu maximieren. Internationale Preisunterschiede sowie der Gebrauchtmarkt bieten zusätzliche Einsparpotenziale für informierte Käufer. Langfristig profitieren Sammler von fundiertem Markt-Know-how bei zukünftigen Käufen und Verkäufen ihrer Luxusuhren-Kollektion.

Kurz mal die Welt retten

Wie GreenTech-Start-ups aus dem DACH-Raum dazu beitragen, die Auswirkungen des Klimawandels zu mildern.

Ist es bereits zu spät, den Klimawandel aufzuhalten? Während diese Frage unablässig für hitzige Debatten sorgt, arbeiten Start-ups unermüdlich an Lösungen für die dringendsten Umweltprobleme. Die DACH-Region erlebt einen rasanten Anstieg von GreenTech-Start-ups, angetrieben durch technologische Innovationen und zunehmenden regulatorischen Druck. Dies zeigt u.a. das DACH GreenTech Software Mapping 2025 von Hi Inov und veranschaulicht, welche vielversprechenden Ansätze und Technologien die Zukunft des GreenTech-Ökosystems in Europa prägen.

Mapping der Herausforderungen und Lösungen

Das Mapping bietet einen umfassenden Überblick über die Softwarelösungen von GreenTech-Start-ups im DACH-Raum. Sie umfassen eine Vielzahl von Ansätzen, um den Anstieg der globalen Temperaturen einzudämmen und die damit einhergehenden wirtschaftlichen und gesellschaftlichen Herausforderungen zu bewältigen.

1. Messung und Optimierung des CO2-Fußabdrucks

Fortgeschrittene Techniken zur Datenerfassung und KI-gesteuerte Analysen helfen Organisationen, ihre Effizienz zu steigern und ihren CO₂-Fußabdruck zu reduzieren. Sie helfen Unternehmen, jährlich Emissionen von über 216.000 Tonnen CO₂-Äquivalenten zu vermeiden. Horizontale Plattformen bieten allgemeine Monitoring-Tools für branchenübergreifende Messdienste. Vertikale Lösungen wie die für die Immobilienbranche maßgeschneiderte ESG-Datenplattform Deepki integrieren branchenspezifische Anforderungen.

2. Beschleunigung der Energiewende

Softwarelösungen spielen eine entscheidende Rolle bei der Optimierung der Standortauswahl für die Produktion erneuerbarer Energien, der vorausschauenden Wartung von Infrastruktur und der Verbesserung der Energiespeicherung. Sie können die Schwankungen in der Stromeinspeisung erneuerbarer Energien mindern und somit die Abhängigkeit von fossilen Brennstoffen reduzieren. Das Stuttgarter Start-up metergrid ermöglicht es beispielsweise Mieter*innen in Mehrfamilienhäusern, umweltfreundlichen Solarstrom zu nutzen, der im selben Gebäude produziert wird (mehr dazu in der StartingUp 01/25).

3. Förderung der Kreislaufwirtschaft und Ressourcenoptimierung

Digitale Lösungen erleichtern die Schonung von natürlichen Ressourcen durch intelligentes Ressourcenmanagement, indem sie die Planung und Nutzung von Ressourcen verbessern. Durch den Einsatz von KI lassen sich viele Prozesse optimieren, darunter Recycling, Landwirtschaft und Wassermanagement. So reduziert das Berliner Start-up Freshflow Abfall, indem es die Nachbestellung von frischen Lebensmitteln mit Machine Learning automatisiert und optimiert. Darüber hinaus verbinden digitale Marktplätze Produzent*innen überschüssiger Ware mit potenziellen Abnehmer*innen, um Ressourcen effizierter zu nutzen.

4. Förderung von Nachhaltigkeitsinitiativen in Unternehmen

Unternehmen nutzen digitale Werkzeuge, um ihre Nachhaltigkeit über die regulatorischen Anforderungen hinaus zu verbessern. Zu den eingesetzten Lösungen zählen CO₂-Kreditbörsen, die es Organisationen ermöglichen, Emissionen durch strukturierte Märkte auszugleichen, und Mitarbeiterengagement-Plattformen, die die Teilnahme der Belegschaft an ESG-Initiativen fördern. Start-ups wie das Hamburger CarbonStack unterstützen Unternehmen bei der Erstellung von Nachhaltigkeitsberichten und dabei die relevanten Richtlinien einzuhalten.

Die Entwicklung von 2023 bis heute

Insgesamt zeigt das Mapping ein reiferes und strukturierteres GreenTech-Ökosystem, das Europas Position als Pionier in digitalen Klimaschutzlösungen stärkt. Die Entwicklung zwischen den Mappings aus den Jahren 2023 und 2025 verdeutlicht drei wichtige Trends:

1. Anstieg der Anzahl der angebotenen Softwarelösungen

Die steigende Nachfrage nach nachhaltigkeitsorientierten Innovationen in verschiedenen Branchen hat das Wachstum des GreenTech-Ökosystems beschleunigt und zu einem rasanten Anstieg der angebotenen Softwarelösungen geführt.

2. Regulatorisch getriebene Fortschritte

Aufgrund des zunehmenden regulatorischen Drucks wächst der Anteil der angebotenen Lösungen, die auf Compliance-Bedürfnisse wie CSRD, die Rückverfolgbarkeit von Produkten und transparente CO₂-Buchhaltung eingehen. Es werden zunehmend vertikalisierte Monitoring-Tools entwickelt, um spezialisierte Datensätze und branchenspezifische Algorithmen zu erstellen.

3. Einfluss von generativer KI

Der Einsatz von generativer KI nimmt zu. Neue Anwendungsfälle im Bereich Nachhaltigkeit umfassen verbesserte Datenanalyse, automatisierte Compliance-Berichterstattung, sowie die Echtzeit-Optimierung von CO₂-Fußabdrücken und Ressourcenmanagement.

Fazit: Ein florierendes Ökosystem mit starker europäischer Führung

Der Klimawandel stellt eine immense Herausforderung dar, deren Bewältigung innovative technologische Lösungen erfordert. Das GreenTech Mapping 2025 verdeutlicht die führende Rolle Europas bei der Entwicklung dieser Lösungen und zeigt ein reiferes GreenTech-Ökosystem mit großer Dynamik. Durch den Einsatz fortschrittlicher Datenanalysen, KI und Automatisierung sind Start-ups in der DACHRegion gut positioniert, um sowohl wirtschaftlichen als auch ökologischen Mehrwert zu schaffen. Sie werden Unternehmen und politischen Entscheidungsträger*innen dabei helfen, den Übergang zu einer nachhaltigeren Wirtschaft zu beschleunigen und die Folgen des Klimawandels einzudämmen.

Der Autor Dr. Wolfgang Krause leitet als Managing Partner das Deutschlandgeschäft des auf B2B-Digitallösungen spezialisierten VC-Fonds von Hi Inov.

Zeit für ein neues Leistungsnarrativ

Warum wir Ambitionen neu denken müssen. Ein Kommentar von Benedikt Sons, Co-Founder und CEO der Cansativa Group.

In Deutschland ist Leistung ein stilles Versprechen. Man bringt sie, spricht aber selten darüber. Wer es doch tut, wird schnell als selbstverliebt, unsolidarisch oder toxisch abgestempelt. Ambition? Gilt bei uns oft als Ego-Trip.

Dabei trifft genau das Gegenteil zu: Ambitionen sind der Motor des Fortschritts. Will heißen – ohne Ambitionen treten wir auf der Stelle. Können wir uns das, können wir uns ein Denken, dass Leistung ein Ego-Trip ist, heute noch erlauben? In einer Zeit, die von multiplen geopolitischen Spannungen geprägt ist?

Wir diskutieren über die Vier-Tage-Woche. Obwohl wir international an Boden verlieren und andere Länder Tempo machen, Innovation finanzieren und mutig skalieren. Deutschland? Spricht über „Entschleunigung“ und über Work-Life-Balance als übergeordnetes Ziel. Dabei geht es meiner Meinung nach nicht um weniger Arbeit, sondern um die Frage: Wofür lohnt es sich, Leistung zu bringen – und wie schaffen wir es, das Beste aus Menschen herauszuholen, ohne sie zu verheizen?

Also: Wie kommen wir da hin, dass sich Leistung wieder gut anfühlt?

Leistung: Zwischen Burnout-Mythos und Selbstoptimierungswahn

Das gegenwärtige Leistungsbild pendelt zwischen zwei Polen: Auf der einen Seite der ausgebrannte Consultant, der sein Leben für ein Projekt opfert. Auf der anderen Seite die Influencer-Ästhetik, in der jeder Tag „High Performance“ verspricht, solange die richtige Morgenroutine stimmt.

Beides ist Unsinn. Beides ist egozentriert. Beides ignoriert, worum es wirklich geht: Leistung als kollektives Ziel, als Ausdruck von Sinn, von Teamgeist, von etwas, das größer ist als man selbst. Wenn wir es schaffen, Leistung als etwas Verbindendes zu begreifen, als Teamgedanken – nicht als Konkurrenz –, dann entsteht neben Erfolg auch Identifikation.

Ambitionen sind kein Makel – sie sind Orientierung

Wir müssen wieder lernen, uns mit ambitioniertem Handeln zu identifizieren. Deutschland ist ein Land voller Talente – aber oft auch voller Zweifel. Was fehlt, ist ein klarer Rahmen: Wo wollen wir hin? Wer sind unsere Vorbilder? Und warum lohnt es sich überhaupt, den Sprint aufzunehmen?

Diese Fragen betreffen unser gesamtes Wirtschaftsverständnis. Wir brauchen mehr Mut, klare Ziele zu formulieren. Und wir brauchen den Willen, sie offen zu verfolgen.

Start-up-Kultur: Hardcore oder Heilsbringer?

Start-ups sind Meister darin, ein klares, übergeordnetes Ziel zu formulieren – und mit dem unerschütterlichen Antrieb einer Rakete arbeiten sie gerade zu Beginn mit vollem Schub darauf hin. Gleichzeitig sind Start-ups der Inbegriff von Überforderung: lange Tage, kurze Nächte, wenig Absicherung. Manche glorifizieren diesen Zustand, andere verdammen ihn. Die Wahrheit ist: Start-up ist ein Überlebenskampf, aber auch eine Schule für Fokus, Disziplin und Priorisierung. Mein alter Physiklehrer sagte: „Leistung ist Arbeit pro Zeit.“ Und genau darum geht es. Nicht um den Dauer-Hustle, sondern um kluge, fokussierte Arbeit.

Daher braucht die deutsche Wirtschaft ein Ökosystem, das Hochleistung fördert – ohne Burnout zu belohnen. In dem man mit hoher Schlagzahl arbeitet, aber nicht daran zerbricht. Studien zeigen: Ja, die Belastung im Start-up-Sektor ist hoch – längere Arbeitszeiten, geringere Gehälter, weniger Sicherheit. Besonders Frauen sind oft benachteiligt.

Aber: Die Offenheit für neue Arbeitsmodelle ist ebenfalls höher. Viele Start-ups bieten flexiblere Strukturen, Homeoffice, Fokus-Zeiten, Purpose-getriebenes Arbeiten – also eine Umgebung, die mehr bietet als den klassischen „9-to-5“-Job. Damit machen sie einen entscheidenden Unterschied gegenüber Traditionsunternehmen, die eher auf feste Arbeitszeiten und Bürokultur setzen.

Innovation braucht Raum, kein Sicherheitsdenken

Apropos Traditionsunternehmen: Ich glaube, dass in einem überregulierten Ökosystem die Innovation auf der Strecke bleibt. Wer bei jedem Schritt Angst vor Fehlern hat, wird keine Risiken eingehen. Doch Innovation ohne Risiko gibt es nicht. Unternehmen, die keine Fehler machen wollen, machen auch keine Fortschritte.

Hier ist ein Umdenken gefragt – auch politisch. Wer heute in Deutschland ein Unternehmen gründet, sieht sich mit einer Bürokratie konfrontiert, die oft mehr lähmt als schützt. Gleichzeitig verlieren wir im internationalen Wettbewerb – weil andere Länder schneller, pragmatischer und technologieoffener agieren. Innovation verlangt Raum, Geschwindigkeit – und eine Kultur für Gründer*innen und Investor*innen, in der sie schnell skalieren können.

Europas Chance: Der Weg der Qualität

Der Inbegriff für schnelles Skalieren sind China und die USA. Während China auf Masse setzt und die USA auf Kommerzialisierung, hat Europa die Chance, einen eigenen Weg zu gehen: mit Qualität und gesellschaftlicher Einheit als Alleinstellungsmerkmal. Europa ist eine der wenigen Regionen, in der wirtschaftlicher Erfolg mit sozialer Verantwortung verbunden wird. Wir haben Zugang zu Spitzenforschung, zu klugen Köpfen, zu funktionierenden Institutionen. Was uns fehlt, ist der Mut zur schnellen Umsetzung.

Wir brauchen mehr Kommerzialisierung, ohne unsere Werte zu verlieren. Wir brauchen mehr Tempo, ohne Menschen zu überfordern. Und wir benötigen ein neues Narrativ, das Leistung nicht als toxisch, sondern als Teil einer starken Gesellschaft begreift.

Warum der Leistungsanspruch tief im Unternehmen verankert sein muss

Mehr Tempo, kluge Köpfe, ein Team: Wie gut dieser Dreiklang für mehr Leistung funktioniert, zeigt die Geschichte von Cansativa selbst. 2017 mit wenig Kapital gegründet, haben mein Bruder Jakob und ich früh auf Geschwindigkeit und Umsetzung gesetzt. Während andere noch in Businessplänen dachten, organisierten wir die ersten Importe von Medizinalcannabis, navigierten durch eine regulatorisch hochkomplexe Landschaft und bauten eine Plattform auf, die heute Marktführer in Deutschland ist.

Dass wir vom Bundesinstitut für Arzneimittel und Medizinprodukte (BfArM) den Zuschlag für die Distribution von in Deutschland angebautem Cannabis erhielten, war kein Zufall, sondern Ergebnis von Expertise, strategischer Schärfe und kompromissloser Arbeit. Inzwischen haben wir über 2500 B2B-Kund*innen, ein eigenes Produktportfolio, ein starkes Partnerschaftsnetzwerk und wachsen mit jeder regulatorischen Veränderung weiter. Nicht weil wir Glück hatten, sondern weil wir Leistung als Haltung verstehen.

Ambition braucht Anerkennung

Deshalb fordere ich: Deutschland muss lernen, Ambitionen nicht zu fürchten, sondern zu fördern. Denn wer Leistung immer nur mit Egoismus, Selbstausbeutung oder Ellenbogenmentalität gleichsetzt, nimmt sich die Chance auf echten Fortschritt. Leistung ist kein Selbstzweck – sie ist ein Beitrag zum Wirtschaftswachstum Europas. Sie ist Ausdruck von Haltung, Verantwortung und dem Willen, Dinge besser zu machen. Gefragt ist ein gesellschaftliches Klima, in dem es willkommen ist, Großes zu wollen. Und in dem diejenigen, die sich anstrengen, auch Rückenwind bekommen – nicht Gegenwind.

Unser Unternehmen ist nur ein Beispiel dafür, was möglich ist, wenn Menschen Verantwortung übernehmen und mit einem klaren Ziel handeln. Der Erfolg ist kein Zufall, sondern das Ergebnis einer gelebten Leistungskultur, die nicht auf Kontrolle, sondern auf Klarheit basiert. Und auf dem Mut weiterzumachen, gerade wenn der Weg steinig ist.

Es ist Zeit, dass wir in Deutschland – und in Europa – ein neues Kapitel aufschlagen. Eines, in dem Ambition der Antrieb ist, in dem Leistung nicht verdächtig, sondern wertvoll ist. Und in dem wir verstehen: Zukunft entsteht dort, wo Menschen nicht fragen, was gerade bequem, sondern was möglich ist.

Was sollten Eigentümer in Bezug auf Gewerbeimmobilien beachten?

Entdecken Sie wichtige Tipps für Gewerbeimmobilien-Eigentümer. Infos und wichtige Details.

Gewerbeimmobilien stellen eine wichtige Anlageklasse dar, die sowohl attraktive Renditen als auch besondere Herausforderungen mit sich bringt. Der deutsche Gewerbeimmobilienmarkt erlebt derzeit nicht nur einen zyklischen Abschwung, sondern einen dauerhaften strukturellen Wandel durch die Zinswende. Diese Entwicklung verändert die Rahmenbedingungen für Eigentümer grundlegend und erfordert eine Anpassung der Investitionsstrategien.

Neben den klassischen Überlegungen zu Standort, Mieterstruktur und Rendite gewinnen neue Aspekte wie Nachhaltigkeit, Energieeffizienz und regulatorische Anforderungen zunehmend an Bedeutung. Eine fundierte Kenntnis aller relevanten Faktoren ist daher essentiell für erfolgreiche Gewerbeimmobilien-Investments. Die folgenden Abschnitte liefern eine praktische Übersicht.

Frühzeitig Verpflichtungen rund um das Thema Gebäude prüfen

Neben den klassischen Überlegungen zu Standort, Mieterstruktur und Rendite gewinnen auch technische und infrastrukturelle Aspekte zunehmend an Bedeutung. Insbesondere Kanalservicearbeiten, wie die Wartung und Instandhaltung der unterirdischen Versorgungsnetze, spielen eine wesentliche Rolle bei der Sicherstellung der langfristigen Werthaltigkeit von Gewerbeimmobilien.