Aktuelle Events

Geschäftsideen Club: Kein Zutritt für Männer

"Gentlemen" Club nur für Frauen

Die sogenannten Gentlemen Clubs, in denen sich vorwiegend männliche Geschäftsleute treffen, erleben gerade eine Renaissance. Kaum bekannt ist, dass es schon im 19. Jahrhundert eine Gegenbewegung gab und Clubs eröffneten, die nur für Frauen zugänglich waren.

Diese Tradition der Clubs für Frauen wollen Audrey Gelman und Lauren Kassan mit ihrer Geschäftsidee neu aufleben lassen. 2016 haben sie in Manhattan den ersten Club namens The Wing eröffnet. Hier sind Business-Frauen genauso willkommen wie Frauen, die neue Netzwerke knüpfen möchten. Nicht zugelassen sind Männer.

Natürlich gibt es Angebote, die auch in jedem Gentlemen Club zum guten Ton gehören, wie eine Bibliothek, Konferenzräume, Arbeitsplätze, eine Catering-Area, gemütliche Sessel und eine Bar. Der Jahresbeitrag beträgt mindestens 2350 Dollar. Um der hohen Nachfrage gerecht zu werden, eröffnet The Wing weitere Clubhäuser in den USA.

Sie möchten selbst ein Unternehmen gründen oder sich nebenberuflich selbständig machen? Nutzen Sie jetzt Gründerberater.de. Dort erhalten Sie kostenlos u.a.:

- Rechtsformen-Analyser zur Überprüfung Ihrer Entscheidung

- Step-by-Step Anleitung für Ihre Gründung

- Fördermittel-Sofort-Check passend zu Ihrem Vorhaben

Diese Artikel könnten Sie auch interessieren:

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

eeden: Die Alchemie der Altkleider

Das Münsteraner Unternehmen eeden verwandelt Textilmüll in hochwertige Rohstoffe. Mit Millioneninvestments baut das Team um Steffen Gerlach und Tobias Börnhorst nun die erste Demonstrationsanlage auf.

Steffen Gerlach saß entspannt mit seinem Schulfreund Reiner Mantsch auf einer Couch in einer Kölner Wohngemeinschaft. Mantsch hatte zuvor an der Universität in Mönchengladbach Textiltechnik studiert. Er berichtete leidenschaftlich von seinen naturwissenschaftlichen Forschungen zur Kreislaufwirtschaft. Dieses Gespräch veränderte Gerlachs gesamte berufliche Planung radikal. Mantsch suchte jemanden für die Marktseite seiner technischen Vision. Gerlach war sofort fasziniert von dem ökonomischen Potenzial. Er wollte wissen, ob man daraus ein echtes Unternehmen formen kann. „Das war der eigentliche Startpunkt für eeden. Wir entschieden uns für einen vollen Fokus auf das Projekt. Und wir wollten das Recyclingproblem der Branche grundlegend lösen“, erinnert sich Gerlach.

Der langsame Weg zum technologischen Durchbruch

Es gab keinen plötzlichen Heureka-Moment in einem winzigen und improvisierten Labor. Die Entwicklung war eher eine gezielte Suche nach einer Problemlösung. Mantsch war früher Leistungssportler und brachte den nötigen Fokus mit. Er sah den Frust seiner Kommilitonen nach Praktika in der Industrie. Die Branche wirkte starr und wenig dynamisch für junge Talente. Das Duo suchte stattdessen nach den Megatrends der Zukunft. „Die Kreislaufwirtschaft kristallisierte sich schnell als das zentrale Thema heraus. Ich habe die Marktseite intensiv analysiert und viele Gespräche geführt“, so Gerlach. Er erkannte die Verknüpfungen zwischen technischer Machbarkeit und ökonomischen Anforderungen. Die Suche nach dem technologischen Sweetspot dauerte Monate. Am Anfang stand lediglich die reine Faszination für das Recycling. Es war ein schleichender Prozess mit vielen Etappenentscheidungen.

Die wachsende Last der globalen Fast Fashion

Das Umweltproblem der globalen Textilindustrie ist mittlerweile gewaltig. Die Branche verdoppelt ihren Durchsatz alle 20 bis 30 Jahre. Jährlich werden mittlerweile mehr als 120 Mio. Tonnen Textilien produziert. Nach Angaben der Ellen MacArthur Foundation werden weltweit ungefähr zwei Drittel dieser Mengen praktisch direkt nach der Nutzung entsorgt; sie landen auf riesigen Deponien oder werden ungenutzt verbrannt. In Deutschland steht das klassische Rücknahmesystem laut Experten vor dem Kollaps. Es gibt nach seiner Aussage derzeit eine gestiegene Anzahl an Insolvenzen bei Sammel- und Sortierbetrieben. Die Qualität der Kleidung sinkt durch den Trend zur Fast Fashion massiv. Der Wiederverkauf der gebrauchten Ware lohnt sich oft nicht mehr. Neuware aus Asien ist meistens günstiger als Second Hand-Stücke aus Europa. In Deutschland verursacht die Entsorgung einer Tonne Altkleider zudem Kosten – das Material wird somit zur finanziellen Belastung für die Sammel- und Sortierbetriebe.

Chemische Trennung als industrieller Schlüssel

Das Unternehmen aus Münster setzt genau an diesem Punkt an. Die Technologie ermöglicht die Trennung von Baumwolle und Polyester und macht beide Materialien wieder nutzbar. Das ist entscheidend für den Erfolg der Kreislaufwirtschaft. Die meisten Textilien bestehen heute aus komplexen Mischgeweben. Gerlach erklärt, dass das Unternehmen aus dem Abfall eine hochwertige Cellulose und chemische Bausteine für neues Polyester gewinnt. Die Cellulose dient als sauberes Vorprodukt für die neue Faserherstellung. Das Polyester wird in seine Grundbausteine zerlegt, die für die Herstellung von neuem Polyester verwendet werden können. „Wir stellen aus Baumwolle eine hochwertige Cellulose her und gewinnen aus dem Polyester die chemischen Bausteine zurück“, sagt Gerlach. Beide Materialströme können direkt wieder in der Textilproduktion eingesetzt werden. Damit wird der Kreislauf zwischen Abfall und Kleidung geschlossen. Seit Anfang 2025 hilft zudem eine neue gesetzliche Regelung. Die EU-weite Getrenntsammlungspflicht für Textilabfälle ist in Kraft getreten: Unternehmen dürfen Textilien nun nicht mehr über den Restmüll entsorgen. Das sichert den Zugang zu großen Mengen an Rohstoffen.

Harte Verhandlungen in der Welt des Wagniskapitals

Der Weg von der ersten Idee zur fertig gebauten Industrieanlage ist lang. Deeptech-Unternehmen brauchen oft viel Geduld und Zeit für die Entwicklung. Das erfordert Investoren mit einem sehr langen Atem. In einer frühen Phase kam der High-Tech Gründerfonds an Bord. Auch die NRW.Bank und der TechVision Fonds unterstützen das Vorhaben. Später stiegen Forbion und der Chemiekonzern Henkel als Investor ein. Gerlach erinnert sich im Gespräch an einen intensiven Lernprozess bei den ersten Finanzierungsrunden. Man müsse technische Begeisterung mit harten Umsatzprognosen anreichern. Auch D11Z.Ventures, das Family Office von Dieter Schwarz (Lidl/Kaufland), investierte in das Unternehmen. Die Investoren verstehen laut Gerlach die Entwicklungszyklen und Skalierung von Deeptech-Unternehmen. Mittlerweile flossen über 20 Mio. EUR an Kapital in die Firma. Dieses Geld ermöglicht nun den nächsten großen Schritt.

Ein neues Team für die industrielle Skalierung

Das Start-up ist mittlerweile den Kinderschuhen entwachsen. In Münster entsteht derzeit eine industrielle Demonstrationsanlage. Gerlach erinnert sich an den Moment der Schlüsselübergabe: Zuerst wirkte die leere Halle riesig auf das Team. Inzwischen planen die Ingenieure bereits jeden Zentimeter der Fläche. Das Team ist auf über 25 Köpfe gewachsen. Es ist eine Mischung aus jungen Talenten und erfahrenen Kräften. Viele Mitarbeitende wechselten von großen Konzernen wie BASF nach Münster. Gerlach beobachtet eine große Lust auf die Arbeit an innovativen Prozessen. Die flachen Hierarchien im Unternehmen ziehen Experten an. Er schätzt das Know-how dieser Fachkräfte für den Anlagenbau. Erfahrene Chemiker bringen eine neue Qualität in die Prozesse. Die Zusammenarbeit zwischen Alt und Jung funktioniert hervorragend.

Führung zwischen Agilität und unternehmerischer Verantwortung

Die Unternehmenskultur hat sich mit der Größe weiterentwickelt. Gerlach betont, dass viele Impulse direkt aus der Belegschaft kommen. So wurde die Regelung für die Präsenz im Büro gemeinsam erarbeitet. Die Mitarbeitenden wünschten sich feste Tage für den Austausch. „Die schönsten Tage sind jene mit viel Begegnung“, berichtet Gerlach. Die bürokratischen Pflichten eines Geschäftsführers gehören einfach dazu. Trotzdem bleibt die Mission der Firma der wichtigste Treiber. Die Motivation im gesamten Team sei extrem hoch. Jeder packt an und treibt das Unternehmen voran. Der Spagat zwischen Entwicklung und Business ist fordernd. Gerlach jedoch genießt diese tägliche Herausforderung sehr.

Der Standort Deutschland als Zentrum für Innovation

Viele Fachleute kritisieren die Bedingungen für die Chemieindustrie. Hohe Energiekosten belasten die traditionsreichen Unternehmen stark. Gerlach sieht das differenzierter aus der Perspektive von innovativen Start-ups: „Für die Entwicklung neuer Technologien ist der Standort Deutschland weiter exzellent. Und die Qualifikation der Technologen ist hervorragend. Die aktuelle Krise führt bei uns auch zu Bewerbungen von erfahrenen Talenten aus der chemischen Industrie – die hätte es vor einigen Jahren in der Menge nicht gegeben.“ Die vorhandene Infrastruktur sei ein klarer Vorteil. Auch Konzerne beobachten solche Innovationen genau. Die Nähe zum Mittelstand fördert zudem die Skalierung. Für die beiden Gründer ist die aktuelle Produktionsanlage nur ein Anfang. Langfristig soll die Technologie weltweit lizenziert werden; überall auf der Welt fällt schließlich Textilmüll an. Die Kombination aus Ingenieurskunst und Skalierung ist das Ziel. Auch die aktuellen Investoren von eeden sehen dieses globale Potenzial. Das Unternehmen will beweisen, dass sich Kreislaufwirtschaft lohnt. Deutschland bleibt dafür ein wichtiger Ankerpunkt.

Distart: Vom Agentur-Frust zum EdTech-Champion

Wie das 2021 von Thomy Roecklin gegründete und seit 2025 zusammen mit Lucia-Miriam Selbert geführte Leipziger EdTech Distart das Bildungssystem „gegen den Strich bürstet“.

Wer in Deutschland über Start-up-Hubs spricht, landet meist schnell in Berlin oder München. Doch in der sächsischen Metropole Leipzig wächst seit einigen Jahren ein Player heran, der beweist, dass Innovation auch abseits der üblichen Verdächtigen gedeiht: Die Distart Education GmbH. Ihr Treibstoff ist der eklatante Mangel an digitaler Kompetenz in der deutschen Wirtschaft – und der Mut, das „System Bildung“ gegen den Strich zu bürsten.

Wenn „Done for You“ nicht mehr reicht

Die Wurzeln des Unternehmens reichen weiter zurück als das offizielle Gründungsjahr 2021. Gründer Thomy Roecklin setzte jahrelang mit seinen Agenturen MNKY lab und TRDIGITAL digitale Kampagnen für Kund*innen um. Doch im Tagesgeschäft bremste das fehlende Digitalverständnis auf Kundenseite die Projekte immer wieder aus. Die Erkenntnis, dass Deutschland weniger neue Agenturen, sondern mehr digitale Mündigkeit braucht, führte schließlich zum Pivot.

Interessanterweise war der Auslöser für diesen Kurswechsel kein konkretes Kundenprojekt. Auf die Frage nach dem „Aha-Moment“ erklärt Roecklin, dass er lediglich versuchte, Lucia-Miriam Selbert einzuarbeiten, und dabei schockiert feststellte, wie wenig praxisnahe digitale Weiterbildungen existierten. Er baute kurzerhand selbst ein Lernprogramm – ohne zu ahnen, dass daraus einmal Distart entstehen würde. Im Januar 2021 fiel der Startschuss für Distart learn. Mitten in der Pandemie setzte Roecklin auf ein Modell, das sich radikal von klassischen Bildungsträgern unterschied: 100 Prozent remote, aber mit enger persönlicher Betreuung und einem klaren Fokus auf die Praxis.

Das Schnellboot zwischen den Tankern

Distart operiert im sogenannten AZAV-Markt (Akkreditierungs- und Zulassungsverordnung Arbeitsförderung). Während etablierte Bildungsriesen oft mit der Trägheit ihrer Größe kämpfen und bis zu 24 Monate für Lehrplananpassungen benötigen, hat sich Distart als agiler „Qualitäts-Vorreiter“ positioniert.

Für Roecklin ist diese Agilität eine Frage des Überlebens, da sich Jobs und Skills heute schneller verändern als jede klassische Bildungslogik. Er betont, dass man ohne permanente Weiterentwicklung der Inhalte zwangsläufig am Markt vorbei ausbilden würde. Diese Flexibilität ist zudem essenziell für die Zielgruppe: Viele Teilnehmende bilden sich neben ihrem 9-to-5-Job weiter, betreuen Kinder oder pflegen Angehörige und benötigen daher flexible statt starrer Strukturen.

Agency-DNA statt Schulbank-Feeling

Der entscheidende Wettbewerbsvorteil liegt in der Herkunft: Distart ist keine klassische Schule, sondern wurde von Marketern für Marketer gebaut. Diese „Agency-DNA“ durchzieht das gesamte Geschäftsmodell. Mit einer modernen Lernumgebung aus Live-Sessions und asynchronen Deep-Dives spricht das Unternehmen alle Altersgruppen gleichermaßen an.

Auch technologisch ist man der Konkurrenz oft einen Schritt voraus: Als ChatGPT Ende 2022 die Arbeitswelt veränderte, reagierte Distart fast in Echtzeit. Auf die kritische Frage, ob KI das vermittelte Wissen nicht bald obsolet mache, findet Roecklin eine klare Antwort: KI ersetzt keine Menschen, sie ersetzt lediglich Mittelmaß. Während KI das Netz mit generischen Inhalten flutet, steige paradoxerweise der Hunger nach echten Stimmen, Ideen und Perspektiven – Marketing werde also menschlicher.

Bootstrapping und gesundes Wachstum

Der Erfolg gibt dem Konzept recht. Im September 2024 erfolgte die Umfirmierung zur Distart Education GmbH, was den Übergang vom Start-up zum etablierten Bildungsinstitut markierte. Während andere Tech-Unternehmen Personal abbauen mussten, verdoppelte Distart seine Belegschaft beinahe auf über 100 Köpfe und bezog im Oktober 2025 neue Räumlichkeiten im NEO Leipzig.

Besonders bemerkenswert: Das Wachstum ist organisch und gebootstrapped – finanziert aus dem eigenen Cashflow ohne externe Risikokapitalgeber. Das macht Distart unabhängig von Exit-Druck. Seit Februar 2025 verstärkt Lucia-Miriam Selbert als Geschäftsführerin die strategische Ausrichtung.

Dennoch birgt die Skalierung Risiken, da das Geschäftsmodell stark von staatlichen Bildungsgutscheinen abhängt. Auf einen möglichen „Plan B“ angesprochen, erklärt das Unternehmen, dass Förderungen zwar beim Beschleunigen helfen, man Distart aber bewusst so aufbaue, dass langfristig strukturelle Unabhängigkeit erreicht wird. Auch die Qualitätssicherung bei über 100 Mitarbeitenden ist eine Herausforderung. Thomy Roecklin gibt offen zu, dass Wachstum kein Wellnessprogramm ist und es im Getriebe zwangsläufig knirscht. Sein Schlüssel: Qualität darf nicht an Einzelpersonen hängen, sondern muss im gesamten System verankert sein, kombiniert mit echtem Vertrauen in das Team statt Kontrolle.

Der Standort als Statement und Vision

Dass Distart in Leipzig verwurzelt bleibt, ist Teil der Identität. Roecklin sieht im Osten Deutschlands ein enormes, oft unterschätztes Potenzial und erlebt dort viel Talent, Pragmatismus und Lernhunger. Distart versteht sich hier auch als Regionalentwickler.

Die Vision der Gründer geht jedoch über reine Kurse hinaus. Unterstrichen durch Auszeichnungen wie „Top Fernschule 2025“ und „2026“, arbeitet das Team nun an der Gründung der Distart University of Applied Sciences. Das Ziel bis 2030 ist ambitioniert: Ein Alumni-Netzwerk von 25.000 Absolvent*innen. Sollte der komplexe Weg zur staatlichen Anerkennung gelingen, wird Distart endgültig zum gewichtigen Faktor für die digitale Wettbewerbsfähigkeit der Bundesrepublik.

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

ChatGPT schreibt Texte. R3 Robotics zerlegt Batterien

Es gibt Probleme, die man mit Software lösen kann, und es gibt Probleme, für die man sich die Hände schmutzig machen muss – oder besser: Roboterhände nutzt. Antoine Welter und Dr. Xavier Kohll haben mit Circu Li-ion begonnen, um Batterien zu retten. Jetzt, unter dem neuen Namen R3 Robotics und mit 20 Millionen Euro frischem Kapital im Rücken, treten sie an, um den wohl größten Flaschenhals der kommenden Mobilitätswende zu beseitigen. Ihr Ansatz: Keine teuren Spezialmaschinen, sondern intelligente Standard-Roboter, die sehen, verstehen und sicher zupacken.

Wenn in den Vorstandsetagen der Automobilhersteller über die Zukunft gesprochen wird, geht es meist um Reichweiten und Software-Defined Vehicles. Doch am anderen Ende der Wertschöpfungskette braut sich ein Sturm zusammen. Millionen von Elektrofahrzeugen werden in den kommenden Jahren ihr Lebensende erreichen. Die derzeitige Realität in vielen Recyclinghöfen wirkt dagegen fast archaisch: Menschen, die mit Handwerkzeugen komplexe Systeme auseinanderschrauben. Das ist nicht nur teuer und schwer skalierbar, sondern bei Hochvolt-Systemen auch lebensgefährlich.

Genau hier setzen Antoine Welter und Xavier Kohll an. Die Nachricht, die das deutsch-luxemburgische Unternehmen Anfang Februar 2026 verkündete, ist mehr als nur eine Finanzierungsrunde. Die 20 Millionen Euro – aufgeteilt in 14 Millionen Euro Series-A-Kapital und 6 Millionen Euro öffentliche Fördergelder – heben die Gesamtfinanzierung des Unternehmens auf ein neues Level. Angeführt wird die Runde von HG Ventures und Suma Capital, unterstützt von Co-Investoren wie der Oetker Collection und dem EIC Fund.

Doch das Geld ist nur der Treibstoff für eine strategische Evolution. Aus Circu Li-ion wird R3 Robotics. Der neue Name ist Programm: Repair, Reuse, Recycle. Antoine Welter erklärt die Motivation hinter der Umbenennung pragmatisch: „Circu Li-ion hat beschrieben, wo wir angefangen haben. R3 Robotics beschreibt, was wir aufbauen: industrielle Robotik, die Demontage skalierbar, sicher und kosteneffizient macht.“

Wenn der Roboter Augen bekommt

Die größte Hürde im Recycling ist nicht die Chemie, sondern die Variabilität. Kein Batteriepack gleicht dem anderen, E-Motoren sind unterschiedlich verbaut, Schrauben sind korrodiert. Starre Fertigungsstraßen scheitern hier. R3 Robotics löst dies mit einer Plattform, die Computer Vision, künstliche Intelligenz und Robotik verschmilzt.

Das System fungiert dabei fast wie ein „ChatGPT für die physische Welt“: Anstatt Text zu generieren, plant die KI physische Handlungen. Sensoren scannen das Bauteil, die KI erkennt den Zustand und promptet den Roboterarm dynamisch durch den Demontageprozess. Der entscheidende Vorteil: Der Mensch wird aus der Gefahrenzone der Hochspannung genommen, während der Roboter Aufgaben erledigt, die für klassische Automatisierung zu komplex wären.

Angesprochen auf den Vergleich mit Generative AI und die Frage, wie die Roboter tatsächlich „sehen“ und „entscheiden“, bestätigt Welter die Parallele: „Der Vergleich mit Generative AI passt gut: Das Modell bekommt einen Input – keinen Text, sondern einen Scan des Bauteils – und generiert daraus eine Handlungssequenz.“ Es gehe darum zu erkennen, um welches Modell es sich handelt, wie der Zustand ist und wo die Verbindungspunkte liegen. „Das klingt simpel, ist es aber nicht – kein Pack ist identisch“, so Welter. Die eigentliche Herausforderung liege jedoch in der Entscheidung davor: „Welche Reihenfolge ist sicher? Ein falscher Griff an ein Hochvoltsystem kann tödlich sein. Unser System sieht, bewertet und entscheidet.“

Smart Hardware: Warum das Rad neu erfinden?

Ein Detail, das Investor*innen besonders aufhorchen lässt, ist die Kapitaleffizienz der Gründer. Wer an Industrie-Robotik denkt, denkt an teure Hardware-Entwicklung. R3 Robotics geht einen pragmatischen Weg: Ein Großteil der verwendeten Hardware wird „von der Stange“ gekauft.

Die Roboterarme sind Standardprodukte. Die Innovation – und damit das geistige Eigentum – steckt in den spezialisierten „End-Effektoren“ (den Roboterhänden), den Sensorsystemen und vor allem dem Software-Stack, der alles steuert. Das erlaubt eine Skalierung, die mit proprietärer Hardware kaum möglich wäre. Mitgründer Dr. Xavier Kohll betont, dass dies eine bewusste Entscheidung gegen „Over-Engineering“ war: „Der Roboterarm ist Standard und die Intelligenz sitzt in den Endeffektoren, der Sensorik und dem Software-Stack, der alles zusammenbringt. Das ist unser geistiges Eigentum, und genau das lässt sich skalieren.“

David gegen Goliath – oder Partner?

Während große Recycling-Konzerne oft noch auf den Schredder setzen und die manuelle Demontage an ihre Grenzen stößt, positioniert sich R3 Robotics in einer neuen Nische. Es geht nicht darum, die Chemie-Giganten zu ersetzen, sondern ihnen den Rohstoff so rein wie möglich zu liefern – als strategische Quelle für kritische Materialien. Doch der Markt schläft nicht: Weltweit entstehen Initiativen zur Automatisierung.

Trotz des aktuellen „Gegners“ – dem Menschen mit dem Schraubenzieher – und potenzieller Konkurrenz durch Tech-Start-ups oder Autohersteller, bleibt Welter gelassen. „Wir konkurrieren nicht mit den Chemie-Giganten, wir liefern ihnen den reinsten möglichen Stoffstrom“, stellt er klar. Gegenüber potenziellen Nachahmern sieht er einen entscheidenden Vorteil, den „Unfair Advantage“: die Kombination aus Flexibilität und industrieller Automatisierungstiefe. „Wir sind aktuell die einzige Plattform, die sowohl Variabilität managt als auch für kontinuierlichen Industriebetrieb ausgelegt ist.“

Deutschland als Labor, USA als Skalierungsmarkt

Die Wachstumsstrategie von R3 Robotics ruht auf zwei massiven Säulen: technologischer Tiefe in Europa und kommerzieller Breite in den USA.

Deutschland fungiert dabei als das technologische Rückgrat. Mit der Erweiterung der Anlage in Karlsruhe zur Lighthouse Facility demonstriert das Unternehmen industrielle Leistungsfähigkeit direkt vor der Haustür der großen Autobauer. Hier wird die Technologie gehärtet. Das zeigt sich auch im Leuchtturmprojekt ReDriveS, wo R3 Robotics Seite an Seite mit Giganten wie Schaeffler und VW an der Demontage von E-Achsen arbeitet.

Doch für das massive Volumen blickt das Team über den Atlantik. Der für 2026 geplante Markteintritt in den USA ist Kern der neuen Strategie. Die frischen 20 Millionen Euro sollen gezielt in den Aufbau strategischer Partnerschaften vor Ort fließen, um die Technologie dort auszurollen, wo Pragmatismus auf riesige „End-of-Life“-Volumina trifft. Für Welter ist dieser Doppelschlag essenziell: „Deutschland ist unser Beweisstand. Hier zeigen wir Schaeffler, VW und Co., dass unsere Technologie industriellen Maßstäben in Deutschland standhält.“ Die USA seien hingegen der wichtige Skalierungsmarkt, wo pragmatische Entscheider auf gigantische Volumina treffen. „Beides brauchen wir: die Glaubwürdigkeit aus Europa und das Volumen aus Amerika.“

Industrialisierung statt Romantik

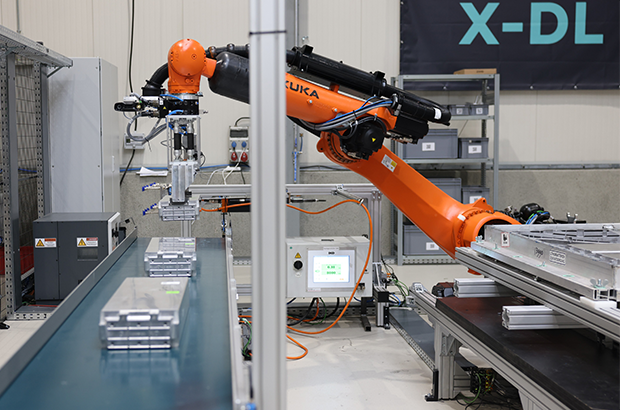

Mit Peter Mohnen, dem ehemaligen CEO des Roboter-Riesen KUKA, holte sich das Start-up zudem einen Beirat, der wie kaum ein anderer weiß, was Industriestandard bedeutet. Er beschreibt den Ansatz von R3 als Beweis für die nötige Automatisierungsexpertise, um Variabilität und Sicherheit gleichzeitig zu managen.

Um diese Expertise weiter auszubauen, wächst das Team rasant. Die Belegschaft soll mit der neuen Finanzierung massiv aufgestockt werden, vor allem im Bereich Engineering und KI. R3 Robotics hat den Beweis erbracht, dass Kreislaufwirtschaft kein ökologisches Nischenprojekt sein muss, sondern ein harter industrieller Prozess ist, der sich rechnet.

Denn letztlich, so das Fazit von Antoine Welter, sei Automatisierung der einzige Weg, das Problem wirklich zu lösen – nicht allein aus ökologischen Gründen, sondern weil es wirtschaftlich Sinn ergibt. „Was wir aufbauen, ist am Ende ein harter industrieller Prozess: Er muss zuverlässig funktionieren und sich rechnen.“ Es gehe aber um mehr als ein Geschäftsmodell: „Europa braucht eine Antwort auf die Frage, woher seine kritischen Materialien in Zukunft kommen“, mahnt Welter abschließend. „Wenn Europa diesen Zugang sichern will, braucht es Unternehmen, die genau das industriell umsetzen können. Dafür bauen wir diese Infrastruktur, und mit dem neuen Kapital und Team haben wir jetzt die Mittel dazu.“

VESTIO: Wenn ein Solar-Entrepreneur auf einen Stil-Rebellen trifft

Die Geschichte der jungen FashionTech-App VESTIO ist zugleich die zweier Gründer, die sich in einem gemeinsamen Ziel treffen: Die Demokratisierung von gutem Stil durch algorithmische Logik.

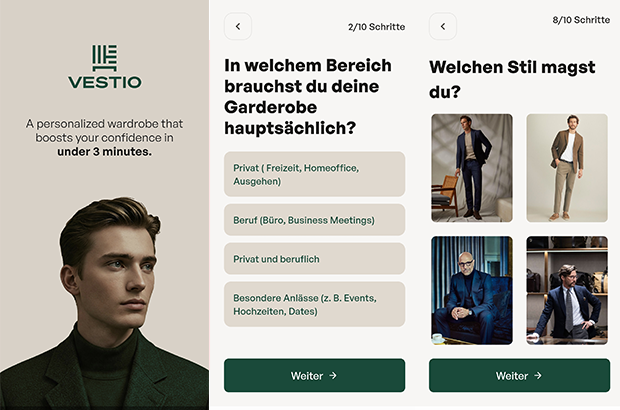

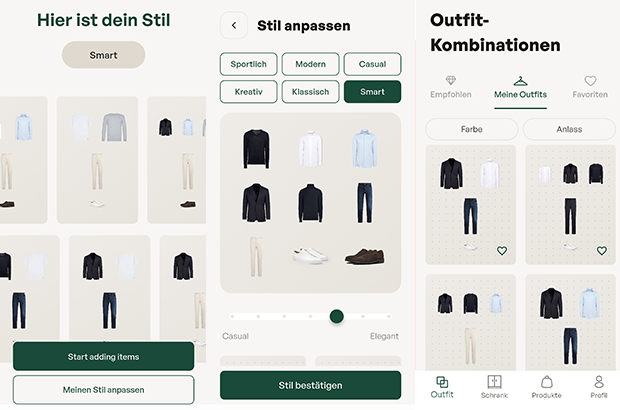

Hinter der FashionTech-App VESTIO steht die im Jahr 2024 von Bastian Arend und Justus Hansen gegründete Opus Stilberater GmbH, die den Anspruch erhebt, professionelle Stilberatung erstmals digital, logisch und kostenlos zugänglich zu machen.

Der „Solar-Entrepreneur“ trifft den Stil-Rebell

Die persönlichen Hintergründe der Gründer bieten spannende Kontraste, die weit über ein übliches Business-Profil hinausgehen. Bastian Arend, Co-Founder und CEO, kam über die Energiewende zur Mode. Als Seriengründer baute er den Online-Solar-Anbieter Klarsolar auf und verkaufte ihn im Dezember 2023 erfolgreich an den Energiekonzern E.ON. Die Übernahme erfolgte in einer für die Solarbranche schwierigen Marktphase, was Bastian Arend als Krisen-erprobten Strategen auszeichnet.

VESTIO entwickelte er 2024 jedoch aus einem ganz persönlichen „Pain Point“ heraus: Während er internationale Millionen-Finanzierungsrunden leitete, bestand sein eigener Stil mangels Zeit lediglich aus Hoodie, Jeans und Sneakern. „Ich wollte nur jemanden, der für mich einkauft“, erinnert er sich an diese Phase. Seine Abneigung gegen zeitraubendes Shopping führte ihn schließlich zu Justus Hansen.

Justus Hansen, Co-Founder und Chief Styling Officer, bringt eine Biografie ein, in der Mode schon immer eine zentrale Rolle spielte. Sein Gespür für klassische Mode ist tief verwurzelt: Justus Hansen trug bereits im Kindergarten eine Fliege und provozierte später Lehrer, indem er im Sakko zum Unterricht erschien. Bevor er mit über 1,6 Millionen Follower*innen zu einem der bekanntesten Männerstilberater Deutschlands aufstieg, studierte er Jura und absolvierte Praktika im Bankensektor, unter anderem bei der Dresdner Bank.

Diese Erfahrungen schärften seinen Blick für die Anforderungen moderner „Business-Garderoben“. Als Arend ihn fragte, ob er für ihn einkaufen könne, antwortete Justus Hansen bestimmt: „Einfach irgendwas kaufen? Nein. Ich muss verstehen, wer du bist.“ Bastian Arend begriff Hansens modulare Styling-Methode sofort als logisches System und schlug vor: „Wir sollten deine Methode digitalisieren und kostenlos für jeden Mann zugänglich machen.“ Für Justus Hansen wurde damit ein „Lebenstraum“ wahr.

Das Konzept: „Weniger Teile, mehr Outfits“

Das Herzstück der App bildet ein algorithmisches Styling-System, das strikt dem Leitsatz „Weniger Teile. Mehr Outfits“ folgt. In nur drei Minuten erstellt ein Stilfinder-Fragebogen eine persönliche Grundgarderobe. Der digitale Kleiderschrank funktioniert dabei bewusst ohne das mühsame Hochladen von Fotos; das System kennt die wichtigsten Basics, erkennt Lücken und empfiehlt gezielt Ergänzungen. Justus Hansen betont dabei die Wichtigkeit der Basis: „Die wenigsten Männer besitzen eine echte Basisgarderobe. Und das ist die Grundlage, aus der ihre besten Outfits entstehen.“

Ziel ist es, automatisch kombinierbare Outfits für alle Anlässe zu generieren. Dabei verfolgen die Gründer eine klare ästhetische Linie: „Outfits müssen nicht kompliziert sein, um zu wirken. Sie brauchen lediglich eine klar erkennbare Linie“, so Hansen. Bastian Arend ergänzt: „Die besten Outfits für Männer sind nicht kompliziert, sondern harmonisch und durchdacht.“

Das Affiliate-Dilemma: Geschäftsmodell im kritischen Check

Wirtschaftlich operiert VESTIO über ein Affiliate-Modell. Die App ist für Nutzer kostenlos, während das Unternehmen Provisionen von Partner-Anbietern bei einem erfolgreichen Kauf erhält. Hier liegt für den kritischen Betrachter ein interessanter systemischer Interessenkonflikt: Das erklärte Ziel „Weniger Konsum – bessere Entscheidungen“ steht ökonomisch potenziell im Widerspruch zu einem Modell, das von Transaktionen lebt. Zudem stellt sich die Frage der langfristigen Nutzerbindung: Sobald ein Mann seine „perfekte Garderobe“ aufgebaut hat, sinkt der Bedarf für weitere Anschaffungen. Dass das Unternehmen dennoch auf Wachstum setzt, zeigt die Erhöhung des Stammkapitals auf knapp 30.000 Euro im September 2025. Langfristig plant VESTIO die Integration eines Marktplatzes, der Partnerprodukte und eigene Kollektionen vereint, um basierend auf Daten den größten Mehrwert zu liefern.

Marktpositionierung und technologischer Vorsprung

Im Vergleich zum Wettbewerb besetzt VESTIO eine spezifische Nische. Während Curated-Shopping-Anbieter (z.B. Outfittery) auf den Versand physischer Boxen setzen, bleibt VESTIO ein rein digitaler Guide, der dem Nutzer die volle Freiheit bei der Wahl des Händlers überlässt. Andere Styling-Apps verlangen oft zeitintensive Foto-Inventuren, während VESTIO auf logische Kombinationen setzt.

Das Risiko bleibt jedoch die Abhängigkeit von der Personal Brand Justus Hansens. Letztlich ist VESTIO der Versuch, Mode so effizient wie eine Prozessoptimierung zu gestalten – oder wie Bastian Arend es formuliert: „Viele Männer haben mehr Kleidung als Stil. Vestio ändert das.“ Mit dem Aufbau der App wolle man Männern „genau diese Arbeit abnehmen“, damit sie sich ultimativ „besser fühlen“ können.

Von der Kochbox zum Hundenapf: Ex-HelloFresh-Duo startet Tasty Petfood

Wie Lisa Vannini und Nadja Chylla mit ihrem Start-up Tasty Petfood die etablierten Premium-Tierfuttermarken herausfordern.

Das Berliner Start-up Tasty Petfood ist offiziell in den Markt eingetreten. Das Unternehmen, gegründet von den ehemaligen HelloFresh-Kolleginnen Lisa Vannini und Nadja Chylla, positioniert sich im Premium-Segment für Hundefutter und setzt dabei auf ein digitales Vertriebsmodell. Der offizielle Marktstart in Deutschland und der Schweiz erfolgte am 6. Februar 2026.

Transfer von Food-Logistik auf den Heimtiermarkt

Die Gründerinnen arbeiteten zuvor über fünf Jahre gemeinsam beim Kochboxen-Versender HelloFresh. Das dort in den Bereichen Skalierung und Operations gewonnene Know-how wollen Lisa und Nadja nun auf den Heimtiermarkt übertragen.

„Wir haben gemerkt, dass viele Hundehalter entweder bei klassischem Trockenfutter bleiben oder sehr viel Zeit in aufwendige BARF-Konzepte investieren müssen. Genau diese Lücke zwischen Bequemlichkeit und echter Qualität wollten wir schließen“, berichtet Lisa.

Das Kernprodukt von Tasty Petfood unterscheidet sich logistisch von herkömmlichem Nassfutter oder Barf-Angeboten: Das Unternehmen vertreibt dampfgegartes Frischfutter im Glas. Ein wesentlicher Unterschied zu vielen Wettbewerbern im Frische-Segment ist die Haltbarmachung: Die Produkte benötigen keine geschlossene Kühlkette und können ungekühlt gelagert werden. Dies reduziert die Komplexität in der Lagerhaltung und im Versand erheblich – ein Faktor, der im D2C-Bereich direkten Einfluss auf die Unit Economics hat. „Unser Anspruch war Qualität wie selbstgekocht – aber ohne Kühlschrank und ohne komplizierte Logistik. Dass wir Frische, Haltbarkeit und Alltagstauglichkeit verbinden können, ist für viele Kundinnen und Kunden ein echter Gamechanger“, sagt Nadja.

Wachstumskurs in einem Milliardenmarkt

Mit ihrem Geschäftsmodell stoßen die Gründerinnen in ein wirtschaftlich hochattraktives Umfeld vor. Nach aktuellen Daten des Industrieverbands Heimtierbedarf (IVH) und des Zentralverbands Zoologischer Fachbetriebe (ZZF) liegt der Gesamtumsatz der Branche bei rund sieben Milliarden Euro, wobei allein das Segment für Fertignahrung gut 4,4 Milliarden Euro ausmacht. Trotz allgemeiner wirtschaftlicher Herausforderungen bleibt die Zahlungsbereitschaft der Halter hoch.

Während der Absatz im Standard-Segment teils stagniert, wächst der Bereich für Premium-Nahrung kontinuierlich. Tasty Petfood ordnet sich im oberen Preissegment ein und zielt auf eine kaufkräftige Zielgruppe, die den Trend zur „Humanisierung“ des Haustiers vorantreibt.

„Hunde werden heute immer stärker als Familienmitglieder gesehen. Entsprechend steigen die Ansprüche an Transparenz, Zutatenqualität und Nährstoffversorgung – ähnlich wie beim eigenen Essen“, so Lisa.

Die Nische zwischen Konzern und Tiefkühltruhe

In diesem dynamischen Umfeld muss sich Tasty Petfood gegen zwei Lager behaupten. Zum einen konkurriert das Start-up mit etablierten Premium-Marken im stationären Handel wie Terra Canis, das als Pionier für „Human Grade“-Nahrung gilt und seit 2017 mehrheitlich zum Nestlé-Konzern gehört. Zum anderen wächst der Druck durch rein digitale Player wie Butternut Box oder HelloBello, die ebenfalls auf personalisiertes Frischfutter setzen, dieses jedoch tiefgekühlt versenden.

Genau hier besetzt Tasty Petfood eine strategische Lücke: Start-ups fungieren in diesem Sektor aktuell als wesentliche Innovationstreiber, und die Berliner Gründerinnen nutzen dies für eine „Ambient Fresh“-Strategie. Mit ungekühlt haltbarem Frischfutter verbindet das Unternehmen den steigenden Wunsch nach Convenience mit der Qualität von Frische-Menüs – ein entscheidender Logistik-Vorteil gegenüber der aufwendigen Tiefkühl-Konkurrenz. „Wir sitzen genau zwischen Tiefkühltruhe und Trockenfutter. Unser Futter ist reisefähig, blockiert keinen Gefrierschrank und passt damit perfekt in den Alltag moderner Hundehalter“, sagt Nadja.

Datengetriebenes Abo-Modell

Der Bestellvorgang für den/die Endkund*in ist vollständig datengestützt aufgebaut. Zu Beginn erfassen Interessent*innen über ein Online-Quiz relevante Parameter wie Rasse, Alter und Gewicht des Tieres. Auf Grundlage dieser Daten berechnet das Unternehmen einen individuellen Futterplan, der exakt auf den Hund zugeschnitten ist. Um die Akzeptanz zu testen, erhalten Neukund*innen zunächst eine Probebox mit verschiedenen Sorten. Bei erfolgreicher Annahme geht das Modell automatisch in ein flexibles Abonnement über, bei dem sowohl die Rationsgröße als auch der Lieferrhythmus dynamisch an den tatsächlichen Bedarf des Hundes angepasst werden. „Viele Halter sind unsicher, ob sie ihren Hund wirklich bedarfsgerecht füttern. Unser Algorithmus nimmt ihnen diese Entscheidung ab und sorgt dafür, dass Menge und Nährstoffe langfristig passen“, so Lisa.

Positionierung im Premium-Segment

Das Produktportfolio umfasst zum Start sechs Sorten auf Monoprotein-Basis. Durch den hohen Fleischanteil und den Verzicht auf Füllstoffe oder Konservierungsmittel zielt das Start-up auf die „Human Grade“-Nische ab. Das Produkt ist dabei so designt, dass es optisch und qualitativ an selbstgekochtes Futter erinnert, um die Hürde für qualitätsbewusste Käufer*innen zu senken. Das Kalkül: Die Zielgruppe sucht die Qualität einer BARF-Ernährung, benötigt aber die Convenience eines Fertigprodukts. „Unser Ziel ist es, Pet Nutrition durch sichtbare Qualität und Transparenz neu zu definieren“, so Nadja über den Anspruch, moderne Halterbedürfnisse mit dem Produkt-Design zu adressieren.

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

KI als neuer Ort für Kaufentscheidungen

Das Start-up publuence.ai zeigt am Beispiel der Automobilbranche, wie Marken in generativen KI-Antworten sichtbar werden und warum das zum neuen Erfolgsfaktor wird.

2025 haben wir euch das Start-up publuence.ai von Cevahir Ejder als "Gründer*in der Woche" präsentiert. Publuence.ai ist eine SaaS-Lösung für AI Search Analytics für Marken, die täglich analysiert, wie sichtbar Marken in generativen KI-Antworten sind: bei welchen Fragen erscheinen sie, wie werden sie erwähnt und welche Inhalte sowie Quellen beeinflussen die Antworten. Da die KI-Sichtbarkeit zunehmend darüber entscheidet, ob eine Marke in der engeren Auswahl der Konsumenten stattfindet, sind die Ergebnisse für Unternehmen strategisch sehr relevant.

Beispiel Automobilbrache: KI wird zum Verkaufsberater, Chatfenster zum Showroom

Während Marketing- und Kommunikationsbudgets weiterhin nach klassischen Logiken verteilt werden, fällt ein entscheidender Teil der Markenbildung inzwischen außerhalb des Mediaplans: KI-Systeme beantworten Kauf- und Vergleichsfragen oft lange bevor Kampagnen greifen. Anhand der Automobilbranche etwa, in der Marken wie Volkswagen für eine ganze Industrie stehen, zeigt sich, dass sich Sichtbarkeit im KI-Dialog zum neuen Machtfaktor entwickelt. Sie entscheidet zunehmend darüber, welche Hersteller überhaupt in die engere Auswahl kommen.

Was früher im Autohaus oder auf Herstellerwebsites stattfand, spielt sich heute in KI-gestützten Beratungsgesprächen ab. Nutzer*innen stellen dort Fragen wie: „Welche E-Autos sind familienfreundlich?“ „Wie gut ist die Reichweite im Winter?“ „Welche Modelle laden am schnellsten?“

In der Initialanalyse erzielt beispielsweise VW im Themenbereich E-Autos – je nach Fragestellung bzw. Prompt – Sichtbarkeitswerte zwischen 20 und 88 Prozent. Damit prägen die Antworten frühzeitig das Bild, das Konsument*innen von der Marke haben. Wer dort nicht vorkommt beziehungsweise seine Mehrwerte nicht sichtbar macht, wird in der Entscheidungsfindung schlicht nicht berücksichtigt.

Tesla und Hyundai vorn, VW im Mittelfeld

Das aktuelle Wettbewerbsranking der führenden Automobilhersteller – basierend auf 30 relevanten KI-Prompts rund um das Thema Elektromobilität – zeigt, wie präsent die einzelnen Marken im neuen digitalen Beratungsraum sind. Mit knapp 64 Prozent Sichtbarkeit führt Tesla klar und profitiert von seiner technologischen Positionierung sowie einer starken Medienpräsenz. Überraschend landet Hyundai insbesondere im E-Auto-Segment mit mehr als 58 Prozent dahinter. Volkswagen erreicht solide, aber deutlich ausbaufähige 51 Prozent.

Doch es geht nicht nur um Quantität, die Analyse zeigt auch, wo das Bild der Marken ins Wanken gerät. Im Fall von VW sind es vor allem Themen wie Winterreichweite, Ladeinfrastruktur und Schnellladekosten, die negative Ausschläge erzeugen. Diese kritischen Inhalte sind es allerdings, die die Markenwahrnehmung und dementsprechend auch die konkreten Kaufentscheidungen beeinflussen.

Die stille Macht der Quellen: Medien, die prägen

Eine zentrale Erkenntnis der Analyse von publuence.ai ist, dass KI-Systeme nicht auf Basis eines objektiven Querschnitts des Internets antworten. Vielmehr orientieren sie sich an bestimmten Medienquellen, deren Inhalte überproportional stark einfließen und so die Darstellung von Marken maßgeblich mitformen. Umso wichtiger ist es für Marken zu verstehen, auf welche Fragen sie reagieren müssen – und über welche vertrauenswürdigen Medien sie in den Wissensraum der KI gelangen.

Dabei zeigen sich je nach Medium erhebliche Unterschiede in der Tonalität. Während focus.de sowie adac.de E-Mobilität eher wohlwollend behandelt, sind andere Portale kritischer. Für Unternehmen bedeutet das: Wer verstehen will, wie KI über die eigene Marke spricht, muss wissen, welche Inhalte sie beeinflussen.

Warum Marken nicht an KI-Monitoring vorbeikommen

Publuence.ai bietet Unternehmen ein strukturiertes, datenbasiertes Werkzeug, um ihre Sichtbarkeit in KI-Systemen wie ChatGPT, Google oder Perplexity zu analysieren und darauf aufbauend gezielt zu steuern. Die Plattform zeigt, welche Fragen zur Marke führen, wie die Antworten ausfallen, welche Medien zugrunde liegen und wo Wettbewerber besser abschneiden.

Besonders wichtig ist die Identifikation von Content- und Sentiment-Gaps. Sie erkennt Themenfelder, in denen eine Marke kaum oder gar nicht auftaucht, obwohl sie dort relevant sein sollte. Gleichzeitig analysiert sie, ob etwas positiv, negativ oder neutral erwähnt wird. Dies macht publuence.ai für Kommunikations-, Marketing- und Markenverantwortliche zum zentralen Steuerungsinstrument. Nur wer versteht, wie KI antwortet, kann Inhalte gezielt darauf anpassen, Medienarbeit datenbasiert ausrichten und so die eigene Markenpräsenz dort stärken, wo die Entscheidungen heute vorbereitet werden.

KI-Sichtbarkeit wird zur Basis für Markterfolg

Cevahir Ejder, Gründer und GF der publuence GmbH, fasst zusammen: „Kaufentscheidungen beginnen heute und auch in Zukunft im Dialog mit KI-Systemen. Marken, die dort nicht auftauchen, sind raus.“ Volkswagen steht dabei stellvertretend für viele Unternehmen, die ihren Fokus noch auf klassische Marketingkanäle legen und den digitalen Showroom der KI bislang kaum berücksichtigen. Ejder warnt: „Wer jetzt nicht handelt, riskiert, neben Reichweitenverlusten, einen tiefgreifenden Bedeutungsverlust im Moment der Entscheidung.“

Social Engineering auf dem Vormarsch

Wie Deepfakes die Sicherheit von Führungskräften stärker in den Fokus rücken.

Fotorealistische KI liefert innerhalb von kürzester Zeit realistische Visuals. Was in vielerlei Hinsicht den Arbeitsalltag erleichtert, bedeutet für Social Engineering jedoch eine neue Eskalationsstufe, wie nicht zuletzt die hitzige Debatte um massenhaft sexualisierte Deepfakes von realen Personen durch Grok eindrücklich vor Augen führte.

Auch Personen in leitenden Funktionen in Unternehmen sind vor solchen Manipulationen nicht gefeit. Zunehmend zielen Angriffe auf Menschen mit Zugriffsrechten und Entscheidungsbefugnissen, deren Freigaben unmittelbare Wirkung auf die Sicherheit einer ganzen Organisation haben. „Fotorealistische KI und hybride Social-Engineering-Kampagnen erhöhen den Druck auf Schlüsselpersonen. Daher brauchen Unternehmen belastbare Verifikationsprozesse, Krisenroutinen und integrierte Schutzkonzepte“, erklärt Markus Weidenauer, geschäftsführender Gesellschafter der SecCon Group GmbH.

Deepfakes zielen auf privates Umfeld

Nach Angaben des Bundesamts für Sicherheit in der Informationstechnik (BSI) lassen sich Deepfakes als Verfahren beschreiben, die gezielt Spear-Phishing und andere Social-Engineering-Angriffe nutzen, um Vertrauen aufzubauen und Autorität zu simulieren. Generative KI fungiert dabei als zentraler technischer Enabler, da sie die realistische Erzeugung manipulativer Audio-, Video- und Textinhalte erstmals in industriellem Maßstab ermöglicht. „Die eigentliche Bedrohung ergibt sich dabei nicht aus einzelnen KI-generierten Inhalten, sondern aus deren koordinierter Nutzung“, weiß der Sicherheitsexperte.

Infolge der steigenden Qualität und der zunehmenden Verfügbarkeit generativer KI wird es darüber hinaus zunehmend schwieriger, Fakt von Fiktion zu unterscheiden „Zwar können isolierte Inhalte für sich betrachtet zweifelhaft sein, doch das konsistente Zusammenspiel mehrerer manipulierter Medieninhalte erhöht die wahrgenommene Glaubwürdigkeit erheblich“, ergänzt der Profi und weist darauf hin, dass sich diese Entwicklung in der Praxis zuspitzt. „Social Engineering, Deepfakes und digitale Erpressung werden immer häufiger mit Observationen des privaten Umfelds sowie Angriffen auf die Heim-IT kombiniert. Durch diese Eskalation der Angriffsmittel bauen Täter gezielt psychologischen Druck auf, der die Widerstandsfähigkeit der Betroffenen weiter reduziert.“

Risiken kennen, Wege einüben

Kompromittierte Schlüsselpersonen mit Steuerungs- und Entscheidungsfähigkeiten bergen hohes Schadenspotenzial für Betriebe. Das reicht von unmittelbaren finanziellen Verlusten bis zu dauerhaften Reputationsschäden. Dieses Risiko wird insbesondere dort verstärkt, wo organisatorische und prozessuale Absicherungen fehlen. „Resilienz bedeutet aber, auch in potenziellen Krisensituationen sichere Entscheidungen treffen zu können“, betont Markus Weidenauer. Trotzdem mangelt es vielen Unternehmen sowohl an speziellen Trainings zum Thema Social Engineering als auch an Meldewegen, klaren Freigabeprozessen, die auch unter Druck funktionieren, sowie alternativen Kommunikationskanälen. „Nur wenn Mitarbeiter diese Strukturen kennen und regelmäßig einüben, entsteht eine Kultur, in der eine frühzeitige Eskalation in der Meldekette als notwendiger Beitrag zur Sicherheit des gesamten Betriebs wahrgenommen wird“, fügt Markus Weidenauer hinzu.

Dringender Handlungsbedarf in Unternehmen

Um hier Abhilfe zu schaffen, verabschiedete im September 2025 das Bundeskabinett das sogenannte KRITIS-Dachgesetz zur Stärkung der Resilienz kritischer Einrichtungen. Es verpflichtet die Unternehmensleitung, Schutz- und Präventionsmaßnahmen umzusetzen, deren Wirksamkeit nachzuweisen ist. Der dem Regelwerk zugrunde liegende All-Gefahren-Ansatz fordert, dabei physische, digitale und organisatorische Dimensionen gemeinsam zu betrachten. „Auch wenn Führungskräftesicherheit hier kein eigener Rechtsbegriff ist, sollte sie Teil der Anforderungen an ein modernes Sicherheitsmanagement sein“, so der Geschäftsführer der SecCon Group.

Das bedeutet: Führungskräfte etwa vor Erpressungsversuchen durch Social Engineering zu schützen, ist weder persönlicher Luxus noch Symbolpolitik, sondern ein Element der nachweisbaren Unternehmensresilienz. Schließlich ist die Sicherung von Steuerungs- und Entscheidungsfähigkeit ein Governance-Baustein. Nicht die Person steht im Mittelpunkt, sondern die Handlungsfähigkeit des Instituts.