Aktuelle Events

Der 5-Sterne-Gründer

Rolf Schrömgens zeigt, wie man einen Welterfolg bauen kann. Mit Trivago hat er die größte Online-Hotelsuche geschaffen, sein Unternehmen erfolgreich an die Nasdaq gebracht und zu einer milliardenschweren Tech-Company gemacht.

Hotel? Trivago!“ Den Slogan, vorgetragen von dem charmant-nuschelnden TV-Werbemann mit französischem Akzent, kennen rund 90 Prozent aller Deutschen. Und weltweit klicken 1,4 Milliarden Menschen auf trivago.de, wenn sie im Internet nach einem Hotel suchen, statt den Weg über die Google-Suche zu nehmen. Wie aber schafft man es, eine Art von Google für etwas zu werden – also das Synonym für eine Dienstleistung, eine Branche, eine Branchenlösung? Also etwas zu werden, das von sehr vielen wie selbstverständlich genutzt wird, ohne dass man so recht weiß, wer die Köpfe dahinter sind. Es gibt zahlreiche ambitionierte Start-ups, die vollmundig damit werben, das Google für etwas zu sein oder zumindest in Bälde werden zu wollen. Bei den meisten dieser Aussagen handelt es sich schlichtweg um PR-Slogans bzw. um ein Sich-mit-fremden-Federn-Schmücken.

Sich mit fremden Federn zu schmücken war und ist mit Sicherheit nicht das Ding von Rolf Schrömgens, dem 41-jährigen Gründer von Trivago, der weltweit führenden Meta-Suchmaschine für Hotels. Er und seine Mitstreiter Malte Siewert und Peter Vinnemeier haben es in rund 12 Jahren geschafft, ein Tech-Unternehmen aufzubauen, das an der US-Börse notiert ist, das aktuell mit über 4 Milliarden US-Dollar bewertet wird und damit zu einem der hierzulande äußert seltenen sog. Unicorns gehört, das bislang auf eher leisen PR-Pfaden unterwegs ist. Höchste Zeit, dass sich das ändert.

Höchste Zeit also, die Gründer- und Erfolgsstory von Trivago zu erzählen, also den Weg der ersten deutschen Suchmaschine für Hotels hin zur weltweit größten Online-Hotelsuche, die nichts weniger leistet, als die Preise bzw. Preisänderungen für rund 1,3 Millionen Hotels in über 190 Ländern zu ermitteln, zu analysieren und zu speichern. Die Gründerstory aus Düsseldorf zeigt, wie ein Welterfolg entstehen kann, basierend auf dem Gespür für eine Idee und deren Transformation zu einem wirtschaftlich tragfähigen und zukunftsweisenden Geschäftsmodell. Trivago ist zugleich die Story eines der wenigen deutschen Start-ups, das trotz eines millionenschweren Exits – übrigens der drittgrößte in der deutschen Start-up-Geschichte – operativ noch fest in Gründerhand ist und dies wohl auch weiter bleiben wird.

Rolf Schrömgens erzählt offen, konkret und verbindlich, ohne Pathos oder gespielte Bescheidenheit von seinem Weg, der eine Lehrstunde in Company Building und Change Management ist und schlichtweg der Stoff, aus dem große Tech-Erfolge wachsen können.

Der Weg ins digitale Business

Rolf stammt aus Mönchengladbach, wo seine Familie seit Generationen ein Restaurant hat. Er wächst in und mit der Gastronomie auf und stellt dabei rasch fest, dass er nicht in die familiären Fußstapfen treten will. Stattdessen startet Rolf nach dem Abi mit einem klassischem BWL-Studium in Essen, wechselt dann nach dem Vordiplom 1997 an die private HHL Leipzig Graduate School of Management und nimmt einen Kredit auf, um dort seinen Abschluss machen zu können.

An der Leipziger Uni herrscht eine regelrechte Gründerstimmung. Die Hochschule ist neu, „man wusste noch nicht so genau, was der Abschluss dort letztlich wert wäre, es war also schon ein gewisses Risiko, dorthin zu gehen, und so waren auch die Leute dort eingestellt. Es waren sehr unternehmerisch denkende Leute, ganz viele von meinen ehemaligen Kommilitonen sind heute selbst Unternehmer“, berichtet Rolf. „Und letztlich habe ich dort, bereits am ersten Tag, meine Partner kennen gelernt, mit denen ich dann später Trivago gegründet habe.“

Im Sommer 1999 – Rolf befindet sich nach Beendigung eines Auslandssemesters auf dem Rückflug von Chicago nach Frankfurt – liest er einen großen Artikel über die Samwers, die gerade Alando für 50 Mio. US-Dollar an Ebay verkauft hatten, und realisiert bei der Lektüre, dass er offensichtlich in einer ungewöhnlichen Zeit lebt, in der unternehmerisch sehr viel möglich ist. „Und das wollte ich nutzen“, so Rolf rückblickend über diese gedankliche Initialzündung. Statt ein weiteres Praktikum zu machen, arbeitet er an seinem Hochschulabschluss und parallel dazu mit seinen Kommilitonen Stephan Stubner und Peter Vinnemeier an seinem ersten Start-up, dem Verbraucherportal Amiro.de. Um dies zu realisieren, bringt Rolf sich selbst das Programmieren bei.

Das Amiro-Konzept ist so einfach wie erfolgreich: Statt Firmen ihre eigenen Waren und Dienstleistungen aus den Bereichen wie Autos, Handys, Computer, Bücher, Musik, Sport und Spiel anpreisen zu lassen, urteilen die Verbraucher selbst über Qualität und Preis und veröffentlichen ihre Meinung auf der Plattform. Anfang 2000 fusioniert Amiro mit seinem direkten Wettbewerber Ciao.de. Ciao ist damit die größte Online-Meinungs-Community Europas.

Rolf bleibt in dem neuen Unternehmen, bis er Mitte 2001 die Segel streicht und aussteigt. „Letztlich waren nach rund einem Jahr – auch aufgrund der vielen Investoren – nur noch sehr wenige eigene Anteile übrig, wir (also Rolf und seine Amiro-Mitgründer, Anm. d. Red.) waren an einem Punkt angelangt, an dem wir immer weniger Einfluss auf die Unternehmensgeschicke hatten. Wir waren mehr Manager als Unternehmer und haben uns einfach nicht mehr wohl gefühlt in der Situation“, erläutert Rolf seinen Ausstieg.

Wikipedia für Reisende

Der Start von Trivago – der Name ist übrigens ein reines Kunstwort – erfolgt dann in Düsseldorf Anfang 2005. Das Ziel des Gründerteams bestehend aus Rolf Schrömgens, Peter Vinnemeier und Stephan Stubner (Letzterer scheidet 2006 aus der Geschäftsleitung aus und wird von Malte Siewert abgelöst) ist es zunächst, „eine Firma zu gründen, mit der wir uns über Wasser halten können und die uns unsere Miete bezahlt“, erklärt Rolf. Und wichtig ist ihm von Anfang an „bei einem neuen Anlauf alles anders zu machen, nichts künstlich aufzublasen, nicht um jeden Preis möglichst viel Kapital aufzusaugen. Es war unsere Philosophie, mit sehr wenig Kapital zu gründen“. Die Geschäftsidee der Gründer ist es, mit Trivago „eine kommerzialisierte Version von Wikipedia für Reisen zu entwerfen“, erklärt Rolf. „Also ein Wikipedia aufzubauen, neue Artikel schreiben zu lassen und letztlich Werbetreibende aus der Reiseindustrie an den Umsätzen zu beteiligen.“ Das Konzept: Content verbunden mit klassischem Advertising – 2005 eine moderne und lohnende Einnahmequelle.

Das Allesmacher-Dilemma

Geld verdienen die Gründer mit neben den Texten platzierten Anzeigen bzw. Pop-ups, für die nicht selten bis zu 120 Euro TKP (Tausend-Kontakt-Preis) bezahlt werden. Und das Konzept hat, so Rolf, auch eine Zeit lang gut funktioniert. „Wir konnten unsere Miete zahlen und halbwegs davon leben.“ Aber das ändert sich, als die ersten Advertiser anfangen, genauer darauf zu achten, was ihre Werbung einbringt, sprich, was an Buchungen zurückkommt. Da kam es schon mal vor, berichtet Rolf, dass ein Werbetreibender 2000 Euro investiert hatte und nur eine Buchung dafür bekam. Das Problem: „Die Werbung war nicht zielgerecht platzierbar“, erläutert Rolf. Die jungen Unternehmer versuchen dies ihren Werbepartnern klar zu machen. Das heißt, ihnen zu vermitteln, dass sie bspw. im Umfeld eines redaktionellen Beitrags über den Eiffelturm auch Werbung zu Paris platzieren sollten. „Aber das war halt damals nicht möglich, weil die Anbieter die technischen Voraussetzungen dafür nicht leisten konnten bzw. wollten“, so Rolf.

Daher kommen die Gründer zu der Erkenntnis: „Ok, wenn ihr uns das nicht geben könnt, dann machen wir das halt selbst, sprich programmieren selbst.“ Funnel-Optimierung muss her, also die Möglichkeit, dass die Werbung aus dem Netz passgenau zu dem betreffenden Content auf die Seite findet. Gesagt, getan. Doch das nächste Problem wartet bereits. Denn oft kommt es vor, dass bspw. als Werbung zu einem Eiffelturm-Artikel dann fünf Mal die gleichen Hotels von unterschiedlichen Werbeanbietern mit unterschiedlichen Preisen angezeigt werden, was ja nicht unbedingt im Sinne der Werbetreibenden und der Plattformnutzer ist.

Daher machen Rolf und seine Mitstreiter wiederum aus der Not eine Tugend und entwickeln auch dafür eine Lösung: „Das einzige, was wir tun konnten war, eine eigene Datenbank aufzubauen, um darüber die Hotels zu vermatchen, sodass wir dann praktisch nur noch einmal das Hotel anzeigen, und alle Preise darunter packen können.“ Das ist der erste Schritt hin zu dem heutigen Trivago-Geschäftsmodell.

Der zweite Schritt dahin ist eine weitere folgenreiche Erkenntnis: „Anfangs haben wir den Fokus aufs Schreiben gelegt. Dann haben wir festgestellt, dass uns die Leute nicht mehr benutzt haben, um die Artikel zu lesen, sondern letztlich dazu, einen Preisvergleich zu machen. Unsere Kompetenz war es also, die unterschiedlichen Hotelanbieter zusammenzubringen“, so Rolf. Diese Fokussierung bzw. Spezialisierung erfolgt zwar nicht von jetzt auf gleich, die Basis dafür ist aber gelegt. „Wir sind immer gewachsen: an uns, an den Aufgaben. Und wir haben uns immer weiterentwickelt und zwar immer schneller als die Leute außenrum.“

Ein weiterer Pluspunkt ist, dass die Gründer – als Lerneffekt aus der Amiro-Zeit – nur wenig Fremdkapital (rund 1 Mio. Euro) von Investoren wie den Start-up-Größen Florian Heinemann, Lukasz Gadowski oder den Samwer-Brüdern aufnehmen. „Wir hatten schon drauf geachtet, keine institutionellen Investoren zu haben, die auf einen Verkauf ausgerichtet waren, sondern wir wollten andere Gründer haben, die privat investiert haben“, so Rolf. Das ermöglicht den Trivago-Chefs, möglichst beweglich bzw. unabhängig zu bleiben.

Es dauert dann noch rund zwei Jahre, bis die Gründer sich dazu entschließen, ihr Businessmodell klar

zu definieren bzw. es finden. Denn letztlich müssen sie erst noch erkennen, dass der eingeschlagene Weg dauerhaft nicht funktionieren kann. „Wir waren noch von dieser romantischen Idee der Community getragen, die sich selbst administriert und so weiter, und haben das auch noch eine Zeit lang vorangetrieben, bis wir dann in die Situation kamen, dass uns das Geld ausgegangen ist“, erläutert Rolf und ergänzt: „Wir machten zu viele Sachen gleichzeitig. Wir haben nicht nur die Community gemacht, sondern auch Bewertungen der Hotels eingesammelt, wir haben Software für Reisebüros gemacht und Software für große Konsumgüterunternehmen, die ihre Reisen über uns abgewickelt haben, um Umsatz zu machen, und haben uns dabei sehr verzettelt.“

Trivago-Mission-Statement

Diese akute Krisensituation und die damit verbundene Gefahr, Mitarbeiter entlassen zu müssen, setzt bei dem Unternehmer-Trio neue Kräfte frei. „Ich denke, dass Leute immer dann am besten funktionieren, wenn es einen Druck gibt und man einfach nochmal Dinge überdenkt und bereit ist, alte Zöpfe abzuschneiden“, so Rolf. Kurzerhand schotten sich die drei Geschäftsführer von allen Alltagsgeschäften ab, quartieren sich drei Tage lang in einem Düsseldorfer Hotel ein, buchen sich dort einen Meetingraum und gehen in Klausur. Dabei heraus kommt ein Mission Statement, das im Prinzip bis heute nicht mehr verändert worden ist und zu einer Art von Guiding Light geworden ist, auf dessen Grundlage seit 2008 jedes Jahr die Strategien im Unternehmen ausgerichtet bzw. abgeglichen werden.

Im Zuge dieses Mission Statements fällen die drei Geschäftsführer drei fundamentale Entscheidungen. „Die erste war, dass wir nur noch Hotels machen wollen, die zweite, dass wir nur eine Hochtechnologie sein wollen (also kein Content-Unternehmen mehr, sondern eine Tech-Company mit einer Meta-Suchmaschine ausschließlich für Hotels, Anm. d. Red.), und die dritte war, eine Marke aufzubauen“, erläutert Rolf. „Das wollten wir die nächsten Jahre abliefern.“

Die Entscheidung, sich ausschließlich auf Hotels zu spezialisieren, begründet Rolf damit, dass Hotels die eigentliche innere Ressource von Trivago sind und dass der Fokus auf die Hotelsuche dem klaren Kundenwunsch bzw. -nutzen geschuldet ist. Darüber hinaus ist die Hotelsuche, so Rolf, im Gegensatz zu einer Flugsuche emotional, weil es dabei große Unterschiede gibt – sowohl was die Anbieter angeht als auch die Hotels mit ihren Angeboten und Ausstattungen. „Sich selbst in das ideale Hotel zu bringen, ist erst mal eine riesige Aufgabe“, definiert Rolf das eigentlich zu lösende Problem. Und das ist nicht allein eine Frage des Preises. „Der Preisvergleich ist die absolut notwendige Voraussetzung. Ich glaube aber nicht, dass man eine gute Suche bauen kann, wenn man kein unabhängiger Marktteilnehmer ist, der nicht alle Seiten durchsucht“, führt Rolf weiter aus. Daher ist es das Ziel, alle verfügbaren Hotels von allen Anbietern mit allen Preisen listen zu können. Das ist

das technologische Pflichtprogramm. „Letztendlich ist die Kür aber die Frage, wie ich das für mich am besten passende Hotel finde“, ergänzt Rolf.

In Sachen Markenaufbau – dem Punkt drei des Mission Statements – gibt Rolf das Motto aus: „We want to be the First and the Independent.“ Das strategische Ziel ist es, dauerhaft die erste, direkte und unabhängige Anlaufstelle bzw. der Erstkontakt für Hotelsuchende zu sein, die dann idealerweise nicht mehr über Google kommen, was eine große Abhängigkeit und hohe Kosten bedeutet, sondern Trivago direkt ansteuern. Also schlichtweg besser als andere Suchmaschinen zu sein und damit im Idealfall das Google der Hotelsuche.

Das Geschäftsmodell

Die Marschrichtung ist damit vorgegeben, Rolf und seine Mitstreiter arbeiten ab sofort daran, aus ihrem Gemischtwaren-Unternehmen einen Spezialisten zu formen. Der Erfolg gibt ihnen recht. In den folgenden Jahren bauen sie mit Trivago die erste deutsche Meta-Suche für Hotels auf und verfolgen parallel dazu die konsequente Internationalisierung ihres Angebots bzw. ihrer Plattform. Zunächst expandiert man in Europa, dann folgen Nord- und Südamerika und ab 2013 ist die Webseite schließlich auch auf dem asiatisch-pazifischen Markt vertreten.

Das Geschäftsmodell funktioniert dabei ähnlich wie das von Google. „Es gibt bei uns einen Marktplatz, da bieten die Anbieter um Aufmerksamkeit, und davon hängt es letztlich ab, wie viel Aufmerksamkeit Hotels dann bekommen“, erklärt Rolf. Es handelt sich also um eine Art Auktionsverfahren, über das die Anbieter ihre Wahrscheinlichkeit für Klicks verbessern können. Mit den Klicks, also dem Weiterleiten ihrer Nutzer auf die Seiten der Hotelanbieter, verdient Trivago Geld.

Die Umsätze steigen signifikant, 2012 werden bereits ca. 99 Mio. Euro eingefahren. Um organisch zu wachsen, verzichten die Gründer auf neues Fremdkapital. „Wir hätten deutlich schneller wachsen können. Aber wir hatten letztlich immer unsere Profitabilität zum Maßstab genommen für die Geschwindigkeit, mit der wir wachsen wollen,“ so der Trivago-Chef.

Mega-Exit ohne Ausstieg

Ende 2012 sorgt Trivago erstmals für große Schlagzeilen. Die Gründerszene verbucht einen der bis dato seltenen Mega-Exits eines deutschen Start-ups. Denn die US-Reiseportalgruppe Expedia erwirbt für ca. 477 Mio. Euro rund 62 Prozent der Geschäftsanteile an Trivago. Das Besondere an dem Mega-Deal: Neben Expedia bleiben nur Rolf und seine zwei Co-Gründer an Trivago beteiligt. Das ist auch der Grund, warum Rolf den Begriff Exit nicht so gern hört. „Für die Investoren, die ihre Anteile verkauft haben, war das toll. Wir Gründer haben das nie als Exit gesehen und haben damals mit knapp 40 Prozent des Unternehmens den überwiegenden Teil unserer Anteile behalten“, erklärt er. Und Expedia erhält auch nicht die Option, die Gründer aus dem Unternehmen herauszukaufen.

Als wichtigen Grund für den Deal gibt Rolf an, die zu diesem Zeitpunkt sehr fragmentierte Shareholder-Struktur bereinigen zu wollen. „Also haben wir einen Weg gesucht, selbst nur wenig zu verkaufen, um dafür aber strategisch langfristig einen Weg zu sehen, wieder unabhängiger zu werden.“ Und zu der Entscheidung für den Reise-Giganten äußert er sich wie folgt: „Mit Expedia hatten wir einen so großen Investor gefunden, dass wir mitschwimmen konnten, d.h., nicht immer auf die Quartalszahlen sehen oder reporten mussten und dabei Gefahr laufen, unsere Geschwindigkeit zu verlieren.“

Basierend auf diesem Exit wird Trivagos Wert 2012 auf rund 700 Mio. Euro geschätzt (ein Jahr später bereits auf gut 800 Mio. Euro). Das Unternehmen, zu diesem Zeitpunkt bereits die Nr. 1 der Online-Hotelsuche in Europa, nimmt weiter an Fahrt auf und investiert massiv in Mitarbeiter, Marketing und Werbung. So steigen seitdem letztlich die Umsätze, Gewinne werden allerdings bislang keine erzielt. 2013 wird ein Jahresumsatz in Höhe von ca. 185 Mio. Euro eingefahren, bis 2016 steigt der Umsatz auf 754,2 Mio. Euro. Die Zahl der Mitarbeiter steigt von unter 300 Personen im Jahr 2012 auf über 500 im Jahr 2015 – heute sind rund 1200 Personen bei Trivago aktiv, 90 Prozent davon in den Düsseldorfer Headquarters.

Der Weg zur Börse

Der nächste unternehmerische Paukenschlag folgt Ende 2016 mit dem Börsengang von Trivago. Es ist der zweitgrößte Börsengang eines Unternehmens aus Deutschland im Jahr 2016 nach Innogy. Zu diesem Zeitpunkt bewerten Analysten Trivago mit mehr als vier Milliarden US-Dollar – damit ist der Wert gut viermal so hoch wie der anvisierte Umsatz von rund einer Milliarde Euro im Jahr 2017.

Am 16. Dezember 2016 eröffnet Rolf an der Nasdaq in New York den Parketthandel. Auf die Frage, ob dies die logische Konsequenz aus dem Expedia-Einstieg gewesen sei, antwortet er: „Es war eine logische Entwicklung, ganz einfach, weil wir größer geworden sind und damit auch größer innerhalb der Expedia-Familie, und dann angefangen haben, die Quartalszahlen public zu machen –unter dem Expedia-Mantel –, und damit im Prinzip so reingewachsen sind, eine öffentlich gelistete Firma zu sein.“ Die Entscheidung für USA und die Nasdaq liegt auf der Hand. „Wir sehen uns als globales Tech-Unternehmen und die USA sind mit Abstand unser stärkster Markt.

Rund 25 Prozent unseres Umsatzes kommen von dort. Wir sind sehr international aufgestellt. Die anderen globalen Tech-Unternehmen in unserem Bereich, unsere Peers, sind alle an der Nasdaq gelistet“, erklärt Rolf. Er, Peter und Malte geben beim Börsengang einen Teil ihrer Unternehmensanteile als Aktien ab. Mit ihrem Geld investieren die Gründer unter anderem über ihre Wagniskapitalfirma Monkfish Equity in junge Start-ups wie Delivery Hero, Hello Fresh oder Moebel24. Die Trivago-Mutter Expedia behält ihre Anteile. Darüber hinaus werden zusätzliche Aktien ausgegeben.

Wohin geht die Trivago-Reise?

Was hat sich seit dem Börsengang verändert? Der tägliche Blick auf den Börsenkurs? „Es hat sich ehrlich gesagt kaum etwas verändert“, so Rolf. „Im täglichen Geschäft hält sich das sehr in Grenzen. Ich schau’ mir auch den Kurs nicht jeden Tag an. Aber ich finde, dass sich Trivago noch mal ein Stückchen besser anfühlt als vorher. Ich glaube, dass man jetzt die Identität noch mehr, noch stärker nach außen leben kann, was vorher nicht so der Fall gewesen war. Das lag vielleicht auch ein bisschen an uns.“

Die Aufmerksamkeit an der Marke Trivago und das frische Kapital kommen sehr gelegen. Denn der globale Online-Hotelmarkt ist umkämpft, langfristig werden nur die ganz Großen überleben. Zumal der Markt noch einiges an Wachstumsmöglichkeiten zu bieten hat. Unter allen Anbietern, die Hotels und mehr online vermitteln, sieht Rolf Google als größte Herausforderung: „Ich glaube, wenn es einen Wettbewerber gibt, dann ist es im Zweifel immer Google, obwohl wir Google in den letzten Jahren extrem viel Marktanteile abgenommen haben.“

Die Nase vorn haben wird derjenige, so Rolf, der im Hotelbereich die beste Suche baut. „Wir glauben, dass langfristig Spezialisten generell einen großen Vorteil haben werden. Das heißt, es wird nicht mehr darum gehen, Webseiten zu scrollen und so viele Informationen wie möglich zu durchsuchen und diese zu ranken, sondern in der Zukunft wird es mehr in Richtung eines persönlichen virtuellen Assistenten gehen, an den die Erwartungen in Sachen Suche weitaus höher sein werden.“ Und er konkretisiert: „Es geht uns also einerseits darum, herauszufinden, was der Suchende will und zum anderen herauszufinden, was ein Hotel so besonders macht, um diese Profile miteinander zu matchen.“ Kurzum: Jeder soll im Idealfall nur noch das auf seine aktuellen individuellen Bedürfnisse perfekt passende Hotel angezeigt bekommen. „Das ist eine riesige Aufgabe, an der wir arbeiten“, betont Rolf.

Und weil Trivago geschätzte 85 Prozent seines Umsatzes in weltweite TV- und Internet-Werbekampagnen steckt, um seine Markenbekanntheit weiter zu steigern, ist es unabdingbar, „die Profitabilität weiter nach oben zu bewegen, wir haben noch viel Potenzial.“ Denn obwohl Trivago betont, dass sein Schlüsselindikator, der Return on Advertising Spending, positiv sei, sprich, dass ein Werbe-Euro 2016 bereits 1,20 Euro Umsatz einbringe, muss noch viel Geld in Mitarbeiter, IT-Entwicklung und nicht zuletzt in den für 2018 geplanten Umzug des Unternehmens in den Düsseldorfer Medienhafen investiert werden. Dort entsteht für gut 200 Mio. Euro ein sechsgeschossiger campusartiger Bau im Silicon-Valley-Style mit Platz für mindestens 2000 Mitarbeiter. „Unser Ziel ist es, die besten Talente aus aller Welt anzuziehen. Mit 63 Nationalitäten, die sich ein Büro teilen, ist es sehr wichtig, dafür zu sorgen, dass sich alle wohlfühlen“, so ein Unternehmenssprecher.

Das Wohlfühlen ist natürlich kein Selbstzweck, sondern dient dem Ziel, zu motivieren und das gegenseitige Vertrauen in die Company zu festigen. „Wenn man sich vertraut, gibt man Fehler zu, probiert mehr aus als man es sich sonst ggf. trauen würde, teilt Informationen schneller und schafft damit eine Basis, auf der wir alle viel schneller lernen können“, so Rolf. „Was uns auszeichnet ist: Wir sind nicht immer gut, aber wir sind einfach besser darin, schneller besser zu werden.“ Und abschließend gibt der Trivago-Chef heutigen Gründern mit auf den Weg: „Bei uns hat es sich ausgezahlt, immer stärker nach innen als nach außen zu schauen, immer stärker auf den Kunden als auf die Konkurrenz zu schauen, nicht zu glauben, dass die anderen die Lösung schon gefunden haben, sondern selber zu denken.“

P.S.: Dieser Beitrag stammt aus dem Jahr 2017

Seit 2019 ist Rolf Schrömgens Founding Investor GRID GmbH und seit 2020 Co-Founder leadership.sprouts.

Diese Artikel könnten Sie auch interessieren:

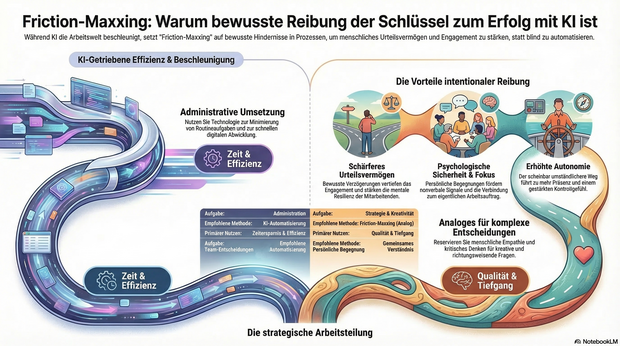

KI-Müdigkeit im Team? Warum Friction-Maxxing jetzt die Antwort ist

Nach all der Euphorie über KI-Tools macht sich bei immer mehr Menschen eine gewisse KI-Müdigkeit breit. Die Technologie hat die Arbeitswelt im Sturm erobert – doch in Unternehmen wachsen die Zweifel: Macht KI wirklich alles einfacher oder trägt sie sogar zu sinkendem Engagement bei? Dr. Arne Sjöström von Culture Amp erklärt, warum Unternehmen jetzt auf Friction-Maxxing setzen sollten.

Friction-Maxxing ist ein Trend aus dem Lifestyle-Bereich, der jedoch auch großes Potenzial für die Arbeitswelt und den strategischen Einsatz von KI in Unternehmen hat. Gemeint ist damit ein Verhalten, bei dem man bewusst mehr kleine Hindernisse und Hürden in Arbeitsprozessen akzeptiert.

Der große Vorteil: Durch eine bewusste Verzögerung wird das Urteilsvermögen geschärft, das Engagement vertieft und die mentale Resilienz der Mitarbeitenden gestärkt.

Friction-Maxxing als Gegengewicht zur KI-Dominanz

Insbesondere für Führungskräfte und das mittlere Management bietet Friction-Maxxing die Möglichkeit, produktive Reibung in Entscheidungsprozesse zurückzubringen. Durch die Rückkehr zu mehr persönlichen Begegnungen und analogen Arbeitsabläufen entstehen Dinge, die in digitalen Formaten schlicht verloren gehen:

- Konzentrierte Aufmerksamkeit.

- Psychologische Sicherheit.

- Wichtige nonverbale Signale.

Persönliche Begegnungen ermöglichen einen konstruktiven Austausch und helfen Teams dabei, ein gemeinsames Verständnis von Qualität zu entwickeln. Am Ende geht es nicht darum, unnötige Hürden aufzubauen, sondern das richtige Maß an „Reibung“ zu gestalten: Analoges für einen besseren Umgang mit Ambiguität, Kreativität und richtungsweisenden Entscheidungen – Digitales für die Umsetzung.

Fokus und Sinnhaftigkeit zurückerobern

Positive Reibung kann als dringend benötigtes Gegengewicht zur KI-getriebenen Beschleunigung in der Arbeitswelt fungieren und den Fokus wiederherstellen. Sei es durch das gründliche, manuelle Überdenken eines Briefings oder den bewussten Wunsch nach persönlichem Austausch anstelle eines asynchronen Chats. Wer sich Zeit zum Denken, Begegnen und Gestalten zurückerobert, ermöglicht es Teams, sich wieder mit ihrem eigentlichen Auftrag und ihren Ansprüchen zu verbinden – Qualitäten, die KI-Automatisierung allein niemals erreichen kann.

Dieses geänderte Verhalten führt zu mehr Präsenz, weniger Angst und einem gestärkten Gefühl der Kontrolle. Der bewusst gewählte, nur scheinbar umständlichere Weg kann somit zu mehr Autonomie und tieferer Zufriedenheit am Arbeitsplatz beitragen.

Ein Plädoyer für intentionale Reibung

Die Aufgabe moderner Führungskräfte ist es daher, bei menschenzentrierten Tätigkeiten ganz bewusst sogenannte intentionale Reibung herbeizuführen und KI parallel dazu zu nutzen, den täglichen administrativen Arbeitsaufwand zu minimieren.

Unternehmen müssen klar benennen, wo KI ihre Stärken hat und eingesetzt werden soll – und wo menschliche Fähigkeiten wie Empathie, Urteilsvermögen und kritisches Denken absolut unersetzlich sind. So gibt man Mitarbeitenden die Möglichkeit, sich auf die Arbeit zu konzentrieren, die wirklich zählt und echten Mehrwert schafft.

Friction-Maxxing ist somit weniger ein Plädoyer gegen die Technologie, sondern vielmehr ein Aufruf zur Intentionalität: Dem bewussten Abwägen darüber, wann Prozesse automatisiert werden sollten und wann gerade der Widerstand den entscheidenden Unterschied machen kann.

Der Autor Dr. Arne Sjöström ist Regional Director, People Science EMEA bei Culture Amp. Sein Schwerpunkt liegt in der Organisationspsychologie und der angewandten Forschung.

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

MedTech-Start-up RAYDIAX holt 7,5 Mio. Euro für neuartiges CT-System

RAYDIAX sichert sich 7,5 Mio. Euro, um mit einem speziell für minimal-invasive Eingriffe entwickelten Computertomographen die Krebsbehandlung zu verbessern. Doch der Weg vom universitären Forschungslabor in die globalen Operationssäle ist im hochregulierten Gesundheitsmarkt lang. Ein Blick auf ein DeepTech-Geschäftsmodell, das sich nun in der klinischen Praxis beweisen muss.

Die erfolgreiche Series-A1-Finanzierungsrunde über 7,5 Millionen Euro für RAYDIAX markiert einen wichtigen Meilenstein von der universitären Forschung in den Gesundheitsmarkt. Das 2022 gegründete Unternehmen mit Hauptsitz im Magdeburger Wissenschaftshafen ist eine Ausgründung des Forschungscampus STIMULATE und der Otto-von-Guericke-Universität Magdeburg. Unter der Führung eines fünfköpfigen Gründerteams – bestehend aus CEO Dr. Thomas Hoffmann, Dr. Tim Pfeiffer, Dr. André Mewes, Benjamin Fritsch und Robert Frysch – konnte das Start-up nach einer erfolgreichen Seed-Phase nun erhebliche Mittel für den Eintritt in die klinische Phase sichern.

Das frische Kapital setzt sich aus 5 Millionen Euro Venture Capital von bestehenden Business Angels, dem Bestandsinvestor bmp Ventures mit den IBG Fonds sowie dem neu eingestiegenen GETEC Family Office um Dr. Karl Gerhold zusammen. Ergänzt wird diese Summe durch 2,5 Millionen Euro Fördermittel aus dem hochkompetitiven EIC Accelerator-Programm der Europäischen Kommission, das gezielt disruptive Deep-Tech-Innovationen mit hohem Skalierungspotenzial unterstützt.

TACT: Computertomographie für den OP neu gedacht

Im Zentrum dieser ambitionierten Wachstumspläne steht der Therapieassistenz-Computertomograph „TACT“, den RAYDIAX dediziert für minimal-invasive Krebstherapien entwickelt. Anders als herkömmliche CTs optimiert das Unternehmen sein System sowohl im Hardware- als auch im Softwarebereich speziell für den interventionellen Einsatz bei der Therapieplanung, -durchführung und -kontrolle. Wie Steffen Schmidt, CFO der GETEC-Gruppe, hervorhebt, ermöglicht die innovative Technologie eine fokussierte Live-Bildgebung, welche die Strahlenbelastung für Patient*innen und Operateur*innen senkt und die Operationszeit verringert.

Zudem bietet das System durch eine größere Geräteöffnung völlig neue Operationsmethoden im CT, wie beispielsweise den Einsatz von Robotik. Der Markt für solche Lösungen wächst, da minimal-invasive Eingriffe angesichts einer alternden Bevölkerung und steigender Krebsinzidenzen massiv an Bedeutung gewinnen. Sie ermöglichen in vielen Fällen eine schonendere Behandlung im Vergleich zu offenen chirurgischen Eingriffen, verkürzen potenziell Operations- sowie Liegezeiten, verringern Komplikationen und können so zusätzliche Behandlungskapazitäten schaffen, um die Krankenhausstrukturen zu entlasten.

Harter Wettbewerb und regulatorische Hürden

Trotz der vielversprechenden Technologie steht das Geschäftsmodell in der Praxis vor erheblichen Herausforderungen. Der globale Markt für medizinische Bildgebung ist hart umkämpft, und der Vertrieb an Kliniken ist durch extrem lange, hochkomplexe B2B-Entscheidungszyklen geprägt. RAYDIAX tritt diesem Wettbewerb entgegen, indem es anstrebt, eine funktional dringend benötigte, neue Gerätekategorie in der interventionellen Onkologie zu etablieren, um so eine Lücke im OP-Betrieb zu füllen.

Der Beweisdruck auf dem jungen Unternehmen ist dennoch enorm: Das neu eingeworbene Kapital wird nun für First-in-Human-Studien eingesetzt, um die frühe klinische Evidenz am Patienten zu generieren. Diese Phase legt die Grundlage für die regulatorische Zulassung und kommerzielle Skalierung. Parallel dazu erfordert die Weiterentwicklung zur Serienreife einen konsequenten Ausbau in den Bereichen Vertrieb, Produktion und Qualitätsmanagement, um die ersten kommerziellen Installationen systematisch vorzubereiten.

Lehrstück für europäisches DeepTech

Dieser Fall zeigt eindrucksvoll die Realität und die hohen Anforderungen europäischen DeepTech-Unternehmertums. Der Abschluss dieser Finanzierungsrunde belegt deutlich, wie essenziell die intelligente Kombination aus wissenschaftlicher Grundlagenforschung, klassischem Risikokapital und strategischen europäischen Fördergeldern ist. Nur so lässt sich die extrem kapitalintensive Entwicklungsphase von Hardware in der Medizintechnik erfolgreich überstehen. Wenn es dem Gründerteam nun gelingt, die klinische Wirksamkeit in der Praxis zu belegen und die regulatorischen Hürden zu meistern, hat dieses Spin-off das Potenzial, die Anwendung minimal-invasiver Krebstherapien erheblich auszuweiten.

Primogene: Muttermilch als Vorbild

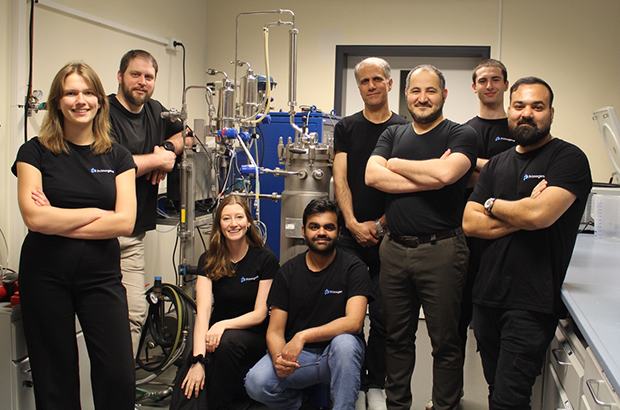

Primogene ist ein 2023 gegründetes BioTech-Start-up mit Sitz in Leipzig, das sich auf die Entwicklung biotechnologischer Herstellungsverfahren für bioidentische Inhaltsstoffe spezialisiert hat. Ein Schwerpunkt liegt auf Verbindungen, die der Muttermilch nachempfunden sind und die Gesundheit in allen Lebensphasen fördern können.

Auch wenn das Produkt als weißes Pulver eher unscheinbar aussieht, markiert seine Existenz einen wissenschaftlichen Meilenstein. „Wir haben eine spezielle Technologie entwickelt, dank der wir komplexe bioidentische humane Milchzucker skalierbar herstellen können“, erzählt Linda Karger, einst Managementstudentin an der Technischen Universität in München, heute COO der 2023 in Leipzig gegründeten Primogene GmbH. Die chemischen Verbindungen entsprechen also den im menschlichen Körper vorkommenden Molekülen bis ins kleinste biochemische Detail. Und sie übernehmen – obwohl industriell hergestellt – die gleichen Funktionen, die bisher nur Muttermilch garantierte.

Zum Verständnis: Die komplexen Zuckerstrukturen sind nach Fett und Laktose der drittgrößte feste Bestandteil menschlicher Milch. Sie bieten einzigartige gesundheitliche Vorteile, unterstützen beispielsweise das Immunsystem sowie die kognitive Entwicklung wie kein anderer Stoff. „Nach zahllosen Gesprächen mit Ärzten und Kliniken begann unsere Geschichte mit der Idee, nährstoffreiche Inhaltsstoffe als Zusatz für die Ernährung von Frühgeborenen herzustellen. Weitergedacht können bioaktive Bestandteile der Muttermilch ebenso zur Krankheitsprävention bei Erwachsenen sinnvoll eingesetzt werden“, erklärt Karger. „Um das Wirkungspotenzial unserer Human Milk Oligosaccharides (HMO) weiter zu erforschen, testen wir diese aktuell in enger Zusammenarbeit mit dem Leipziger Fraunhofer-Institut für Zelltherapie und Immunologie.“

Produktsortiment in der Breite offen

Gleichzeitig wird die von Dr.-Ing. Reza Mahour (CEO, Experte für Bioverfahrenstechnologie) und Valerian Grote (CTO, Molekularbiologe/Experte für Analytische Biochemie) entwickelte enzymatische Technologie genutzt, um bioidentische Moleküle für andere Märkte zu erzeugen, beispielsweise Inhaltsstoffe für Produkte der Körperpflege oder Rohmaterialien für die Pharmaindustrie. „Wir produzieren selbst. Dabei lässt sich jedes unserer Produkte auf die spezielle Technologie zurückführen. Unseren Kunden bieten wir Komplettlösungen – das reicht von der Suche nach der richtigen Produktionsplattform bis hin zu Entwicklung und Produktion“, bestätigt Karger. Erste Umsätze wurden nach ihren Angaben bereits früh erzielt. Inhaltsstoffe für den Kosmetikbereich sollen noch in diesem Jahr mithilfe bestehender Partnerschaften am Markt eingeführt werden. Im Pharmabereich wird ebenfalls mit ersten Kunden zusammengearbeitet.

Karger ergänzt: „Wir haben früh auf Partnerschaften und Vorbestellungen gesetzt, um den Markt besser zu verstehen.“ Um die bereits verabredeten hochwertigen Roh- und Inhaltsstoffe bald in größeren Mengen liefern zu können, ist das aktuell elfköpfige Team von Primogene gerade innerhalb Leipzigs umgezogen. Für die anstehende Skalierung war der Wechsel auf eine Betriebsstätte mit mehr Laborfläche und größerem Produktionsbereich wichtig. Große Mitspieler auf dem Feld der HMOs wie die niederländische DSM-Firmenich oder der dänische Konzern Chr. Hansen schrecken Karger nicht: „Bekannt sind mehr als 200 verschiedene HMOs, davon sind bisher sieben strukturell einfacher industriell herstellbar und auf dem Markt. Sie werden mit einer Fermentationstechnologie produziert. Unser enzymatisches Verfahren kann deutlich mehr und komplexere Zuckerstrukturen hervorbringen. Außerdem reicht unsere Produktpalette weit über HMOs hinaus.“

Sichtbarkeit durch Innovationsplattform futureSax erleichtert Investorensuche

Das bisher benötigte Kapital stammt unter anderem von Business Angels aus dem Bereich der Biotechnologie, darunter auch Climate Founders, bei deren Accelerator-Programm Mahour Grote und Karger einst zusammenfanden. Für Primogene als forschungs- und deshalb kapitalintensives Biotech-Unternehmen sind daneben die Mittel aus Förderprogrammen des Landes Sachsen und der Stadt Leipzig von wesentlicher Bedeutung. Darüber hinaus profitiert das Start-up noch heute von der Sichtbarkeit, die es durch den Gewinn des dritten Platzes beim Sächsischen Gründerpreis 2024 erhielt. Zunächst sorgten der professionelle Nominiertenfilm und die begleitende Öffentlichkeitsarbeit von futureSax für Aufmerksamkeit sowohl in den Medien als auch innerhalb des Netzwerks.

Dann bot die Preisübergabe auf der Sächsischen Innovationskonferenz vor über 1.000 Gästen Primogene eine wichtige Gelegenheit zur Präsentation. „Sachsen ist ein Innovationsstandort mit besonderer Dichte: Exzellente Forschung, starke Industrie- und Mittelstandsstrukturen und eine wachsende Start-up-Szene greifen ineinander. Hier entstehen Lösungen, die international wettbewerbsfähig sind. Entscheidend ist der Schulterschluss im Ökosystem – von Hochschulen über Unternehmen bis zu Kapitalgebern. futureSax schafft dafür die Bühne und die Verbindungen, damit aus Ideen schneller Produkte, Partnerschaften und Gründungen werden“, erklärt Susanne Stump, Geschäftsführerin der Innovationsplattform des Freistaats Sachsen. Das Interesse großer Investoren bestätigt, dass Primogene auf dem richtigen Weg ist. Im Jahr 2025 schloss das innovative Start-up eine Seed-Finanzierungsrunde mit namhaften Investoren wie HTGF, TGFS, der Sächsischen Beteiligungsgesellschaft und better ventures ab. Das geplante Personalwachstum sowie die Produktionsaktivitäten der nächsten zwei Jahre sind damit gesichert.

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen: https://t1p.de/p8gop

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

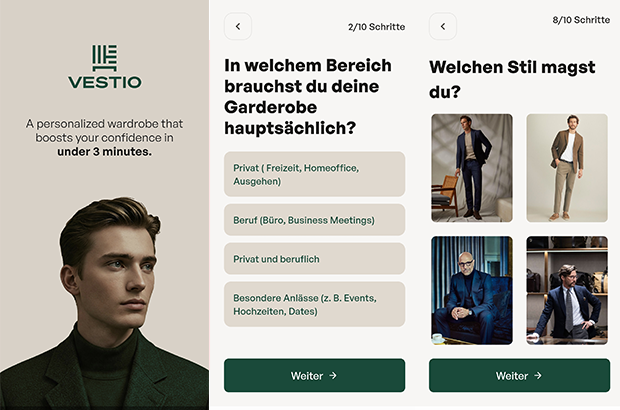

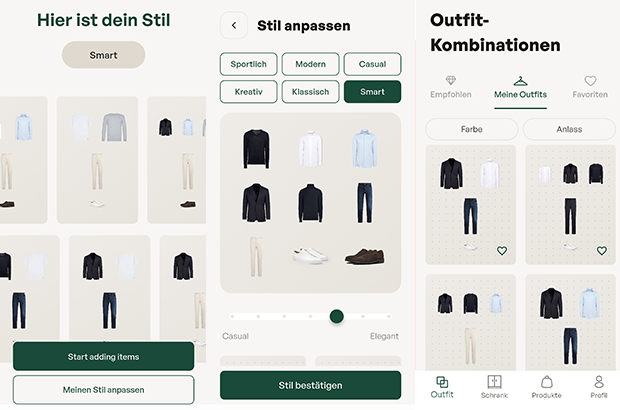

VESTIO: Wenn ein Solar-Entrepreneur auf einen Stil-Rebellen trifft

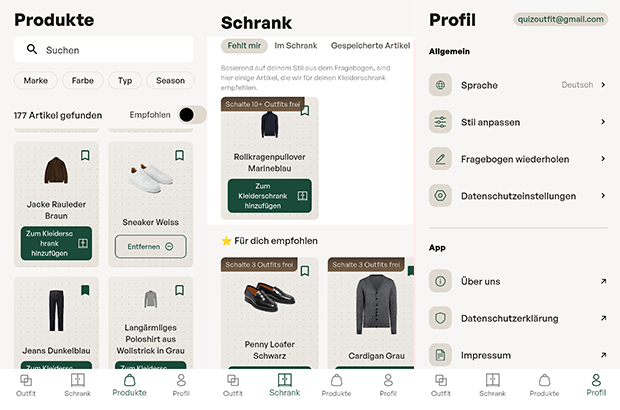

Die Geschichte der jungen FashionTech-App VESTIO ist zugleich die zweier Gründer, die sich in einem gemeinsamen Ziel treffen: Die Demokratisierung von gutem Stil durch algorithmische Logik.

Hinter der FashionTech-App VESTIO steht die im Jahr 2024 von Bastian Arend und Justus Hansen gegründete Opus Stilberater GmbH, die den Anspruch erhebt, professionelle Stilberatung erstmals digital, logisch und kostenlos zugänglich zu machen.

Der „Solar-Entrepreneur“ trifft den Stil-Rebell

Die persönlichen Hintergründe der Gründer bieten spannende Kontraste, die weit über ein übliches Business-Profil hinausgehen. Bastian Arend, Co-Founder und CEO, kam über die Energiewende zur Mode. Als Seriengründer baute er den Online-Solar-Anbieter Klarsolar auf und verkaufte ihn im Dezember 2023 erfolgreich an den Energiekonzern E.ON. Die Übernahme erfolgte in einer für die Solarbranche schwierigen Marktphase, was Bastian Arend als Krisen-erprobten Strategen auszeichnet.

VESTIO entwickelte er 2024 jedoch aus einem ganz persönlichen „Pain Point“ heraus: Während er internationale Millionen-Finanzierungsrunden leitete, bestand sein eigener Stil mangels Zeit lediglich aus Hoodie, Jeans und Sneakern. „Ich wollte nur jemanden, der für mich einkauft“, erinnert er sich an diese Phase. Seine Abneigung gegen zeitraubendes Shopping führte ihn schließlich zu Justus Hansen.

Justus Hansen, Co-Founder und Chief Styling Officer, bringt eine Biografie ein, in der Mode schon immer eine zentrale Rolle spielte. Sein Gespür für klassische Mode ist tief verwurzelt: Justus Hansen trug bereits im Kindergarten eine Fliege und provozierte später Lehrer, indem er im Sakko zum Unterricht erschien. Bevor er mit über 1,6 Millionen Follower*innen zu einem der bekanntesten Männerstilberater Deutschlands aufstieg, studierte er Jura und absolvierte Praktika im Bankensektor, unter anderem bei der Dresdner Bank.

Diese Erfahrungen schärften seinen Blick für die Anforderungen moderner „Business-Garderoben“. Als Arend ihn fragte, ob er für ihn einkaufen könne, antwortete Justus Hansen bestimmt: „Einfach irgendwas kaufen? Nein. Ich muss verstehen, wer du bist.“ Bastian Arend begriff Hansens modulare Styling-Methode sofort als logisches System und schlug vor: „Wir sollten deine Methode digitalisieren und kostenlos für jeden Mann zugänglich machen.“ Für Justus Hansen wurde damit ein „Lebenstraum“ wahr.

Das Konzept: „Weniger Teile, mehr Outfits“

Das Herzstück der App bildet ein algorithmisches Styling-System, das strikt dem Leitsatz „Weniger Teile. Mehr Outfits“ folgt. In nur drei Minuten erstellt ein Stilfinder-Fragebogen eine persönliche Grundgarderobe. Der digitale Kleiderschrank funktioniert dabei bewusst ohne das mühsame Hochladen von Fotos; das System kennt die wichtigsten Basics, erkennt Lücken und empfiehlt gezielt Ergänzungen. Justus Hansen betont dabei die Wichtigkeit der Basis: „Die wenigsten Männer besitzen eine echte Basisgarderobe. Und das ist die Grundlage, aus der ihre besten Outfits entstehen.“

Ziel ist es, automatisch kombinierbare Outfits für alle Anlässe zu generieren. Dabei verfolgen die Gründer eine klare ästhetische Linie: „Outfits müssen nicht kompliziert sein, um zu wirken. Sie brauchen lediglich eine klar erkennbare Linie“, so Hansen. Bastian Arend ergänzt: „Die besten Outfits für Männer sind nicht kompliziert, sondern harmonisch und durchdacht.“

Das Affiliate-Dilemma: Geschäftsmodell im kritischen Check

Wirtschaftlich operiert VESTIO über ein Affiliate-Modell. Die App ist für Nutzer kostenlos, während das Unternehmen Provisionen von Partner-Anbietern bei einem erfolgreichen Kauf erhält. Hier liegt für den kritischen Betrachter ein interessanter systemischer Interessenkonflikt: Das erklärte Ziel „Weniger Konsum – bessere Entscheidungen“ steht ökonomisch potenziell im Widerspruch zu einem Modell, das von Transaktionen lebt. Zudem stellt sich die Frage der langfristigen Nutzerbindung: Sobald ein Mann seine „perfekte Garderobe“ aufgebaut hat, sinkt der Bedarf für weitere Anschaffungen. Dass das Unternehmen dennoch auf Wachstum setzt, zeigt die Erhöhung des Stammkapitals auf knapp 30.000 Euro im September 2025. Langfristig plant VESTIO die Integration eines Marktplatzes, der Partnerprodukte und eigene Kollektionen vereint, um basierend auf Daten den größten Mehrwert zu liefern.

Marktpositionierung und technologischer Vorsprung

Im Vergleich zum Wettbewerb besetzt VESTIO eine spezifische Nische. Während Curated-Shopping-Anbieter (z.B. Outfittery) auf den Versand physischer Boxen setzen, bleibt VESTIO ein rein digitaler Guide, der dem Nutzer die volle Freiheit bei der Wahl des Händlers überlässt. Andere Styling-Apps verlangen oft zeitintensive Foto-Inventuren, während VESTIO auf logische Kombinationen setzt.

Das Risiko bleibt jedoch die Abhängigkeit von der Personal Brand Justus Hansens. Letztlich ist VESTIO der Versuch, Mode so effizient wie eine Prozessoptimierung zu gestalten – oder wie Bastian Arend es formuliert: „Viele Männer haben mehr Kleidung als Stil. Vestio ändert das.“ Mit dem Aufbau der App wolle man Männern „genau diese Arbeit abnehmen“, damit sie sich ultimativ „besser fühlen“ können.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

Wie viel verdienen Twitch Streamer wirklich? Zahlen und Verdienstmöglichkeiten im Blick

Wer als passionierter Spieler noch nicht an eine Gaming Karriere gedacht hat, sollte dies jetzt nachholen: Schließlich ergeben sich aus dieser von Esport-Turnieren bis hin zum Streaming einige Verdienstmöglichkeiten. Creatoren verdienen mit der Echtzeit-Übertragung ihres Spielerlebnisses Geld. Was sich einfach anhört, kann für so manchen Spieler auch zum komplexen Unterfangen werden. Wie hoch der Streamer Verdienst in diesen Fällen ausfällt und welche Einnahmemöglichkeiten es für Twitch Streamer noch gibt, erfahren Sie hier.

Die Top 10 Twitch Streamer im Jahr 2025

„Es gewinnt nicht der beste Spieler, sondern der beste Entertainer.“ |

Auf Plattformen wie Twitch gilt: Die Community beeinflusst stark, wie viel Geld Streamer verdienen können. Wer eine starke Zuschauergemeinde aufbauen kann, freut sich in der Regel über ein höheres Einkommen – dabei spielt vor allem die Interaktion der Viewer eine zentrale Rolle.

Aktuell weisen diese top 10 Twitch Channels die höchsten Zuschauerzahlen vor:

Streamer | Durchschnittliche Zuschauerzahl | Follower |

126.449 | 19,8 Millionen | |

52.024 | 7,9 Millionen | |

46.844 | 3,3 Millionen | |

36.903 | 2,2 Millionen | |

29.320 | 2,2 Millionen | |

71.045 | 1,5 Millionen | |

31.839 | 1,5 Millionen | |

42.837 | 1,4 Millionen | |

34.996 | 1,1 Millionen | |

30.438 | 993.817 |

Geld verdienen mit Streaming: Diese Faktoren wirken sich auf Twitch Einnahmen aus

Die Twitch-Einnahmen der verschiedenen Streamer setzen sich aus unterschiedlichen Verdienstquellen zusammen. So können die Kontoinhaber Werbung in ihren Live-Übertragungen schalten, die ihnen je nach Zuschauerzahl und Länge der Werbepause einen kleinen bis mittleren Betrag einbringen. Hierbei handelt es sich jedoch um ein eher statisches Nebeneinkommen, das die meisten Streamer auch als nebensächlich empfinden. Den größeren Teil des Twitch Einkommens machen Abonnements und Spenden der Zuschauer aus, aber auch Sponsoring und Markenpartnerschaften.

Übrigens: Twitch Auszahlungen erfolgen automatisch via PayPal oder Banküberweisung, sofern ein gewisser Mindestbetrag erreicht wurde. In diesem Zusammenhang bieten mobile casinos, ähnlich wie Streaming-Plattformen, eine bequeme Möglichkeit für Spieler, jederzeit und überall zu spielen, ohne auf traditionelle Zahlungsmethoden angewiesen zu sein. Diese Art von Plattformen hat sich zu einer beliebten Option entwickelt, da sie den Nutzern schnelle Auszahlungen und einfache Handhabung bieten.

Twitch Daten Leak 2021: Das verdienen Top-Streamer

Ende 2021 wurde die bekannte Plattform Twitch gehackt. Bei einem Datenleck kam heraus, dass die 2014 von Amazon gekaufte Plattform kaum Sicherheitsvorkehrungen geschaffen hatte – weshalb große Teile des Programmiercodes sowie Login-Daten und Zahlen zum Streamer Verdienst veröffentlicht werden konnten. Zu sehen waren vor allem die Gesamteinnahmen der Top Spieler aus den Twitch Statistiken des Zeitraumes August 2018 bis Oktober 2021 in US-Dollar:

- CriticalRole: 9,6 Millionen

- xQc: 8,5 Millionen

- summit1g: 5,8 Millionen

- Tfue: 5,3 Millionen

- Nickmercs: 5,1 Millionen

Zum Vergleich: Der deutsche Twitch Streamer Marcel Eris (alias MontanaBlack88) hat über Twitch 2,4 Millionen US-Dollar eingenommen. Der Streamer MontanaBlack88 gehört zu den bestbezahlten deutschen Spielern auf Twitch.

Damit werden die großen Unterschiede zwischen den Verdiensten der Streamer aus Deutschland und den USA deutlich. Rund vier Millionen Deutsche verfolgen Twitch-Übertragungen – und das sogar täglich. In den USA liegt die tägliche Zuschauerzahl bei stolzen 35 Millionen Nutzern, sodass amerikanische Streamer auch einen deutlich größeren Markt bedienen und die Einkommensunterschiede nicht verwunderlich sind. MontanaBlack88 ist allerdings auch auf anderen Plattformen wie YouTube zu finden, sodass sein Gesamtverdienst womöglich deutlich höher liegt.

Gut zu wissen: Twitch Partner (von Twitch ausgewählte Streamer mit qualitativem Content) können sich über höhere Einnahmen freuen – etwa einen höheren Anteil aus dem Abonnenten-Verdienst.

Im Detail: So setzt sich der Verdienst zusammen

Wie eingangs erwähnt, verdienen Twitch Streamer vor allem durch Abonnenten einen großen Teil ihres Einkommens. Das Abonnement kostet Subscribern in der ersten Stufe 4,99 Euro – wovon Streamer in der Regel 50% (2,50 Euro) behalten dürfen. Dafür erhalten Abonnenten bestimmte Vorteile wie etwa die Möglichkeit, per Chat mit dem Streamer interagieren zu können. Wer also 1.000 Abonnenten hat, kann deshalb schon mit Einnahmen von 2.500 Euro monatlich rechnen.

Einen Großteil ihrer Einnahmen generieren Gaming-Streamer aber auch mit Hilfe von Subscriber-Spenden. Diese werden in Twitch Bits genannt und von der Plattform ausgezahlt. Die Spenden rufen bei einigen Streamern emotionale Reaktionen hervor, was wiederum mehr Menschen zum Spenden anregt.

Eine weitere Möglichkeit stellt Affiliate-Marketing dar: Streamer bewerben in dem Fall für ihre Zuschauer interessante Produkte in ihren Videos. Kaufen Zuschauer die Produkte, profitieren Streamer von einer Provision – die nicht selten 30% des Kaufbetrages ausmacht.

Sponsoren und Markendeals als größte Einnahmequelle für Streamer