Aktuelle Events

Das „Cannabiz“

Deutschland vergibt die ersten Lizenzen für den medizinischen Anbau von Cannabis. Die Regularien sind streng, Schnelligkeit und Innovationsbereitschaft eröffnen Chancen, gerade auch für Gründer.

Seit März 2017 ist das „Cannabis als Medizin“-Gesetz in Kraft. Es regelt den Einsatz von Cannabisarzneimitteln als Therapiealternative bei bestimmten Patienten. Das Interesse an dem Geschäft mit der grünen Wunderpflanze steigt. Ob Cannabisblüten, -öle oder -extrakte – die Lizenzen sind gefragt und der Bedarf wird in die Höhe schießen. Aktuell muss der Rohstoff importiert werden, doch die eingeführte Menge lag im letzten Jahr bereits bei 170 Kilogramm. Ab 2019 sollen auch Ernteerträge aus dem heimischen Anbau zur Verfügung stehen.

Eines wird klar: Der Cannabis-Markt birgt viele Chancen und Herausforderungen. Bis zur Gesetzgebung im März 2017 waren rund 1000 Personen mit Ausnahmegenehmigung dazu berechtigt, Cannabis aus der Apotheke zu erwerben. Schätzungen zufolge wird die Zahl der Patienten, die sich Cannabis verschreiben lassen, zukünftig zwischen 120.000 und 850.000 liegen, da die Übernahme durch die Krankenkassen Hürden überwindet. Klar ist, dass die bisherigen Versorgungsstrukturen keinesfalls ausreichen werden, da es bereits immer wieder zu Lieferengpässen kommt. Bisher wurden die Patienten mit Cannabis aus den Niederlanden versorgt. Seit einigen Monaten können die Betroffenen auch auf Sorten aus Kanada zurückgreifen. Es stellt sich somit die Frage: Legalisierung von Cannabis: Welche Chancen bietet sie?

Wettlauf um die Lizenzen

Um die Produktion und Distribution von medizinischem Cannabis zu vereinfachen, hat die Regierung die Gründung einer sog. Cannabisagentur angekündigt. Derzeit bewerben sich einige Dutzend Unternehmen und Vereinigungen um eine Anbaulizenz. Die Vorschriften und Auflagen sind streng, da es sich um ein medizinisches Produkt handelt.

Wenn das deutsche Gesetz EU-weit ratifiziert würde, hätten 510 Mio. Menschen auf einmal Zugang zu medizinischem Cannabis. Der daraus entstehende Markt ist größer als der US-Markt und der kanadische zusammen. Während in den USA Patienten selbst für Cannabis aufkommen müssen, werden die Kosten in Deutschland von der Krankenkasse übernommen. Diese Regelung treibt die Nachfrage in die Höhe. US-amerikanische und kanadische Unternehmen sehen darin ein großes Potential und versuchen auf dem deutschen Markt Fuß zu fassen. Auch Israel plant eine führende Rolle bei der Produktion und beim Export von medizinischem Cannabis einzunehmen. Hier muss Deutschland schnell nachziehen, um den Anschluss nicht zu verlieren.

Cannabis-Service-Industrie

In den USA haben viele Unternehmer erstaunliche Kreativität im „Cannabiz“ bewiesen. Von auf das Geschäft mit Cannabis spezialisierten Anwälten und Business-Consulting-Unternehmen über Anbauschulungen und eine Jobvermittlungsplattform bis hin zu Cannabis-Hochzeitsplanern und Kifferbustouren wird inzwischen jede erdenkliche Dienstleistung angeboten. Bei uns sind die Möglichkeiten noch begrenzt, da ausschließlich der medizinische Cannabisgebrauch zugelassen ist.

Unabhängig davon, wann die Produktion hier starten wird, können zukünftig weit mehr Menschen in der „Cannabis-Service-Industrie“ arbeiten als in der Produktion. New Frontier Data schätzt, dass bis 2020 gut 280.000 neue Arbeitsplätze im Cannabiz entstehen werden.

Kreative Ideen gefragt

Seitdem die ersten US-Staaten Cannabis vollständig legalisiert haben, ist Cannabis das große Geschäft. Beachtlich ist: 40 Prozent der Gründungen in der Cannabisindustrie wurden in den USA von Frauen durchgeführt. Der Prozentsatz ist höher als in jeder anderen Branche und sollte Gründerinnen in Deutschland ermutigen. Die Vorteile von Nutzhanf liegen aber nicht nur in der Wirtschaft, sondern auch in ökologischen Überlegungen begründet.

Die Teillegalisierung macht Platz für eine Vielzahl von Produkten. Die Palette reicht von Zigaretten mit dem nicht-psychoaktiven Cannabidiol CBD über Intimsprays bis hin zu Getränken, Lotions oder Beruhigungsmitteln. Es ist nur eine Frage der Innovationsbereitschaft, wann es zu einem Wirtschaftsboom der Cannabis-Branche, wie in den USA kommt.

Die Autorin Janika Takats ist die Geschäftsführerin von sens media

Zwischen Hausaufgaben und Datenschutz: Der mutige B2C-Vorstoß von innoGPT

Die Inno KI GmbH aus Vechta öffnet ihre bisher auf Geschäftskunden ausgerichtete KI-Plattform nun für Familien. Mit einem neuen "Family Package" wollen die Gründer Mike Koene und Maurice Brumund das Problem des Datenschutzes bei der KI-Nutzung von Jugendlichen lösen. Ein cleverer Schachzug in eine unbesetzte Nische – oder ein schwieriges B2C-Geschäftsmodell mit hoher Preishürde?

Die Zahlen der jüngsten JIM-Studie (Jugend, Information, Medien) sprechen eine deutliche Sprache: 70 Prozent der Jugendlichen nutzen Künstliche Intelligenz zur Informationssuche, 74 Prozent lassen sich bei den Hausaufgaben helfen. Die Kehrseite dieser rasanten Adaption: Die Nutzung erfolgt zumeist über die kostenlosen Web-Versionen von US-Giganten wie OpenAI oder Google. Sensible Daten – von persönlichen Fragen bis zu hochgeladenen Schuldokumenten – fließen oft ungefiltert in die globalen Trainingsdatenbanken der Anbieter, sofern nicht manuell widersprochen wird.

Während die Politik über Social-Media-Verbote für Minderjährige debattiert, bleibt der regulatorische blinde Fleck bei KI-Tools im Kinderzimmer bislang bestehen. Genau in diese Lücke stößt nun das niedersächsische Start-up Inno KI GmbH mit seiner Plattform innoGPT.

Von der Agentur zum KI-Aggregator

Hinter innoGPT steht kein klassisches, VC-finanziertes Silicon-Valley-Konstrukt, sondern mittelständischer Pragmatismus aus Vechta. Co-Founder Maurice Brumund und sein Team begannen bereits 2022 im Umfeld einer eigenen Digitalmarketing-Agentur, intensiv mit KI-Tools zu experimentieren.

Aus dem internen Pain Point – der Frage, wie Mitarbeitende rechtssicher und datenschutzkonform mit großen Sprachmodellen (LLMs) arbeiten können – entstand Ende 2024 die Plattform innoGPT. Bisher lag der Fokus des Startups strikt auf dem B2B-Segment: Mit rein europäischem Hosting, DSGVO-Konformität und einer Zero-Retention-Policy (keine Nutzung der API-Daten für das Modell-Training) positionierte sich innoGPT als Lösung gegen die „Schatten-IT“ in Unternehmen. Laut Unternehmensangaben nutzen bereits über 2.500 Privat- und Geschäftskund*innen den Service. Nun folgt die Ausweitung des Geschäftsmodells auf den B2C-Markt.

Das Produkt: Ein "Safe Space" für die Familie

Mit dem neuen „Family Package“ erhalten bis zu fünf Familienmitglieder für 34,90 Euro im Monat individuelle Logins zu einer zentralen Plattform. Über diese können sie gebündelt auf verschiedene führende KI-Modelle von OpenAI, Anthropic, Google, Meta, Mistral und Black Forest Labs zugreifen. Ein zusätzlich buchbares Add-on filtert persönliche Daten (Named Entity Recognition) wie Namen oder E-Mail-Adressen und ersetzt diese vor der Übermittlung an die Rechenzentren automatisch durch Platzhalter.

Das Geschäftsmodell und der Markt

Aus Start-up-Sicht ist der Vorstoß von B2B-SaaS in ein Family-Abo-Modell gleichermaßen spannend wie riskant. Eine kritische Analyse offenbart dabei mehrere Marktherausforderungen:

- Der technologische Burggraben (Moat): Das Geschäftsmodell von innoGPT ist im Kern ein Aggregator- oder Wrapper-Modell. Das Start-up entwickelt keine eigenen Foundation-Modelle, sondern baut eine sichere, europäische Middleware-Schicht über die Schnittstellen (APIs) der Tech-Giganten. Der technologische Burggraben ist folglich eher niedrig. Der primäre Unternehmenswert liegt in der User Experience, der reibungslosen Modellanbindung und dem abstrakten Vertrauensfaktor „Datenschutz“.

- Zahlungsbereitschaft: 34,90 Euro im Monat (knapp 420 Euro im Jahr) sind für ein klassisches Familienbudget eine erhebliche Summe. Der Preis entspricht fast den Kosten von anderthalb ChatGPT-Plus-Lizenzen. Die zentrale Herausforderung für das Marketing wird sein: Sind Eltern bereit, für den Schutz der Daten ihrer Kinder diesen Premium-Aufschlag zu zahlen, während der Nachwuchs die Basis-Tools de facto kostenlos und mit einem Klick auf dem Smartphone nutzen kann?

- Token-Ökonomie in der Praxis: Das Modell sieht einen geteilten Token-Pool für die fünf Accounts vor. In der Praxis könnte dies zu Reibereien führen, wenn beispielsweise ein Familienmitglied rechenintensive Bildgenerierungen (etwa über Black Forest Labs) durchführt und das Kontingent für die Text-Prompts der restlichen Familie vorzeitig aufbraucht.

- Wettbewerbslandschaft: InnoGPT bewegt sich in einem Sandwich-Markt. Von oben drohen die direkten B2C-Angebote der Tech-Riesen (es ist absehbar, dass OpenAI oder Google eigene „Family Plans“ ausrollen). Von der Seite drücken EdTech-Start-ups in den Markt, die KI DSGVO-konform direkt in die Lernplattformen der Schulen integrieren – was eine private Familienlizenz obsolet machen könnte.

Ein mutiger Testballon

Für das Start-up-Ökosystem ist die Inno KI GmbH dennoch ein Paradebeispiel für „bootstrapped“ Innovationskraft. Anstatt ein Produkt am Reißbrett zu entwerfen, hat das Team ein valides Angebot aus einem eigenen betrieblichen Schmerz heraus entwickelt.

Der Vorstoß in den B2C-Markt wirkt wie ein smarter, PR-wirksamer Testballon. Das Start-up greift eine hochaktuelle, emotionale gesellschaftliche Debatte auf (Jugendschutz bei KI) und besetzt rhetorisch geschickt die Rolle des Problemlösers. Ob sich das Family-Modell finanziell trägt, hängt letztlich davon ab, ob innoGPT den trockenen Begriff der „DSGVO-Konformität“ für Eltern emotional so aufladen kann, dass er als unverzichtbare Sicherheitsmaßnahme wahrgenommen wird. Gelingt dies nicht, ist das Risiko überschaubar: Das Start-up kann sich nahtlos wieder auf sein wachsendes B2B-Kerngeschäft konzentrieren.

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

Die Müsli-Macher und die Kälte: Das neue Millionen-Projekt von Kraiss & Mahler

Dass sie Märkte revolutionieren können, haben die Freda-Gründer bereits bewiesen – nun steht die Tiefkühlkette auf dem Prüfstand. Mit einem mutigen Modul-Konzept fordern Philipp Kraiss und Christian Mahler die Industrie-Riesen im Supermarktregal heraus.

In der Start-up-Welt ist der Begriff Seriengründer*in oft ein zweischneidiges Schwert: Das Vertrauen der Investor*innen ist hoch, doch die Fallhöhe nach einem Erfolg wie mymuesli ebenso. Philipp Kraiss und Christian Mahler haben sich mit ihrem 2023 gegründeten Food-Start-up Freda bewusst gegen ein „Me-too-Produkt“ und für eine operative Wette auf die Zukunft der Tiefkühlkette entschieden. Mit einem mutigen Modul-Konzept fordern sie die etablierten Industrie-Riesen im Supermarktregal heraus. Die Prämisse: Der Markt für Tiefkühlkost (TK) wächst – auf über 22,6 Milliarden Euro im Jahr 2024 –, ist aber durch extremen Preisdruck und eine veraltete Produktlogik geprägt. Wir haben uns das Geschäftsmodell näher angesehen und die Gründer dazu befragt.

Pizza, Pasta, Gelato … und jetzt Blocks?

Die Pizza „Salami Sensation“ war für Freda der Türöffner. Mit dem Sieg bei Stiftung Warentest (2024) bewies das Team, dass es Qualität „kann“ und schuf einen starken USP. Strategisch ist Pizza jedoch kein leichtes Feld: Der Wettbewerb ist anspruchsvoll, die Regalplätze im Einzelhandel sind besetzt und die Differenzierung erfolgt meist über den Preis. Mit einer Innovation wie „Frozen Blocks“ erweitert Freda nun das Spielfeld und eröffnet eine neue Kategorie von Tiefkühlkost.

Es handelt sich dabei nicht mehr um ein fertiges Gericht, sondern um eine Systemkomponente. Das Konzept orientiert sich am gastronomischen „Mise en Place“: Vorbereitete, schockgefrostete Komponenten wie Beef Ragù oder Chili sin Carne fungieren als Basismodule für die heimische Küche. Strategisch gesehen erhöht dies die Wertdichte pro Kubikzentimeter im TK-Fach und verringert die Komplexität in der eigenen Produktion im Vergleich zu mehrkomponentigen Fertigmenüs.

Auf die Frage, ob der strategische Wechsel von der Pizza zu den „Frozen Blocks“ eine Flucht aus dem Commodity-Preiskampf der Pizza-Truhe hin zu einer proprietären Nische sei, widerspricht Philipp Kraiss. Vielmehr handele es sich um einen konsequenten Ausbau des Sortiments, denn Freda solle künftig den gesamten Alltag der Kund*innen abbilden – vom Frühstück bis zum Abendbrot. Das sei eben mehr als nur Pizza. „Unser Anspruch ist aber nicht nur Bekanntes besser zu machen – wie bei unserer Pizza, sondern auch neue Wege zu gehen“, stellt der Gründer klar. Die flexiblen Module seien auf diesem Weg der nächste logische Schritt. Er verspricht dabei maximale Vielfalt aus dem Gefrierfach, „denn jeder Block lässt sich vielfältig kombinieren.“

Die Retail-Herausforderung: Kaufland als Stresstest

Mit einer Basis von über 30.000 D2C-Kund*innen hat das Unternehmen bereits bewiesen, dass die Nachfrage nach seinen Produkten besteht. Um dieses Potenzial voll auszuschöpfen und die Margen zu stärken, wurde im August 2025 der Launch in 780 Kaufland-Märkten umgesetzt – ein strategischer Meilenstein, der die Reichweite massiv erhöht und über das Volumen des stationären Einzelhandels den Weg zu nachhaltigem, profitablem Wachstum ebnet – ohne aufwendigen Versand mit Isolierung und Trockeneis.

Hier zählt nun die Shelf Velocity (Abverkaufsgeschwindigkeit). Ein modulares System erfordert von der Kundschaft jedoch ein Umdenken: Man kauft kein fertiges Abendessen, sondern eine Zutat. Freda muss hier beweisen, dass der Mehrwert der Zeitersparnis am Point of Sale verstanden wird, bevor die harten Auslistungsmechanismen des Handels greifen.

Doch wie überzeugt man eine*n Einkäufer*in davon, dass ein modulares System mehr Flächenproduktivität bringt als die zehnte Sorte Standard-Lasagne? Christian Mahler kontert auf diese Retail-Frage mit einem anschaulichen Branchen-Vergleich: „Wir sind eben nicht die zehnte Lasagne. Eine klassische TK-Lasagne belegt viel Regalfläche, bedient genau einen Anlass und konkurriert mit neun anderen Lasagnen um denselben Kunden.“ Durch das kompakte Format und eine maximale SKU-Dichte der Blocks könne der Händler auf derselben Regalfläche mehrere Sorten listen und spreche damit dutzende Zubereitungsarten von der Bowl bis zum Curry an. Mahler zeigt sich selbstbewusst: „Wir eröffnen eine neue Kategorie statt in einer bestehenden zu kämpfen.“

Operative Exzellenz vs. bayerisches Handwerk

Ein weiterer Spagat wartet in der Produktion: Freda wirbt offensiv mit „Made in Bavaria“ und handwerklicher Herstellung. In der Start-up-Praxis beißt sich Handwerk jedoch oft mit Skalierung. Wer bundesweit fast 900 Supermärkte bedient, muss industrielle Prozesse beherrschen. Die Gefahr dabei ist offensichtlich: Wenn die Qualität durch die Masse sinkt, verliert Freda seinen wichtigsten USP. Gleichzeitig bleibt bei der exklusiven Zielgruppe, die bereit ist, für TK-Komponenten Premium-Preise zu zahlen, in Zeiten der Inflation die Frage der Preissensibilität bestehen.

Auf drohende Kapazitätsgrenzen angesprochen, räumt Philipp Kraiss ein, dass die Passauer Manufaktur zwar das Herzstück bleibe. „Aber wir waren von Anfang an ehrlich zu uns selbst: Eine Manufaktur skaliert nicht linear“, gibt der Seriengründer zu bedenken. Mit wachsendem Geschäft müsse man die Produktion auf breitere Schultern stellen und mit Partnern zusammenarbeiten. Sein Kernversprechen an die Kund*innen lautet dabei jedoch: „Wir lagern nicht die Rezeptur aus, sondern die Kapazität.“

Marktpsychologie: Convenience ohne Reue

Psychologisch besetzt Freda damit eine überaus geschickte Lücke. Die „Frozen Blocks“ nehmen der Käuferschaft zwar die Entscheidung für die aufwendige Kernkomponente ab, lassen das Gefühl des Selbstkochens durch das frische Ergänzen von Beilagen jedoch vollkommen intakt. Dies eliminiert die oft vorhandene „Convenience-Scham“ gesundheitsbewusster Zielgruppen und könnte die Lösung für die stagnierenden Marktanteile klassischer Fertiggerichte bei jüngeren Konsument*innen sein.

Fazit für die Start-up-Praxis

Freda ist ein Lehrstück für den Übergang von einer digitalen D2C-Brand zum Player im Massenmarkt. Die Gründer nutzen ihre Erfahrung, um eine etablierte Kategorie neu zu denken. Ob die Rechnung aufgeht, wird sich an der Regal-Rotation zeigen. Wenn die Kund*innen den Aufpreis für die „bayerische Handarbeit“ und das modulare System dauerhaft akzeptieren, könnte Freda die Blaupause für die nächste Generation von Food-Marken liefern.

Distart: Vom Agentur-Frust zum EdTech-Champion

Wie das 2021 von Thomy Roecklin gegründete und seit 2025 zusammen mit Lucia-Miriam Selbert geführte Leipziger EdTech Distart das Bildungssystem „gegen den Strich bürstet“.

Wer in Deutschland über Start-up-Hubs spricht, landet meist schnell in Berlin oder München. Doch in der sächsischen Metropole Leipzig wächst seit einigen Jahren ein Player heran, der beweist, dass Innovation auch abseits der üblichen Verdächtigen gedeiht: Die Distart Education GmbH. Ihr Treibstoff ist der eklatante Mangel an digitaler Kompetenz in der deutschen Wirtschaft – und der Mut, das „System Bildung“ gegen den Strich zu bürsten.

Wenn „Done for You“ nicht mehr reicht

Die Wurzeln des Unternehmens reichen weiter zurück als das offizielle Gründungsjahr 2021. Gründer Thomy Roecklin setzte jahrelang mit seinen Agenturen MNKY lab und TRDIGITAL digitale Kampagnen für Kund*innen um. Doch im Tagesgeschäft bremste das fehlende Digitalverständnis auf Kundenseite die Projekte immer wieder aus. Die Erkenntnis, dass Deutschland weniger neue Agenturen, sondern mehr digitale Mündigkeit braucht, führte schließlich zum Pivot.

Interessanterweise war der Auslöser für diesen Kurswechsel kein konkretes Kundenprojekt. Auf die Frage nach dem „Aha-Moment“ erklärt Roecklin, dass er lediglich versuchte, Lucia-Miriam Selbert einzuarbeiten, und dabei schockiert feststellte, wie wenig praxisnahe digitale Weiterbildungen existierten. Er baute kurzerhand selbst ein Lernprogramm – ohne zu ahnen, dass daraus einmal Distart entstehen würde. Im Januar 2021 fiel der Startschuss für Distart learn. Mitten in der Pandemie setzte Roecklin auf ein Modell, das sich radikal von klassischen Bildungsträgern unterschied: 100 Prozent remote, aber mit enger persönlicher Betreuung und einem klaren Fokus auf die Praxis.

Das Schnellboot zwischen den Tankern

Distart operiert im sogenannten AZAV-Markt (Akkreditierungs- und Zulassungsverordnung Arbeitsförderung). Während etablierte Bildungsriesen oft mit der Trägheit ihrer Größe kämpfen und bis zu 24 Monate für Lehrplananpassungen benötigen, hat sich Distart als agiler „Qualitäts-Vorreiter“ positioniert.

Für Roecklin ist diese Agilität eine Frage des Überlebens, da sich Jobs und Skills heute schneller verändern als jede klassische Bildungslogik. Er betont, dass man ohne permanente Weiterentwicklung der Inhalte zwangsläufig am Markt vorbei ausbilden würde. Diese Flexibilität ist zudem essenziell für die Zielgruppe: Viele Teilnehmende bilden sich neben ihrem 9-to-5-Job weiter, betreuen Kinder oder pflegen Angehörige und benötigen daher flexible statt starrer Strukturen.

Agency-DNA statt Schulbank-Feeling

Der entscheidende Wettbewerbsvorteil liegt in der Herkunft: Distart ist keine klassische Schule, sondern wurde von Marketern für Marketer gebaut. Diese „Agency-DNA“ durchzieht das gesamte Geschäftsmodell. Mit einer modernen Lernumgebung aus Live-Sessions und asynchronen Deep-Dives spricht das Unternehmen alle Altersgruppen gleichermaßen an.

Auch technologisch ist man der Konkurrenz oft einen Schritt voraus: Als ChatGPT Ende 2022 die Arbeitswelt veränderte, reagierte Distart fast in Echtzeit. Auf die kritische Frage, ob KI das vermittelte Wissen nicht bald obsolet mache, findet Roecklin eine klare Antwort: KI ersetzt keine Menschen, sie ersetzt lediglich Mittelmaß. Während KI das Netz mit generischen Inhalten flutet, steige paradoxerweise der Hunger nach echten Stimmen, Ideen und Perspektiven – Marketing werde also menschlicher.

Bootstrapping und gesundes Wachstum

Der Erfolg gibt dem Konzept recht. Im September 2024 erfolgte die Umfirmierung zur Distart Education GmbH, was den Übergang vom Start-up zum etablierten Bildungsinstitut markierte. Während andere Tech-Unternehmen Personal abbauen mussten, verdoppelte Distart seine Belegschaft beinahe auf über 100 Köpfe und bezog im Oktober 2025 neue Räumlichkeiten im NEO Leipzig.

Besonders bemerkenswert: Das Wachstum ist organisch und gebootstrapped – finanziert aus dem eigenen Cashflow ohne externe Risikokapitalgeber. Das macht Distart unabhängig von Exit-Druck. Seit Februar 2025 verstärkt Lucia-Miriam Selbert als Geschäftsführerin die strategische Ausrichtung.

Dennoch birgt die Skalierung Risiken, da das Geschäftsmodell stark von staatlichen Bildungsgutscheinen abhängt. Auf einen möglichen „Plan B“ angesprochen, erklärt das Unternehmen, dass Förderungen zwar beim Beschleunigen helfen, man Distart aber bewusst so aufbaue, dass langfristig strukturelle Unabhängigkeit erreicht wird. Auch die Qualitätssicherung bei über 100 Mitarbeitenden ist eine Herausforderung. Thomy Roecklin gibt offen zu, dass Wachstum kein Wellnessprogramm ist und es im Getriebe zwangsläufig knirscht. Sein Schlüssel: Qualität darf nicht an Einzelpersonen hängen, sondern muss im gesamten System verankert sein, kombiniert mit echtem Vertrauen in das Team statt Kontrolle.

Der Standort als Statement und Vision

Dass Distart in Leipzig verwurzelt bleibt, ist Teil der Identität. Roecklin sieht im Osten Deutschlands ein enormes, oft unterschätztes Potenzial und erlebt dort viel Talent, Pragmatismus und Lernhunger. Distart versteht sich hier auch als Regionalentwickler.

Die Vision der Gründer geht jedoch über reine Kurse hinaus. Unterstrichen durch Auszeichnungen wie „Top Fernschule 2025“ und „2026“, arbeitet das Team nun an der Gründung der Distart University of Applied Sciences. Das Ziel bis 2030 ist ambitioniert: Ein Alumni-Netzwerk von 25.000 Absolvent*innen. Sollte der komplexe Weg zur staatlichen Anerkennung gelingen, wird Distart endgültig zum gewichtigen Faktor für die digitale Wettbewerbsfähigkeit der Bundesrepublik.

Agentic AI als Erfolgsgrundlage für Start-ups

KI befeuert den aktuellen Gründungsboom, doch für eine erfolgreiche Skalierung braucht es mehr. Warum Agentic AI auf Basis einer soliden Datenarchitektur zum entscheidenden Erfolgsfaktor für Start-ups wird.

Das Jahr startete für Start-ups mit einer Rekordmeldung: In Deutschland wurden im vergangenen Jahr fast ein Drittel mehr Gründungen verzeichnet. In absoluten Zahlen wurden 2025 insgesamt 3.568 neue Firmen geschaffen – ein neuer Höchststand, wie der Start-up-Verband im Januar verkündete. Dies ist auch der künstlichen Intelligenz (KI) zu verdanken, wie sich beim genauen Hinschauen herausstellt. 853 dieser neuen Unternehmen kommen aus dem Bereich Software. Doch nicht nur sie verwenden KI; bei einer Umfrage gab ein Drittel aller Gründer und Gründerinnen an, dass sie mit KI arbeiten. Dementsprechend sehen die Sprecher des Verbands in der Technologie auch die treibende Kraft hinter dem Start-up-Rekord.

Wirft man einen Blick über den Tellerrand hinaus, so lässt sich feststellen, dass die Start-up-Szene in Europa insgesamt floriert. Der „State of European Tech 2025“-Report im Auftrag von Atomico und anderen schätzt, dass im letzten Jahr Investitionen in Höhe von 44 Milliarden US-Dollar (umgerechnet ca. 38 Mrd. EUR) in diesen Sektor geflossen sind. Geldgeber erwarten inzwischen, dass Start-ups mit KI und Deep Tech arbeiten, so der Report. Demnach flossen auch 36 Prozent der europäischen Start-up-Investitionen in genau diese beiden Felder.

Das Gründungsumfeld könnte also kaum besser sein. Doch ein Rekord an Start-ups und steigende Investitionssummen bedeuten nicht zwangsläufig auch eine einfache Skalierung der Geschäftsmodelle. Viele – zu viele – Start-ups scheitern nach erfolgreichen ersten Jahren an der Weiterentwicklung ihres Geschäfts. Neben einer Reihe üblicher Herausforderungen stehen vor allem Bürokratie, Fragen zur Datenhoheit und ein Betrieb über Landesgrenzen und Wirtschaftszonen hinweg im Vordergrund. Start-ups müssen nachweisen, dass ihre Nutzung von KI auf soliden, regulierten Datenfundamenten basiert und den Compliance-Vorgaben entspricht.

Hier kommt Agentic AI ins Spiel. Die Einbettung von KI-Agenten in den Kern der Betriebsabläufe ist die Antwort auf viele dieser Herausforderungen und wird für das Wachstum im Jahr 2026 von entscheidender Bedeutung sein.

Solide Datenbasis vor KI-Einsatz

Start-ups, die dies erreichen wollen, sollten sich darauf konzentrieren, ihre KI-Nutzung auf einer soliden Datenbasis aufzubauen, deren Fundament eine einheitliche Datenarchitektur ist. Sie tun sich deutlich leichter damit, die dafür nötigen Architekturentscheidungen zu treffen, als etablierte Unternehmen mit entsprechender Legacy-IT. Gründer und Gründerinnen sollten daher von Beginn an darüber nachdenken, wie sie eine starke Datenarchitektur aufsetzen, Silos abbauen und KI als Herzstück ihrer Prozesse einbetten.

Diese Grundlage hilft bei der Einführung von KI-Agenten, damit deren Output auch die Erwartungen erfüllt: Geschäftsprozesse effizienter zu strukturieren und zu optimieren sowie die Entscheidungsfindung zu beschleunigen. Start-ups, die dies umsetzen, werden sich gegen ihre Konkurrenten durchsetzen und letztlich erfolgreich sein.

KI-Agenten als Innovationsbeschleuniger

Indem Start-ups KI-Agenten von Beginn an in den Kern ihrer Geschäftsabläufe integrieren, skalieren sie schneller als mit dem Einsatz von nur einem reinen Large Language Model (LLM). Der Grund dafür liegt in der Standardisierung der Daten, die für KI-Agenten notwendig ist. Auf dieser Grundlage können die Agenten ihre einzigartigen, autonomen Fähigkeiten ausspielen, da sie mit unternehmenseigenen Daten trainiert werden. Vor allem bei Start-ups können Potenziale schnell gehoben werden: Wenn Agenten für bestimmte Aufgaben entwickelt werden, können sie diese auch lösen – egal wie komplex und fachspezifisch sie sein mögen. Stimmt die Datenbasis, lassen sich auch mehrere Agenten miteinander verknüpfen, um sogar noch komplexere Herausforderungen zu bewältigen.

Ein Beispiel dafür ist die mögliche Kooperation zwischen einem Kundensupport-Agenten und einem Prognose-Agenten. Wenn ein Kunde einen Support-Fall auslöst, kann der andere Agent sogleich die Kosten berechnen, was die Kundenzufriedenheit durch eine schnellere Reaktion steigern kann. Für die Skalierung von Start-ups ist ein enges Zusammenspiel der Abteilungen wichtig, um die Geschäftsbeziehungen zu zufriedenen Kunden weiter ausbauen zu können. Der Einsatz von KI-Agenten kann, gepaart mit dem menschlichen Element, begrenzte personelle Ressourcen ausgleichen und eine bessere Serviceleistung ermöglichen, was für ein schnelles Wachstum unabdingbar ist.

Doch nicht nur der Kundenkontakt lässt sich automatisieren, sondern auch eine ganze Reihe von Routinevorgängen in der internen Verwaltung der Firmen selbst. Dies ermöglicht nicht nur dem Management, sondern auch den Investoren, schnell einen fundierten Überblick über Liquidität, Umsatz, Einnahmen und Gewinn zu erhalten. Die Erkenntnisse in Echtzeit führen zu schnellen und datenbasierten Entscheidungen, was für junge Unternehmen Gold wert ist und es ihnen ermöglicht, flexibel zu bleiben.

Die Datenbasis muss stimmen

Für Start-ups sind Probleme beim Datenzugriff ein kritisches Risiko für den Geschäftserfolg. Eine einheitliche, moderne Datenarchitektur ermöglicht die Demokratisierung des Datenzugriffs und löst Datensilos auf. Der Vorteil liegt auf der Hand: Schneller Datenzugriff schafft Transparenz gegenüber Kunden und Aufsichtsbehörden. Darüber hinaus erhöht dies auch das Vertrauen der Mitarbeitenden und schafft ein Gefühl des Zusammenhalts.

Governance ist auch bei der Verwendung von KI-Agenten von entscheidender Bedeutung. Der Druck zur Einhaltung von Vorschriften sollte daher als Vorteil betrachtet werden.

Der Dreiklang aus Datenherkunft, Versionierung und automatisierter Auswertung der Ergebnisse hilft jungen Unternehmen dabei, Governance auf einem soliden Fundament aufzubauen. Die Teams erhalten direkte Transparenz darüber, wie sich die KI-Agenten verhalten, auf welchen Daten sie basieren und wie sie ihre Ergebnisse im Laufe der Zeit verändern. Laufende Bewertungen tragen dazu bei, dass KI-Agenten präziser werden, um genau jene hochwertigen Ergebnisse zu liefern, die Start-ups für die Skalierung ihrer Geschäftsmodelle benötigen. Dies ist besonders wichtig, wenn proprietäre KI-Modelle entwickelt und von der Testphase in die Produktion überführt werden, wobei gesetzliche Vorschriften wie die DSGVO oder der EU AI Act zwingend einzuhalten sind.

Parloa, ein deutsches Start-up-Unternehmen mit einer Bewertung von drei Milliarden US-Dollar, ist ein hervorragendes Beispiel dafür, wie dieser Ansatz in der Praxis aussehen kann: Das Unternehmen hat KI-Agenten zum Kern seines Kundenservice gemacht und gleichzeitig eine einheitliche, kontrollierte Datenbasis aufgebaut, die vollständig mit der DSGVO und dem EU AI Act konform ist. Seine Plattform folgt den Prinzipien des „Privacy by Design“, sodass sensible Kundendaten ohne Kontrollverlust verwendet werden können. Durch die Verwaltung des gesamten Lebenszyklus von KI-Agenten macht Parloa Governance zu etwas Greifbarem und gibt den Teams Klarheit darüber, welche Daten verwendet wurden, wie sich die Agenten verhalten haben und wie sich die Ergebnisse im Laufe der Zeit entwickelt haben. Diese Kombination aus moderner Architektur und starker Governance ermöglicht es den Kunden von Parloa, Zugang zu hochwertigen Daten zu erhalten und die Transparenz für Regulierungsbehörden sowie Endnutzer zu erhöhen – und dennoch KI-gesteuerte Kundeninteraktionen in Umgebungen zu skalieren, in denen Fehler oder Missbrauch inakzeptabel sind.

Fazit

KI-Agenten bieten europäischen Start-ups eine einmalige Gelegenheit, schnell zu wachsen und gleichzeitig Investoren anzuziehen, die bekanntermaßen ihr Geld bevorzugt in Unternehmen investieren, die Wert auf Datenverwaltung, Genauigkeit, Qualität und die Schaffung von echtem Mehrwert durch Technologie legen. Es ist jedoch ein Fehler, sich ohne sorgfältige Überlegungen auf die Einführung von Agenten zu stürzen. Start-ups, die KI-Agenten einsetzen, ohne zuvor eine einheitliche Datenbasis aufzubauen und eine solide Verwaltung sowie Bewertung sicherzustellen, riskieren, mehr Komplexität als Mehrwert zu schaffen. Letztlich werden jene Gründer und Gründerinnen erfolgreich sein, die ihre Geschäftsmodelle branchen- und länderübergreifend skalieren können – hierbei spielt der Einsatz von KI-Agenten bereits jetzt eine entscheidende Rolle.

Der Autor Nico Gaviola ist VP Digital Natives & Emerging Enterprise bei Databricks EMEA.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

VESTIO: Wenn ein Solar-Entrepreneur auf einen Stil-Rebellen trifft

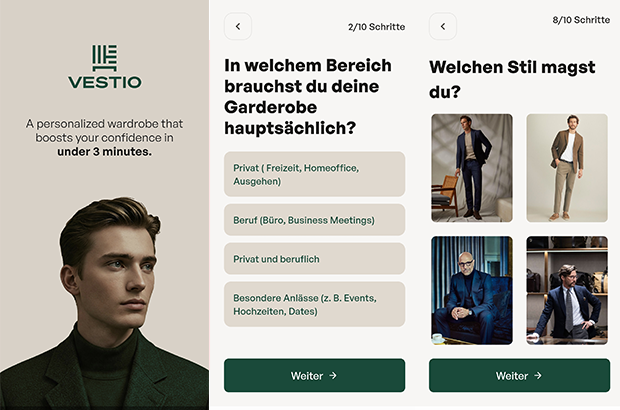

Die Geschichte der jungen FashionTech-App VESTIO ist zugleich die zweier Gründer, die sich in einem gemeinsamen Ziel treffen: Die Demokratisierung von gutem Stil durch algorithmische Logik.

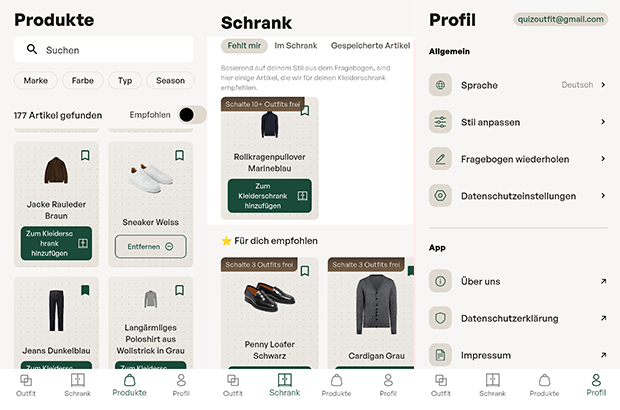

Hinter der FashionTech-App VESTIO steht die im Jahr 2024 von Bastian Arend und Justus Hansen gegründete Opus Stilberater GmbH, die den Anspruch erhebt, professionelle Stilberatung erstmals digital, logisch und kostenlos zugänglich zu machen.

Der „Solar-Entrepreneur“ trifft den Stil-Rebell

Die persönlichen Hintergründe der Gründer bieten spannende Kontraste, die weit über ein übliches Business-Profil hinausgehen. Bastian Arend, Co-Founder und CEO, kam über die Energiewende zur Mode. Als Seriengründer baute er den Online-Solar-Anbieter Klarsolar auf und verkaufte ihn im Dezember 2023 erfolgreich an den Energiekonzern E.ON. Die Übernahme erfolgte in einer für die Solarbranche schwierigen Marktphase, was Bastian Arend als Krisen-erprobten Strategen auszeichnet.

VESTIO entwickelte er 2024 jedoch aus einem ganz persönlichen „Pain Point“ heraus: Während er internationale Millionen-Finanzierungsrunden leitete, bestand sein eigener Stil mangels Zeit lediglich aus Hoodie, Jeans und Sneakern. „Ich wollte nur jemanden, der für mich einkauft“, erinnert er sich an diese Phase. Seine Abneigung gegen zeitraubendes Shopping führte ihn schließlich zu Justus Hansen.

Justus Hansen, Co-Founder und Chief Styling Officer, bringt eine Biografie ein, in der Mode schon immer eine zentrale Rolle spielte. Sein Gespür für klassische Mode ist tief verwurzelt: Justus Hansen trug bereits im Kindergarten eine Fliege und provozierte später Lehrer, indem er im Sakko zum Unterricht erschien. Bevor er mit über 1,6 Millionen Follower*innen zu einem der bekanntesten Männerstilberater Deutschlands aufstieg, studierte er Jura und absolvierte Praktika im Bankensektor, unter anderem bei der Dresdner Bank.

Diese Erfahrungen schärften seinen Blick für die Anforderungen moderner „Business-Garderoben“. Als Arend ihn fragte, ob er für ihn einkaufen könne, antwortete Justus Hansen bestimmt: „Einfach irgendwas kaufen? Nein. Ich muss verstehen, wer du bist.“ Bastian Arend begriff Hansens modulare Styling-Methode sofort als logisches System und schlug vor: „Wir sollten deine Methode digitalisieren und kostenlos für jeden Mann zugänglich machen.“ Für Justus Hansen wurde damit ein „Lebenstraum“ wahr.

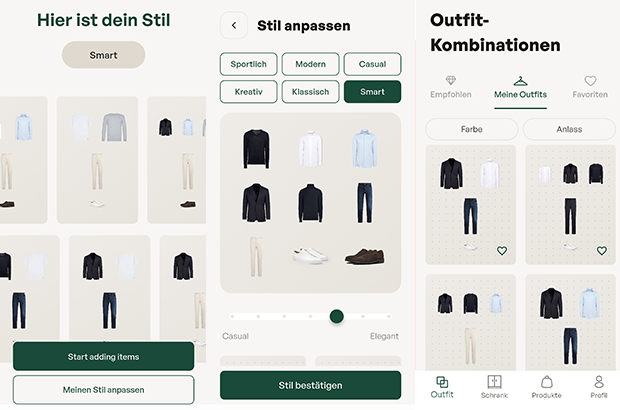

Das Konzept: „Weniger Teile, mehr Outfits“

Das Herzstück der App bildet ein algorithmisches Styling-System, das strikt dem Leitsatz „Weniger Teile. Mehr Outfits“ folgt. In nur drei Minuten erstellt ein Stilfinder-Fragebogen eine persönliche Grundgarderobe. Der digitale Kleiderschrank funktioniert dabei bewusst ohne das mühsame Hochladen von Fotos; das System kennt die wichtigsten Basics, erkennt Lücken und empfiehlt gezielt Ergänzungen. Justus Hansen betont dabei die Wichtigkeit der Basis: „Die wenigsten Männer besitzen eine echte Basisgarderobe. Und das ist die Grundlage, aus der ihre besten Outfits entstehen.“

Ziel ist es, automatisch kombinierbare Outfits für alle Anlässe zu generieren. Dabei verfolgen die Gründer eine klare ästhetische Linie: „Outfits müssen nicht kompliziert sein, um zu wirken. Sie brauchen lediglich eine klar erkennbare Linie“, so Hansen. Bastian Arend ergänzt: „Die besten Outfits für Männer sind nicht kompliziert, sondern harmonisch und durchdacht.“

Das Affiliate-Dilemma: Geschäftsmodell im kritischen Check

Wirtschaftlich operiert VESTIO über ein Affiliate-Modell. Die App ist für Nutzer kostenlos, während das Unternehmen Provisionen von Partner-Anbietern bei einem erfolgreichen Kauf erhält. Hier liegt für den kritischen Betrachter ein interessanter systemischer Interessenkonflikt: Das erklärte Ziel „Weniger Konsum – bessere Entscheidungen“ steht ökonomisch potenziell im Widerspruch zu einem Modell, das von Transaktionen lebt. Zudem stellt sich die Frage der langfristigen Nutzerbindung: Sobald ein Mann seine „perfekte Garderobe“ aufgebaut hat, sinkt der Bedarf für weitere Anschaffungen. Dass das Unternehmen dennoch auf Wachstum setzt, zeigt die Erhöhung des Stammkapitals auf knapp 30.000 Euro im September 2025. Langfristig plant VESTIO die Integration eines Marktplatzes, der Partnerprodukte und eigene Kollektionen vereint, um basierend auf Daten den größten Mehrwert zu liefern.

Marktpositionierung und technologischer Vorsprung

Im Vergleich zum Wettbewerb besetzt VESTIO eine spezifische Nische. Während Curated-Shopping-Anbieter (z.B. Outfittery) auf den Versand physischer Boxen setzen, bleibt VESTIO ein rein digitaler Guide, der dem Nutzer die volle Freiheit bei der Wahl des Händlers überlässt. Andere Styling-Apps verlangen oft zeitintensive Foto-Inventuren, während VESTIO auf logische Kombinationen setzt.

Das Risiko bleibt jedoch die Abhängigkeit von der Personal Brand Justus Hansens. Letztlich ist VESTIO der Versuch, Mode so effizient wie eine Prozessoptimierung zu gestalten – oder wie Bastian Arend es formuliert: „Viele Männer haben mehr Kleidung als Stil. Vestio ändert das.“ Mit dem Aufbau der App wolle man Männern „genau diese Arbeit abnehmen“, damit sie sich ultimativ „besser fühlen“ können.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

KI erfolgreich industrialisieren

Warum 95 Prozent der KI-Pilotprojekte scheitern – und wie du deine Chancen erhöhst, zu den erfolgreichen fünf Prozent zu gehören.

Künstliche Intelligenz ist in der Industrie angekommen, doch zwischen Anspruch und Wirklichkeit klafft oft eine Lücke. Eine aktuelle Untersuchung des MIT - Massachusetts Institute of Technology („The GenAI Divide“) zeigt: Nur fünf Prozent der KI-Pilotprojekte schaffen tatsächlich den Sprung in die produktive Anwendung. Diese „Pilot-to-Production“-Falle ist eines der größten Risiken für Industrieunternehmen heute.

Der feine Unterschied

GenAI ist keine Produktions-KI Oft werden Äpfel mit Birnen verglichen. Generative KI (GenAI) ist fantastisch für kreative Aufgaben und Chatbots, scheitert aber oft an der Verlässlichkeit, die in der Produktion nötig ist. Industrietaugliche „Produktions-KI“ hingegen muss anders funktionieren: Sie lernt aus Maschinendaten, erkennt Zusammenhänge in Echtzeit und muss absolut robust laufen.

Besonders in der Kunststoffverarbeitung, etwa bei schwankenden Recyclingmaterialien oder Verschleiß, spielt Produktions-KI ihre Stärken aus: Sie gibt den Mitarbeitenden an der Maschine konkrete Handlungsempfehlungen, statt nur Daten zu sammeln.

Faktor Mensch und Organisation

Das MIT fand heraus: Technik ist selten das Problem. Es sind die organisatorischen Hürden. Unternehmen, die sich externe Expertise und spezialisierte Software-Partner ins Haus holen, verdoppeln ihre Chance, KI-Projekte erfolgreich in den Regelbetrieb zu überführen. Es geht darum, Fachwissen mit Technologie zu verheiraten.

Wie gelingt der Transfer in den Shopfloor?

- Fokus statt Gießkanne: Identifiziere konkrete Probleme (z.B. Anfahrausschuss) und priorisiere diese nach wirtschaftlichem Mehrwert.

- Integration planen: KI darf keine Insel sein. Die Anbindung an IT- und OT-Systeme muss von Anfang an stehen.

- Externe Power nutzen: Setze auf Partner, die deine Industrie verstehen, um die Kinderkrankheiten von Pilotprojekten zu vermeiden.

- Skalierung: Starte fokussiert, miss den Erfolg anhand harter Kennzahlen (OEE, Ausschussrate) und rolle sodann funktionierende Lösungen breit aus.

Fazit

Wer KI nicht als IT-Projekt, sondern als Werkzeug für den Shopfloor begreift und strategisch implementiert, sichert sich echte Wettbewerbsvorteile.

Die Autorin Dr. Louisa Desel ist Mitgründerin und CEO der OSPHIM GmbH. Das 2024 gegründete Unternehmen entwickelt spezialisierte KI-Lösungen für die Kunststoffindustrie.

KI als neuer Ort für Kaufentscheidungen

Das Start-up publuence.ai zeigt am Beispiel der Automobilbranche, wie Marken in generativen KI-Antworten sichtbar werden und warum das zum neuen Erfolgsfaktor wird.

2025 haben wir euch das Start-up publuence.ai von Cevahir Ejder als "Gründer*in der Woche" präsentiert. Publuence.ai ist eine SaaS-Lösung für AI Search Analytics für Marken, die täglich analysiert, wie sichtbar Marken in generativen KI-Antworten sind: bei welchen Fragen erscheinen sie, wie werden sie erwähnt und welche Inhalte sowie Quellen beeinflussen die Antworten. Da die KI-Sichtbarkeit zunehmend darüber entscheidet, ob eine Marke in der engeren Auswahl der Konsumenten stattfindet, sind die Ergebnisse für Unternehmen strategisch sehr relevant.

Beispiel Automobilbrache: KI wird zum Verkaufsberater, Chatfenster zum Showroom

Während Marketing- und Kommunikationsbudgets weiterhin nach klassischen Logiken verteilt werden, fällt ein entscheidender Teil der Markenbildung inzwischen außerhalb des Mediaplans: KI-Systeme beantworten Kauf- und Vergleichsfragen oft lange bevor Kampagnen greifen. Anhand der Automobilbranche etwa, in der Marken wie Volkswagen für eine ganze Industrie stehen, zeigt sich, dass sich Sichtbarkeit im KI-Dialog zum neuen Machtfaktor entwickelt. Sie entscheidet zunehmend darüber, welche Hersteller überhaupt in die engere Auswahl kommen.

Was früher im Autohaus oder auf Herstellerwebsites stattfand, spielt sich heute in KI-gestützten Beratungsgesprächen ab. Nutzer*innen stellen dort Fragen wie: „Welche E-Autos sind familienfreundlich?“ „Wie gut ist die Reichweite im Winter?“ „Welche Modelle laden am schnellsten?“

In der Initialanalyse erzielt beispielsweise VW im Themenbereich E-Autos – je nach Fragestellung bzw. Prompt – Sichtbarkeitswerte zwischen 20 und 88 Prozent. Damit prägen die Antworten frühzeitig das Bild, das Konsument*innen von der Marke haben. Wer dort nicht vorkommt beziehungsweise seine Mehrwerte nicht sichtbar macht, wird in der Entscheidungsfindung schlicht nicht berücksichtigt.

Tesla und Hyundai vorn, VW im Mittelfeld

Das aktuelle Wettbewerbsranking der führenden Automobilhersteller – basierend auf 30 relevanten KI-Prompts rund um das Thema Elektromobilität – zeigt, wie präsent die einzelnen Marken im neuen digitalen Beratungsraum sind. Mit knapp 64 Prozent Sichtbarkeit führt Tesla klar und profitiert von seiner technologischen Positionierung sowie einer starken Medienpräsenz. Überraschend landet Hyundai insbesondere im E-Auto-Segment mit mehr als 58 Prozent dahinter. Volkswagen erreicht solide, aber deutlich ausbaufähige 51 Prozent.

Doch es geht nicht nur um Quantität, die Analyse zeigt auch, wo das Bild der Marken ins Wanken gerät. Im Fall von VW sind es vor allem Themen wie Winterreichweite, Ladeinfrastruktur und Schnellladekosten, die negative Ausschläge erzeugen. Diese kritischen Inhalte sind es allerdings, die die Markenwahrnehmung und dementsprechend auch die konkreten Kaufentscheidungen beeinflussen.

Die stille Macht der Quellen: Medien, die prägen

Eine zentrale Erkenntnis der Analyse von publuence.ai ist, dass KI-Systeme nicht auf Basis eines objektiven Querschnitts des Internets antworten. Vielmehr orientieren sie sich an bestimmten Medienquellen, deren Inhalte überproportional stark einfließen und so die Darstellung von Marken maßgeblich mitformen. Umso wichtiger ist es für Marken zu verstehen, auf welche Fragen sie reagieren müssen – und über welche vertrauenswürdigen Medien sie in den Wissensraum der KI gelangen.

Dabei zeigen sich je nach Medium erhebliche Unterschiede in der Tonalität. Während focus.de sowie adac.de E-Mobilität eher wohlwollend behandelt, sind andere Portale kritischer. Für Unternehmen bedeutet das: Wer verstehen will, wie KI über die eigene Marke spricht, muss wissen, welche Inhalte sie beeinflussen.

Warum Marken nicht an KI-Monitoring vorbeikommen

Publuence.ai bietet Unternehmen ein strukturiertes, datenbasiertes Werkzeug, um ihre Sichtbarkeit in KI-Systemen wie ChatGPT, Google oder Perplexity zu analysieren und darauf aufbauend gezielt zu steuern. Die Plattform zeigt, welche Fragen zur Marke führen, wie die Antworten ausfallen, welche Medien zugrunde liegen und wo Wettbewerber besser abschneiden.

Besonders wichtig ist die Identifikation von Content- und Sentiment-Gaps. Sie erkennt Themenfelder, in denen eine Marke kaum oder gar nicht auftaucht, obwohl sie dort relevant sein sollte. Gleichzeitig analysiert sie, ob etwas positiv, negativ oder neutral erwähnt wird. Dies macht publuence.ai für Kommunikations-, Marketing- und Markenverantwortliche zum zentralen Steuerungsinstrument. Nur wer versteht, wie KI antwortet, kann Inhalte gezielt darauf anpassen, Medienarbeit datenbasiert ausrichten und so die eigene Markenpräsenz dort stärken, wo die Entscheidungen heute vorbereitet werden.

KI-Sichtbarkeit wird zur Basis für Markterfolg

Cevahir Ejder, Gründer und GF der publuence GmbH, fasst zusammen: „Kaufentscheidungen beginnen heute und auch in Zukunft im Dialog mit KI-Systemen. Marken, die dort nicht auftauchen, sind raus.“ Volkswagen steht dabei stellvertretend für viele Unternehmen, die ihren Fokus noch auf klassische Marketingkanäle legen und den digitalen Showroom der KI bislang kaum berücksichtigen. Ejder warnt: „Wer jetzt nicht handelt, riskiert, neben Reichweitenverlusten, einen tiefgreifenden Bedeutungsverlust im Moment der Entscheidung.“

Optocycle: Bauschutt-Recycling auf KI-Basis

Die Optocycle-Gründer Max-Frederick Gerken und Lars Wolff Optocycle zeigen, wie aus Bauschutt neuer Rohstoff wird und erhalten dafür eine Förderung der Deutschen Bundesstiftung Umwelt (DBU).

Jährlich fallen in Deutschland laut Umweltbundesamt rund 86 Mio. Tonnen Schutt und Abfälle auf Baustellen an. Häufig landen diese Materialien auf Deponien. So gehen allerdings wertvolle Ressourcen verloren. Der Ausweg: Ein hochqualitatives Recycling des Schutts vermeidet klimaschädliche Emissionen und hält wertvolle Materialien im Wertstoffkreislauf – und das bei zertifiziert gleichwertiger Qualität.

Um das Recycling von Material im Bausektor zu automatisieren, entwickelt das 2022 von Max-Frederick Gerken und Lars Wolff gegründete Start-up Optocycle aus Tübingen ein System auf Grundlage künstlicher Intelligenz (KI) zum Echtzeit-Monitoring.

Echtzeit-Monitoring im Recycling-Prozess

Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit rund 170.000 Euro. Im Rahmen der DBU-Green Startup-Förderung haben die Gründer ein KI-basiertes System zur automatischen, reproduzierbaren Klassifizierung von Bauabfällen entwickelt. Darauf aufbauend soll nun ein Prototyp das Echtzeit-Monitoring von RC-Körnungen – also recycelten Gesteinskörnungen aus Bauschutt – ermöglichen.

„Aktuell basiert in der Branche der Aufbereitungsprozess von Bauschutt meist auf subjektiven Schätzungen“, so Max-Frederick Gerken. Auch das Endprodukt werde nur stichprobenartig im Labor überprüft. Mit dem System sei „Echtzeitmonitoring von Recycling-Gesteinskörnungen möglich. Somit können die Qualität der Körnung verbessert und mehr Material in die Beton-Produktion überführt werden“, so Gerken.

Die Qualität von Sekundärrohstoffen verbessern

Das System kombiniert laut Gerken moderne, optische Sensorik mit KI – und löse so ein altbekanntes Problem in der Baubranche. „Zurzeit schwankt oft die Beschaffenheit der recycelten Rohstoffe. Das bedeutet einerseits ein wirtschaftliches Risiko für Unternehmen und führt andererseits zum Verlust von wertvollen Materialien“, so Gerken. Optocycle erwartet mithilfe seiner Entwicklung eine 20 Prozent höhere Menge an recycelten, hochqualitativen Gesteinskörnungen sowie 15 Prozent geringere Abfallreste, die sonst auf Deponien landen würden. Dazu werden nach Gerkens Angaben sowohl der eingehende Schutt „optimal klassifiziert“ als auch das Ergebnis transparent überprüft. Kooperationspartner ist hierbei die Heinrich Feeß GmbH, die laut Gerken bereits seit vielen Jahren mit Optocycle zusammenarbeitet. Der Mitgründer weiter: „Die Technologie leistet einen Beitrag für Kreislaufwirtschaft im Bauwesen. Wir helfen dabei, die Qualität von Sekundärrohstoffen zu verbessern, die aus dem Bauschutt gewonnen werden. Diese Lösung lässt sich zudem perspektivisch auf alle Abfallströme übertragen."

Das System von Optocycle kann Gerken zufolge direkt in bereits bestehende Anlagen zur Verarbeitung von Bauabfällen installiert werden – „direkt über dem Fließband.“ Diese einfache Nachrüstung spare Kosten und ermögliche die schnelle Umsetzung eines innovativen Bauschutt-Recyclings. „Denn nur wenn das Recycling finanziell machbar ist, kann die Kreislaufwirtschaft in der Baubranche Erfolg haben“, so Gerken.

Kreislaufwirtschaft in der Baubranche ist aktiver Klimaschutz

Kreislaufwirtschaft in der Baubranche hat nach den Worten des zuständigen DBU-Referenten Dr. Volker Berding wichtige Effekte für den Klimaschutz: „Die Produktion von immer neuem Beton sorgt für hohen Ausstoß von klimaschädlichen Treibhausgasen.“ Einer WWF-Studie zufolge entstehen bei der Herstellung von Zement – dem wichtigsten Bestandteil von Beton – acht Prozent der gesamten globalen Treibhausgasemissionen. Berding: „Alles, was zur einer Emissionsreduzierung beiträgt, hat also bereits einen großen Effekt für den Klimaschutz.“ Eine Kreislaufwirtschaft funktioniere jedoch nur, „wenn die Sekundärrohstoffe sich qualitativ nicht von einer Neuproduktion unterscheiden. Genau diesen Schritt kann Optocycle mit einem skalierbaren, optimierten Prototypen gehen.“

reltix: Vom Aktenordner zum Algorithmus

Wie das 2025 von Andreas Plakinger, Jan Horstmann und Léon Bamesreiter gegründete Düsseldorfer PropTech-Start-up reltix das angestaubte Image einer Branche poliert.

Hausverwaltungen gelten nicht gerade als Sprintdisziplin. Schwer erreichbare Ansprechpartner, Papierberge und zähe Abläufe prägen das Image einer Branche, in der es an Nachwuchs fehlt und Fristen dennoch gnadenlos ticken. Genau da setzt reltix an und wächst: Im März 2025 gegründet, zählt das Düsseldorfer Start-up inzwischen 2000 Kund*innen.

Gegründet wurde reltix von drei ehemaligen Kommilitonen, die sich an der WHU Otto Beisheim School of Management in Vallendar bei Koblenz kennenlernten: Léon Bamesreiter, Jan Horstmann und Andreas Plakinger. Der Motor für die Gründung war eine große Portion eigener Unzufriedenheit. Bamesreiter kaufte mit 20 Jahren während seines dualen Studiums bei einer Großbank seine erste Wohnung, weitere folgten. Seine Erfahrung mit den Verwaltungen: dicke Ordner, langsame Reaktionen, wenig Transparenz. „Ich hatte das Gefühl, ich werde selbst zum Hausverwalter.“

Weniger Bürokratie und mehr Präsenz am Objekt

Mit dem Gründungsstipendium starteten die Drei eine Umfrage unter über 120 Eigentümer*innen: 87 Prozent gaben an, mit ihrer Verwaltung unzufrieden zu sein. Reltix will diese Unzufriedenheit nicht mit mehr Personal, sondern mit Digitalisierung im Hintergrund beheben. Herzstück ist eine selbst entwickelte Software, die E-Mails und WhatsApp-Nachrichten erfasst, automatisch Tickets anlegt, digitale Unterlagen ausliest und Vorgängen zuordnet. Handwerkeranfragen werden systemgestützt angestoßen, Daten zentral strukturiert. Gleichzeitig setzen die Düsseldorfer auf eine feste Ansprechperson je Immobilie.

Erklärtes Ziel der Gründer: weniger Bürokratie und mehr Präsenz am Objekt. Für diesen Ansatz erhielt das Team gerade eine Zusage zur Forschungszulage des Bundesministeriums für Forschung, Technologie, und Raumfahrt zum weiteren Ausbau der eigenen Software mit einer Projektsumme von 1,3 Millionen Euro.

Jahresendspurt brachte Mandate ...

Den größten Schub spürte reltix im Dezember 2025. Viele Hausverwaltungsverträge enden zum 31. Dezember, gleichzeitig laufen Abrechnungsfristen aus. Wer bis Jahresende keine neue Verwaltung findet, bekommt schnell kalte Füße. In den letzten Wochen des Jahres kamen deshalb laut Unternehmen 500 Mandate kurzfristig hinzu, darunter Neubauprojekte in Langenfeld und Köln. Einige namhafte Banken, Family Offices und größere private Bestandshalter zählt das Unternehmen ebenso zu seinen Kund*innen.

... und Personalaufbau

Das Start-up musste personell nachziehen und stockt zum Februar von 14 auf 17 Mitarbeitende auf. Während viele klassische Verwaltungen über fehlenden Nachwuchs klagen, setzt reltix auf junge Mitarbeitende, Quereinsteiger*innen und bildet selbst aus. Das Unternehmen ist IHK Ausbildungsbetrieb und beschäftigt eine Auszubildende im ersten Lehrjahr. Die 28-Jährige, aus der Ukraine geflüchtet, ist aktuell die älteste im Team. Dazu kommen Quereinsteiger*innen: Ein früherer Maschinenbauingenieur leitet inzwischen die Mietverwaltung, eine Mitarbeiterin aus dem Bankgeschäft arbeitet in der Buchhaltung.

Von Rhein-Ruhr bis an den Main

Neben der Verwaltung großer Objekte bietet das Düsseldorfer PropTech für kleinere Eigentümer*innengemeinschaften mit drei bis acht Einheiten die sogenannte Kompaktverwaltung. Enthalten ist darin eine rechtssichere Abrechnung, die Durchführung von Eigentümer*innenversammlungen sowie größere Sanierungen, während Alltägliches bei den Eigentümer*innen bleibt. Regional liegt der Fokus auf Rhein-Ruhr sowie dem Umfeld Köln Bonn. Frankfurt mit einem weiteren Standort ist als nächster Schritt Richtung Sommer geplant. Düsseldorf soll Hauptsitz bleiben.