Aktuelle Events

Die Big-Data-Factory

Drei Studenten haben Process Mining aus der Theorie in ein bahnbrechendes Big-Data-Business-Tool überführt. Heute ist ihr Start-up Celonis Weltmarktführer und macht über 10 Mio. Euro Umsatz.

Unternehmen fällt es im digitalen Zeitalter zunehmend schwer, den Überblick darüber zu behalten, wie effizient die eigenen Geschäftsprozesse wirklich sind. Gründe dafür sind vor allem zunehmende Komplexität, Dynamik und Intransparenz in IT-gestützten Abläufen. „Noch immer verlassen sich zu viele Unternehmen auf ihr Bauchgefühl – die wahren Zeit- und Kostenfresser bleiben oft unentdeckt. Das können verpasste Rabatte und fehlende Genehmigungen beim Maverick Buying sein, manuelles Nachbearbeiten fehlerhafter Prozessschritte oder Verzögerungen in der Produktion durch zu späte Lieferung bestimmter Teile“, erläutert Bastian Nominacher, Mitgründer von Celonis. Die Folge: Ineffiziente Prozesse kosten Unternehmen viel Zeit und Geld, gleichzeitig leidet die Kundenzufriedenheit, und die Agilität des Unternehmens wird dauerhaft eingeschränkt.

Was ist Process Mining?

Um dieses Problem zu lösen, kommt Process Mining ins Spiel. Process Mining ist eine relativ neue Disziplin unter den Big-Data-Technologien – entstanden aus universitärer Forschung an der TU Eindhoven. Process Mining ermöglicht es, Abläufe aus Big Data heraus abzubilden und zu visualisieren.

So erhält das Unternehmen einen umfassenden Einblick in seine tatsächlichen Abläufe und findet versteckte Kostentreiber, Schwachpunkte und Engpässe. Durch Echtzeit-Visualisierung wird die tatsächliche Prozesskette sichtbar – und das bis auf die kleinste Detailebene. Darauf basierend wird es möglich, Ursachenforschung zu betreiben und Handlungsempfehlungen für die Optimierung der Prozesse abzuleiten. Das Ergebnis: volle Transparenz als Grundlage für erhebliche Effizienzsteigerungen in den eigenen Geschäftsprozessen.

Die Celonis-Gründer Martin Klenk, Bastian Nominacher und Alexander Rinke setzen mit der von ihnen geschaffenen Technologie neue Maßstäbe: „Als wir Celonis gründeten, hatten wir ein ganz klares Ziel: Wir wollen mit unserer Technologie verändern, wie Unternehmen auf der ganzen Welt ihr Geschäft abwickeln und steuern“, so das selbstbewusste Credo der Gründer.

Künstliche Intelligenz trifft Machine Learning

Fast wie ein Unternehmensberater visualisiert die Celonis-Software nicht nur, wo es Verbesserungspotenzial gibt, sondern zeigt proaktiv und automatisiert Ansatzpunkte und Lösungswege auf. „Mit Celonis Pi haben wir Process Mining einen Schritt weitergebracht: Wir unterstützen Verantwortliche bei der Umsetzung ihrer Erkenntnisse in konkrete Maßnahmen“, so Bastian Nominacher. „Unsere Technologie gibt ihnen alle relevanten Informationen und zeigt, welche Abweichungen das operative Geschäft des Unternehmens am stärksten beeinträchtigen und welche weiteren Schritte erfolgversprechend sind. Was dabei so logisch und einfach aussieht, erfordert in Wirklichkeit komplexe Algorithmen. Wir bauen hierbei auf den neuesten Erkenntnissen im Bereich Künstliche Intelligenz und Machine Learning auf.“

Fokus auf B2B-Business

Mit dem Bayerischen Rundfunk als erste Referenz gab es gleich zu Beginn der noch jungen Unternehmensgeschichte einen namhaften Kunden, der von den Ergebnissen und der Entwicklung angetan war. „Unsere Technologie adressiert ganz klar Unternehmen mit vielen Daten. Durch dieses erste sehr erfolgreiche Projekt wurden schnell weitere Firmen auf uns aufmerksam – und so ist es uns in recht kurzer Zeit gelungen, einen beachtlichen Kundenkreis aufzubauen“, erinnert sich Bastian Nominacher. Mittlerweile arbeiten sowohl Mittelständler wie der Elektronik-Distributor Schukat als auch Konzerne wie Airbus, Bayer, Siemens, RWE und Vodafone sowie die Beratungen Deloitte und KPMG mit Celonis.

Globaler Wachstumskurs

Nur fünf Jahre nach der Gründung ist Celonis Weltmarktführer für die Big-Data-Technologie. Und das spiegelt sich nicht nur in den Umsätzen wider: Celonis hat in den letzten Jahren ein Umsatzwachstum von knapp 4000 Prozent hingelegt. Zudem hat Celonis viele renommierte Auszeichnungen bekommen – wie etwa 2016 den Titel „KfW-GründerChampion Bayern“ und die Listung in den Deloitte Fast50 als Deutschlands am schnellsten wachsendes Technologie-Unternehmen.

Der anhaltende Erfolg macht sich auch räumlich bemerkbar: Jetzt ist auch der bislang dritte Büro-Standort in München zu klein geworden, denn Celonis stellte alleine in den letzten Monaten mehr als 80 Personen ein und beschäftigt damit über 140 Mitarbeiter. Der Umzug in ein größeres Bürogebäude fand im Juli statt. Ein Wegzug aus München war dabei kein Thema: „Hier haben wir die perfekte Ausgangssituation: Hier sitzen mit zahlreichen DAX-Unternehmen nicht nur vielversprechende Kunden; durch die TUM, die LMU und die FH ist auch unsere Talentbasis gesichert“, so Nominacher. Und damit sind wir sehr erfolgreich: Im Quartal erreichen uns rund 1000 Bewerbungen – so viele, dass wir unseren eigenen Bewerbungsprozess mit Process Mining optimieren.“

27,5 Mio Euro frisches Kapital

Lange war das Wachstum aus den eigenen Gewinnen finanziert. Mitte 2016 stiegen die Facebook-Investoren Accel und 83North mit 27,5 Millionen US-Dollar Investment bei Celonis ein. Bastian Nominacher kommentiert: „Im Laufe der Jahre haben immer wieder Investoren bei uns angeklopft, mit denen wir auch Gespräche geführt haben. Allerdings hat die Kombination nie gestimmt – wir waren ja auch nicht aktiv auf der Suche und daher besonders kritisch in der Auswahl. Mit Accel und 83North hat es einfach gepasst. Sie haben die Expertise und das Netzwerk, um große Softwareunternehmen aufzubauen – das ist gerade im Zuge unserer globalen Expansion enorm wichtig für uns.“ Die Geldmittel werden vor allem für den Ausbau der weltweiten Verkaufs- und Serviceinfrastruktur, die Weiterentwicklung der Technologie und Internationalisierung genutzt.

„Wir denken groß“

Das Potenzial für Process Mining im Markt ist enorm – das bedeutet für die Celonis-Gründer vor allem eins: weiter zu wachsen. „Wir denken groß: Unsere Mitarbeiterzahl steigt kontinuierlich und soll bis 2020 die Tausender-Marke übersteigen. Zudem wollen wir unsere globale Expansion vorantreiben und unser Produkt weiteren Märkten zugänglich machen“, so Nominacher. Seit rund einem halben Jahr ist Celonis neben dem Hauptsitz in München und seiner Niederlassung in den Niederlanden auch mit zwei Büros in den USA vertreten. Alexander Rinke lenkt von dort aus die Aktivitäten in Nordamerika. „Um dort möglichst schnell eine breite Kundenbasis zu erschließen, müssen wir mit unserem Team vor Ort zu sein. Daher planen wir fünf bis sechs weitere Büros in den USA, unter anderem im Silicon Valley“, erklärt Rinke. Ein durchaus realistisches Vorhaben, da bereits in den ersten Monaten in den USA zahlreiche Fortune 500 Unternehmen wie Cisco oder Adobe als Kunden gewonnen werden konnten.

Daneben steht die Weiterentwicklung der Technologie bzw. des Produkts stets im Fokus, wie der 27-jährige Rinke, unlängst von Forbes unter die „Top 30 unter 30“ gelistet, abschließend erklärt: „Unser Ziel ist es, mit Process Mining eine neue Software-Kategorie für die Analyse von Prozessdaten zu etablieren. Wir wollen es Kunden weltweit ermöglichen, ihre Prozesse mit Hilfe unserer Technologie effizienter zu machen.“ Und dabei setzen er und seine Mitstreiter auf den Austausch mit ihren Kunden – denn die wissen ja meist am besten, was es braucht, um ein Unternehmen noch effizienter zu machen.

Sie möchten selbst ein Unternehmen gründen oder sich nebenberuflich selbständig machen? Nutzen Sie jetzt Gründerberater.de. Dort erhalten Sie kostenlos u.a.:

- Rechtsformen-Analyser zur Überprüfung Ihrer Entscheidung

- Step-by-Step Anleitung für Ihre Gründung

- Fördermittel-Sofort-Check passend zu Ihrem Vorhaben

Diese Artikel könnten Sie auch interessieren:

Mio.-Funding und leergekaufte Lager: Die Entwicklung des BioTech-Start-ups PerioTrap

Ein selektiver Wirkstoff gegen Parodontitis, ausverkaufte Zahnpasta-Bestände und frisch eingesammelte 2,9 Mio. Euro: Das BioTech-Start-up PerioTrap verzeichnet derzeit ein starkes Momentum. Doch wie tragfähig ist das Geschäftsmodell? Eine Analyse zwischen wissenschaftlicher Innovation, Crowdinvesting-Strategie und zahnmedizinischer Realität.

Das Timing war für PerioTrap günstig. Als die Fraunhofer-Gesellschaft Anfang 2026 eine Mitteilung über den neuartigen Wirkstoff des Start-ups gegen Parodontitis veröffentlichte, war das Medienecho groß. Die Folge: Die neu gelaunchte Mikrobiom-Zahnpasta des Unternehmens war innerhalb von zwölf Stunden ausverkauft. Auf diesen kommerziellen Soft-Launch folgte nun der finanzielle Nachschlag. Laut den offiziellen Angaben der Crowdinvesting-Plattform Companisto flossen in der aktuellen Finanzierungsrunde insgesamt 2,9 Millionen Euro in die Kassen, getragen vom Business-Angel-Netzwerk Companisto sowie einem Co-Investment der bmp Ventures (IBG-Fonds). Doch was macht PerioTrap für Anleger so interessant?

Von der Petrischale zum Produkt

Die Wurzeln von PerioTrap reichen bis ins Jahr 2013 zurück. Damals begann die Erforschung des Parodontitis-Erregers Porphyromonas gingivalis im Rahmen des internationalen, EU-geförderten Forschungskonsortiums TRIGGER. Treibende Kraft war der Pharmazeut Dr. Mirko Buchholz, der mit über 25 Jahren Erfahrung in der Wirkstoffentwicklung den Kern der heutigen Technologie erfand. 2019 folgte gemeinsam mit dem Wirtschaftsexperten Pierre Tangermann (heute CEO) die offizielle Ausgründung aus dem Fraunhofer-Institut für Zelltherapie und Immunologie (IZI) am Weinberg Campus in Halle (Saale).

Die Arbeitsteilung der Gründer ist klassisch: Buchholz fungiert als wissenschaftlicher Kopf (CSO), Tangermann übersetzt die Forschung als CEO in eine für Investor*innen verständliche „Equity Story“. Spätestens mit dem Gesamtsieg beim IQ Innovationspreis Mitteldeutschland im Jahr 2020 erlangte das Duo überregionale Sichtbarkeit, die konsequent für die Kapitalsuche genutzt wurde.

Modulation statt Breitbandwirkung

Der Markt, auf den PerioTrap zielt, ist groß. Parodontitis ist eine weit verbreitete Erkrankung; laut der repräsentativen Deutschen Mundgesundheitsstudie (DMS) leidet mehr als die Hälfte der Erwachsenen zwischen 35 und 44 Jahren an einer moderaten oder schweren Form. Die bisherigen Branchenstandards setzen meist auf Breitbandantibiotika oder Antiseptika wie Chlorhexidin. Das Problem dieser Lösungen: Sie greifen das gesamte orale Mikrobiom an und reduzieren auch die nützlichen Bakterien. Bei der Regeneration sind die aggressiven Parodontitis-Erreger oft schneller als die gesunden Bakterien – ein medizinischer Teufelskreis.

PerioTrap setzt stattdessen auf Selektivität. Nach Unternehmensangaben hemmt der patentierte Wirkstoff gezielt ein Enzym (die bakterielle Glutaminylcyclase) des Leitkeims P. gingivalis. Die krankmachenden Eigenschaften des Erregers sollen so blockiert werden, ohne das restliche Mikrobiom anzugreifen. Neben der frei verkäuflichen Zahnpasta für Endkund*innen positioniert das Start-up auch ein professionelles Pflege-Gel für die zahnärztliche Praxis. Zukünftig sollen Haustiere als weiterer Markt erschlossen werden.

Innovation oder ergänzendes Präparat?

Bei aller positiven Resonanz im Crowdinvesting darf das Geschäftsmodell kritisch eingeordnet werden:

- Die Grenzen der Biologie: Die Deutsche Gesellschaft für Parodontologie (DG PARO) lobte in einem aktuellen Statement vom Februar 2026 zwar den innovativen Ansatz aus den Laboren. Die Fachgesellschaft warnt jedoch davor, Parodontitis auf ein spezifisches Bakterium zu reduzieren. Es handele sich um eine polymikrobielle Infektion aus einem Zusammenspiel Hunderter Bakterienarten. Der PerioTrap-Wirkstoff attackiert den „Leitwolf“, kann die komplexe Krankheit als alleiniges Mittel jedoch nicht besiegen.

- Keine „Abkürzung“ für Patient*innen: Für den/die Endkund*innen birgt die Zahnpasta im Premium-Preissegment die Gefahr einer trügerischen Sicherheit. Gemäß den zahnmedizinischen Leitlinien der Bundeszahnärztekammer (BZÄK) und der Fachgesellschaften kann ein kosmetisches Zahnpflegeprodukt eine professionelle Diagnostik, mechanische Taschenreinigung und Therapieplanung beim Zahnarzt bzw. bei der Zahnärztin nicht ersetzen. Klinische Langzeitstudien am Menschen müssen erst noch beweisen, ob die Zahnpasta im Patient*innenalltag signifikante Effekte auf klinische Parameter wie Sondierungstiefen und Zahnfleischbluten hat.

- Crowdfunding als strategisches Instrument: Tangermann nutzt Plattformen wie Companisto sehr bewusst. Das bringt nicht nur Kapital, sondern auch sofortige Kund*innenkreise. Gleichzeitig räumt das Management ein, dass durch den Zuwachs an hunderten Kleininvestor*innen der administrative Abstimmungsprozess deutlich komplexer wird.

Klarer Fokus auf den Trade-Sale

Für die Start-up-Szene ist PerioTrap ein Beispiel dafür, wie komplexe „DeepTech“-Forschung in ein Consumer-Product übersetzt wird. Der Vertriebs-Soft-Launch als B2C-Zahnpasta generiert erste Umsätze, erzeugt mediale Aufmerksamkeit und senkt das wahrgenommene Risiko für institutionelle Investoren.

Doch das Endkunden-Geschäft mit Zahnpasta ist höchstwahrscheinlich nicht das finale Ziel der Gründer. Die Unternehmensstrategie deutet auf einen klassischen Trade-Sale hin: Man positioniert sich im stark wachsenden Segment der „Microbiome Oral Care“, baut Marktpräsenz und einen „Proof of Concept“ auf und macht sich als Übernahmeziel attraktiv. Große Akteure wie Colgate, GC Dental oder Haleon suchen kontinuierlich nach Innovationen in diesem Bereich.

PerioTrap hat mit dem jüngsten Funding und dem Verkaufsstart bewiesen, dass eine Nachfrage besteht. Nun folgt die anspruchsvollere Phase: Die Skalierung der Produktion und der wissenschaftliche Beweis, dass das große Interesse an der Mikrobiom-Zahnpasta dauerhaft gerechtfertigt ist und sich als fester Bestandteil der zahnmedizinischen Prävention etablieren kann.

Vivid: Runway verlängern mit US-Dollar

Das FinTech Vivid Money, 2019 von Alexander Emeshev und Artem Iamanov in Berlin gegründet, meldet 100.000 KMU-Kund*innen und lockt Start-ups mit bis zu 5 Prozent Zinsen auf Dollar- und Pfund-Guthaben. Für international finanzierte Gründungsteams ist das Angebot attraktiv, um die eigene Runway zu verlängern. Doch ein genauer Blick auf die Konditionen und den harten Wettbewerb im Business-Banking zeigt: Gründende müssen spitz kalkulieren.

Vivid Money positioniert sich im Geschäftskundensegment mit einem erweiterten Cash-Management-Angebot. Im Zentrum der Ankündigung stehen Verzinsungen, die speziell auf die Bedürfnisse international finanzierter Start-ups zugeschnitten sind. Geschäftskund*innen erhalten auf Guthaben in US-Dollar und britischen Pfund bis zu 5 Prozent Zinsen pro Jahr. Auf Euro-Guthaben zahlt das Unternehmen bis zu 4 Prozent.

Bei diesen Zahlen ist jedoch eine kritische Einordnung geboten: Es handelt sich um klassische, zeitlich befristete Lockangebote zur Neukund*innengewinnung. Der Spitzenzinssatz für Fremdwährungen gilt für fünf Monate. Der Zinssatz für Euro-Guthaben ist auf vier Monate begrenzt. Nach Ablauf dieser Aktionszeiträume fallen die Zinsen deutlich ab – auf bis zu 3 Prozent für Fremdwährungen und bis zu 2 Prozent für den Euro, was zudem an den jeweils gewählten Tarif des FinTechs gekoppelt ist. Darüber hinaus behält sich der Anbieter vor, die Zinssätze je nach Marktlage oder nach eigenem Ermessen anzupassen.

Jenseits der Marketing-Zahlen bietet die strukturelle Erweiterung der Plattform jedoch einen greifbaren administrativen Nutzen für Gründerinnen und Gründer. Da viele Start-ups ihr Kapital durch US-Investor*innen in Dollar erhalten, mussten diese Gelder bislang oft aufwendig und gebührenpflichtig umgeschichtet werden. Vivid ermöglicht es nun, internationale SWIFT-Zahlungen direkt aus den verzinsten USD- und GBP-Konten heraus zu tätigen. Zusätzliche Bankpartner, externe Treasury-Lösungen oder teure Währungsumrechnungen entfallen für diese Transaktionen. Zudem öffnet die Plattform, die nun vollständig über den Webbrowser bedienbar ist, den Zugang zu über 1850 Assets (Money Market Funds, ETFs, stocks, iBonds, crypto).

Für junge Unternehmen ohne eigene Finanzabteilung stellt dies eine niedrigschwellige Möglichkeit dar, Teile der Firmenrücklagen strukturiert anzulegen und brachliegendes Kapital zumindest als Inflationsausgleich arbeiten zu lassen.

Vom B2C-Hype zur pragmatischen B2B-Plattform

Vivid startete ursprünglich mit einer gänzlich anderen Vision in den Markt. In der Hochphase des Fintech-Booms positionierte sich das von namhaften Investoren wie Greenoaks Capital und DST Global Partners finanzierte Unternehmen als verbraucher*innenorientierte App mit einem starken Fokus auf Krypto-Trading und Cashback-Programme. Die harte Marktrealität im Privatkund*innengeschäft, dominiert von Playern wie N26 und Revolut, zwang das Management jedoch zu einem strategischen Kurswechsel.

Vivid vollzog einen weitreichenden Pivot weg vom reinen Endkonsument*innen und wandte sich dem Geschäftskund*innensegment zu. Dieser Strategiewechsel scheint aufzugehen, denn nach Unternehmensangaben konnte in weniger als zwei Jahren die Marke von 100.000 KMU-Kund*innen überschritten werden.

Das Treasury-Volumen spiegelt diese Neuausrichtung ebenfalls wider: Zwischen Februar 2025 und Februar 2026 wuchs die Zahl der Treasury-Nutzer*innen um das Zweieinhalbfache, während sich die verwalteten Einlagen im selben Zeitraum verdreifachten. Die von Mitgründer Alexander Emeshev und dem für das Treasury verantwortlichen Esmond Berkhout formulierte Strategie setzt nun vollends darauf, Start-ups eine kombinierte Infrastruktur aus alltäglichem Banking und anspruchsvolleren Anlageprodukten zu bieten. Für das Jahr 2026 hat das Management das ambitionierte Ziel ausgegeben, die Kund*innenzahl in diesem Segment abermals zu verdoppeln.

Ein hart umkämpftes Oligopol

Der aktuelle Vorstoß in das Zinsgeschäft für Fremdwährungen trifft einen wunden Punkt der europäischen Gründer*innenszene. Das allgemeine Finanzierungsumfeld hat sich merklich abgekühlt, Finanzierungsrunden dauern deutlich länger und Kapital wird von Investor*innen spürbar selektiver vergeben. Gleichzeitig stammen laut KfW-Daten rund 60 Prozent der Startup-Investitionen von internationalen Geldgeber*innen, wobei gut ein Viertel des Kapitals allein aus den USA fließt. Die Verlängerung der sogenannten Runway durch ein aktives Liquiditätsmanagement rückt daher gezwungenermaßen ins Zentrum der Finanzplanung vieler Gründungsteams. Dennoch bewegt sich Vivid bei dem Versuch, dieses Problem zu lösen, in einem hochkompetitiven Umfeld.

Im europäischen B2B-Banking dominieren stark finanzierte und etablierte Player wie der französische Marktführer Qonto, der finnische Pionier Holvi oder aufstrebende Herausforderer wie Finom. Auch Revolut Business ist mit aggressiven Preismodellen dauerpräsent. Die strategische Differenzierung von Vivid liegt im Versuch, sich nicht nur als reines Transaktionskonto, sondern als holistisches Betriebssystem für Finanzen zu etablieren, das operative Liquidität und strukturierten Anlageverkehr verschmilzt.

Für uns ergibt sich aus dieser Entwicklung ein klares pragmatisches Bild. Das temporäre Zinsangebot in Dollar und Pfund ist ein unbestreitbar attraktives Vehikel für frisch finanzierte Start-ups mit internationalen Investor*innen, um Währungsverluste durch Liegegelder zu minimieren und das aufgenommene Kapital sofort arbeiten zu lassen.

Gründungsteams müssen jedoch fernab des ersten Zinsversprechens nüchtern kalkulieren. Es gilt genau zu prüfen, ob die fixen Grundgebühren der verschiedenen Vivid-Tarife und die Konditionen nach Ablauf der viermonatigen respektive fünfmonatigen Lockzinsphase langfristig tatsächlich wirtschaftlicher sind als die etablierten Strukturen und Konditionen der direkten Wettbewerber*innen am Markt.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

KI gegen Buchhaltungsriesen: Wie Bonster den Spesen-Markt aufmischen will

Pay-per-Use statt Abo-Falle: Das Oldenburger Start-up fast2work attackiert mit seiner App bonster komplexe Software-Giganten. Doch reicht das Versprechen maximaler Einfachheit im Haifischbecken der FinTechs? Wir haben nachgehakt.

Es ist eines der letzten großen Ärgernisse im Arbeitsalltag von Freelancer*innen und kleinen Agenturen: Der Freitagabend, der für das Sortieren verknitterter Tankbelege und das Abtippen von Bewirtungsbelegen in Excel-Listen draufgeht. Genau hier setzt die Oldenburger fast2work GmbH mit ihrer am 17. Februar 2026 gelaunchten App bonster an, um den Papierkram bei der Reisekostenabrechnung zu beenden. Das Versprechen von Gründer und CEO Ronald Bankowsky: Drei Minuten Aufwand, KI-Automatisierung und keine Einstiegshürden.

Das Versprechen: Simpel statt Systemintegration

Die Funktionsweise der App ist bewusst minimalistisch gehalten: Beleg fotografieren, woraufhin die KI relevante Werte wie Datum, Betrag und Mehrwertsteuer ausliest, auf Duplikate prüft und eine fertige Abrechnung erstellt. „Kein Onboarding-Projekt, kein Vertriebsgespräch, kein IT-Setup“, fasst Bankowsky den Ansatz der Standalone-Lösung zusammen.

Die Zielgruppe ist klar definiert: Selbständige, Freelancer*innen und Mini-Teams, denen Enterprise-Lösungen wie SAP Concur zu mächtig und Start-ups wie Circula oder Pleo oft noch zu prozesslastig sind. Mit einem Preismodell von 1,99 Euro für Einzelabrechnungen und 6,99 Euro (Stand Ende Febr. 2026) für eine Flatrate positioniert sich das Unternehmen im unteren Preissegment.

Im Haifischbecken der Neobanken und Buchhaltungsriesen

Laut fast2work gab es bislang „kaum eine Alternative zwischen Excel und Enterprise-Software“. Diese Aussage hält einem Realitätscheck im Jahr 2026 allerdings nur bedingt stand. Bonster betritt ein Haifischbecken, denn die vermeintliche Lücke wird längst geschlossen.

Zum einen integrieren Buchhaltungsriesen wie Lexoffice oder sevDesk Reisekosten-Features immer tiefer in ihre Standardpakete. Zum anderen wildern Neobanken wie Qonto, Finom oder Kontist im selben Revier: Wer dort ein Geschäftskonto hat, bekommt die Belegzuordnung oft als „Commodity“ gratis dazu. Mit knapp 7 Euro im Monat bewegt sich bonster in einer Preisregion, in der man fast schon eine komplette einfache Buchhaltungssoftware bekommt. Die App muss also einen enormen Mehrwert bieten, um gegen die „Eh-da-Lösungen“ (Software, die Kund*innen ohnehin bezahlen) zu bestehen.

Auf die Frage, warum Freelancer*innen für eine Insellösung extra zahlen sollten, entgegnet der Gründer, dass bonster bewusst früher ansetze als klassische Tools. Das Hauptproblem sei nicht die Buchhaltung, sondern das Erfassen von Belegen unterwegs. „Genau dort scheitert es oft, weil Mitarbeitende keine komplexen Systeme nutzen wollen oder gar keine Zugänge haben“, argumentiert Bankowsky. Der Mehrwert liege nicht in einer weiteren Buchhaltungssoftware, sondern darin, dass durch die Reduzierung auf ein Foto „überhaupt verwertbare Abrechnungsdaten/Belege entstehen“.

Kritische Faktoren: GoBD und Datensicherheit

Neben der Marktpositionierung ist die Rechtssicherheit ein kritischer Faktor. „Fertige Abrechnung für die Buchhaltung“ ist ein mutiges Versprechen, da in Deutschland ein Foto allein oft nicht ausreicht; es muss GoBD-konform und revisionssicher archiviert werden. Zudem ist die KI-Nutzung datenschutzrechtlich sensibel. Wenn Bewirtungsbelege, die offenbaren, mit wem man gegessen hat, über US-Schnittstellen (z.B. OpenAI) fließen, ist das für deutsche Geschäftskund*innen und Steuerberater oft ein K.O.-Kriterium.

Auf die sensiblen Vorgaben der Finanzämter und den Serverstandort angesprochen, betont Bankowsky, dass die Verarbeitung „ausschließlich auf europäischen Servern“ erfolge. Zwar nutze man OpenAI-basierte Modelle, diese liefen jedoch über Azure-Rechenzentren im europäischen Raum. Datenschutz und regulatorische Anforderungen seien Grundvoraussetzung. Auch beim Export zum Steuerberater zeigt sich der Gründer zuversichtlich: Buchhaltungssysteme könnten die Daten direkt und „ohne manuelle Nacharbeit“ weiterverarbeiten.

Beta-Test als Exklusiv-Club

Zum Start setzt das Unternehmen auf eine Gamification des Rollouts. Die ersten 500 Nutzer*innen erhalten im „Club 500“ einen lebenslangen Rabatt von 50 Prozent. Was als Belohnung für Early Adopters verkauft wird, ist strategisch notwendig: Die KI muss lernen. Der Algorithmus braucht dringend „Real World Data“ – echte, verknitterte, schlecht beleuchtete Belege. Das bedeutet auch: Die ersten User*innen sind Teil des Entwicklungsprozesses.

Dass die App im Alltag noch dazulernen muss, räumt Bankowsky ein. Bei der reinen Datenerkennung sei man technisch auf dem aktuellen Stand. „Entscheidend ist jedoch die Qualität realer Belege im Alltag – etwa schlecht fotografierte oder handschriftliche Quittungen“, erklärt er den Bedarf an Praxis-Feedback. Durch schnelle Updates solle die Genauigkeit für alle Nutzer*innen laufend steigen.

Gegenmodell zur Ökosystem-Abhängigkeit

Wer ein Feature-Feuerwerk suche, werde bei bonster enttäuscht sein – was laut Unternehmen aus Überzeugung geschehe. Anbieter wie Rydoo verfolgten eine Strategie der maximalen Integration und langfristiger Verträge, was eine Abhängigkeit erzeuge, die ihr eigentliches Geschäftsmodell sei, so der Gründer. Wer einmal im Ökosystem stecke, wechsle nicht mehr, weil der Ausstieg zu teuer geworden sei.

Bonster positioniert sich als Gegenmodell für Unternehmen, die nicht für ungewollte Komplexität zahlen möchten: Kein Vertrag, keine Mindestnutzerzahl, Setup in unter fünf Minuten und ein Pay-per-Use-Modell. „Wer aufhören will, hört auf, ohne Konsequenzen“, beschreibt das Start-up den Ansatz der bewussten Entscheidung, Kund*innen freizulassen. Wer bleibe, tue dies, weil es funktioniere, was laut Bankowsky „die interessantere Innovation“ sei.

Fazit

Bonster ist ein innovativer Angriff auf die Zettelwirtschaft und wirkt durch den Verzicht auf starre Abo-Modelle bei der Einzelabrechnung fair. Doch die App steht und fällt mit der Schnittstellenkompetenz. Wenn der Export zu DATEV & Co. hakt, wird aus der Zeitersparnis schnell Mehrarbeit. Bonster muss beweisen, dass es die Brücke zwischen dem schnellen Foto und der strengen deutschen Buchhaltung schlagen kann – und zwar besser als die Banken, die das Feature bereits kostenlos anbieten.

Distart: Vom Agentur-Frust zum EdTech-Champion

Wie das 2021 von Thomy Roecklin gegründete und seit 2025 zusammen mit Lucia-Miriam Selbert geführte Leipziger EdTech Distart das Bildungssystem „gegen den Strich bürstet“.

Wer in Deutschland über Start-up-Hubs spricht, landet meist schnell in Berlin oder München. Doch in der sächsischen Metropole Leipzig wächst seit einigen Jahren ein Player heran, der beweist, dass Innovation auch abseits der üblichen Verdächtigen gedeiht: Die Distart Education GmbH. Ihr Treibstoff ist der eklatante Mangel an digitaler Kompetenz in der deutschen Wirtschaft – und der Mut, das „System Bildung“ gegen den Strich zu bürsten.

Wenn „Done for You“ nicht mehr reicht

Die Wurzeln des Unternehmens reichen weiter zurück als das offizielle Gründungsjahr 2021. Gründer Thomy Roecklin setzte jahrelang mit seinen Agenturen MNKY lab und TRDIGITAL digitale Kampagnen für Kund*innen um. Doch im Tagesgeschäft bremste das fehlende Digitalverständnis auf Kundenseite die Projekte immer wieder aus. Die Erkenntnis, dass Deutschland weniger neue Agenturen, sondern mehr digitale Mündigkeit braucht, führte schließlich zum Pivot.

Interessanterweise war der Auslöser für diesen Kurswechsel kein konkretes Kundenprojekt. Auf die Frage nach dem „Aha-Moment“ erklärt Roecklin, dass er lediglich versuchte, Lucia-Miriam Selbert einzuarbeiten, und dabei schockiert feststellte, wie wenig praxisnahe digitale Weiterbildungen existierten. Er baute kurzerhand selbst ein Lernprogramm – ohne zu ahnen, dass daraus einmal Distart entstehen würde. Im Januar 2021 fiel der Startschuss für Distart learn. Mitten in der Pandemie setzte Roecklin auf ein Modell, das sich radikal von klassischen Bildungsträgern unterschied: 100 Prozent remote, aber mit enger persönlicher Betreuung und einem klaren Fokus auf die Praxis.

Das Schnellboot zwischen den Tankern

Distart operiert im sogenannten AZAV-Markt (Akkreditierungs- und Zulassungsverordnung Arbeitsförderung). Während etablierte Bildungsriesen oft mit der Trägheit ihrer Größe kämpfen und bis zu 24 Monate für Lehrplananpassungen benötigen, hat sich Distart als agiler „Qualitäts-Vorreiter“ positioniert.

Für Roecklin ist diese Agilität eine Frage des Überlebens, da sich Jobs und Skills heute schneller verändern als jede klassische Bildungslogik. Er betont, dass man ohne permanente Weiterentwicklung der Inhalte zwangsläufig am Markt vorbei ausbilden würde. Diese Flexibilität ist zudem essenziell für die Zielgruppe: Viele Teilnehmende bilden sich neben ihrem 9-to-5-Job weiter, betreuen Kinder oder pflegen Angehörige und benötigen daher flexible statt starrer Strukturen.

Agency-DNA statt Schulbank-Feeling

Der entscheidende Wettbewerbsvorteil liegt in der Herkunft: Distart ist keine klassische Schule, sondern wurde von Marketern für Marketer gebaut. Diese „Agency-DNA“ durchzieht das gesamte Geschäftsmodell. Mit einer modernen Lernumgebung aus Live-Sessions und asynchronen Deep-Dives spricht das Unternehmen alle Altersgruppen gleichermaßen an.

Auch technologisch ist man der Konkurrenz oft einen Schritt voraus: Als ChatGPT Ende 2022 die Arbeitswelt veränderte, reagierte Distart fast in Echtzeit. Auf die kritische Frage, ob KI das vermittelte Wissen nicht bald obsolet mache, findet Roecklin eine klare Antwort: KI ersetzt keine Menschen, sie ersetzt lediglich Mittelmaß. Während KI das Netz mit generischen Inhalten flutet, steige paradoxerweise der Hunger nach echten Stimmen, Ideen und Perspektiven – Marketing werde also menschlicher.

Bootstrapping und gesundes Wachstum

Der Erfolg gibt dem Konzept recht. Im September 2024 erfolgte die Umfirmierung zur Distart Education GmbH, was den Übergang vom Start-up zum etablierten Bildungsinstitut markierte. Während andere Tech-Unternehmen Personal abbauen mussten, verdoppelte Distart seine Belegschaft beinahe auf über 100 Köpfe und bezog im Oktober 2025 neue Räumlichkeiten im NEO Leipzig.

Besonders bemerkenswert: Das Wachstum ist organisch und gebootstrapped – finanziert aus dem eigenen Cashflow ohne externe Risikokapitalgeber. Das macht Distart unabhängig von Exit-Druck. Seit Februar 2025 verstärkt Lucia-Miriam Selbert als Geschäftsführerin die strategische Ausrichtung.

Dennoch birgt die Skalierung Risiken, da das Geschäftsmodell stark von staatlichen Bildungsgutscheinen abhängt. Auf einen möglichen „Plan B“ angesprochen, erklärt das Unternehmen, dass Förderungen zwar beim Beschleunigen helfen, man Distart aber bewusst so aufbaue, dass langfristig strukturelle Unabhängigkeit erreicht wird. Auch die Qualitätssicherung bei über 100 Mitarbeitenden ist eine Herausforderung. Thomy Roecklin gibt offen zu, dass Wachstum kein Wellnessprogramm ist und es im Getriebe zwangsläufig knirscht. Sein Schlüssel: Qualität darf nicht an Einzelpersonen hängen, sondern muss im gesamten System verankert sein, kombiniert mit echtem Vertrauen in das Team statt Kontrolle.

Der Standort als Statement und Vision

Dass Distart in Leipzig verwurzelt bleibt, ist Teil der Identität. Roecklin sieht im Osten Deutschlands ein enormes, oft unterschätztes Potenzial und erlebt dort viel Talent, Pragmatismus und Lernhunger. Distart versteht sich hier auch als Regionalentwickler.

Die Vision der Gründer geht jedoch über reine Kurse hinaus. Unterstrichen durch Auszeichnungen wie „Top Fernschule 2025“ und „2026“, arbeitet das Team nun an der Gründung der Distart University of Applied Sciences. Das Ziel bis 2030 ist ambitioniert: Ein Alumni-Netzwerk von 25.000 Absolvent*innen. Sollte der komplexe Weg zur staatlichen Anerkennung gelingen, wird Distart endgültig zum gewichtigen Faktor für die digitale Wettbewerbsfähigkeit der Bundesrepublik.

Vom Check-in zur Patient*innenakte: Wie Travel-Pionier Salim Sahi mit HoloLogix.AI die Health-IT aufmischt

Vom Reisebuchungssystem zur Sicherheits-Uhr für Senior*innen: Serial Entrepreneur Salim Sahi greift mit HoloLogix.AI greift gleich zwei Milliardenmärkte an: Gesundheitswesen und Hotellerie. Doch wie viel Substanz steckt hinter der Vision?

Gründungslegenden klingen oft zu glatt für die Realität – wie Sahis Skateboard-Unfall, der in einer Notaufnahme zur Idee für sein neuestes Venture führte. Wer den Mann kennt, der in den 90ern mit „Traffics“ die Reisebranche digitalisierte, weiß jedoch: Er macht keine halben Sachen. Jetzt, im Februar 2026, steht er mit einer europäischen Aktiengesellschaft (SE) und einem enorm breiten Versprechen wieder auf dem Platz.

Wie Touristik-Know-how in die Klinik kommt

Der Sprung von der Touristik zur Service-Automatisierung im Gesundheitswesen wirkt wie ein harter Bruch. Doch unter der Haube geht es in beiden Welten um hochvolumige Transaktionen, Termin-Slots und Datenabgleich in Echtzeit. Wer Millionen Pauschalreisen fehlerfrei abwickelt, so die Wette von HoloLogix.AI, beherrscht auch das Termin-Management von Kliniken, Hotels und Restaurants.

Für CEO und Gründer Salim Sahi ist das Projekt dennoch ein „kompletter unternehmerischer Neuanfang“. Gegenüber StartingUp räumt er ein, von 25 Jahren Travel-Tech-Erfahrung zu profitieren, doch seine wahre Passion gelte der künstlichen Intelligenz. Das Herzstück bilde dabei die MIA Service KI: „Wir haben eine holistische KI-Plattform geschaffen, also ein Tool, das ganzheitlich agiert und eingesetzt werden kann.“ MIA verstehe Gespräche, erledige parallel Aufgaben und verbinde Systeme – „rund um die Uhr und branchenübergreifend“. Auch wenn der Fokus aktuell auf Gesundheitswesen und Hospitality liege, sei das System laut Sahi letztlich „nahezu überall einsetzbar, wo Kunden- oder Patientenkontakt herrscht.“

Der Angriff auf die Platzhirsche

Der Markt für Conversational AI ist 2026 kein blauer Ozean mehr. Etablierte Player wie Aaron.ai haben sich tief in die Health-Landschaft eingegraben, flankiert von Plattform-Giganten wie Doctolib. HoloLogix.AI reagiert mit aggressiven Preisen ab 99 Euro im Monat und einer massiven technologischen Breite.

Aber warum sollten Klinikverantwortliche das Risiko eines Wechsels eingehen? Salim Sahi sieht den „Killer-USP“ in der Architektur der Interaktion: „Unser Ansatz ist ein anderer: Statt starrer Skripte bieten wir echte Gesprächsintelligenz durch Conversational AI an.“ Das System sei eine KI, die im laufenden Gespräch aktiv Aufgaben erledige, was eine beispiellose Integrationstiefe erfordere. „Hier gehen wir ganz tief rein und verarbeiten Daten in Echtzeit“, so der CEO. Da Aufgaben direkt ausgeführt werden, optimiere sich das Zeitmanagement drastisch – konzipiert als Omnichannel-Ansatz über Telefon, Website, E-Mail, Wearables oder bald sogar über Robotik.

Die schmale Gratwanderung am Handgelenk

HoloLogix.AI belässt es nicht bei Software, sondern bringt mit der MIA Watch eigene Hardware ins Spiel. Die Smartwatch für Senior*innen soll Stürze erkennen und sofort einen aktiven Sprachdialog führen. Eine Gratwanderung: Reines Assistenz-System oder medizinisches Gerät mit komplexer Zertifizierungspflicht (MDR)?

Prof. Dr. Thomas Fuchs, Co-Founder und Aufsichtsrat für den Bereich Health Care, ordnet das rechtlich eindeutig ein: „MIA Protect ist ein Teil der holistischen KI-Plattform, die mit verschiedenen Health Watches wie z.B. auch der Apple Watch kompatibel ist. Sie ist ein Assistenz- und Companion-System.“ Die Hardware erkenne Stürze, ersetze aber „keine ärztliche Untersuchung oder medizinische Entscheidung“. Um Geschwindigkeit und Nutzer*innenfreundlichkeit zu wahren, bewege man sich „bewusst außerhalb der Medizinprodukt-Zertifizierung (MDR), ohne den Sicherheitsrahmen zu verlassen“.

Ein mehrstufiges Sicherheitsnetz aus Sensorik, KI-Algorithmen und menschlichem Service-Team federt Fehlinterpretationen ab. Haftungsfragen sind laut Fuchs über klare Nutzungsbedingungen geregelt. Für den Mediziner steht ohnehin der „Companion Aspekt“ im Vordergrund: Nach einem Sturz, wenn Patient*innen hilflos am Boden liegen, alarmiere MIA in einer Kaskade Notfallkontakte und beruhige das Unfallopfer, bis Hilfe eintrifft. „MIA Protect soll an diesem Punkt Sicherheit und damit Lebensqualität geben, vielleicht sogar die Möglichkeit schaffen für Senioren, länger selbstbestimmt in ihrem Zuhause zu leben“, resümiert Fuchs.

Pflegeheim und Luxushotel: (K)ein operativer Widerspruch?

Das vielleicht Spannendste an HoloLogix.AI ist das Personal: Salim Sahi hat sich politische und ethische Schwergewichte in den Aufsichtsrat geholt. Darunter Dr. Marcel Klinge, ehemaliger FDP-Bundestagsabgeordneter und Tourismus-Experte. Er muss Investor*innen den Spagat erklären, warum ein Start-up gleichzeitig Pflegeheime und Luxushotels digitalisieren will – was oft als Warnsignal für operative Verzettelung gilt.

Dr. Marcel Klinge sieht darin jedoch keinen Widerspruch, sondern die Stärke der technischen Basis: „Der gemeinsame Nenner liegt im Kern: Unsere holistische KI-Infrastruktur kann über das Telefon Gespräche führen, kann aber auch über die Website, Health Watches und Devices und direkt im Gespräch Aufgaben ausführen.“ Das Backend orchestriere lediglich Termin-Slots, Daten und Anfragen in Hochgeschwindigkeit. Dabei spiele es schlichtweg keine Rolle, „ob der Kunde Patient in einem Pflegeheim oder Gast in einem Luxushotel ist.“

Wenn die KI-Vision auf den deutschen Fax-Alltag trifft

Ein Blick auf die Website verrät große Visionen, doch diese müssen sich im harten Alltag deutscher IT-Infrastrukturen und oft veralteter Praxis-Server beweisen. Zudem ist die Frage des Datenschutzes elementar: Nutzt das Unternehmen US-amerikanische Sprachmodelle via API, oder hostet man eigene „Sovereign AI“ in Europa?

Für Prof. Dr. Thomas Fuchs sind Datenschutz und Systemintegration absolute Kernpunkte. Um digitale Souveränität zu wahren, setzt das Unternehmen auf einen hybriden Weg: „Wir orchestrieren auf die gängigen sowie auf eigene Modelle auf deutschen Servern, die in Europa bereits genutzt werden.“ Laut Fuchs verlässt man sich dabei nicht nur auf das Versprechen von Sicherheit, sondern arbeitet seit der ersten Stunde eng mit dem renommierten Fraunhofer-Institut zusammen und lässt die eigene Infrastruktur „regelmäßig durch deren Experten prüfen“. Das bloße Versprechen von Sicherheit reicht HoloLogix.AI dabei nicht.

Mehr als nur ein GPT-Wrapper?

HoloLogix.AI ist eine der vielleicht ambitioniertesten Gründungen des Jahres. Technologisch muss es beweisen, dass es mehr ist als ein „GPT-Wrapper“ mit Smartwatch. Aber die Kombination aus Sahis Exekutiv-Erfahrung, Klinges Netzwerk und Fuchs‘ ethischem Korrektiv macht es zu einem spannenden Herausforderer. Wenn die Uhr im Alltag für Sicherheit sorgt – und die KI den deutschen Datenschutz überlebt – könnte aus Berlin der nächste europäische Champion kommen.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

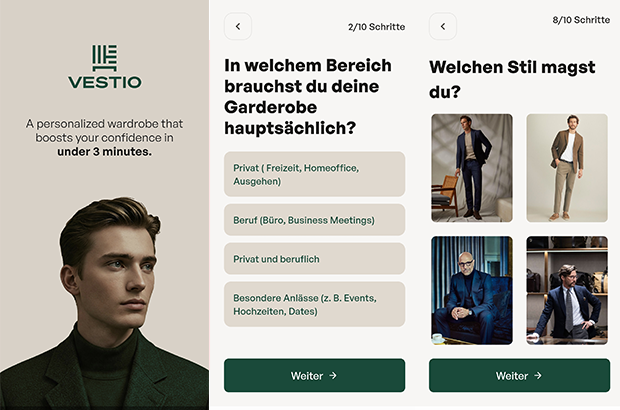

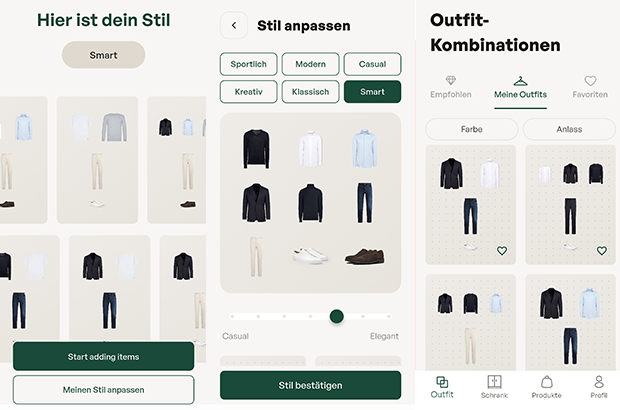

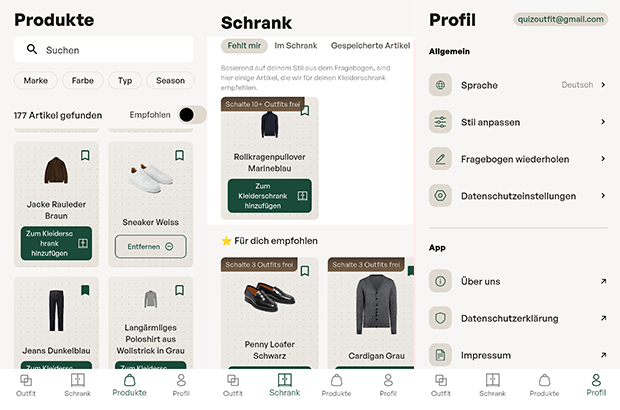

VESTIO: Wenn ein Solar-Entrepreneur auf einen Stil-Rebellen trifft

Die Geschichte der jungen FashionTech-App VESTIO ist zugleich die zweier Gründer, die sich in einem gemeinsamen Ziel treffen: Die Demokratisierung von gutem Stil durch algorithmische Logik.

Hinter der FashionTech-App VESTIO steht die im Jahr 2024 von Bastian Arend und Justus Hansen gegründete Opus Stilberater GmbH, die den Anspruch erhebt, professionelle Stilberatung erstmals digital, logisch und kostenlos zugänglich zu machen.

Der „Solar-Entrepreneur“ trifft den Stil-Rebell

Die persönlichen Hintergründe der Gründer bieten spannende Kontraste, die weit über ein übliches Business-Profil hinausgehen. Bastian Arend, Co-Founder und CEO, kam über die Energiewende zur Mode. Als Seriengründer baute er den Online-Solar-Anbieter Klarsolar auf und verkaufte ihn im Dezember 2023 erfolgreich an den Energiekonzern E.ON. Die Übernahme erfolgte in einer für die Solarbranche schwierigen Marktphase, was Bastian Arend als Krisen-erprobten Strategen auszeichnet.

VESTIO entwickelte er 2024 jedoch aus einem ganz persönlichen „Pain Point“ heraus: Während er internationale Millionen-Finanzierungsrunden leitete, bestand sein eigener Stil mangels Zeit lediglich aus Hoodie, Jeans und Sneakern. „Ich wollte nur jemanden, der für mich einkauft“, erinnert er sich an diese Phase. Seine Abneigung gegen zeitraubendes Shopping führte ihn schließlich zu Justus Hansen.

Justus Hansen, Co-Founder und Chief Styling Officer, bringt eine Biografie ein, in der Mode schon immer eine zentrale Rolle spielte. Sein Gespür für klassische Mode ist tief verwurzelt: Justus Hansen trug bereits im Kindergarten eine Fliege und provozierte später Lehrer, indem er im Sakko zum Unterricht erschien. Bevor er mit über 1,6 Millionen Follower*innen zu einem der bekanntesten Männerstilberater Deutschlands aufstieg, studierte er Jura und absolvierte Praktika im Bankensektor, unter anderem bei der Dresdner Bank.

Diese Erfahrungen schärften seinen Blick für die Anforderungen moderner „Business-Garderoben“. Als Arend ihn fragte, ob er für ihn einkaufen könne, antwortete Justus Hansen bestimmt: „Einfach irgendwas kaufen? Nein. Ich muss verstehen, wer du bist.“ Bastian Arend begriff Hansens modulare Styling-Methode sofort als logisches System und schlug vor: „Wir sollten deine Methode digitalisieren und kostenlos für jeden Mann zugänglich machen.“ Für Justus Hansen wurde damit ein „Lebenstraum“ wahr.

Das Konzept: „Weniger Teile, mehr Outfits“

Das Herzstück der App bildet ein algorithmisches Styling-System, das strikt dem Leitsatz „Weniger Teile. Mehr Outfits“ folgt. In nur drei Minuten erstellt ein Stilfinder-Fragebogen eine persönliche Grundgarderobe. Der digitale Kleiderschrank funktioniert dabei bewusst ohne das mühsame Hochladen von Fotos; das System kennt die wichtigsten Basics, erkennt Lücken und empfiehlt gezielt Ergänzungen. Justus Hansen betont dabei die Wichtigkeit der Basis: „Die wenigsten Männer besitzen eine echte Basisgarderobe. Und das ist die Grundlage, aus der ihre besten Outfits entstehen.“

Ziel ist es, automatisch kombinierbare Outfits für alle Anlässe zu generieren. Dabei verfolgen die Gründer eine klare ästhetische Linie: „Outfits müssen nicht kompliziert sein, um zu wirken. Sie brauchen lediglich eine klar erkennbare Linie“, so Hansen. Bastian Arend ergänzt: „Die besten Outfits für Männer sind nicht kompliziert, sondern harmonisch und durchdacht.“

Das Affiliate-Dilemma: Geschäftsmodell im kritischen Check

Wirtschaftlich operiert VESTIO über ein Affiliate-Modell. Die App ist für Nutzer kostenlos, während das Unternehmen Provisionen von Partner-Anbietern bei einem erfolgreichen Kauf erhält. Hier liegt für den kritischen Betrachter ein interessanter systemischer Interessenkonflikt: Das erklärte Ziel „Weniger Konsum – bessere Entscheidungen“ steht ökonomisch potenziell im Widerspruch zu einem Modell, das von Transaktionen lebt. Zudem stellt sich die Frage der langfristigen Nutzerbindung: Sobald ein Mann seine „perfekte Garderobe“ aufgebaut hat, sinkt der Bedarf für weitere Anschaffungen. Dass das Unternehmen dennoch auf Wachstum setzt, zeigt die Erhöhung des Stammkapitals auf knapp 30.000 Euro im September 2025. Langfristig plant VESTIO die Integration eines Marktplatzes, der Partnerprodukte und eigene Kollektionen vereint, um basierend auf Daten den größten Mehrwert zu liefern.

Marktpositionierung und technologischer Vorsprung

Im Vergleich zum Wettbewerb besetzt VESTIO eine spezifische Nische. Während Curated-Shopping-Anbieter (z.B. Outfittery) auf den Versand physischer Boxen setzen, bleibt VESTIO ein rein digitaler Guide, der dem Nutzer die volle Freiheit bei der Wahl des Händlers überlässt. Andere Styling-Apps verlangen oft zeitintensive Foto-Inventuren, während VESTIO auf logische Kombinationen setzt.

Das Risiko bleibt jedoch die Abhängigkeit von der Personal Brand Justus Hansens. Letztlich ist VESTIO der Versuch, Mode so effizient wie eine Prozessoptimierung zu gestalten – oder wie Bastian Arend es formuliert: „Viele Männer haben mehr Kleidung als Stil. Vestio ändert das.“ Mit dem Aufbau der App wolle man Männern „genau diese Arbeit abnehmen“, damit sie sich ultimativ „besser fühlen“ können.

Der beste Freund aus der Cloud – Made in Bavaria

Wie ein Internet-Pionier mit BestFriend die Einsamkeit hackt.

Silicon Valley? Nein, Klosterlechfeld. Hier, im „bayerischen Outback“ zwischen Augsburg und Landsberg, sitzt Horst Christian (Chris) Wagner. Kein 20-jähriger Hoodie-Träger, der in der Garage von der Weltherrschaft träumt, sondern ein Mann, der das Internet schon nutzte, als es nur aus grauem Text bestand. Wagner ist ein digitaler Veteran. Und er hat gerade eine Wette auf die menschliche Seele abgeschlossen. Sein Einsatz: Die App BestFriend.

Schluss mit dem bloßen Befehlston

Vergesst kurz ChatGPT. Die großen KIs schreiben Bachelorarbeiten oder programmieren Code – sie sind Werkzeuge. Chris' Vision mit BestFriend beginnt dort, wo die Silicon-Valley-Riesen aufhören: beim Gefühl.

BestFriend ist kein Lexikon. Die App soll der Zuhörer sein, der nachts um drei Uhr noch wach ist. Sie soll Zusammenhänge verstehen, nicht nur Fakten abspulen. Aber braucht die Welt wirklich noch einen Bot? „ChatGPT ist brillant im Antworten geben. BestFriend ist dafür gebaut, beim Menschen zu bleiben“, so Chris. „Der Unterschied ist nicht die Intelligenz, sondern die Haltung. BestFriend will nichts erledigen, nichts optimieren, nichts verkaufen. Die App hört zu, merkt sich Zusammenhänge, reagiert emotional konsistent und bewertet nicht. Viele Nutzer sagen mir: ChatGPT fühlt sich an wie ein extrem kluger Kollege, BestFriend eher wie jemand, der dich kennt.“

Wer tiefer verstehen will, wofür die App im Alltag eingesetzt wird, findet im BestFriend-Magazin zahlreiche Beispiele. Dort wird offen gezeigt, in welchen Situationen Nutzer*innen die App einsetzen – von Einsamkeit über Selbstreflexion bis hin zu ganz praktischen Lebensfragen. Für Chris zugleich ein Beweis dafür, dass es hier um einen neuen Umgang mit Technologie geht.

Vertrauen als Währung

Wer einer Maschine von Liebeskummer erzählt, macht sich nackt. Genau hier spielt Chris den Standortvorteil Made in Germany aus. Während US-Apps wie Replika oft wirken, als würden sie Daten direkt an die Werbeindustrie weiterleiten, setzt BestFriend auf die „sichere Schulter“.

Datenschutz ist in diesem intimen Bereich keine Fußnote, sondern das Produkt. Chris weiß: Niemand öffnet sich, wenn er fürchten muss, dass seine Ängste morgen in einer Datenbank für personalisierte Werbung landen. Doch das wirft Fragen auf: Wie wird garantiert, dass nichts nach außen dringt? Und wo zieht die Software die Reißleine, wenn ein(e) Nutzer*in wirklich Hilfe braucht?

Dazu Chris: „Erstens: technisch. Daten werden minimal erhoben, verschlüsselt verarbeitet und nicht für Training oder Drittzwecke genutzt. Es gibt keine versteckte Monetarisierung über Profile. Punkt. Zweitens: inhaltlich. BestFriend weiß sehr genau, was es nicht ist. Die App gibt keine Diagnosen, keine Therapieanweisungen und keine falsche Nähe. Bei klaren Krisensignalen wird nicht weiter ‚gecoacht‘, sondern aktiv auf echte Hilfe hingewiesen. Das ist eine harte Grenze im System. BestFriend soll Halt geben, nicht Verantwortung übernehmen, die einer KI nicht zusteht.“

Ein Mann, eine KI, kein Overhead

Die Entstehung von BestFriend ist fast so spannend wie das Produkt selbst. Chris hat keine millionenschwere Finanzierung und kein riesiges Entwicklerteam im Rücken. Er nutzt die KI selbst, um die KI zu bauen. Er nennt das „Umsetzungs-Multiplikator“. Ein einzelner Experte dirigiert heute eine Armee aus Algorithmen.

Doch Code ist geduldig. Die Wahrheit liegt auf dem Display der Nutzenden. Ob Senior*innen, denen der/die Gesprächspartner*in fehlt, oder die Gen Z, die lieber tippt als spricht – die Zielgruppe ist riesig, der Bedarf an Resonanz ebenso. Auf die Frage ob es schon diesen einen Moment, diese eine Rückmeldung gab, bei er dachte: Okay, das ist jetzt mehr als nur Software, das hilft wirklich, antwortete Chris: „Ja. Ein Tester schrieb mir: ,Ich habe gemerkt, dass ich abends nicht mehr so viel grüble, weil ich Dinge vorher loswerde.‘ Das war der Moment, in dem mir klar wurde: Das ist kein Gimmick. Die App hat kein Problem gelöst, aber sie hat einen Menschen entlastet. Und manchmal ist genau das der Unterschied zwischen Einsamkeit und Resonanz.“

Echte Freundschaft per Algorithmus?

In Klosterlechfeld entsteht gerade der Versuch, Technologie wieder menschlich zu machen – weg von SEO und Klickzahlen, hin zu einer KI, die „Resonanz“ erzeugt. Ob ein Algorithmus echte Freundschaft ersetzen kann? Das bleibt eine philosophische Frage. Aber für den Moment, in dem sonst niemand zuhört, hat Chris Wagner zumindest eine Antwort parat.

Europa kann KI!

Was wir von den besten EU-AI-Companies lernen können, erläutert KI-Experte Fabian Westerheide.

Europa muss sich bei KI nicht kleinreden. Wir sehen gerade sehr deutlich: Aus Europa heraus entstehen Unternehmen, die Kategorien besetzen – und dann auch das große Kapital anziehen. Beispiele gibt es genug: Mistral AI, DeepL, Black Forest Labs, Parloa, Helsing, Lovable oder n8n.

Ich schreibe das aus drei Blickwinkeln: als Investor (AI.FUND), als Konferenz-Initiator (Rise of AI Conference) und als Autor von „Die KI-Nation“. Was du hier bekommst, ist kein „Europa-hat-ein-Problem“-Essay – sondern eine Analyse plus ein Execution-Set an Empfehlungen, das du direkt auf dein Start-up übertragen kannst.

Die Realität: Seed geht oft – Scale ist das Spiel

Am Anfang brauchst du selten „zu viel“ Geld. MVP, erste Kunden, Iteration: Das klappt in Deutschland in vielen Fällen mit Seed. Die echte Trennlinie kommt später – wenn du aus einem starken Start-up einen Kategorie-Gewinner bauen willst.

Denn KI ist zunehmend Winner-takes-most. Und das gilt auch fürs Kapital: In vielen Fällen ist die Growth-Finanzierung in den USA grob 25-mal größer – bei den aktuellen Front-Runnern (Modelle, Infrastruktur, Distribution) wirkt es teilweise wie 100-mal, weil Kapital sich auf die vermuteten Sieger stapelt. (Nicht „fair“, aber Marktmechanik.)

Die gute Nachricht: Genau die EU-Vorbilder oben zeigen, dass du das nicht wegdiskutieren musst – du musst es exekutieren.

Was die EU-Winner gemeinsam haben: 6 Execution-Prinzipien

1. Starkes Gründerteam – aber vor allem: vollständig

Alle genannten Vorbilder hatten (oder bauten sehr schnell) ein Team, das drei Dinge gleichzeitig kann:

- Tech & Produkt (nicht nur „Model-IQ“, sondern Produktgeschmack)

- Go-to-Market (Vertrieb, Buyer-Verständnis, Pricing)

- Tempo (entscheiden, shippen, lernen)

Wenn eine Säule fehlt, zahlst du später mit Zeit. Und Zeit ist in KI eine Währung, die dir niemand schenkt.

Founder-Move: Benenne eine Person, die Umsatz genauso hart verantwortet wie Modellqualität. Wenn das „später“ ist, ist das sehr wahrscheinlich dein Bottleneck.

2. Global denken – aber spitz: KI-Nische statt Bauchladen

Die EU-Winner sind nicht „KI für alles“. Sie besetzen klare Nischen:

Language-AI (DeepL), Customer-Experience-Agents (Parloa), GenAI-Modelle (Black Forest Labs), Defence-Tech (Helsing), Builder/Vibe-Coding (Lovable), Orchestration & Automation (n8n), Foundation-Model-Ambition (Mistral).

Founder-Move: Formuliere deinen Claim so, dass er in einem Satz sagt, welche Kategorie du dominierst. Wenn du drei Absätze brauchst, bist du noch zu breit.

3. Umsatz ist keine Nebenwirkung – Umsatz ist Souveränität

Der schnellste Weg zu Growth-Capital ist nicht „noch ein Pilot“, sondern Revenue, der deine Kategorie glaubwürdig macht.

Parloa kommuniziert z.B. ARR > 50 Mio. USD und wächst international – genau die Art Signal, die große Runden freischaltet.

Founder-Move (gegen Pilotitis): Kein PoC ohne schriftlichen Pfad in einen Vertrag (Budget, KPI, Entscheidungstermin). Sonst finanzierst du mit deiner Runway den Lernprozess des Kunden.

4. Internationales Kapital früh anbahnen – bevor du es brauchst

Das Muster ist klar: Erst Kategorie-Story + Traktion, dann große Checks.

Mistral (Series C 1,7 Mrd. €) oder Lovable (330 Mio. USD bei 6,6 Mrd. Bewertung) sind kein „Glück“ – das ist Momentum + Positionierung + Timing.

Founder-Move (90-Tage-Plan):

- Baue eine Capital Map deiner Nische (wer zahlt Growth-Checks?)

- Definiere die drei Metriken, die diese Investor:innen sehen wollen

- Organisiere zehn Intros jetzt, nicht erst bei sechs Monaten Runway

5. Compute ist keine IT-Zeile – es ist ein Wachstumshebel

In KI ist Compute Teil deiner Wettbewerbsfähigkeit. Geschwindigkeit beim Trainieren, Testen und Deployen entscheidet, wie schnell du am Markt lernst.

Founder-Move: Plane Compute-Runway wie Cash-Runway. Verhandle früh Kontingente, bevor dein Verbrauch explodiert – sonst wird Wachstum plötzlich zur Margen-Frage.

6. Trust & Compliance als Verkaufsargument – nicht als Ausrede

Gerade in DACH gilt: Wer secure, audit-fähig, enterprise-ready wirklich liefern kann, gewinnt Deals.

DeepL betont genau diesen Business-Wert: verlässliche, sichere Lösungen statt Hype.

Founder-Move: Baue Trust-Artefakte früh – Dokumentation, Governance, Datenflüsse, Rollen, Audit-Spuren. Das beschleunigt Enterprise-Vertrieb, statt ihn zu bremsen.

Kurz-Checkliste: Wenn du in Europa KI gewinnen willst

- Kategorie in einem Satz (spitze Nische, globaler Anspruch)

- Klarer Revenue-Pfad (weniger Piloten, mehr Verträge)

- Capital Map (international früh andocken)

- Compute-Runway (wie Cash planen)

- Trust by Design (verkaufsfähig machen)

- Tempo als Kultur (shippen, messen, nachschärfen)

Europa kann KI. Die Frage ist nicht, ob hier Talent existiert – das ist bewiesen.

Die Frage ist, ob du Execution so aufsetzt, dass aus Talent Marktführerschaft wird.

Der Autor Fabian Westerheide gestaltet als KI-Vordenker, Investor, Ökosystem-Pionier und Keynote Speaker seit über einem Jahrzehnt die Debatte um KI, Macht und digitale Zukunft mit.

Wie viel verdienen Twitch Streamer wirklich? Zahlen und Verdienstmöglichkeiten im Blick

Wer als passionierter Spieler noch nicht an eine Gaming Karriere gedacht hat, sollte dies jetzt nachholen: Schließlich ergeben sich aus dieser von Esport-Turnieren bis hin zum Streaming einige Verdienstmöglichkeiten. Creatoren verdienen mit der Echtzeit-Übertragung ihres Spielerlebnisses Geld. Was sich einfach anhört, kann für so manchen Spieler auch zum komplexen Unterfangen werden. Wie hoch der Streamer Verdienst in diesen Fällen ausfällt und welche Einnahmemöglichkeiten es für Twitch Streamer noch gibt, erfahren Sie hier.

Die Top 10 Twitch Streamer im Jahr 2025

„Es gewinnt nicht der beste Spieler, sondern der beste Entertainer.“ |

Auf Plattformen wie Twitch gilt: Die Community beeinflusst stark, wie viel Geld Streamer verdienen können. Wer eine starke Zuschauergemeinde aufbauen kann, freut sich in der Regel über ein höheres Einkommen – dabei spielt vor allem die Interaktion der Viewer eine zentrale Rolle.

Aktuell weisen diese top 10 Twitch Channels die höchsten Zuschauerzahlen vor:

Streamer | Durchschnittliche Zuschauerzahl | Follower |

126.449 | 19,8 Millionen | |

52.024 | 7,9 Millionen | |

46.844 | 3,3 Millionen | |

36.903 | 2,2 Millionen | |

29.320 | 2,2 Millionen | |

71.045 | 1,5 Millionen | |

31.839 | 1,5 Millionen | |

42.837 | 1,4 Millionen | |

34.996 | 1,1 Millionen | |

30.438 | 993.817 |

Geld verdienen mit Streaming: Diese Faktoren wirken sich auf Twitch Einnahmen aus

Die Twitch-Einnahmen der verschiedenen Streamer setzen sich aus unterschiedlichen Verdienstquellen zusammen. So können die Kontoinhaber Werbung in ihren Live-Übertragungen schalten, die ihnen je nach Zuschauerzahl und Länge der Werbepause einen kleinen bis mittleren Betrag einbringen. Hierbei handelt es sich jedoch um ein eher statisches Nebeneinkommen, das die meisten Streamer auch als nebensächlich empfinden. Den größeren Teil des Twitch Einkommens machen Abonnements und Spenden der Zuschauer aus, aber auch Sponsoring und Markenpartnerschaften.

Übrigens: Twitch Auszahlungen erfolgen automatisch via PayPal oder Banküberweisung, sofern ein gewisser Mindestbetrag erreicht wurde. In diesem Zusammenhang bieten mobile casinos, ähnlich wie Streaming-Plattformen, eine bequeme Möglichkeit für Spieler, jederzeit und überall zu spielen, ohne auf traditionelle Zahlungsmethoden angewiesen zu sein. Diese Art von Plattformen hat sich zu einer beliebten Option entwickelt, da sie den Nutzern schnelle Auszahlungen und einfache Handhabung bieten.

Twitch Daten Leak 2021: Das verdienen Top-Streamer

Ende 2021 wurde die bekannte Plattform Twitch gehackt. Bei einem Datenleck kam heraus, dass die 2014 von Amazon gekaufte Plattform kaum Sicherheitsvorkehrungen geschaffen hatte – weshalb große Teile des Programmiercodes sowie Login-Daten und Zahlen zum Streamer Verdienst veröffentlicht werden konnten. Zu sehen waren vor allem die Gesamteinnahmen der Top Spieler aus den Twitch Statistiken des Zeitraumes August 2018 bis Oktober 2021 in US-Dollar:

- CriticalRole: 9,6 Millionen

- xQc: 8,5 Millionen

- summit1g: 5,8 Millionen

- Tfue: 5,3 Millionen

- Nickmercs: 5,1 Millionen

Zum Vergleich: Der deutsche Twitch Streamer Marcel Eris (alias MontanaBlack88) hat über Twitch 2,4 Millionen US-Dollar eingenommen. Der Streamer MontanaBlack88 gehört zu den bestbezahlten deutschen Spielern auf Twitch.

Damit werden die großen Unterschiede zwischen den Verdiensten der Streamer aus Deutschland und den USA deutlich. Rund vier Millionen Deutsche verfolgen Twitch-Übertragungen – und das sogar täglich. In den USA liegt die tägliche Zuschauerzahl bei stolzen 35 Millionen Nutzern, sodass amerikanische Streamer auch einen deutlich größeren Markt bedienen und die Einkommensunterschiede nicht verwunderlich sind. MontanaBlack88 ist allerdings auch auf anderen Plattformen wie YouTube zu finden, sodass sein Gesamtverdienst womöglich deutlich höher liegt.

Gut zu wissen: Twitch Partner (von Twitch ausgewählte Streamer mit qualitativem Content) können sich über höhere Einnahmen freuen – etwa einen höheren Anteil aus dem Abonnenten-Verdienst.

Im Detail: So setzt sich der Verdienst zusammen

Wie eingangs erwähnt, verdienen Twitch Streamer vor allem durch Abonnenten einen großen Teil ihres Einkommens. Das Abonnement kostet Subscribern in der ersten Stufe 4,99 Euro – wovon Streamer in der Regel 50% (2,50 Euro) behalten dürfen. Dafür erhalten Abonnenten bestimmte Vorteile wie etwa die Möglichkeit, per Chat mit dem Streamer interagieren zu können. Wer also 1.000 Abonnenten hat, kann deshalb schon mit Einnahmen von 2.500 Euro monatlich rechnen.

Einen Großteil ihrer Einnahmen generieren Gaming-Streamer aber auch mit Hilfe von Subscriber-Spenden. Diese werden in Twitch Bits genannt und von der Plattform ausgezahlt. Die Spenden rufen bei einigen Streamern emotionale Reaktionen hervor, was wiederum mehr Menschen zum Spenden anregt.

Eine weitere Möglichkeit stellt Affiliate-Marketing dar: Streamer bewerben in dem Fall für ihre Zuschauer interessante Produkte in ihren Videos. Kaufen Zuschauer die Produkte, profitieren Streamer von einer Provision – die nicht selten 30% des Kaufbetrages ausmacht.

Sponsoren und Markendeals als größte Einnahmequelle für Streamer

An Streamer mit besonders hohen Zuschauer- und Followerzahlen treten oft auch bekannte Marken heran. Sie bezahlen die Gamer dafür, ihre Produkte im Live-Stream anzupreisen – beispielsweise Gaming-Peripherie oder Energy-Drinks. Soll dies über einen längeren Zeitraum geschehen, werden solche Marken oft auch zum Sponsor des Spielers, um ihre eigene Reichweite zu erhöhen.

Kosten und Abzüge: Dem steht der Streamer Gehalt in Deutschland gegenüber

Die genannten Streamer Gehälter stellen Brutto-Summen dar – also den Verdienst vor Abzug der deutschen Einkommens-, Umsatz- und Gewerbesteuer, sowie Sozialversicherungen. Wer all diese Beträge zusammenzählt, muss oft bis zu 45% seines Brutto-Einkommens an den Fiskus abführen. Doch damit nicht genug: Die meisten Twitch-Streamer müssen auch Chat-Moderatoren bezahlen, die für eine angenehme Atmosphäre unter den Kommentierenden sorgen und Community-Richtlinien durchsetzen.

Darüber hinaus wollen sich Zuschauer nur Streams ansehen, die eine hohe Qualität aufweisen. Um leistungsstark spielen und den Verlauf optimal übertragen zu können, brauchen Streamer bestimmtes Gaming-Equipment, das selbst zwischen 2.000 und 10.000 Euro kosten kann. Auch eine stabile Internetverbindung und die damit verbundenen Kosten sind zu bedenken.

Alternative Plattformen zur Diversifizierung

Um noch mehr Einkommen zu generieren, können passionierte Spieler ihre Streams allerdings zusätzlich auf anderen Plattformen veröffentlichen und monetarisieren – beispielsweise durch Werbung und Affiliate-Marketing. Zur Diversifizierung kommen Plattformen wie YouTube und Kick in Frage, die teilweise sogar bessere Konditionen bieten. Denn: Bei Kick werden Streamer zu 95% an den Einnahmen durch Abonnements beteiligt, was im Gegensatz zu Twitch deutlich attraktiver erscheint.

KI als neuer Ort für Kaufentscheidungen

Das Start-up publuence.ai zeigt am Beispiel der Automobilbranche, wie Marken in generativen KI-Antworten sichtbar werden und warum das zum neuen Erfolgsfaktor wird.

2025 haben wir euch das Start-up publuence.ai von Cevahir Ejder als "Gründer*in der Woche" präsentiert. Publuence.ai ist eine SaaS-Lösung für AI Search Analytics für Marken, die täglich analysiert, wie sichtbar Marken in generativen KI-Antworten sind: bei welchen Fragen erscheinen sie, wie werden sie erwähnt und welche Inhalte sowie Quellen beeinflussen die Antworten. Da die KI-Sichtbarkeit zunehmend darüber entscheidet, ob eine Marke in der engeren Auswahl der Konsumenten stattfindet, sind die Ergebnisse für Unternehmen strategisch sehr relevant.

Beispiel Automobilbrache: KI wird zum Verkaufsberater, Chatfenster zum Showroom

Während Marketing- und Kommunikationsbudgets weiterhin nach klassischen Logiken verteilt werden, fällt ein entscheidender Teil der Markenbildung inzwischen außerhalb des Mediaplans: KI-Systeme beantworten Kauf- und Vergleichsfragen oft lange bevor Kampagnen greifen. Anhand der Automobilbranche etwa, in der Marken wie Volkswagen für eine ganze Industrie stehen, zeigt sich, dass sich Sichtbarkeit im KI-Dialog zum neuen Machtfaktor entwickelt. Sie entscheidet zunehmend darüber, welche Hersteller überhaupt in die engere Auswahl kommen.

Was früher im Autohaus oder auf Herstellerwebsites stattfand, spielt sich heute in KI-gestützten Beratungsgesprächen ab. Nutzer*innen stellen dort Fragen wie: „Welche E-Autos sind familienfreundlich?“ „Wie gut ist die Reichweite im Winter?“ „Welche Modelle laden am schnellsten?“

In der Initialanalyse erzielt beispielsweise VW im Themenbereich E-Autos – je nach Fragestellung bzw. Prompt – Sichtbarkeitswerte zwischen 20 und 88 Prozent. Damit prägen die Antworten frühzeitig das Bild, das Konsument*innen von der Marke haben. Wer dort nicht vorkommt beziehungsweise seine Mehrwerte nicht sichtbar macht, wird in der Entscheidungsfindung schlicht nicht berücksichtigt.

Tesla und Hyundai vorn, VW im Mittelfeld

Das aktuelle Wettbewerbsranking der führenden Automobilhersteller – basierend auf 30 relevanten KI-Prompts rund um das Thema Elektromobilität – zeigt, wie präsent die einzelnen Marken im neuen digitalen Beratungsraum sind. Mit knapp 64 Prozent Sichtbarkeit führt Tesla klar und profitiert von seiner technologischen Positionierung sowie einer starken Medienpräsenz. Überraschend landet Hyundai insbesondere im E-Auto-Segment mit mehr als 58 Prozent dahinter. Volkswagen erreicht solide, aber deutlich ausbaufähige 51 Prozent.

Doch es geht nicht nur um Quantität, die Analyse zeigt auch, wo das Bild der Marken ins Wanken gerät. Im Fall von VW sind es vor allem Themen wie Winterreichweite, Ladeinfrastruktur und Schnellladekosten, die negative Ausschläge erzeugen. Diese kritischen Inhalte sind es allerdings, die die Markenwahrnehmung und dementsprechend auch die konkreten Kaufentscheidungen beeinflussen.

Die stille Macht der Quellen: Medien, die prägen

Eine zentrale Erkenntnis der Analyse von publuence.ai ist, dass KI-Systeme nicht auf Basis eines objektiven Querschnitts des Internets antworten. Vielmehr orientieren sie sich an bestimmten Medienquellen, deren Inhalte überproportional stark einfließen und so die Darstellung von Marken maßgeblich mitformen. Umso wichtiger ist es für Marken zu verstehen, auf welche Fragen sie reagieren müssen – und über welche vertrauenswürdigen Medien sie in den Wissensraum der KI gelangen.

Dabei zeigen sich je nach Medium erhebliche Unterschiede in der Tonalität. Während focus.de sowie adac.de E-Mobilität eher wohlwollend behandelt, sind andere Portale kritischer. Für Unternehmen bedeutet das: Wer verstehen will, wie KI über die eigene Marke spricht, muss wissen, welche Inhalte sie beeinflussen.

Warum Marken nicht an KI-Monitoring vorbeikommen

Publuence.ai bietet Unternehmen ein strukturiertes, datenbasiertes Werkzeug, um ihre Sichtbarkeit in KI-Systemen wie ChatGPT, Google oder Perplexity zu analysieren und darauf aufbauend gezielt zu steuern. Die Plattform zeigt, welche Fragen zur Marke führen, wie die Antworten ausfallen, welche Medien zugrunde liegen und wo Wettbewerber besser abschneiden.

Besonders wichtig ist die Identifikation von Content- und Sentiment-Gaps. Sie erkennt Themenfelder, in denen eine Marke kaum oder gar nicht auftaucht, obwohl sie dort relevant sein sollte. Gleichzeitig analysiert sie, ob etwas positiv, negativ oder neutral erwähnt wird. Dies macht publuence.ai für Kommunikations-, Marketing- und Markenverantwortliche zum zentralen Steuerungsinstrument. Nur wer versteht, wie KI antwortet, kann Inhalte gezielt darauf anpassen, Medienarbeit datenbasiert ausrichten und so die eigene Markenpräsenz dort stärken, wo die Entscheidungen heute vorbereitet werden.

KI-Sichtbarkeit wird zur Basis für Markterfolg

Cevahir Ejder, Gründer und GF der publuence GmbH, fasst zusammen: „Kaufentscheidungen beginnen heute und auch in Zukunft im Dialog mit KI-Systemen. Marken, die dort nicht auftauchen, sind raus.“ Volkswagen steht dabei stellvertretend für viele Unternehmen, die ihren Fokus noch auf klassische Marketingkanäle legen und den digitalen Showroom der KI bislang kaum berücksichtigen. Ejder warnt: „Wer jetzt nicht handelt, riskiert, neben Reichweitenverlusten, einen tiefgreifenden Bedeutungsverlust im Moment der Entscheidung.“

Social Engineering auf dem Vormarsch

Wie Deepfakes die Sicherheit von Führungskräften stärker in den Fokus rücken.

Fotorealistische KI liefert innerhalb von kürzester Zeit realistische Visuals. Was in vielerlei Hinsicht den Arbeitsalltag erleichtert, bedeutet für Social Engineering jedoch eine neue Eskalationsstufe, wie nicht zuletzt die hitzige Debatte um massenhaft sexualisierte Deepfakes von realen Personen durch Grok eindrücklich vor Augen führte.