Aktuelle Events

Stadtplan zum Zerknüllen

Auch wenn es immer mehr Smartphones und Handys mit integriertem Navigationssystem gibt, stirbt der traditionelle Stadtplan nicht so schnell aus. Denn mit einem normalen Stadtplan hat man die bessere Übersicht. Allerdings haben Papierstadtpläne auch ihre Nachteile. Wenn man sie auseinandergefaltet hat, schafft man es selten, sie auch wieder "unfallfrei" zusammenzufalten. Und wenn es regnet, hat man schnell nur noch einen Papierklumpen in der Hand.

Für dieses Problem hat der Designer Emanuele Pizzolorusso mit seinem Textilstadtplan eine Lösung gefunden. Leider knittert auch dieser Plan, aber dafür kann er gebügelt und somit wieder in Form gebracht werden. Auch einen Regenschauer überlebt dieser Plan ohne Probleme. Zudem ist er mit 21 Gramm federleicht. Bisher ist er für folgende zwölf Städte erhältlich: Amsterdam, Barcelona, Berlin, Hamburg, Lissabon, London, Mailand, New York, Paris, Rom, Sydney und Tokio. Jeder Textil-Stadtplan kostet 12 Euro.

Zwischen Hausaufgaben und Datenschutz: Der mutige B2C-Vorstoß von innoGPT

Die Inno KI GmbH aus Vechta öffnet ihre bisher auf Geschäftskunden ausgerichtete KI-Plattform nun für Familien. Mit einem neuen "Family Package" wollen die Gründer Mike Koene und Maurice Brumund das Problem des Datenschutzes bei der KI-Nutzung von Jugendlichen lösen. Ein cleverer Schachzug in eine unbesetzte Nische – oder ein schwieriges B2C-Geschäftsmodell mit hoher Preishürde?

Die Zahlen der jüngsten JIM-Studie (Jugend, Information, Medien) sprechen eine deutliche Sprache: 70 Prozent der Jugendlichen nutzen Künstliche Intelligenz zur Informationssuche, 74 Prozent lassen sich bei den Hausaufgaben helfen. Die Kehrseite dieser rasanten Adaption: Die Nutzung erfolgt zumeist über die kostenlosen Web-Versionen von US-Giganten wie OpenAI oder Google. Sensible Daten – von persönlichen Fragen bis zu hochgeladenen Schuldokumenten – fließen oft ungefiltert in die globalen Trainingsdatenbanken der Anbieter, sofern nicht manuell widersprochen wird.

Während die Politik über Social-Media-Verbote für Minderjährige debattiert, bleibt der regulatorische blinde Fleck bei KI-Tools im Kinderzimmer bislang bestehen. Genau in diese Lücke stößt nun das niedersächsische Start-up Inno KI GmbH mit seiner Plattform innoGPT.

Von der Agentur zum KI-Aggregator

Hinter innoGPT steht kein klassisches, VC-finanziertes Silicon-Valley-Konstrukt, sondern mittelständischer Pragmatismus aus Vechta. Co-Founder Maurice Brumund und sein Team begannen bereits 2022 im Umfeld einer eigenen Digitalmarketing-Agentur, intensiv mit KI-Tools zu experimentieren.

Aus dem internen Pain Point – der Frage, wie Mitarbeitende rechtssicher und datenschutzkonform mit großen Sprachmodellen (LLMs) arbeiten können – entstand Ende 2024 die Plattform innoGPT. Bisher lag der Fokus des Startups strikt auf dem B2B-Segment: Mit rein europäischem Hosting, DSGVO-Konformität und einer Zero-Retention-Policy (keine Nutzung der API-Daten für das Modell-Training) positionierte sich innoGPT als Lösung gegen die „Schatten-IT“ in Unternehmen. Laut Unternehmensangaben nutzen bereits über 2.500 Privat- und Geschäftskund*innen den Service. Nun folgt die Ausweitung des Geschäftsmodells auf den B2C-Markt.

Das Produkt: Ein "Safe Space" für die Familie

Mit dem neuen „Family Package“ erhalten bis zu fünf Familienmitglieder für 34,90 Euro im Monat individuelle Logins zu einer zentralen Plattform. Über diese können sie gebündelt auf verschiedene führende KI-Modelle von OpenAI, Anthropic, Google, Meta, Mistral und Black Forest Labs zugreifen. Ein zusätzlich buchbares Add-on filtert persönliche Daten (Named Entity Recognition) wie Namen oder E-Mail-Adressen und ersetzt diese vor der Übermittlung an die Rechenzentren automatisch durch Platzhalter.

Das Geschäftsmodell und der Markt

Aus Start-up-Sicht ist der Vorstoß von B2B-SaaS in ein Family-Abo-Modell gleichermaßen spannend wie riskant. Eine kritische Analyse offenbart dabei mehrere Marktherausforderungen:

- Der technologische Burggraben (Moat): Das Geschäftsmodell von innoGPT ist im Kern ein Aggregator- oder Wrapper-Modell. Das Start-up entwickelt keine eigenen Foundation-Modelle, sondern baut eine sichere, europäische Middleware-Schicht über die Schnittstellen (APIs) der Tech-Giganten. Der technologische Burggraben ist folglich eher niedrig. Der primäre Unternehmenswert liegt in der User Experience, der reibungslosen Modellanbindung und dem abstrakten Vertrauensfaktor „Datenschutz“.

- Zahlungsbereitschaft: 34,90 Euro im Monat (knapp 420 Euro im Jahr) sind für ein klassisches Familienbudget eine erhebliche Summe. Der Preis entspricht fast den Kosten von anderthalb ChatGPT-Plus-Lizenzen. Die zentrale Herausforderung für das Marketing wird sein: Sind Eltern bereit, für den Schutz der Daten ihrer Kinder diesen Premium-Aufschlag zu zahlen, während der Nachwuchs die Basis-Tools de facto kostenlos und mit einem Klick auf dem Smartphone nutzen kann?

- Token-Ökonomie in der Praxis: Das Modell sieht einen geteilten Token-Pool für die fünf Accounts vor. In der Praxis könnte dies zu Reibereien führen, wenn beispielsweise ein Familienmitglied rechenintensive Bildgenerierungen (etwa über Black Forest Labs) durchführt und das Kontingent für die Text-Prompts der restlichen Familie vorzeitig aufbraucht.

- Wettbewerbslandschaft: InnoGPT bewegt sich in einem Sandwich-Markt. Von oben drohen die direkten B2C-Angebote der Tech-Riesen (es ist absehbar, dass OpenAI oder Google eigene „Family Plans“ ausrollen). Von der Seite drücken EdTech-Start-ups in den Markt, die KI DSGVO-konform direkt in die Lernplattformen der Schulen integrieren – was eine private Familienlizenz obsolet machen könnte.

Ein mutiger Testballon

Für das Start-up-Ökosystem ist die Inno KI GmbH dennoch ein Paradebeispiel für „bootstrapped“ Innovationskraft. Anstatt ein Produkt am Reißbrett zu entwerfen, hat das Team ein valides Angebot aus einem eigenen betrieblichen Schmerz heraus entwickelt.

Der Vorstoß in den B2C-Markt wirkt wie ein smarter, PR-wirksamer Testballon. Das Start-up greift eine hochaktuelle, emotionale gesellschaftliche Debatte auf (Jugendschutz bei KI) und besetzt rhetorisch geschickt die Rolle des Problemlösers. Ob sich das Family-Modell finanziell trägt, hängt letztlich davon ab, ob innoGPT den trockenen Begriff der „DSGVO-Konformität“ für Eltern emotional so aufladen kann, dass er als unverzichtbare Sicherheitsmaßnahme wahrgenommen wird. Gelingt dies nicht, ist das Risiko überschaubar: Das Start-up kann sich nahtlos wieder auf sein wachsendes B2B-Kerngeschäft konzentrieren.

Aiconiq.io: Das KI-Gehirn für den Mittelstand – Brillante Vision oder teure Manufaktur?

Autonome Agenten, halbierte Prozesskosten und sicheres Daten-Hosting: Mit Aiconiq.io tritt ein Start-up an, um das KI-Gehirn für den Mittelstand zu bauen. Wir wollten wissen, wie das „Corporate Brain“ funktioniert und wo die Herausforderungen bei der Skalierung liegen.

Hinter der Aiconiq GmbH stehen zwei ausgewiesene Branchenexperten. Gegründet wurde das Start-up 2025 von Prof. Dr. Peter Gentsch, einem bekannten KI-Pionier und Seriengründer, sowie dem KI-DeepTech-Experten Dr. Michael Patrushev. Gemeinsam bringen sie jahrzehntelange Erfahrung aus der KI-Forschung, im internationalen Engineering und beim Skalieren technologiegetriebener Unternehmen in ihr neues Projekt ein.

Mehr als nur ein Chatbot

Dass hier DeepTech-Experten am Werk sind, zeigt sich am technologischen Anspruch: Während viele Firmen mit generischen Chatbots experimentieren, integriert Aiconiqs Corporate Brain laut Unternehmensangaben nicht nur explizites, sondern gezielt das implizite Wissen (Tacit Knowledge) der Belegschaft. Erfasst wird dies durch KI-gesteuerte Interviews. Um Halluzinationen und subjektiven Fehleinschätzungen vorzubeugen, setzt Co-Gründer Michael Patrushev auf harte Validierung: „Die KI stellt keine offenen, spekulativen Fragen, sondern kontextualisierte, prozessbezogene Fragen entlang realer Use Cases.“

Nach einem Abgleich mit ERP-Logs und Experten-Kreuzvergleichen speichere das System keine absoluten Wahrheiten, so Patrushev, sondern „gewichtete Wissenselemente mit Vertrauens-Score und Quellenreferenz“. Gerade dieses subjektive Erfahrungswissen sei im Unternehmensalltag entscheidend, müsse aber umsichtig geprüft werden.

David gegen die Tech-Goliaths

Im hart umkämpften Markt stellt sich die Frage, wie lange das Start-up gegen die Milliarden-Budgets von Microsoft oder OpenAI bestehen kann. Prof. Peter Gentsch gibt sich pragmatisch: „Wir kämpfen nicht gegen die Hyperscaler wie OpenAI, Google oder Anthropic – wir nutzen sie.“ Das eigene System setze horizontal auf den bekannten Modellen auf. Der Burggraben entstehe durch branchenspezifische Use Cases in einer sicheren, DSGVO-konformen Umgebung, wahlweise on-premises oder in einer europäischen Cloud.

Gentsch pointiert: „Wir wollen nicht das größte Gehirn bauen; wir bauen das relevanteste Brain für ein Unternehmen. Die Tech-Giganten optimieren Skalierung – wir optimieren den Unternehmens-Kontext.“

Skalierung: Softwareprodukt oder Manufaktur?

Die schnelle Entwicklung der eigenen Modelle sichert Aiconiq durch die interne „Aiconiq Factory“ ab, die auf radikale Automatisierung setzt. Kontrollverlust fürchtet Patrushev dabei nicht: „Geschwindigkeit ersetzt bei uns nicht Qualität – sie wird durch Qualitätssicherungssysteme ermöglicht.“ Jeder KI-generierte Code durchlaufe strenge Security-Checks und Test-Pipelines.

Doch lässt sich das aufwendige Einfangen von Unternehmenswissen beim Kunden ebenso reibungslos skalieren, oder droht Aiconiq in einem beratungsintensiven Manufaktur-Modell steckenzubleiben? Gentsch wehrt ab: Man nutze KI, um KI im Unternehmen aufzubauen. Algorithmen deckten Inkonsistenzen im Wissen automatisch auf und lösten sie teils selbständig. Ganz ohne menschliches Zutun gehe es aber nicht, räumt der Gründer ein: „Damit bleibt immer ein wenig Manufaktur bzw. ‚Human in the loop‘.“

Ausblick

Mit einer aktuellen Bewertung von 10 Millionen Euro und der Aufnahme ins „German Accelerator USA-Programm“ hat Aiconiq.io nach eigenen Angaben bereits namhafte DAX-Konzerne überzeugt. Gelingt es den Frankfurtern nun, die komplexe Wissensextraktion weiter zu standardisieren, könnte sich ihr „Corporate Brain“ als eine treibende Kraft der „industriellen KI-Revolution“ aus Deutschland etablieren.

Glitter Spritz: Popstar trifft Bootstrapping

Warum Bill Kaulitz nicht als Werbegesicht, sondern als Mitgründer beim Aperitif-Start-up Glitter Spritz der Gründer Lupo Porschen und Basti Fischer einsteigt – und was die Gründer*innenszene daraus lernen kann.

Wenn ein internationaler Popstar bei einem deutschen Getränke-Start-up einsteigt, klingeln in der Branche normalerweise die Alarmglocken: Ist das die nächste kurzlebige Influencer-Kampagne? Bei der Berliner Marke Glitter Spritz der Craft Circus GmbH wählt man einen anderen Weg. Tokio-Hotel-Frontmann Bill Kaulitz wird nicht nur Werbegesicht, sondern steigt aktiv als Mitgründer und Gesellschafter in die eigens dafür ausgegründete Glitter Spritz GmbH ein. Ab dem 9. März 2026 startet die begleitende nationale Handelskampagne. Ein Deal, der strategisch wertvoll ist – und auf einem Fundament ruht, das in der Start-up-Welt selten geworden ist.

Vom WG-Zimmer zur Brand-Maschine

Die Historie von Glitter Spritz ist keine klassische VC-finanzierte Start-up-Story. Die Marke entspringt der Craft Circus GmbH, die 2014 von den Studienfreunden Lupo Porschen und Basti Fischer gegründet wurde. Die beiden starteten ihr Unternehmen noch während des Studiums aus einer studentischen Wohngemeinschaft in der Hamburger Sternschanze heraus.

Die Manufaktur hat sich über zehn Jahre hinweg komplett ohne externes Investorenkapital (Bootstrapping) aufgebaut. Eine frühe strategische Entscheidung der Gründer war es, die eigentliche Destillation nicht selbst durchzuführen, sondern an eine Familienbrennerei in Rheinland-Pfalz auszulagern. So konnte sich das Team von Beginn an voll auf seine Kernkompetenzen konzentrieren: Produktentwicklung, Design, Marketing und den eigenständigen Vertrieb.

Erprobte Konzepte: "BIRDS" und "Flaschenpost" ebneten Weg

Für Bill Kaulitz ist das Investment kein Blindflug, denn Glitter Spritz ist keine unerprobte Neuentwicklung. Das Craft-Circus-Team hat in den vergangenen zehn Jahren mehrfach bewiesen, wie man Marken im Regal platziert und im Handel positioniert.

Den Anfang machte 2015 der BIRDS Dry Gin. Inspiriert von einer gemeinsamen Weltreise der Gründer, vereint der Gin 15 Botanicals aus fünf Kontinenten und bediente früh den Wunsch nach "Purpose": Mit jeder verkauften Flasche wird ein nachhaltiges oder soziales Projekt unterstützt.

2017 folgte der massentauglichere Flaschenpost Gin, der gezielt mit dem klassischen Image von Spirituosen brach. Abgefüllt in Apothekerflaschen, setzen die Gründer hier auf humorvolle Sprüche auf den Etiketten und fokussierten sich auf den lukrativen Geschenkemarkt. Bei diesem Produkt experimentierte Craft Circus auch erstmals mit visuellen USPs, die später bei Glitter Spritz weiterentwickelt wurden: Sondereditionen, die durch die Zugabe von Tonic Water ihre Farbe ändern oder bereits einen Glitzereffekt integriert haben.

Der Markt: Alkoholfrei boomt, klassischer Alkohol schwächelt

Mit Glitter Spritz agiert das Start-up in einem dynamischen Marktumfeld. Während der klassische Alkoholmarkt in Deutschland insgesamt rückläufig ist, wächst das Segment für Alternativen spürbar. Um unterschiedliche Zielgruppen zu bedienen, liefert die Marke zwei Varianten: eine Version mit 15 Prozent Alkohol und eine alkoholfreie Alternative.

Letztere trifft den aktuellen Zeitgeist: Laut Unternehmensangaben auf Basis von NielsenIQ-Daten belegte Glitter Spritz im Jahr 2025 Platz 2 der absatzstärksten alkoholfreien Aperitif-Marken im deutschen Lebensmitteleinzelhandel. Das Unternehmen erzielte in diesem Zeitraum einen mittleren sechsstelligen Absatz und verzeichnete ein zweistelliges Wachstum. Geschmacklich setzt das in Deutschland produzierte Getränk auf Bitterorange, Rhabarber und mediterrane Kräuter und positioniert sich fruchtiger und weniger bitter als herkömmliche Aperitifs.

Smartes Creator-Play oder kurzlebiger Hype?

Für Gründerinnen und Gründer bietet der Case "Glitter Spritz x Kaulitz" lehrreiche Ansatzpunkte, birgt aber auch branchenübliche Risiken. Der USP des Getränks ist primär visueller Natur: Ein essbarer Glitzer, basierend auf dem in der EU zugelassenen Lebensmittelfarbstoff Eisenoxid, sorgt im Glas für einen optischen Effekt. Solche "instagrammablen" Produkte generieren schnelle virale Aufmerksamkeit, bergen jedoch die Gefahr der Kurzlebigkeit. Wenn der Neuheitseffekt verfliegt, muss das Produkt zwingend über Geschmack und Markenidentifikation überzeugen, um dauerhafte Wiederkaufraten zu sichern.

Hier greift jedoch der strategische Schachzug: Dass Kaulitz nicht als reines Testimonial, sondern als echter Gesellschafter und Mitgründer einsteigt, ist ein starkes "Creator-Play". Während viele Creator-Brands an der operativen Umsetzung scheitern, trifft hier eine immense Reichweite auf ein krisenerprobtes Gründerteam, das Logistik, Produktion und den Vertrieb in über 5.000 Märkte und mehr als 15 Länder bereits etabliert hat. Die tiefe gesellschaftsrechtliche Bindung in einer gemeinsam gegründeten GmbH minimiert zudem das Risiko, dass der Prominente schnell das Interesse verliert.

Dennoch gleicht das Unterfangen im Einzelhandel einem Kampf David gegen Goliath. Der Aperitif-Markt wird von Konzernen mit massiven Marketingbudgets dominiert, und die Regalmeter im Supermarkt sind teuer und umkämpft. Auch wenn Glitter Spritz laut Daten zu den wachstumsstärksten Marken der Kategorie gehört, erfordert die geplante strategische Expansion im In- und Ausland enorme Ressourcen.

Letztlich zeigt der Fall eindrucksvoll, wie man ein bootstrapped Start-up durch gezieltes Design und iterativen Markenaufbau so weit skaliert, dass es für internationale Prominenz als Investment attraktiv wird. Wenn es dem Team um Fischer, Porschen und nun auch Kaulitz gelingt, den optischen Effekt zu einem festen Lifestyle-Attribut zu etablieren, hat das Unternehmen reales Potenzial, den Branchenriesen langfristig Marktanteile abzunehmen.

Die Müsli-Macher und die Kälte: Das neue Millionen-Projekt von Kraiss & Mahler

Dass sie Märkte revolutionieren können, haben die Freda-Gründer bereits bewiesen – nun steht die Tiefkühlkette auf dem Prüfstand. Mit einem mutigen Modul-Konzept fordern Philipp Kraiss und Christian Mahler die Industrie-Riesen im Supermarktregal heraus.

In der Start-up-Welt ist der Begriff Seriengründer*in oft ein zweischneidiges Schwert: Das Vertrauen der Investor*innen ist hoch, doch die Fallhöhe nach einem Erfolg wie mymuesli ebenso. Philipp Kraiss und Christian Mahler haben sich mit ihrem 2023 gegründeten Food-Start-up Freda bewusst gegen ein „Me-too-Produkt“ und für eine operative Wette auf die Zukunft der Tiefkühlkette entschieden. Mit einem mutigen Modul-Konzept fordern sie die etablierten Industrie-Riesen im Supermarktregal heraus. Die Prämisse: Der Markt für Tiefkühlkost (TK) wächst – auf über 22,6 Milliarden Euro im Jahr 2024 –, ist aber durch extremen Preisdruck und eine veraltete Produktlogik geprägt. Wir haben uns das Geschäftsmodell näher angesehen und die Gründer dazu befragt.

Pizza, Pasta, Gelato … und jetzt Blocks?

Die Pizza „Salami Sensation“ war für Freda der Türöffner. Mit dem Sieg bei Stiftung Warentest (2024) bewies das Team, dass es Qualität „kann“ und schuf einen starken USP. Strategisch ist Pizza jedoch kein leichtes Feld: Der Wettbewerb ist anspruchsvoll, die Regalplätze im Einzelhandel sind besetzt und die Differenzierung erfolgt meist über den Preis. Mit einer Innovation wie „Frozen Blocks“ erweitert Freda nun das Spielfeld und eröffnet eine neue Kategorie von Tiefkühlkost.

Es handelt sich dabei nicht mehr um ein fertiges Gericht, sondern um eine Systemkomponente. Das Konzept orientiert sich am gastronomischen „Mise en Place“: Vorbereitete, schockgefrostete Komponenten wie Beef Ragù oder Chili sin Carne fungieren als Basismodule für die heimische Küche. Strategisch gesehen erhöht dies die Wertdichte pro Kubikzentimeter im TK-Fach und verringert die Komplexität in der eigenen Produktion im Vergleich zu mehrkomponentigen Fertigmenüs.

Auf die Frage, ob der strategische Wechsel von der Pizza zu den „Frozen Blocks“ eine Flucht aus dem Commodity-Preiskampf der Pizza-Truhe hin zu einer proprietären Nische sei, widerspricht Philipp Kraiss. Vielmehr handele es sich um einen konsequenten Ausbau des Sortiments, denn Freda solle künftig den gesamten Alltag der Kund*innen abbilden – vom Frühstück bis zum Abendbrot. Das sei eben mehr als nur Pizza. „Unser Anspruch ist aber nicht nur Bekanntes besser zu machen – wie bei unserer Pizza, sondern auch neue Wege zu gehen“, stellt der Gründer klar. Die flexiblen Module seien auf diesem Weg der nächste logische Schritt. Er verspricht dabei maximale Vielfalt aus dem Gefrierfach, „denn jeder Block lässt sich vielfältig kombinieren.“

Die Retail-Herausforderung: Kaufland als Stresstest

Mit einer Basis von über 30.000 D2C-Kund*innen hat das Unternehmen bereits bewiesen, dass die Nachfrage nach seinen Produkten besteht. Um dieses Potenzial voll auszuschöpfen und die Margen zu stärken, wurde im August 2025 der Launch in 780 Kaufland-Märkten umgesetzt – ein strategischer Meilenstein, der die Reichweite massiv erhöht und über das Volumen des stationären Einzelhandels den Weg zu nachhaltigem, profitablem Wachstum ebnet – ohne aufwendigen Versand mit Isolierung und Trockeneis.

Hier zählt nun die Shelf Velocity (Abverkaufsgeschwindigkeit). Ein modulares System erfordert von der Kundschaft jedoch ein Umdenken: Man kauft kein fertiges Abendessen, sondern eine Zutat. Freda muss hier beweisen, dass der Mehrwert der Zeitersparnis am Point of Sale verstanden wird, bevor die harten Auslistungsmechanismen des Handels greifen.

Doch wie überzeugt man eine*n Einkäufer*in davon, dass ein modulares System mehr Flächenproduktivität bringt als die zehnte Sorte Standard-Lasagne? Christian Mahler kontert auf diese Retail-Frage mit einem anschaulichen Branchen-Vergleich: „Wir sind eben nicht die zehnte Lasagne. Eine klassische TK-Lasagne belegt viel Regalfläche, bedient genau einen Anlass und konkurriert mit neun anderen Lasagnen um denselben Kunden.“ Durch das kompakte Format und eine maximale SKU-Dichte der Blocks könne der Händler auf derselben Regalfläche mehrere Sorten listen und spreche damit dutzende Zubereitungsarten von der Bowl bis zum Curry an. Mahler zeigt sich selbstbewusst: „Wir eröffnen eine neue Kategorie statt in einer bestehenden zu kämpfen.“

Operative Exzellenz vs. bayerisches Handwerk

Ein weiterer Spagat wartet in der Produktion: Freda wirbt offensiv mit „Made in Bavaria“ und handwerklicher Herstellung. In der Start-up-Praxis beißt sich Handwerk jedoch oft mit Skalierung. Wer bundesweit fast 900 Supermärkte bedient, muss industrielle Prozesse beherrschen. Die Gefahr dabei ist offensichtlich: Wenn die Qualität durch die Masse sinkt, verliert Freda seinen wichtigsten USP. Gleichzeitig bleibt bei der exklusiven Zielgruppe, die bereit ist, für TK-Komponenten Premium-Preise zu zahlen, in Zeiten der Inflation die Frage der Preissensibilität bestehen.

Auf drohende Kapazitätsgrenzen angesprochen, räumt Philipp Kraiss ein, dass die Passauer Manufaktur zwar das Herzstück bleibe. „Aber wir waren von Anfang an ehrlich zu uns selbst: Eine Manufaktur skaliert nicht linear“, gibt der Seriengründer zu bedenken. Mit wachsendem Geschäft müsse man die Produktion auf breitere Schultern stellen und mit Partnern zusammenarbeiten. Sein Kernversprechen an die Kund*innen lautet dabei jedoch: „Wir lagern nicht die Rezeptur aus, sondern die Kapazität.“

Marktpsychologie: Convenience ohne Reue

Psychologisch besetzt Freda damit eine überaus geschickte Lücke. Die „Frozen Blocks“ nehmen der Käuferschaft zwar die Entscheidung für die aufwendige Kernkomponente ab, lassen das Gefühl des Selbstkochens durch das frische Ergänzen von Beilagen jedoch vollkommen intakt. Dies eliminiert die oft vorhandene „Convenience-Scham“ gesundheitsbewusster Zielgruppen und könnte die Lösung für die stagnierenden Marktanteile klassischer Fertiggerichte bei jüngeren Konsument*innen sein.

Fazit für die Start-up-Praxis

Freda ist ein Lehrstück für den Übergang von einer digitalen D2C-Brand zum Player im Massenmarkt. Die Gründer nutzen ihre Erfahrung, um eine etablierte Kategorie neu zu denken. Ob die Rechnung aufgeht, wird sich an der Regal-Rotation zeigen. Wenn die Kund*innen den Aufpreis für die „bayerische Handarbeit“ und das modulare System dauerhaft akzeptieren, könnte Freda die Blaupause für die nächste Generation von Food-Marken liefern.

Primogene: Muttermilch als Vorbild

Primogene ist ein 2023 gegründetes BioTech-Start-up mit Sitz in Leipzig, das sich auf die Entwicklung biotechnologischer Herstellungsverfahren für bioidentische Inhaltsstoffe spezialisiert hat. Ein Schwerpunkt liegt auf Verbindungen, die der Muttermilch nachempfunden sind und die Gesundheit in allen Lebensphasen fördern können.

Auch wenn das Produkt als weißes Pulver eher unscheinbar aussieht, markiert seine Existenz einen wissenschaftlichen Meilenstein. „Wir haben eine spezielle Technologie entwickelt, dank der wir komplexe bioidentische humane Milchzucker skalierbar herstellen können“, erzählt Linda Karger, einst Managementstudentin an der Technischen Universität in München, heute COO der 2023 in Leipzig gegründeten Primogene GmbH. Die chemischen Verbindungen entsprechen also den im menschlichen Körper vorkommenden Molekülen bis ins kleinste biochemische Detail. Und sie übernehmen – obwohl industriell hergestellt – die gleichen Funktionen, die bisher nur Muttermilch garantierte.

Zum Verständnis: Die komplexen Zuckerstrukturen sind nach Fett und Laktose der drittgrößte feste Bestandteil menschlicher Milch. Sie bieten einzigartige gesundheitliche Vorteile, unterstützen beispielsweise das Immunsystem sowie die kognitive Entwicklung wie kein anderer Stoff. „Nach zahllosen Gesprächen mit Ärzten und Kliniken begann unsere Geschichte mit der Idee, nährstoffreiche Inhaltsstoffe als Zusatz für die Ernährung von Frühgeborenen herzustellen. Weitergedacht können bioaktive Bestandteile der Muttermilch ebenso zur Krankheitsprävention bei Erwachsenen sinnvoll eingesetzt werden“, erklärt Karger. „Um das Wirkungspotenzial unserer Human Milk Oligosaccharides (HMO) weiter zu erforschen, testen wir diese aktuell in enger Zusammenarbeit mit dem Leipziger Fraunhofer-Institut für Zelltherapie und Immunologie.“

Produktsortiment in der Breite offen

Gleichzeitig wird die von Dr.-Ing. Reza Mahour (CEO, Experte für Bioverfahrenstechnologie) und Valerian Grote (CTO, Molekularbiologe/Experte für Analytische Biochemie) entwickelte enzymatische Technologie genutzt, um bioidentische Moleküle für andere Märkte zu erzeugen, beispielsweise Inhaltsstoffe für Produkte der Körperpflege oder Rohmaterialien für die Pharmaindustrie. „Wir produzieren selbst. Dabei lässt sich jedes unserer Produkte auf die spezielle Technologie zurückführen. Unseren Kunden bieten wir Komplettlösungen – das reicht von der Suche nach der richtigen Produktionsplattform bis hin zu Entwicklung und Produktion“, bestätigt Karger. Erste Umsätze wurden nach ihren Angaben bereits früh erzielt. Inhaltsstoffe für den Kosmetikbereich sollen noch in diesem Jahr mithilfe bestehender Partnerschaften am Markt eingeführt werden. Im Pharmabereich wird ebenfalls mit ersten Kunden zusammengearbeitet.

Karger ergänzt: „Wir haben früh auf Partnerschaften und Vorbestellungen gesetzt, um den Markt besser zu verstehen.“ Um die bereits verabredeten hochwertigen Roh- und Inhaltsstoffe bald in größeren Mengen liefern zu können, ist das aktuell elfköpfige Team von Primogene gerade innerhalb Leipzigs umgezogen. Für die anstehende Skalierung war der Wechsel auf eine Betriebsstätte mit mehr Laborfläche und größerem Produktionsbereich wichtig. Große Mitspieler auf dem Feld der HMOs wie die niederländische DSM-Firmenich oder der dänische Konzern Chr. Hansen schrecken Karger nicht: „Bekannt sind mehr als 200 verschiedene HMOs, davon sind bisher sieben strukturell einfacher industriell herstellbar und auf dem Markt. Sie werden mit einer Fermentationstechnologie produziert. Unser enzymatisches Verfahren kann deutlich mehr und komplexere Zuckerstrukturen hervorbringen. Außerdem reicht unsere Produktpalette weit über HMOs hinaus.“

Sichtbarkeit durch Innovationsplattform futureSax erleichtert Investorensuche

Das bisher benötigte Kapital stammt unter anderem von Business Angels aus dem Bereich der Biotechnologie, darunter auch Climate Founders, bei deren Accelerator-Programm Mahour Grote und Karger einst zusammenfanden. Für Primogene als forschungs- und deshalb kapitalintensives Biotech-Unternehmen sind daneben die Mittel aus Förderprogrammen des Landes Sachsen und der Stadt Leipzig von wesentlicher Bedeutung. Darüber hinaus profitiert das Start-up noch heute von der Sichtbarkeit, die es durch den Gewinn des dritten Platzes beim Sächsischen Gründerpreis 2024 erhielt. Zunächst sorgten der professionelle Nominiertenfilm und die begleitende Öffentlichkeitsarbeit von futureSax für Aufmerksamkeit sowohl in den Medien als auch innerhalb des Netzwerks.

Dann bot die Preisübergabe auf der Sächsischen Innovationskonferenz vor über 1.000 Gästen Primogene eine wichtige Gelegenheit zur Präsentation. „Sachsen ist ein Innovationsstandort mit besonderer Dichte: Exzellente Forschung, starke Industrie- und Mittelstandsstrukturen und eine wachsende Start-up-Szene greifen ineinander. Hier entstehen Lösungen, die international wettbewerbsfähig sind. Entscheidend ist der Schulterschluss im Ökosystem – von Hochschulen über Unternehmen bis zu Kapitalgebern. futureSax schafft dafür die Bühne und die Verbindungen, damit aus Ideen schneller Produkte, Partnerschaften und Gründungen werden“, erklärt Susanne Stump, Geschäftsführerin der Innovationsplattform des Freistaats Sachsen. Das Interesse großer Investoren bestätigt, dass Primogene auf dem richtigen Weg ist. Im Jahr 2025 schloss das innovative Start-up eine Seed-Finanzierungsrunde mit namhaften Investoren wie HTGF, TGFS, der Sächsischen Beteiligungsgesellschaft und better ventures ab. Das geplante Personalwachstum sowie die Produktionsaktivitäten der nächsten zwei Jahre sind damit gesichert.

Dies ist ein Beitrag aus der StartingUp 01/26 – hier kannst du die gesamt Ausgabe kostenfrei lesen: https://t1p.de/p8gop

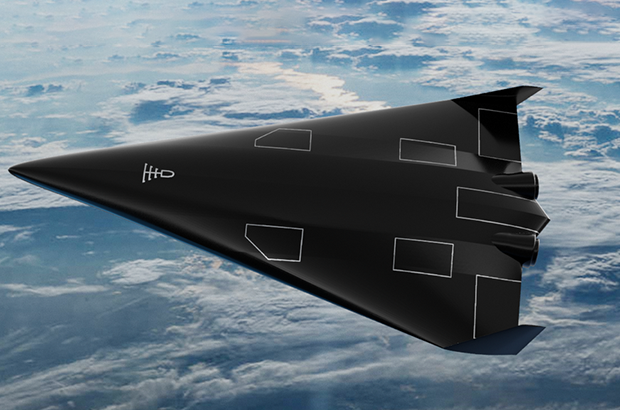

Battle-Tested & German Engineered: Das neue Power-JV der Drohnenwelt

Mit QFI startet die erste vollautomatisierte Produktionslinie für ukrainische Drohnen in Europa. Ein Gamechanger für die „Build with Ukraine“-Initiative und ein Weckruf für das deutsche Tech-Ökosystem. Agilität schlägt Trägheit: Unsere Analyse über die Architekten der neuen europäischen Resilienz und die Rolle von Start-ups.

Während die klassische Rüstungsindustrie oft mit jahrzehntelangen Entwicklungszyklen ringt, zeigt ein deutsch-ukrainisches Joint Venture, wie das „New Defense“-Zeitalter in Lichtgeschwindigkeit skaliert. Nur zwei Monate nach der offiziellen Ankündigung ist das Joint Venture Quantum Frontline Industries (QFI) operative Realität. Ein symbolträchtiger Moment markierte am 13. Februar den Startschuss: Auf seinem Weg zur Münchner Sicherheitskonferenz nahm der ukrainische Präsident Wolodymyr Selenskyj im Werk bei München die erste in Deutschland gefertigte Linza 3.0 entgegen – ein Meilenstein, der unter der Schirmherrschaft von Verteidigungsminister Boris Pistorius als neues „Leuchtturmprojekt“ der europäischen Souveränität gefeiert wird.

Das „German Model“: Wenn Software-Agilität auf automatisierte Masse trifft

QFI ist mehr als eine Fabrik; es ist der Prototyp des sogenannten German Model. Hier verschmilzt die operative Erfahrung von Frontline Robotics aus dem aktivsten Drohnenkrieg der Geschichte mit der industriellen Exzellenz der Münchner Quantum Systems GmbH. Das Ziel ist ambitioniert: Allein 2026 sollen 10.000 Einheiten der Modelle Linza und Zoom vom Band laufen. Diese Systeme sind hochgradig gegen elektronische Kampfführung (EW) gehärtet und finden dank KI-gestützter visueller Navigation auch ohne GPS-Signal ihr Ziel.

Dieser Erfolg strahlt auf das gesamte deutsche Ökosystem aus. Wir erleben derzeit, wie eine neue Generation von Gründern die Grenzen zwischen digitaler und physischer Souveränität neu zieht.

Ein vernetztes Ökosystem: Die Architekten der Resilienz

Hinter dem Erfolg von QFI steht ein Geflecht aus spezialisierten DeepTech-Akteuren, die Deutschland zum führenden Defense-Hub Europas gemacht haben. Während Quantum Systems mit seinem Status als „Triple Unicorn“ (Bewertung > 3 Mrd. €) die industrielle Skalierung im Luftraum beherrscht, liefert das Münchner Decacorn Helsing (bewertet mit 12 Mrd. €) das digitale Rückgrat. Helsing fungiert als der softwareseitige Integrator, dessen KI-Plattformen heute die Koordination zwischen autonomen Schwärmen und bemannten Einheiten übernehmen.

Am Boden setzt ARX Robotics Maßstäbe. Das Start-up hat seine Series-A im Sommer 2025 auf 42 Millionen Euro aufgestockt und Partnerschaften mit Schwergewichten wie Daimler Truck und Renk geschlossen. Ihr Betriebssystem Arx Mithra OS ermöglicht es, bestehende Fahrzeugflotten zu digitalisieren und in autonome „Mensch-Maschine-Teams“ zu verwandeln. Diese physische Präsenz am Boden wird durch die Orbit-Kapazitäten von Reflex Aerospace vervollständigt. Die Berliner liefern jene ISR-Daten (Intelligence, Surveillance, Reconnaissance), die für die Präzision moderner Drohnensysteme unverzichtbar sind.

Um die Abhängigkeit von asiatischen Lieferketten zu brechen, schließt das bayerische Start-up Donaustahl die Lücke in der Basis-Hardware. Mit einer neuen Fertigung in Hutthurm produziert Donaustahl nicht nur die bewährte „Maus“-Drohne, sondern skaliert die Produktion von Drohnenmotoren und Gefechtsköpfen wie dem „Shahed-Killer“. Ziel ist eine vollkommen souveräne Wertschöpfungskette „Made in Bavaria“, die auch bei globalen Handelskrisen handlungsfähig bleibt.

Der Finanz-Turbo: ESG als Enabler

Dass dieses Ökosystem so rasant wächst, liegt an einem fundamentalen Shift in der Finanzwelt. Seit die EU Verteidigungsinvestitionen offiziell als nachhaltigen Beitrag zur Sicherheit eingestuft hat, ist das Stigma verflogen. Investoren wie DTCP mit ihrem 500-Millionen-Euro-Fonds „Project Liberty“ oder die KfW über den „Ukraine Recovery Fund“ treiben die Skalierung voran. DefenseTech ist damit endgültig in den Portfolios institutioneller Anleger angekommen.

Strategie-Checkliste: Der Masterplan für Dual-Use-Gründer*innen

Für Gründer*innen, die in diesen Markt drängen, hat sich das Spielfeld professionalisiert. Wer 2026 erfolgreich sein will, muss diese fünf Punkte erfüllen:

- Dual-Use-DNA: Plane Technologie, die zivil (z.B. Katastrophenschutz) und militärisch nutzbar ist, um den Zugang zu ESG-konformen Kapitalspritzen zu maximieren.

- Compliance-Automatisierung: Nutze die neuen BAFA-Genehmigungen (AGG 45/46) für beschleunigte Exporte innerhalb der NATO und an strategische Partner.

- BSI-Kriterien erfüllen: Militärische Kund*innen akzeptieren nur Hardware, die höchsten Sicherheitsstandards (C5-Kriterien) entspricht.

- Operational Feedback-Loops: Suche Kooperationen für „Battle-Testing“. Echte Einsatzdaten sind 2026 die wichtigste Währung für technologische Überlegenheit.

- Mission-Driven Recruiting: Nutze den „Schutz der Demokratie“ als USP, um Top-KI-Talente von zivilen BigTech-Konzernen abzuwerben.

Fazit: Agilität schlägt Trägheit

Die Gründung von QFI ist der Beweis, dass Europa seine industrielle Trägheit ablegen kann. Durch die Verbindung von Start-up-Mentalität, staatlicher Rückendeckung und automatisierter Fertigung entsteht eine neue Form der technologischen Souveränität. Für das deutsche Ökosystem bedeutet das: Wir bauen nicht mehr nur Apps – wir bauen die Sicherheit der Zukunft.

Medizinal-Cannabis: Zwischen Wachstumsschub und regulatorischer Neujustierung

Zwischen Boom und strengeren Regeln: Der Markt für Medizinal-Cannabis steht nach einem Rekordjahr am Scheideweg. Investoren und Patienten blicken gespannt auf mögliche Gesetzesänderungen für 2026.

2025 war das erste vollständige Geschäftsjahr nach Inkrafttreten des Medizinal-Cannabisgesetzes im April 2024 – und damit ein echter Praxistest für den deutschen Markt. Mit der Entkopplung von Cannabis aus dem Betäubungsmittelrecht und der Vereinfachung der Verschreibung über Telemedizinplattformen änderten sich die Rahmenbedingungen spürbar. Die Effekte ließen nicht lange auf sich warten und resultierten in steigende Verordnungszahlen, stark wachsende Importmengen und einem beschleunigten Ausbau von Versorgungsstrukturen. Doch wie geht es weiter?

Ein Markt im ersten Jahr nach der Reform

Die Importzahlen verdeutlichen die Dynamik. Während 2023 noch rund 30 Tonnen medizinisches Cannabis nach Deutschland eingeführt wurden, entwickelten sich die Zahlen anschließend immer rasanter. Das Bundesministerium für Gesundheit vermeldete im ersten Halbjahr 2025 einen Anstieg der Importe von mehr als 400 Prozent, von rund 19 auf 80 Tonnen. Hochgerechnet auf das Gesamtjahr dürfte das Volumen jenseits der 140-Tonnen-Marke liegen. Diese Änderungen haben einen aufstrebenden Markt geschaffen, wodurch sich Deutschland zum größten Einzelmarkt für Medizinal-Cannabis in Europa entwickelt hat.

Parallel dazu stieg auch die Zahl der ausgestellten Rezepte deutlich an. Schätzungen gehen inzwischen von mehreren Millionen Patientinnen und Patienten aus, die Cannabis auf ärztliche Verordnung nutzen. Das Marktvolumen wird für 2025 auf bis zu eine Milliarde Euro geschätzt.

Ausbau der Strukturen und steigende Professionalisierung

Für viele Unternehmen der Branche war 2025 ein Jahr des Ausbaus. Investiert wurde in GMP-konforme Prozesse (Good Manufacturing Practice), Lieferkettenstabilität, Qualitätssicherung und digitale Patientensteuerung. Deutschland bleibt stark importabhängig, die inländische Produktion deckt weiterhin nur einen begrenzten Teil des Bedarfs. Internationale Partnerschaften mit Produzenten in Kanada, Portugal oder anderen EU-Staaten sind daher weiterhin zentraler Bestandteil der Marktstruktur.

Politische Reaktionen auf das Wachstum

Mit der steigenden Bedeutung des Marktes wächst auch die politische Aufmerksamkeit, die Debatte rund um die Teillegalisierung polarisiert und spaltet Meinungen. Vertreter der CDU äußerten frühzeitig Bedenken, dass vereinfachte Verschreibungswege zu Fehlentwicklungen führen könnten. Besonders digitale Plattformmodelle bzw. Telemedizinanbieter mit Sitz im Ausland geraten dabei in den Fokus der Kritik.

Im Herbst 2025 wurde von Warken & Co. ein Gesetzeswurf zur Änderung des Medizinal-Cannabisgesetzes vorgestellt. Dieser sieht unter anderem strengere Vorgaben für telemedizinische Verschreibungen vor, genauer gesagt einen verpflichtenden persönlichen Arztkontakt sowie ein Versandverbot über Telemedizinanbieter. Ziel ist es, medizinische Standards zu präzisieren und potenziellen Missbrauch zu verhindern. Die politische Argumentation verweist auf die stark gestiegenen Importzahlen und die zunehmende Zahl digital vermittelter Rezepte. Gleichzeitig wird betont, dass Cannabis als medizinische Therapie klar vom Freizeitkonsum abgegrenzt bleiben müsse und sich dabei viele Freizeitkonsumenten als Patienten ausgeben.

Innerhalb der Branche wird diese Entwicklung differenziert bewertet. Sascha Mielcarek, CEO der Canify AG, ordnet den Gesetzentwurf nüchtern ein: „Der Kabinettsentwurf zur Änderung des MedCanG schießt mit Kanonen auf Spatzen. Wir haben ein wachsendes Problem mit der missbräuchlichen Anwendung von Opioiden, Benzodiazepin und anderen verschreibungspflichtigen Medikamenten. Die Therapie mit Cannabis bietet in vielen Fällen eine nebenwirkungsärmere Alternative und mit dem Gesetzentwurf würde der Zugriff genau darauf erschwert werden. Medizinisches Cannabis eignet sich nicht, einen Präzedenzfall zu schaffen. Der Gesetzentwurf ist kein Beitrag zur Patientensicherheit.“

Unabhängig von der Bewertung einzelner Maßnahmen zeigt sich vor allem, dass der regulatorische Rahmen weiterhin in Bewegung ist. Für Unternehmen bedeutet das eine Phase erhöhter Unsicherheit bei gleichzeitig stabiler Nachfrage. Experten befürchten, dass der Markt um die Hälfte einbrechen könnte, sollte ein physischer, persönlicher Arztkontakt Wirklichkeit werden.

Was bedeutet das für Start-ups und Investoren?

Für Gründer und Kapitalgeber bleibt der Markt grundsätzlich attraktiv. Das Wachstum der vergangenen zwei Jahre zeigt eine robuste Nachfrage. Gleichzeitig sind die Eintrittsbarrieren hoch. Wer im medizinischen Cannabissektor aktiv werden möchte, benötigt regulatorisches Know-how, belastbare Lieferketten, medizinische Anbindung und Kapital für Qualitätssicherung und Compliance.

Gerade diese Anforderungen wirken jedoch auch stabilisierend. Der Markt ist stark reguliert, professionell organisiert und eingebettet in bestehende Gesundheitsstrukturen. Für Investoren stellt sich daher weniger die Frage nach dem Potenzial als nach der Planbarkeit. Politische Anpassungen wirken sich unmittelbar auf Geschäftsmodelle, Bewertungen und Expansionsstrategien aus.

Ausblick auf 2026

Mit Blick auf das neue Jahr zeichnet sich ein Szenario der Neujustierung ab. Möglich ist eine Konsolidierung, bei der sich professionelle Anbieter weiter etablieren und regulatorische Klarstellungen für mehr Stabilität sorgen. Ebenso denkbar sind weitere gesetzliche Anpassungen, die das Wachstum stärker strukturieren. 2026 wird zeigen, unter welchen regulatorischen Bedingungen sich dieser Markt weiterentwickelt – und wie attraktiv er für Gründer und Investoren langfristig bleibt.

VESTIO: Wenn ein Solar-Entrepreneur auf einen Stil-Rebellen trifft

Die Geschichte der jungen FashionTech-App VESTIO ist zugleich die zweier Gründer, die sich in einem gemeinsamen Ziel treffen: Die Demokratisierung von gutem Stil durch algorithmische Logik.

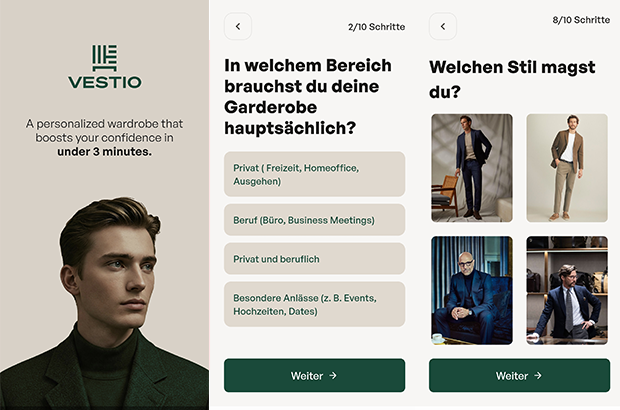

Hinter der FashionTech-App VESTIO steht die im Jahr 2024 von Bastian Arend und Justus Hansen gegründete Opus Stilberater GmbH, die den Anspruch erhebt, professionelle Stilberatung erstmals digital, logisch und kostenlos zugänglich zu machen.

Der „Solar-Entrepreneur“ trifft den Stil-Rebell

Die persönlichen Hintergründe der Gründer bieten spannende Kontraste, die weit über ein übliches Business-Profil hinausgehen. Bastian Arend, Co-Founder und CEO, kam über die Energiewende zur Mode. Als Seriengründer baute er den Online-Solar-Anbieter Klarsolar auf und verkaufte ihn im Dezember 2023 erfolgreich an den Energiekonzern E.ON. Die Übernahme erfolgte in einer für die Solarbranche schwierigen Marktphase, was Bastian Arend als Krisen-erprobten Strategen auszeichnet.

VESTIO entwickelte er 2024 jedoch aus einem ganz persönlichen „Pain Point“ heraus: Während er internationale Millionen-Finanzierungsrunden leitete, bestand sein eigener Stil mangels Zeit lediglich aus Hoodie, Jeans und Sneakern. „Ich wollte nur jemanden, der für mich einkauft“, erinnert er sich an diese Phase. Seine Abneigung gegen zeitraubendes Shopping führte ihn schließlich zu Justus Hansen.

Justus Hansen, Co-Founder und Chief Styling Officer, bringt eine Biografie ein, in der Mode schon immer eine zentrale Rolle spielte. Sein Gespür für klassische Mode ist tief verwurzelt: Justus Hansen trug bereits im Kindergarten eine Fliege und provozierte später Lehrer, indem er im Sakko zum Unterricht erschien. Bevor er mit über 1,6 Millionen Follower*innen zu einem der bekanntesten Männerstilberater Deutschlands aufstieg, studierte er Jura und absolvierte Praktika im Bankensektor, unter anderem bei der Dresdner Bank.

Diese Erfahrungen schärften seinen Blick für die Anforderungen moderner „Business-Garderoben“. Als Arend ihn fragte, ob er für ihn einkaufen könne, antwortete Justus Hansen bestimmt: „Einfach irgendwas kaufen? Nein. Ich muss verstehen, wer du bist.“ Bastian Arend begriff Hansens modulare Styling-Methode sofort als logisches System und schlug vor: „Wir sollten deine Methode digitalisieren und kostenlos für jeden Mann zugänglich machen.“ Für Justus Hansen wurde damit ein „Lebenstraum“ wahr.

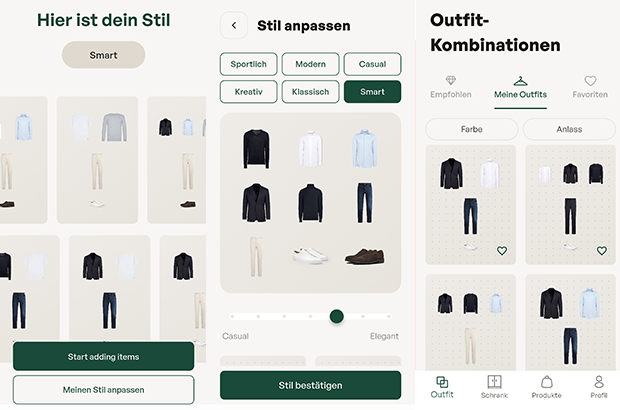

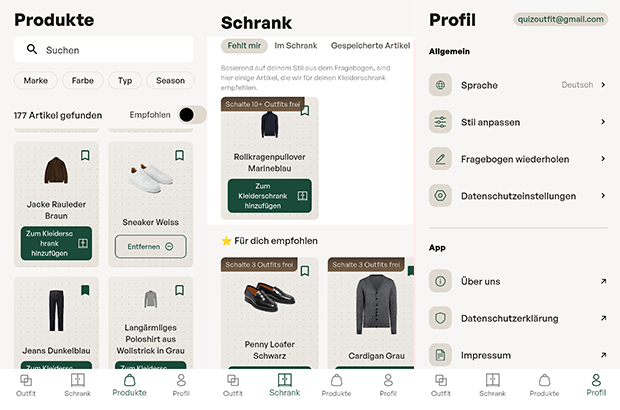

Das Konzept: „Weniger Teile, mehr Outfits“

Das Herzstück der App bildet ein algorithmisches Styling-System, das strikt dem Leitsatz „Weniger Teile. Mehr Outfits“ folgt. In nur drei Minuten erstellt ein Stilfinder-Fragebogen eine persönliche Grundgarderobe. Der digitale Kleiderschrank funktioniert dabei bewusst ohne das mühsame Hochladen von Fotos; das System kennt die wichtigsten Basics, erkennt Lücken und empfiehlt gezielt Ergänzungen. Justus Hansen betont dabei die Wichtigkeit der Basis: „Die wenigsten Männer besitzen eine echte Basisgarderobe. Und das ist die Grundlage, aus der ihre besten Outfits entstehen.“

Ziel ist es, automatisch kombinierbare Outfits für alle Anlässe zu generieren. Dabei verfolgen die Gründer eine klare ästhetische Linie: „Outfits müssen nicht kompliziert sein, um zu wirken. Sie brauchen lediglich eine klar erkennbare Linie“, so Hansen. Bastian Arend ergänzt: „Die besten Outfits für Männer sind nicht kompliziert, sondern harmonisch und durchdacht.“

Das Affiliate-Dilemma: Geschäftsmodell im kritischen Check

Wirtschaftlich operiert VESTIO über ein Affiliate-Modell. Die App ist für Nutzer kostenlos, während das Unternehmen Provisionen von Partner-Anbietern bei einem erfolgreichen Kauf erhält. Hier liegt für den kritischen Betrachter ein interessanter systemischer Interessenkonflikt: Das erklärte Ziel „Weniger Konsum – bessere Entscheidungen“ steht ökonomisch potenziell im Widerspruch zu einem Modell, das von Transaktionen lebt. Zudem stellt sich die Frage der langfristigen Nutzerbindung: Sobald ein Mann seine „perfekte Garderobe“ aufgebaut hat, sinkt der Bedarf für weitere Anschaffungen. Dass das Unternehmen dennoch auf Wachstum setzt, zeigt die Erhöhung des Stammkapitals auf knapp 30.000 Euro im September 2025. Langfristig plant VESTIO die Integration eines Marktplatzes, der Partnerprodukte und eigene Kollektionen vereint, um basierend auf Daten den größten Mehrwert zu liefern.

Marktpositionierung und technologischer Vorsprung

Im Vergleich zum Wettbewerb besetzt VESTIO eine spezifische Nische. Während Curated-Shopping-Anbieter (z.B. Outfittery) auf den Versand physischer Boxen setzen, bleibt VESTIO ein rein digitaler Guide, der dem Nutzer die volle Freiheit bei der Wahl des Händlers überlässt. Andere Styling-Apps verlangen oft zeitintensive Foto-Inventuren, während VESTIO auf logische Kombinationen setzt.

Das Risiko bleibt jedoch die Abhängigkeit von der Personal Brand Justus Hansens. Letztlich ist VESTIO der Versuch, Mode so effizient wie eine Prozessoptimierung zu gestalten – oder wie Bastian Arend es formuliert: „Viele Männer haben mehr Kleidung als Stil. Vestio ändert das.“ Mit dem Aufbau der App wolle man Männern „genau diese Arbeit abnehmen“, damit sie sich ultimativ „besser fühlen“ können.

DIONYS: Schluss mit Event-Chaos

Events und Offsites erleben ein massives Comeback. Doch hinter den Kulissen vieler Locations herrscht oft noch analoges Chaos. Das Münchner Start-up DIONYS will genau das ändern: Schluss mit dem E-Mail-Pingpong, hin zu echten Buchungen.

Die steigende Nachfrage nach Firmen-Events und privaten Feiern stellt die Hospitality-Branche vor administrative Herausforderungen. Während Hotelzimmer und Tischreservierungen weitgehend digitalisiert sind, erfolgt die Bearbeitung von Gruppenanfragen und Event-Konfigurationen in vielen Betrieben noch manuell. Das 2025 gegründete Software-Start-up DIONYS tritt an, um diesen Prozess durch Standardisierung zu beschleunigen.

Konfigurator statt E-Mail-Pingpong

Das Kernprodukt des Unternehmens ist eine Softwarelösung, die den Angebotsprozess für Veranstaltungen digitalisiert. Anstatt individuelle Angebote manuell zu tippen, sollen Kunden ihre Events – von Menüs bis zu Getränkepaketen – über eine Online-Oberfläche selbst konfigurieren können.

CEO Folke Mehrtens beschreibt den aktuellen Zustand der Branche als paradox: „Es ist absurd: Gerade dort, wo Events den meisten Umsatz bringen, fehlt oft jede Struktur. Solange Events wie Sonderfälle behandelt werden, bleiben sie ein operativer Schmerz.“

Die Software von DIONYS zielt darauf ab, diesen „Schmerz“ zu lindern, indem sie Events von der manuellen Ausnahme zum standardisierten Produkt wandelt – buchbar und transparent wie im E-Commerce.

Technik trifft auf operative Erfahrung

Technisch steht das Unternehmen vor der Hürde, die individuellen Parameter von Gastronomiebetrieben – etwa spezifische Stornoregeln oder variable Menüfolgen – in einen Algorithmus zu überführen. CTO Gregor Matte betont, dass die Herausforderung weniger in der reinen Buchung, sondern in der Abbildung der operativen Vielfalt liege.

Um die Praxistauglichkeit sicherzustellen, setzt das Gründungsteam auf Mitstreiter mit Branchenhintergrund. Neben Mehrtens (Strategie) und Matte (Technik) sind unter anderem Ekkehard Bay (ehemals Manager im Mandarin Oriental) sowie Daniel Simon (ehemals OpenTable) an Bord.

Wettbewerb und der Faktor „Mensch“

DIONYS positioniert sich in einem dichten Marktumfeld zwischen etablierten Back-Office-Lösungen wie Bankettprofi und modernen Reservierungssystemen wie aleno. Die Münchner suchen ihre Nische bei individuellen Event-Locations und Restaurants, die sich von reinen Tagungshotels abgrenzen.

Die in der Branche verbreitete Sorge, dass durch die Digitalisierung die persönliche Note leide, versucht Head of Hospitality Ekkehard Bay zu entkräften: „Wenn Standardfragen digital geklärt sind, bleibt im echten Gespräch mehr Zeit für das, was wirklich zählt: besondere Wünsche und echte Aufmerksamkeit.“

Erste Marktdaten und Ausblick

Seit dem Start im Herbst 2025 wurden nach Angaben des Unternehmens Anfragen mit einem Volumen von rund 400.000 Euro über das System abgewickelt. Zu den ersten Nutzern zählen bekannte Münchner Betriebe wie Kustermann und die Bar Valentin. Das Erlösmodell basiert auf einer Kombination aus monatlicher Softwaregebühr und umsatzabhängigen Komponenten.

Für die nächste Wachstumsphase strebt DIONYS die Akquise von 100 „Pionier-Betrieben“ in der DACH-Region an. Ob sich der Ansatz als neuer Industriestandard durchsetzen kann, wird davon abhängen, ob die Software die komplexen Anforderungen einer breiten Masse an unterschiedlichen Betrieben tatsächlich ohne manuelles Nachsteuern abbilden kann. Daniel Simon gibt sich zuversichtlich: „In drei Jahren wird Event-Management nicht mehr improvisiert, sondern datenbasiert gesteuert.“

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

Die Wächter des Firmengedächtnisses

Wie das 2025 von Christian Kirsch und Stefan Kirsch gegründete Start-up amaiko den Strukturwandel im Mittelstand adressiert.

Der demografische Wandel und eine erhöhte Personalfluktuation stellen mittelständische Unternehmen zunehmend vor die Herausforderung, internes Know-how zu bewahren. Viele Unternehmen stehen vor der Schwierigkeit, dass Firmenwissen fragmentiert vorliegt. Informationen sind häufig in unterschiedlichen Systemen oder ausschließlich in den Köpfen der Mitarbeitenden gespeichert. Verlassen langjährige Fachkräfte den Betrieb in den Ruhestand oder wechseln jüngere Arbeitnehmerinnen und Arbeitnehmer kurzfristig die Stelle, gehen diese Informationen oft verloren. Zudem bindet die Suche nach relevanten Dokumenten in verwaisten Ordnerstrukturen Arbeitszeit, die in operativen Prozessen fehlt.

Das 2025 gegründete Start-up amaiko aus Niederbayern setzt hierbei auf einen technischen Ansatz, der auf die Einführung neuer Plattformen verzichtet und stattdessen eine KI-Lösung direkt in die bestehende Infrastruktur von Microsoft Teams integriert. Vor diesem Hintergrund entwickelten die Brüder Christian und Stefan Kirsch mit amaiko eine Softwarelösung, die spezifisch auf die Ressourcenstruktur mittelständischer Betriebe ausgelegt ist.

Integration statt neuer Insellösungen – und die Abgrenzung zu Copilot

Ein wesentliches Merkmal des Ansatzes ist die Entscheidung gegen eine separate Software-Plattform. Christian Kirsch, Geschäftsführer von PASSION4IT und amaiko, positioniert die Lösung als „Teams-native“. Das bedeutet, dass der KI-Assistent technisch in Microsoft Teams eingebettet wird – jene Umgebung, die in vielen Büros bereits als primäres Kommunikationswerkzeug dient. Ziel ist es, die Hürden bei der Implementierung zu senken, da Nutzer ihre gewohnte Arbeitsumgebung nicht verlassen müssen.

Angesichts der Tatsache, dass Microsoft mit dem „Microsoft 365 Copilot“ derzeit eine eigene, tief integrierte KI-Lösung ausrollt, stellt sich die Frage nach der Positionierung. Christian Kirsch sieht hier jedoch keine direkte Konkurrenzsituation, sondern eine klare Differenzierung: Copilot sei eine sehr breite, Microsoft-zentrische KI-Funktion. Amaiko hingegen verstehe sich als spezialisierter, mittelstandsorientierter Wissensassistent, der Beziehungen, Rollen, Prozesse und Unternehmenslogik tiefgreifend abbildet.

Ein entscheidender Vorteil liegt laut Kirsch zudem in der Offenheit des Systems: „Während Copilot naturgemäß an Microsoft‑Systeme gebunden ist, lässt sich amaiko herstellerunabhängig in eine viel breitere Softwarelandschaft integrieren – vom ERP über CRM bis zu Branchenlösungen. Unser Ziel ist nicht, Copilot zu kopieren, sondern reale Mittelstandsprozesse nutzbar zu machen“, so der Co-Founder.

Funktionsweise, Sicherheit und Haftung

Funktional unterscheidet sich das System von herkömmlichen Suchmasken durch eine agentenähnliche Logik. Die Software bündelt Wissen aus internen Quellen wie Richtlinien oder Projektdokumentationen und stellt diese kontextbezogen zur Verfügung. Ein Fokus liegt dabei auf der Datensouveränität. Hierbei betont Christian Kirsch, dass Kundendaten nicht in öffentlichen Modellen verarbeitet werden: „Die Modelle laufen in der europäischen Azure AI Foundry, unsere eigenen Dienste auf deutschen Servern. Die Daten des Kunden bleiben on rest vollständig im jeweiligen Microsoft‑365‑Tenant. Es findet kein Training der Foundation Models mit Kundendaten statt – weder bei Microsoft noch bei uns. Grundlage dafür sind die Azure OpenAI Non‑Training Guarantees, die Microsoft in den Product Terms sowie in SOC‑2/SOC‑3‑ und ISO‑27001‑Reports dokumentiert.“

Auch rechtlich zieht das Start-up eine klare Grenze, sollte die KI einmal fehlerhafte Informationen, sogenannte Halluzinationen, liefern. „Amaiko generiert Vorschläge, keine rechts‑ oder sicherheitsverbindlichen Anweisungen. Das stellen wir in unseren AGB klar: Die Entscheidungshoheit bleibt beim Unternehmen. Wir haften für den sicheren Betrieb der Plattform, nicht für kundenseitig freigegebene Inhalte oder daraus abgeleitete Maßnahmen. Es geht um eine saubere Abgrenzung – technische Verantwortung bei uns, inhaltliche Verantwortung beim Unternehmen“, so Christian Kirsch.

Geschäftsmodell und Markteintritt

Seit der Vorstellung der Version amaiko.ai im Juli 2025 wird das System nach Angaben des Unternehmens mittlerweile von über 200 Anwendern genutzt. Durch die Integration in die bestehende Microsoft-365-Landschaft entfällt für mittelständische Kunden eine aufwendige Systemmigration, was die technische Eintrittsbarriere gering hält.

Passend zu diesem Ansatz ist amaiko als reines SaaS-Produkt konzipiert, das Unternehmen ohne Einstiegshürde direkt online buchen können. Laut Kirsch sind keine Vorprojekte, individuellen Integrationspfade oder teuren Beratungspflichten notwendig: „Die Nutzung ist selbsterklärend und leichtgewichtig. Wer zusätzlich Unterstützung möchte – etwa zur Wissensstrukturierung oder Governance – kann sie bekommen. Aber die technische Einführung selbst ist bewusst so gestaltet, dass Mittelständler ohne Implementierungsaufwand starten können.“

Unterm Strich liefert amaiko damit eine pragmatische Antwort auf den drohenden Wissensverlust durch den demografischen Wandel: Statt auf komplexe IT-Großprojekte zu setzen, holt das bayerische Start-up die Mitarbeitenden dort ab, wo sie ohnehin kommunizieren. Ob sich die „Teams-native“-Strategie langfristig gegen die Feature-Macht von Microsoft behauptet, bleibt abzuwarten – doch mit dem Fokus auf Datensouveränität und mittelständische Prozesslogik hat amaiko gewichtige Argumente auf seiner Seite, um sich als spezialisierter Wächter des Firmengedächtnisses zu etablieren.

Wie viel verdienen Twitch Streamer wirklich? Zahlen und Verdienstmöglichkeiten im Blick

Wer als passionierter Spieler noch nicht an eine Gaming Karriere gedacht hat, sollte dies jetzt nachholen: Schließlich ergeben sich aus dieser von Esport-Turnieren bis hin zum Streaming einige Verdienstmöglichkeiten. Creatoren verdienen mit der Echtzeit-Übertragung ihres Spielerlebnisses Geld. Was sich einfach anhört, kann für so manchen Spieler auch zum komplexen Unterfangen werden. Wie hoch der Streamer Verdienst in diesen Fällen ausfällt und welche Einnahmemöglichkeiten es für Twitch Streamer noch gibt, erfahren Sie hier.

Die Top 10 Twitch Streamer im Jahr 2025

„Es gewinnt nicht der beste Spieler, sondern der beste Entertainer.“ |

Auf Plattformen wie Twitch gilt: Die Community beeinflusst stark, wie viel Geld Streamer verdienen können. Wer eine starke Zuschauergemeinde aufbauen kann, freut sich in der Regel über ein höheres Einkommen – dabei spielt vor allem die Interaktion der Viewer eine zentrale Rolle.

Aktuell weisen diese top 10 Twitch Channels die höchsten Zuschauerzahlen vor:

Streamer | Durchschnittliche Zuschauerzahl | Follower |

126.449 | 19,8 Millionen | |

52.024 | 7,9 Millionen | |

46.844 | 3,3 Millionen | |

36.903 | 2,2 Millionen | |

29.320 | 2,2 Millionen | |

71.045 | 1,5 Millionen | |

31.839 | 1,5 Millionen | |

42.837 | 1,4 Millionen | |

34.996 | 1,1 Millionen | |

30.438 | 993.817 |

Geld verdienen mit Streaming: Diese Faktoren wirken sich auf Twitch Einnahmen aus

Die Twitch-Einnahmen der verschiedenen Streamer setzen sich aus unterschiedlichen Verdienstquellen zusammen. So können die Kontoinhaber Werbung in ihren Live-Übertragungen schalten, die ihnen je nach Zuschauerzahl und Länge der Werbepause einen kleinen bis mittleren Betrag einbringen. Hierbei handelt es sich jedoch um ein eher statisches Nebeneinkommen, das die meisten Streamer auch als nebensächlich empfinden. Den größeren Teil des Twitch Einkommens machen Abonnements und Spenden der Zuschauer aus, aber auch Sponsoring und Markenpartnerschaften.

Übrigens: Twitch Auszahlungen erfolgen automatisch via PayPal oder Banküberweisung, sofern ein gewisser Mindestbetrag erreicht wurde. In diesem Zusammenhang bieten mobile casinos, ähnlich wie Streaming-Plattformen, eine bequeme Möglichkeit für Spieler, jederzeit und überall zu spielen, ohne auf traditionelle Zahlungsmethoden angewiesen zu sein. Diese Art von Plattformen hat sich zu einer beliebten Option entwickelt, da sie den Nutzern schnelle Auszahlungen und einfache Handhabung bieten.

Twitch Daten Leak 2021: Das verdienen Top-Streamer

Ende 2021 wurde die bekannte Plattform Twitch gehackt. Bei einem Datenleck kam heraus, dass die 2014 von Amazon gekaufte Plattform kaum Sicherheitsvorkehrungen geschaffen hatte – weshalb große Teile des Programmiercodes sowie Login-Daten und Zahlen zum Streamer Verdienst veröffentlicht werden konnten. Zu sehen waren vor allem die Gesamteinnahmen der Top Spieler aus den Twitch Statistiken des Zeitraumes August 2018 bis Oktober 2021 in US-Dollar:

- CriticalRole: 9,6 Millionen

- xQc: 8,5 Millionen

- summit1g: 5,8 Millionen

- Tfue: 5,3 Millionen

- Nickmercs: 5,1 Millionen

Zum Vergleich: Der deutsche Twitch Streamer Marcel Eris (alias MontanaBlack88) hat über Twitch 2,4 Millionen US-Dollar eingenommen. Der Streamer MontanaBlack88 gehört zu den bestbezahlten deutschen Spielern auf Twitch.

Damit werden die großen Unterschiede zwischen den Verdiensten der Streamer aus Deutschland und den USA deutlich. Rund vier Millionen Deutsche verfolgen Twitch-Übertragungen – und das sogar täglich. In den USA liegt die tägliche Zuschauerzahl bei stolzen 35 Millionen Nutzern, sodass amerikanische Streamer auch einen deutlich größeren Markt bedienen und die Einkommensunterschiede nicht verwunderlich sind. MontanaBlack88 ist allerdings auch auf anderen Plattformen wie YouTube zu finden, sodass sein Gesamtverdienst womöglich deutlich höher liegt.

Gut zu wissen: Twitch Partner (von Twitch ausgewählte Streamer mit qualitativem Content) können sich über höhere Einnahmen freuen – etwa einen höheren Anteil aus dem Abonnenten-Verdienst.

Im Detail: So setzt sich der Verdienst zusammen

Wie eingangs erwähnt, verdienen Twitch Streamer vor allem durch Abonnenten einen großen Teil ihres Einkommens. Das Abonnement kostet Subscribern in der ersten Stufe 4,99 Euro – wovon Streamer in der Regel 50% (2,50 Euro) behalten dürfen. Dafür erhalten Abonnenten bestimmte Vorteile wie etwa die Möglichkeit, per Chat mit dem Streamer interagieren zu können. Wer also 1.000 Abonnenten hat, kann deshalb schon mit Einnahmen von 2.500 Euro monatlich rechnen.

Einen Großteil ihrer Einnahmen generieren Gaming-Streamer aber auch mit Hilfe von Subscriber-Spenden. Diese werden in Twitch Bits genannt und von der Plattform ausgezahlt. Die Spenden rufen bei einigen Streamern emotionale Reaktionen hervor, was wiederum mehr Menschen zum Spenden anregt.

Eine weitere Möglichkeit stellt Affiliate-Marketing dar: Streamer bewerben in dem Fall für ihre Zuschauer interessante Produkte in ihren Videos. Kaufen Zuschauer die Produkte, profitieren Streamer von einer Provision – die nicht selten 30% des Kaufbetrages ausmacht.

Sponsoren und Markendeals als größte Einnahmequelle für Streamer

An Streamer mit besonders hohen Zuschauer- und Followerzahlen treten oft auch bekannte Marken heran. Sie bezahlen die Gamer dafür, ihre Produkte im Live-Stream anzupreisen – beispielsweise Gaming-Peripherie oder Energy-Drinks. Soll dies über einen längeren Zeitraum geschehen, werden solche Marken oft auch zum Sponsor des Spielers, um ihre eigene Reichweite zu erhöhen.

Kosten und Abzüge: Dem steht der Streamer Gehalt in Deutschland gegenüber

Die genannten Streamer Gehälter stellen Brutto-Summen dar – also den Verdienst vor Abzug der deutschen Einkommens-, Umsatz- und Gewerbesteuer, sowie Sozialversicherungen. Wer all diese Beträge zusammenzählt, muss oft bis zu 45% seines Brutto-Einkommens an den Fiskus abführen. Doch damit nicht genug: Die meisten Twitch-Streamer müssen auch Chat-Moderatoren bezahlen, die für eine angenehme Atmosphäre unter den Kommentierenden sorgen und Community-Richtlinien durchsetzen.

Darüber hinaus wollen sich Zuschauer nur Streams ansehen, die eine hohe Qualität aufweisen. Um leistungsstark spielen und den Verlauf optimal übertragen zu können, brauchen Streamer bestimmtes Gaming-Equipment, das selbst zwischen 2.000 und 10.000 Euro kosten kann. Auch eine stabile Internetverbindung und die damit verbundenen Kosten sind zu bedenken.

Alternative Plattformen zur Diversifizierung

Um noch mehr Einkommen zu generieren, können passionierte Spieler ihre Streams allerdings zusätzlich auf anderen Plattformen veröffentlichen und monetarisieren – beispielsweise durch Werbung und Affiliate-Marketing. Zur Diversifizierung kommen Plattformen wie YouTube und Kick in Frage, die teilweise sogar bessere Konditionen bieten. Denn: Bei Kick werden Streamer zu 95% an den Einnahmen durch Abonnements beteiligt, was im Gegensatz zu Twitch deutlich attraktiver erscheint.

Optocycle: Bauschutt-Recycling auf KI-Basis

Die Optocycle-Gründer Max-Frederick Gerken und Lars Wolff Optocycle zeigen, wie aus Bauschutt neuer Rohstoff wird und erhalten dafür eine Förderung der Deutschen Bundesstiftung Umwelt (DBU).

Jährlich fallen in Deutschland laut Umweltbundesamt rund 86 Mio. Tonnen Schutt und Abfälle auf Baustellen an. Häufig landen diese Materialien auf Deponien. So gehen allerdings wertvolle Ressourcen verloren. Der Ausweg: Ein hochqualitatives Recycling des Schutts vermeidet klimaschädliche Emissionen und hält wertvolle Materialien im Wertstoffkreislauf – und das bei zertifiziert gleichwertiger Qualität.

Um das Recycling von Material im Bausektor zu automatisieren, entwickelt das 2022 von Max-Frederick Gerken und Lars Wolff gegründete Start-up Optocycle aus Tübingen ein System auf Grundlage künstlicher Intelligenz (KI) zum Echtzeit-Monitoring.

Echtzeit-Monitoring im Recycling-Prozess

Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit rund 170.000 Euro. Im Rahmen der DBU-Green Startup-Förderung haben die Gründer ein KI-basiertes System zur automatischen, reproduzierbaren Klassifizierung von Bauabfällen entwickelt. Darauf aufbauend soll nun ein Prototyp das Echtzeit-Monitoring von RC-Körnungen – also recycelten Gesteinskörnungen aus Bauschutt – ermöglichen.

„Aktuell basiert in der Branche der Aufbereitungsprozess von Bauschutt meist auf subjektiven Schätzungen“, so Max-Frederick Gerken. Auch das Endprodukt werde nur stichprobenartig im Labor überprüft. Mit dem System sei „Echtzeitmonitoring von Recycling-Gesteinskörnungen möglich. Somit können die Qualität der Körnung verbessert und mehr Material in die Beton-Produktion überführt werden“, so Gerken.

Die Qualität von Sekundärrohstoffen verbessern

Das System kombiniert laut Gerken moderne, optische Sensorik mit KI – und löse so ein altbekanntes Problem in der Baubranche. „Zurzeit schwankt oft die Beschaffenheit der recycelten Rohstoffe. Das bedeutet einerseits ein wirtschaftliches Risiko für Unternehmen und führt andererseits zum Verlust von wertvollen Materialien“, so Gerken. Optocycle erwartet mithilfe seiner Entwicklung eine 20 Prozent höhere Menge an recycelten, hochqualitativen Gesteinskörnungen sowie 15 Prozent geringere Abfallreste, die sonst auf Deponien landen würden. Dazu werden nach Gerkens Angaben sowohl der eingehende Schutt „optimal klassifiziert“ als auch das Ergebnis transparent überprüft. Kooperationspartner ist hierbei die Heinrich Feeß GmbH, die laut Gerken bereits seit vielen Jahren mit Optocycle zusammenarbeitet. Der Mitgründer weiter: „Die Technologie leistet einen Beitrag für Kreislaufwirtschaft im Bauwesen. Wir helfen dabei, die Qualität von Sekundärrohstoffen zu verbessern, die aus dem Bauschutt gewonnen werden. Diese Lösung lässt sich zudem perspektivisch auf alle Abfallströme übertragen."

Das System von Optocycle kann Gerken zufolge direkt in bereits bestehende Anlagen zur Verarbeitung von Bauabfällen installiert werden – „direkt über dem Fließband.“ Diese einfache Nachrüstung spare Kosten und ermögliche die schnelle Umsetzung eines innovativen Bauschutt-Recyclings. „Denn nur wenn das Recycling finanziell machbar ist, kann die Kreislaufwirtschaft in der Baubranche Erfolg haben“, so Gerken.

Kreislaufwirtschaft in der Baubranche ist aktiver Klimaschutz

Kreislaufwirtschaft in der Baubranche hat nach den Worten des zuständigen DBU-Referenten Dr. Volker Berding wichtige Effekte für den Klimaschutz: „Die Produktion von immer neuem Beton sorgt für hohen Ausstoß von klimaschädlichen Treibhausgasen.“ Einer WWF-Studie zufolge entstehen bei der Herstellung von Zement – dem wichtigsten Bestandteil von Beton – acht Prozent der gesamten globalen Treibhausgasemissionen. Berding: „Alles, was zur einer Emissionsreduzierung beiträgt, hat also bereits einen großen Effekt für den Klimaschutz.“ Eine Kreislaufwirtschaft funktioniere jedoch nur, „wenn die Sekundärrohstoffe sich qualitativ nicht von einer Neuproduktion unterscheiden. Genau diesen Schritt kann Optocycle mit einem skalierbaren, optimierten Prototypen gehen.“