Aktuelle Events

Von der Kochbox zum Hundenapf: Ex-HelloFresh-Duo startet Tasty Petfood

10.02.2026

Wie Lisa Vannini und Nadja Chylla mit ihrem Start-up Tasty Petfood die etablierten Premium-Tierfuttermarken herausfordern.

Das Berliner Start-up Tasty Petfood ist offiziell in den Markt eingetreten. Das Unternehmen, gegründet von den ehemaligen HelloFresh-Kolleginnen Lisa Vannini und Nadja Chylla, positioniert sich im Premium-Segment für Hundefutter und setzt dabei auf ein digitales Vertriebsmodell. Der offizielle Marktstart in Deutschland und der Schweiz erfolgte am 6. Februar 2026.

Transfer von Food-Logistik auf den Heimtiermarkt

Die Gründerinnen arbeiteten zuvor über fünf Jahre gemeinsam beim Kochboxen-Versender HelloFresh. Das dort in den Bereichen Skalierung und Operations gewonnene Know-how wollen Lisa und Nadja nun auf den Heimtiermarkt übertragen.

„Wir haben gemerkt, dass viele Hundehalter entweder bei klassischem Trockenfutter bleiben oder sehr viel Zeit in aufwendige BARF-Konzepte investieren müssen. Genau diese Lücke zwischen Bequemlichkeit und echter Qualität wollten wir schließen“, berichtet Lisa.

Das Kernprodukt von Tasty Petfood unterscheidet sich logistisch von herkömmlichem Nassfutter oder Barf-Angeboten: Das Unternehmen vertreibt dampfgegartes Frischfutter im Glas. Ein wesentlicher Unterschied zu vielen Wettbewerbern im Frische-Segment ist die Haltbarmachung: Die Produkte benötigen keine geschlossene Kühlkette und können ungekühlt gelagert werden. Dies reduziert die Komplexität in der Lagerhaltung und im Versand erheblich – ein Faktor, der im D2C-Bereich direkten Einfluss auf die Unit Economics hat. „Unser Anspruch war Qualität wie selbstgekocht – aber ohne Kühlschrank und ohne komplizierte Logistik. Dass wir Frische, Haltbarkeit und Alltagstauglichkeit verbinden können, ist für viele Kundinnen und Kunden ein echter Gamechanger“, sagt Nadja.

Wachstumskurs in einem Milliardenmarkt

Mit ihrem Geschäftsmodell stoßen die Gründerinnen in ein wirtschaftlich hochattraktives Umfeld vor. Nach aktuellen Daten des Industrieverbands Heimtierbedarf (IVH) und des Zentralverbands Zoologischer Fachbetriebe (ZZF) liegt der Gesamtumsatz der Branche bei rund sieben Milliarden Euro, wobei allein das Segment für Fertignahrung gut 4,4 Milliarden Euro ausmacht. Trotz allgemeiner wirtschaftlicher Herausforderungen bleibt die Zahlungsbereitschaft der Halter hoch.

Während der Absatz im Standard-Segment teils stagniert, wächst der Bereich für Premium-Nahrung kontinuierlich. Tasty Petfood ordnet sich im oberen Preissegment ein und zielt auf eine kaufkräftige Zielgruppe, die den Trend zur „Humanisierung“ des Haustiers vorantreibt.

„Hunde werden heute immer stärker als Familienmitglieder gesehen. Entsprechend steigen die Ansprüche an Transparenz, Zutatenqualität und Nährstoffversorgung – ähnlich wie beim eigenen Essen“, so Lisa.

Die Nische zwischen Konzern und Tiefkühltruhe

In diesem dynamischen Umfeld muss sich Tasty Petfood gegen zwei Lager behaupten. Zum einen konkurriert das Start-up mit etablierten Premium-Marken im stationären Handel wie Terra Canis, das als Pionier für „Human Grade“-Nahrung gilt und seit 2017 mehrheitlich zum Nestlé-Konzern gehört. Zum anderen wächst der Druck durch rein digitale Player wie Butternut Box oder HelloBello, die ebenfalls auf personalisiertes Frischfutter setzen, dieses jedoch tiefgekühlt versenden.

Genau hier besetzt Tasty Petfood eine strategische Lücke: Start-ups fungieren in diesem Sektor aktuell als wesentliche Innovationstreiber, und die Berliner Gründerinnen nutzen dies für eine „Ambient Fresh“-Strategie. Mit ungekühlt haltbarem Frischfutter verbindet das Unternehmen den steigenden Wunsch nach Convenience mit der Qualität von Frische-Menüs – ein entscheidender Logistik-Vorteil gegenüber der aufwendigen Tiefkühl-Konkurrenz. „Wir sitzen genau zwischen Tiefkühltruhe und Trockenfutter. Unser Futter ist reisefähig, blockiert keinen Gefrierschrank und passt damit perfekt in den Alltag moderner Hundehalter“, sagt Nadja.

Datengetriebenes Abo-Modell

Der Bestellvorgang für den/die Endkund*in ist vollständig datengestützt aufgebaut. Zu Beginn erfassen Interessent*innen über ein Online-Quiz relevante Parameter wie Rasse, Alter und Gewicht des Tieres. Auf Grundlage dieser Daten berechnet das Unternehmen einen individuellen Futterplan, der exakt auf den Hund zugeschnitten ist. Um die Akzeptanz zu testen, erhalten Neukund*innen zunächst eine Probebox mit verschiedenen Sorten. Bei erfolgreicher Annahme geht das Modell automatisch in ein flexibles Abonnement über, bei dem sowohl die Rationsgröße als auch der Lieferrhythmus dynamisch an den tatsächlichen Bedarf des Hundes angepasst werden. „Viele Halter sind unsicher, ob sie ihren Hund wirklich bedarfsgerecht füttern. Unser Algorithmus nimmt ihnen diese Entscheidung ab und sorgt dafür, dass Menge und Nährstoffe langfristig passen“, so Lisa.

Positionierung im Premium-Segment

Das Produktportfolio umfasst zum Start sechs Sorten auf Monoprotein-Basis. Durch den hohen Fleischanteil und den Verzicht auf Füllstoffe oder Konservierungsmittel zielt das Start-up auf die „Human Grade“-Nische ab. Das Produkt ist dabei so designt, dass es optisch und qualitativ an selbstgekochtes Futter erinnert, um die Hürde für qualitätsbewusste Käufer*innen zu senken. Das Kalkül: Die Zielgruppe sucht die Qualität einer BARF-Ernährung, benötigt aber die Convenience eines Fertigprodukts. „Unser Ziel ist es, Pet Nutrition durch sichtbare Qualität und Transparenz neu zu definieren“, so Nadja über den Anspruch, moderne Halterbedürfnisse mit dem Produkt-Design zu adressieren.

Diese Artikel könnten Sie auch interessieren:

Comeback in der Energiebranche: Ex-Yello-Chef Peter Vest fordert mit neuem Modell den Strommarkt heraus

Mit STARQstrom ist zum Jahresanfang ein neuer Player in den Energiemarkt eingetreten. Das Hamburger Start-up setzt auf ein prominentes Gründer-Duo und ein Modell, das den klassischen Börsenhandel umgehen will. Der Fokus liegt dabei nicht nur auf dem Preis, sondern auf den wachsenden ESG-Nachweispflichten des Mittelstands.

In der deutschen Energielandschaft meldet sich ein bekanntes Gesicht zurück: Dr. Peter Vest, der ehemalige Geschäftsführer von Yello Strom, hat gemeinsam mit Fabio Griemens zum 1. Januar 2026 den neuen Energieversorger STARQstrom gelauncht. Während Vest die Branchenerfahrung aus der Konzernwelt mitbringt, kommt Co-Gründer Griemens aus der Tech- und Skalierungsecke, mit Stationen im Management von LinkedIn und FREENOW.

Das Duo tritt an, um die Wertschöpfungskette der Stromversorgung zu straffen. Das Kernversprechen des neuen Anbieters liegt in der sogenannten „Direktvermarktung“. Anstatt den erzeugten Strom über die Strombörse zu handeln – wo er oft anonymisiert und wieder zurückgekauft wird –, setzt das Startup auf eine direkte Verzahnung von Erzeugung und Belieferung.

Umgehung der „Doppelschleife“

Das Geschäftsmodell zielt darauf ab, Handelsstufen zu eliminieren. Laut Peter Vest vermeidet das Unternehmen die übliche „Doppelschleife“ über die Börse, bei der Energie zunächst vermarktet und später für die Belieferung wieder beschafft wird. Stattdessen nutzt STARQstrom Energie aus eigenen PV- und Windparks sowie den direkten Einkauf, um sie ohne Umwege an die Endkunden zu bringen.

Diese Strategie soll vor allem Preistransparenz schaffen und die Volatilität abfedern. Im ersten Betriebsmonat nach dem Start im Januar 2026 konnte das Unternehmen nach eigenen Angaben bereits rund drei Millionen Kilowattstunden (kWh) Grünstrom absetzen.

ESG-Pflichten als Wachstumstreiber

Obwohl das Angebot auch Privatkunden offensteht, visiert das Startup strategisch vor allem den energieintensiven Mittelstand an. Hier identifizieren die Gründer ein drängendes Problem jenseits der reinen Kosten: die bürokratischen Anforderungen der Energiewende.

Unternehmen stehen zunehmend unter Druck, im Rahmen von ESG-Berichtspflichten (Environment, Social, Governance) und Audits die Herkunft ihrer Energie lückenlos nachzuweisen. „Wer heute Strom einkauft, schaut nicht nur auf den Preis, sondern genauso auf Herkunft und Nachweislogik“, erklärt Mitgründer Fabio Griemens die Marktlücke. Da der Strom aus definierten Anlagen in Deutschland stammt und nicht als Graustrom über die Börse fließt, können Herkunftsnachweise für jede Kilowattstunde direkt bereitgestellt werden, was die Compliance-Prozesse für Firmenkunden vereinfachen soll.

Ambitionierte Skalierungsziele

Die Ziele für die Anlaufphase sind sportlich gesteckt. Für das laufende Geschäftsjahr 2026 plant das Hamburger Unternehmen mit einem Volumen von rund 500 GWh im eigenen Bilanzkreis. Gedeckt wird dieser Bedarf durch einen Mix aus PV- und Onshore-Windanlagen, wobei bei Spitzenlasten ergänzend auf Börsenbeschaffung zurückgegriffen werden kann.

Mittelfristig zielt das Gründer-Duo auf den Massenmarkt: Bis Ende 2027 soll rechnerisch eine Menge an Erneuerbarer Energie bereitgestellt werden, die der Versorgung von einer Million Haushalte entspricht. Ob das Modell der direkten Vermarktung angesichts des volatilen Erzeugungsprofils erneuerbarer Energien auch bei dieser Skalierung die versprochene Planungssicherheit halten kann, wird die Marktentwicklung in den kommenden zwei Jahren zeigen.

Dr. Peter Vest und Fabio Griemens werden ihr Konzept dem Fachpublikum erstmals auf der E-World im Februar vorstellen.

Highspeed-Pivot: Wie POLARIS die Bundeswehr für sich gewann

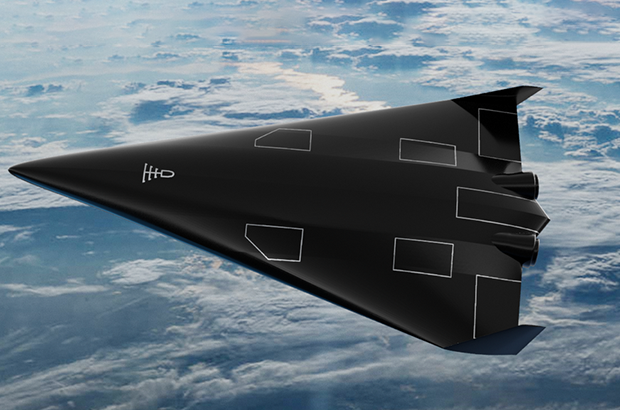

Ein Bremer NewSpace-Start-up baut für die Bundeswehr das Raumflugzeug der Zukunft. Mit seinem revolutionären Antrieb sticht POLARIS dabei sogar die US-Konkurrenz aus und fungiert zugleich als Eisbrecher für die deutsche DeepTech-Szene.

Wenn Alexander Kopp über die Ostsee blickt, sieht er nicht nur Wasser, sondern die Zukunft der europäischen Souveränität. Während in Berlin oft über die Trägheit der Beschaffungswesen geklagt wird, lässt der Gründer von POLARIS Raumflugzeuge Fakten sprechen – oder besser gesagt: Triebwerke heulen.

Das DLR-Spin-off schafft gerade, woran Konzerne seit Jahrzehnten scheitern: Ein Raumflugzeug zu bauen, das wie ein normaler Airliner startet, aber die Leistung einer Rakete besitzt. Und noch etwas ist ungewöhnlich in der deutschen Start-up-Landschaft: Der erste große Kunde, der die Bremer „Tüftler“ finanziert, ist kein Risikokapitalgeber aus dem Silicon Valley, sondern das Beschaffungsamt der Bundeswehr.

Der Traum vom Aerospike

Was das Team um den ehemaligen DLR-Ingenieur Kopp antreibt, ist der Abschied von der teuren Einweg-Mentalität der Raumfahrt. Seine Strategie ist eine radikale Flucht nach vorn: „Wenn wir im Wettbewerb bestehen wollen, uns vielleicht sogar an die Spitze setzen wollen, müssen wir die Raketen überspringen“, erklärte Kopp gegenüber dem Magazin 1E9. „Wir müssen direkt neue, bessere Konzepte umsetzen. Keine Raketen, sondern Raumflugzeuge.“

Der technologische Schlüssel, um diese Vision Realität werden zu lassen, ist das sogenannte Linear Aerospike-Triebwerk. Es gilt als der „Heilige Gral“ der Raketentechnik, an dem sich schon die NASA in den 90er Jahren die Zähne ausbiss. Das Problem herkömmlicher Raketendüsen ist ihre Glockenform – sie sind physikalisch bedingt entweder nur am Boden oder im All effizient, nie beides gleichzeitig.

Das Aerospike-Triebwerk hingegen ist ein technologisches Chamäleon: Durch seine offene, stachelförmige Bauweise passt sich der Abgasstrahl automatisch dem Luftdruck an. Es arbeitet auf dem Rollfeld genauso effizient wie im Vakuum. Dass das nicht nur graue Theorie ist, bewies Polaris im Oktober 2024: Mit dem Demonstrator „MIRA II“ gelang dem Start-up über der Ostsee die weltweit erste Zündung eines solchen Triebwerks im Flug.

Bootstrapping in Feldgrau

Diese Mischung aus „Rapid Prototyping“ – also dem schnellen Bauen, Testen und Verbessern – und technologischer Exzellenz kam genau zur richtigen Zeit für die Strategen der Bundeswehr. Berührungsängste mit dem Uniformträger hat der Gründer dabei nicht, im Gegenteil. „Wenn man sich die Historie der Raumfahrt anschaut, kamen die Durchbrüche meist direkt oder indirekt durch das Militär“, ordnete Kopp die Zusammenarbeit im Business Insider pragmatisch ein.

Denn beim Militär treibt man das Thema „Responsive Space“ voran. Das Szenario ist so simpel wie bedrohlich: Im Konfliktfall werden eigene Aufklärungssatelliten zerstört oder geblendet. Mit dem System von POLARIS, dessen finales Modell „Aurora“ ab 2026 produziert werden soll, könnte Deutschland binnen 24 Stunden Ersatz-Satelliten in den Orbit schießen. Und zwar von jedem normalen Flughafen aus, ohne auf verwundbare Startrampen angewiesen zu sein. Für POLARIS wurde das Militär so vom reinen Geldgeber zum strategischen Anker-Kunden, der dem Start-up den nötigen „Runway“ verschafft – finanziell wie physisch.

Ein Eisbrecher für die deutsche DeepTech-Szene

POLARIS operiert dabei längst nicht mehr im luftleeren Raum. Der Erfolg der Bremer sendet ein Signal in den Markt, das weit über das eigene Unternehmen hinausstrahlt: Der Staat ist bereit, in junge High-Tech-Firmen zu investieren, wenn die Technologie „Dual-Use“ ist, also zivil und militärisch genutzt werden kann.

Davon profitieren Start-ups wie das Münchner Unternehmen OroraTech, deren Waldbrand-Satelliten im Ernstfall schnell ersetzt werden müssten – eine perfekte Fracht für Polaris. Auch im Bereich der Datenverarbeitung entstehen Synergien: Wenn ein Hyperschall-Flieger Terabytes an Aufklärungsdaten sammelt, braucht es KI-Lösungen von Firmen wie dem Defense-Einhorn Helsing, um diese Informationen in Echtzeit auszuwerten. POLARIS wirkt hier wie ein Eisbrecher, der validiert, dass „Made in Germany“ auch im neuen „Space Race“ eine Währung ist.

Denn die Konkurrenz schläft nicht. In den USA pumpen das Pentagon und die Air Force Millionen in Wettbewerber wie Hermeus oder Stratolaunch, und China arbeitet mit Hochdruck am Projekt „Tengyun“. Doch während im Silicon Valley oft noch an Simulationen gefeilt wird, haben die Bremer mit ihrem fliegenden Aerospike-Triebwerk einen Vorsprung, der sich mit Geld allein schwer aufholen lässt. Aus der visionären Idee in einem Bremer Büro ist ein Projekt von nationaler Tragweite geworden. Wenn Alexander Kopps Plan aufgeht, schauen die Amerikaner beim nächsten Wettlauf ins All nicht nach oben, sondern in den Rückspiegel.

Globaler Wettbewerb: Polaris vs. US-Konkurrenz

Merkmal | Polaris Raumflugzeuge (Deutschland) | Hermeus (USA) | Stratolaunch (USA) |

Haupt-Fahrzeug | Aurora (in Entwicklung) | Quarterhorse (Demo) / Darkhorse | Talon-A |

Start-Methode | Horizontal (Startbahn) | Horizontal (Startbahn) | Air-Launch (Abwurf vom Trägerflugzeug „Roc“) |

Antrieb | Linear Aerospike (Rakete) + Turbinen | TBCC (Turbine + Ramjet) | Flüssig-Raketentriebwerk (Konventionell) |

Haupt-Mission | Multimission: Satellitenstart (Orbit) + Hyperschall-Test/Aufklärung | Transport: Passagier/Fracht (Point-to-Point) + Militär | Testbed: Zielsimulation & Testplattform für US-Militär |

Wiederverwendbar? | Ja (System landet wie Flugzeug) | Ja | Ja (landet gleitend auf Landebahn) |

Aktueller Status | Fliegend: Skalierte Demonstratoren (MIRA) erfolgreich getestet. | Boden-Tests: Triebwerkstests erfolgreich, Rolltests ("Taxiing"). | Operativ: Talon-A hat bereits motorisierte Hyperschallflüge absolviert. |

Finanzierung | Bundeswehr (BAAINBw) & Private Investoren | US Air Force, Pentagon (DIU) & Venture Capital | Private Equity (Cerberus Capital Management) |

Die Wächter des Firmengedächtnisses

Wie das 2025 von Christian Kirsch und Stefan Kirsch gegründete Start-up amaiko den Strukturwandel im Mittelstand adressiert.

Der demografische Wandel und eine erhöhte Personalfluktuation stellen mittelständische Unternehmen zunehmend vor die Herausforderung, internes Know-how zu bewahren. Viele Unternehmen stehen vor der Schwierigkeit, dass Firmenwissen fragmentiert vorliegt. Informationen sind häufig in unterschiedlichen Systemen oder ausschließlich in den Köpfen der Mitarbeitenden gespeichert. Verlassen langjährige Fachkräfte den Betrieb in den Ruhestand oder wechseln jüngere Arbeitnehmerinnen und Arbeitnehmer kurzfristig die Stelle, gehen diese Informationen oft verloren. Zudem bindet die Suche nach relevanten Dokumenten in verwaisten Ordnerstrukturen Arbeitszeit, die in operativen Prozessen fehlt.

Das 2025 gegründete Start-up amaiko aus Niederbayern setzt hierbei auf einen technischen Ansatz, der auf die Einführung neuer Plattformen verzichtet und stattdessen eine KI-Lösung direkt in die bestehende Infrastruktur von Microsoft Teams integriert. Vor diesem Hintergrund entwickelten die Brüder Christian und Stefan Kirsch mit amaiko eine Softwarelösung, die spezifisch auf die Ressourcenstruktur mittelständischer Betriebe ausgelegt ist.

Integration statt neuer Insellösungen – und die Abgrenzung zu Copilot

Ein wesentliches Merkmal des Ansatzes ist die Entscheidung gegen eine separate Software-Plattform. Christian Kirsch, Geschäftsführer von PASSION4IT und amaiko, positioniert die Lösung als „Teams-native“. Das bedeutet, dass der KI-Assistent technisch in Microsoft Teams eingebettet wird – jene Umgebung, die in vielen Büros bereits als primäres Kommunikationswerkzeug dient. Ziel ist es, die Hürden bei der Implementierung zu senken, da Nutzer ihre gewohnte Arbeitsumgebung nicht verlassen müssen.

Angesichts der Tatsache, dass Microsoft mit dem „Microsoft 365 Copilot“ derzeit eine eigene, tief integrierte KI-Lösung ausrollt, stellt sich die Frage nach der Positionierung. Christian Kirsch sieht hier jedoch keine direkte Konkurrenzsituation, sondern eine klare Differenzierung: Copilot sei eine sehr breite, Microsoft-zentrische KI-Funktion. Amaiko hingegen verstehe sich als spezialisierter, mittelstandsorientierter Wissensassistent, der Beziehungen, Rollen, Prozesse und Unternehmenslogik tiefgreifend abbildet.

Ein entscheidender Vorteil liegt laut Kirsch zudem in der Offenheit des Systems: „Während Copilot naturgemäß an Microsoft‑Systeme gebunden ist, lässt sich amaiko herstellerunabhängig in eine viel breitere Softwarelandschaft integrieren – vom ERP über CRM bis zu Branchenlösungen. Unser Ziel ist nicht, Copilot zu kopieren, sondern reale Mittelstandsprozesse nutzbar zu machen“, so der Co-Founder.

Funktionsweise, Sicherheit und Haftung

Funktional unterscheidet sich das System von herkömmlichen Suchmasken durch eine agentenähnliche Logik. Die Software bündelt Wissen aus internen Quellen wie Richtlinien oder Projektdokumentationen und stellt diese kontextbezogen zur Verfügung. Ein Fokus liegt dabei auf der Datensouveränität. Hierbei betont Christian Kirsch, dass Kundendaten nicht in öffentlichen Modellen verarbeitet werden: „Die Modelle laufen in der europäischen Azure AI Foundry, unsere eigenen Dienste auf deutschen Servern. Die Daten des Kunden bleiben on rest vollständig im jeweiligen Microsoft‑365‑Tenant. Es findet kein Training der Foundation Models mit Kundendaten statt – weder bei Microsoft noch bei uns. Grundlage dafür sind die Azure OpenAI Non‑Training Guarantees, die Microsoft in den Product Terms sowie in SOC‑2/SOC‑3‑ und ISO‑27001‑Reports dokumentiert.“

Auch rechtlich zieht das Start-up eine klare Grenze, sollte die KI einmal fehlerhafte Informationen, sogenannte Halluzinationen, liefern. „Amaiko generiert Vorschläge, keine rechts‑ oder sicherheitsverbindlichen Anweisungen. Das stellen wir in unseren AGB klar: Die Entscheidungshoheit bleibt beim Unternehmen. Wir haften für den sicheren Betrieb der Plattform, nicht für kundenseitig freigegebene Inhalte oder daraus abgeleitete Maßnahmen. Es geht um eine saubere Abgrenzung – technische Verantwortung bei uns, inhaltliche Verantwortung beim Unternehmen“, so Christian Kirsch.

Geschäftsmodell und Markteintritt

Seit der Vorstellung der Version amaiko.ai im Juli 2025 wird das System nach Angaben des Unternehmens mittlerweile von über 200 Anwendern genutzt. Durch die Integration in die bestehende Microsoft-365-Landschaft entfällt für mittelständische Kunden eine aufwendige Systemmigration, was die technische Eintrittsbarriere gering hält.

Passend zu diesem Ansatz ist amaiko als reines SaaS-Produkt konzipiert, das Unternehmen ohne Einstiegshürde direkt online buchen können. Laut Kirsch sind keine Vorprojekte, individuellen Integrationspfade oder teuren Beratungspflichten notwendig: „Die Nutzung ist selbsterklärend und leichtgewichtig. Wer zusätzlich Unterstützung möchte – etwa zur Wissensstrukturierung oder Governance – kann sie bekommen. Aber die technische Einführung selbst ist bewusst so gestaltet, dass Mittelständler ohne Implementierungsaufwand starten können.“

Unterm Strich liefert amaiko damit eine pragmatische Antwort auf den drohenden Wissensverlust durch den demografischen Wandel: Statt auf komplexe IT-Großprojekte zu setzen, holt das bayerische Start-up die Mitarbeitenden dort ab, wo sie ohnehin kommunizieren. Ob sich die „Teams-native“-Strategie langfristig gegen die Feature-Macht von Microsoft behauptet, bleibt abzuwarten – doch mit dem Fokus auf Datensouveränität und mittelständische Prozesslogik hat amaiko gewichtige Argumente auf seiner Seite, um sich als spezialisierter Wächter des Firmengedächtnisses zu etablieren.

Der industrielle Wasserkocher: Wie das Start-up SYPOX die Chemie grün färbt

Die chemische Industrie hat ein massives Emissionsproblem, denn ihre Prozesse verschlingen Unmengen an Erdgas. Das 2021 geründete Start-up SYPOX, ein Spin-off der TUM will das ändern – mit einer Technologie, die so simpel wie genial klingt: Ein riesiger, elektrischer Tauchsieder soll die fossile Verbrennung ersetzen. Nun meldet das junge Unternehmen den ersten Durchbruch auf dem Weltmarkt.

Wenn Dr. Martin Baumgärtl erklären will, wie er die chemische Industrie revolutionieren möchte, wählt er ein Bild, das jeder versteht: „Im Grunde ist es wie ein Wasserkocher in der heimischen Küche – nur im industriellen Maßstab.“ Baumgärtl ist CTO von SYPOX, und was er beschreibt, könnte einer der wichtigsten Hebel für die Dekarbonisierung einer der schmutzigsten Branchen der Welt sein.

Die chemische Industrie ist süchtig nach Energie. Um Basischemikalien wie Methanol oder Ammoniak herzustellen, wird sogenanntes Synthesegas benötigt – eine Mischung aus Wasserstoff und Kohlenmonoxid. Die Herstellung geschieht in gewaltigen Hochtemperaturprozessen. Bisher wird die dafür nötige Hitze fast ausschließlich durch das Verbrennen von Erdgas oder Öl erzeugt. Die Folge: Gigantische CO₂-Emissionen.

Strom statt Flamme

Genau hier setzt SYPOX an. Das 2021 in Freising gegründete Unternehmen ersetzt die offenen Gasflammen durch elektrischen Strom. In ihren Reaktoren, die von außen wie gewöhnliche Druckbehälter aussehen, stecken hochkomplexe elektrische Heizelemente, die direkt hinter den Katalysatoren platziert sind.

Der Effekt ist enorm: „In konventionellen Verfahren entfallen rund 40 Prozent der Emissionen allein auf die Wärmeerzeugung aus fossilen Energieträgern“, rechnet Baumgärtl vor. Durch die Elektrifizierung des Reaktors fallen diese Emissionen weg – vorausgesetzt, der Strom kommt aus erneuerbaren Quellen. Zudem lässt sich der Prozess laut den Gründern präziser und sicherer steuern.

Der Anti-Trend im Silicon Valley

Doch nicht nur technologisch, auch ökonomisch schwimmt SYPOX gegen den Strom. In der Tech-Szene ist es üblich, dass Start-ups jahrelang Verluste schreiben und sich von einer Venture-Capital-Runde zur nächsten hangeln, getrieben von Investoren, die schnelles Wachstum fordern.

Die bayerischen Gründer wählten einen konservativeren, fast schon mittelständischen Ansatz. „Es entsprach nicht unserem Stil, Geld einzuwerben – wir haben vielmehr von Anfang an versucht, auf Basis unserer Technologie ein tragfähiges Geschäft aufzubauen“, erklärt CEO Dr. Gianluca Pauletto. Man wolle bodenständig bleiben und sich aus Umsätzen finanzieren, statt sich in Abhängigkeiten zu begeben.

Vom Container im Altmühltal zum Großkunden

Die Wurzeln des Unternehmens liegen an der Technischen Universität München (TUM). Die Idee brachte Pauletto aus seiner Zeit in Montréal mit, an der TUM fand er in Prof. Johannes Lercher und dem damaligen Doktoranden Martin Baumgärtl die wissenschaftlichen Mitstreiter.

Der Weg zum marktreifen Produkt war – typisch für „Deep Tech“ – langwierig. „Vier Jahre Forschung und zahlreiche Versuchsreihen waren notwendig“, erinnert sich Lercher. Während andere Software im Co-Working-Space programmierten, baute das SYPOX-Team eine Pilotanlage in einem einfachen Stahlcontainer auf dem Gelände einer Biogasanlage im ländlichen Dollnstein (Altmühltal).

Diese Beharrlichkeit zahlt sich nun aus. Das Start-up hat, unterstützt durch den Spezialchemie-Konzern Clariant, seinen ersten Großkunden an Land gezogen. Ab 2026 soll eine erste industrielle Anlage in Betrieb gehen, die täglich 150 Tonnen Synthesegas produziert. „Das ist nicht nur ein Meilenstein für uns, sondern auch ein starkes Signal an die gesamte chemische Industrie“, so Baumgärtl.

Für das Team, das inzwischen in Langenbach bei Freising sitzt und weiterhin Labore auf dem Forschungscampus Garching betreibt, ist das der Beweis: Die Elektrifizierung der Chemie ist keine Zukunftsmusik mehr, sie beginnt jetzt.

Optocycle: Bauschutt-Recycling auf KI-Basis

Die Optocycle-Gründer Max-Frederick Gerken und Lars Wolff Optocycle zeigen, wie aus Bauschutt neuer Rohstoff wird und erhalten dafür eine Förderung der Deutschen Bundesstiftung Umwelt (DBU).

Jährlich fallen in Deutschland laut Umweltbundesamt rund 86 Mio. Tonnen Schutt und Abfälle auf Baustellen an. Häufig landen diese Materialien auf Deponien. So gehen allerdings wertvolle Ressourcen verloren. Der Ausweg: Ein hochqualitatives Recycling des Schutts vermeidet klimaschädliche Emissionen und hält wertvolle Materialien im Wertstoffkreislauf – und das bei zertifiziert gleichwertiger Qualität.

Um das Recycling von Material im Bausektor zu automatisieren, entwickelt das 2022 von Max-Frederick Gerken und Lars Wolff gegründete Start-up Optocycle aus Tübingen ein System auf Grundlage künstlicher Intelligenz (KI) zum Echtzeit-Monitoring.

Echtzeit-Monitoring im Recycling-Prozess

Die Deutsche Bundesstiftung Umwelt (DBU) fördert das Projekt mit rund 170.000 Euro. Im Rahmen der DBU-Green Startup-Förderung haben die Gründer ein KI-basiertes System zur automatischen, reproduzierbaren Klassifizierung von Bauabfällen entwickelt. Darauf aufbauend soll nun ein Prototyp das Echtzeit-Monitoring von RC-Körnungen – also recycelten Gesteinskörnungen aus Bauschutt – ermöglichen.

„Aktuell basiert in der Branche der Aufbereitungsprozess von Bauschutt meist auf subjektiven Schätzungen“, so Max-Frederick Gerken. Auch das Endprodukt werde nur stichprobenartig im Labor überprüft. Mit dem System sei „Echtzeitmonitoring von Recycling-Gesteinskörnungen möglich. Somit können die Qualität der Körnung verbessert und mehr Material in die Beton-Produktion überführt werden“, so Gerken.

Die Qualität von Sekundärrohstoffen verbessern

Das System kombiniert laut Gerken moderne, optische Sensorik mit KI – und löse so ein altbekanntes Problem in der Baubranche. „Zurzeit schwankt oft die Beschaffenheit der recycelten Rohstoffe. Das bedeutet einerseits ein wirtschaftliches Risiko für Unternehmen und führt andererseits zum Verlust von wertvollen Materialien“, so Gerken. Optocycle erwartet mithilfe seiner Entwicklung eine 20 Prozent höhere Menge an recycelten, hochqualitativen Gesteinskörnungen sowie 15 Prozent geringere Abfallreste, die sonst auf Deponien landen würden. Dazu werden nach Gerkens Angaben sowohl der eingehende Schutt „optimal klassifiziert“ als auch das Ergebnis transparent überprüft. Kooperationspartner ist hierbei die Heinrich Feeß GmbH, die laut Gerken bereits seit vielen Jahren mit Optocycle zusammenarbeitet. Der Mitgründer weiter: „Die Technologie leistet einen Beitrag für Kreislaufwirtschaft im Bauwesen. Wir helfen dabei, die Qualität von Sekundärrohstoffen zu verbessern, die aus dem Bauschutt gewonnen werden. Diese Lösung lässt sich zudem perspektivisch auf alle Abfallströme übertragen."

Das System von Optocycle kann Gerken zufolge direkt in bereits bestehende Anlagen zur Verarbeitung von Bauabfällen installiert werden – „direkt über dem Fließband.“ Diese einfache Nachrüstung spare Kosten und ermögliche die schnelle Umsetzung eines innovativen Bauschutt-Recyclings. „Denn nur wenn das Recycling finanziell machbar ist, kann die Kreislaufwirtschaft in der Baubranche Erfolg haben“, so Gerken.

Kreislaufwirtschaft in der Baubranche ist aktiver Klimaschutz

Kreislaufwirtschaft in der Baubranche hat nach den Worten des zuständigen DBU-Referenten Dr. Volker Berding wichtige Effekte für den Klimaschutz: „Die Produktion von immer neuem Beton sorgt für hohen Ausstoß von klimaschädlichen Treibhausgasen.“ Einer WWF-Studie zufolge entstehen bei der Herstellung von Zement – dem wichtigsten Bestandteil von Beton – acht Prozent der gesamten globalen Treibhausgasemissionen. Berding: „Alles, was zur einer Emissionsreduzierung beiträgt, hat also bereits einen großen Effekt für den Klimaschutz.“ Eine Kreislaufwirtschaft funktioniere jedoch nur, „wenn die Sekundärrohstoffe sich qualitativ nicht von einer Neuproduktion unterscheiden. Genau diesen Schritt kann Optocycle mit einem skalierbaren, optimierten Prototypen gehen.“

reltix: Vom Aktenordner zum Algorithmus

Wie das 2025 von Andreas Plakinger, Jan Horstmann und Léon Bamesreiter gegründete Düsseldorfer PropTech-Start-up reltix das angestaubte Image einer Branche poliert.

Hausverwaltungen gelten nicht gerade als Sprintdisziplin. Schwer erreichbare Ansprechpartner, Papierberge und zähe Abläufe prägen das Image einer Branche, in der es an Nachwuchs fehlt und Fristen dennoch gnadenlos ticken. Genau da setzt reltix an und wächst: Im März 2025 gegründet, zählt das Düsseldorfer Start-up inzwischen 2000 Kund*innen.

Gegründet wurde reltix von drei ehemaligen Kommilitonen, die sich an der WHU Otto Beisheim School of Management in Vallendar bei Koblenz kennenlernten: Léon Bamesreiter, Jan Horstmann und Andreas Plakinger. Der Motor für die Gründung war eine große Portion eigener Unzufriedenheit. Bamesreiter kaufte mit 20 Jahren während seines dualen Studiums bei einer Großbank seine erste Wohnung, weitere folgten. Seine Erfahrung mit den Verwaltungen: dicke Ordner, langsame Reaktionen, wenig Transparenz. „Ich hatte das Gefühl, ich werde selbst zum Hausverwalter.“

Weniger Bürokratie und mehr Präsenz am Objekt

Mit dem Gründungsstipendium starteten die Drei eine Umfrage unter über 120 Eigentümer*innen: 87 Prozent gaben an, mit ihrer Verwaltung unzufrieden zu sein. Reltix will diese Unzufriedenheit nicht mit mehr Personal, sondern mit Digitalisierung im Hintergrund beheben. Herzstück ist eine selbst entwickelte Software, die E-Mails und WhatsApp-Nachrichten erfasst, automatisch Tickets anlegt, digitale Unterlagen ausliest und Vorgängen zuordnet. Handwerkeranfragen werden systemgestützt angestoßen, Daten zentral strukturiert. Gleichzeitig setzen die Düsseldorfer auf eine feste Ansprechperson je Immobilie.

Erklärtes Ziel der Gründer: weniger Bürokratie und mehr Präsenz am Objekt. Für diesen Ansatz erhielt das Team gerade eine Zusage zur Forschungszulage des Bundesministeriums für Forschung, Technologie, und Raumfahrt zum weiteren Ausbau der eigenen Software mit einer Projektsumme von 1,3 Millionen Euro.

Jahresendspurt brachte Mandate ...

Den größten Schub spürte reltix im Dezember 2025. Viele Hausverwaltungsverträge enden zum 31. Dezember, gleichzeitig laufen Abrechnungsfristen aus. Wer bis Jahresende keine neue Verwaltung findet, bekommt schnell kalte Füße. In den letzten Wochen des Jahres kamen deshalb laut Unternehmen 500 Mandate kurzfristig hinzu, darunter Neubauprojekte in Langenfeld und Köln. Einige namhafte Banken, Family Offices und größere private Bestandshalter zählt das Unternehmen ebenso zu seinen Kund*innen.

... und Personalaufbau

Das Start-up musste personell nachziehen und stockt zum Februar von 14 auf 17 Mitarbeitende auf. Während viele klassische Verwaltungen über fehlenden Nachwuchs klagen, setzt reltix auf junge Mitarbeitende, Quereinsteiger*innen und bildet selbst aus. Das Unternehmen ist IHK Ausbildungsbetrieb und beschäftigt eine Auszubildende im ersten Lehrjahr. Die 28-Jährige, aus der Ukraine geflüchtet, ist aktuell die älteste im Team. Dazu kommen Quereinsteiger*innen: Ein früherer Maschinenbauingenieur leitet inzwischen die Mietverwaltung, eine Mitarbeiterin aus dem Bankgeschäft arbeitet in der Buchhaltung.

Von Rhein-Ruhr bis an den Main

Neben der Verwaltung großer Objekte bietet das Düsseldorfer PropTech für kleinere Eigentümer*innengemeinschaften mit drei bis acht Einheiten die sogenannte Kompaktverwaltung. Enthalten ist darin eine rechtssichere Abrechnung, die Durchführung von Eigentümer*innenversammlungen sowie größere Sanierungen, während Alltägliches bei den Eigentümer*innen bleibt. Regional liegt der Fokus auf Rhein-Ruhr sowie dem Umfeld Köln Bonn. Frankfurt mit einem weiteren Standort ist als nächster Schritt Richtung Sommer geplant. Düsseldorf soll Hauptsitz bleiben.

Infinite Roots: Hamburger BioTech bringt pilzbasierte Gerichte ins Kühlregal

Das 2018 von Dr. Mazen Rizk, Anne-Cathrine Hutz und Dr. Thibault Godard als Mushlabs gegründete Hamburger Start-up Infinite Roots (ehemals Mushlabs) bringt die Vorteile der Pilzwelt erstmals als eigenständige Hauptzutat ins Kühlregal.

Infinite Roots ist ein forschungsgetriebenes BioTech-Unternehmen aus Hamburg. Seit 2018 entwickelt das Unternehmen (zunächst unter dem Namen Mushlab) neuartige Lebensmittel auf Basis von Pilzen – inspiriert vom Myzel, dem unterirdischen Wurzelgeflecht essbarer Pilze. Durch Fermentation schafft Infinite Roots Produkte, die über bloße Fleischalternativen hinausgehen. Das Ziel ist es, eine neue Kategorie zu etablieren: Lebensmittel, die echtes Umami und wertvolle Nährstoffe liefern, mit kurzen Zutatenlisten auskommen und die Umwelt entlasten.

Mit mehr als 60 Expert*innen aus Biotechnologie, Data, Lebensmittelwissenschaft und Kulinarik will das Team neue Standards für Geschmack, Qualität und Nachhaltigkeit setzen und zeigen, dass die Ernährung der Zukunft nicht Verzicht bedeutet, sondern Vielfalt und Genuss.

Die MushRoots-Produkte des Unternehmens sind keine Fleischimitate, sondern bieten ein eigenständiges, pilzbasiertes Geschmackserlebnis. Sie zeichnen sich durch einen saftigen, herzhaften Biss und ausgeprägte Umami-Noten aus. Die Hamburger setzen dabei auf Speisepilze, kombiniert mit vertrauten, hochwertigen Zutaten. Entsprechend bauen die Produkte auf einer natürlichen Zutatenliste auf und verzichten auf künstliche Aromen, Geschmacksverstärker und Farbstoffe. So entsteht ein Geschmackserlebnis, das an herzhafte Hausmannskost erinnert. Die Produkte lassen sich vielseitig im Alltag, etwa als Hack, Bällchen oder Patties.

„Im Kühlregal sehen Konsument*innen seit Jahren dieselbe Logik: Tierprotein hier, Pflanzenprotein dort“, sagt Philip Tigges, CCO/CFO von Infinite Roots. „Mit MushRoots bringen wir nicht nur eine dritte Option ins Regal, sondern kehren auch zu Lebensmitteln mit einer natürlichen Hauptzutat zurück. Pilze bieten einen herzhaften Geschmack, sind vielseitig, in allen gewohnten Rezepten einsetzbar und können kinderleicht zubereitet werden.“

MushRoots setzt dabei auf eine Proteinquelle mit vergleichsweise geringem ökologischen Fußabdruck. Pilze lassen sich lokal und ressourcenschonend kultivieren. „Wir wollten nie ein weiteres Fleischimitat herstellen, sondern eine eigene Kategorie umami-reicher Pilzprodukte schaffen, die durch Charakter und Geschmack überzeugen“, ergänzt Tigges. „Unser Ziel ist es jetzt, Menschen für Pilzprodukte zu gewinnen, ohne dass sie Fleisch vermissen.“

Jetzt meldet Infinite Roots, dass vier MushRoots-Produkte ab sofort bei REWE Nord in Norddeutschland und Billa Plus in Österreich erhältlich sind und damit eine neue Kategorie an Pilz-Produkten in die Kühlregale Einzug gehalten haben.

KI-Trends 2026: Reifer, realer, relevanter

2026 tritt KI in eine neue Phase ein: weniger Hype, mehr Haltung. Expert*innen aus Technologie, Kommunikation und Mittelstand zeigen, wie künstliche Intelligenz Prozesse transformiert, Entscheidungen präziser macht und Marken stärkt – aber auch neue Risiken schafft, von Voice-Cloning bis Abhängigkeiten großer Plattformen. Klar wird: KI entfaltet ihr Potenzial dort, wo Unternehmen sie verantwortungsvoll einsetzen, Transparenz schaffen und menschliche Kompetenz stärken.

Zwischen Dynamik und Verantwortung: KI braucht gemeinsame Sichtweisen

„KI schafft keine perfekten Lösungen auf Knopfdruck, sondern eröffnet neue Wege, Herausforderungen besser zu bewältigen. Die größten Chancen liegen darin, Wissensverlust zu vermeiden, Reibungsverluste zu reduzieren und individueller auf Menschen einzugehen – im Gesundheitswesen genauso wie in HR, Bildung und Produktion. Gleichzeitig besteht die größte Herausforderung darin, eine gemeinsame Sichtweise auf KI zu entwickeln: Alle reden darüber, aber oft über völlig Unterschiedliches. Das gelingt nur über kleine Schritte, viel Kommunikation und eine Annäherung auf Augenhöhe. Zugleich zeichnet sich ein klarer Trend ab: die Fragmentarisierung der KI-Landschaft und eine problematische Abhängigkeit von US-Anbietern, die neue, eigene Handlungswege erfordert. Wer diese Dynamik versteht und verantwortungsvoll gestaltet, erschließt das Potenzial von KI von automatisierten medizinischen Leistungen über effizientere Produktionsprozesse bis hin zu deutlich schnelleren Innovationszyklen.“

KI-Modelle erfolgreich im Unternehmen einführen

Worauf es bei der Implementierung von KI wirklich ankommt.

Künstliche Intelligenz (KI) gewinnt in Unternehmen zunehmend an Bedeutung. Sie kann Prozesse beschleunigen, große Datenmengen sinnvoll nutzbar machen und Entscheidungen unterstützen. Doch in der Praxis zeigt sich: Moderne Technologie allein führt noch nicht zum Erfolg. Entscheidend ist ein strukturiertes Vorgehen, bei dem Ziele klar definiert, Daten sorgfältig vorbereitet und organisatorische Rahmenbedingungen von Beginn an berücksichtigt werden. „Viele KI-Initiativen scheitern daran, dass am Anfang die Orientierung fehlt“, sagt Benedikt Weber, Geschäftsführer der applord GmbH. „Struktur schafft Entscheidungsfähigkeit – noch bevor über konkrete KI-Modelle gesprochen wird.“

Organisatorischer Wandel und Einbindung der Mitarbeitenden

Der Einsatz von KI verändert Arbeitsabläufe, Verantwortlichkeiten und Entscheidungswege. Mitarbeitende arbeiten verstärkt mit automatisierten Systemen zusammen, Aufgaben verschieben sich, Rollen entwickeln sich weiter. Wird dieser Wandel nicht aktiv begleitet, entstehen Unsicherheiten oder Ablehnung gegenüber neuen Technologien. Erfolgreiche Unternehmen setzen deshalb auf transparente Kommunikation und frühzeitige Einbindung der Mitarbeitenden. Sie erklären, warum KI eingesetzt wird, welche Aufgaben sie übernimmt und wo menschliche Expertise weiterhin unverzichtbar bleibt. Fehlt dieses gemeinsame Verständnis, werden neue Systeme häufig nur eingeschränkt genutzt. „KI-Projekte scheitern selten an der Technologie“, betont Weber. „Viel häufiger fehlt ein klares Bild davon, welchen konkreten Nutzen KI für Mitarbeitende und Organisation wirklich bringt.“

Auswahl der passenden KI-Lösung

Das Angebot an KI-Lösungen wächst rasant. Für Unternehmen besteht die Herausforderung darin, nicht der technischen Vielfalt zu folgen, sondern eine Lösung zu wählen, die zum eigenen Geschäftsprozess passt. Der Ausgangspunkt sollte immer ein klar definierter Anwendungsfall sein: Welche Aufgabe soll KI konkret unterstützen oder verbessern? Neben den Funktionen spielen auch Fragen der Nachvollziehbarkeit, Integration in bestehende Systeme und regulatorische Anforderungen eine Rolle. Werden diese Aspekte zu spät berücksichtigt, entstehen Lösungen, die technisch leistungsfähig sind, im Alltag aber keinen Mehrwert liefern. „Viele Unternehmen wählen KI nach dem Funktionsumfang aus und stellen später fest, dass sie nicht zum eigenen Prozess passt“, erklärt Weber. „Erfolgreich ist KI dann, wenn sie Abläufe sinnvoll ergänzt und verständliche Ergebnisse liefert.“

Datenqualität als Grundlage für verlässliche Ergebnisse

KI-Modelle sind vollständig von der Qualität ihrer Daten abhängig. In vielen Unternehmen existieren relevante Informationen zwar, sie sind jedoch über verschiedene Systeme verteilt, unterschiedlich gepflegt oder historisch gewachsen. Diese Ausgangslage erschwert nicht nur den Einsatz von KI, sondern kann zu fehlerhaften oder schwer nachvollziehbaren Ergebnissen führen. Datenmanagement ist daher keine einmalige Vorarbeit, sondern eine kontinuierliche Aufgabe. Dazu gehören klare Zuständigkeiten, regelmäßige Prüfungen und eine strukturierte Aufbereitung der Daten. „Der Aufwand für Datenqualität wird häufig unterschätzt“, sagt Weber. „Ohne geprüfte und konsistente Daten lassen sich keine stabilen und verlässlichen KI-Ergebnisse erzielen – unabhängig davon, wie gut das Modell ist.“

Schrittweise Einführung statt großer Umbruch

Statt KI sofort unternehmensweit einzusetzen, empfiehlt sich ein schrittweises Vorgehen. Unternehmen können so mit klar abgegrenzten Anwendungsfällen beginnen, Lösungen im Alltag testen und die Ergebnisse anhand messbarer Kriterien, wie Benutzerfreundlichkeit oder verständlicher Anleitungen, bewerten. So lassen sich Risiken reduzieren und Erkenntnisse gezielt nutzen. Pilotprojekte liefern nicht nur technische Erkenntnisse, sondern zeigen auch, wie gut KI im Arbeitsalltag akzeptiert wird. Auf dieser Basis lässt sich entscheiden, welche Lösungen ausgebaut werden sollten. „Unternehmen, die mit überschaubaren Anwendungsfällen starten, treffen langfristig fundiertere Entscheidungen“, so Weber. „Praxiserfahrungen sind dabei deutlich wertvoller als theoretische Annahmen.“

KI & Bewertungen: Sichtbarkeit in einer neuen Suchrealität

Tipps und To-dos: Wie du dein Bewertungsmanagement strategisch aufsetzt und Sichtbarkeit und Vertrauen im KI-Zeitalter steigerst.

Generative Antworten in Suchmaschinen und Assistenten verändern die Spielregeln der Online-Sichtbarkeit. Nicht mehr nur klassische Rankings entscheiden, sondern die Frage, wem die KI genug vertraut, um es überhaupt zu nennen. Aktuelle, glaubwürdige und inhaltlich konkrete Bewertungen werden dabei zum Schlüsselsignal. Für kleine und mittlere Unternehmen bedeutet das: Bewertungsmanagement ist kein Nice-to-have mehr, sondern ein Pflichtprogramm, das Auffindbarkeit, Auswahl und Conversion spürbar beeinflusst. Im Folgenden erfährst du, wie du dein Bewertungsmanagement strategisch aufsetzen solltest, um Sichtbarkeit und Vertrauen im KI-Zeitalter zu steigern.

Warum Bewertungen jetzt geschäftskritisch sind

KI-Modelle zerlegen Rezensionen in viele kleine Bedeutungseinheiten und ziehen daraus ein konsistentes Bild. Welche Leistung wurde erbracht, an welchem Ort, mit welcher Qualität und für welchen Anlass. Aus den einzelnen Stimmen entsteht so ein Vertrauensprofil, das über bloße Sternesummen hinausgeht. Entscheidend ist nicht die bloße Menge, sondern die Frische und die inhaltliche Dichte der Aussagen. Eine Rezension wie „Schnell geholfen am Sonntag, sehr kompetente Beratung zu Reiseimpfungen“ liefert gleich mehrere Signale. Zeitliche Verfügbarkeit, thematische Expertise und konkreter Nutzen. Genau solche Details erhöhen die Wahrscheinlichkeit, in generativen Antworten aufzutauchen, wenn Menschen in ihrer Nähe nach einer Lösung suchen. Wer regelmäßig neue, authentische und präzise Bewertungen erhält, verschafft der KI verlässliche Hinweise und sichert sich dadurch mehr Sichtbarkeit in genau den Momenten, in denen Entscheidungen vorbereitet werden.

Bewertungsmanagement als Prozess, nicht als Aktion

Wirksam wird Bewertungsarbeit, wenn sie selbstverständlich Teil der täglichen Abläufe ist. Nach dem Kontakt freundlich um Feedback bitten, den Weg zur passenden Plattform so kurz wie möglich machen, interne Zuständigkeiten klar regeln und Reaktionszeiten verbindlich festlegen. Aus diesen scheinbar kleinen Schritten entsteht ein stabiler Rhythmus, der kontinuierlich neue Kund*innenstimmen hervorbringt und der KI immer wieder frische Kontexte liefert. Ein solcher Prozess ist robuster als jede einmalige Kampagne, weil er verlässlich Vertrauen aufbaut und saisonale Schwankungen abfedert. Teams profitieren, wenn sie Zielkorridore definieren, etwa eine bestimmte Zahl neuer Rezensionen pro Woche und wenn sie Fortschritte sichtbar machen. So wird aus gutem Vorsatz ein gelebter Ablauf, der die gesamte Organisation stärkt.

Sprache der Kund*innen wirkt wie natürliches SEO

KI versteht Alltagssprache deutlich besser als Listen isolierter Schlagwörter. Unternehmen gewinnen, wenn sie um freie, aber konkrete Formulierungen bitten, ohne Vorgabetexte und ohne Druck. Eine höfliche Bitte wie: „Wenn es für Sie passt, nennen Sie gern, was Ihnen besonders geholfen hat“ öffnet den Raum für präzise Hinweise auf Leistungen, Erreichbarkeit, Barrierefreiheit oder Schnelligkeit. Solche natürlich entstandenen Details sind für Menschen überzeugend und zugleich für Maschinen gut interpretierbar. Sie zeigen, wofür ein Betrieb tatsächlich steht, und verankern die passenden Begriffe in einem echten Nutzungskontext. Das Ergebnis ist eine Sprache, die Vertrauen schafft und die Auffindbarkeit stärkt, ohne künstlich zu wirken.

Antworten trainieren Vertrauen für Menschen und Maschinen

Jede Reaktion auf eine Bewertung ist ein sichtbares Zeichen von Serviceorientierung und zugleich zusätzlicher Kontext für die KI. Gute Antworten bedanken sich aufrichtig, beziehen sich konkret auf das Erlebte und bieten einen klaren nächsten Schritt an. Bei Kritik zählt ein professioneller Umgang. Das Anliegen nachvollziehen, Verantwortung übernehmen, eine realistische Lösung anbieten und einen direkten Kontaktweg nennen. So entsteht ein Bild von Verlässlichkeit, das Hemmschwellen senkt und Wiederbesuche wahrscheinlicher macht. Die KI erkennt diesen Umgang ebenso und ordnet das Unternehmen eher als vertrauenswürdig ein. Mit der Zeit entsteht ein stabiler Kreislauf aus guter Erfahrung, konstruktiver Reaktion und wachsendem Vertrauen.

Lokaler Content und Social Proof gehören zusammen

Bewertungen entfalten ihre volle Wirkung, wenn sie auf eine solide Informationsbasis treffen. Konsistente Unternehmensdaten, vollständige Leistungsseiten pro Standort, klare Öffnungszeiten inklusive Ausnahmen und eine schnelle, mobil optimierte Webseite erleichtern die Einordnung für Nutzer*innen und Maschine. Wenn ausgewählte Zitate oder Bewertungsschnipsel an relevanten Stellen sichtbar werden, etwa auf der Startseite, in der Buchungsstrecke oder in den häufigen Fragen, entsteht ein schlüssiges Gesamtbild. Der lokale Bezug bleibt klar erkennbar, die Erwartungen sind gut gesetzt, und die nächsten Schritte sind ohne Umwege möglich. So wird aus Social Proof ein handfester Conversion Hebel.

Vom Feedback zur Verbesserungsschleife

Rezensionen sind fortlaufende Marktforschung aus erster Hand. Wer wiederkehrende Themen auswertet, etwa Wartezeiten, Erreichbarkeit oder Bezahloptionen, erkennt schnell die Stellschrauben mit der größten Wirkung. Wichtig ist, die daraus abgeleiteten Verbesserungen konsequent umzusetzen und sichtbar zu machen. Informieren, handeln, erneut um Rückmeldung bitten. Dieser offene Kreislauf wirkt nach innen und nach außen. Mitarbeitende erleben, dass Feedback Veränderungen anstößt, Kund*innen erleben, dass ihre Hinweise ernst genommen werden, und die KI registriert die fortlaufende Pflege der Qualität. Mit jeder Runde werden Erlebnisse besser und Bewertungen stärker, was die Sichtbarkeit weiter erhöht.

Fazit

Sichtbarkeit entsteht heute dort, wo Menschen nach konkreten Lösungen fragen und wo KIs verlässliche Hinweise zu Qualität und Relevanz finden. Unternehmen, die Bewertungen als strategischen, kontinuierlichen Prozess verstehen, erhöhen ihre Chance, in generativen Antworten genannt zu werden und gewinnen genau in den entscheidenden Momenten an Präsenz. Vieles davon ist eine Frage kluger Organisation und klarer Abläufe. Der finanzielle Aufwand bleibt überschaubar, der Nutzen für Auffindbarkeit, Vertrauen und Umsatz ist deutlich spürbar.

Die Autorin Franziska Ortner ist Produktmanagerin bei SELLWERK

NICAMA Naturkosmetik: Von der Studienidee zum nachhaltigen Erfolgsunternehmen

NICAMA Naturkosmetik feiert sein fünfjähriges Bestehen: Was mit kleinen Experimenten während des Studiums begann, ist heute ein etabliertes Naturkosmetikunternehmen mit über 600 Handelspartnern im DACH-Raum.

Was 2019 als mutige Idee von vier Studierenden begann, wurde rasch zu einem inspirierenden Beispiel für gelebte Nachhaltigkeit. In einer Zeit, in der Umweltschutz noch kein selbstverständlicher Trend war, experimentierten die Gründerinnen und Gründer mit festen Shampoos, um eine plastikfreie Alternative zu herkömmlicher Kosmetik zu schaffen. Das erste Produkt entstand mit viel Leidenschaft, Neugier und Improvisation. Damit war der Grundstein für den späteren Unternehmenserfolg gelegt.

Ein erfolgreiches Crowdfunding finanzierte 2019 die erste Produktcharge und machte den Traum vom eigenen Webshop möglich. Es folgten die ersten Partnerschaften mit Bioläden, Outdoorhändlern, Friseuren und Geschenkeläden, die an die Vision glaubten. Heute zählt NICAMA stolz über 600 Vertriebspartner und wächst weiter.

Ein entscheidender Meilenstein war die Entwicklung des 1plus1 Meeresschutz-Prinzips: Für jedes verkaufte Produkt werden 100 Gramm Plastik in Küstenregionen gesammelt. Dieses Prinzip ist transparent, messbar und von jedem/jeder Kund*in nachvollziehbar. Bis heute konnten so über 33.290 Kilogramm Plastik aus der Umwelt entfernt werden. Das entspricht mehr als 3,2 Millionen Plastikflaschen. Darüber hinaus hat das Team mehrere Elbreinigungen organisiert, unter anderem gemeinsam mit der Naturschutzjugend NAJU und Charlotte Meentzen.

Mit dem Schritt in die Upcycling Beauty wurde NICAMA zum Pionier in Deutschland. Dabei werden wertvolle Nebenprodukte aus der Lebensmittelproduktion wie Ingwertrester und Kaffeekirsche zu hochwertigen Inhaltsstoffen verarbeitet. Heute umfasst das Sortiment über 50 plastikfreie Produkte, darunter Seifen, Shampoos, Deocremes, Pflegeöle und Körperpeelings – alle minimalistisch verpackt und mit reduzierten, sorgfältig ausgewählten Rezepturen.

Die Reise war jedoch nicht ohne Herausforderungen: Die Corona Pandemie und die Inflationsfolgen des Ukraine-Krieges setzten auch NICAMA stark zu. Das einst 15-köpfige Team musste sich zwischenzeitlich deutlich verkleinern. Trotz dieser Rückschläge bewies das Unternehmen Durchhaltevermögen. Heute steht es so solide da wie nie zuvor. Seit zwei Jahren verzeichnet NICAMA wieder überdurchschnittliches Wachstum und das deutlich über dem allgemeinen Naturkosmetikmarkt in Deutschland.

Für sein Engagement und seine Innovationskraft wurde das Unternehmen mehrfach ausgezeichnet: 2021 gewann NICAMA den Sächsischen Gründerpreis und erhielt bereits viermal den eku Zukunftspreis des Sächsischen Staatsministeriums für Umwelt und Landwirtschaft.

GreenTech – der Boom geht zu Ende

Zwar zählt Deutschland rund 3000 Start-ups aus dem GreenTech-Bereich, doch viele kämpfen mit Kapitalmangel, Fachkräftedefizit und einer überlasteten Infrastruktur. Der Boom ist vorbei – eine Einschätzung von Seriengründer und Transformationsexperte Daniel Fellhauer.

Die deutsche Wirtschaft steht vor einer ihrer größten Transformationen seit der Industrialisierung. Jahrzehntelang galten Auto- und Stahlindustrie als Rückgrat des Wohlstands. Nun rückt Nachhaltigkeit in den Mittelpunkt. Daniel Fellhauer sieht die GreenTech-Branche an einem kritischen Punkt: „GreenTech ist kein Hype, sondern Realität mit echten Herausforderungen. Die Frage ist: Wer bleibt übrig, wenn die Subventionen verschwinden?“ Seine Aussage bringt auf den Punkt, was viele Brancheninsider beschäftigt: der Übergang von gefördertem Wachstum zu marktwirtschaftlicher Reife. Jetzt entscheidet sich, welche Unternehmen Innovation und Wirtschaftlichkeit in Einklang bringen können – und wer an überzogenen Erwartungen scheitert.

Der Boom geht zu Ende

„Der Anteil grüner Gründungen ist zuletzt deutlich gesunken“, sagt Daniel Fellhauer. „Vor zwei Jahren war noch jedes dritte neue Start-up nachhaltig ausgerichtet. Heute ist es nicht einmal mehr jedes Vierte. Das ist ein deutliches Warnsignal. Der Markt sortiert sich, Kapital wird selektiver, und viele Ideen schaffen es nicht mehr über die Pilotphase hinaus.“ In den vergangenen fünf Jahren flossen zwar rund 11,7 Milliarden Euro in grüne Start-ups – etwa ein Viertel aller deutschen Risikoinvestitionen –, doch das Geld konzentriert sich zunehmend auf wenige, große Player. „Das zeigt eine Reifung, aber auch eine gefährliche Schieflage“, so Fellhauer. „Wir brauchen Breite, nicht nur Leuchttürme. Wenn die Finanzierungsströme versiegen, bevor Skalierung einsetzt, kippt der ganze Innovationspfad.“ Hinzu kommen steigende Zinsen, langwierige Genehmigungen und überlastete Netze. „Viele unterschätzen, wie stark Infrastruktur über Wachstum entscheidet“, erklärt er. „Eine Solarfirma kann heute Aufträge für 1.000 Anlagen im Jahr haben. Aber wenn der Netzanschluss neun Monate dauert, bleibt sie auf halber Strecke stehen.“

Deutschland ist längst auf dem Weg zur nachhaltigen Wirtschaft – doch der Anstieg wird steiler. Die entscheidende Frage lautet: Wird GreenTech zum Fundament der nächsten industriellen Ära, oder zur vertanen Chance einer Generation? Laut einer aktuellen Analyse fließt ein erheblicher Teil staatlicher Investitionen und Subventionen in Deutschland weiterhin in fossile Strukturen – über 60 Milliarden Euro jährlich. Da-bei hatte sich die Bundesregierung bereits 2009 gemeinsam mit anderen Industrieländern verpflichtet, ineffiziente Förderungen für fossile Energieträger bis 2025 zu beenden. Ein Ziel, das laut Fachleuten von Fraunhofer ISI, ZEW und Umweltbundesamt klar verfehlt wird. Daniel Fellhauer warnt: „Das ist kein ideologisches, sondern ein ökonomisches Problem. Solange Kapital und Fördermittel in alte Industrien gelenkt werden, anstatt in skalierbare GreenTech-Lösungen, bleibt Deutschland in der Vergangenheit verhaftet.“

Herausforderungen im deutschen GreenTech-Sektor

Trotz technologischer Fortschritte wird das Wachstum der Branche weiterhin durch strukturelle Probleme gebremst. Zu den größten Hindernissen zählen laut Fellhauer vor allem die unzureichende Netzinfrastruktur, die hohe Kapitalintensität sowie fragmentierte Märkte. Hochqualifizierte Arbeitskräfte in den Bereichen Energie, Elektronik und Software sind rar, wodurch die Entwicklung und Umsetzung neuer Technologien verlangsamt wird. Gleichzeitig behindert der schleppende Ausbau der Strom- und Wärmenetze eine schnelle Skalierung innovativer Lösungen. Daniel Fellhauer erklärt: „Hinzu kommt, dass viele GreenTech-Unternehmen aufgrund langer Entwicklungszeiten und hoher Anfangsinvestitionen auf beträchtliches Kapital angewiesen sind. Schließlich sorgen unterschiedliche Förderprogramme und komplexe regulatorische Vorgaben dafür, dass Innovationen und Markteintritte ausgebremst werden. Diese Faktoren erschweren nicht nur das Wachstum bereits bestehender Firmen, sondern machen auch den Einstieg für neue Gründerinnen und Gründer deutlich schwieriger.“

Zweite Generation der Nachhaltigkeit für mehr wirtschaftliche Tragfähigkeit

„Nur wer wirtschaftlich denkt, kann nachhaltig handeln“, sagt Daniel Fellhauer. Für ihn ist klar: Die nächste Phase der GreenTech-Bewegung entscheidet sich nicht an Visionen, sondern an Umsetzungsdisziplin. „Wir haben die Ideen, die Technologien und den gesellschaftlichen Rückhalt – jetzt geht es um Strukturen, Prozesse und betriebswirtschaftliche Fitness.“ Er spricht damit vor allem zu Gründerinnen und Gründern, die gerade überlegen, in den Markt einzusteigen. „Ich sehe viele junge Teams, die voller Energie starten – aber ohne belastbares Geschäftsmodell. Das ist gefährlich, weil GreenTech kapitalintensiv ist und die Anlaufphase oft Jahre dauert. Wer heute gründet, braucht einen klaren Plan für Cashflow, Partnerschaften und Skalierung, nicht nur für Storytelling.“

Fellhauer plädiert für eine zweite Generation der Nachhaltigkeit: weniger Ideologie, mehr Industriekompetenz. „Wir müssen wieder lernen, wie man produziert, automatisiert und skaliert, nicht nur, wie man pitcht. Nachhaltigkeit ist kein Marketingbegriff, sondern eine Frage des industriellen Könnens.“ Er empfiehlt, früh Kooperationen mit etablierten Mittelständlern oder Industriebetrieben zu suchen, um Skaleneffekte und Erfahrung zu nutzen. Statt auf Subventionen zu bauen, rät er zu robusten Wertschöpfungsmodellen, die auch ohne politische Förderung bestehen können. „Die besten Green-Tech-Firmen der nächsten Jahre werden die sein, die unabhängig funktionieren – weil sie echte Marktprobleme lösen, nicht weil sie im Förderdschungel überleben.“

Politik und Wirtschaft in gemeinsamer Verantwortung

Damit Nachhaltigkeit tatsächlich zum tragfähigen Standbein der deutschen Wirtschaft wird, braucht es planbare Rahmenbedingungen – aber auch Eigeninitiative. Fellhauer betont, dass Gründerinnen und Gründer nicht auf die perfekte Politik warten dürfen. „Wir brauchen beides: verlässliche Energie- und Förderpolitik und unternehmerischen Pragmatismus.“ Politik müsse langfristige Investitionen ermöglichen, den Kapitalzugang vereinfachen und Fachkräfte mobilisieren. Fellhauer nennt staatlich unterstützte Risikokapitalfonds und europäische GreenTech-Programme als zentrale Hebel, damit Innovationen nicht im Frühstadium scheitern. Zugleich müsse Deutschland die Infrastruktur modernisieren: Netze, Standards, Digitalisierung. „Solange ein Windpark genehmigt, aber nicht ans Netz angeschlossen werden kann, bleibt das alles Theorie“, warnt er. Sein Fazit fällt entsprechend klar aus: „GreenTech wird die neue industrielle Basis – wenn wir sie als solche behandeln. Gründer müssen rechnen, Politiker müssen liefern, und die Gesellschaft muss akzeptieren, dass Nachhaltigkeit ein Geschäftsmodell braucht, keinen Idealismuspreis.“

Daniel Fellhauer hat mehrere Unternehmen im Bereich Solar, Wärmepumpen und erneuerbare Energien erfolgreich aufgebaut. Heute ist er Chief Transformation Officer bei Thermondo und eingesetzter CEO seiner ursprünglich gegründeten Firma FEBESOL.

HR-Trends 2026

Die Arbeitswelt verändert sich, die Position der Unternehmen wird stärker, eine Rezession auf Management- und Führungsebene droht: die HR-Welt bleibt ein Schmelztiegel verschiedenster Strömungen. Das sind die fünf größten Herausforderungen für 2026.

Die Arbeitswelt verändert sich - sowohl für Personalmanager*innen als auch für die Belegschaft. Während sich vor wenigen Jahren die Arbeitnehmenden in einer starken Verhandlungsposition befanden, schlägt das Pendel jetzt immer stärker zugunsten der Unternehmen aus. Das eröffnet ihnen die Chance, die Arbeitswelt mehr nach ihren Vorstellungen zu gestalten, um ihren Unternehmenserfolg zu sichern. Gleichzeitig tragen sie auch die große Verantwortung, das Arbeitsumfeld ihrer Mitarbeitenden kontinuierlich zu verbessern, das Engagement zu fördern und die Rolle der KI für die kommenden Jahre mit Weitblick und Sorgfalt auszubalancieren.

Wir werfen einen Blick nach vorne und skizzieren die fünf wichtigsten HR-Trends für die DACH-Region im kommenden Jahr.

1. Kulturelle Transparenz – Strategiewechsel bei der Talentakquise

Die Stagnation der Wirtschaft, der angespannte Arbeitsmarkt, weniger Stellenangebote – all das führt dazu, dass Mitarbeitende lieber in ihren derzeitigen Positionen und Rollen verharren. Die Folge ist ein “Talentestau:” Mitarbeitende, die sonst das Unternehmen verlassen würden, bleiben und blockieren damit die Wechsel- und Entwicklungsmöglichkeiten derer, die eher bereit sind, ihre Karriere engagiert voranzubringen. Auf der Suche nach effektiven Möglichkeiten, diese Engpässe zu überwinden, werden Unternehmen im kommenden Jahr ihre Strategie hin zu mehr kultureller Transparenz ausrichten. Anstatt neue Talente mit einem Wertversprechen oder der einseitigen Hervorhebung positiver Alleinstellungsmerkmale zu gewinnen, kommunizieren sie ihre tatsächlichen Erwartungen und die Realität des Arbeitsalltags klar. Damit betonen sie bewusst auch Aspekte, die weniger passende Bewerbende eher abschrecken - damit sich die wirklich passenden umso stärker angesprochen fühlen. Beispiele dafür können u.a. die Erwartung, wieder vollständig zur Büropräsenz zurückzukehren, Prozessreife und Struktur der Unternehmen sowie die Nutzung von KI-Tools im Arbeitsalltag sein.

2. Neudefinition des Erfolgs – Leistung statt Leistungsschau?

Mitarbeitende haben oft das Gefühl, dass ihre tatsächlich geleistete Arbeit nicht richtig bewertet wird und sie nicht ausreichend Anerkennung erfahren. Analysen von Culture Amp ergaben, dass 2025 rund 20 Prozent der Mitarbeitenden nicht genau wissen, wie sich die Bewertung ihrer Performance zusammensetzt. Die Folge dieser Unkenntnis sind Mutmaßungen und die Fokussierung auf mehr Sichtbarkeit: Mitarbeitende betreiben eine Art Leistungsschau und arbeiten so, dass es vor allem produktiv aussieht. Wenn das Gefühl hinzukommt, einem passiven Monitoring ausgesetzt zu sein – in der DACH-Region nur unter strengen Auflagen erlaubt – konzentrieren sich Mitarbeitende auf das, was vermeintlich gemessen wird. Diese Kluft wird sich 2026 weiter vergrößern, wenn die Verantwortlichen ihre Leistungsbewertung nicht neu ausrichten, um ein vertrauenswürdiges und vollständigeres Bild von der Performance ihrer Mitarbeitenden zu erhalten. Wer hingegen menschzentrierte Feedbacksysteme wie Upward Feedback, 360‑Grad‑Feedback und reflektierende Einzelgespräche verankert, kann das Vertrauen stärken und ein ganzheitlicheres Verständnis der Beiträge der Mitarbeitenden erhalten.

3. Mensch und KI – zwei Seiten der HR-Medaille

2026 werden KI-Tools verstärkt Einzug in den HR-Abteilungen halten. Routineaufgaben wie z.B. eine erste Bewerberauswahl oder die Beantwortung von häufig gestellten Fragen werden zunehmend automatisiert beantwortet. Doch mit den Möglichkeiten der KI wächst auch die Erkenntnis, dass sie nicht die Lösung für alles sein darf. Darüber hinaus tritt 2026 der EU AI Act vollständig in Kraft. Demzufolge werden KI-Tools im Zusammenhang mit Personaleinsatz als Hochrisiko eingestuft: Sie unterliegen sehr strengen Richtlinien bezüglich Transparenz, Kontrolle und Grenzen des KI-Einsatzes. Bei der Frage, welche Aufgaben der KI überlassen werden können und welche nach wie vor die Empathie, die Erfahrung und das Wissen echter HR-Expert*innen erfordern, ist Fingerspitzengefühl gefragt. Auch scheinbar administrative Aufgaben benötigen manchmal den direkten persönlichen Austausch. Unternehmen werden dazu übergehen, deutlicher zu definieren, welche Fragestellungen und Bereiche maschinenbezogene Fähigkeiten und welche menschliche Fähigkeiten erfordern. 2026 wird sich ein deutlicher Trend bemerkbar machen: Die verstärkte Integration von KI in den Personalabteilungen und gleichzeitig die permanente Überprüfung, welche Aufgabenbereiche zukünftig KI-gestützt erledigt werden sollen.

4. Führung neu denken – Managementpositionen verlieren an Attraktivität

Auch das verraten die Analysen von Culture Amp: 72 Prozent der Generation Z sind nicht an Führungspositionen interessiert. Die jungen Arbeitnehmenden bleiben lieber in ihren jeweiligen Rollen, manche entscheiden sich ganz bewusst gegen eine Managementkarriere. Der Reiz, eine Leitungsfunktion zu übernehmen, nimmt insbesondere im Bereich des mittleren Managements ab: Diese Manager*innen fühlen sich zwischen den Erwartungen der Unternehmensführung und den Erwartungen ihres Teams oft unter starkem Druck. In der Folge könnte es im kommenden Jahr zu einer weiteren Abflachung der Hierarchien in den Unternehmen kommen, manche befürchten gar eine Rezession auf der Management- und Führungsebene. Gleichzeitig eröffnen sich Manager*innen durch den Einsatz von KI-Tools neue Möglichkeiten, ihren Einfluss zu vergrößern. Für jene Talente, die sich darauf einlassen, werden Führungspositionen dadurch zugänglicher und nachhaltiger. In Anbetracht dessen werden sich die Dynamiken in den Teams verändern. Unternehmen werden Führungsrollen zunehmend überdenken und ihre Manager*innen besser unterstützen, statt weitere einzustellen. Denn wenn weniger Menschen führen wollen, braucht es nicht mehr, sondern besser unterstützte Manager*innen.

5. Ambitionen und Leistungsbereitschaft wird außerhalb der Arbeitswelt ausgelebt

Ob berufliche Nebentätigkeit, Ehrenamt oder leidenschaftliches Hobby – immer mehr Mitarbeitende bringen Energie und Motivation für Tätigkeiten auf, die außerhalb ihrer regulären Arbeit liegen. Sie erkennen, dass sie ihre Stärken auch anderswo verwirklichen können. Dieser Trend hin zu mehr Kreativität, Leidenschaft und Erfüllung durch sinnvolle Tätigkeiten nach Feierabend und am Wochenende wird sich auch 2026 fortsetzen. Das Risiko für Unternehmen geht dabei über bloße Ablenkung hinaus: Bleiben angemessene Antworten im kommenden Jahr aus, wandern Ambitionen nach außen ab. Führung muss etwas Besseres anbieten: Die Chance 2026 liegt darin, den Hauptjob so zu gestalten, dass er sich wieder energiegeladen, kreativ und investitionswürdig anfühlt.

Fazit

Die Strömungen und Entwicklungen in der HR-Welt bringen einen fortdauernden Wandel mit sich. Gespannt blicken die Personalabteilungen auf die für 2026 vorgesehene nationale Umsetzung der Entgelttransparenz-Richtlinie der EU (EU Pay Transparency Directive and Equal Pay). Die weitreichendsten Veränderungen verursacht aber der Einzug der KI in die Arbeits- und Lebenswelt der Mitarbeitenden. Dies wirft unablässig neue Fragen auf: Droht der Talentepool zu versiegen, wenn Aufgaben für Berufseinsteiger*innen von KI übernommen werden und sie infolgedessen keine Erfahrung aufbauen können? Wird sich die Belegschaft eines Unternehmens früher oder später in KI-resistente und KI-affine Gruppen aufspalten? Die HR-Welt bleibt ein Schmelztiegel verschiedenster Strömungen im Unternehmen, die datengestützte Strategien erfordern.

Der Autor Dr. Arne Sjöström ist Regional Director, People Science EMEA bei Culture Amp mit dem Schwerpunkt Organisationspsychologie und angewandte Forschung.

Vorsicht vor diesen KI-Versuchungen

Allzu großes Vertrauen in GenAI ist fahrlässig, dennoch prüfen nur rund ein Viertel der Menschen in Deutschland die Ergebnisse, die KI für sie generiert, auf Korrektheit. Das sind die größten Gefahren und effektivsten Gegenmaßnahmen.

Die Leistung und die Zuverlässigkeit von KI-Assistenten nehmen gefühlt weiter zu. Doch wer in den letzten Wochen intensives Prompting bei ChatGPT, Perplexity und Co. betrieben und die Ergebnisse eingehend analysiert hat, fühlte sich in diesem Gefühl nicht bestätigt. Im Gegenteil: Die Qualität der generierten Antworten lässt neuerdings öfter zu wünschen übrig. Auf YouTube gibt es zahlreiche Videos zu diesem Phänomen, das sich offenbar auch die Herstellenden nicht so ganz erklären können, aber auch klassische Medien berichten darüber. In Anbetracht der Tatsache, wie abhängig sich viele Menschen im Berufsleben schon heute von GenAI-Tools gemacht haben, ist dieser Trend erschreckend und ernüchternd. Ein blindes Vertrauen in die digitalen Helfer aus der Familie generativer KI birgt zudem großes Schadenspotenzial, etwa dann, wenn sich Ärzt*innen bei der Diagnose auf sie stützen oder Entwickler*innen von der KI vorgeschlagene Frameworks ohne Sicherheitscheck implementieren.

Völliges Vertrauen in GenAI ist also, zurückhaltend formuliert, mindestens gewagt. Die Situation ist ernst und erfordert von GenAI-Anbietenden ein Mindestmaß an Qualitätssicherung – offenbar kein einfaches Unterfangen. Bis dahin ist es wichtig, eigene Maßnahmen zu ergreifen, um nicht in die Falle der folgenden vier Qualitätskiller zu geraten.

1. Halluzinationen

KI-Assistenten wie ChatGPT und Co. wurde die Aufgabe erteilt, Antworten zu liefern – koste es, was es wolle. Wenn die Wissensbibliothek nicht ausreicht, um komplexe Sachverhalte zu beantworten, fängt generative KI an, sich etwas auszudenken. Die von solchen Halluzinationen ausgehende Gefahr ist bekannt. Umso bedrückender ist die Tatsache, dass laut einer aktuellen Studie nur rund ein Viertel (27 %) der Menschen in Deutschland die Ergebnisse, die KI für sie generiert, auf Korrektheit prüfen. Das sind zwar immerhin sieben Prozentpunkte mehr als bei gewöhnlichen Inhalten aus dem Internet, wie eine Studie des PR-COM Research Lab belegt, aber noch immer viel zu wenige.

Gegenmaßnahmen: Wer GenAI nutzt, sollte ausnahmslos alle von ihr produzierten Inhalte überprüfen. Dazu sollten User*innen insbesondere die von der KI verwendeten Primärquellen checken oder – wenn möglich – Expert*innen zur Prüfung der Korrektheit der Antworten zurate ziehen.

2. Bias

Die Anbieter*innen aktueller KI-Assistenten haben sehr viel Arbeit in ihre Produkte gesteckt, um den Bias, also die Voreingenommenheit ihrer Modelle auszumerzen und sie zur Vorurteilsfreiheit zu erziehen.

Verlassen sollten sich User*innen auf die moralische und ethische Unantastbarkeit ihrer Modelle dennoch nicht. Zwar ist es unwahrscheinlich, dass Produkte großer Hersteller*innen noch rassistische, sexistische oder sonstige ethisch fragwürdige Ansichten vertreten, aber komplett ausgeschlossen ist es eben nicht. Noch relativ hoch ist die Gefahr zudem bei der Nutzung von kostenlosen GenAI-Assistenten oder Nischen-Tools.

Gegenmaßnahmen: Auch im Zusammenhang mit Bias gilt es, die Ergebnisse einer KI-Befragung immer genauestens zu checken und mit geltenden Gesetzen und den vorherrschenden Wertevorstellungen unserer Gesellschaft abzugleichen. Wer dubiose KI-Tools meidet, kann sich zudem viel Ärger ersparen.

3. Content-Kannibalisierung

Immer mehr KI-generierter Content flutet das Internet – die logische Folge der zunehmenden Nutzung von GenAI-Assistenten. Leider trainieren KI-Entwickler*innen ihre Chatbots und deren zugrunde liegende Sprachmodelle unter anderem mit genau diesen Inhalten. Und schlimmer noch: Der exponentiell steigende KI-Inhalt ist darüber hinaus auch der Wissensschatz, auf den die KI für ihre Antworten zurückgreift. Dadurch entsteht ein Teufelskreis aus KI, die sich irgendwann nur noch mit von ihr selbst generierten Inhalten trainiert und auch nur noch von ihr produzierten Content als Basiswissen verwendet. Der Mensch wird aus dieser Gleichung immer weiter herausgekürzt. Die Qualität der Ergebnisse von Anfragen an die KI wird somit zunehmend abnehmen. Hinzu kommt, dass alle User*innen irgendwann die gleichen Ergebnisse abrufen, nutzen und veröffentlichen.

Gegenmaßnahmen: Es ergibt Sinn, hin und wieder auch ohne KI zu agieren und Content zu produzieren, der frei von KI-generierten Inhalten ist und das Qualitätsmerkmal „Made in a human brain“ trägt.

4. Wissensoligopol

Der KI-Markt ist derzeit auf einige wenige Big Player geschrumpft, die sich die enormen Rechenressourcen und Entwicklungskosten für generative KI leisten können. Dadurch entsteht zunehmend ein Wissensoligopol, in dem die großen Anbieter*innen wie OpenAI, Google, Microsoft und DeepSeek zukünftig die Art und Weise bestimmen, welche Informationen überhaupt noch zugänglich sind. Schon jetzt gehen Suchanfragen auf den traditionellen Suchmaschinen deutlich zurück, die Ergebnisse zwar nach Algorithmen ranken, aber selten Treffer komplett ausblenden. Viel restriktiver agieren GenAI-Tools, deren implementierte Filter die freiheitliche Verbreitung von Wissen einzuschränken drohen: Was nicht mit den politischen und moralischen Ideen der Hersteller übereinstimmt, wird automatisch unterdrückt. Das erinnert ein wenig an das Wahrheitsministerium aus Orwells „1984“.

Gegenmaßnahmen: Es ist wichtig, dass Unternehmen und offizielle Stellen auch unabhängige Projekte fördern und deren Nutzer*innen- sowie Supporter*innen-Basis wächst. Gleichzeitig sollten User*innen es dringend verinnerlichen, dass KI- Assistenten nicht der Wahrheit letzter Schluss sind. Das Nutzen möglichst vieler Quellen, um das eigene Wissen aufzubauen, ist immer besser als ein vermeintlicher „Single Point of Truth“.

Fazit

Wir sind noch lange nicht so weit, dass ein blindes Vertrauen in generative KI zu rechtfertigen ist. Es ist zwar logisch, dass wir eine vermeintlich arbeitserleichternde Technologie erst einmal ungern hinterfragen – doch dieser Bequemlichkeit wohnt, je nach Einsatzzweck, ein erhebliches Schadenspotenzial inne. Zum jetzigen Zeitpunkt lautet also die Maxime, restlos jede von GenAI generierte Antwort genauestens auf den Prüfstand zu stellen.

Der Autor Alain Blaes ist CEO der Münchner Kommunikationsagentur PR-COM (mit Fokus auf High-tech- und IT-Industrie im B2B-Umfeld).