Aktuelle Events

Linkrisikoanalysen: Mögliche Vorgehensweisen

Um direkt mit der richtigen Erwartungshaltung einzusteigen: Linkrisikoanalysen sind aufwändig, benötigen demnach eine Menge Zeit, extrem viele Daten und einiges an Erfahrung im Umgang mit Links im Allgemeinen. Eine voll automatisierte, 100% akkurate Lösung zur Linkrisikoanalyse existiert nicht! Selbstverständlich gibt es Tools, die die Arbeit signifikant vereinfachten können, aber es geht nicht ohne gesunden Menschenverstand und – schlussendlich – manuelles Überprüfen! Im Folgenden wird das Vorgehen exemplarisch mit dem aktuellen de-facto Standardtool, den LinkResearchTools.com (kurz LRT), skizziert. Die LRT enthalten, speziell zur Bewertung von potenziellen Linkrisiken, das so genannte Tool Link Detox, welches eine Regelwerk-basierte Betrachtung und Bewertung für jeden einzelnen Link des jeweiligen Linkprofiles vornimmt. Diese einzelnen Werte ergeben schlussendlich, vereinfacht formuliert, eine Gesamtbewertung und weiterhin erfolgt die Klassifizierung in entsprechende Risikokategorien. Wie bereits zu Beginn erwähnt, ist jedes Tool nur so gut, wie die vorhandene Datenbasis. Aus diesem Grunde sollten mindestens die Links aus den Google Webmaster Tools exportiert und als CSV Datei dem Link Detox Modul zur Verfügung gestellt werden, da diese Daten kostenlos zur Verfügung stehen. Grundsätzlich gilt aber ganz klar, desto mehr Daten, desto genauer die Betrachtung bzw. Bewertung des Profils. Sofern möglich und verfügbar, sollten Sie darüber hinaus folgende (größtenteils kostenpflichtigen) Datenquellen ebenfalls in Betracht ziehen:

- Majestic.com (via API oder die Export-Option "Advanced Report")

- ahrefs.com (ebenfalls via API oder die Export-Option "Raw Data Export")

- Searchmetrics Suite – Backlink Research (100.000 via Export; ansonsten per API)

- Sistrix Toolbox – Linkmodul (via API)

Und selbstverständlich sind etwaige Listen aus vergangenen Linkaufbau-Aktivitäten "pures Gold" – analysieren Sie diese unbedingt zu aller erst! Nicht selten lassen sich hier bereits erste (hausgemachte) Probleme feststellen.

Weitere Gründe, die für den Einsatz der LRT sprechen, sind die automatische De-Duplizierung der Linkdaten (denn nicht selten gibt es teilweise Überschneidungen der Tool- bzw. Datenanbieter) sowie die darauf folgende Live-Validierung. Es wird, vor dem Erstellen des Reports, für jeden Link überprüft, ob dieser tatsächlich auch noch vorhanden ist. Sie können dann bei Ihrer Arbeit getrost alle toten Links herausfiltern und den Arbeitsaufwand so signifikant minimieren.

LRTs Link Detox in der Praxis

Das Verwenden des Link Detox Tools ist denkbar einfach: Sie definieren die zu analysierende Domain (und wählen unbedingt die Analysefunktion "mit und ohne www", denn häufig werden ansonsten Links übersehen) und wählen das Themenumfeld der Domaininhalte aus. Weiterhin sollten Sie angeben, ob die Domain manuelle Maßnahmen aufweist und, sofern bereits verwendet, das aktuelle Disavow-File hochladen (beides ist selbstverständlich nur dann möglich, wenn Sie eine eigene Domain analysieren; für fremde Domains können Sie diese beiden Punkte einfach ignorieren). Zu guter Letzt ergänzen Sie den Report um die eingangs genannten, externen Linkdaten (sofern vorhanden) und starten dann einen DTOX Report im "klassischen Modus". Danach dauert es, je nach Menge der zu analysierenden Links (und Systemauslastung) von mehreren Minuten bis hin zu einigen Stunden, bevor der fertige Report entsprechend zur Verfügung steht.

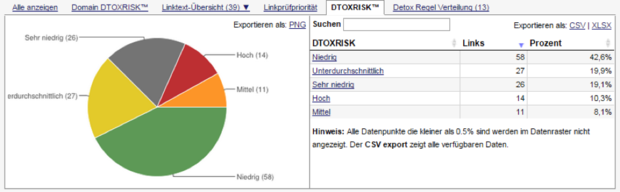

In der Praxis hat es sich bewährt, entweder mit der hier gezeigten Risikoverteilung zu arbeiten und mit den "kritischsten" Links zu beginnen (Sie sollten in jedem Fall die Links der Kategorie "Hoch" überprüfen) oder alternativ in den Tab "Regel Verteilung" wechseln, um dort die für Sie relevanten Regeln zu identifizieren und diese entsprechend abzuarbeiten. Selbstverständlich lassen sich diese Vorgehensweisen auch entsprechend kombinieren oder um einen Filter ergänzen, der diese Regeln nur auf kommerzielle Anchortexte anwendet.

Egal für welche Vorkategorisierung Sie sich auch entscheiden mögen, es folgt der wohl am wenigsten spannende Teil der Analysearbeiten: Das manuelle Review der einzelnen Links. Im Klartext bedeutet das nichts anderes, als dass Sie, je nach Umfang des Linkprofils, die kommenden Stunden (oder Tage bzw. Wochen) damit verbringen werden, viele schöne und weniger schöne Webseiten zu besuchen, um Linkintegrationen anzuschauen und zu bewerten. Achten Sie in dem Zusammenhang übrigens auch unbedingt darauf, einen aktuellen Virenscanner auf Ihrem System installiert zu haben.

Selbstverständlich könnten Sie sich jetzt die gefilterten Daten aus dem Link Detox Report als Excel Spreadsheet exportieren und von dort jeden Link öffnen und entsprechend mit Kommentaren versehen, es geht aber auch deutlich effizienter: Mit dem Link Detox Screener, die Funktionsweise ist hier detailliert erklärt.

Ich hab "schlechte" Links – was nun?

Grundsätzlich stehen beim Linkmanagement drei mögliche Vorgehensweisen zur Verfügung:

1. Gezielter Abbau von (möglicherweise) schlechten Linkquellen

2. Verwenden des Disavow Tools für einzelne Links oder ganze Domains

3. Warten und hoffen, dass Google zukünftig in der Lage ist, schlechte Links 100%ig zu erkennen (sowie automatisch zu entwerten). Und natürlich darauf zu vertrauen, dass diese Links bis dahin keinen Schaden anrichten.

Die Praxis zeigt, dass die dritte Variante – zum aktuellen Zeitpunkt – nicht funktioniert. Das Auswerten von mehreren hundert Beispiellinks, die Google für verschiedenste Domains zur Verfügung gestellt hat, zeigt ganz klar, dass ein signifikanter Anteil manueller Maßnahmen für Linkaufbau-Aktivitäten aus den Jahren 2009 bis 2011 verhängt wurde. Das erscheint insofern auch wenig überraschend, als dass in den vorgenannten Jahren der Linkaufbau über Artikelverzeichnisse, Foren, Web-Directories und andere, kaum relevante Linkquellen, den Markt extrem dominiert hat.

Geht man allerdings davon aus, dass Google die Betrachtung der einzelnen Signale weiter verbessern und verschärfen wird, scheint es durchaus angebracht, sich zeitnah von etwaigen Altlasten zu befreien, auch wenn sich zum aktuellen Zeitpunkt noch keine Performance-Einbußen (im Sinne von Traffic und / oder Rankings) feststellen lassen. Das größte Problem beim Linkabbau / Disavow ist, dass Google keine klaren Informationen darüber preisgibt, welche Links tatsächlich schlecht oder gar schädlich sind – dies hat häufig zur Folge, dass deutlich mehr Links entwertet werden, als eigentlich notwendig. Dies führt nicht selten zu unnötigen Performanceeinbußen der betroffenen Domains.

Grundsätzlich ist Linkabbau der Verwendung des Disavow-Tools vorzuziehen – zumindest dann, wenn es eine echte Chance auf Entfernung der jeweiligen Linkquelle gibt. Das Web befindet sich in konstanter Veränderung. Glaubt man Googles Zahlen, so verändern sich bis zu 15% des gesamten Internets (bzw. URL-Bestandes) täglich. In diesem Zusammenhang erscheint es vollkommen normal, dass einige URLs entsprechend nicht mehr verfügbar sind und mit einem HTTP 404 oder 410 Statuscode antworten. Somit gilt im Linkabbau: Im besten Fall – und zur Vermeidung potenzieller Muster – gehen minderwertige Linkquellen offline und liefern einen der vorgenannten Statuscodes aus. Google entfernt die betroffene Linkquelle nach mehrmaligem Aufrufen ebenfalls. Nicht immer ist es allerdings möglich, Linkquellen offline nehmen zu lassen – bei Scraper oder anderen, nahezu "verwahrlosten" Sites ist die Chance auf eine Antwort und entsprechende Entfernung gering bis nicht vorhanden – hier kann das Disavow Tool helfen. Eine detaillierte Anleitung zur Verwendung des Tools inkl. Checklist zu einem Reconsideration Request gibt’s hier im Peak Ace Blog.

Eine kleine Warnung zum Schluss

Das Thema Link Audits ist keineswegs trivial und Googles Kommunikation mit Seitenbetreibern, wenn überhaupt vorhanden, nur selten wirklich hilfreich. Bevor Sie vermeintlich schlechte Links abbauen oder gar mittels des Disavow Link Tools melden, konsultieren Sie unbedingt einen Berater bzw. eine Agentur für eine zweite Meinung um etwaige Kollateralschaden zu vermeiden.

Und bitte denken Sie auch daran, dieses Prozedere regelmäßig zu wiederholen, denn nicht nur reaktives Linkmanagement, sondern der pro aktive Umgang mit Ihrem Linkprofil hilft schlussendlich, Ihre Seite vor möglichen, Performance-Einbußen oder gar Abstrafungen zu schützen.

Zum Autor:

Bastian Grimm, blickt auf mehr als zehn Jahren Erfahrung im Online Marketing zurück. Bei der international tätigen Performance-Marketing Agentur Peak Ace mit Sitz in Berlin ist er für die Bereiche Suchmaschinenoptimierung (SEO) sowie Content & Online PR verantwortlich. Grimm ist zudem häufiger Speaker auf verschiedensten Konferenzen und Veranstaltungen im In- und Ausland (u.a. SMX, ISS, SES, SEOkomm, etc.). Bevor er sich ganz seinen eigenen Projekten widmete, war Bastian für den Aufbau verschiedener Marketing-Teams verantwortlich, z.B. bei der Fox Mobile Group und verantwortete dort die SEO Aktivitäten in 25+ Ländern und für 100+ Portale.

Seite 2 von 2

Diese Artikel könnten Sie auch interessieren:

II. Onpage Analyse-Tools

II. Onpage Analyse-Tools

Onpage Tools sind eine nützliche Unterstützung, um die eigene Website auf wichtige SEO-Faktoren hin zu überprüfen. Sie decken mögliche Fehlerquellen auf und erkennen mit Hilfe von sog. Crawlern, die die Seite gründlich untersuchen, an welcher Stelle es Verbesserungsbedarf gibt. Die folgenden drei Tools halten wir für essentiell.

Xenu’s Link Sleuth: Das ist ein kostenloses Tool, welches defekte Verlinkungen auf Ihrer Webpräsenz aufspürt. Nach Eingabe der URL startet die Analyse der Seite, und der User erhält im Anschluss einen umfassenden Report, aus dem beispielsweise Statuscode-Fehler hervorgehen. Dank genauer Angabe der Fehlerquellen kann das Problem direkt behoben werden.

Screaming Frog SEO Spider: Hierbei handelt es sich um ein einfach händelbares Desktop-Programm, welches ebenfalls kostenlos erhältlich ist. Es liefert recht umfangreiche Informationen über Onpage-Elemente der jeweiligen Website. Dazu gehört eine Auswertung aller Verlinkungen sowie deren Status, aber auch wichtiger Elemente wie die Meta Description, Meta Keywords und Anchor Text. Eine Export-Funktion ermöglicht das Übertragen in Excel.

Strucr.com: Ein Online-Dienst, der besonders für größere Webseiten eine gute Hilfestellung ist. Auch hier wird die gewünschte Seite mit einem Crawler durchsucht. Dabei überprüft das Tool die Seitenstruktur und liefert im Anschluss mehrere „Hints“, die SEO-relevant sein können. Dies können zu lange Seitentitel oder Fehler in den URLs sein. Es lohnt sich stets, diese Hinweise zu kontrollieren, auch wenn es sich nicht immer um Fehlerquellen handeln muss, die sich aus SEO-Sicht negativ auswirken.

SEO-Tools erleichtern den SEO-Alltag ungemein,

da sie alle Optimierungsmaßnahmen abbilden.

III. Offpage Analyse-Tools

Dank zahlreicher Offpage Analyse-Tools ist es möglich, wichtige ergänzende Daten für die Backlinks zu erhalten und zu verwalten. In kürzester Zeit können sich User einen umfassenden Überblick über vorhandene Backlinkstrukturen verschaffen und diese entsprechend dokumentieren.

Open Site Explorer: Open Site Explorer wurde von SEOmoz entwickelt und eignet sich als gute Ergänzung zu den allgemeinen Tools wie Sistrix und Co. Es erleichtert die Erfassung und schafft mehr Transparenz im Bereich der Backlinkdaten. Mit dem zur Verfügung gestellten Webindex können Linkstrukturen analysiert und abgebildet werden.

Majestic SEO: Majestic SEO ist ein weiteres nützliches Backlinktool, welches Zugang zum eigens entwickelten Index bietet. Sämtliche Daten aus dem sogenannten „Fresh Index“ sind wie der Name schon sagt immer aktuell. Zusätzlich können die Backlinks rückblickend über einen längeren Zeitraum analysiert werden, dazu dient der „Historic Index“. Majestics greift dabei zur Zeit auf weit über 3 Billionen URLs im Historic Index und 140 Milliarden URLs im Fresh Index zurück.

Raven Tools: Der Vorteil von Raven Tools ist hauptsächlich die hohe Datenqualität. In übersichtlicher Form lassen sich Keywords und Backlinks sowohl recherchieren als auch dokumentieren. Sämtliche Backlinks können in den vorhandenen Link-Manager importiert und ausgewertet werden. Außerdem ist mit Hilfe dieser Daten eine Wettbewerbsanalyse möglich.

Der richtige Text als Türöffner

Der richtige Text als Türöffner

Schreiben Sie nicht einfach drauflos. Überlegen Sie bei jeder Anzeige genau, wen Sie wie ansprechen möchten. Machen Sie nicht Gott und die Welt auf sich aufmerksam, sondern Ihre Zielgruppe. Das Grundrezept für gute Online-Texte heißt: Nicht einfach alle verfügbaren Informationen aneinanderreihen und hoffen, dass jemand sie liest. Sondern: kurz und konkret den Kundennutzen aufzeigen. Was sicher keinen Erfolg bringt: möglichst viele Keywords in Ihre Anzeigentexte zu stopfen und erwarten, dass einige Leser darauf klicken werden, dann bestellen und sich Ihre Investition gelohnt hat. Das AdWords-System ist zu komplex und Werbepsychologie von vielen Faktoren geprägt.

Selbstläufer, aber nur an der langen Leine

Überprüfen Sie Ihre Keywords regelmäßig auf folgende Punkte: Werden Ihre Keywords überhaupt eingeblendet, oder ist das Tagesbudget bereits am Mittag aufgebraucht? Lehnt Google bestimmte Keywords ab wegen „geringen Suchvolumens“? Das bedeutet dann: Niemand wird danach suchen, Sie finden keine Kunden, und Google verdient kein Geld. Prüfen Sie gelegentlich, ob das gewählte Tagesbudget nach wie vor den gesetzten Zielen entspricht, oder ob Google von sich aus Änderungen vorschlägt. Entfernen Sie alle Keywords, die in der längeren Betrachtung nicht den gewünschten Erfolg bringen. Dies können solche sein, die thematisch missverständlich sind und deshalb grundsätzlich nicht die gewünschten Kunden bringen.

Entfernen Sie alle Keywords, die so teuer sind, dass der wirtschaftliche Nutzen nicht gegeben ist. Entfernen Sie ebenfalls alle Keywords, die so selten angefragt werden, dass sie langfristig kaum für Ihr Angebot relevant sind. Und fragen Sie sich regelmäßig, ob der Qualitätsfaktor der einzelnen Keywords zufriedenstellend ist oder ob Sie die Inhalte optimieren sollten? Google ist bestrebt, qualitativ gute Anzeigen zu schalten. Wenn der Inhalt Ihrer Anzeige optimal mit Ihren gebuchten Keywords übereinstimmt, wird Ihre Anzeige öfter geschaltet und vermutlich auch angeklickt und rutscht so in der „Gunst“ der Suchmaschine und damit in den Platzierungen künftig nach oben, auch wenn Sie möglicherweise nicht das höchste Gebot abgegeben haben.

Die Konversationsrate macht’s

Werden Ihre Anzeigen häufig angeklickt, ist das schön. Aber die Klicks allein sind noch kein Kriterium für den Erfolg Ihrer Kampagnen! Ein Großkonzern will mit seiner AdWords-Kampagne sicher nicht nur Neukunden gewinnen, sondern auch Markenbekanntheit erlangen oder erhalten. Sein Monatsbudget unterscheidet sich ganz erheblich von dem eines Gründers. Das Ziel Ihrer Kampagne ist aber vermutlich nicht nur eine gute Klickrate, sondern Aktionen der Interessenten: Bestellungen, Termine für Informationsgespräche, Abonnenten.

Das heißt: Möglichst mit jedem eingesetzten Euro Umsatz erzielen. Deshalb ist die Klickrate zwar ein wichtiges Erfolgskriterium. Von zentraler Bedeutung ist aber die Konversionsrate, also die Zahl derer, die nicht nur auf Ihre Seite geklickt haben, sondern dort auch Kunde geworden sind, Produktinformationen angefordert, sich registriert oder in anderer Form das getan haben, was Sie sich wünschen. Denn was nützt es, wenn Tausende von Menschen am Monatsende wissen, dass es in Buxtehude einen tollen Architekten mit einem lustigen Namen gibt, dessen Dienste sie aber nicht benötigen und nur mal eben beim Surfen auf seiner Seite waren?

Checkliste Tipps zur regionalen Eingrenzung

So gelingt die regionale Eingrenzung Ihrer Anzeigen am besten:

- Schalten Sie eine normale Kampagne, in die Sie alle Keywords eingeben, also auch die Stadt, in der Sie gefunden werden möchten. Damit erreichen Sie aber nur Interessenten, die auch die entsprechende Stadt bei der Suche mit eingeben.

- Abhilfe schafft hier eine separate, lokale Kampagne, bei der Sie unter „Einstellungen“ einen benutzerdefinierten Radius ziehen von bis zu xy km um den eigenen Standort. In diesem Fall werden über die jeweilige IP-Adresse des Suchenden automatisch passende Anzeigen eingeblendet, egal, ob der Interessent mit oder ohne Ortsangabe sucht.

- Weniger elegant, aber auch eine Möglichkeit: In der normalen Kampagne einfach die wichtigsten deutschen Städte als ausschließende Keywords eingeben.

- Und zu guter Letzt: Sie können innerhalb einer normalen Kampagne eine Anzeigengruppe mit einer lokalen Anzeige erstellen. Mit dem angenehmen Nebeneffekt, dass diese auch bei Google Maps angezeigt wird.

Seiten-Optimierung

Seiten-Optimierung

Nachdem wir die Struktur Ihres Internetauftritts betrachtet haben, gehen wir im Folgenden auf die Optimierung einer einzelnen Seite ein – also bspw. der Kategorie „Netzwerkkabel“: Im Head Ihrer Seite, also in dem Quellcode zwischen den Tags <head> und </head>, geben Sie Suchmaschinen wertvolle Hinweise auf den Inhalt der Seite sowie auf die Frage, ob Suchmaschinen die Unterseite überhaupt indexieren sollen. Diese Informationen werden als Meta-Informationen bezeichnet.

Innerhalb des Title-Tags (<title>

Der Title-Tag</title>) hinterlegen Sie den Namen der Seite, der sowohl in den Suchergebnissen als auch in der oberen Browserzeile angezeigt wird. Die optimale Länge des Title-Tags liegt bei etwa 65 Zeichen. Fassen Sie sich also kurz, da ansonsten der Title in den Suchergebnissen automatisch gekürzt wird und die einzelnen Begriffe, die Sie im Titel der Seite nutzen, einen geringeren Wert bei der Errechnung des Rankings erhalten. Nutzen Sie das Keyword, mit dem die Seite ranken soll. Im Beispiel „Netzwerkkabel“ sollten Sie also selbstverständlich „Netzwerkkabel“ im Titel erwähnen. Da Sie 65 Zeichen nutzen können, empfehlen wir in diesem Zusammenhang den Longtail zu optimieren und eine aussagekräftige Überschrift zu wählen – bspw. „Netzwerkkabel online kaufen bei Shopname“ – somit weiß der Nutzer, der Ihre Seite besucht, direkt, dass er Netzwerkkabel kaufen kann und nicht nur eine Informationsseite besucht.

Ein wichtiger technischer Baustein von SEO ist

der Auf- und Ausbau der Informations-Architektur.

Description- und Robots-Tag

Das Description-Tag (<meta name =“description“ content=“Beschreibung des Inhalts“>) hat aus Ranking-Gesichtspunkten keine Bedeutung. Allerdings wird die Description auf Suchergebnisseiten ausgegeben und vermittelt somit dem potenziellen Besucher einen ersten Eindruck über den Inhalt der Seite. Die Beschreibung sollte in etwa 160 Zeichen umfassen. Um die Clickrate zu optimieren, sollten Sie also in der Beschreibung kurz formulieren, was Ihren Besucher erwartet. Nutzen Sie auch hier die Keywords, auf denen Sie ranken möchten, da diese bei der entsprechenden Suchanfrage in den Suchergebnissen fett markiert werden und somit dem Suchenden die Relevanz Ihrer Seite nochmals verdeutlichen.

Mit dem Robots-Tag (<meta name =“robots“ content=“no-/index,no-/ follow“>) lässt sich bestimmen, ob eine Seite von Suchmaschinen indexiert werden soll oder nicht. Standardmäßig werden Seiten indexiert. Allerdings kann dies durch die Ausprägung „noindex“ vermieden werden – dies bietet sich insbesondere für solche Seiten an, die über keinen unique Content verfügen bzw. kein Rankingziel haben (z.B. Impressum, Datenschutzerklärung). Durch die Angabe „nofollow“ werden Suchmaschinen angewiesen, den Links auf einer Seite grundsätzlich nicht zu folgen und die Stärke der Seite somit nicht zu vererben. Insbesondere bei internen Links hat das „Nofollow“-Attribut also eine eher schädliche Wirkung.

Vorteile der Agentur-Lösung

Welche Vorteile hat es, SEO an eine Agentur auszulagern?

Nachdem wir die Vorteile einer internen Lösung herausgestellt haben, möchten wir selbstverständlich auch auf die Vorteile eingehen, die die Zusammenarbeit mit einer Agentur mit sich bringen. Zunächst klingt es sicherlich verlockend, einen SEO-Mitarbeiter einzustellen, der sich Vollzeit um die Suchmaschinenoptimierung kümmert. Doch sollte man sich im Vorhinein fragen, ob man diesen Mitarbeiter überhaupt auslasten kann. SEO ist, wie bereits in den vergangenen Teilen der Serie beschrieben, kein Kanal, den man neben der eigentlichen Arbeit betreuen kann.

Es ist also nicht zu empfehlen, den SEM-Manager oder einen Techniker kurzerhand mit dem Thema SEO zu betrauen und davon auszugehen, dass er das kurzfristig neben seiner „normalen“ Arbeit umsetzen kann. Hier sollte man lieber auf Experten setzen, statt eine suboptimale Lösung zu wählen, die dem Unternehmen nachhaltig schaden könnte. Außerdem sollte in Betracht gezogen werden, dass der Arbeitsmarkt für SEOs von einem starken Überhang der Nachfrage gekennzeichnet ist. Somit fällt es nicht einfach, einen wirklich starken Inhouse SEO einzustellen. Und häufig haben Unternehmen, in denen noch kein SEO-Know-how vorliegt, das Problem zu entscheiden, ob ein potenzieller Mitarbeiter wirklich qualifiziert ist, den SEO-Bereich des Unternehmens zu leiten.

Einen SEO-Spezialisten als Angestellten zu finden, ist schwierig, da es zu wenige auf dem Markt gibt.

Neben den personenbezogenen Gründen, die evtl. für eine Zusammenarbeit mit einer SEO-Agentur sprechen, sind auch noch einige andere Gründe denkbar, bei denen die Agentur effizienter arbeiten kann als ein Mitarbeiter des Unternehmens. So besteht bei einer internen Lösung die Gefahr, dass der Inhouse SEO sich ausschließlich mit der eigenen Webseite sowie den Webseiten der direkten Konkurrenten befasst. Ein Blick über den Tellerrand ist dann meist ausgeschlossen. Neue Chancen und Risiken werden häufig vom Inhouse SEO übersehen, da dieser in seiner Routine verhaftet ist und den „Blick auf das Ganze“ verliert bzw. bei Berufseinsteigern noch nicht gewonnen hat. Dadurch, dass ein Mitarbeiter einer SEO-Agentur Einblick in die verschiedensten Branchen und Webseiten hat, kann Expertise eingebracht und Betriebsblindheit vermieden werden.

Außerdem ist insbesondere Start-ups zu empfehlen, sich auf das Kerngeschäft zu konzentrieren, also auf das, was man wirklich kann. Baut man ein internes SEO-Team auf und liegt das Kerngeschäft weniger darin, durch organischen Traffic möglichst viele Besucher auf die Seite zu ziehen. So kann man schnell sein Kerngeschäft vernachlässigen. Daher ist es ratsam, Themen wie die SEO an dafür spezialisierte Agenturen auszulagern. Wie bereits oben erwähnt, birgt die Inhouse Lösung den Vorteil des Aufbaus von Know-how. Dieses ist jedoch stark bei dem SEO-Mitarbeiter gebündelt. Ein Unternehmenswechsel des Kollegen würde das Unternehmen also nachhaltig treffen. Bei einer auf Suchmaschinenoptimierung fokussierten Agentur wird dieses Risiko deutlich minimiert.

Ebenfalls sollte sowohl die Flexibilität als auch die Skalierungsmöglichkeiten einer Agentur nicht unerwähnt bleiben, zwei für Start-ups wichtige Gesichtspunkte. Durch das große Kontaktnetzwerk einer Agentur mit gesunder Größe fällt es dieser zumeist leichter, höhere Budgets sinnreich für den Kunden zu investieren als das ein Inhouse SEO könnte. Auch kann das Budget bei der Zusammenarbeit mit einer Agentur für mehrere Monate gesenkt werden, ohne direkt einen Mitarbeiter verlieren zu müssen.